一种基于层次化R⁃GCN 的会话情绪识别方法

2022-01-14赖河蒗李玲俐胡婉玲颜学明

赖河蒗,李玲俐,胡婉玲,颜学明

(1.华南师范大学计算机学院,广州 510631;2.广东司法警官职业学院信息管理系,广州 510520;3.广东外语外贸大学信息科学与技术学院,广州 510006)

0 概述

随着人工智能技术的快速发展,推荐系统、舆情预测、财务预测、智能搜索、对话系统、人机交互等相关应用得到普及,其中,人机交互受到科研人员的广泛关注。用户在交互过程中会产生各种形式的生理和行为数据,人工智能追求的目标是人机可以无缝衔接,即当用户与机器进行情感交互时,机器可以全面准确地分析交互数据并洞察、理解、表达各种情绪。因此,需要构建能够识别和理解情绪的机器,使得它们可以像人类一样进行自然和友好的互动。

情绪是人们受到外界刺激时在感觉、思想或行为等方面所产生的一些心理或生理反应[1],如生气、开心、伤心、兴奋、沮丧、害怕、惊讶等。情绪在人们的生活中发挥着极其重要的作用,其会影响人们的日常交流、行为举止、判断、决策等。情绪识别是指通过对表达的信息(通常该信息单元是一个“话语”)进行分析,进而判断该“话语”属于哪一种情绪。虽然当前已经有较多关于情绪识别方面的研究,但是较少有学者对会话情绪识别进行研究。随着神经网络、机器学习、深度学习[2-3]等人工智能技术的发展,会话情绪识别成为研究热点,在对话系统中,情绪识别极其重要,其要求机器人能识别并透彻地理解会话中的情绪,从而给出带有感情的响应或回复。然而,由于会话中说话者之间存在很强的相互依赖性,使得会话情绪识别成为一项具有挑战性的任务[4]。在一个交互的会话中,有2 个重要因素影响情绪动态变化:一为说话者自身的情绪影响,指个人在某一时刻的情绪传递到另一时刻;二为说话者之间的情绪影响[5-6],指个人情绪受到了另一说话者的情绪影响。

本文考虑上述2 个影响因素,提出一种基于层次化关系图卷积神经网络(HRGCN)的会话情绪识别方法,其层次化地使用关系图卷积神经网络(R-GCN)对会话中产生的序列“话语”进行建模,从而识别会话中的情绪。具体地,用多模态表示会话中的每一个“话语”,将整个序列输入到一个基础神经网络(该网络可以是LSTM 或GRU 等),经过基础神经网络输出后,按照不同的说话者将整个序列划分成不同的子序列(在本文中划分为2 个子序列)。不同的子序列输送到局部R-GCN(隶属于不同的说话者)进行计算,并将计算结果按照会话发生的时间顺序相级联,级联后的序列“话语”送到全局R-GCN中进行计算,计算后得到的全局特征表示传送到完全连接层进行降维操作,完全连接层的输出即为情绪分类预测结果。

1 相关工作

近年来,随着对话系统应用的普及,会话情绪识别逐渐成为人机交互领域中的一个研究热点,同时也受到国内外研究人员的广泛关注。会话情绪识别是一个涉及信号处理、心理学、自然语言处理、认知科学等多个交叉学科的研究领域。

PORIA 等[7]提出基于卷积多核学习的分类器以及基于上下文的层次化双向LSTM 模型[8],以进行多模态情绪识别以及情感分析。HAZARIKA 等[4]首先提出会话存储网络模型,该模型使用2 个不同的GRU 来捕获不同说话者所表达“话语”的上下文信息,随后,他们改进该模型,通过增加一个GRU 对说话者之间进行建模,该GRU 可以看作跟踪整个会话的记忆存储[9],此外,他们又提出迁移学习的方法,该方法先训练一个神经对话生成模型,然后利用该模型的参数来初始化目标情绪分类器[10]。MAJUMDER等[11]描述一个基于3 个GRU 的循环神经网络,这3 个GRU 分别用于追踪会话中说话者的个人状态、全局上下文信息以及情感状态,该神经模型能有效捕获说话者之间的关系并扩展到多个说话者的会话中。JIN 等[12]将层次化的多模态转换器作为基础网络,设计一个局部感知的注意力机制和一个说话者感知的注意力机制,以分别捕获局部上下文以及说话者的情绪惯性。高玮军等[13]建立一种基于注意力机制的深度学习模型AT-DPCNN,其通过注意力矩阵重点关注文本序列中对情感走向影响较大的部分,解决了传统卷积神经网络在提取特征过程中存在的信息丢失问题。PORIA 等[14]对会话情绪识别中存在的挑战、数据集以及最新进展进行了详细综述。

由于图神经网络(GNN)、图卷积神经网络(GCN)和R-GCN 在捕获相邻信息时具有优势以及在预测分类方面效果较好,因此在情感分析和情绪识别领域得到广泛应用。ZHANG 等[15]提出基于图卷积神经网络的情绪识别模型,用于解决会话中的上下文依赖以及说话者相互依赖这2 个挑战性问题。ZHONG 等[16]设计一个知识丰富型的转换器,利用层次化结构的自我关注来诠释上下文中的“话语”,并通过一个上下文感知的情感图注意力机制来动态地使用相关常识。XU 等[17]使用图卷积神经网络进行特征提取以及面部表情识别分类。WANG 等[18]提出基于锁相值的图卷积神经网络,用于多通道脑电情绪识别。SONG 等[19]设计一个动态图卷积神经网络来进行多通道脑电情绪识别研究。LO 等[20]提出一种基于关系建模的图卷积神经网络,并将其用于微表情识别。GHOSAL 等[21]建立一个对话图卷积神经网络,用于捕获说话者自身以及说话者之间的相互依赖关系。

上述方法都取得了较好的识别效果,但它们大多没有考虑不同说话者自身表达的特点以及历史上下文和将来上下文信息存在不同权重的问题。本文将不同说话者在会话中所表达的“话语”分开进行局部建模,然后再级联完成全局建模,在建模过程中采用非对等窗口技术表示历史上下文和将来上下文信息所隐含的权重。

2 层次化R-GCN 模型

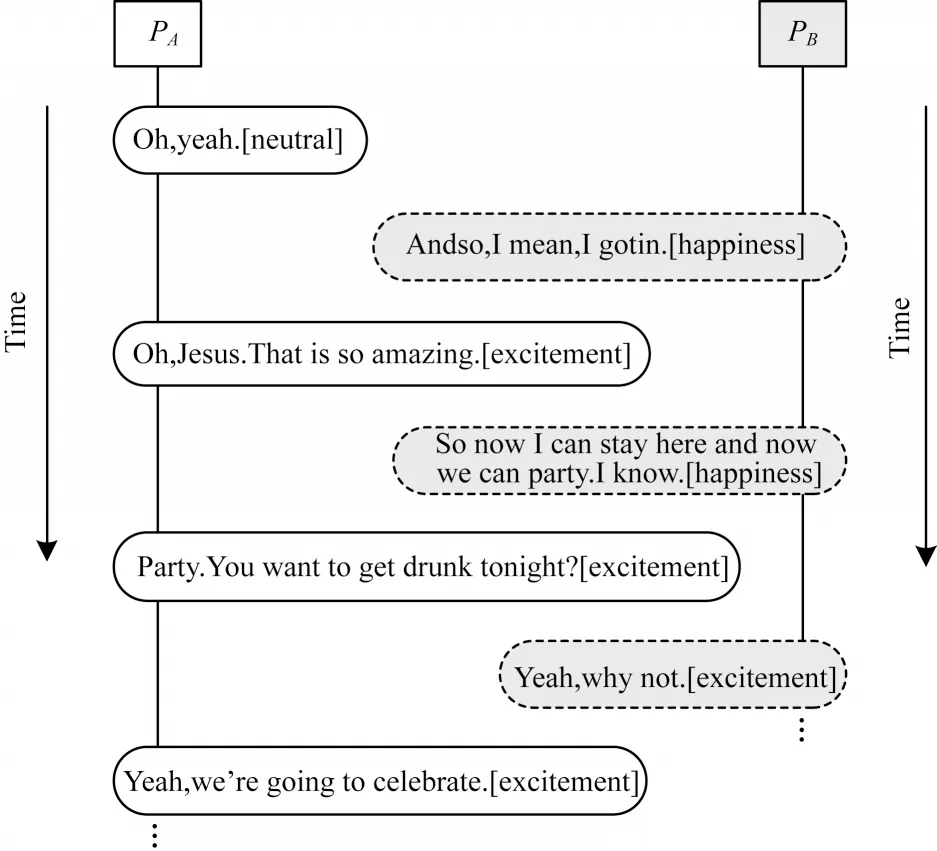

为了有效捕获上下文之间的依赖关系,需要同时考虑说话者自身的情绪影响以及说话者之间的情绪影响。图1 所示为IEMOCAP(Interactive Emotional dyadic Motion Capture database)数据集中抽取出的一个对话片段,其体现了上述2 个因素对情绪变化的影响。

图1 情绪影响示例Fig.1 Examples of emotional impact

本文提出一种HRGCN 方法进行会话情绪识别,所研究的会话是二元会话,即在会话交互过程中有2 个不同的说话者。由于不同说话者具有各自表达的特点,本文将整个会话序列划分成2 个不同的子序列(分别对应2 个说话者各自表达的“话语”序列),并用2 个局部关系图卷积神经网络对2 个子序列进行独立建模。

文献[21]在划分边关系类型时没有考虑“话语”在会话序列中的位置,未区分当前测试“话语”与其他“话语”之间的距离大小。与文献[21]不同,本文认为不同时刻的“话语”所产生的情绪依赖影响是不同的,即不同时刻的“话语”含有不同的权重,在划分边关系类型时,应该将当前测试“话语”与其他“话语”之间的距离大小作为划分结果的主要影响因素之一。在会话过程中,当前测试“话语”的情绪受历史上下文的影响较大,受将来上下文的影响较小。为了强调当前“话语”的历史上下文和将来上下文所占权重不同,本文使用非对等距离大小技术来表示权重,即将历史和将来2 个不同方向的距离设置为不同的值。例如,令测试“话语”ut与其他“话语”之间的距离大小为d,在ut的历史上下文方向设置一个距离划分点,假设距离大小为,在ut的将来上下文方向设置一个距离划分点,假设距离大小为,然后讨论d、三者之间的关系,最后得到边关系类型以及每条边所属的类型。

图2 所示为HRGCN 结构框架,其主要模块有基础神经网络(BNN)、局部关系图卷积神经网络(Local R-GCN)以及全局关系图卷积神经网络(Global R-GCN)。

图2 HRGCN 结构框架Fig.2 HRGCN structural framework

2.1 基础神经网络

基础神经网络的目的是使多模态数据在输入到关系图卷积神经网络之前获得较好的特征表示,即为后续的关系图卷积计算打下基础。该模块可以选择不同的神经网络,如循环神经网络LSTM 或GRU。在本文实验部分,分别采用这2 种不同的神经网络作为基础神经网络,并对比实验效果。

假设有一个二元会话,其“ 话语”序列是u1,u2,u3,u4,u5,u6,其 中,u1,u2,u5是第一个说话者表达 的“话 语”,u3,u4,u6是第二个说话者表达的“话语”。将整个序列输入到基础神经网络时,具体的计算过程为:首先将序列中每个“话语”的各个模态数据(包括文本、声音和图像)级联起来;然后输入到双向LSTM 或GRU 网络进行计算,得到输出序列q1,q2,q3,q4,q5,q6。

2.2 局部关系图卷积神经网络

特征数据在经过基础神经网络之后,将在局部关系图卷积神经网络模块进行局部关系图卷积计算:首先,根据不同的说话者对序列“话语”进行划分;然后,将这2 个不同的子序列输送到Person one RGCN 和Person two RGCN 这2 个不同的局部关系图卷积神经网络。本文所提方法基于局部邻居信息(即一定范围内的邻居“话语”)进行卷积处理,此外,考虑到历史上下文和将来上下文隐含的权重不同,本文引入距离大小非对等技术。

2.2.1 图结构

一个具有N个“话语”的会话,其关系图网络结构可以用一个有向图G=(V,E,R)来表示:图中每个顶点vi∈V表示一个“话 语”;顶 点vi和顶点vj(i,j∈[1,2,…,N])之间的边为(vi,vj)∈E,边的关系类型为r∈R。

2.2.2 顶点划分

在对自身情绪影响进行建模时,考虑到不同说话者具有不同的特点,本文将不同说话者在会话中所表达的“话语”进行划分,如图2 所示,将序列q1,q2,q3,q4,q5,q6划分为q1,q2,q5和q3,q4,q6。划分后将这2 个子序列分别送到Person one RGCN 和Person two RGCN 进行卷积运算。

2.2.3 基于非对等上下文窗口的边集合

边集合中具体包含哪些边取决于建模过程中考虑的上下文内容范围。在一个会话中,如果每个“话语”的上下文内容考虑的范围是其他所有的“话语”,那么会产生一个完全连接图,此时每个顶点与所有其他顶点(包括自身)都有一条边。由于这种情况会花费大量的计算时间,因此本文只考虑局部邻居信息进行卷积处理,即在收集局部邻居信息时使用上下文窗口来限制范围。例如,将历史上下文窗口设置为Wp,将来上下文窗口设置为Wf,图中任意一个“话语”为vi∈V,则该“话语”vi对应的边集合中包含vi自 身、Wp个历史“话 语”(在vi之前的vi-1,vi-2,…,vi-Wp)以及Wf个将来“话语”(在vi之后的vi+1,vi+2,…,vi+Wf)。

进一步区分Person one RGCN 和Person two RGCN网络的上下文窗口,将其分别设置为Wp1、Wp2与Wf1、Wf2。为了进行简化,在图2 所示的模型中,这4 个窗口的大小均设置为2,需要注意的是,在优化实验参数时,可以将隶属于不同说话者的Wp和Wf窗口大小设置为非对等数值。在窗口值范围内,说话者Person one的“话语”序列q1,q2,q5所产生的边有<1,1>、<1,2>、<1,5>、<2,2>、<2,1>、<2,5>、<5,5>、<5,1>、<5,2>。同 理,说话者Person two 的“话 语”序 列q3,q4,q6所产生的边有<3,3>、<3,4>、<3,6>、<4,4>、<4,3>、<4,6>、<6,6>、<6,3>、<6,4>。

2.2.4 基于非对等距离大小的关系划分

在二元会话中,2 个“话语”之间的时序关系依赖于它们在会话中的位置。在划分每条边所属关系时,本文采用基于非对等距离大小的方法来产生不同时序“话语”之间的边关系类型。

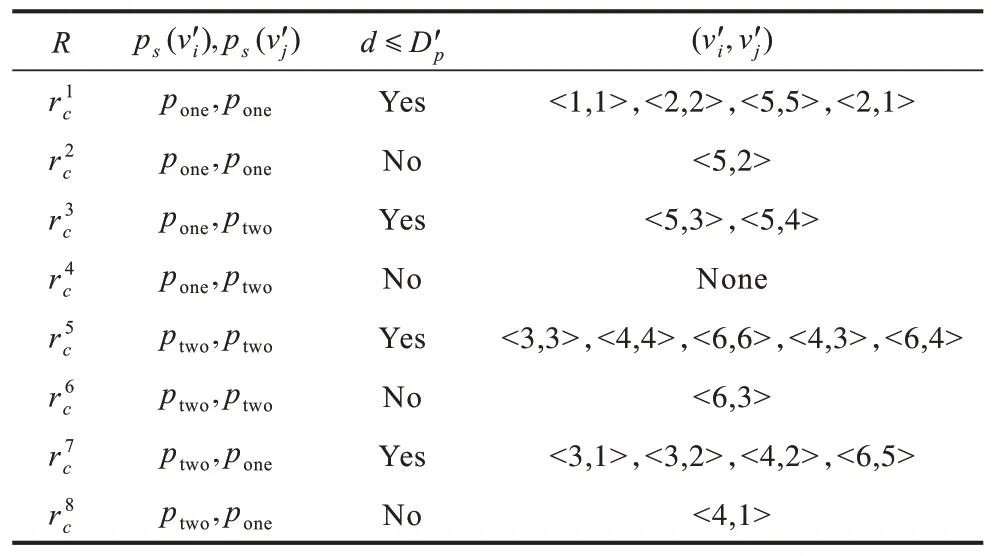

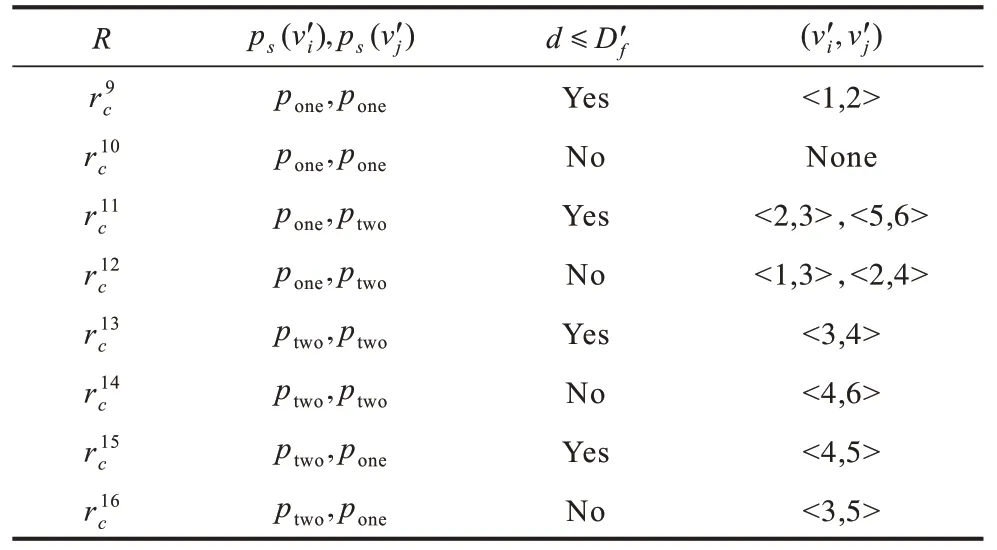

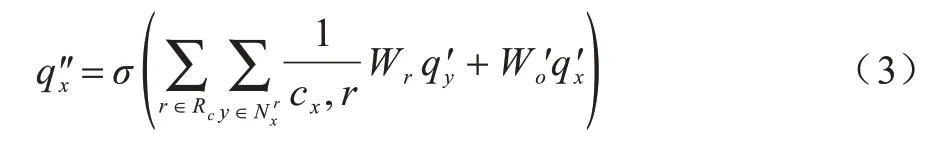

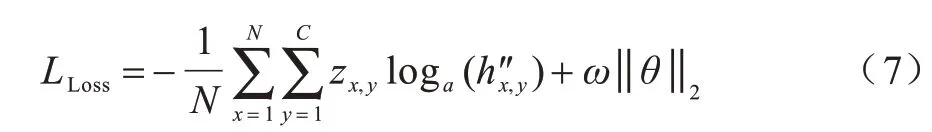

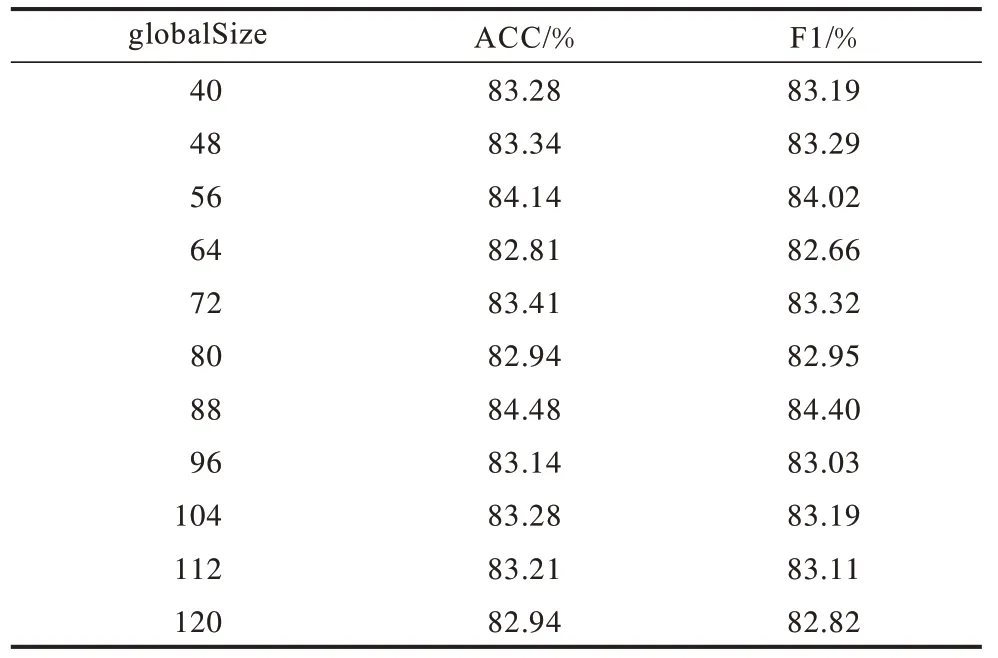

在局部关系图卷积神经网络Person one RGCN中,2 个非对等距离分别用Dp1和Df1(0 同理,在局部关系图卷积神经网络Person two RGCN 中,2 个非对等距离分别用Dp2和Df2(0 图2中的Person one RGCN 和Person two RGCN 模块展示的是Dp1、Df1、Dp2、Df2均设置为1时的划分情况。 2.2.5 基于局部序列的特征转换 根据2 个不同的说话者划分出的2 个不同子序列“话语”,分别被送到Person one RGCN 和Person two RGCN 进行特征转换运算。本文使用受文献[21-23]启发的特定于关系的转换方法来进行转换运算,通过收集基于非对等上下文窗口(Wp1、Wp2、Wf1、Wf2)的邻居上下文信息(“话语”),可以将某一“话语”vx的特征qx转换为新的特征表示。 在Person one RGCN 中,运算公式如下: 在Person two RGCN 中,运算公式如下: 其中:x=1,2,…,N;表示“话语”vx在关系r∈Ra或r∈Rb下的邻居“话语”的索引集合;cx,r是一个特定于问题的规范化常量,可以通过学习获得或预先设置(如);σ是激活函数;Wr、、Wo2是可以训练的转换参数。 在局部关系图卷积神经网络Person one RGCN和Person two RGCN 中分别计算出局部序列的新特征后,HRGCN 依据会话中发生的时序将2 个局部序列进行级联,形成一个具有N个“话语”的序列(如图2 中的序列),并输送到全局关系图卷积神经网络。 2.3.1 基于非对等上下文窗口的边集合 在全局关系图卷积神经网络中也采用非对等上下文窗口技术。例如,将历史上下文窗口设置为,将来上下文窗口设置为。在图2 的模型中,和的大小分别设置为3 和2,在这2 个窗口值范围内,“话语”序列所产生的边有<1,1>、<2,2>、<5,5>、<2,1>、<5,2>、<5,3>、<5,4>、<3,3>、<4,4>、<6,6>、<4,3>、<6,4>、<6,3>、<3,1>、<3,2>、<4,2>、<6,5>、<4,1>、<1,2>、<2,3>、<5,6>、<1,3>、<2,4>、<3,4>、<4,6>、<4,5>、<3,5>。 2.3.2 基于非对等距离大小的关系划分 在全局关系图卷积神经网络中,边关系类型的划分比较复杂,需要分情况讨论。为了确定某条边的关系类型,本文考虑的因素包括“话语”的时序关系、“话语”的间隔距离关系以及“话语”的说话者关系。 类似于局部关系图卷积神经网络的划分,本文在间隔距离关系方面同样采用基于非对等距离大小的方法。2 个非对等距离分别用和表 示,任 意2 个“话 语”分别用和表 示(i',j'∈[1,2,…,N]),“话语”和所对应的说话者分别用和表示,会话中的第一个说话者和第二个说话者分别用pone和ptwo表示。“话语”和之间相隔的距离设置为d。在图2的模型中,和分别设置为2 和1,则可以得到以下2 种划分情况: 表1 图2 中Global R-GCN 关系划分结果1Table 1 Global R-GCN relationship division result 1 of fig.2 表2 图2 中Global R-GCN 关系划分结果2Table 2 Global R-GCN relationship division result 2 of fig.2 所有的边关系类型用集合Rc表示,即 2.3.3 基于全局序列的特征转换 与局部序列的特征转换计算类似,全局序列的特征转换使用特定于关系的转换方法,基于非对等上下文窗口收集相邻上下文“话语”的信息,然后转换局部特征为全局特征 Global R-GCN 的运算公式如下: 输入的特征数据经过上述层次化的关系图卷积神经网络计算(式(1)~式(3))之后,序列中的每个“话语”都积累了其相邻“话语”的相关信息。最后,将全局关系图卷积神经网络的计算结果输入到一个完全连接层,经过降维后进行预测分类。计算公式如下: 在训练过程中,使用带L2 正则化的交叉熵损失函数来计算损失值: 其中:N表示训练集中所有“话语”的总个数;C是情绪分类的数目;zx,y是训练集中第x个“话 语”属于第y类别的真值;是预测第x个“话语”属于第y类别的概率值;ω是L2 正则化的权重值;θ是所有训练参数的集合。 本文实验基于IEMOCAP 数据集进行[24],该数据集包含总长约12 h 的二元会话视频数据,这些视频共有5 个会话,每个会话又有若干个5 min 左右的交互视频,每个交互视频被进一步划分为若干个切片,这些切片也称为“话语”,所有的“话语”都用多模态(文本、声音以及图像的级联)进行表示,并至少由三名标注人员标注一个情绪标签。本文考虑的情绪标签包括生气(anger)、开心(happiness)、伤心(sadness)、中立(neutral)、兴奋(excitement)、沮丧(frustration)共6 类。表3 所示为IEMOCAP 数据集中各种情绪的分布情况。 表3 IEMOCAP 数据集中各种情绪的分布情况Table 3 Distribution of various emotions in IEMOCAP dataset 参考文献[4,9,11,21]对特征数据集进行预处理,且同一说话者可以出现在训练集和测试集中。在实验过程中,首先将下载的多模态特征数据集随机打乱,然后随机划分出80%作为训练集和验证集,20%作为测试集。本文HRGCN 方法所使用的优化器是Adam[25],学习率设为0.001。为了防止过拟合,采用Dropout[26]机制。在训练阶段设置早停机制,如果验证集的损失值连续10 轮不再下降,则停止训练。实验采用的评估指标是准确率(记为ACC)和F1 分数(记为F1)。 本文在IEMOCAP 数据集上进行会话情绪识别测试。实验中的对比模型如下: 1)LSTM[27],即长短期记忆神经网络,是为了解决一般RNN 存在的长期依赖问题而专门设计出的时间循环神经网络。 2)GRU[28],即门控循环单元,它是为解决长期记忆和反向传播中的梯度等问题而设计出的时间循环神经网络。 3)Local R-GCN,本文HRGCN 方法中的Local R-GCN 模 块,即Person one RGCN 和Person two RGCN 这2 个部分的组合。 4)Global R-GCN,本 文HRGCN 方法中的Global R-GCN 模块。 5)HRGCN(BNN=GRU),在本文HRGCN 方法的BNN 中装载GRU 神经网络。 6)HRGCN(BNN=LSTM),在本文HRGCN 方法的BNN 中装载LSTM 神经网络。 不同模型在IEMOCAP 数据集上的实验结果如表4 所示。从表4 可以看出,HRGCN(BNN=LSTM)模型的识别效果最好,其次是HRGCN(BNN=GRU)模型,效果较差的是Local R-GCN 模型。 表4 不同模型在IEMOCAP 数据集上的实验结果Table 4 Experimental results of different models on IEMOCAP dataset % 本文HRGCN 方法的理论依据是:在会话交互的过程中,一个“话语”的情绪既受到说话者自身情绪变化的影响,也受到说话者之间情绪变化的影响[5-6]。局部R-GCN 模块对说话者自身情绪的变化进行建模,考虑到不同说话者会受到自身情绪变化的影响(有各自不同的表达特点),局部R-GCN 模块使用2 个独立的关系图神经网络进行特征转换。全局R-GCN 模块对说话者之间情绪的变化进行建模。实验结果表明,特征数据经过局部R-GCN 以及全局R-GCN 之后,可以更好地捕获说话者自身以及说话者之间的情绪影响,从而提高会话情绪识别的性能。仅使用局部R-GCN 或全局R-GCN 都不能全面地捕获以上2 个方面的影响,其中的原因可能是:单一的局部建模不能很好地反映会话是一个交互现象,无法很好地捕获说话者之间的情绪影响;单一的全局建模没有考虑到不同说话者各自的特点,无法较好地捕获说话者自身的情绪变化影响。 本文对HRGCN(BNN=LSTM)模型的相关超参数进行分析。令局部R-GCN 计算输出结果的特征维度大小为localSize,全局R-GCN 计算输出结果的特征维度大小为globalSize,本文使用随机参数搜索方法,在实验中得到最优参数组合为localSize=176,globalSize=88。当globalSize 的大小固定为88时,表5 所示为localSize 取不同值时ACC 和F1 的变化情况。当localSize 的大小固定为176 时,表6 所示为globalSize 取不同值时ACC 和F1 的变化情况。 表5 localSize 取不同值时ACC 和F1 的变化情况Table 5 The change of ACC and F1 when localSize takes different values 表6 globalSize 取不同值时ACC 和F1 的变化情况Table 6 The change of ACC and F1 when globalSize takes different values 此外,为了验证预测输出阶段的降维操作是否对情绪识别效果产生影响,本文分析维度取不同值时ACC 和F1 的变化情况。令预测输出阶段的维度大小为hiddenSizeFC,表7 所示为hiddenSizeFC 取不同值时ACC 和F1 的变化情况。 表7 hiddenSizeFC 取不同值时ACC 和F1 的变化情况Table 7 The change of ACC and F1 when hiddenSizeFC takes different values 从表7 可以看出:在开始阶段,随着hiddenSizeFC的增大,ACC 和F1 均略有提高;当hiddenSizeFC 取值58 时,ACC 和F1 达到最好效果;随后,在继续增大hiddenSizeFC 时,ACC 和F1 均略有下降。由此可见,预测输出阶段的维度大小对HRGCN(BNN=LSTM)模型的分类效果具有一定影响。 本文提出一种基于层次化R-GCN 的会话情绪识别方法。该方法利用2 个不同的局部关系图卷积神经网络对输入特征数据进行局部建模,然后使用全局关系图卷积神经网络对所得局部建模结果进行全局建模,从而充分考虑不同说话者自身的特点以及相互之间的依赖关系。在情绪识别基准数据集IEMOCAP 上进行实验,结果表明,相比循环神经网络,该方法的情绪识别性能较高,准确率高达84.48%。但是,本文所提方法仍存在一定的局限性,如涉及的超参数较多、层次化神经网络组合运算成本较高、运算实时性不佳等。因此,下一步将优化参数组合并通过调整神经网络结构等方法来降低模型的运算复杂度。

2.3 全局关系图卷积神经网络

2.4 预测输出

3 实验结果与分析

3.1 数据集

3.2 实验设置

3.3 结果分析

4 超参数分析

5 结束语