基于L1-L0分解的可见光-红外线图像融合方法

2022-01-11常莉红冯福存

常莉红,冯福存

(宁夏师范学院数学与计算机科学学院,宁夏 固原 756000)

1 引 言

红外视觉技术是一种常用的夜视背景增强技术。红外传感器通过采集物体表面的热辐射来获取图像信息,它能探测到人眼在黑暗或者遮挡条件下看不见得物体,而夜间可见光图像通常是用低感光度的CCD相机拍摄,它能提供更适合人类感知的细节和背景物体,因此红外视觉技术常见的一种技术就是将两种不同类型的电磁光谱图像信息进行融合,获得增强的、更全面的场景信息。

近十几年来,人们提出了多种像素级的红外线与可见光图像的融合方法。其中基于多尺度的图像融合算法是最流行的。经典的多尺度图像融合方法主要包括金字塔分解方法,小波变换方法,非下采样轮廓波方法(nonsubsampled contourlet transform,NSCT)[1],脊波变换方法(curvelet transforms,CVT)[2]等。大多数基于多尺度变换的方法的目标是在分解过程中获得更多的定向子带或在各种尺度上获得更好的细节选择。然而,由于红外线图像和可见光图像之间的亮度响应存在着较大的差异,当图像之间的细节不互补时,它们可能会降低可见光图像中的原始感知信息。因此后续的研究工作中出现了许多改进的方法,比较优秀的方法有:①基于学习的方法,比如基于脉冲神经网络的方法[3]和卷积神经网络的方法(convolutional neural network,CNN)[4]等。②基于微分方程的方法,其代表方法有基于四阶微分方程的方法(the fourth order partial differential equations,FPDE)[5]、基于各向异性扩散方程的融合方法(anisotropic diusion and principal component analysis based fusion,ADPCA)[6]等。③基于保边滤波器的方法,比如基于方向滤波的方法(the guided image filter,GF)[7]、高斯滤波融合方法[8]等。这些方法都取得了很好的效果。

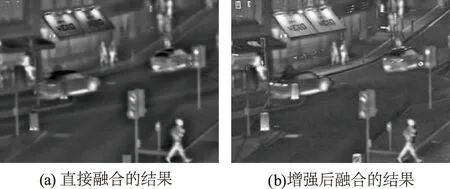

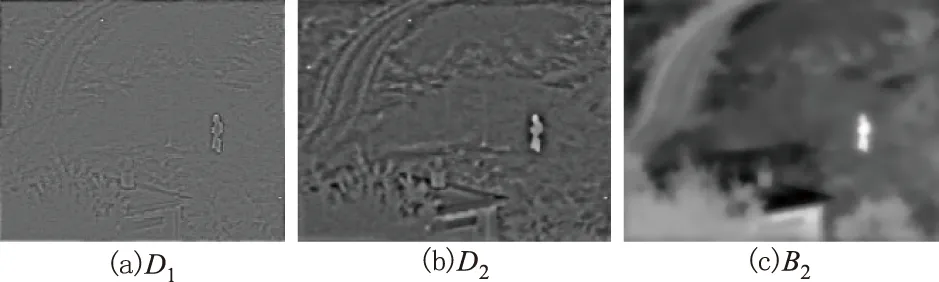

在弱光条件下获得的细节通常在可见光图像中以极低的对比度显示,在这种情况下,直接将它与红外线图像进行融合,并不能改善融合结果中的夜视场景,图1(a)所示,融合结果夜视场景的细节信息模糊不清,图1(b)是对可见光图像进行增强后融合的结果,对比很明显,融合结果中包含了更多的场景细节信息。因此,增强可见光图像的对比度是十分有必要的。另外,红外线与可见光图像融合的结果中还要很好的保留红外线图像中的显著性目标,这样在后续的应用中才是有意义的。

图1 融合结果Fig.1 Fusion results

因此本文基于上述目的,提出了一种基于内容增强的可见光图像和红外线图像的融合方法。与现有的融合方法相比,该方法的主要贡献是利用L1-L0约束的新型图像分解方法[9]对图像进行信息表示,并利用二尺度下的细节层与源图像的差建立视觉显著性权重图对细节层进行融合,利用加权局部能量的融合规则对基础层进行融合,在融合结果中保留了丰富的场景细节和显著性目标信息。

2 相关理论

2.1 方向导波的图像增强方法

迄今为止,人们提出了各种增强算法,其中方向导波的图像增强算法[7]表现出了优秀的性能,能很好的将可见光图像中的每个弱光区域的细节增强,以尽可能提高图像的可见性。具体实施方法是通过对图像成份的分解结合高动态范围压缩实现的。

方向导波是一种局部线性模型,其输出结果qi是引导图Ii在像素k的局部窗ωk中的一个线性输出,其数学表达式为:

(1)

(2)

其中,ε是正则化参数;pi是输入图。

为了方便表示,我们把(1)式中方向导波对图像的作用记作GFr,ε(·),其所实现的图像增强方法可以表示如下四步:

1)利用方向导波对图像I进行分解,先得到图像的基础层Ib=GFr,ε(I)。

(3)

(4)

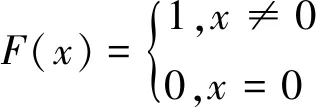

3)利用比例因子β对基础层进行动态范围压缩,然后利用因子γ恢复整体对比度:

(5)

4)最后将增强的图像转换到空间域,其结果为:

(6)

图2给出了一组基于方向导波增强方法的效果图。图2(a)是未增强的可见光图像,光照条件比较差,很多场景内容都无法清晰的看到,图2(b)是所给算法的增强结果,从图中明显看出来,经过该算法增强后,源图像中低对比的夜视场景细节均显示出来了,大大地提高了图像的视觉效果。

图2 可见光图像的增强结果Fig.2 Enhancement results for s set of visible images

2.2 基于L1-L0约束的图像分解方法

Zhang[9]等人通过对图像的细节层和基础层分别施加L1范数结构先验和L0范数的边缘保护先验提出了一种新型的图像分解方法。一方面,由于L1范数的先验约束条件具有离群拒绝性,保留了基础层的大梯度,使得基础层是分段光滑的。另一方面用L0范数的约束条件能产生扁平效应来约束细节层,这样可以强制细节层的小纹理梯度为零(可以去除噪声的影响)的同时保持了视觉上重要的边缘信息和主结构的纹理信息。基于L1-L0约束的图像分解方法的数学优化模型可以表示为:

(7)

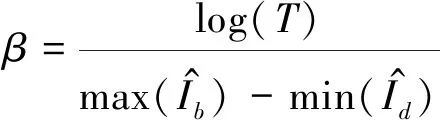

其中,P是像素点;N是像素的总个数;Ip是输入的原图像;Bp是它的基础层;(Ip-Bp)是细节层;(IP-BP)2是强制基础层接近原图像;|∂iBP| 是对基础层所施加的L1范数的约束条件;∂i表示偏导数符号,F(∂i(IP-BP))指对细节层加入L0的梯度约束;λ1和λ2是两个参数(文中取λ1=λ2=0.3)。F是如下指示函数:

(8)

式(7)的优化求解可以用交替迭代法[10]获得。这样对图像I基于L1-L0的二尺度分解可以写为:

(9)

D1=I-B1

(10)

B2=modelL1-L0(B1)

(11)

D2=B1-B2

(12)

其中,modelL1-L0(·)是指对图像通过公式(7)的求解结果;B1是对图像I第一次分解得到的基础层;D1是第一次分解得到细节层;B2是对图像B1再次分解得到的基础层,即是图像二尺度分解下的基础层;D2是二尺度分解下的细节层。

最后通过将各个分解层叠加起来就得到了合成的图像:

I=D1+D2+B2

(13)

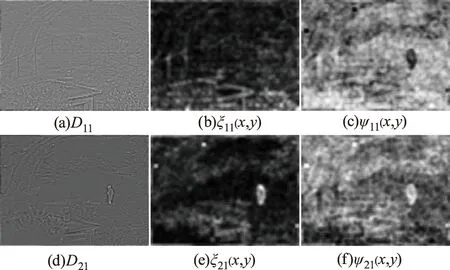

图3给出了基于L1-L0约束分解的一个例子。从图3中我们明显看到基础层B2是大结构信息,不同尺度下的细节层D1和D2保护了不同的纹理细节。

他也许是在说他自己,内心不够纯净,做久了playboy,懒得再相信真心?但是他在努力,他在努力接受她的真心。

图3 基于L1-L0的图像分解Fig.3 Based on L1-L0 image decomposition

3 所提的图像融合方法

第二步:对I1和I2利用(8)~(13)式进行L1-L0的图像分解,分别得到不同尺度下图像的基础层和细节层;

(14)

(15)

第三步:在基础层和细节层上选取不同的融合规则进行融合。

由于基础层B2i(i=1,2)集中了图像的主要能量,因此本文选取加权局部能量(weighted local energy,WLE)[11]的融合规则,其表达式为:

(i+m,j+n)2

(16)

其中,S∈{B21,B22};W是半径为r,大小为(2r+1)×(2r+1)的加权矩阵,本文取r=1,有:

这样得到融合的基础层为:

(17)

细节层包含了图像的纹理细节和噪声,反映的是源图像的小梯度变化,因此可以根据图像梯度构建细节层的梯度显著性图。常见的梯度算子中,Sobel算子相对来说更能平滑图像中的噪声,有效的保留纹理信息,降低噪声的影响。Sobel(·)算子是如下定义的:

Sobel(D(x,y))=|(D(x+1,y-1)+2D(x+1,y)+

D(x+1,y+1)-(D(x-1,y-1)+2D(x-1,y)+D(x-1,y+1))|+

|(D(x-1,y-1)+2D(x,y+1)+D(x+1,y+1)-(D(x-1,y-1)+

2D(x,y-1)+D(x+1,y-1))|

(18)

这样由Sobel(·)算子可以得到可见光和红外线图像细节层的梯度显著性图:

S1i(x,y)=Sobel(D1i) (i=1,2)

(19)

S2i(x,y)=Sobel(D2i) (i=1,2)

(20)

为了增加梯度对权重的影响范围,常常用高斯滤波器对梯度显著性进行扩散,得到最终的梯度显著性图:

ζ1i(x,y)=Gaussian(S1i,δ,r)

(21)

ζ2i(x,y)=Gaussian(S2i,δ,r)

(22)

其中,(x,y)是对应的像素位置;Gaussian(·)是高斯滤波器;δ,r是高斯滤波器的参数,文中取δ=r=5。

这样细节层的权重可以定义为:

(23)

(24)

图4给出了细节层D11和D21的显著性图ζ11(x,y)、ζ21(x,y)和权重图ψ11(x,y)、ψ21(x,y)。

图4 细节层、显著性图和权重图Fig.4 Sources,visual saliency,weight maps

利用显著性和权重图得到融合的最后的细节层为:

Df(x,y)=ψ11(x,y)D11(x,y)+ψ21(x,y)·

D21(x,y)+ψ21(x,y)D12(x,y)+

ψ22(x,y)D22(x,y)

(25)

第四步:将融合的基础层和细节层进行叠加得到融合的图像,即:

If(x,y)=Bf+Df

(26)

4 实验结果及分析

4.1 测试图集

为了测试所提方法的有效性,我们选取了14对红外线图像和可见光图像(如图5所示)进行测试,这些图像来自:http://figshare.com/articles/TNO_Image_fusion_dataset/1008029.

图5 测试集Fig.5 Test set

4.2 客观评价指标

融合结果从两方面进行评价,一方面是主观的视觉效果,另一方面是通过四种专门评价融合结果的客观指标,它们是标准偏差(Standard deviation,SD),熵(Entropy,EN),互信息(Mutual information,MI)[12]和基于结构相似度的梯度QG[13]评价指标,实验结果的指标值越大说明融合效果越好。

4.3 结果与分析

为了说明所提算法的有效性,将本文所提方法分两种情况(一种是可见光未增强直接与红外线图像进行融合,另一种是可见光被增强后与红外线图像进行融合,为了方便前者记作L0L1,后者记作EL0L1)与下面选取的三类5种关于红外线与可见光图像具有代表性的图像融合方法作比较,它们是基于多尺度变换的融合方法(CVT[1],NSCT[2]),基于深度学习的方法(CNN[4])和基于微分方程的方法(ADPCA[5],FDEP[6])。各个方法的参数选取均是对应参考文献中给出的最优选择下的参数设置。

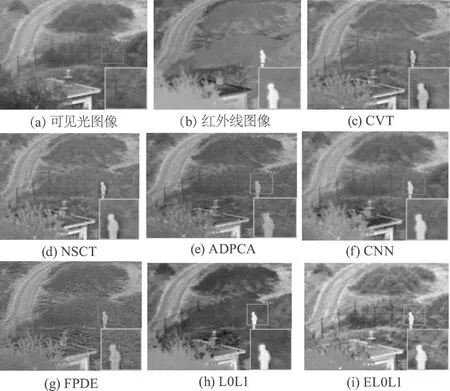

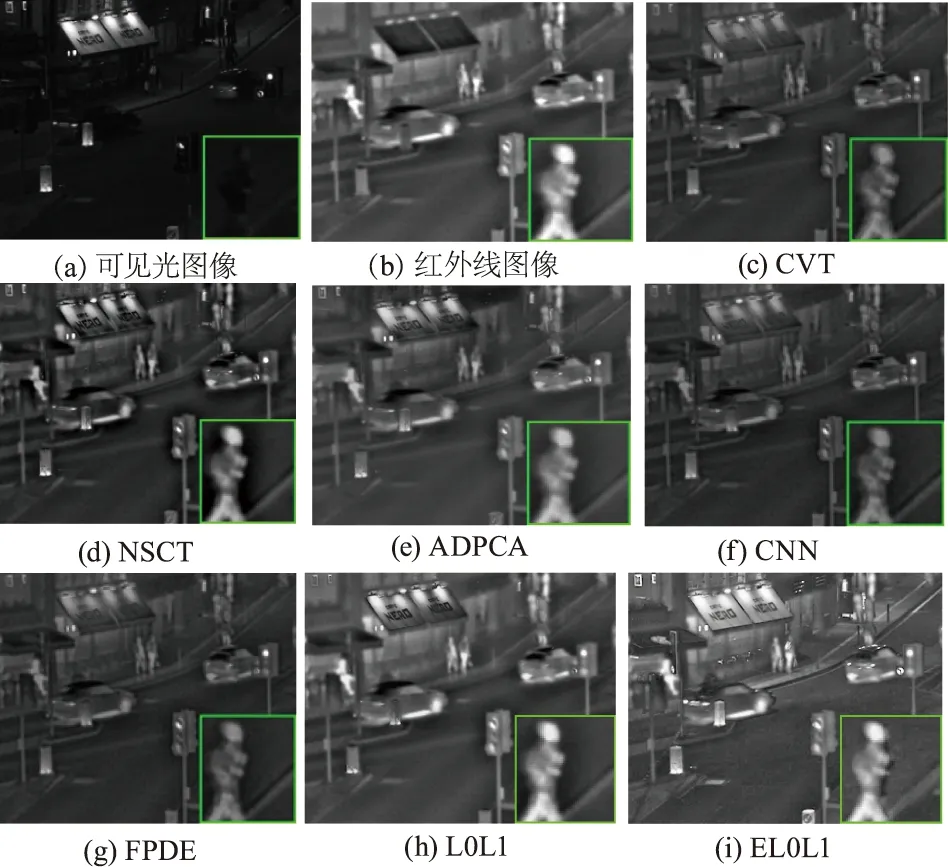

图6和图7给出了两组测试图集中前段所提各个方法的融合效果图。

图6 不同方法对“Nato-camp”图的融合结果Fig.6 Fusion results of different methods for “Nato-camp” image

图7 不同方法对“Street” 图的融合结果Fig.7 Fusion results of different methods for “Street” image “Street” image

图6给出了一组关于“Nato-camp”图的融合结果图。所给的场景中主要包含人、树木、道路、栅栏和屋顶等特征,是一组静态目标图,通过本组图像的对比,六种方法增强后均有效的使红外线图和可见光图的信息得到互补,视觉效果都有了很大的改善。通过山路的路畔和栅栏等清晰度的对比,FPDE图的整体效果相对模糊点。本文所提方法与其他几种方法相比较,L0L1算法保留了红外线图像中的高亮目标,人像比其他方法清晰,但是由于弱光图像的影响,融合后场景中的许多细节信息丢失,例如从视觉上草木处出现了较大的黑影,栅栏也分辨不清。EL0L1算法所得图像的亮度比前五种方法有较大的提高,栅栏和房顶上的烟囱清晰可辨,房屋前树冠上的树叶的轮廓更加清晰。若选取同一对比物,以图中的人像为例,通过放大图像的对比,发现ADPCA图和FPDE图的结果比较模糊,在局部放大的图像中,其他几种方法都出现了人物边缘的伪影,而EL0L1的方法边没有这种现象,这表明所提方法具有很好的保边缘作用,同时还保留了更多的场景细节。

图7给出了各个方法对“Street” 图的融合结果。图像主要包含行人、公交站点、文字、汽车和信号灯等目标特征,此图中涉及光源目标、动态目标较多,是一组动静结合目标图。通过本组图像的对比,六种方法增强后均有效的使红外线图和可见光图的信息得到互补,视觉效果都有了较大的改善。通过各光源点的亮度、站台上方字母、人行道上的路灯杆及行人等清晰度的对比,CNN图的整体效果相对模糊点。本文所提方法与其他几种方法相比较,L0L1图和EL0L1图像的亮度均比前五种方法有较大的提高,L0L1图相对于其他五种方法清晰度没有较大优势,但EL0L1图的亮度更高,图像也更清晰,第一辆汽车顶部路灯的反射光,第二辆汽车后方的路灯杆及没有发光的路灯泡,站台下的一组护栏等在前六图中基本看不到。字母标识牌上的字母比前六图更加清晰。若选取同一对比物,以图中局部放大的行人为例,发现图CVT和FPDE图的结果比较模糊,其他几种方法能较清晰的看到人头部的轮廓,而EL0L1方法比其他方法融合结果的亮度更高一点。通过本文算法加强后EL0L1图的效果较好,更能较多的显示出场景中的细节信息。

图8给出了本文所提各个算法在测试集(14组图像)上每组图像融合结果的EN、SD、MI、 QG指标值的折线图。每张子图上方给出了各算法对该指标值的平均值。从四个指标图像中能清楚的看到本文所提的算法L0L1和EL0L1算法相比较其他五个算法从各个指标上取得了好的结果,特别是EL0L1更为突出,在四个指标上均值都取得了最大,在单个的图像上除了个别图像上单个指标未达到最大,大多数图像上都取得了最大。EN指标图说明了算法能保留更多的源图像中的平均信息,SD指标说明所提算法得到融合图像的对比度。MI是指融合图像中从源图像中携带的信息量,所提方法都取得了较好的效果。QG是指的所给方法的保边的信息,EL0L1算法的值最大,这说明图像中包含了更多边缘信息,因此从视觉上图像更加清晰,这与前面的效果图的分析是一致的。图7的实验结果也再次证实了所提方法可以取得好的结果,这也表明了所提方法能很好的从源图像中保留更多的信息,也具有很好的保护边缘的性能。

图8 各个指标值及其平均值Fig.8 Each metric and its average value

表1给出了几种算法在测试集上运行的平均时间(均为MATLAB语言成像,在Dell Intel®CoreTMi7-7600U CPU@2.80GHz 2.90 GHz 机上测试),本文所提算法EL0L1所用的时间相对于算法CNN少得多,相比较除CNN算法外本文所提的其他算法所用时间差距最大是1.5965 s,最小是0.6223 s,比算法L0L1多1.3164 s,运算的时间成本不是太大,但比较图像融合结果,无论从视觉效果还是指标值的取值,算法EL0L1均是最好的。

表1 各个算法在测试图集上运行的平均时间Tab.1 Average running time of each algorithm on test set

5 总 结

本文基于L1-L0图像分解方法提出了一种可见光图像和红外线图像的融合方法,并结合方向导波的图像增强方法进一步提高了融合图像的细节信息。通过L1-L0的图像分解方法是通过先验约束对图像进行分解的,所得的基础层包含了图像的大的结构,集中了图像的主要能量,因此在该层采用了局部能量保护的融合规则,而细节层包含了主要纹理、噪声和小的结构,都属于小梯度信息,因此采用了梯度显著性图的融合规则。通过实验及其数据分析证明了所提方法,尤其是增强后的算法与不同类型的融合方法比较,无论从视觉上还是客观指标上都取得了较好的效果。