基于引导滤波权重与显著信息优化的红外与可见光图像融合

2021-12-28杨擎宇宋泉宏魏志飞顾一凡

杨擎宇,宋泉宏,魏志飞,顾一凡

(上海机电工程研究所,上海 201109)

0 引 言

红外与可见光传感器能捕获同一目标的不同信息,红外传感器主要采集场景目标的红外热辐射能量大小,受烟雾及风沙影响较小,作用距离远,但和可见光图像相比,红外图像对比度低、分辨细节能力较差。因此融合红外与可见光传感器获取的图像可弥补红外传感器的不足,对于场景信息增强、图像分辨率提升有重要意义,图像融合技术在现代应用技术和计算机视觉中起着越来越重要的作用[1]。

红外与可见光图像融合主流算法为基于多尺度变换的图像融合。最早由Burt和Adelson 提出拉普拉斯金字塔融合算法[2];针对拉普拉斯融合方法的不足,学者们提出基于小波变换的融合[3-4],其在正交性、方向性等方面有更好的表现,但对于二维图像中的特征信息处理欠佳;而后NSCT(non-subsampled contourlet transform)[5]、NSST(non-subsampled shearlet transform)[6]等方法被提出并被证实具备更优的方向性及重构效果,但算法复杂性高且融合过程会丢失信息,存在图像失真的现象。近几年为了改善传统多尺度融合算法的缺陷,边缘保持滤波器在图像融合中逐步得到应用,此类方法在去除伪影及噪声并保持边缘方面有出色的表现。Yadav 和Jain[7]使用基于双边滤波的融合方法获取了更优的融合效果,为了提升效率,研究人员又将引导滤波应用在图像融合中[8-9],同时结合双尺度分解完成融合,避免了多层分解带来的信息冗余,但该方法融合权重系数选取对不同图像适应性不足,背景噪声也未有效滤除。

为了解决上述问题,本文提出一种基于权重与显著性信息优化的引导滤波图像融合方法。首先考虑到人类感官对于物体轮廓的敏感性,通过边缘提取作为显著性信息提取;随后使用滑动窗口计算局部梯度优化权重系数;最后选择合适的细节层与基础层融合系数,强化细节信息完成图像融合。

1 算法介绍

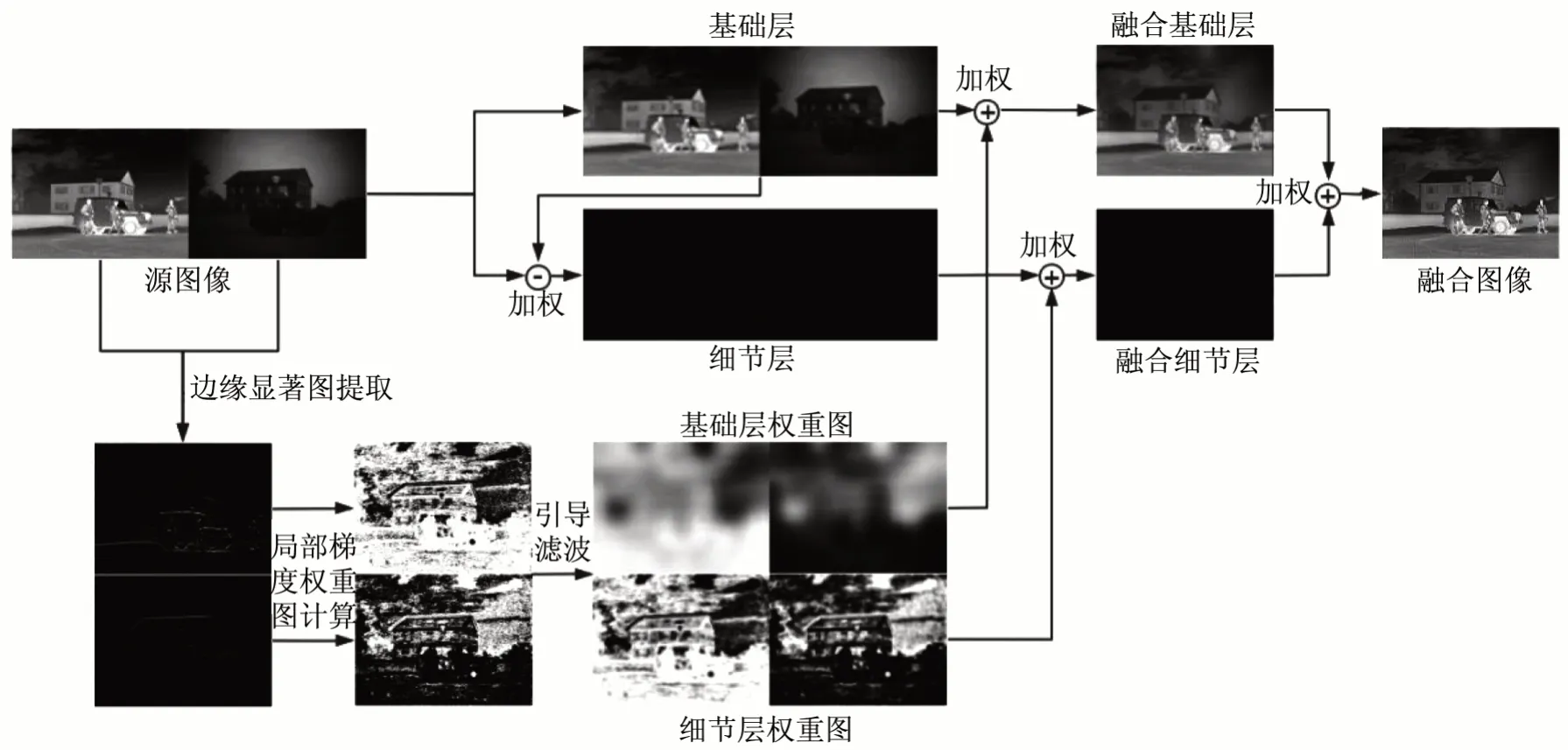

图像融合算法中常用的图像多层分解融合执行效率低且会导致信息冗余,而直接加权或进行主次成分替代的融合算法细节缺失严重,因此本文采用高斯滤波将红外与可见光图像分解为基础层与细节层,提取边缘作为显著图。考虑到像素邻域影响,通过滑动窗口计算显著图像素点局部梯度获取权重图;进一步由引导滤波去除伪影及可能的噪声点,并将细节层与基础层权重图与各自图层加权融合,得到最终的融合图像。图1给出了本文算法流程框架。

图1 基于局部梯度与边缘显著提取的引导滤波图像融合算法框架Fig.1 Guided filtering image fusion algorithm framework based on local gradient and edge saliency extraction

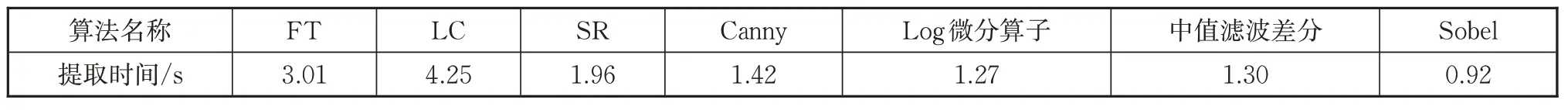

1.1 双尺度分解

双尺度分解将图像分解为基础层与细节层,通过高斯滤波对图像做模糊化处理获取基础层,可表达为

式中:G为高斯滤波,根据经验值滤波窗口大小选择为11×11,标准差选择为5;I表示光源图;B为输出基础层;下标k表示图像类型,k=1 表示红外源图,k=2 表示可见光源图。

细节层Dk则由输入源图减去基础层获得,即

1.2 显著图提取

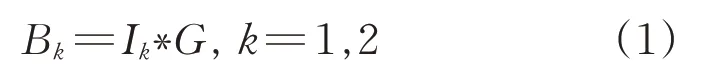

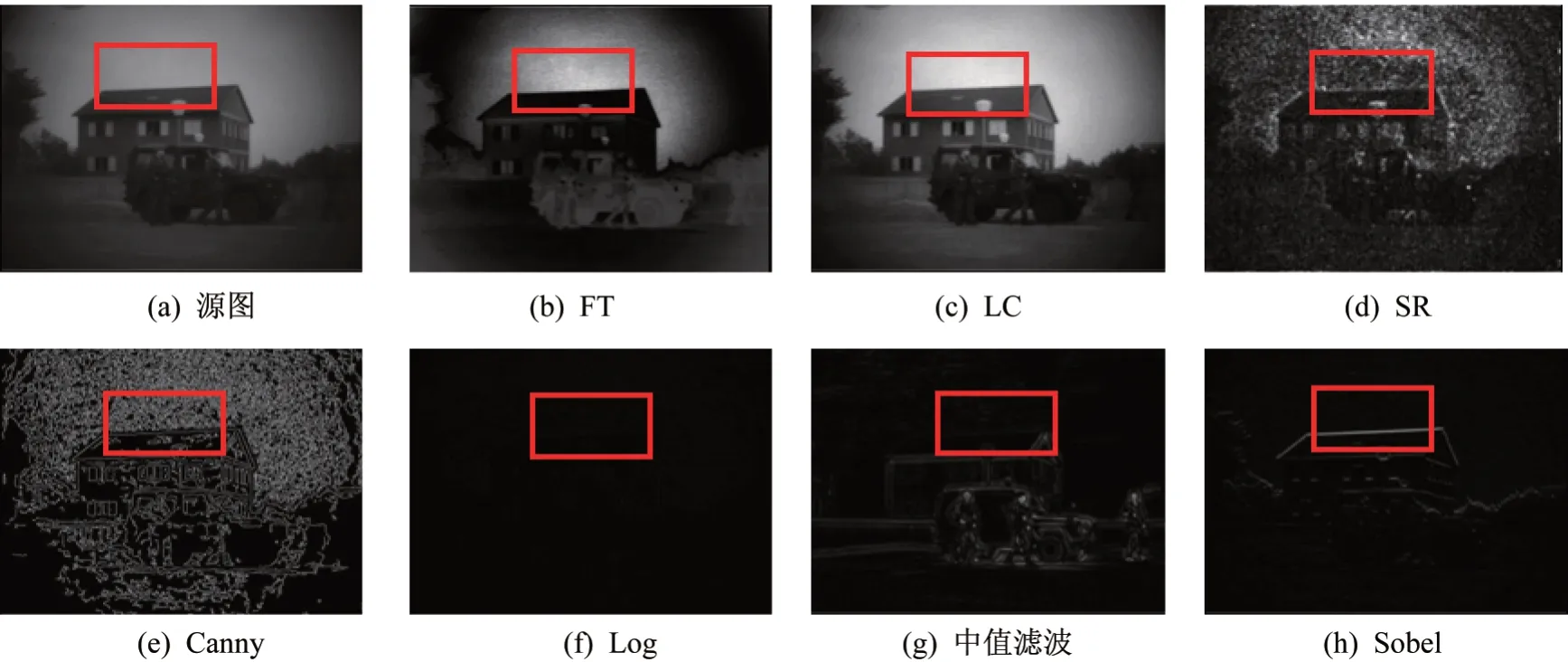

基础层与细节层的权重图构造由提取的图像显著性计算决定,传统的显著性信息提取算法(如FT(frequency-tuned salient region detection)算法)是将色彩进行转变,经过统计欧氏距离进一步得出显著图,由于需计算显著性区域,其算法效率并不高。而对于人类感官,一般通过物体的基本轮廓信息便能判断物体所属类型,因此为了加快处理速度,可以通过提取边缘直接作为显著性信息。为了说明问题,本文对比了几种具有代表性的边缘提取算法与传统显著性信息提取算法的结果,如图2所示。

图2 显著信息提取Fig.2 Extraction of saliency information

由图2 可知,在晚间或者傍晚光线昏暗的可见光图像中背景天空中存在大量白噪声,而FT 及LC(luminance contrast)算法提取的显著性信息并没有剔除这种大片的背景噪声;SR(spectral residual)算法对于图像中细微对象和多纹理细节最为敏感,因而其提取的显著性信息中同样存在大量敏感噪声点;Canny边缘检测算法将背景白噪声误判为多个小边缘,其提取的边缘图并不适合作为显著性信息;在观察源图(a)时,人类感官的注意力首先集中于梯度及对比度变化较大的房屋及屋顶边缘,相比于Log 与中值滤波提取的显著性信息,Sobel算法获取的显著图更好地捕捉到了屋顶等信息。同时选取大小为505×510 的图像,统计十次运行时间的平均值,其中Sobel 算法效率最高,综上Sobel 算法处理本文所选数据集效果更好,速度更快,因此本文采用Sobel 算法获取边缘信息T1和T2作为显著性信息。

表1 不同算法显著性提取时间对比Tab.1 Comparison of saliency extraction time of different algorithms

1.3 引导滤波

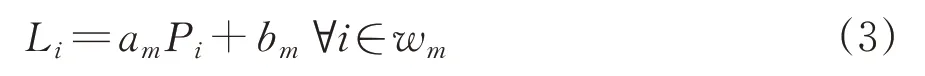

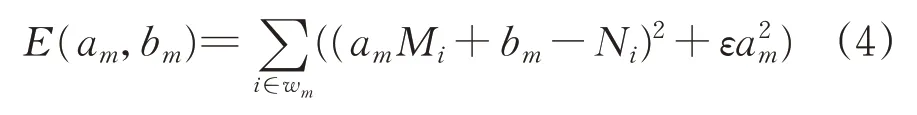

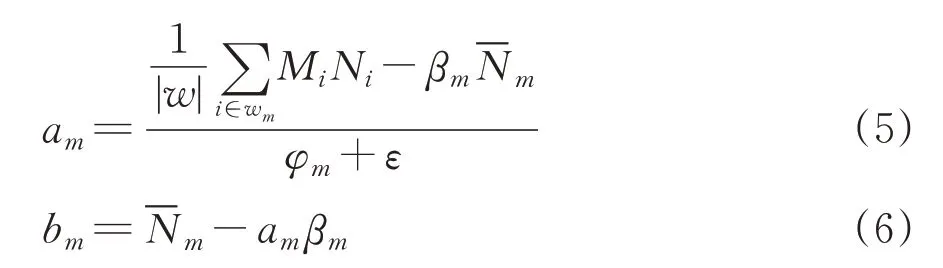

引导滤波(guided filtering,GF)是一种局部线性滤波器,其输出图像L 是中心在像素m 处的局部窗口对引导图像P的线性变换[10],可表达为

我的家乡是一座古老的小镇,那里紧靠一望无际的长阳湖,一条条清澈见底的小溪从小镇欢快地流过,小溪之间是一片一片肥沃的田野。

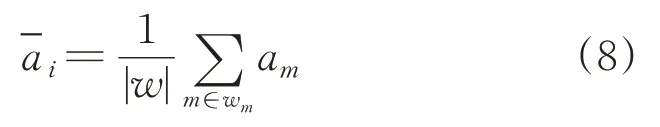

式中:wm是边长为(2r+1)的正方形窗口;am和bm为线性系数,通过最小化输入图像Mi 与输出图像Ni 平方差来决定,即代价函数

式中:ε为正则化参数。

am和bm可进一步由线性回归得到,即

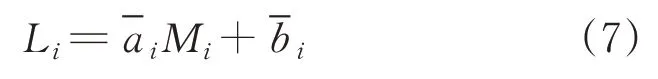

式中:βm和φm分别是图像Mi 在窗口wm的均值和方差;|w|为wm中的像素数量;是Ni 在窗口wm中的均值。由于不同的wm窗口计算输出Qi时,其值都将发生变化,因此对系数am和bm的所有可能值进行平均,最终的滤波输出为

引导滤波计算时间与滤波窗口大小的选择无关,即与w无关,相比于双边滤波效率其融合效率更高。

1.4 基于滑动窗口的局部梯度滤波

红外与可见光图像蕴含的信息不同,可根据提取的源图显著性信息构造权重图作为最终融合的判断依据,但由于噪声影响,单纯地对比单个像素显著性高低的置信度不高,同时也忽略了邻近像素的影响。因此,本文根据提取的红外与可见光显著图,通过滑动窗口计算局部梯度并进行对比,以构建权重图,在充分考虑像素邻域点的基础上一定程度平滑了噪声。

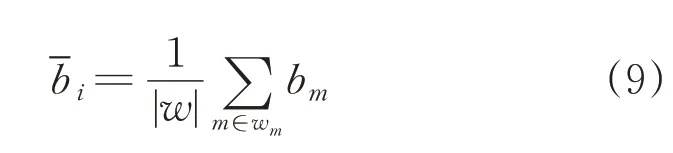

使用Sobel 算子计算源图1 与源图2 相同区域梯度

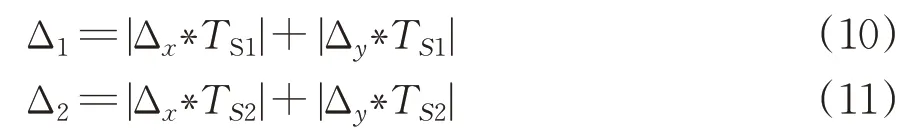

式 中:Δx=为提取的显著图T1的3×3 区域;TS2为提取的显著图T2的3×3区域,得到的权重R1和R2为

初步构建的权重图由于图像配准误差等问题,存在伪影以及噪声的影响,因此进一步使用引导滤波进行处理,在平滑噪声、减轻伪影的同时保持边缘细节。

式中:Bk为基础层;Dk为细节层;为基础层权重系数;为细节层权重系数。

1.5 细节层与基础层融合策略

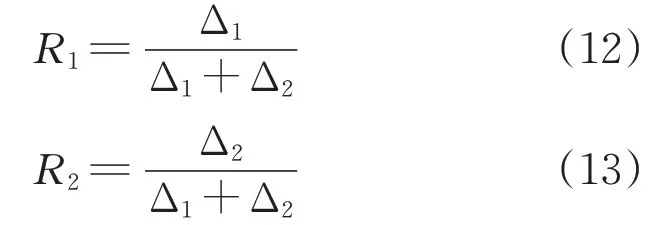

细节层与细节层权重图融合为

基础层与基础层权重图融合为

由于使用滑动窗口计算局部梯度与局部对比度优化权重系数,并对权重图进行引导滤波处理,导致部分细节信息的损失,为了强化细节信息,本文给细节层附属一个加权系数n。

系数n小于1时无法起到强化细节的作用,而n过大时会导致图像失真。通常细节层与基础层融合时系数n取1~3,本文通过实验综合对比融合效果,为了在避免融合失真的同时增强细节,系数n取2.5。

2 实验结果及分析

为验证本文算法,本文从红外与可见光图像数据库(已配准)中选取了3 组图片[11],分别为“Smoke”、“Jeep”、“Kaptein”。“Smoke”是典型的烟雾遮蔽场景,能验证算法在复杂场景中烟雾遮蔽情况下的融合性能;“Jeep”包含大片天空云背景,主要考察算法在单一背景中特征的融合保留能力;“Kaptein”包含诸多纹理细节,是为了体现算法在减少细节损失及伪影的性能。同时选择了以下具有代表性的5种经典算法进行对比:基于双树复小波变换与稀疏表示的融合算法(DTWCT-SR)、基于引导滤波的图像融合算法(GFF)、基于潜在低秩表示的融合算法(LatLRR)、基于梯度转移和总变分最小化的融合算法(GTF)、基于多尺度奇异值分解的图像融合(MSVD)。通过主观、客观、运行时间对本文算法的融合效果和快速性进行评价,所选择的对比算法的参数均使用文献[8]中参数。

2.1 主观分析

图3 为不同融合算法处理“Smoke”的实验对比:图3(c)、图3(e)和 图3(g)分 别 为DTWCT-SR、LatLRR 和MSVD 算法融合效果,融合后人物边缘较为模糊,同时背景树干部分细节也不易分辨;图3(d)为GFF实验结果,其背景树干的诸多细节没有很好的体现;图3(f)为GTF 算法融合效果,烟雾轮廓完全丢失,人物边缘模糊化较为严重;图3(h)为本文算法融合效果,背景树干的细节得到了极大的保留,且人物边缘明显。

图3 不同算法融合“Smoke”效果图Fig.3 Different fusion algorithms process the"Smoke"effect

图4 为“Jeep”实验结果,其中:GFF 算法效果图中天空信息严重损失,丢失了云彩信息,说明GFF 算法受背景噪声的影响较大;DTWCT-SR、LatLRR 与MSVD 算法效果图中天空信息虽然得到了很好的保留,但整体对比度下降,红外图像中车辆及人的信息在融合后有较大的损失;GTF算法融合后图像整体对比度得到提升,但车辆、人物以及房屋的细节特征被严重模糊;而本文算法在极大程度地保留了天空信息后,车辆、人物以及房屋的边缘细节处理效果都明显优于其他算法。

图4 不同算法融合“Jeep”效果图Fig.4 Different fusion algorithms process the"Jeep"effect

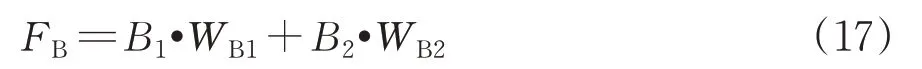

图5 为“Kaptein”融合结果:DTWCT-SR 算法在图像边缘处都存有黑色轮廓,尤其是人物周围最为明显,同时树干部分存在重影;GFF 算法整体过度平滑,损失了灌木丛大量的枝叶细节信息,并且在明显标志物边缘与天空背景的过度不够自然;LatLRR 与MSVD算法则是存在较大的伪影问题;GTF算法效果欠佳,边缘细节丢失严重,还存在伪影、天空失真的问题;而本文算法综合权重了源图信息,极大程度地分别保留了两幅源图中高价值信息,同时也不存在伪影以及边缘非自然过渡的问题。

图5 不同算法融合“Kaptein”效果图Fig.5 Different fusion algorithms process the"Kaptein"effect

2.2 客观评价

客观分析方面则采用4种无参考图像融合[12]质量评价方式:信息熵(IE)[13]、平均梯度(AVG)、盲图像质量指标(BIQI)以及互信息(NMI)[14]。信息熵主要评价融合后图像信息量大小,熵指标越高,图像所含信息量越大,质量越好;平均梯度可以反应图像的微小细节表达能力,主要评价图像细节的融合质量,平均梯度越大表明图像越清晰;盲图像质量指标用于判断融合图像失真程度,即信息融合后的信息损失情况,该值越小表示损失越小,图像质量越佳;互信息评价融合图像从源图像获取的信息量大小,该值越大表示获取信息越丰富。

表2给出了不同融合方法的客观评价结果。IE指标中本文方法虽然在“Jeep”图像中略低于GTF 融合策略,但在“Smoke”、“Kaptein”两组图像上IE 指标表现优异,说明本文算法充分保留了源图像有效信息。AVG 和BIBQ 指标上本文算法表现均远优于DTWCT-SR、GFF、LRR、GTF、MSVD,说明本文算法融合后的图像细节表达能力强,保留了更多源图细节,融合质量最高。对于“Jeep”图像,NMI 评价指标中GTF 算法指标高于本文算法,这是由于GTF 融合时考虑了更多的红外图像信息,但GTF融合后的细节损失严重,而本文算法权衡考虑红外与可见光图像细节与梯度信息,更好地提取了源图有效信息,且对于其他两组图像本文算法的NMI 指标排列均为第一。综上,相比于DTWCT-SR、GFF、LRR、GTF、MSVD这五种算法,本文算法性能更优。

表2 融合效果客观评价Tab.2 Objective evaluation of fusion effect

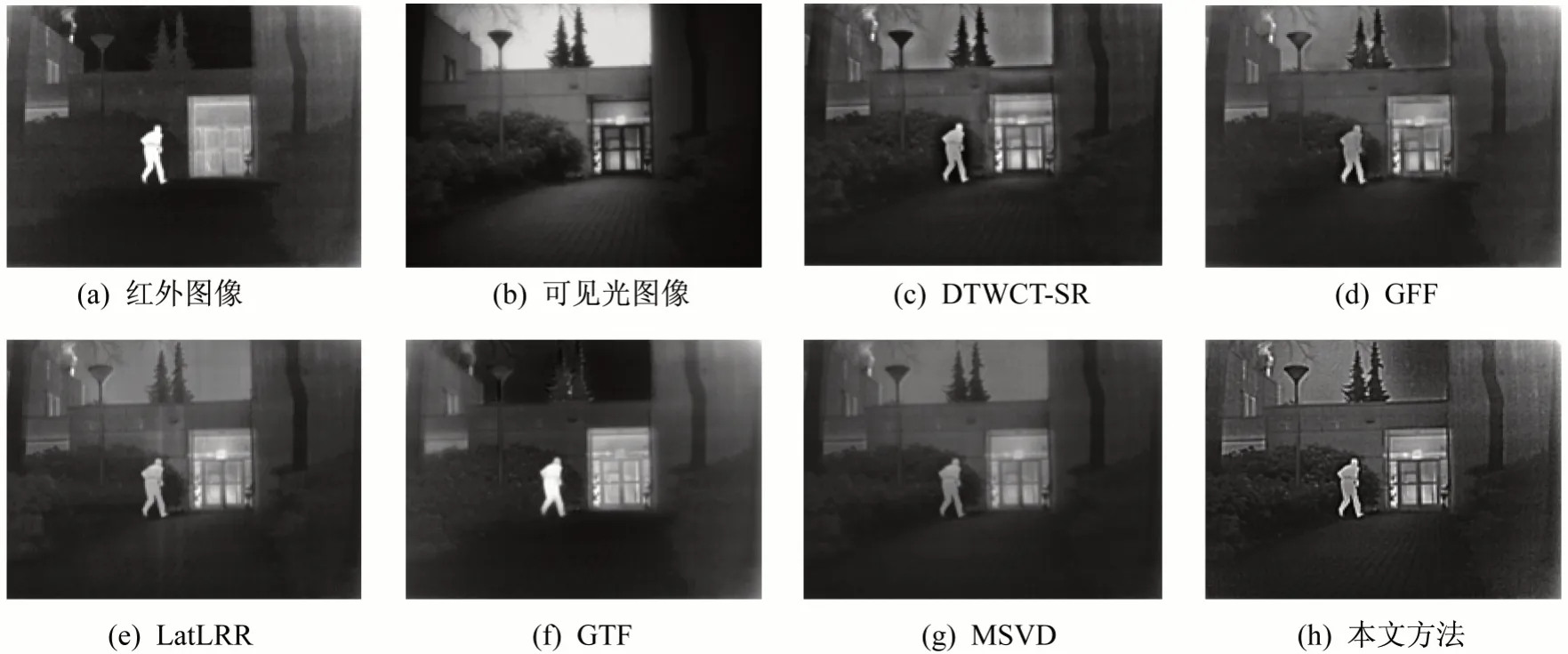

2.3 运行时间

取大小为505×510 的图像,统计十次运行时间并取平均。对比各个融合算法运行时间(见表3),DTWCT-SR、GFF、和MSVD 融合算法计算时间较短,但上述算法融合后细节信息损失较多,整体对比度偏低;LatLRR 算法虽然效果不错,但运行时间过长;本文算法运行时间略长于GTF 算法,这主要是由于采用滑动窗口增加了计算代价,但本文算法不受区域噪声影响,细节信息得到强化,融合效果大幅提升,后续可针对性优化,提升算法效率。

表3 计算代价对比Tab.3 Calculation cost comparison

3 结束语

本文提出了一种基于权重与显著性信息优化的引导滤波红外与可见光图像融合算法。提取目标主体轮廓作为显著性信息,避免区域噪声影响,同时使用滑动窗口计算局部梯度优化权重系数,减轻单个噪声点的影响且提升权重图置信度;借助引导滤波去除伪影及噪声影响,并改变细节层与基础层融合系数,强化融合细节信息。实验结果表明,本文提出的融合算法在信息熵、平均梯度、盲图像质量及互信息指标方面表现优于常用的5 个具有代表性的融合算法,且融合方面后保留了更多的纹理细节信息,可视性更强。