基于联合低秩稀疏分解的红外与可见光图像融合

2021-09-29王文卿

王文卿 马 笑 刘 涵

(1. 西安理工大学自动化与信息工程学院, 陕西西安 710048; 2. 西安理工大学陕西省复杂系统控制与智能信息处理重点实验室, 陕西西安 710048)

1 引言

由于不同类型传感器的成像机理存在较大差异,多传感器可以为同一场景提供不同的图像数据。例如,红外传感器基于目标产生的热辐射成像,在全天时和全天候条件下具有良好的目标发现能力。然而,红外图像分辨率通常较低,缺少纹理、边缘等细节信息。可见光传感器是基于外观信息丰富的反射光成像,可见光图像具有清楚的细节纹理信息和较高的分辨率。然而,场景中的目标由于隐藏在黑暗、丛林或者烟雾中却无法清晰成像。因此将红外与可见光图像融合可互补两种图像的特性,得到一幅细节信息丰富的融合图像。目前,红外与可见光图像融合技术在目标识别、检测和视频监视等领域中得到广泛应用[1-3]。

像素级图像融合直接作用于原始输入图像,能够保留原始图像中丰富的细节信息,提取图像的重要信息并将获取信息以最小的失真或损失转化为融合图像是像素级图像融合的关键。近几十年来,人们已经提出了众多有效的红外与可见光图像融合方法,归纳起来可分为四类:基于多尺度变换的融合方法,基于稀疏表示的融合方法,基于神经网络的融合方法和基于显著性的融合方法[4]。

基于多尺度变换的图像融合方法是目前红外和可见光图像融合领域的研究热点[5]。多尺度变换可以实现源图像由细到粗不同尺度的分解,且许多研究证明多尺度变换与人们的视觉感知一致,可使得融合图像具有良好的视觉效果。基于多尺度变换的融合方法主要包括三个步骤。首先,将红外和可见光源图像分别分解成不同尺度的若干层。然后根据规定的融合规则对多尺度系数进行融合;最后进行多尺度逆变换可获得最终融合图像。多尺度变换方法的选择和融合规则的设计是实现该类方法的两个关键步骤。红外与可见光图像融合中常用的多尺度变换有金字塔变换、小波变换、轮廓波变换、剪切波变换、边缘保持滤波器等[6-10]。尽管变换系数可以合理地表示图像的重要特征,但是每种变换都有自己的优缺点,因此选择一种最优的多尺度变换由具体场景信息决定。

稀疏表示理论以其良好的表征人类视觉系统能力,在计算机视觉、机器学习、信息融合等不同领域得到了广泛应用。稀疏表示遵循输入信号可以近似地由过完备字典中的原子稀疏线性组合表示。文献[11]首次利用稀疏表示模型解决图像融合问题。首先,采用滑动窗口策略将每幅源图像分解为若干个重叠的图像块。其次,通过正交匹配算法对每一个图像块进行稀疏编码获得稀疏系数。然后,采用稀疏系数向量的范数作为活跃级度量对稀疏系数进行融合。最后,利用融合稀疏系数和过完备字典重构最终融合图像。构造过完备字典和稀疏编码是基于稀疏表示图像融合的两个关键问题。文献[12]采用了同时正交匹配算法进行稀疏编码,保证相同位置的源图像块可以由字典中相同的原子子集表示。此外还采用K-SVD算法从大量自然图像块中学习得到字典,代替了离散余弦变换基构造的字典。文献[13]采用形态学分量分析模型获得源图像的卡通和纹理分量的稀疏表示,根据不同分量的特性设计合适的融合策略。文献[14]提出了自适应稀疏表示的图像融合方法,其通过学习训练样本的不同梯度方向信息构建字典,根据图像块的梯度信息在字典集中自适应选择合适的字典进行稀疏编码。为了克服传统稀疏表示采用基于图像块编码存在细节保持能力有限和对误配准的敏感性高的不足,文献[15]提出了基于卷积稀疏表示的图像融合方法。基于稀疏表示的方法取得很好的融合结果,但由于稀疏求解过程复杂,使得计算复杂度很高。

近年来深度学习方法也逐渐地被用到图像融合领域。文献[16]提出基于卷积神经网络的红外与可见光图像融合方法,在拉普拉斯金字塔结构上使用卷积神经网络来提取图像特征并构造权重图。文献[17]构建并训练了一个端到端的生成对抗性网络模型来融合红外和可见光图像。文献[18]提出了一种端到端的聚合残差密集网络结构,充分利用了残差网络的密集结构优势,实现了红外与可见光图像的有效融合。

基于显著性的融合方法作为红外与可见光融合的代表性框架之一,可保持显著性目标区域的完整性,提高融合图像的视觉质量。权重计算和显著目标提取是两种不同的实现方法。前者通常和多尺度方法相结合,将红外与可见光源图像分解成基础层和细节层,然后对基础层或细节层采用显著性提取模型获得显著图并计算得到权重图,根据权重图实现基础层和细节层图像的融合,最后通过融合的基础层和细节层重构融合图像。文献[19]提出基于多尺度边缘保存滤波和引导滤波的红外与可见光图像融合方法,采用相位一致性来获取基础层和细节层的显著图,然后对显著图进行引导滤波获得权重图。后者通常采用显著性模型提取红外图像的显著性区域,使得融合图像具有良好的视觉效果。文献[20]采用基于超像素的显著性模型获得红外图像的显著性区域,很好地保留了红外图像的目标信息。

为了更好地提取红外图像的显著目标,且考虑到红外与可见光图像的相关性,本文提出了一种基于联合低秩稀疏(Joint Low-rank and Sparse, JLRS)分解的红外与可见光图像融合方法。与传统低秩稀疏分解不同,该方法假设红外与可见光图像具有共有的低秩分量,将源图像联合分解成共有低秩分量,特有低秩分量和特有稀疏分量三部分。针对特有低秩分量和特有稀疏分量的不同特点,采用基于非下采样Shearlet变换(Non-Subsampled Shearlet Transform, NSST)和区域能量的融合方法分别对特有低秩分量和特有稀疏分量进行融合。最后将融合的特有低秩分量和特有稀疏分量与共有低秩分量合并重构最终的融合图像。实验结果表明本文算法能够有效地提取红外图像中的目标信息和保留可见光图像的背景信息,提高目标显著性,并且在主观视觉和客观评价指标方面都明显优于对比算法。

2 联合低秩稀疏分解

低秩稀疏分解是一种有效的图像表示模型,在图像分类、图像去噪、图像对齐等研究中表现出良好性能[21]。对于一幅数字图像,为了利用高维数据中的低秩低维结构,可将图像矩阵分解成高度相关的低秩部分和近似噪声或野点的稀疏部分。设输入图像矩阵为X=[x1,x2,…,xn]∈Rm×n,则有:

(1)

其中:L和S分别代表低秩分量和稀疏分量,rank(L)表示L的秩,||S||0表示矩阵S的0范数。然而,上述求解过程是NP-hard问题。为了得到最优解,通常将(1)转化为凸优化问题,如(2)所示:

(2)

其中:||L||*表示矩阵L的核范数,||S||1表示矩阵S的1范数。

针对多幅图像分解,原始低秩分解方法是逐一对源图像进行单独分解。然而,此方法忽略了多幅源图像之间的相关性。因此,文献[22]提出了一种联合低秩稀疏分解模型。该模型假设数据矩阵由三部分组成:共有低秩部分、特有低秩部分和特有稀疏部分。假设Xq=[xq,1,xq,2,…,xq,n]∈Rm×n(q=1,2,…,Q)表示第q幅输入图像,Q为输入图像的总个数。因此,Xq可以被写成以下三个分量之和:

Xq=Lc+Lq+Sq

(3)

其中:Lc表示共有低秩分量,Lq和Sq分别表示第q幅图像的特有低秩部分和特有稀疏部分。通过求如下解优化问题(4),可以恢复出分解后的三部分分量。

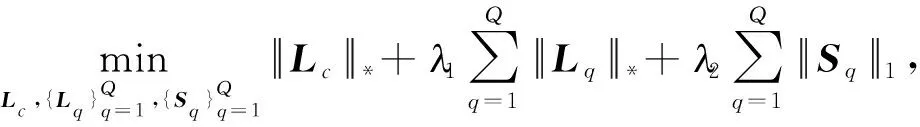

(4)

其中:λ1和λ2表示正则化参数。増广拉格朗日乘子法可以求解凸优化问题。公式(4)的増广拉格朗日函数为:

(5)

然后使用交替方法乘子法(Alternating Direction Method of Multipliers,ADMM) 求解以下最小化问题可以获得最优解。

(6)

3 本文算法

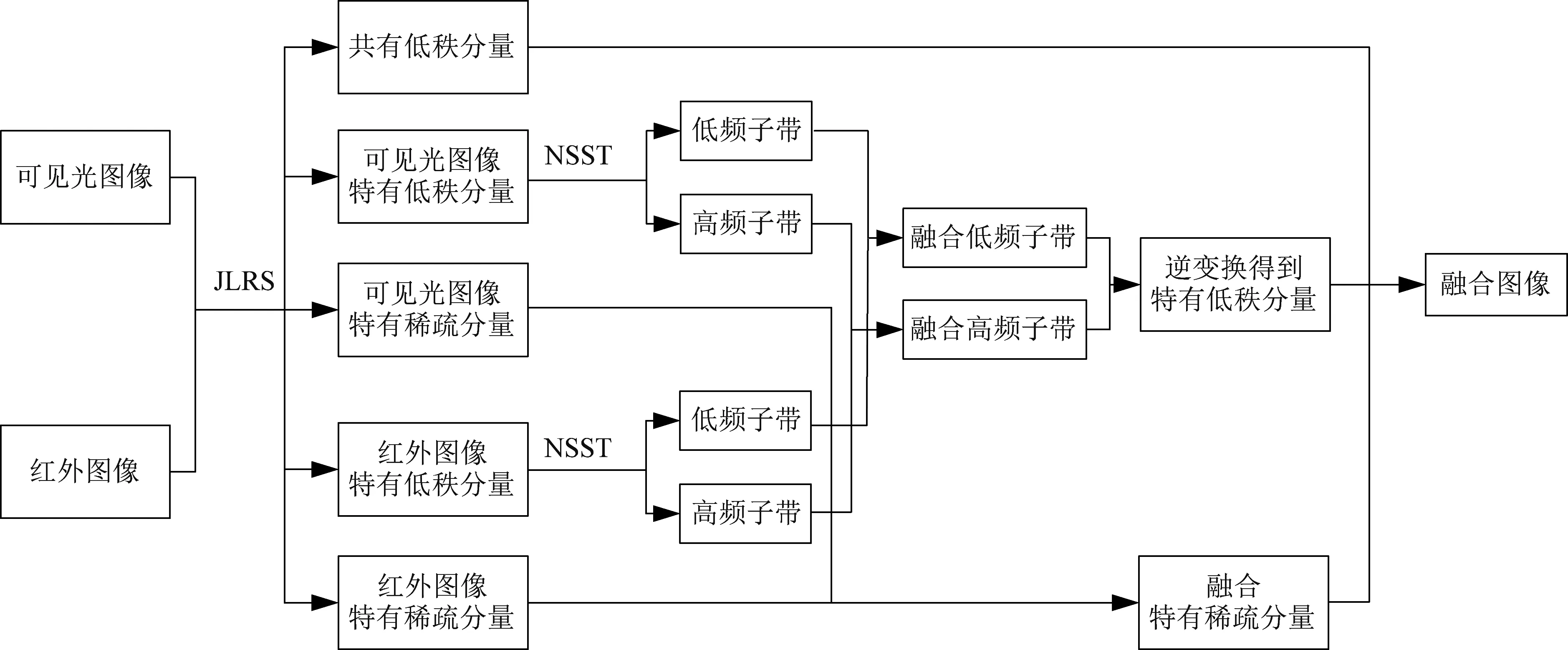

本文提出了一种基于联合低秩稀疏分解的红外与可见光图像融合算法,其算法流程如图1所示。本方法主要包含以下四个步骤:源图像联合低秩稀疏分解、特有低秩分量融合、特有稀疏分量融合与融合图像重构。具体实现步骤如下。

图1 算法框架Fig.1 Algorithm framework

3.1 联合低秩稀疏分解

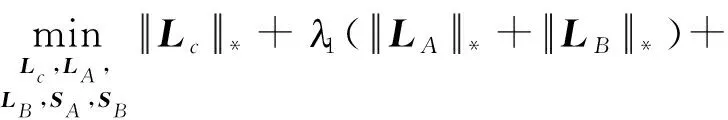

利用联合低秩稀疏分解模型将红外图像IA和可见光图像IB联合分解成共有低秩分量、特有低秩分量和特有稀疏分量。分解过程如式(7)所示:

(7)

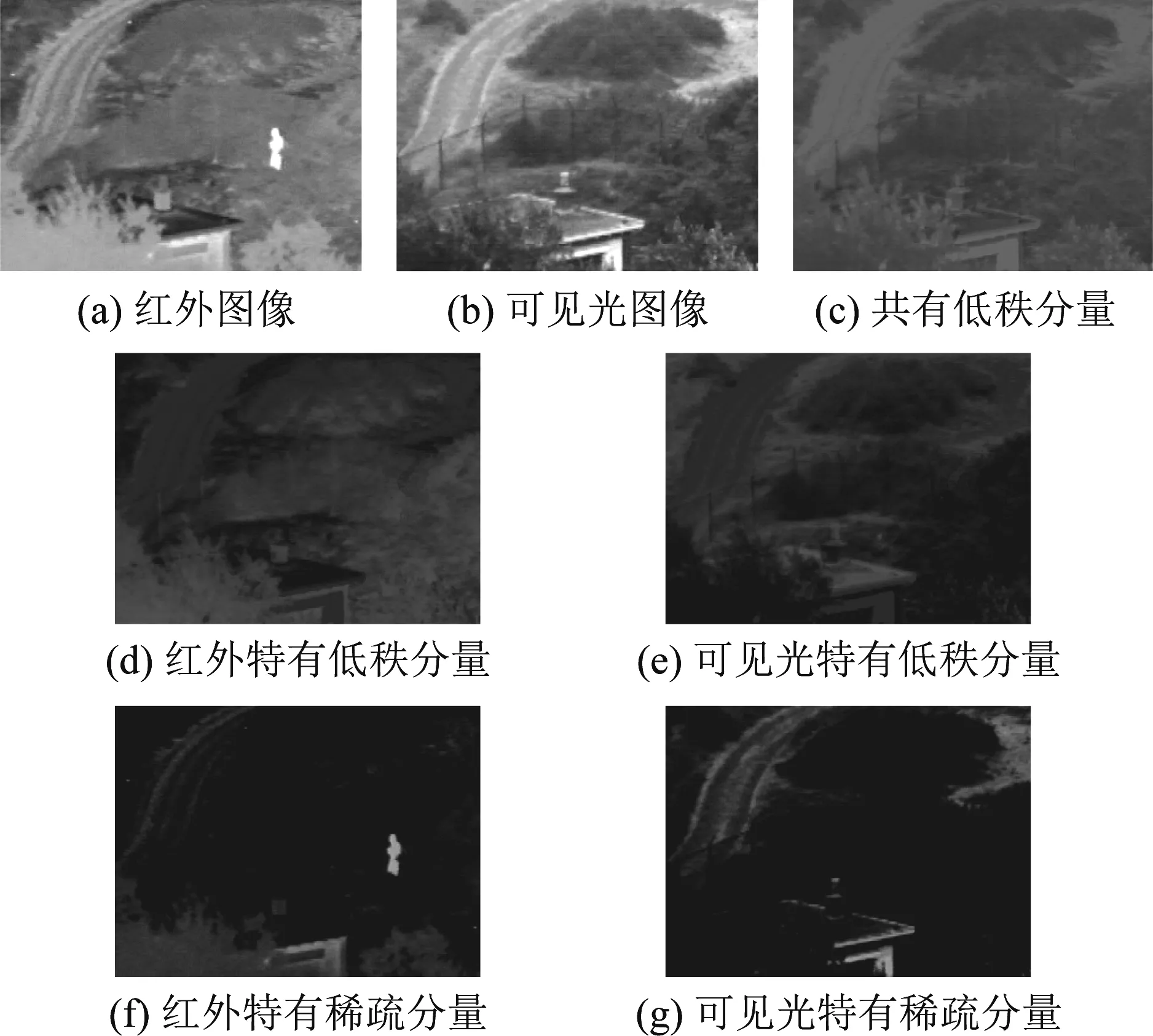

其中:Lc表示红外与可见光图像的共有低秩分量,LA和LB分别表示红外与可见光图像的特有低秩分量,SA和SB分别表示红外与可见光图像的特有稀疏分量。图2所示为一组红外与可见光图像的联合低秩稀疏分解结果。图2(a)和(b)分别表示红外图像与可见光图像。红外图像中行人目标温度较高则可以清晰地发现,但图像的背景信息清晰度很低,分辨率明显低于可见光图像。可见光图像中细节纹理明显清晰,但隐藏在丛林中的人物目标无法被观察到。图2(c)表示共有低秩分量。从图中可以看到,其保留了两幅图像的共有轮廓信息。图2(d)和(e)分别表示红外和可见光图像的特有低秩分量。从图中可以看到,两幅图分别包含了红外图像和可见光图像各自特有的背景信息,其中蕴含着源图像的部分纹理细节信息。特有稀疏分量如图(f)和图(g)所示,包含着源图像的显著目标信息。针对特有低秩分量与特有稀疏分量,分别构建了不同融合策略。

图2 红外与可见光图像联合低秩稀疏分解Fig.2 Joint low-rank and sparse decomposition of infrared and visible images

3.2 特有低秩分量融合策略

3.2.1低频子带融合

低频子带蕴含特有低秩分量的绝大部分信息。为了更好地保留有效信息,去除冗余信息,本文采用基于稀疏表示的融合策略对特有低秩分量的低频子带进行融合。具体实现步骤如下:

2)利用稀疏表示模型对每一个图像块进行稀疏分解,获得每一个图像块的稀疏系数。

(8)

(9)

(10)

(11)

(12)

将所有融合后的图像块向量转换成为图像块,对重叠区域进行平均可得到低频子带融合图像FL。

3.2.2高频子带融合

2)对初始决策图采用一致性检验得到最终决策图,如式(13)所示。

(13)

(14)

3.3 特有稀疏分量融合策略

特有稀疏分量主要包含源图像中亮度较大的目标信息。能量常用来描述图像的亮度特征,为了减少能量的损失,保留图像中的显著目标,本文采用区域能量取大的融合策略对特有稀疏分量进行融合。

红外图像特有稀疏分量SA和可见光图像特有稀疏分量SB的区域能量计算如下:

(15)

(16)

其中:W表示一个(2r+1)×(2r+1)的权重矩阵,其根据四邻域离中心位置的距离设定如下。

(17)

因此,融合特有稀疏分量可通过以下规则得到。

(18)

3.4 融合图像重构

通过上述步骤,可获得融合后的特有低秩分量和特有稀疏分量。最终融合图像可通过式(19)获得。

If=Lc+Lf+Sf

(19)

4 实验结果与分析

本文在Bristol Eden Project1、Nato-camp和TNO2公共数据集中选取一些严格配准的红外与可见光图像进行测试。实验环境平台为:Intel(R) core(TM) i7-9700 @3.00 GHz,RAM 16.0 GB,MATLAB 2018b。

客观评价指标可以定量地评估图像的质量。本文采用熵(Entropy, EN)、互信息(Mutual Information, MI)、标准差(Standard Deviation, SD)、视觉信息保真度(Visual Information Fidelity, VIF)、差异相关系数之和(The Sum of the Correlations of Differences, SCD)和QY作为客观评价指标对融合算法性能进行评估[27]。EN反映了融合图像中包含信息量的多少。MI衡量了从源图像到融合图像传输的信息量。SD反映了融合图像的灰度与图像平均值之间的差异。VIF反应融合图像的信息保真度。SCD计算源图像与融合图像的差分图像之间的相关性,QY衡量融合图像保存结构信息的能力。六种客观评价指标数值越大,融合图像质量越高。

第一组测试数据选用Nato-camp图像序列,包含32帧大小为270×360的红外图像和可见光图像。图3(a)和(b)所示为其中一帧红外与可见光源图像。图3(c)~(l)表示对比方法与本文方法的融合结果。从图中可以看出,GTF方法的融合图像视觉质量较差,细节信息模糊不清。LP、DTCWT、NSCT、NSST和CSR方法能够保留可见光图像中树木的纹理信息,但是融合结果中人物目标偏暗且周围存在黑洞,对比度偏低。GF较好地保存了红外图像中的显著目标,但是融合图像背景不清晰。LATLRR方法的融合结果整体比较模糊且分辨率较低。CNN方法的融合结果整体比较清晰,但建筑旁边的树木边缘轮廓不理想。本文方法的融合结果相对于比较方法,目标清晰,对比度高,具有较好的视觉效果。

图3 Nato-camp图像融合结果Fig.3 Fusion results of Nato-camp images

图4所示为十种融合方法在Nato-camp 32帧测试图像序列上的六种客观评价指标结果曲线图,其中带有星号的曲线代表本文融合算法。从图中可以看到,本文方法的32幅融合图像具有最优的VIF,SCD和QY数值结果,并且大多数融合结果具有最优的MI值。在EN和SD指标上,本文方法的数值结果均低于GTF方法的数值结果,但与CNN方法的数值结果不相伯仲。综上所述,面对Nato-camp 32帧图像序列,本文方法在主观视觉和客观评价上表现出优越的融合性能。

图4 不同融合方法的客观评价指标结果 (Nato-camp)Fig.4 Objective evaluation results of different fusion methods (Nato-camp)

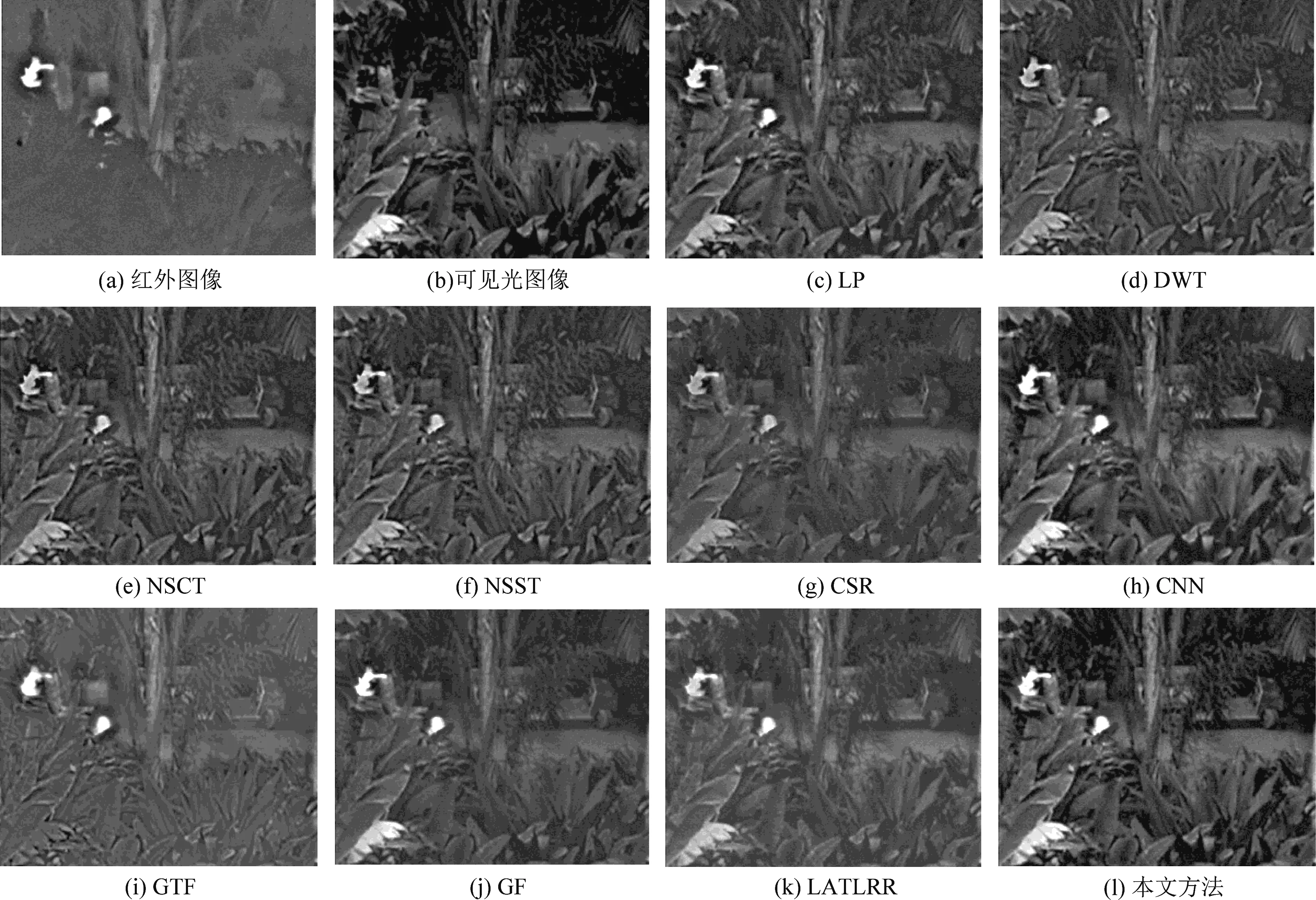

图5所示为Bristol Eden Project图像序列中某帧源图像和对比算法的融合结果。图5(a)和(b)分别表示红外和可见光源图像。图5(c)~(l)分别表示对比算法和本文算法的融合结果。从图中可以看到,DTCWT、NSCT和NSST方法的融合结果中人物目标和背景都比较暗淡,对比度较低。CSR、GTF、GF和LATLRR方法的融合结果存在背景细节信息丢失问题,LP和CNN方法的融合图像中人物目标周围背景信息有一定程度丢失。本文方法的融合结果具有层次感,亮度高,人物目标非常清晰,具有更好的人类视觉效果。

图5 Bristol Eden Project图像融合结果Fig.5 Fusion results of Bristol Eden Project

图6为十种融合方法在Bristol Eden Project 32帧测试图像序列上的六种客观评价指标结果曲线图,图中带有星号的曲线代表本文融合算法。本文方法的32幅融合图像具有最优的MI,VIF和SCD指标值,从EN值结果曲线中可以看出本文方法远高于其他对比方法的熵值,SD值结果曲线中本文方法仅有一部分图像帧融合结果未达到最优。总之,本文方法对Bristol Eden Project 32帧图像序列在主观视觉和客观评价上均表现出一定的优势。

图6 不同融合方法的客观评价指标结果 (Bristol Eden Project)Fig.6 Objective evaluation results of different fusion methods (Bristol Eden Project)

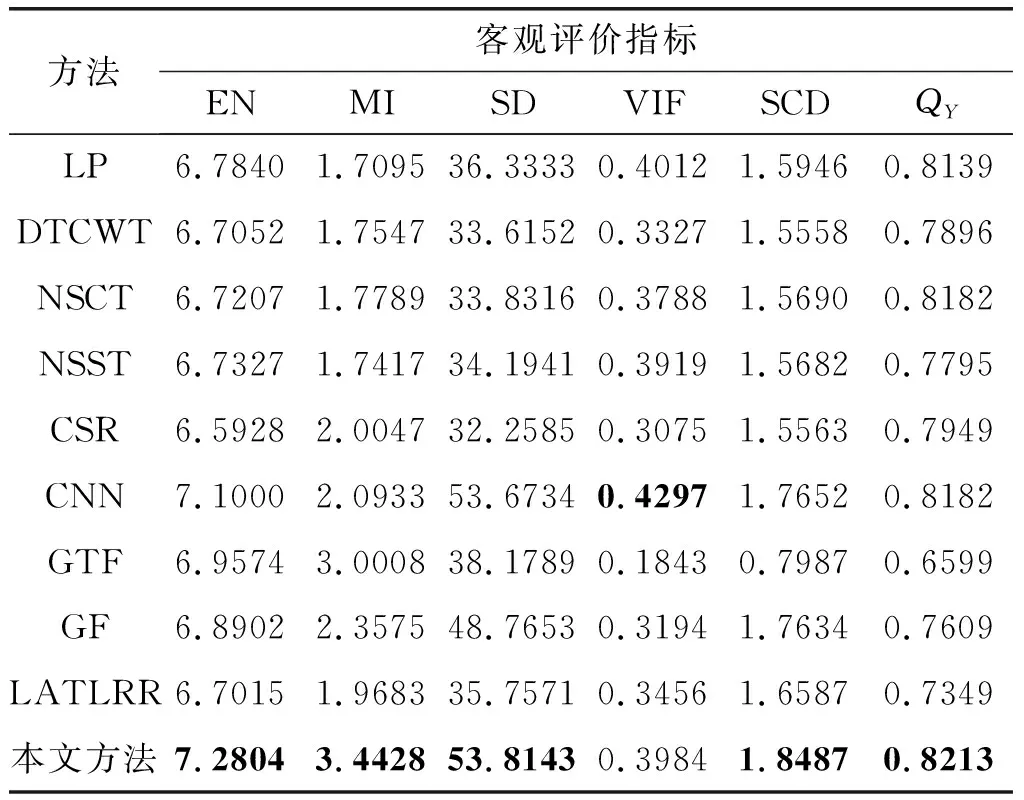

第三组测试图像为Kaptein图像,如图7(a)和(b)所示。图7(c)~(l)为对比方法和本文方法的融合结果。从主观视觉来看,LP、DTCWT、NSCT、NSST、CSR、CNN和LATLRR方法的融合结果人物目标暗淡,对比度较差。GTF、GF和CNN方法能够有效地保留清晰的人物目标。然而,GTF方法的融合结果背景模糊,GF方法的融合结果中庭院过度光滑,细节纹理不清晰。本文方法既保留红外图像中显著的人物目标和屋顶的烟囱,又保留了可见光图像中充足的背景信息,图像整体视觉效果较好。为了进一步客观评价融合算法的性能,表1列出了Kaptein图像融合结果的客观评价指标数值结果。从表中可以看出本文方法的EN、MI、SD、SCD和QY五项指标值都高于其他对比算法。

表1 Kaptein图像的客观评价指标

表2列出了不同融合方法在3组数据集上的运行时间。对于Nato-camp和Bristol Eden Project数据集,表2所列为不同融合方法在32幅图像数据上的平均计算时间。对于Nato-camp数据集,LP、DTCWT、GTF与GF方法的计算时间均小于1 s,NSCT与NSST方法的计算时间略大于1 s,CSR、CNN、LATLLR与本文方法的计算时间远大于1 s。对于Bristol Eden Project和Kaptein数据集,LP、DTCWT与GF方法的计算时间均小于1 s,NSCT、NSST和GTF方法的计算时间略大于3 s,CSR、CNN、LATLLR与本文方法的计算时间远大于3 s。总之,相比于多尺度融合方法,如LP、DTCWT、NSCT、NSST、GTF和GF,本文方法的计算复杂度更高。然而,相较于CSR、CNN和LATLRR等方法,本文方法的计算复杂度较低。

表2 不同融合方法的运行时间 (s)

5 结论

针对传统红外与可见光图像融合算法在融合图像中细节信息丢失、显著目标不清晰和对比度低等问题,充分考虑红外与可见光图像的相关性,提出了一种基于联合低秩稀疏分解的红外与可见光图像融合方法。通过联合低秩稀疏分解可以有效地将图像目标与背景分离。设计合适融合规则实现了特有低秩分量和特有稀疏分量的有效融合。实验结果表明本文方法获得的融合图像目标清晰,细节丰富,在主观视觉和客观评价指标上都优于对比方法。