E级高性能计算机系统中监控分系统的挑战与设计*

2021-09-24李世杰邢建英蒋句平

袁 远,李世杰,邢建英,蒋句平

(国防科技大学计算机学院,湖南 长沙 410073)

1 引言

高性能计算能力是综合国力的重要体现,是国家创新体系的重要组成部分,是国家科研实力的重要标志之一。国际上,美国、日本、欧盟都在研发E级高性能计算机系统,预计2021年前后推出。国内,国防科技大学、江南计算所和曙光公司都已完成E级验证系统研制[1],各自探索出了构建E级系统的技术路线。但是,验证系统毕竟规模有限,与实际E级系统相比,在处理器性能、网络规模、可靠性、可用性和能耗等方面还存在较大差距,E级系统构建中仍面临诸多挑战,仍需要进一步攻克一系列关键技术,才能构建出实用好用的E级系统。

监控分系统作为高性能计算机系统的神经中枢[2],为系统提供全方位的状态监控、配置控制和调试维护功能,是高性能计算机系统稳定运行的重要保障。随着高性能计算机系统计算能力达到E级甚至数E级,组装密度成倍增加,结点规模不断扩大,其可靠性、可扩展性和能耗问题更加突显[3],这导致监控分系统自身在可扩展性、可靠性、可服务性和高效运维等方面面临更大的挑战,现有监控分系统架构和软硬件设计[4]已不能满足E级系统需求,亟待全面革新,以支撑E级甚至数E级系统的构建。

本文重点介绍了E级监控分系统面临的主要挑战和应对这些挑战的设计思路。针对可扩展性挑战,提出插件、机框到系统三级区域自治式监控管理架构,3级之间统一通过高速以太网互连,可支持10万以上结点规模E级系统的监控管理;针对可靠性挑战,在专用监控网络中设计多级双星型网络拓扑,通过核心交换机、机框管理单元和系统管理单元的冗余技术,有效避免了单点故障,提升监控分系统可靠性;针对可服务性挑战,设计单插件4结点以上的串口远程访问、多结点固件带外并发远程更新、插件管理单元BMU(Board Management Unit)物理位置映射、固件高速分发等功能,可有效支持大规模结点带外配置与调试;针对高效运维需求,引入智能化运维AIOps(Artificial Intelligence for IT Operations)技术[5],基于全系统监控数据,通过机器学习方法,支持故障诊断和预测、制冷设备能耗管理等功能,提升运维效率,降低能耗。

本文剩余部分组织如下:第2节介绍E级监控分系统面临的主要挑战,第3节介绍E级监控分系统为应对各挑战的针对性设计,第4节通过原型系统对部分设计进行验证,第5节总结全文。

2 E级监控分系统面临的挑战

E级监控分系统主要在可扩展性、可靠性、可服务性和高效运维4个方面面临更大的挑战。

(1)可扩展性。

监控分系统的可扩展性必须与高性能计算机系统的可扩展性相匹配。E级系统较现有100P级系统,虽然单结点计算能力有数倍提升,但计算结点规模仍将扩展至5~10倍,可能达到10万之多[6]。待监控功能组件数量的大幅增加对监控系统的可扩展性带来了更大挑战。可扩展性挑战主要体现在2个方面:一是监控架构可扩展,随着计算结点数量的增加,为确保E级系统构建成本可接受,必须不断提高组装密度,因此监控架构需满足机框内不断增加的功能组件的精细化监控需求;同时监控架构还需具有更强大的机框间横向扩展能力,用于支持未来数E级系统的构建。二是处理方式的可扩展,海量功能组件的精细化监控,所产生的监控信息大数据化,很难通过集中方式完成全系统监控信息的处理分析,对监控组件的处理方式提出了新要求。因此,如何综合通过监控分系统的架构和网络设计解决可扩展性问题是亟待思考的关键问题。

(2)可靠性。

监控分系统自身的可靠性是保障高性能计算机系统安全稳定运行的前提。在E级系统中,监控、互连、存储和基础架构组件的规模都将随着计算结点规模的扩大而扩大[7]。假设未来E级系统中的计算结点规模达到10万,按现有“天河二号”2倍计算密度的组装结构来估算,即使不考虑互连和存储的监控组件需求,插件级监控组件数量将超过2万,机框级监控组件数量也达到800,监控组件故障率将大幅提升。如不采取可靠性设计,很可能导致监控组件先于功能组件发生故障(此处故障指引起异常现象的根因),直接影响到功能组件的异常(此处异常指故障引起的现象)检测与故障诊断,甚至在突发情况下导致安全事故。因此,如何提升监控系统自身的可靠性,使其成为全系统安全稳定运行的坚强后盾,是E级监控系统面临的主要挑战之一。

(3)可服务性。

监控分系统为高性能计算机全系统配置调试提供了必备手段。监控分系统提供的配置调试手段主要包括状态监测、结点远程串口访问、高速网络配置管理、远程固件更新和加切电控制等。实践证明,这些手段能够有效地提升高性能计算机全系统调试效率,但同样会由于E级系统计算密度增加与结点规模的扩大而面临新的挑战。如远程串口访问功能,如何实现单计算插件中4~8个计算结点远程并发串口访问,需要监控组件在软硬件设计上提供支持;又如远程固件更新功能,如何通过带外方式快速地将二进制的固件文件分发到末端监控组件上,这些都是需要思考解决的问题。因此,如何有效满足E级系统大规模调试管理需求,提升全系统的配置调试效率,也是监控分系统面临的难点之一。

(4)高效运维。

监控分系统为高性能计算机系统的运维管理提供了高效支撑。监控分系统的运维管理功能不但覆盖了高性能计算机系统中计算、互连、存储和基础架构等各个组成部分,还负责对超算中心配套的制冷系统和供电系统实施管理。在E级系统中,可靠性墙和能耗墙与计算规模和计算能力之间的矛盾变得难以调和[8]。为确保E级系统中各任务稳定低耗运行,海量组件故障的精确诊断与预测、主机系统与制冷系统协同能耗优化管理等成为监控分系统必须解决的难题。然而,现有的自动化运维和开发运维方式由于效率低、准确性差等问题,已无法满足E级系统高效运维管理的需求。如何充分利用好监控分系统收集到的海量监控数据,通过机器学习的方法开展智能化运维,成为监控分系统面临的另一大挑战。

3 E级监控分系统设计

3.1 监控架构设计

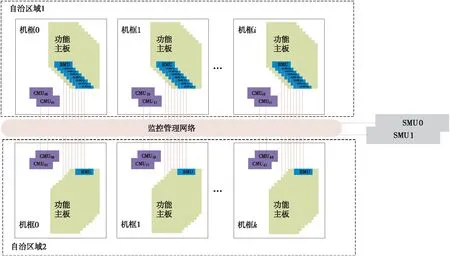

针对监控分系统在可扩展性和可靠性上面临的挑战,本文提出一种区域自治式3级监控管理架构,如图1所示。该架构将系统中的监控组件划分为3个层级,包括插件管理单元BMU、机框管理单元CMU(Chassis Management Unit)和系统管理单元SMU(System Management Unit)。3个层级的监控组件统一通过网络接口接入专用监控网络,实现监控数据和控制命令的上传下达。

Figure 1 Architecture of the multi-level monitoring with regional autonomy图1 区域自治式多级监控管理架构

(1)BMU。由于E级系统中计算插件组装密度大幅提高,互连插件光端口数成倍增长,仅依赖硬件接口资源受限的机框监控单元实施全机框扁平化监控管理,监控服务的可扩展性和实时性无法得到保障。因此,在监控架构设计上向下延伸一级,增加插件管理单元BMU,承担各功能插件内部的精细化监控管理。BMU采用模块化的设计思路,一块BMU板卡采用标准连接器与各种功能插件对接,通过软件定义的方式同时满足计算、互连和存储等功能插件定制化的监控需求。这样既保证了插件级监控服务的可扩展性,同时BMU板卡可独立设计与升级,且支持各插件单独调测试,提高了研发和调测试效率。

(2)CMU。CMU硬件以独立插件形式组装在机框背板上。为提升机框级监控服务的可扩展性,CMU上集成一个机框交换模块,通过背板实现与机框内其它插件BMU的互连,用于构建机框内的监控网络;为分担系统管理单元SMU的服务压力,CMU上集成一个机框管理模块,该模块由低功耗通用微处理器、内存和本地盘构成,可先于SMU对机框内各功能插件监控数据进行独立收集、存储与处理,提供区域自治管理能力;CMU上还安装有一块BMU板卡,实现对CMU插件、机框环境(温度、烟雾等)和机框共享组件(电源模块、散热模块)的监控;为保障机框级监控服务的可靠性,CMU采用冗余热备设计,支持单点故障后的自动切换。

(3)SMU。SMU硬件基于通用高性能服务器构建,负责对全系统实施多维度监控管理,并通过基于Web的图形化监控管理软件,为用户提供系统级的状态监测、配置控制、调试维护、故障预测和能耗控制等服务,保障全系统高效调测试和稳定运行。为保障系统级监控服务的可靠性,SMU采用冗余多活设计,多台SMU互为备份,当出现SMU宕机,可确保系统级监控服务不中断。

3个层级的监控组件共同实现区域自治管理功能。在区域自治管理机制中,根据计算结点的不同任务定位,由SMU将若干个机框组织成一个自治区域,如单个机柜由4个机框组成,可以被组织成一个区域,又或者多个机柜组织成一个区域。区域中CMU和BMU分饰“管理者”和“执行者”的角色,并由多个“管理者”中选出一个作为“高级管理者”,“高级管理者”负责区域自治管理策略的制定,传达SMU的命令,并收集上报区域内各个“管理者”的监控情况。“高级管理者”的选取可通过人工方式或者自动选取算法,基于区域内CMU的网络拓扑结构,综合考虑CMU之间、CMU和SMU之间的跳步数来确定。

Figure 2 Topology diagram of the system-level monitoring network图2 监控网络拓扑结构示意图

在每个自治区域中,“高级管理者”根据SMU下达的当前区域划分与任务定位,结合该区域的软硬件配置、能耗需求和故障特点,制定该区域的自治管理策略。如异构科学计算区域中不但需要监控多核微处理器结点的运行状态,还需要重点监控众核加速器和集中共享存储设备的软硬件状态、功耗和故障;大数据计算区域中则需要增加分布式存储设备的状态及故障监控等等;在此基础上,提供适合该区域任务的软件环境和并发固件带外更新、高速网络配置管理、故障调试诊断等手段,高效实现区域全面自治管理。区域自治管理机制可有效降低SMU的管理复杂度,支持面向应用任务划分的区域管理,支持单柜、单排以及各种规模的系统调试,大幅提升监控分系统的可扩展性和管理效率,结合专用监控网络设计,可有效满足10万结点甚至更大规模高性能计算机系统的监控管理需求。

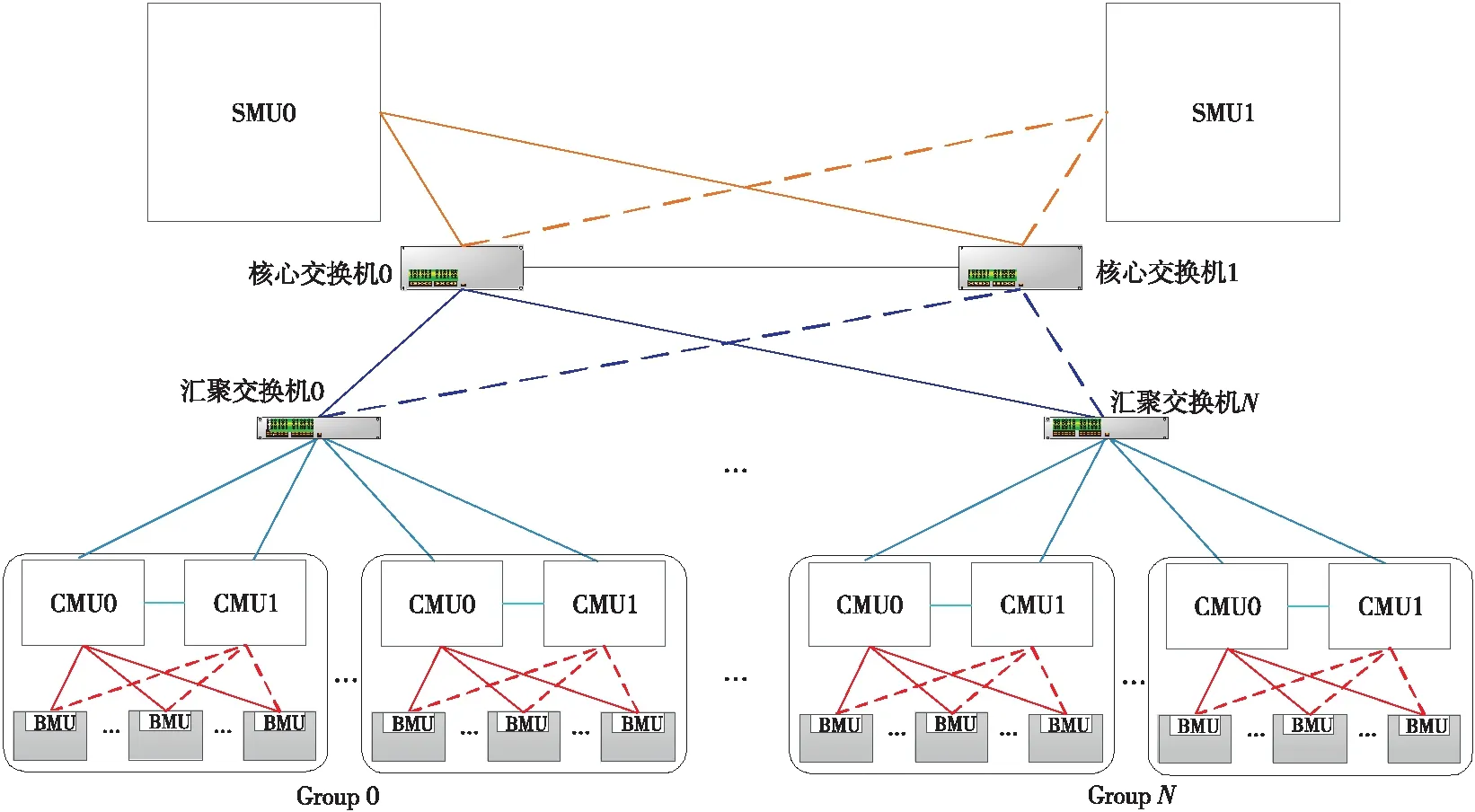

3.2 监控网络设计

监控网络独立于用于业务数据交互的高速互连网络,负责3级监控组件之间互连互通,其设计是满足E级监控分系统高可扩展性和高可靠性的关键。在高可扩展性方面,通过机框内CMU上的机框交换模块设计,满足单机框最大组装密度下的监控需求;通过机框间的监控网络拓扑设计和2级外部交换机选型,满足10万结点规模E级系统的监控需求。在高可靠性方面,通过多级双星型网络拓扑设计,实现CMU的冗余热备、SMU的冗余多活和核心交换机的冗余热备。

监控网络分为3层,如图2所示:第1层为核心层,由2台多端口高速核心交换机组成,端口数和吞吐率与汇聚层交换机数量和吞吐率相匹配;第2层为汇聚层,由若干多端口千兆以太网交换机组成,端口数与吞吐率与接入层CMU机框交换模块相匹配;第3层为接入层,由所有主从CMU机框交换模块组成,端口数由机框内功能插件数量来决定。

(1)在核心层中,考虑监控网络的高可用性,选用的2台多端口高速核心交换机互为冗余,可虚拟成1台核心交换机,核心交换机与汇聚交换机之间采用双星型拓扑,避免核心交换机单点故障。2台或多台SMU连接到2台核心交换机上,通过核心交换机的网关功能实现SMU的冗余多活。

(2)在汇聚层中,若干机框分为1组,每组采用1台48端口千兆网交换机构建网络。组内每个机框的主从CMU都通过1路千兆以太网链路连接到该48端口千兆交换机上,千兆交换机分别上行2路万兆以太网链路连接到2台高速核心交换机上。

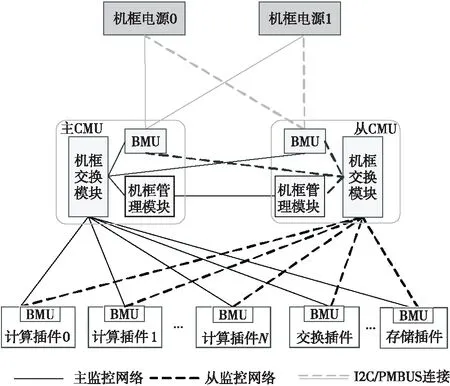

(3)在接入层中,主从CMU与各功能插件的BMU之间构建双星型冗余拓扑,如图3所示,框内2个交换平面相互独立,通过冗余切换策略,可有效避免CMU的单点故障,提升机框级监控服务的可靠性。

Figure 3 Topology diagram of the chassis-level double star monitoring network图3 机框内双星型监控网络拓扑结构示意图

3.3 监控功能设计

针对E级监控分系统在可服务性上面临的挑战,主要对BMU和CMU上的配置调试功能开展优化设计。

(1)BMU。BMU作为整个监控分系统的末端,是所有监控功能的最终“执行者”。BMU通过多路I2C、GPIO等接口与功能插件主板上的传感器相连接,实时监测器件的电压、电流和温度等状态参数,并负责根据阈值判断状态正常与否,利用SNMP-Trap的方式上报CMU;BMU还通过I2C或GPIO接口对功能插件上计算结点和高速互连芯片实施加切电控制,同时支持突发情况下自动安全保护,即过温切电等。针对带内更新结点固件依赖于操作系统的问题,设计带外多结点固件并发更新功能,使得更新时机与结点系统是否正常工作无关,同时优化固件更新的软件栈,缩短固件更新时间,提高大规模系统配置效率。针对多结点并发远程调试需求,BMU的主控芯片通过外接USB转串口芯片,可实现1路USB接口扩展至少4路串口,并且通过硬件手段检测USB设备的加载顺序,支持多路串口设备与结点号之间有序映射,有效满足了高组装密度计算插件的结点远程调试需求。

(2)CMU。CMU作为机框的“管理者”,负责向机框内各BMU下达命令,并收集处理BMU上报的各类监控数据。针对机框自动分配IP地址的BMU无法定位物理位置的问题,CMU主控通过MDIO接口访问机框交换模块,获取交换芯片的端口与IP地址映射表,再根据交换端口与槽位号的布线关系,可有效识别BMU物理位置,在高效配置IP地址的同时实现了监控数据源的精确定位。针对大规模系统中固件和服务更新速度慢的问题,CMU设计多级组播树的文件分发机制,SMU将文件分发给少量CMU,再通过CMU之间“一传十,十传百”的方式,可有效提高文件在监控网络中的分发速度,满足高效配置大规模系统需求。针对主从CMU冗余切换中存在误切、拒切和“脑分裂”的问题,CMU设计一种基于混合状态心跳的对端BMU仲裁冗余切换机制,该机制中的混合状态心跳包含软硬件多种状态信息,以确保主从切换的准确性;同时,当主从CMU之间的心跳线出现故障时,通过收到补救心跳的对端BMU来实施主从仲裁,有效避免“脑分裂”现象的出现。

(3)SMU。SMU是全系统的“大总管”,通过基于RESTFUL形式的轻量级监控管理协议与CMU交互。在SMU上部署的系统级监控数据管理平台,负责存储和展现海量多源异构的带内、带外的监控数据,并提供挂载智能化运维功能接口。针对大数据处理分析时访问量大的特点,设计高可靠的数据索引方法和高通量的数据访问策略,为高效训练建模和预测推理提供支持,保证数据访问的高可获得性和海量数据分析的实时性。

3.4 智能运维设计

为提高E级系统的运维效率,需引入智能化运维(AIOps)概念,基于海量监控数据,结合机器学习算法,开展系统级智能化运维探索。然而,智能化运维不但覆盖E级主机系统及配套的制冷系统和供电系统,涉及资源管理与调度、故障诊断与预测、能耗管理与优化等诸多方面,且海量监控数据作为智能运维的基础,从采集、存储到分析建模各步骤都面临需要解决的问题。考虑到篇幅受限,本节主要从主机系统故障预测和制冷设备能耗管理2个方面分析建模相关设计思路。

3.4.1 主机系统故障预测

主机系统故障预测主要分3大功能模块:异常检测[9]、故障诊断[10]和故障预测[11]。

在异常检测模块中,通过收集一段时间系统某项指标相关的监控数据,结合人工标注,利用机器学习的方法,如聚类算法、随机森林等,来进行关键性能指标KPI(Key Performance Indicator)曲线分析,构建起其中的正常模式与异常模式,再对实时监控数据进行模式匹配,发现异常。

在故障诊断模块中,由于E级系统规模大,系统复杂,导致同一故障源会触发一系列异常事件,不同的故障源也可能触发得到相同的异常事件。因此,需要基于检测到的海量异常事件,结合运维人员经验,通过机器学习的方法,如FP-Growth、Apriori等,对异常事件之间的关联关系开展分析挖掘,构建较完备的故障传播链。故障传播链可以用有向无环图来表示,当系统检测出异常时,可通过搜索算法,沿着故障传播链找出根因,实现异常诊断。

在故障预测模块中,主要挑战在于训练故障预测模型的监控数据需要足够多,但实际情况中故障数量较少,且监控数据中有效信息也相对较少。故障预测首先要通过机器学习的方法,如决策树、聚类树和随机森林等,并结合运维人员经验,从历史监控数据中找出导致该类异常事件的相关信号,当出现这些信号,则认为异常事件将会发生,并通过故障诊断定位根因,帮助运维人员提前处理问题。

3.4.2 制冷设备能耗管理

制冷系统作为超算中心中除E级主机系统外的第一“能耗大户”,能耗优化需求迫切[12]。现有制冷系统能耗优化手段缺乏制冷设备相互之间的和与主机系统之间的有效协同,效率低、效果差。此外,由于制冷设备种类多,参数量大,影响能耗的因素复杂,且与主机系统之间存在复杂能量转换关系,耦合紧密,因此协同能耗管理是一个极具挑战的难题。采用大数据加机器学习的方法是解决这一难题的有效手段之一[13]。本节给出一种基于机器学习的制冷设备能耗调节方法。该方法包括制冷设备能耗预测和面向实时负载的制冷设备能耗调节2个模块。

在制冷设备能耗预测方法中,基于监控分系统采集到的制冷设备历史能耗、配置参数和环境等数据,结合系统历史作业负载数据,在对样本数据清理、抽取的基础上,综合利用数据挖掘和机器学习的方法进行分析,训练并构建制冷设备智能化能耗预测模型。该模型包括2个方面:一是多配置参数条件下制冷量和能耗预测模型,为制冷设备配置参数方案优化提供评估手段;二是面向作业负载的最小制冷量需求和最低制冷能耗预测模型,为制冷设备配置参数方案调整提供优化目标。

在制冷设备能耗调节方法中,面向动态变化的系统负载,设计面向系统负载的制冷设备配置参数生成框架,生成过程将划分为2个阶段,第1阶段基于作业负载变化对制冷量与能耗需求进行预测,采取面向最小制冷量和最低能耗目标的配置参数反向设计方式,达到快速生成目标参数配置方案的目标;第2阶段基于制冷量与能耗量目标评估实现参数配置方案快速生成,即面向确定的制冷量与能耗量目标,设计可快速收敛的高维配置参数空间近似最优解算法,从而可根据作业负载数据找出满足该负载且支持制冷设备最低能耗的配置参数,实现制冷设备的有效节能。

4 实验验证

为对监控分系统的设计进行阶段性验证,完成了BMU、CMU硬件原型的设计与实现,以及3级监控组件主要软件功能研发,并依托基础架构分系统构建了一个机框规模的原型系统。在该原型系统上,开展了监控架构、监控网络和监控功能的相关验证。但是,由于原型系统规模小,实际运行时间短,部分系统级设计,如区域自治管理、固件分发、智能化运维相关功能,尚不具备验证条件,因此本节仅对可验证功能情况进行描述。

4.1 原型系统

如图4所示,机框原型系统由1套机框结构件、32块计算插件、2块互连插件、2个机框管理单元CMU、1块背板以及配套供电和散热组件等组成。计算插件、互连插件和CMU上都安装有插件管理单元BMU,BMU和CMU之间通过背板实现互连,构建机框内双星型监控网络;系统管理单元SMU与CMU之间通过以太网实现互连。

Figure 4 Chassis prototype图4 机框原型系统

(1)BMU板卡上集成一颗嵌入式SOC主控、DDR3内存颗粒和SPI FLASH等器件,通过SODIMM插槽与各功能插件的主板连接,提供多路I2C、RGMII、SPI、USB、JTAG、GPIO等硬件I/O接口。BMU上基于嵌入式操作系统部署有插件级监控管理软件。BMU实物如图5所示。

Figure 5 BMU prototype图5 BMU板卡实物图

(2)CMU主板由一颗低功耗的FT-HK芯片作为主控,配置有2 GB DDR4的内存颗粒、256 GB SSD固态盘、48端口的交换芯片和1块BMU板卡。前面板提供2个RJ45千兆网接口用于对接外部的汇聚交换机,1个USB接口用于系统配置与调试。CMU上基于裁剪优化后Linux操作系统部署有机框级监控管理软件。CMU实物如图6所示。

Figure 6 CMU prototype图6 CMU实物图

(3)SMU硬件上为一款12盘位的双路通用服务,在通用Linux操作系统上部署有基于ElasticSearch和Kibana的系统级监控数据统管理平台。SMU实物如图7所示。

Figure 7 SMU server图7 SMU实物图

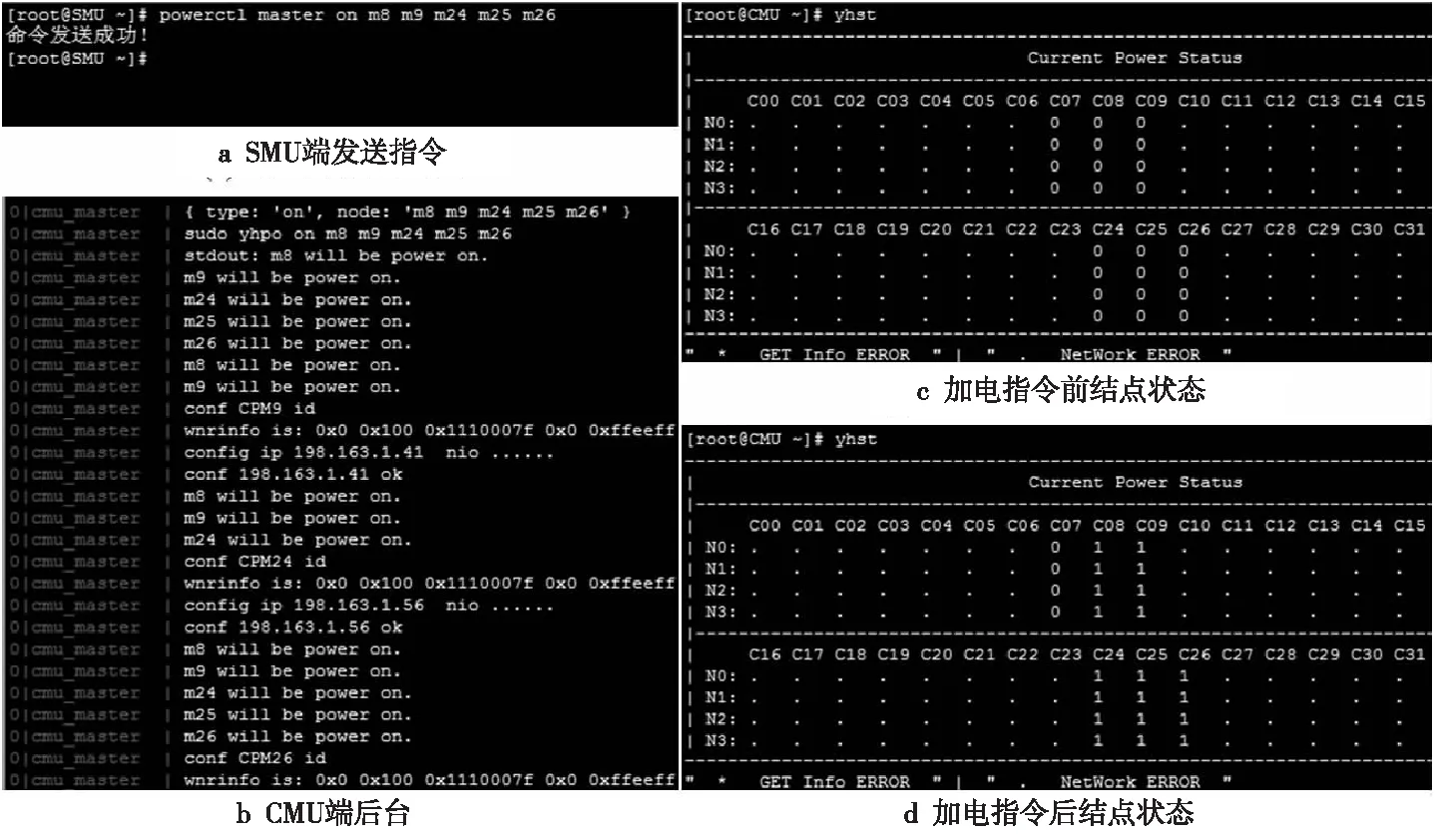

Figure 8 Connectivity verification of the 3-level monitoring architecture图8 3级监控架构连通性验证

4.2 验证情况

4.2.1 功能验证

(1)监控架构验证。

SMU向CMU发送powerctl指令进行指定计算插件的加切电控制,CMU接收到后,向BMU发送基于IPMI的加切电指令,并完成计算插件的加切电控制。验证情况如图8所示。

图8a表示从SMU的终端上输入powerctl指令,通知CMU对原型系统中8,9,24,25,26号计算插件进行加电操作,图8c显示上述计算插件初始状态均为未上电状态,用0表示。图8b显示CMU的后台程序执行情况,可以看出在收到SMU命令后,CMU对相应计算插件进行了加电power on操作,相应的图8d显示了加电后的计算插件状态,可以发现目标计算插件均已变为上电状态,用1表示。该结果验证了3级监控架构中组件之间的连通性。

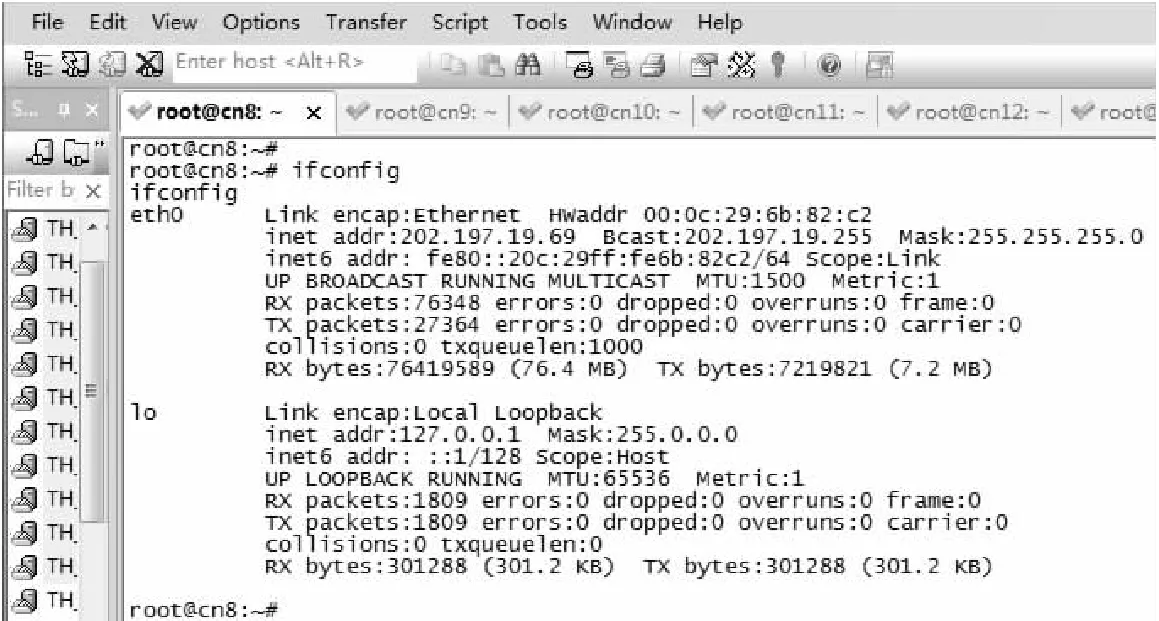

(2)远程并发串口访问功能验证。

SMU上的SecureCRT软件同时开启多个计算结点串口,并通过操作验证远程并发串口访问功能。验证情况如图9所示,结果表明各计算结点的串口能同时远程访问和交互。

Figure 9 Verification of the parallel serial port over lan access图9 远程并发串口访问功能验证

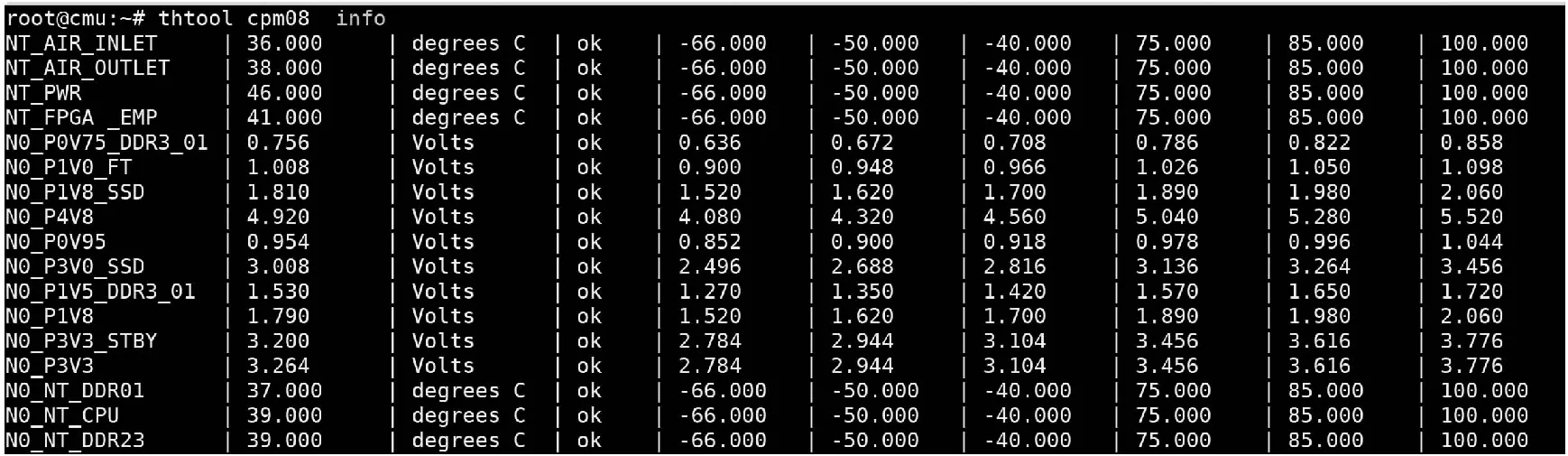

(3)监控数据采集功能验证。

在CMU的终端上输入计算插件监控数据采集命令,等待BMU返回结果。验证情况如图10所示,结果表明CMU能够有效地从BMU上获取计算插件所有传感器信息。

Figure 10 Verification of monitoring data acquisition function图10 监控数据采集功能验证

Figure 11 Verification of the BIOS firmware update function图11 固件更新功能验证

(4)固件远程更新功能验证。

在CMU的终端上输入计算结点固件(BIOS)远程更新命令,对相应固件进行在线远程更新,等待BMU返回结果。验证情况如图11所示,结果表明固件远程更新功能正确。

(5)监控图形化界面功能验证。

在浏览器中输入SMU的web界面URL,查看SMU图形化监控功能。验证情况如图12所示,结果表明图形化监控功能正常。

Figure 12 Function Verification of monitoring graphical interface图12 监控图形化界面功能验证

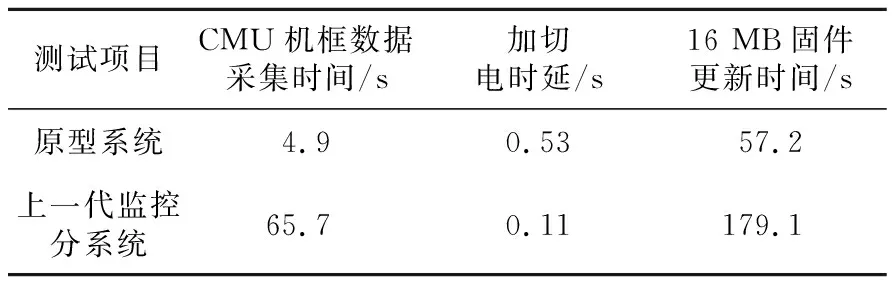

4.2.2 性能验证

在原型系统性能验证中,将本文提出的系统与上一代实际系统中的监控分系统进行了对比测试,分别从CMU的数据采集时间、加切电时延、固件更新时间等3个方面评测原型系统的性能表现。性能比较结果如表1所示。

(1)机框数据采集。

由于原型系统中3级监控架构采用了CMU到BMU、BMU到多个结点的2级并发数据采集机制,而上一代监控分系统中无BMU,CMU仅通过多路低速I2C硬件接口与对应数量插件相连,因此原型系统的机框数据采集时间要远优于上一代监控分系统。

Table 1 Results of the performance comparison表1 性能验证对比测试结果

(2)加切电时延。

由于原型系统的监控诊断分系统中增加了插件的监控层级,计算插件上复杂可编程逻辑器件CPLD(Complex Programmable Logic Device)设计预留的加切电延时相应增加,以保证加切电命令确实完整执行,因此相比上一代监控分系统,原型系统的加切电时延有所增大。

(3)固件更新时间。

在单结点上,原型系统中采用的带外远程固件更新方式和上一代使用的带内固件更新方式相比时间更短,主要原因是带外固件更新硬件通路与带内固件更新一致,但从软件进行了裁剪优化,因此表现更好。

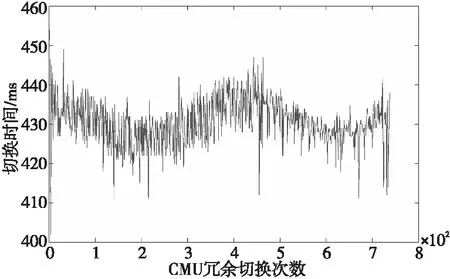

(4)冗余切换。

由于上一代监控分系统不具备主从CMU冗余架构,本文仅对原型系统上主从CMU冗余切换功能进行测试。通过模拟主CMU故障,共进行750次冗余切换,记录下每次冗余切换时间,验证结果如图13所示。从结果可以看出,冗余切换时间比较稳定地维持在430 ms左右,表明冗余切换准确性和稳定性较强。

Figure 13 Verification of redundancy switching 图13 冗余切换功能验证

5 结束语

本文重点介绍了E级高性能计算机系统中监控分系统面临的主要挑战和应对这些挑战的设计思路。针对可扩展性挑战,可通过增加监控层级和区域自治的方式解决;针对可靠性挑战,可通过专用监控网络设计和增加监控组件冗余备份能力来避免单点故障;针对可服务性挑战,可通过软硬件协同设计,优化各类监控服务大规模系统效率来解决;针对高效运维的需求,可通过探索智能化运维方法来提升E级系统可靠性,降低能耗。这些设计思路部分已在机框规模原型系统上得到验证,对于下一步E级监控分系统的构建有较大的指导意义。