基于天基边缘计算的在轨智能技术

2021-09-11陈小前季明江

张 飞,陈小前,于 帅,季明江,刘 勇,曹 璐

(1.军事科学院 国防科技创新研究院,北京 100071;2.中山大学 计算机学院,广东 广州 510006)

0 引言

随着人类在航空航天、深海探测以及无人驾驶等科技领域的快速进步,人类的活动范围不断向更加偏远的地区延伸(如外太空、沙漠腹地及深海等)[1]。地面移动通信网络很难覆盖沙漠、深海以及外太空等偏远地区,已无法适应新型移动设备泛在连接(Ubiquitous Connectivity)的需求。卫星具有广域覆盖的特点,是偏远地区各类信息技术应用的重要支撑。随着移动终端技术的发展,各类新兴应用不断涌现,如移动物联网、虚拟现实、智能物流、目标识别与跟踪等。但是受能源、尺寸等因素限制,移动终端通常以无线接入的方式将采集的数据传输到后端云计算平台进行处理。这同时也带来了巨大的延迟开销,无法适应一些延迟敏感型应用,例如,虚拟现实为了与现实场景深度融合,从玩家移动头部到看到新的、正确的场景视图的延迟应小于15 ms[2]。边缘计算可以将计算资源部署在移动终端附近来减少数据传输并降低计算时延。

本文利用低轨卫星广域覆盖、轨道低、数据传输延迟小等特点,提出了一种基于空天地海一体化网 络(Space-Air-Ground-Aqua Integrated Networks)[3-5]的天基边缘计算框架。该架构包含接入层和处理层2 个层面:在接入层,地面/海面终端(如移动用户、互联网设备等)通过低轨卫星(Low Earth Orbit,LEO)星座接入空天地海一体化网络,并通过计算卸载(Computation Offloading)的方式,将其计算任务卸载到处理层(即星上边缘计算平台);在处理层,星上边缘计算平台与空中计算平台、地面云计算中心协作处理接收到的计算任务(即星地协同[6])。随后,本文提出一种基于深度模仿学习(Deep Imitation Learning,DIL)的智能计算卸载模型,通过星地以及星间的计算卸载,以达到提升星上边缘计算平台的任务处理速度的目的。最后,针对天基网络中卫星星座的动态拓扑环境,为所提出的智能计算卸载模型设计一种分布式联邦学习的模型训练机制,以降低星地通信开销和保障星上数据隐私。

基于空天地海一体化网络的天基边缘计算以其独特的全球覆盖信息服务能力,已成为下一代移动通信网络(6G)和国家重大基础设施建设方向。本文提出的天基边缘计算架构、智能计算卸载模型及其分布式模型训练机制,可实现地面终端的泛在连接与在轨数据实时采集、处理及存储功能,可支持如天基物联网、目标检测与跟踪、气象观测、自动驾驶等各类军民应用。

1 研究现状

天基边缘计算也被称为在轨边缘计算(Orbital Edge Computing,OEC)[7-8],指通过将计算、存储以及传感器等硬件设备部署在空天地海一体化网络中的通信卫星上,以实现数据的在轨采集、接收、处理和分发。由于其全球覆盖的优势,在近年来得到了学术界和产业界的极大关注,被认为是下一代移动通信网络(6G)的关键技术之一。目前,由于对天基边缘计算的研究尚处在初级阶段,相关的研究成果多集中在其体系架构上。例如,文献[7]提出了OEC 的概念,OEC 支持在每个配备了摄像机的低轨卫星上进行边缘计算,以便在下行链路中断时可以在轨处理感测数据。同时,为了解决边缘处理延迟问题,OEC 系统将卫星星座组织成计算管道。这些管道基于地理位置并行数据采集和数据处理,无需交叉连接协调。文献[9]研究了空天地海一体化中与多接入边缘计算网络的融合架构,并探讨了其在降低时延、缓存与网络开销等方面的优势。由于数据在轨存储被认为是一种有前途的安全存储模式,文献[10]将低轨卫星视为安全的数据存储介质,并研究从低轨卫星数据存储系统(也称为低轨卫星数据中心)获取数据。在该框架下,一个基本的挑战是在保持系统稳定性的同时处理从空间到地面的节能下载。因此,作者提出了一种在线调度框架,目标是在最小化能耗的同时最大化数据量下载(低轨卫星到地面终端)。在低轨卫星的部署方式方面,文献[11]提出一种超密集近地轨道网络(Ultra-Dense LEO),以实现和地面网络的高效数据卸载。其目标是在同时优化每个低轨卫星回程容量的前提下,使总速率和接入用户数最大化。

2 天基边缘计算架构

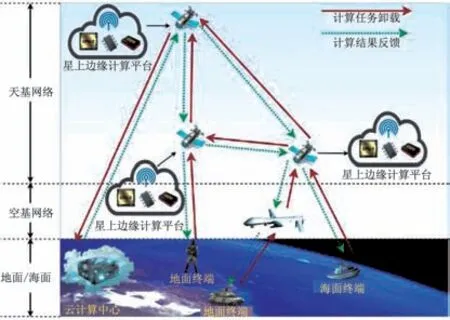

天基边缘计算就是以卫星为核心实现空天地海多域平台高效互联,并在星上构建边缘计算平台,赋予整个网络数据在轨收集、处理与缓存的能力。天基边缘计算架构主要由地面/海面终端、空天网络、星上边缘计算平台以及云计算中心部分构成,如图1 所示。

图1 基于空天地海一体化网络的天基边缘计算架构Fig.1 Space edge computing architecture for space-airground-aqua integrated networks

1)地面/海面终端:具有数据采集和弱处理能力的各类移动终端设备,包括移动终端、探测器和物联网设备等。地面/海面终端通过无线网络将其采集到的数据卸载到处理能力更强的外部处理平台(如图1 所示的天基网络或空基网络中的边缘计算平台)执行。

2)空天网络:由以卫星为核心高效互联的各类天、空平台(High and Low Altitude Platforms)[3]组成。天基网络由若干卫星通过星间链路构建。由于低轨卫星轨道低,星地传输延迟小,可作为地面/海面终端的主要接入点。当需要更大数据采集和更强计算能力时,可由低轨卫星转发数据至高轨卫星或地面云计算中心进行处理。在临时和局部需要较强计算和通信能力支撑时,通过部署空基平台作为天基平台的中转和补充。

3)星上边缘计算平台:利用虚拟化和边缘计算技术,在每颗卫星上部署边缘计算平台。各星上边缘计算平台间可实现计算资源共享,同时可接收来自地面/海面终端和空中平台卸载来的计算任务。星上边缘计算平台将处理后的结果可快速返回给地面/海面终端。

4)云计算中心:天基和空基边缘计算平台的重要支撑,当移动应用需要的算力较大时,各平台将数据传至云中心进行处理。云计算中心同时也是数据汇聚池,所有边缘计算平台需要存储的数据都发回云计算中心进行存储,进而可利用大数据技术深度挖掘数据价值。

3 天基边缘计算智能卸载模型

本章首先对天基边缘计算系统进行建模,归纳了最小化程序执行时延的优化目标,以及构建了基于深度模仿学习的智能计算卸载决策模型。

3.1 天基边缘系统建模

假定当前天基边缘计算系统中的天基网络包含N个具有边缘计算能力的卫星(即边缘节点),其集合为N={1,2,…,N}。针对天基边缘计算系统中待执行的应用程序,本文考虑细粒度(Fine-Grained)的程序切分方案[12],即一个应用程序O可被切分为若干个可独立执行的子程序。令O={S,D},其中,S为子程序的集合,D为子程序间所需传递的数据的集合(即子程序的输入输出)。

3.2 计算任务卸载决策优化目标

基于所构建的网络模型,可对计算任务卸载及优化目标进行建模。具体而言,假设应用程序O可拆分成|S|个可独立执行的子程序,则该应用程序的计算卸载 决策可由AO={a1,a2,…,as,…,a|S|}表示,其中,as为第s个子程序的卸载决策。as必然为以下3 种决策之一:

1)as=0,表示低轨卫星n将其应用程序O的子程序s通过星地无线链路卸载到云计算中心执行(即地面执行),其时延为Tc;

2)as=k,(k=n),表示子程序s在任务发起的低轨卫星n上运行(即在轨本地执行),其时延为Tl,k,n∈N={1,2,…,N};

3)as=k,(k≠n),表示将子程序s卸载到除任务发起卫星n以外的其他低轨卫星上运行(即在轨远端执行),其时延为Ts,k,n∈N={1,2,…,N}。

计算任务卸载的程序运行时延的优化问题可以建模成如下数学规划问题:

注意到,该优化问题为整数规划问题,其最优化算法的复杂度随子程序的个数|S|及低轨卫星个数N呈指数倍增长,因此,无法在多项式时间内得到最优解。为此,本文采用一种基于深度模仿学习的智能计算卸载决策模型,通过星地、星间的计算卸载,达到提升程序运行速度的目的。

3.3 基于深度模仿学习的智能计算卸载决策模型

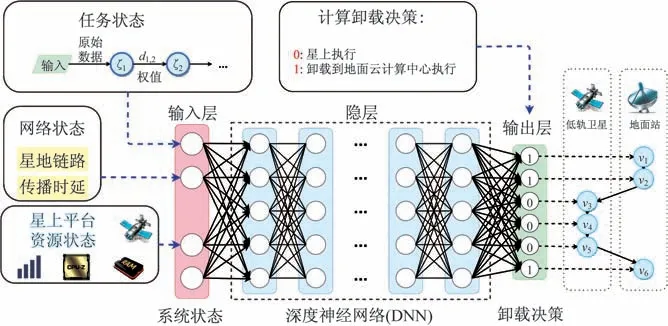

为了得到式(1)中细粒度的、实时的计算卸载决策,本文采用一种基于深度模仿学习的智能计算卸载决策模型,如图2 所示。基于行为克隆(Behavioral Cloning)[13]、模仿学习(Imitation Learning),通过监督式学习的方式,以及离线的模仿范例(本文中为最优的计算卸载决策范例),做出实时、在线的处理决策。该模型的运行包含如下3 个阶段:

图2 基于深度模仿学习的智能计算卸载决策模型Fig.2 DIL based intelligent computation offloading model

1)离线范例生成,通过整数规划传统的解法得到处理决策的最优解作为范例;

2)离线模型训练,使用深度神经网络(Deep Neural Network,DNN)来提取和训练上一阶段生成的范例数据,以此训练决策模型;

3)在线决策生成,DNN 的离线模型训练阶段一旦完成,就可以在线地进行实时的计算卸载决策。通过该输出评估该深度模拟学习模型的决策 精度和程序执行时延。

4 智能计算卸载模型的分布式在轨训练

在星上边缘计算平台的智能服务处理中,许多业务往往涉及数据驱动的智能AI 任务[14]。其特点是需要协同利用地面/海面的海量数据进行汇聚式分析处理,生成相应的机器学习模型。传统的集中式联邦学习模型如图3(a)所示。通常将这些数据聚集到一个云端服务器上进行统一处理和训练,这种中心化的模型训练方式会带来隐私泄露的风险,危害数据安全。同时,依赖于云端的集中式训练方式也需要星上边缘计算的各个低轨卫星把自身数据传输到地面云计算中心。由于星地之间无线链路的长时延及不稳定性,其带来的传输开销非常巨大,对网络带宽造成很大压力。为此,本文为上述智能计算卸载模型设计了一种基于分布式联邦学习的在轨模型训练机制,如图3(b)所示。

图3 计算卸载决策模型的在轨训练Fig.3 On-orbit training for the computation offloading model

具体而言,每颗低轨卫星首先根据自身的决策范例独立训练本地的决策模型。随后,低轨卫星按顺序将训练好的本地模型传递到下一颗临近的卫星。如图3(b)所示,低轨卫星1 将其本地模型发送到低轨卫星2;随后,低轨卫星2 将其收到的模型与本地模型聚合生成新的聚合模型并传递到低轨卫星3;低轨卫星3 继续将收到的模型与其本地模型聚合。由于低轨卫星3 已收到全网的训练模型信息,因此,生成的聚合模型为全局模型;最后,低轨卫星3 将生成的全局模型发送给其他低轨卫星(可通过广播的方式)。该模型训练方式避免众多低轨卫星与地面云计算中心进行通信,大大减少星地间的通信开销,且能保障星上数据隐私。因此,非常适合在天基边缘计算网络环境训练多种隐私敏感且数据量较大的人工智能模型。

5 仿真试验及结果分析

5.1 仿真结果

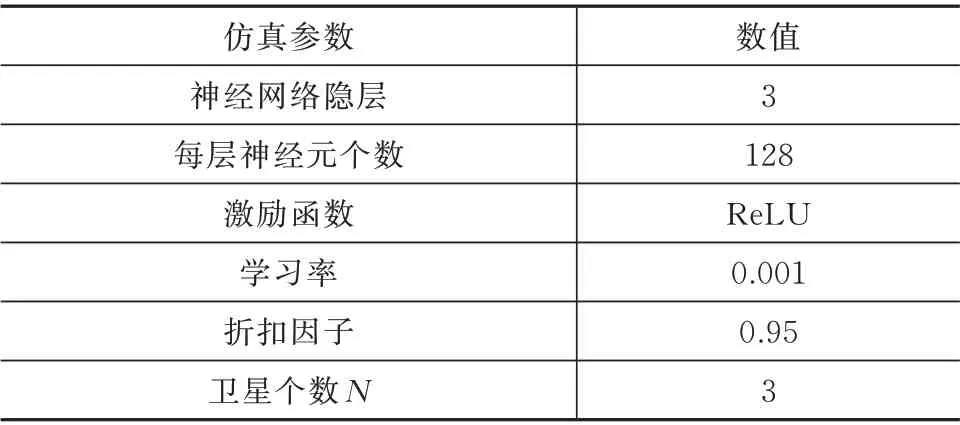

本文使用Matlab 仿真软件对提出的在轨智能技术进行仿真分析及性能评估。仿真环境见表1,即如图2 所示的DNN 参数。同时,为了评估该技术(即智能决策)的性能,本文提出3 种计算卸载参照方案,分别为:

表1 仿真参数设置Tab.1 Simulation parameters

1)云处理,即所有子任务卸载到地面云计算中心进行处理;

2)星上处理,即所有子任务在卫星端处理;

3)贪婪决策,即每个子程序采用贪婪算法抢占网络资源,最大化自己的短期收益,从而得到计算卸载决策。

对于计算任务模型,我们考虑一个包含6 个子任务的计算任务(即|D|=6),每个子任务的数据输入/输出数据量大小在[100,500]kB 上服从均匀分布,处理其每字节所消耗的算力(与算法计算复杂度相关)在[0,12 000]CPU(Cycles Per Byte)上服从均匀分布[15],星地链路的传播时延开销为30 ms。

5.2 结果分析

不同计算卸载决策方案的性能比较如图4 所示。其中,图4(a)比较了不同卸载决策方案的卸载决策准确率(相比于通过穷举法得到的最优决策),图4(b)比较了不同卸载决策方案的程序执行时延。从图4(a)中可见,相比于其他决策方案,本文提出的智能决策模型的决策准确率最高,达到了60.24%。

注意到,更高的决策准确率带来程序执行时延大幅降低。为此,图4(b)给出了不同决策方案的程序执行时延。从图中可见,本文提出的智能卸载决策模型相比于云处理、星上处理、贪婪决策分别降低了54.96%、42.08%、23.80% 的程序执行时延。这是因为智能卸载通过不断地学习最优决策范例,从而不断提升自身的决策准确率,以此降低了程序执行时延。

图4 计算卸载决策方案的性能分析Fig.4 Performance of different computation offloading schemes

本文提出的分布式联邦学习过程中不同卫星的数量对全局模型准确率的影响如图5 所示。令每个卫星当前数据样本(即最优决策范例)个数为1 000。注意到,单星条件下的全局模型为本地模型,其模型决策准确率较低为42.85%。而在多星条件下,通过不断的本地模型传递与聚合,全局模型的准确率不断攀升,在四星协作分布式模型训练的过程中,准确率达到了57.24%。这是因为参与模型训练的卫星越多,提供的数据样本越丰富,因此,全局模型的决策准确率得到了提升。

图5 不同卫星数量下的全局模型准确率Fig.5 Offloading accuracy of the global model under different numbers of satellites

6 结束语

本文研究了基于天基边缘计算的在轨智能技术,提出以天基为核心的空天地海一体化边缘计算架构,对基于深度模仿学习的智能计算卸载进行了建模。该模型可针对多种任务状态及网络状态做出实时的、细粒度的计算卸载决策,并降低空间应用程序的程序执行时延。为提升上述模型的决策准确率并降低星地通信开销,提出了该模型的在轨分布式联邦学习训练方案。后续将继续基于星上边缘计算平台开展星上分布式联邦学习技术研究。