深度卷积神经网络图像识别模型对抗鲁棒性技术综述

2021-09-02计科峰匡纲要

孙 浩 陈 进 雷 琳 计科峰 匡纲要

①(国防科技大学电子信息系统复杂电磁环境效应国家重点实验室 长沙 410073)

②(北京市遥感信息研究所 北京 100192)

1 引言

近年来以深度卷积神经网络为代表的联结主义智能化[1]图像识别方法取得巨大进展,不断刷新光学和SAR图像场景分类、目标检测与识别、语义分割、变化检测等多任务性能水平[2–5]。智能化的一个重要特征就是能够跨任务、跨领域、跨类别进行知识泛化。然而,现有深度卷积神经网络识别模型依赖统计学习,只有在训练数据和测试数据服从独立同分布的假设前提下泛化性能才能得到有效保证[6]。深度卷积神经网络图像识别模型在面对多种不同类型的训练数据和测试数据间分布漂移时,预测性能水平会大大下降,缺乏对输入扰动的鲁棒性。研究表明[7,8]:在输入图像数据中添加细微对抗扰动,对于人类视觉感知信息变化过于微小不可分辨,但是却会导致深度卷积神经网络识别结果产生大范围的波动变化,甚至是严重的错误输出。深度卷积神经网络图像识别模型的对抗脆弱性给其在安全敏感领域的广泛部署带来巨大安全隐患[1,9–11]。

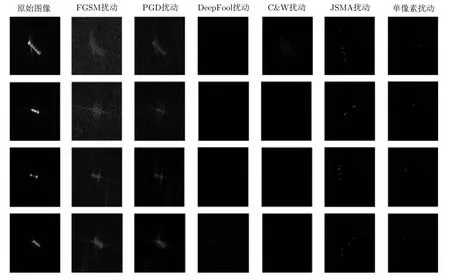

图1给出了深度卷积神经网络SAR图像识别模型不同输入扰动对比示例。对于来自MSTAR数据集[12]的SAR图像目标切片,以俯仰角17°切片作为训练集学习VGG-16网络[13]深度识别模型。如图1所示,测试图像目标真实类别为BMP2,当无噪声干扰时,识别模型预测输出为真实类别;当在测试图像中添加不同形式的噪声扰动后导致模型预测输出为错误类别。对抗扰动或堕化噪声并没有改变输入图像的语义内容,因此深度卷积神经网络识别模型不应该因其存在而改变决策行为。但事实上深度卷积神经网络识别模型很容易被很小的局部变化所迷惑,改变决策行为,以高置信度给出错误判断[7,8]。与堕化噪声相比较,由于对抗扰动产生机理更加复杂、扰动幅度小,人类视觉通常不可分辨、机器统计量很难可靠检测,在安全敏感领域危害性更强。与光学图像相比,SAR图像视觉解译变化量更多、解译难度更大,因此对抗扰动潜在攻击面更广。特别是在数字域对抗扰动的视觉不可感知范围更大,在物理域扰动实现手段更加多样化。

图1 SAR图像深度神经网络识别模型典型扰动对比示例Fig.1 Different perturbations for deep neural networks based SAR image recognition models

针对深度神经网络的对抗脆弱性,文献[9]从模型防御角度综述了图像分类对抗机器学习攻防技术,重点强调设计和评估对抗防御手段应该遵循的基本原则。文献[10]对目标识别应用中的对抗样本技术进行了总结与分析,讨论了对抗样本对于神经网络安全性和鲁棒性的影响,并重点分析了对抗样本的存在性假说及其在多个机器学习模型之间的迁移特性。文献[11]从网络安全角度回顾了针对智能化应用场景的对抗攻击技术,重点关注增强学习和联邦学习场景中智能化模型存在的对抗脆弱性。与现有的相关综述相比,本文聚焦深度卷积神经网络图像识别模型对抗鲁棒性技术研究进展,本文的特色和创新之处在于:(1)从智能化图像识别系统部署和应用流程出发,以信息安全视角全面分析系统存在的安全威胁和潜在攻击面,重点讨论了投毒攻击和逃避攻击特性及对抗脆弱性成因;(2)以对抗动态博弈视角分别建立对抗攻击与防御的威胁模型,按照攻防模型要素梳理现有研究方法,并以SAR图像深度识别模型对抗攻击为例分析典型方法特性;(3)系统介绍了对抗鲁棒性基本定义、对抗攻击、对抗防御、对抗鲁棒性评估的一般思路和指导原则,并结合团队研究工作进展,讨论未来研究趋势。

本文的组织形式如下:第2节从信息安全的角度分析深度卷积神经网络图像识别系统面临的多样化安全风险和脆弱性成因;第3节给出对抗鲁棒性的基本定义,系统总结深度神经网络对抗攻击与防御技术研究进展,分析对抗鲁棒性评估的基本准则和指标体系;第4节归纳现有研究存在的不足,指出一些开放性问题,为下一步研究提供参考。

2 深度卷积神经网络识别系统安全风险

2.1 深度学习图像识别系统安全威胁

以卫星、无人机等为代表的多源空天图像侦察近年来发展迅猛,不断持续获取海量高分辨率图像数据,仅依赖专家判读的数据分析模式已无法满足情报生成的时效性要求。一方面,基于人工智能和深度学习算法的大规模图像内容自动分析已逐步被引入离线情报生产过程中。另一方面,考虑到通信带宽、数据传输效率、情报生成实时性和区域拒止电磁对抗等多因素的影响,未来大量基于深度神经网络模型的多源图像目标检测与识别算法将被部署在边缘计算平台,进行在线目标识别和感兴趣数据筛选。

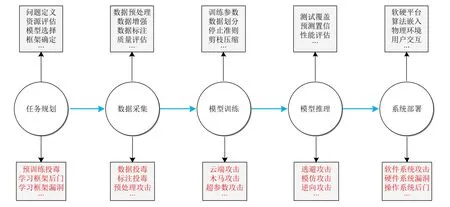

与传统的基于专家系统的符号主义智能化识别系统不同,基于深度卷积神经网络的联结主义智能化图像识别系统涉及全链路的数据复杂处理操作、预训练系统、机器学习框架多个方面,这些方面在军事对抗场景中都可能涉及安全问题[1]。深度神经网络识别系统开发部署过程可以分为任务规划、数据采集、模型训练、模型推理和系统部署5个阶段,如图2所示。

图2 深度学习图像识别系统潜在安全风险Fig.2 Security risks for deep learning based image recognition system

在现实应用中,各个环节间并不一定是序贯的,多个环节间通常会涉及反馈和循环。

(1) 任务规划阶段:开发智能化识别系统的首要问题是明确解决任务的边界条件,明确系统的期望图像输入数据及其分布,估计系统的准确性、鲁棒性、计算资源和运行时效性等指标。然后,对任务进行模块化分解,选择机器学习模型和框架。任务规划阶段面临的主要安全风险形式有学习框架后门和漏洞攻击、预训练模型投毒攻击等[14]。

(2) 数据采集阶段:在确定好问题的边界条件后,需要采集和整理用于深度识别模型的大规模标注训练数据集和测试数据集。为了提升模型的准确性指标和收敛速度,通常会采用图像几何变换和光度变换、物理仿真、对抗图像生成等方式进行训练数据扩充。数据采集与预处理阶段面临的主要安全风险形式有数据投毒攻击[15]、标注投毒攻击、图像尺度变换攻击[16]、数据集偏差攻击等。

(3) 模型训练阶段:对训练数据集合进行合理划分,在固定边界条件下进行模型架构或参数学习,确定迭代轮次、停止准则、学习率等超参数。资源受限应用场景中还需要考虑模型的剪枝和压缩问题。模型训练阶段面临的主要安全风险形式有云端攻击、木马攻击和超参数攻击等[17]。

(4) 模型推理阶段:对训练完成后的深度模型进行准确性和鲁棒性测试,以期满足预设指标。模型推理阶段面临的安全风险最大,常见的攻击形式有逃避攻击、模仿攻击和逆向攻击[18]。推理阶段的许多攻击方法不需要获取数据和模型的先验信息,采用黑盒方法,基于迁移性进行攻击,安全危害极大。逃避攻击的代表形式是深度识别模型的对抗样本。通过在目标外部添加特定设计的图案可以有效地逃避自动化算法的探测识别,与传统的电磁隐身伪装不同,基于对抗样本的智能扰动逃避攻击成本更低、部署和应用更加灵活。

(5) 系统部署阶段:将测试完成后的模型部署到相应的软硬件平台中,并完成真实物理环境中用户交互验证。系统部署阶段面临的主要安全风险有软件系统攻击、硬件系统漏洞、操作系统后门等[19]。

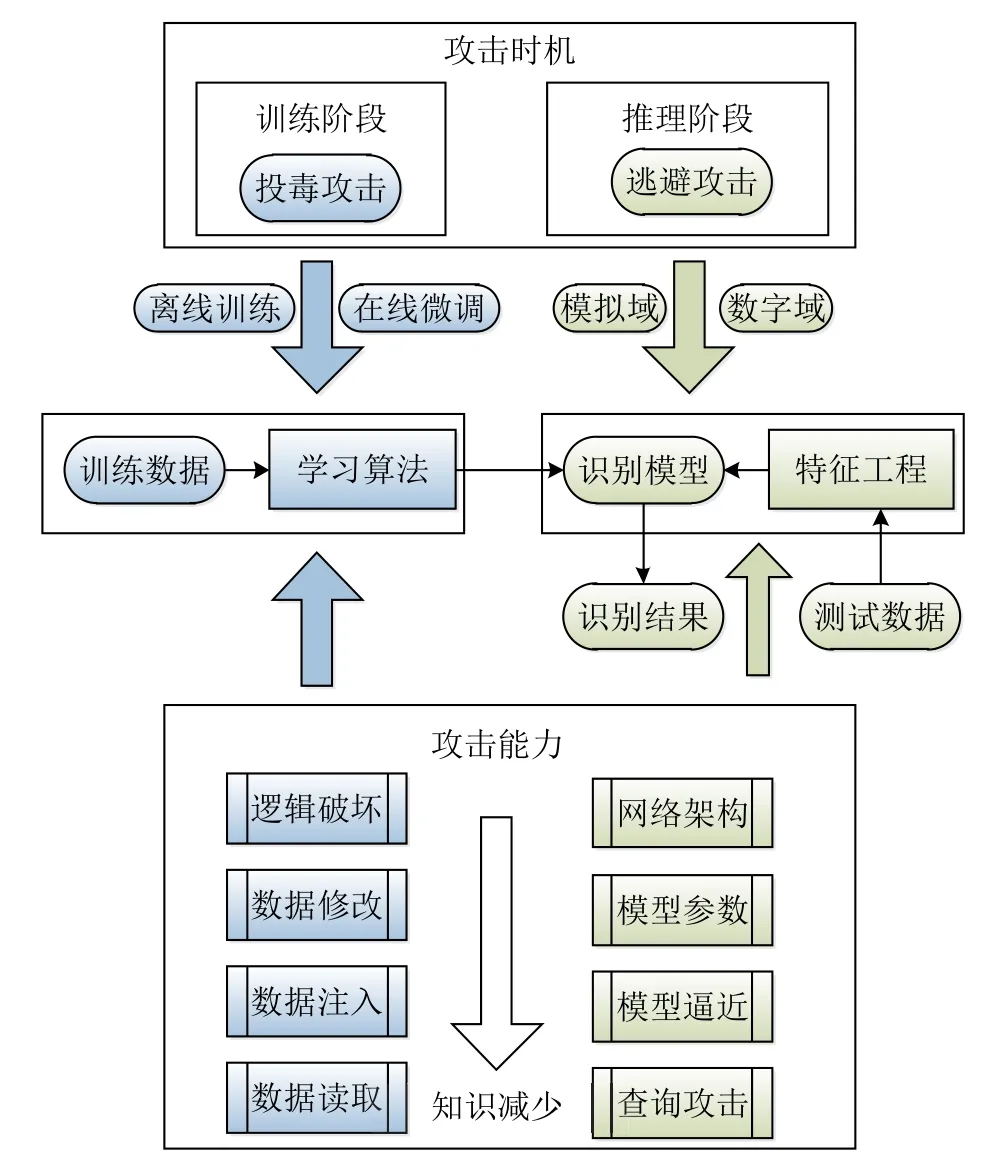

所有潜在攻击样式中,针对深度神经网络模型训练阶段的数据投毒攻击和针对模型推理阶段的逃避攻击在图像处理领域研究受到广泛关注,其攻击时机与攻击能力如图3所示。随着攻击知识的减少,投毒攻击的攻击能力按照逻辑破坏、数据修改、数据注入和数据读取等几个层次依次递减;逃避攻击的攻击能力按照网络架构、模型参数、模型逼近、查询攻击等几个层次依次递减。投毒攻击的实施可以是离线数据采集与模型学习阶段,也可以是在模型在线微调阶段;逃避攻击的实施可以是在物理域中构建光电或射频扰动,也可以在数字域中添加对抗噪声。

图3 深度学习训练阶段和测试阶段攻击对比Fig.3 Comparison of training stage attacks and testing stage attacks for deep learning

数据投毒攻击通过在训练数据集合中注入虚假数据或混淆性标记信息,影响深度模型的归纳偏差,造成模型推理性能下降。如图4所示,通过在训练集中添加污染后的有毒数据,造成正确模型的决策边界出现偏离,从而造成测试样本的类别识别出现错误。逃避攻击不干扰训练数据,仅在推理阶段调整测试样本。逃避攻击的典型实现方式是生成对抗样本,通过在测试样本中添加微小非随机性扰动造成模型错误输出。对抗扰动通过面向识别模型的对抗攻击优化算法生成,通过细微扰动跨越模型的决策边界。

图4 投毒攻击与逃避攻击基本原理Fig.4 Illustration of poisoning attack and evasion attack

2.2 投毒攻击和逃避攻击脆弱性成因

深度图像识别系统可能在多个阶段和层次被攻击,其中许多潜在安全风险是信息安全领域的普遍问题,本节重点分析与深度学习过程紧密相关的投毒攻击和逃避攻击脆弱性成因。

2.2.1 训练数据依赖性

深度神经网络图像识别模型的准确率和鲁棒性高度依赖训练数据的数量和质量。只有在训练数据是无偏的情形下,深度识别模型才能达到理想的性能。深度识别模型仅仅从数据中学习得到了相关关系,而相关关系往往会随着数据分布的变化而变化,模型本身无法将虚假的相关与真实的因果区分开来。在许多安全敏感领域,大规模高质量训练数据严重稀缺,仅有的少量训练数据中还存在类别不平衡性和标注不确定性等问题,这些因素都严重加剧了模型的泛化风险和对抗脆弱性。与标准深度识别模型相比,鲁棒深度识别模型的样本采样复杂度更高,对标注数据的依赖性更强。采用预训练模型进行参数初始化可以加速模型收敛、提升模型性能,但同时会将预训练模型所采用数据集中的偏差、虚假相关、投毒数据等引入后续模型。在线微调阶段,物理域或数字域所产生的对抗样本都可以应用于投毒过程。

2.2.2 输入与状态空间高维特性

复杂的深度识别模型包含数百万量级参数,为了逼近决策函数这些参数需要在训练过程中进行迭代更新。参数的组合空间巨大,模型对输入数据的决策边界只能逼近求解。由于模型的高度非线性,因此输入数据的微小扰动可能会产生巨大的输出差异。训练数据一般情况下位于完备输入空间的低维流形,该现象通常也称为“维度灾难”。以VGG-16模型为例,16层深度的模型参数约135 M,采用二进制比特表示时输入空间维度为2224×224×3×8=21204224(模型输入图像空间大小为224像素×224像素,波段通道为3个,数字值量化为8比特位),因此训练数据集合仅仅覆盖了输入空间中非常小的一部分,大量可能的输入数据,在训练过程中并没有利用。一方面,如果给模型输入训练过程中未观测到的良性数据,并且该数据与训练数据差别较大,那么模型可能无法泛化到这些输入数据,造成模型的安全风险。另一方面,当故意设计的对抗样本输入模型时会造成系统错误输出。文献[20]认为对抗样本存在于数据流形的低概率空间,很难通过随机采样输入数据的近邻空间得到,对抗样本所在区域是模型预测不确定性的盲点。尽管主流的深度卷积网络模型为了提升鲁棒性,在训练过程中都进行了数据增广,但变换后的数据与原始输入数据高度相关,且来自同样的数据分布,然而对抗样本通常呈现非相关和非同分布特性。此外,对抗样本生成过程中,向正常干净样本添加非随机噪声违背了模型训练过程中关于统计噪声的隐性假设。

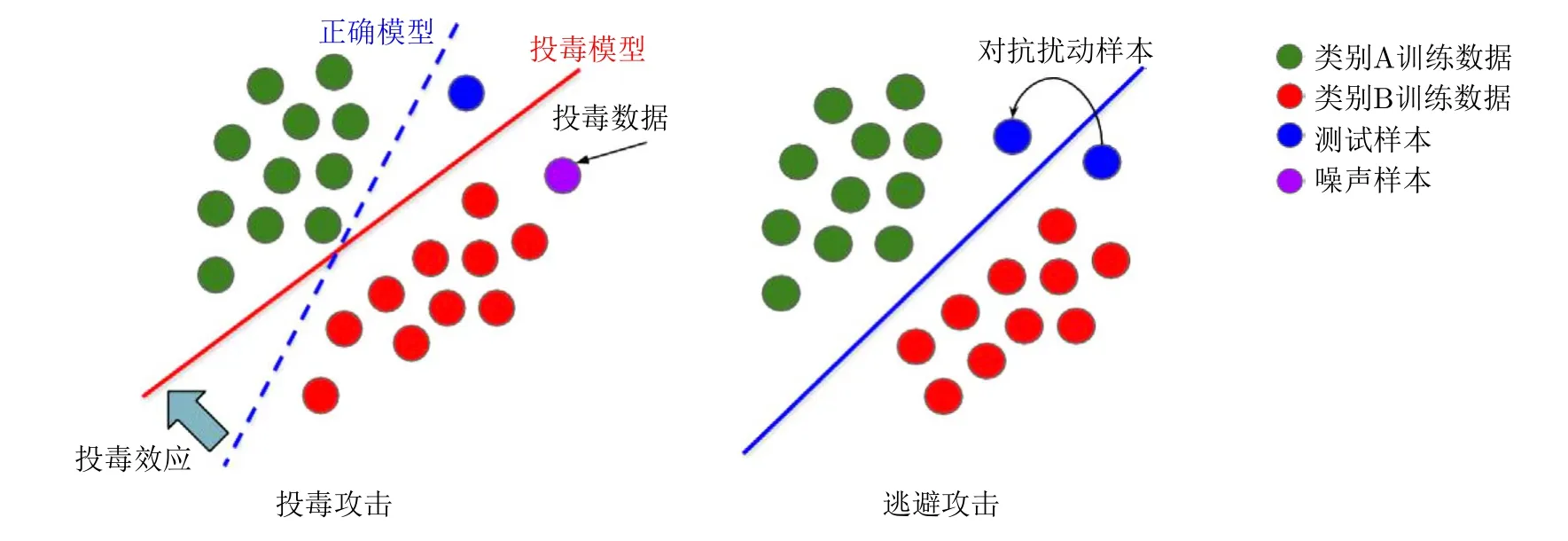

由于理论上理想的任务决策边界通常在实际中只能通过模型决策边界近似,因此图像解译过程中无论是人类判读还是深度识别模型都是会出现错误的。模型通过数据和进化过程进行训练。在训练得到的模型中,传感器输入或其他边界条件的微小变化都有可能会导致状态改变,在状态空间中跨越决策边界。例如输入中出现的传感器微小噪声可能导致输出的巨大改变。任务决策边界与模型决策边界之间并不一定总是能够重合,在两者不同的区域,输入空间中常常存在对抗样本。图5表示输入空间二维投影中存在的对抗样本。输入空间中,存在4个类别的数据样本,类别A的深度识别模型决策边界由3个决策边界共同构成。类别A的任务决策边界与模型决策边界存在差异,在跨越或不跨越任务决策边界前提下,位于模型决策边界周围的样本都很容易受到微小扰动的影响造成模型输出错误。在高维空间中,搜索非重合区域内的样本很容易构造对抗样本。

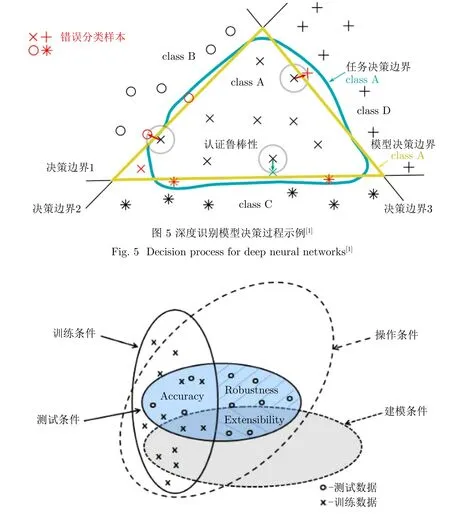

图6为MSTAR图像目标识别性能评估策略的对比示意图[5,21],这些评估准则确定了标准操作条件和扩展操作条件。标准操作条件是由现有数据集合构成的训练条件和测试条件,扩展操作条件是由建模条件定义。可见,不同条件下的输入空间存在部分不重叠区域和未覆盖区域,这些区域内的数据点都很容易被用于生成攻击样本。

图6 MSTAR性能评估策略[21]Fig.6 Performance evaluation strategy for MSTAR[21]

2.2.3 黑盒特性与难解释性

基于深度卷积神经网络的图像识别模型结构设计和参数优化过程复杂,缺乏可解释性。用于解决图像处理任务的传统计算机程序是很容易理解的,对于具有充分知识背景的编程人员来说,系统是透明的。然而由于深度神经网络巨大的参数空间,复杂的深度识别模型不具备这一特性。编程人员仍然可以理解任务边界条件和解决任务的方法,但无法直接将神经网络的内部表示转换为理解其行为特性的工具。从信息安全的角度来看,这意味着只能通过模型的错误行为(而不是模型本身)来检测攻击,而模型的错误行为描述仍然是一个困难的问题。因此训练过程结束后,由于模型缺乏透明性,很难检测训练数据中存在的投毒攻击。

在安全敏感领域中需要提升深度识别模型的透明性和可解释性,特别是在军事应用领域,需要建立用户与智能识别模型之间的信任关系,辅助用户进行决策。可解释性深度识别模型的研究有两类典型思路[22–24]:一类是分析模型的动态特性,通过在输入变量中添加扰动或调整模型参数,对系统的输出进行统计分析,推测模型的决策依据。另一类是直接构建结构化和可解释性更强的深度网络模型。

3 深度卷积神经网络对抗鲁棒性研究进展

3.1 对抗鲁棒性定义

深度卷积神经网络识别模型可以描述为一个函数:fθ:X →Y,将输入图像空间中的一个向量x ∈X映射到标记空间中y ∈Y,其中θ ∈W是函数的参数变量,W,X和Y分别表示深度卷积神经网络的权重空间、输入空间和输出空间。深度识别模型将整个输入空间划分为一组区域,每个区域具有唯一性的类别标记,识别模型的决策边界可以利用两组不同标记区域的交汇点集来定义。在有监督学习条件下,给定数据对(x,y)的分布D,学习算法的目标是寻找一个分类器将任意的输入x映射到标记y,使得在分布D上的期望风险最小化,即

其中,L(x,y;θ)表示特定形式的损失函数。实际应用中我们无法获取所有的数据分布D,仅仅利用一组训练样本集合因此无法通过最小化期望风险获得fθ。通常求解经验风险最小化问题,即

深度卷积神经网络识别模型通常由多个前馈神经网络复合构成,其中第t层的输出zt ∈RDk依赖前一层输出:

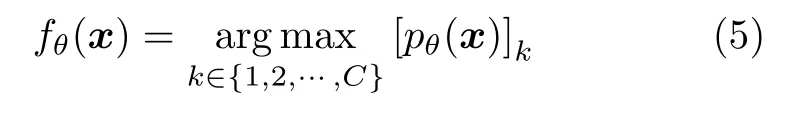

神经网络识别模型输出结果是最高概率密度的标记索引:

深度识别模型对随机噪声扰动具有一定的鲁棒性;但对于对抗扰动,神经网络表现出极差的对抗脆弱性[7–11]。对抗扰动是输入x的最坏情形微小扰动,经过精心设计用于欺骗神经网络。而且现有研究表明:对于任意的x和 识别模型fθ总是可以找到对抗扰动,表明神经网络的决策边界在某些方向上靠近给定的数据样本,因此在这些方向上添加很小的扰动就可以改变分类器的输出结果。

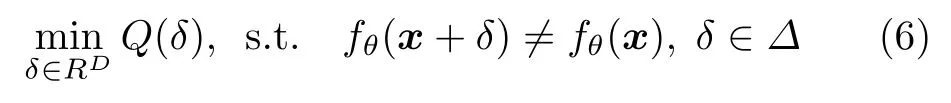

定义对抗扰动δ(x)∈RD是下述优化问题的解[25]:

其中,Q(δ)表示目标函数的一般形式,Δ表示刻画扰动特性的一组约束集合。不同类型对抗扰动主要差别在于Q(δ)和Δ,例如最小ℓp范数对抗扰动定义为

式(7)表示在ℓp范数度量下,跨越识别模型决策边界的最小加性扰动。

ε约束对抗扰动定义为

式(8)表示在给定数据样本x的ε邻域内最大化损失函数的最坏情形扰动,ε的取值使得最终的扰动尽可能小,视觉不可感知。文献中还有其他形式的距离度量来定义对抗样本,例如数据流形测地线距离、感知度量和Wasserstein距离等。在现有的对抗扰动研究中,ℓp扰动研究得最为广泛和深入。

对抗样本很容易计算且大量存在,暴露出深度神经网络识别模型的脆弱性。为了解决这个问题,需要定义客观的度量来量化神经网络对于对抗扰动输入的鲁棒性。根据应用场景和任务的不同,fθ对抗鲁棒性的定义可以有多种形式,一种常用的定义是基于对抗场景中分类器的泛化能力,即对抗扰动输入时神经网络的最坏情形准确率。

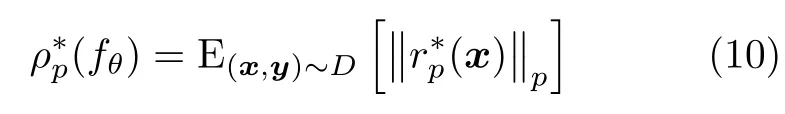

考虑神经网络决策函数的几何特性,可以通过计算任意样本到神经网络的决策边界的平均距离定义对抗鲁棒性:

几何视角描述对抗鲁棒性的优势是鲁棒性的计算与对抗扰动产生算法无关,对抗鲁棒性是分类器的特性。采用几何测度,提升分类器的对抗鲁棒性意味着将决策边界与数据样本远离。采用式(9)测量分类器的鲁棒性还存在很多挑战,例如现有对抗攻击方法在计算扰动δ(x)时并非最优。然而,我们可以通过计算所有样本和神经网络决策边界的安全距离来验证分类器的鲁棒性。分类器如果是ℓp范数下ε认证鲁棒的,那么分类器在任意样本的半径为ε的ℓp超球邻域内输出稳定的标记信息。在高维空间中进行鲁棒性认证,需要大量的计算代价,因此目前一般都是针对特定形式的分类器。

3.2 对抗攻击研究进展

3.2.1 对抗攻击模型

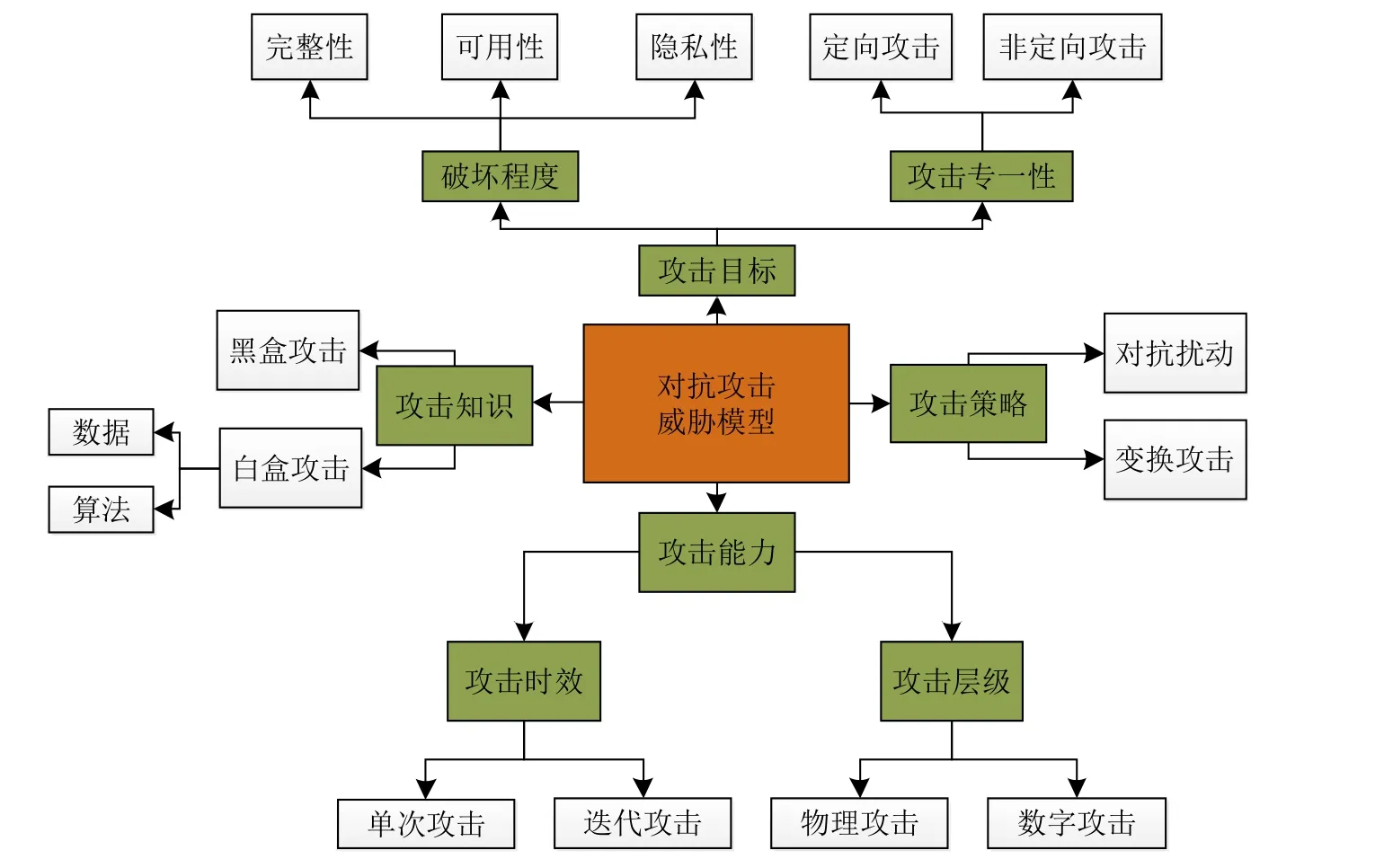

聚焦深度模型推理阶段的安全风险,建立对抗攻击威胁模型如图7所示,主要包括对抗攻击目标、对抗攻击知识、对抗攻击能力和对抗攻击策略4个方面[26,27]。对抗攻击的目标可采用安全破坏程度和攻击专一性进行描述。安全破坏程度主要是指对抗攻击者期望破坏深度识别系统的完整性、可用性或隐私性;攻击专一性主要包括定向攻击和非定向攻击两类。例如对抗攻击的目标可以是产生一个特定类别的识别错误攻击或非定向性的系统识别功能破坏攻击。对抗攻击的知识根据攻击者获取的先验信息来进行考虑,通常可以分为白盒攻击和黑盒攻击。白盒攻击场景下,攻击者已知识别模型的架构与参数、训练数据、预训练模型等信息,攻击效果最强。黑盒攻击场景下,攻击者仅通过有限的查询访问或对抗样本的迁移特性实现攻击。攻击能力采用攻击时效和攻击层级两个维度描述。对抗攻击时效可分为迭代型攻击和单次性攻击,虽然迭代型攻击效果较好,但军事应用场景中单次性攻击的危害性也需要重点关注。对抗攻击策略是指攻击者为了达到攻击目的而采取的图像内容或特征修改措施,典型策略有对抗扰动生成和变换攻击。基于对抗扰动生成的逃避攻击,通常称为对抗攻击。在许多安全敏感领域,攻击者很难获取训练阶段数据或相关信息,基于对抗样本的深度识别模型推理阶段对抗攻击威胁性更高,因此受到学术界和工业界的广泛关注。

图7 对抗攻击威胁模型Fig.7 Threat model for adversarial attacks

3.2.2 对抗样本生成

图8描述了对抗样本生成的一般流程[18]。在白盒攻击场景中,攻击者通过求解梯度优化或约束优化问题、敏感性分析、生成模型采样等方式构造对抗样本[7–11,18,19,26,27];在黑盒攻击场景中,攻击者通过多次查询被攻击模型获取相关信息,然后训练替代模型进行白盒攻击,或者估计梯度和近似决策边界来寻找对抗样本[7–11,18,19]。

图8 对抗样本生成流程Fig.8 Flowchart for adversarial example generation

表1归纳总结了典型对抗样本生成方法的攻击知识、攻击目标、攻击策略、扰动度量和扰动范围。对抗样本主要包括个体扰动对抗样本和通用扰动对抗样本两类。个体扰动对抗样本是指对于给定的测试图像,根据优化算法生成特定的扰动,不同图像扰动模式不同;通用扰动对抗样本是指在特定数据集上或针对特定识别模型产生的扰动模式,对于数据集中的所有图像该扰动模式保持不变。对抗攻击策略主要包括图像空间扰动、特征空间扰动和决策空间扰动3类,在图像空间和特征空间进行扰动通常采用生成模型、梯度优化和敏感性分析算法实现,在决策空间进行扰动常采用约束优化算法实现。

为了说明典型攻击方法对雷达图像深度目标识别模型的影响,在MSTAR数据集上,以俯仰角17°目标切片图像作为训练集学习VGG-16深度识别模型,攻击目标设定为定向攻击,采用PGD (Projected Gradient Descent)[36],DeepFool[30],C&W[34]3种方法的定向攻击版本生成对抗扰动。PGD攻击噪声范数选用L∞,攻击强度设定为0.3;Deep-Fool攻击步长设定为10–6,最大迭代次数设定为100次;C&W攻击方法学习率设定为0.01,最大迭代次数设定为100。采用Grad-CAM方法[57]对3种方法生成的定向攻击样本、无扰动干净样本(原始类别和定向攻击目标类别)在VGG-16识别模型的激活响应进行可视化,第2,4,7,10,13卷积层特征激活结果如图9所示。其中第1行图像分别为真实类别(BTR70)的测试图像、采用3种攻击方法生成的定向攻击个体扰动对抗样本(BTR70定向攻击为ZIL131)、真实类别为ZIL131的测试图像(作为参考对照),由于对抗扰动的幅度微小,因此3种方法生成的定向攻击样本与原始图像人眼无法分辨其中差别。观察特征层的激活情况容易发现:基于梯度优化的PGD攻击对抗样本从低层(第2层)卷积特征开始就与定向攻击类别的激活响应具有较高的相似性,攻击目标实现依赖多隐层特征空间扰动;基于约束优化的DeepFool攻击方法和C&W攻击方法产生的对抗样本仅在高层(第13层)卷积特征激活与真实类别具有较高的特征激活相似度,攻击目标实现更多依赖决策空间扰动。

图9 SAR图像目标识别定向对抗攻击举例Fig.9 Targeted adversarial attacks for SAR image target recognition

图10展示了来自FUSAR-Ship数据集[58]的4幅SAR舰船目标图像切片及典型攻击方法产生的对抗扰动(实验细节见文献[59]),4幅图像的类别从上至下依次为集装箱船、货船、渔船和油轮。为了显示效果,所有的对抗扰动都进行了放大。基于梯度优化的对抗扰动(FGSM,PGD)、稀疏对抗扰动(JSMA,单像素)和基于约束优化的对抗扰动(DeepFool,C&W)在扰动模式上呈现明显的差异。FGSM和PGD扰动模式更加聚焦原始图像中的图像灰度变化剧烈区域,与图像梯度紧密相关。JSMA和单像素扰动仅仅改变了少量像素,但对抗扰动幅值较大。DeepFool扰动和C&W扰动改变了大量像素,但对抗扰动幅值较小。

图10 FUSAR-Ship数据子集对抗扰动举例[59]Fig. 10 Adversarial perturbations on images from FUSAR-Ship dataset[59]

3.3 对抗防御研究进展

3.3.1 对抗防御模型

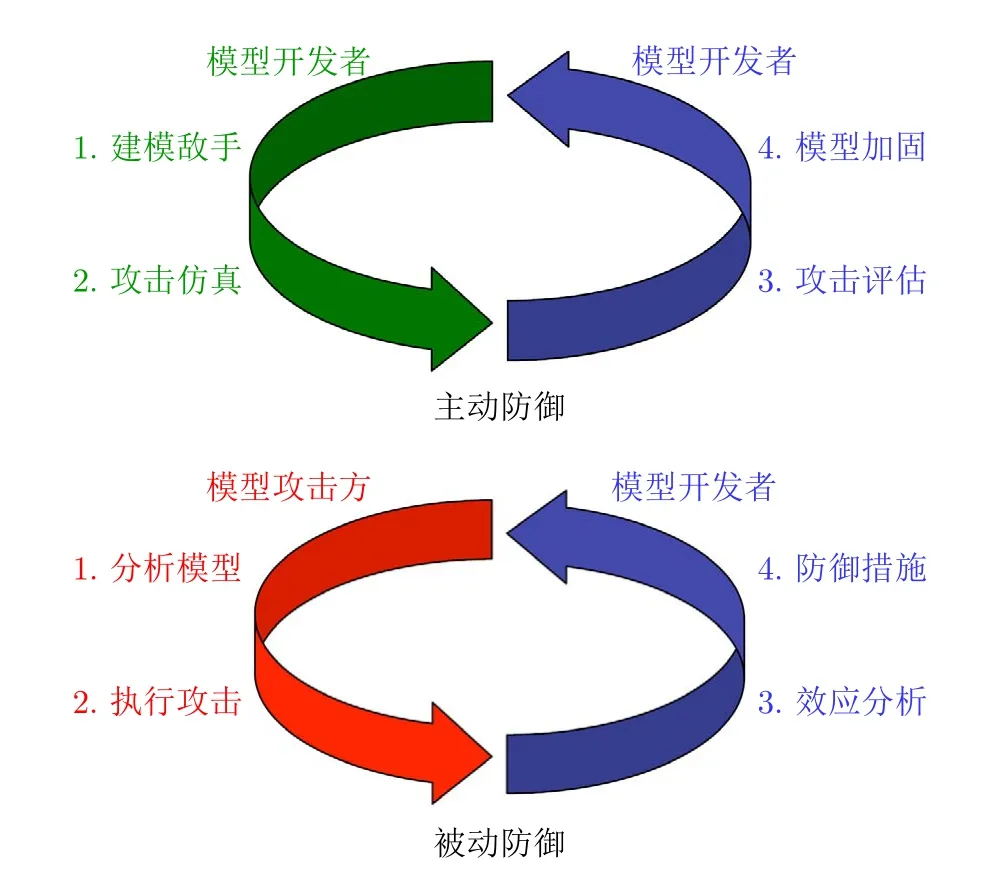

大量对抗样本生成方法的不断提出,催生深度神经网络识别模型防御技术迭代演进,两者之间形成对抗攻防竞赛。根据防御目标的不同,对抗防御技术可以分为主动性防御和被动性防御两类[60,61],两者之间的区别如图11所示。主动性防御技术是深度识别模型的开发者主动进行仿真攻击发现模型缺陷,并对模型进行鲁棒性提升。模型开发者首先通过分析敌手对抗攻击过程,建立对抗攻击威胁模型;然后仿真不同攻击目标、攻击知识、攻击策略和攻击能力情形下的攻击样式,对识别模型进行对抗攻击鲁棒性评估;最后设计并开发相关手段对模型进行加固,消除潜在的对抗风险。主动性防御技术的实现过程中不涉及真实的攻击敌手,是模型开发者自我模拟博弈对抗过程。被动性防御技术涉及真实对抗场景中模型攻击方与模型开发者之间的动态博弈进化。一方面,深度识别模型的攻击方通过分析模型的对抗脆弱性,设计并执行对抗攻击。为了达到更好的攻击效果,对抗攻击机理和样式不断演变,例如复合攻击和自动化攻击。另一方面,模型开发者通过分析对抗攻击给识别模型带来的多样化影响,研究提出新的对抗防御方法,并及时更新识别系统安全措施。

图11 对抗攻击防御模型[60]Fig.11 Defense model for adversarial attacks[60]

3.3.2 对抗攻击防御与检测

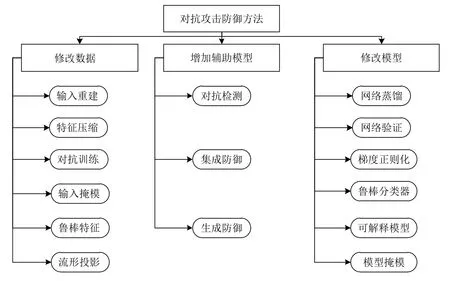

根据防御策略的不同,对抗攻击防御方法可以分为修改数据、修改模型和增加辅助模型等[26],如图12所示。修改数据类方法基本思想是通过在训练阶段或测试阶段修改数据及特征实现防御,典型方法包括通过图像样本重建消除对抗扰动、压缩特征空间减小被攻击概率、引入对抗样本到训练集合中进行模型重训练、易干扰特征添加掩模、利用数据的不同属性关联提取鲁棒性特征、输入图像投影到训练数据流形等。修改模型类方法基本思想是修改从数据学习得到的模型结构或参数信息实现防御,典型方法包括网络蒸馏、网络验证、梯度正则化、鲁棒分类模型、可解释性机器学习模型和模型安全性掩模等。增加辅助模型方法通过引入额外的网络模型增强鲁棒性,典型策略包括对抗样本检测网络、多防御策略集成网络、生成模型网络等。

图12 对抗攻击典型防御方法分类[26]Fig.12 Taxonomy of defense methods for adversarial attack[26]

按照防御目标和防御策略的不同,表2对典型对抗攻击防御方法进行了总结分析。如表2所示,所有的防御方法都是在假设特定对抗攻击下进行评估的,PGD通常被认为是白盒攻击场景下评估防御方法的一种有效基准攻击。基于PGD攻击样本的对抗训练防御策略目前是对大多数攻击方法防御效果最好的一类防御方法。但是对抗训练会导致模型在干净数据集上泛化性能的下降,此外对抗训练过程涉及最大最小优化问题,训练过程十分耗时,在大规模数据集上的应用受限。

表2 对抗攻击防御方法Tab.2 Defense methods for adversarial attack

对抗样本检测方法可以看成是一类被动防御方法,对推理阶段的所有测试样本首先进行诊断,判断是否可能为恶意对抗样本。对抗样本检测与深度模型预测不确定性、分布外检测等领域紧密相关,核心思想是利用集成策略、度量方法、不一致性准则和生成性方法在推理阶段检测可靠泛化区域外的异常样本[122]。对抗样本检测4类典型方法的基本原理如图13所示。集成检测方法同时利用多个经过不同训练过程的深度神经网络识别模型。在推理阶段,多个识别模型分别独立产生输入数据的预测结果。多个网络的预测输出差别越大,那么该输入样本的决策错误可能性就越大。由于多个网络的决策边界之间存在差别,所以当对抗样本在分布内并且靠近决策边界时,该检测策略效果较好。但是分布外对抗样本或者特定类型的对抗样本有可能在特征空间中远离决策边界,对于这些对抗样本需要采用其他的检测方法。如果测试样本的动态激活特性与训练数据集合中泛化区域内的样本动态激活特性相似,则度量检测方法判断该样本为正常样本;动态激活特性的大差异性表明对抗样本在可靠泛化区域外。生成检测方法是利用采用数据生成策略,判断测试样本是否在训练数据的生成流形上,通过计算偏移程度检测对抗攻击。度量检测方法通常涉及输入数据、多个隐含层、输入输出组合损失函数梯度等多个环节的变换比较。不一致性方法是采用图像变换方法将一个测试样本变换成多个不同版本,然后比较多版本增强图像是否存在输出不一致的问题,从而判断测试样本是否为对抗样本。

图13 对抗样本检测方法[122]Fig.13 Adversarial example detection methods[122]

3.4 对抗鲁棒性评估进展

为了严格评估深度神经网络的对抗鲁棒性,文献中已经提出了大量评估准则或基准数据集[34,123–132]。防御评估的准则主要有:针对敌手进行防御、测试最坏情形下的鲁棒性、以人类识别能力衡量深度模型的进步等。防御评估的建议主要有:同时采用定向攻击和非定向攻击、进行消融实验、多样化测试设置、在多领域进行防御评估、采用随机性集成策略、利用迁移攻击、提供鲁棒性上限等。现有的对抗攻防评价测度通常采用简单的攻击成功率或分类正确率指标,导致模型输出评估不充分。例如在特定扰动幅度下攻击分类正确率不能衡量模型在对抗场景中的内在行为特性。针对图像分类任务中面向Lp范数约束对抗扰动和常见堕化扰动的深度模型鲁棒性评估,文献[127]提出了一组评估指标,如表3所示。表3的评估指标主要可以分为面向数据的评估测度和面向模型的评估测度,按照行为特性、架构、对抗扰动、堕化扰动、攻击知识和攻击模型等维度对评估指标进行细化分解。由于模型鲁棒性评估是采用一组扰动测试样本进行,因此首先采用神经元覆盖和数据不可感知度等面向数据的测度衡量测试样本的完整性。其次,采用决策边界距离变化、模型神经元敏感性和不确定性、堕化性能等指标评估模型在对抗场景中的动态特性。

在FUSAR-Ship数据集中我们通过人工选择4类数据样例数目较多、图像质量较好的SAR舰船目标图像420幅[59],其中集装箱船122幅、货船158幅、渔船94幅和油轮46幅。每个类别选取80%样本作为训练样本,20%样本作为测试样本,选择在该数据子集上对抗鲁棒性较好[59]的ResNet101对4类白盒攻击方法(FGSM,PGD,DeepFool,C&W)和2类黑盒攻击(HSJA、单像素)方法进行评估,其中FGSM,PGD攻击无穷范数阈值设置为16,其他攻击方法为最小扰动。从深度模型误识别和扰动不可感知两个方面,从表3中选取代表性指标进行评估,其量化评估见表4,其中,分类正确率指标有:平均分类正确率、对抗类别平均置信度

表3 对抗鲁棒性评估指标体系[127]Tab.3 Adversarial evaluation for deep models[127]

表4 SAR舰船目标识别深度模型对抗鲁棒性评估实例[59]Tab.4 Adversarial robustness evaluation of deep models for SAR ship recognition[59]

(Average Confidence for Adversarial Class,ACAC)、正确类别平均置信度(Average Confidence for True Class,ACTC);平均Lp失真度(Average Lp Distortion,ALDp)衡量对抗样本与原始图像间的p范数距离,值越小失真越小,代表攻击效果更好;平均结构相似度(Average Structural Similarity,ASS)衡量攻击成功的对抗样本与原始图像间的自相似性,值越大代表对抗样本越难以用人眼进行识别;扰动敏感距离(Perturbation Sensitivity Distance,PSD)衡量人类感知扰动的指标,值越小代表越难以被人类视觉察觉;误分类与最大概率差(Noise Tolerance Estimation,NTE)衡量对抗样本在保持错误分类不变的情况下所能忍受的噪声,值越大代表攻击方法更加稳健。

4 开放性问题

深度卷积神经网络图像识别模型的对抗鲁棒性与其泛化性、安全性、隐私性和可解释性等特性紧密相关,近年来在学术界和工业界都进行了广泛而深入的研究,大量研究成果不断涌现,然而仍有许多开放性问题值得重点关注。

(1) 深度卷积神经网络识别模型的对抗脆弱性成因在理论上还需要进一步深入研究[133–139]。目前关于对抗样本在理论上为何存在及其特性描述等基础性问题学术界研究还没有形成统一的认识。深度卷积神经网络图像识别模型对抗鲁棒性与模型泛化性、模型堕化噪声鲁棒性之间的关系在理论上和实践中仍需进一步研究。

(2) 利用无监督数据提升深度识别模型的对抗鲁棒性是未来重要研究方向[140–144]。目前对抗鲁棒性最有效的提升方法是采用最大化模型损失的对抗样本重训练深度网络模型,对抗训练过程十分耗时。此外,鲁棒深度识别模型的样本采样复杂度要比标准模型更高,因此需要更大规模的高质量标记数据集。在许多应用领域中,大规模高质量标记数据集获取不仅十分耗时,而且代价昂贵。充分挖掘无标记数据中的潜在语义关系和因果关系将大大降低鲁棒识别模型学习算法对标记数据的严重依赖。图14为本研究团队开展的基于无监督对抗扰动的深度识别模型对抗鲁棒性提升结果。在NWPU-RESISC45数据集上[145],采用ResNet18网络结构[146],利用 BYOL对比学习过程的梯度下降产生无监督对抗扰动[147,148],并最大化每个实例图像与其无监督对抗扰动版本间的相似性,构造更加稳健的预训练特征编码网络。特征编码器的训练过程无需任何标记数据,每个类别选取400幅图像,训练过程不使用标记信息。在经过微调(每个类别选取200幅图像进行有监督学习)后,可以获得鲁棒性更强的识别模型。对比标准模型(每个类别选取600幅有监督图像进行训练)和无监督鲁棒提升模型(每个类别选取400幅图像进行无监督对抗对比预训练,200幅图像进行有监督微调)在正常样本及PGD攻击样本的激活情况,可以看到:通过无监督数据可以将深度模型的特征编码更加聚焦在显著目标区域,减小非鲁棒性特征对识别结果的影响。

图14 无监督数据提升对抗鲁棒性Fig.14 Unlabeled data for improving adversarial robustness

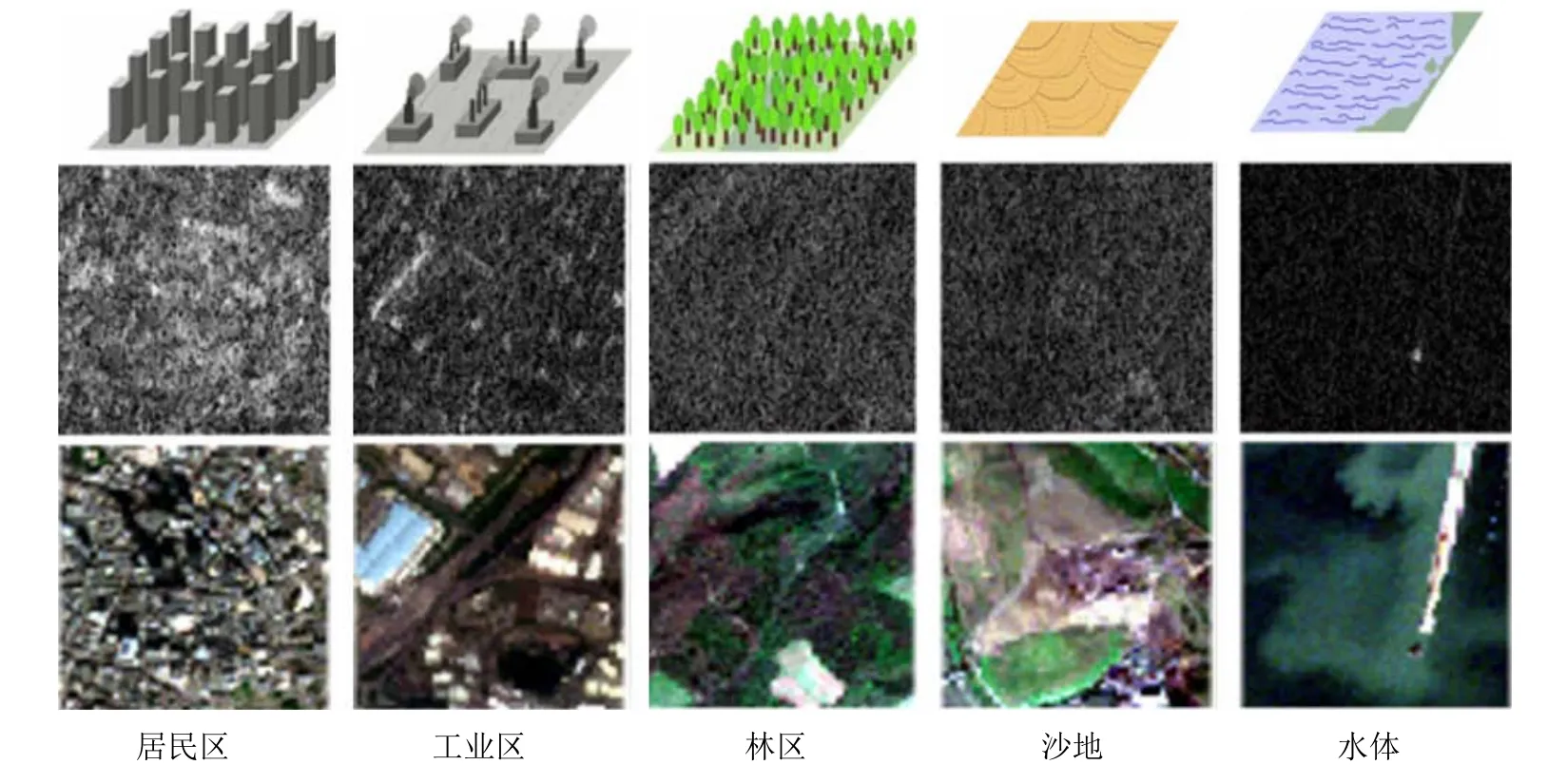

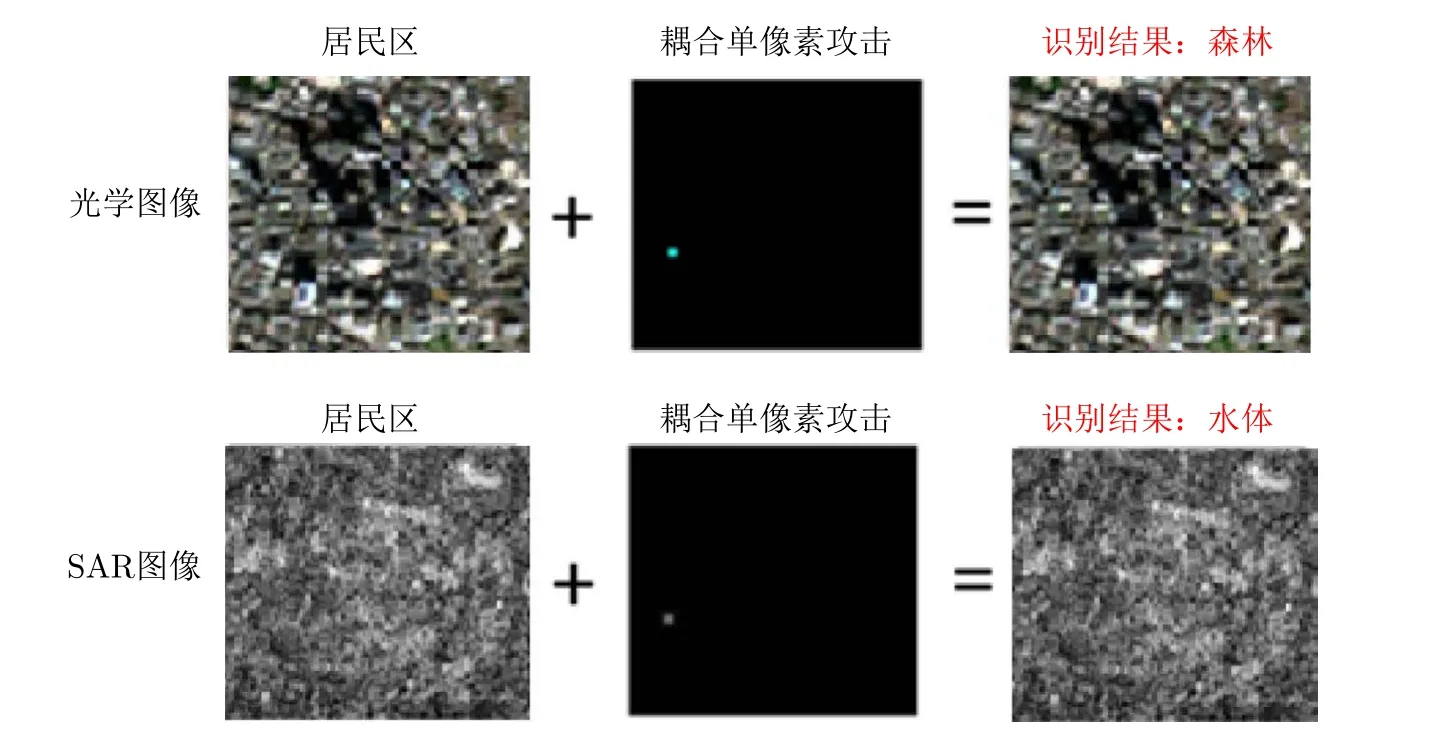

(3) 多传感器耦合对抗攻击与防御将更具实际应用价值[149–153]。在自动驾驶和军事侦察等多种应用场景同时存在光电和微波等多类图像传感器,现有的攻击算法重点关注光电对抗智能扰动技术,很容易在其他波段暴露。深度学习在多源图像处理任务结构上的相似性会导致耦合攻击风险。在So2Sat LCZ42标准数据集上[154]选择居民区(训练样本256幅,测试样本266幅)、工业区(训练样本860幅,测试样本905幅)、林区(训练样本2287幅,测试样本2365幅)、沙地(训练样本672幅,测试样本570幅)和水体(训练样本2609幅,测试样本2530幅) 5类数据子集,数据子集中的示例图像如图15所示,第1行为地物空间分布示意,第2行为SAR样例图像,第3行为SAR样例图像对应的光学图像(已完成空间几何配准)。

图15 So2Sat LCZ42数据子集示例[154]Fig. 15 Examples images from the So2Sat LCZ42 dataset[154]

实验中选择光学图像(RGB波段)和SAR图像(垂直极化)数据分别训练ResNet18模型,优化器选用Adam优化器,学习率设为10–3,batch_size大小设为256,得到光学识别模型和SAR识别模型。采用修改后的单像素对抗样本生成方法[52]攻击两个识别模型,首先对初代种子的参数进行初始化,其中噪声点位置初始化为32×32图像中均匀随机分布,噪声强度信息初始化服从高斯分布,初代投放100个种子,经100次种群选择,最终挑选出攻击效果最佳的对抗样本。如图16所示,仅仅扰动同一个像素位置的数字值,光学图像和SAR图像添加的扰动幅度不同,便可以同时欺骗光学和SAR图像识别模型。统计结果表明:在协同攻击同一位置像素的情况下,可以将光学识别模型的正确率由92.36%降低到30.98%,同时将SAR识别模型的正确率由81.24%降低到42.07%。

图16 多传感器耦合对抗攻击实例Fig.16 Adversarial attacks for multiple sensors

5 结语

基于深度卷积神经网络模型的新一代智能化图像识别系统已逐步在医疗、安防、自动驾驶和军事等安全敏感领域广泛部署。然而现有深度识别模型依赖大规模高质量的训练数据,只能提供有限的可靠性能保证,并且缺乏可解释性,给模型在复杂电磁环境下强对抗场景中的实际应用带来严重安全隐患。本文从信息安全、对抗攻防威胁模型两个方面系统总结了深度神经网络图像识别模型对抗脆弱性成因与对抗鲁棒性研究进展,重点梳理了对抗样本生成、主被动对抗防御、对抗鲁棒性评估等方面的技术思路与典型方法,为下一步建立鲁棒可信的高性能智能化图像识别系统提供参考。