基于边缘感知的深度神经网络红外装甲目标检测

2021-08-31盛大俊

盛大俊,张 强

基于边缘感知的深度神经网络红外装甲目标检测

盛大俊1,张 强2

(1. 信阳学院 大数据与人工智能学院,河南 信阳 464000;2. 中国人民解放军空军第一航空学院,河南 信阳 464000)

装甲目标自动检测一直是红外制导领域的研究热点与难点。解决该问题的传统方法是提取目标的低层次特征,并对特征分类器进行训练。然而,由于传统的检测算法不能覆盖所有的目标模式,在实际应用中的检测性能受到限制。本文受边缘感知模型的启发,提出了一种基于边缘感知的改进深度网络,该网络是通过边缘感知融合模块提升装甲轮廓精度,利用特征提取模块和上下文聚合模块的优势,能够更好地适应目标的形态变化,具有较高的检测与识别的精度。验证结果表明,本文提出的装甲检测网络模型可以有效地提高红外图像中装甲的检测与定位精度。

装甲车辆;红外图像;目标检测;边缘感知;自寻的导弹;金字塔池化

0 引言

自寻的导弹是指导弹能够自主地搜索、捕获、识别、跟踪和攻击目标,是一种发射后锁定的制导方式[1]。由于红外图像对比度较低,目标与背景灰度类似,很难直接采用传统的检测算法来定位目标[2-3]。

众所周知,目标的轮廓信息是实现目标检测与识别的关键。语义边缘检测常用于定位目标轮廓并实现目标分类。语义边缘检测是计算机视觉领域的热门研究方向,也是更复杂、更高层次视觉任务的基础,如目标定位,目标检测,记忆重捕等[4]。早期的边缘检测算法主要利用目标像素及其局部区域之间的灰度差作为特征来确定像素的类型:边缘或非边缘,如Sobel、Canny等运算符[5-6]。然而,仅仅通过使用局部梯度渐变很难识别目标轮廓及其类别。因此,一些学者提出采用多尺度特征融合实现边缘特征提取与分类。军械工程学院的彭博采用局部多尺度特性融合,并结合边缘检测实现目标精确检测,降低了光照不均对目标检测与识别的影响[7]。此类改进的算法都是需要提取人工设计的特征并将其作为后续分类或回归模型的输入,最后才实现目标轮廓识别。人工设计的特征需要分析并结合目标特有的先验信息,其过程非常繁琐,且也是一个启发式过程。

北方激光研究院唐中和研究员在弹箭技术科学家论坛中提出从海量数据中学习并理解数据是智能产品发展的驱动力,其本质是解决人类大量的、重复性操作。因此,基于深度卷积网络模型在海量数据驱动下实现端到端的目标检测,可应用于智能产品研制。Xia等人[8]利用边缘感知融合模块有效地提取目标的边缘轮廓,同时利用辅助旁侧输出与金字塔池化层输出的尺度融合,表征出目标丰富的全局上下文信息,最终实现了复杂背景下的低对比度目标检测。随着深度卷积网络模型研究的深入,基于语义边缘检测的改进深度网络已经应用到视觉识别领域。但是,由于语义边缘检测是由边缘定位和分类两个子模块组成,这需要提出目标不同层次的特征。边缘定位提供了用于分类的位置信息;分类有助于实现目标的轮廓与其他边缘有效鉴别。目标的边缘定位需要较低层次的特征,而这些特征并不能提升识别分类的精度。边缘分类需要更高层次的抽象特征,这些特征有助于细粒度图像分类。因此,利用多尺度深度特征进行语义边缘检测是一个具有挑战性的问题[9]。目前,主流的语义边缘检测算法包括CASENet及其变体算法[10],该类算法主要利用语义边缘类别感知进行目标检测,并取得了显著的检测精度,但对于低对比度,边缘模糊的红外图像很难取得很好的检测效果。因此,对于实时性、准确性和有效性要求极高的武器装备,基于深度学习模型的检测与定位应用仍然存在不足。

针对红外图像复杂背景特点,本文在多尺度深度模型的基础上,提出了一种基于语义边缘检测的深度融合网络,旨在利用边缘定位和分类子任务的不同要求以及它们的互补性,实现复杂背景下典型装甲目标的检测与识别,该算法在高层次的上下文特征中逐步增强细节信息,同步提升边缘定位和分类的精度。

1 基于边缘感知的改进深度网络装甲目标检测算法

众所周知,装甲目标定位的关键是获取装甲的轮廓信息,然后通过特征建模,进而实现装甲区域的准确定位[11]。边缘轮廓检测的相关工作大致可分为3类:边缘检测、物体轮廓检测和语义边缘检测,其对应特征大致可分为低、中、高3个层次[12]。低层次特征描述了目标区域的细粒度局部变化;中层次特征则表征了较大的局部区域编码模式;高层次特征包含目标级的上下文信息。边缘检测仅使用局部低层次信息来定位相邻像素强度急剧变化的边缘;目标轮廓检测通常结合低层次和中层次特征信息来定位边缘,同时抑制不属于目标轮廓的边缘;语义边缘检测则利用类标签信息生成目标轮廓。为了检测语义边缘,从低到高的特征提取与融合是必要的。因此,随着深度学习网络可以学习从低到高的深度特征学习,结合边缘检测的目标识别任务也变得相对活跃。

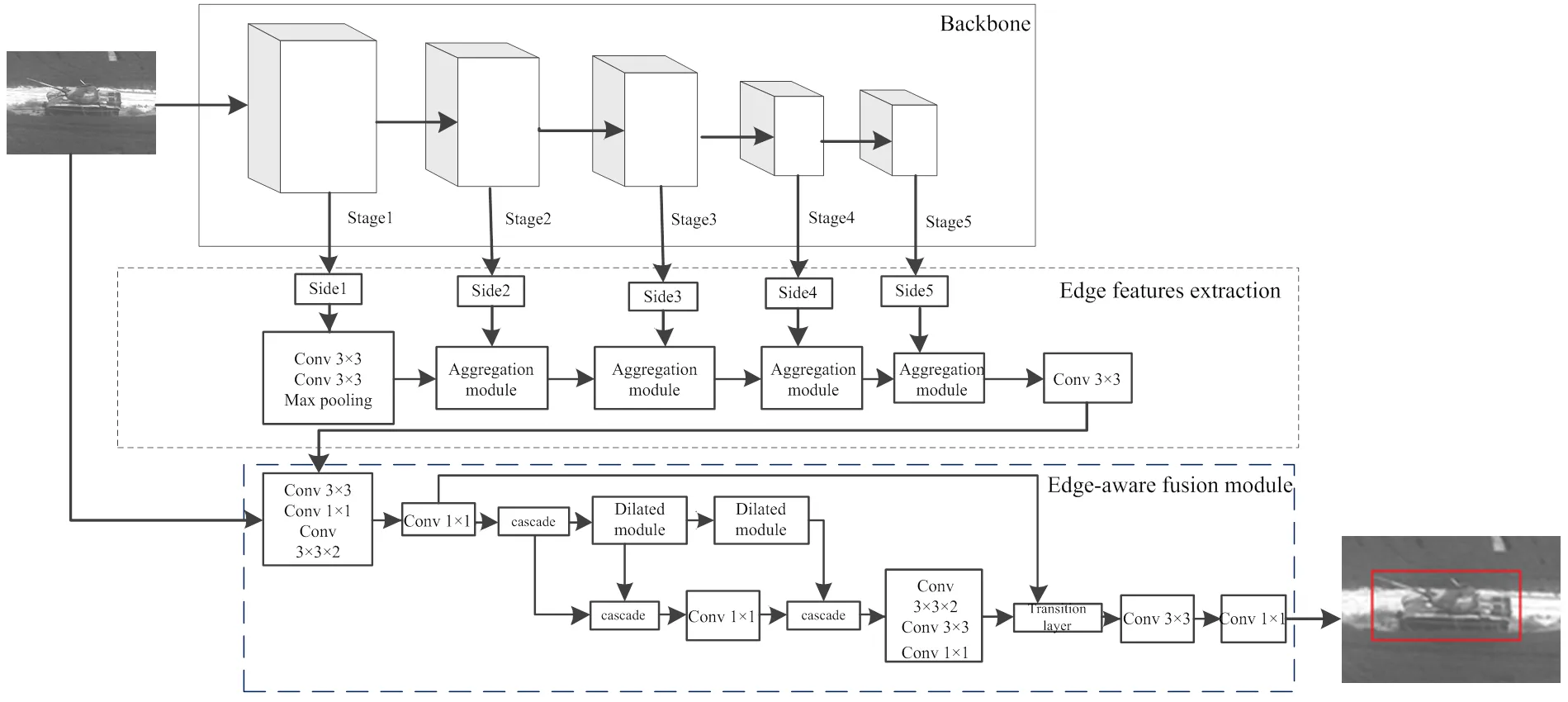

本文提出了一种基于多尺度上下文深度网络的语义边缘检测算法,该算法是采用一种级联融合结构,通过逐步融合多尺度深度特征,有利于提升深度特征表征能力。与现有的逐步融合策略不同,该算法是将低层次特征分步抽象出高层次特征,以保留更多上下文信息,并增强目标细节,而不是像现有的逐步融合策略那样将高层特征与低层特征融合在一起。此外,本文改进的模型提出了一种位置感知融合模块,由于每个模块的融合都是位置自适应的,它可以选择性地集成较低层次特征的细节。为了进一步丰富模型的特征表达能力,本文提出了一个上下文聚合模块,并在每个特征提取和融合阶段添加一个边缘感知模块。本文设计的整体结构和两个功能模块能够满足不同子任务的功能要求,并利用它们的互补性,同时获得高精度的目标边缘定位及其类别,所提的方法的网络总体框架如图1所示,该网络采用了5层ResNet101作为骨干,CASENet网络已经证明了该方法对语义边缘检测是有效的。为了使最初设计用于图像分类的ResNet101能够适应语义边缘检测,该结构在高层次的上下文特征中逐步增强细节信息,同步提升边缘定位和分类的精度,并在每个融合阶段增加了一个位置感知的融合模块,融合多个尺度的特征的同时,抑制了来自低层次特征的噪声信息,使得网络模型能够聚焦于物体轮廓周围的细节。

1.1 语义特征提取模块

由于深度网络编解码模块的前馈网络层可以获取装甲目标粗定位,但是空间上采样操作并不能有效恢复空间信息和更精细的细节特征,所以不能很好地保留边缘结构[13]。为了准确地定位目标的轮廓,本文采用的语义边缘检测网络是一种逐级自下而上的特征融合结构。理论上,多尺度特征信息融合的基本结构在功能上可以用于语义边缘检测,但这种结构忽略了低层次特征,而这些特征对于边缘定位至关重要。CASENet网络直接将所有的侧面特征层连接在一起,但这种结构忽略了从低层次特征到高层次特征在边缘定位和分类中的不同作用[14]。因此,本文采用了一种自上而下的逐步融合结构,它将从高层次特征到低层次特征的多尺度特征逐步融合,弱化了高层次特征在边缘分类中的作用。该结构采用自下而上的融合设计,逐渐融合了从低到高的多尺度特征,有利于利用互补特征获取更有效的多尺度特征空间,并逐步增强高层次特征的语义识别能力,同时促进边缘分类和定位。

图1 基于边缘感知的目标检测模型框架

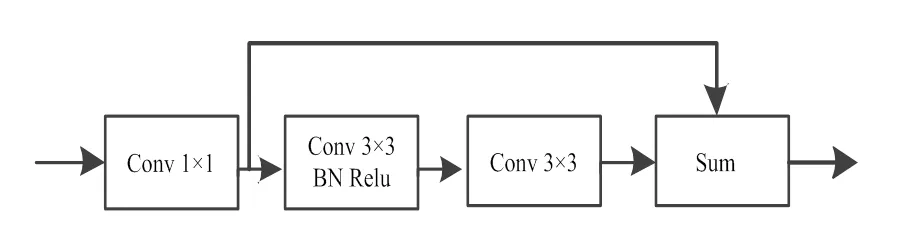

1.2 上下文聚合模块

由于边缘特征分类需要目标的上下文信息,本文引用了一种上下文聚合模块来学习输入特征的上下文特征,如图2所示,该模块以残差网络为基本结构,其第一个组件是1×1卷积层,旨在降低输入特征图的通道数以节省计算成本;后面两个3×3卷积层有助于提取目标的上下文信息,其输出的特征与1×1卷积层生成的特征图相加有助于表征能力更强的上下文特征映射。在实际应用过程中,随着空间维数逐渐减小,stage1到stage5中的信道数也相应设置为32、64、128、256和512。在DeepLab网络中,扩张卷积可以在不增加参数数量的情况下增加感受野[15]。因此,为了提升目标的上下文特征信息,本文在上下文聚合模块中引入了扩张卷积,通过多个扩张率将扩张卷积以级联或融合方式来捕获多尺度上下文特征。然而,语义边缘检测还需要细节信息来进行边缘定位。从这个角度来看,较大的扩张率可能会造成负面影响。因此,有必要在边缘感知先验信息下逐层学习出最优深度特征。

图2 上下文聚合模块

1.3 边缘感知融合模块

本文采用的边缘感知融合模块的目的是学习从较低层次特征中选择上下文细节来增强高层次特征的表征能力,其选择过程依赖于高层次特征的指导,如图3所示。边缘感知融合模块将不同层次的特征映射作为输入。首先,边缘感知融合模块对低层次特征进行下采样以获得与高层次特征相同的尺寸;然后,边缘感知融合模块将不同层次的特征级联在一起,并将级联后的特征输入到两个1×1的卷积层。基于低层次特征和高层次特征之间的对应关系,这两个卷积层被训练生成低层次特征的权重图,其中权重映射的通道数与低层特征的通道数相同。接下来,将较低层次特征与权重映射相乘并增加到较高层次特征中。实际上,级联操作可以忽略,以便只使用更高层次的特征映射来计算权重。在图2中,本文使用4个边缘感知融合模块来逐步融合5个阶段的特征。值得注意的是边缘感知融合模块中的下采样结构是步幅为2的1×1卷积层。理论上,步长为2的1×1卷积层比其他下采样结构所需的计算量要少。在Tensor Flow深度学习框架中ResNet101是整个网络的主干,采用该结构进行下采样。然而,这种下采样结构在效率上的优势在实践中并不显著,因为下采样只占整个网络结构的一小部分。实际上,在Pythorch中实现的ResNet101采用3×3滤波器,步长为2。总之,本文提出的模型增加了边缘感知融合模块,可以提升装甲目标轮廓精度;利用多尺度特征融合捕获红外图像的高层次语义特征,最终可以有效地提高红外图像装甲目标的检测与定位精度。

图3 边缘感知融合模块

2 实验结果及其性能分析

2.1 实验数据及其参数设置

为了评估本文提出的装甲检测算法性能,训练集使用外场装甲数据集作为训练图像,其中6500张红外图像的装甲被准确标注。90%的数据集用于训练,其余10%用于测试。自建装甲数据集是从利用直升机外挂红外成像设备在阿拉善戈壁环境下采集,其环境覆盖了尽可能多姿态与角度的装甲车辆,具有多种纹理背景与部分遮挡干扰。除目标区域外,其余部分标记为背景,也就是说标注数据集可用于装甲定位模型的训练和测试。这些数据包含大量复杂背景。需要说明的是,虽然非制冷红外图像不清晰,且数据集中存在一些边缘高亮区域,但不影响对红外图像进行标注与定位。

在深度卷积网络中,需要手动设置的参数称为超参数,其参数设置没有具体的方法,但大多可以根据网络训练经验进行调整。例如,学习率是控制模型更新速度的一个重要超参数。选择一个好的学习率是很有挑战性的,因为如果学习率太小,那么训练速度将非常慢且耗时,而且很可能会陷入局部最小值。反之,如果学习率过大,训练过程将不稳定。本文提出的网络模块在TensorFlow深度学习框架下完成。为了提高优化效率,采用小批量随机梯度下降优化算法,其超参数中基本学习率、权重衰减和动量分别设置为2×10-7,5×10-4和0.9。对于装甲目标轮廓检测模块,学习率设置为10-6,训练迭代次数为200k/次;训练样本的大小调整为128×128并作为网络的输入。本实验搭建的实验环境均在戴尔工作站上进行,该系统具有一个Intel Xeon CPU,最高频率为3.2 GHz;英伟达GeForce GTX1050TI显卡,以及64位操作系统Ubuntu 6.06。

2.2 评价指标

目前,现有的识别算法对红外图像中的装甲目标存在较大漏检与误检,主要归咎于目标对比度低、边缘模糊且不同视角下目标外形差异较大。如何对复杂战场环境下获得的红外目标检测结果进行有效评估,降低主观误差对性能的影响,是评价算法性能的关键。为了更清楚地说明目标检测模型之间的差异,需要引入定量评估准则。因此,本文采用评价标准是检测率与误检率指标,侧重考察漏检出现的概率,如表1所示。

表1 装甲检测结果统计

为了实现对检测结果进行有效评估,对获得的装甲区域检测矩形框的评价准则是检测率与误检率,其公式如下所示:

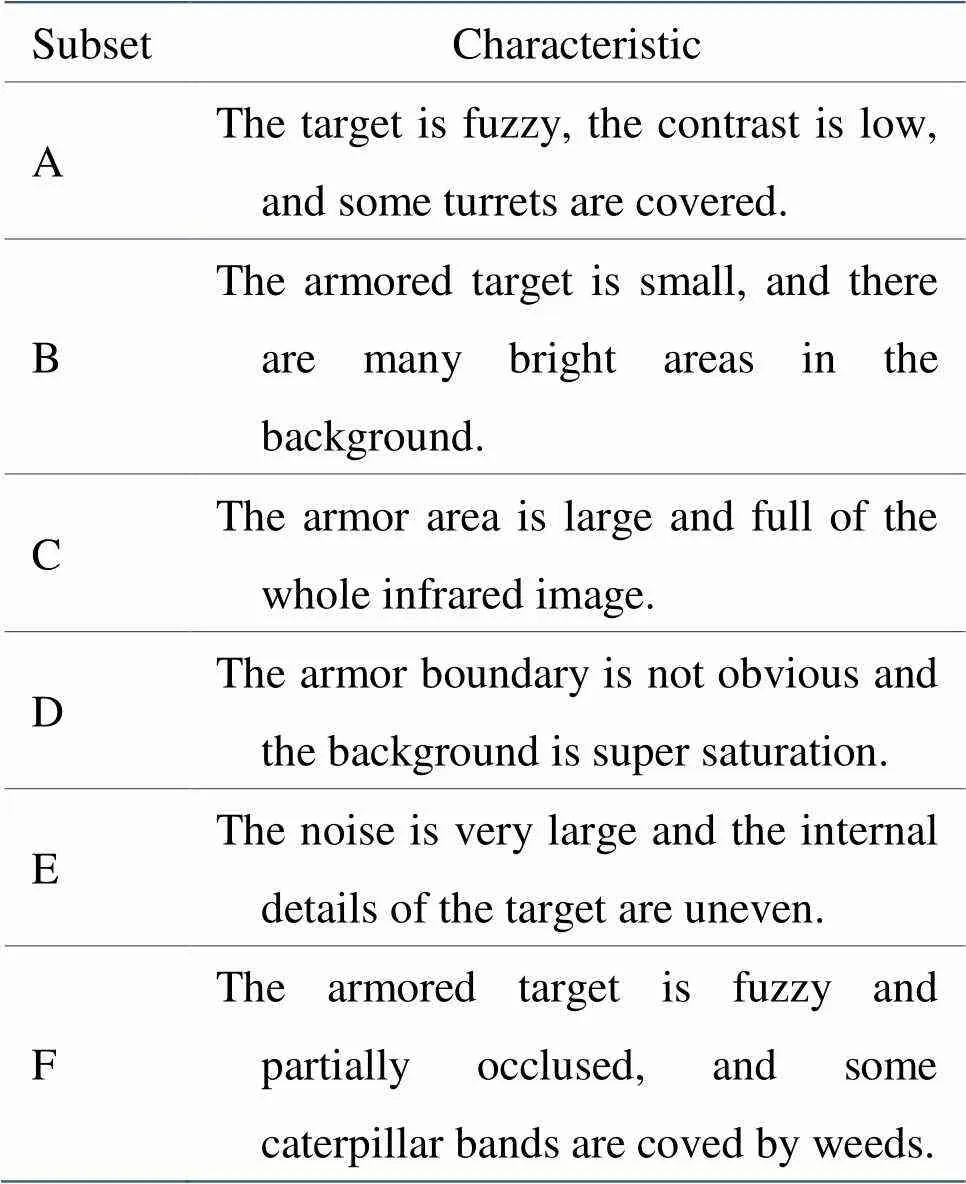

其中参数定义参见文献[8]。为了便于对比分析,实验将选用的测试数据集分成6大类,其标识及特点如表2所示。此外,为了评估装甲检测和定位结果的准确性,本文还使用像素精度(Pixel accuracy,PA)和平均IoU(Mean intersection over union,MIoU)作为评价准则。

表2 不同测试子集的特点

2.3 定性定量分析

目前,已经有许多针对自然图像进行目标检测的算法。然而,目前针对红外图像的装甲目标检测的模型较少。本文目的是将目标检测作为自寻的导弹自主地搜索目标,实现发射后高精度锁定目标,降低背景干扰的影响。由于基于深度学习的检测算法在自然图像领域已经获得了巨大的成果。为了定性定量分析红外图像领域的本文提出的装甲目标检测的精度,实验选用了对比算法分别是ConvNet[16]、YOLO-V2[17]、SSD[18]、DenseNet[19]与ResNet[20]。选用的所有对比算法都采用作者给出的源代码进行分析。虽然这些深度模型并不是针对红外目标检测,但这些模型并不区分红外图像与自然图像,只要给予充分的训练数据,就能得到相应的检测结果。为了便于所有对比算法进行公平公正地对比分析,所有的对比模型都用相同的训练集与测试集进行实验。

2.3.1 检测精度对比

本文提出的算法是一种结合了语义边缘先验的目标检测模型,旨在利用边缘定位和分类子任务对特征的不同要求以及它们的互补性,实现复杂背景下典型装甲目标的检测与识别。众所周知,不同的评价标准下的检测精度存在较大差异。一般来说,目标检测精度与精度曲线密切相关。精确曲线是通过绘制每个目标类的曲线来评估目标检测模型在置信度改变时的性能。如果目标检测模型的精确度随着阈值的增加而保持较高的话,那么该模型的性能较好。

表3展示了不同对比算法对不同测试子集的检测结果。实验结果表明,大多数对比模型对背景复杂度的变化具有较强的鲁棒性,对不同背景的检测效果没有明显差异。然而,对于目标尺度不大于10×10小目标的检测,SSD、DenseNet、ResNet与ConvNet具有局限性,这是由于这些深度模型都具有较深的网络层,其生成的低层特征很少,但低层次特征对于弱小装甲目标的检测贡献很大。本文提出的模型无论是对单个还是多个、稀疏还是密集、大或小目标,都具有更好的性能,满足了光电系统目标精确检测的要求。从表3的定量测试结果可以看出,本文所提的装甲目标检测率是所有对比算法中最佳。数据集A中目标模糊,对比度低,部分炮塔存在覆盖物,但最终本文模型的检测概率是90.06%;数据集B中装甲目标较小,背景中存在大量高亮区域,最终本文模型的检测概率是77.14%;

在数据集C中密集卷积网络(DenseNet)的平均检测率为73.22%,而本文算法的性能明显优于DenseNet。由于数据集E中的所有图像都具有较大噪声,且目标内部细节不均匀,很容易被当成多个分离的实体,严重影响检测精度。从表3的检测率对比结果可以看出,数据集E上的装甲检测精度是最低的,仅仅59.58%,但也比其他对比模型的精度高。虽然DenseNet可以通过多通道特征级联实现特征重用,有利于大大降低参数和计算成本,避免了加深加宽网络导致实时性大大降低,但特征重用通道数依赖于的超参数中增长率的设置,需要根据图像内容自适应调整,这就使得DenseNet泛化能力不足,对背景差异较大样本的检测性能较差。YOLO v2在网络中取消了全连接层,添加了BN层,并利用锚点框进行预测,其训练过程是在ImageNet数据集上进行参数微调。从实验结果可以看出,YOLO v2是所有对比算法中最优的检测结果,仅次于本文提出的模型。与对比检测模型相比,本文提出的模型在6类数据集上具有最优的检测性能,同时,这表明了该方法的优越性。从检测结果可以看出,本文模型可以生成更可靠的检测结果,更接近实际基准情况。

2.3.2 检测框性能对比

在目标检测应用里,通常采用边界框来描述目标位置,一个较好的检测结果是目标的边界框应该与目标的最小外接矩形重合。在我们的实验中,如果获取的目标边界框与其中一个目标的基准框的重叠区域超过0.5,则认为检测的结果是有效的。为了直观地对比分析不同模型间的性能差异,实验采用目标的检测率(detective rate DR)与误检率(false positives per-image,FPPI)的关系图来描述装甲目标检测算法在不同误检率下的统计结果,如图4所示。也就是说,设置不同的误检率可以得到不同的检测精度。从实验结果可以看出,不同模型生成的对比曲线差异较大,且层次明显。为了便于直观地性能对比,一般可以选择一个FPPI值来对比相应的检测率。当FPPI=0.5时,本文所提装甲检测算法的检测率是81%,而最优对比算法YOLO v2检测器的检测率为76%,ResNet检测器的检测率为74%,相较YOLO v2检测器提升了5%。对比结果表明本文所提模型在保证目标检测实时性的前提下有效地提高了目标的检测准确率。

表3 不同测试数据集下检测精度

图4 检测率与FPPI的关系曲线

由于导弹制导系统中,中心位置精度决定了检测结果是否满足攻击要求。为了便于定量分析,本实验也比较了基于位置误差度量的精确度图和基于重叠度量的成功率图,如图5所示。图5(a)是不同中心位置误差阈值下的检测精度,其误差阈值越大,精度越接近1。图5(b)是不同重叠率误差阈值下的检测成功率,其重叠率阈值越大,精度越接近0。在实际应用中,中心位置误差阈值与重叠率阈值分别设置为10与0.5。可以看出,本文所提的检测模型在10个像素阈值下的检测精度是0.83,在重叠率阈值0.5下的检测成功率是0.87,优于最优对比检测网络YOLO v2。定量分析结果表明,本文所提的深度融合网络能够利用语义特征提取模块和上下文聚合模块来实现复杂背景下典型装甲目标的检测与识别,同步提升边缘定位和分类的精度。尤其是对不同视角下装甲图像,我们能够准确地标记出装甲的位置,提高了打击精度与效率。

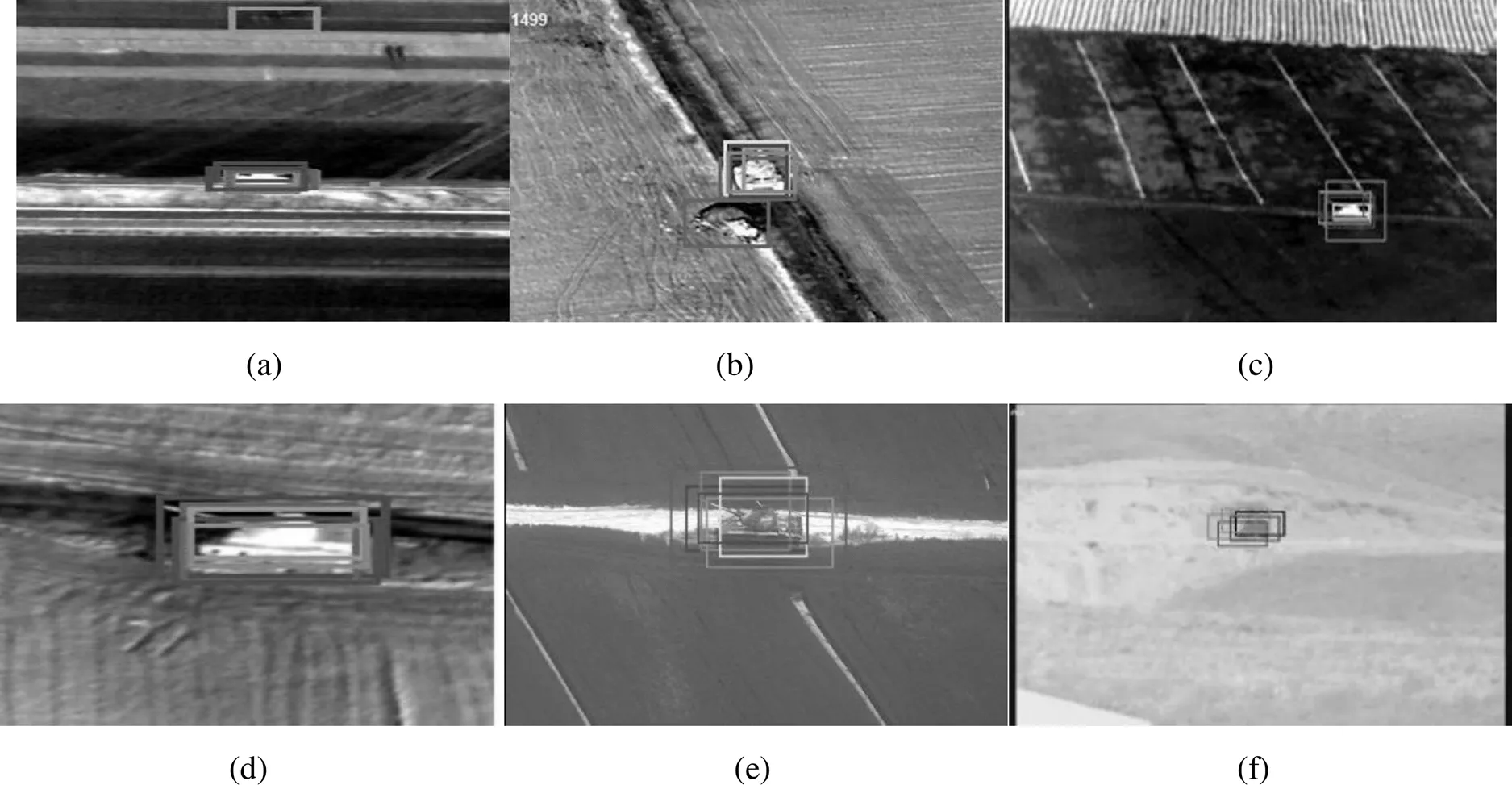

2.3.3 定性对比

图6是不同对比算法对不同红外图像的装甲目标检测的结果,其中本文模型,SDD,DenseNet,ResNet,ConvNet与YOLO v2的结果分别采用不同边界框表示。受制于篇幅的限制,本文只选用了比较具有代表性的6幅图像来进行测试。在图6(a),6(b)和图6(d) 装甲的形态差异较大,尤其是装甲目标与背景的灰度相近,这就导致DenseNet常检测到错误的目标。SSD算法和DenseNet算法的结果虽然接近本文提出的算法,但由于反卷积恢复到原始尺寸时存在插值误差,导致结果也存在偏差。根据响应图极大值分析,这些外观变化无法获取准确的边界,导致损失函数无法收敛,检测差异较大。因此,所有对比网络模型不准确的定位目标的位置,而本文模型结果则证明了对于形变,低对比度等干扰影响下的精度较低的问题,能够通过轮廓感知网络来解决。虽然YOLO v2能够检测到目标,但仍然易遭受复杂背景干扰,导致检测中心存在偏差。图6(e)中,目标的对比度与旁边地表的灰度类似,但又与道路灰度存在较大差异,容易出现地景干扰,影响检测精度,而图6(c)与6(f)中目标边界不明显,且目标尺度较小,边界模糊。从检测实验结果可以看出,ConvNet检测框已经偏离目标中心,而本文提出的目标检测网络能够结合语义特征提取模块和上下文聚合模块的优势,能够更好地适应目标的形态变化,具有较高的检测与识别的精度。

图5 不同对比算法的性能对比

图6 不同对比算法对不同红外图像的装甲检测的结果,其中(a)-(f)分别代表不同图像

3 结论

目标检测在现代武器系统中得到了广泛的应用,能够自主识别目标,并实现目标的跟踪与打击。由于红外图像对比度较低,目标与背景灰度类似,很难直接采用传统的检测算法来检测目标。为了提升装甲目标检测中的抗干扰能力差的问题,本文结合深度特征提取模块和上下文聚合模块,提出了一种表征能力更强的多尺度耦合模型。与对比检测模型相比,本文提出的模型在6类数据集上具有最优的检测性能,从检测结果可以看出,本文模型可以生成更可靠的检测结果,更接近实际基准情况,可以有效地提高红外图像中装甲的检测与定位精度。

[1] 陈国胜, 胡福东, 周成宝, 等. 基于BIRD网络的智能红外全景识别系统[J]. 红外技术, 2018, 40(8): 765-770.

CHEN Guosheng, HU Fudong, ZHOU Chenbao, et al. Intelligent infrared panoramic recognition system based on BIRD network[J]., 2018, 40(8): 765-770.

[2] 刘博文, 戴永寿, 金久才, 等. 基于空间分布与统计特性的海面远景目标检测方法[J]. 海洋科学, 2018, 42(1): 88-92.

LIU B, DAI Y, JIN J, et al. Long-range object detection on sea surface based on spatial distribution and statistical characteristics[J]., 2018, 42 (1): 88-92

[3] 骆清国, 赵耀, 俞长贺, 等. 某型装甲车辆红外辐射信号的建模与仿真[J]. 装甲兵工程学院学报, 2019, 33(1): 31-36.

LUO Q, ZHAO Y, YUC, et al. Modeling and simulation of infrared radiation signal of an armored vehicle[J]., 2019, 33(1): 31-36.

[4] DONG X, HUANG X, ZHENG Y, et al. A novel infrared small moving target detection method based on tracking interest points under complicated background[J].., 2014, 65: 36-42.

[5] HE Y, LI M, ZHANG J, et al. Small infrared target detection based on low-rank and sparse representation[J]., 2015, 68: 98-109.

[6] GUO J, Hsia C, LIU Y, et al. Fast background subtraction based on a multilayer codebook model for moving object detection[C]//, 2013, 23(10): 1809-1821.

[7] 彭博, 臧笛. 基于深度学习的红外车辆识识别方法研究[J]. 计算机科学, 2015, 42(4): 268-273.

PENG Bo, ZANG Di. Vehicle logo recognition based on deep learning[J]., 2015, 42(4): 268-273.

[8] XIA K J , CHENG J , TAO D , et al. Liver detection algorithm based on an improved deep network combined with edge perception[J]., 2019, 12: 175135-17514.

[9] Redmon J, Farhadi A. YOLO9000: Better, Faster, Stronger[C]//, 2017: 6517-6525.

[10] YU Z, FENG C, LIU M Y, et al. CASENet: Deep category-aware semantic edge detection[C]//, 2017: 1761-1770(doi: 10.1109/CVPR.2017.191).

[11] Neubeck A, Gool L V. Efficient non-maximum suppression[C]//, IEEE Computer Society, 2006: 850-855.

[12] 焦安波, 何淼, 罗海波. 一种改进的HED网络及其在边缘检测中的应用[J]. 红外技术, 2019, 41(1): 72-77. JIAO Anbo, HE Miao, LUO Haibo. Research on significant edge detection of infrared image based on deep learning[J]., 2019, 41(1): 72-77.

[13] 杨眷玉. 基于卷积神经网络的物体识别研究与实现[D]. 西安: 西安电子科技大学, 2016.

YANG J. Research and Implementation of Object Detection Based on Convolutional Neural Networks[D]. Xi’an: Xidian University, 2016.

[14] 丁文秀, 孙悦, 闫晓星. 基于分层深度学习的鲁棒行人分类[J]. 光电工程, 2015, 42(9): 21-27.

DING W, SUN Y, YAN Xiaoxing. Robust pedestrian classification based on hierarchical deep learning[J]., 2015, 42(9): 21-27.

[15] CHEN S, CHEN Z, XU X, et al. Nv-Net: efficient infrared image segmentation with convolutional neural networks in the low illumination environment[J]., 2020, 105: 103184.

[16] HOSANG J, BENENSON R, SCHIELE B. A convnet for non-maximum suppression[C]//, Cham: Springer, 2016: 192-204.

[17] REDMON J, FARHADI A. YOLO9000: Better, faster, stronger[C]//, New York: IEEE Press, 2017: 7263-7271.

[18] LIU W, ANGUELOV D, ERHAN D, et al. SSD: single shot multibox detector[C]//. Cham: Springer, 2016: 21-37.

[19] HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]//, 2017: 4700-4708.

[20] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//, 2016: 770-778.

Infrared Armored Target Detection Based on Edge-perception in Deep Neural Network

SHENG Dajun1,ZHANG Qiang2

(1.,,464000,; 2.,,464000,)

Automatic detection of armored targets has always been the most challenging problem in the field of infrared guidance. Traditional models address this problem by extracting the low-level features of an object and then training the feature classifier. However, because traditional detection algorithms can not cover all object patterns, the detection performance in practical applications is limited. Inspired by the edge-aware model, this study proposes an improved deep network based on edge perception. The network improves the accuracy of the armored contour through an edge-aware fusion module. By exploiting he advantages of the feature extraction module and context aggregation module, it can better adapt to thechanges of objects and has high detection and recognition accuracy. The results show that the proposed armored detection network model can effectively improve the accuracy of detection and positioning in infrared images.

armored vehicle, infrared image, target detection, edge perception, homing missile, pyramid pooling

TP753

A

1001-8891(2021)06-0784-08

2020-05-10;

2020-09-03.

盛大俊(1981-),男,讲师,研究方向:制导测试技术,计算机视觉应用

张强(1975-),男,高工,研究方向:光电系统维修与测试,红外制导技术等,E-mail:x0376y@163.com。

装备预研基金资助课题。