高效节能新技术在超大型云计算数据中心的研究及其应用

2021-07-15盛伟伟

郑 锋, 连 怿, 韩 颖, 朱 健, 盛伟伟

(1.上海信业智能科技股份有限公司, 上海 201203;2.上海信得天达云计算科技有限公司, 上海 201800)

0 引 言

我国力争2030年前实现碳达峰,2060年前实现碳中和。数据中心能源消耗量巨大且能源利用效率低,节能降耗成为数据中心产业发展中的热点问题。上海市政府提出IDC建设指导意见,新建IDC限制PUE<1.3。本文主要介绍末端空调形式的节能技术、主机侧冷机节能技术、自然冷却节能技术、集成冷冻站节能技术、AI群控系统节能技术在上海市嘉定区外冈物联网数据智能产业园建造的超大型云计算数据中心的应用[1-3]。

1 项目概况

上海市嘉定区外冈镇外冈物联网数据智能产业园内由1#机房、2#机房及过街楼组成,两栋机房楼皆为地上3层(局部4层),无地下室,总建筑面积47 589.8 m2。两栋机房楼层高相同,1F高10 m,2F高7 m,3F高6 m,总建筑高度23.950 m(室外地坪至女儿墙高度)。

项目园区2栋机房楼可提供装机容量6 kW机架6 000个,将对嘉定区云计算、边缘计算、物联网产业、车联网产业、移动端视频服务业务、数字经济、通信行业的可持续发展及满足社会各类对数据通信的需求有着积极和重要的意义。

上海嘉定外冈物联网数据智能产业园效果如图1所示。

图1 上海嘉定外冈物联网数据智能产业园效果

嘉定区地处北亚热带北缘,为东南季风盛行地区,四季分明,气候温和,雨量充沛,光温适中,日照充足。年均温15.7 ℃,1月均温2.5 ℃,7月均温28 ℃;年均降雨量1 077.6 mm,雨日130.2 d;年均日照2 114.8 h,年均太阳辐射总量

114.5 千卡/cm2;年均无霜日数223 d。

2 末端空调节能技术

机房空调的任务是在一定的传热驱动温差下,将IT设备散热量从室内送到室外。早期机房中的IT设备散热量不高,采用冷机供冷即可满足散热要求,随着近年来高热密度数据中心的出现和冷机能耗的增加,利用自然冷源为机房供冷的自然冷却技术开始出现并逐渐发展成熟,因此,逐渐发展出了两种不同的机房冷却方式:机械制冷和自然冷却。

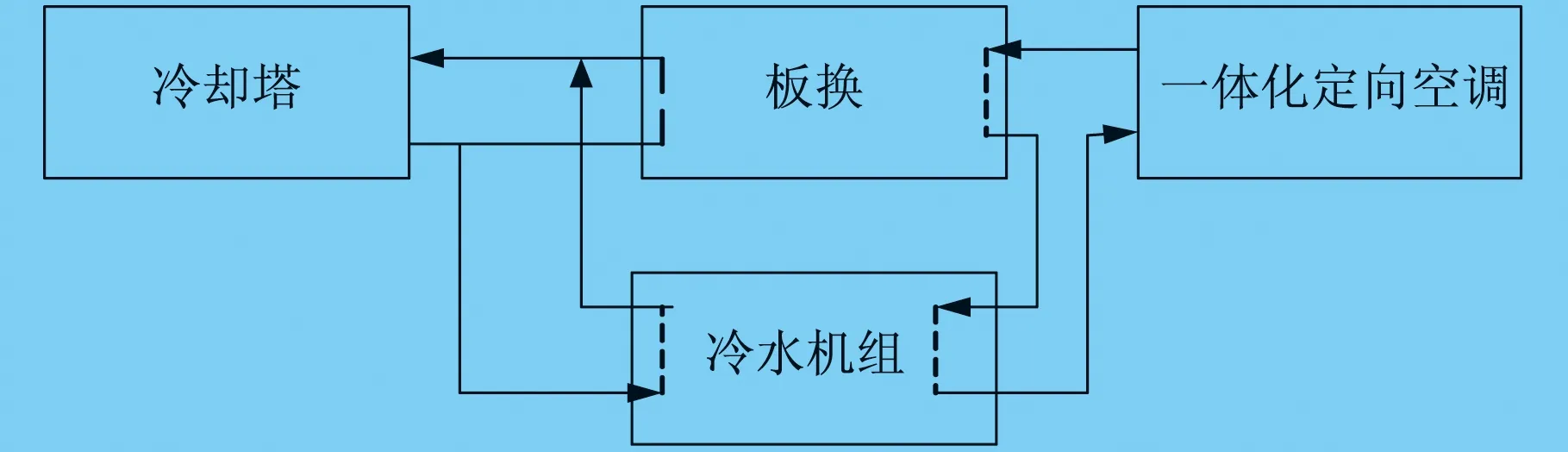

大多数数据中心的机械制冷采用冷机集中供冷方式,包括室内末端换热和主机侧换热两个环节。机房机械制冷换热流程图如图2所示。

图2 机房机械制冷换热流程图

很大一部分空调制冷量都由于气流组织的不合理而被浪费掉了,机房中普遍存在局部过热及冷热气流相混合的问题,这两种现象都极大地降低了制冷效率,此两种现象在房间级制冷尤为突显,依靠房间级制冷已不能有效地对信得天达云计算数据中心6 K负荷机柜起作用。

行间级制冷:在云计算和大数据应用背景的促进下,数据中心迎来了一个新的建设高潮,传统数据中心部署缓慢、密度小、很难扩展,且“牵一发而动全身”,人们逐渐认识到集中制冷的弊端和按需制冷的必要性,此阶段典型的制冷节能技术就是行间级制冷空调应用。在行间级制冷架构中,其气流通路比房间级制冷架构短,且制冷对象更为明确。此外,其气流可预测性较好,机房空调的全部额定制冷量均可得到利用,并可以实现更高密度的布局,行间空调通过内部风机将封闭通道中的热空气输送至表冷盘管,实现冷却降温,IT设备根据自身需求将低温的冷通道空气引入,通过服务器风扇排至封闭的热通道中,实现水平方向的空气循环。行间级空调系统因靠近负荷中心,输送冷空气至负荷中心的距离减小,设备维持制冷循环所需的能耗比传统方式少。

机柜级制冷:机柜的气流组织遵循冷热通道原则且为等风程设计,低温冷空气经DHU风机加压,由地板送出对服务器散热冷却,温度升高后,高温空气从服务器排出由封闭热通道回到DHU表冷器,进行冷却降温,依此循环。

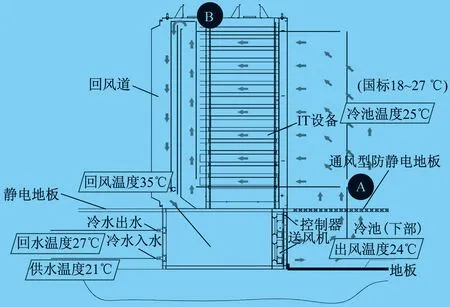

服务器机架为特殊定制机柜——定向冷却机柜(DCC),DCC正面为敞开式,采用地板下送风(由下向上),整个机房作为冷池,DCC背面为封闭式热通道。每台DCC对应一台分布式空气处理单元(DHU)。DHU气流组织原理图如图3所示。

图3 DHU气流组织原理图

2.1 末端空调(机柜级)制冷工作原理及气流组织

(1) 由于末端空调直接在机柜底下,送回风程最短,风阻最小,送风过程冷损失小,风机功耗低。

(2) 根据单柜负载设计表冷器,风-水换热温差降低至2~3 ℃(正常精密空调或列间空调风水换热温差6~8 ℃),在相同送风的情况下,相比可提高供水温度4 ℃,有利于自然冷源利用时间增加。

(3) 同程风道设计,机柜底部至顶部的送回风阻一致,机柜上下送风温差低于1 ℃,无热岛效应。

(4) 热通道封闭,通过每个机柜底下的风机精确控制回风温度,控制颗粒度做到柜级控制,无负载或低负载机柜,风机功率消耗越低,整体精确控制,挖掘更大节能空间。

2.2 末端空调20%裕量设计

与机柜一对一配置,每台空调按20%裕量设计,整个主机房作为冷池,热通道通过机柜后门封闭,当机柜对应的风机故障时,控制系统控制机柜后窗弹开并报警,与之相邻的空调输出冷量增加用以补充故障风机冷量。末端空调20%裕量设计原理图如图4所示。

图4 末端空调20%裕量设计原理图

每台空调配置无源能量平衡阀,根据单柜IT负荷调节水量。

2.3 房间级制冷、行间级制冷、机柜级制冷三种方式的性能对比

与房间级或行间级制冷架构相比,机柜级制冷的气流路径更短且定义更为准确,使得气流完全不受任何设施变动或机房约束条件的影响,机房全部额定制冷量均可得到充分利用,并可实现最高的负载密度。

嘉定外冈超大型云计算数据中心是按A级机房标准设计,冷通道和机柜送风温度为18~27 ℃,在满足此温度情况下,尽可能提高冷冻水温度,有利于自然冷源时间的增加,从而减少机械制冷时间。通常情况下的机房专用空调设计换热温差为6 ℃,如果能将换热温差减少一半,控制在3 ℃以内,那冷冻水温度可以相应的提高至21 ℃。DHU换热原理图如图5所示。

图5 DHU换热原理图

末端空调制冷性能比较如图6所示。

图6 末端空调制冷性能比较

通过以上三种末端空调形式性能对比,本案末端选型为机柜级冷却方式。 每台空调配置无源能量平衡阀,根据单柜IT负荷调节水量。

3 自然冷源节能技术

数据中心冷源系统的任务是提供一定的传热温差,将IT设备散发的热量从室内搬运到室外。

数据中心冷源系统按照其冷凝方式可分为风冷系统、水冷系统和蒸发冷却系统。从冷源来源上可分为机械制冷系统和自然冷源系统,一般,水冷系统COP大于风冷系统COP,自然冷源系统的能耗低于机械制冷系统的能耗,本项目地点在上海嘉定,根据气候条件,本案冷源系统采用集中式的机械制冷和自然冷源制冷的水冷系统,又称双冷源系统。

3.1 自然冷源工作原理及组成

自然冷源在数据中心主机侧的应用指的是在冬季和春秋过度季节时,采用冷却塔加板换的水侧自然冷却方式,通过板换让冷却水直接给冷冻水降温,制冷机组不开压缩机,利用室外的免费自然冷源制冷,来冷却水循环系统中的冷冻水,从而大大节约了压缩机的功耗,达到了降低PUE的效果。冷却塔加板换的水侧自然冷源工作原理图如图7所示。

图7 冷却塔加板换的水侧自然冷源工作原理图

采用高温冷冻水设计,可显著提升自然冷却应用时间,也能降低冷机制冷功耗。

根据本次暖通设计工艺,充分利用自然冷源,在满足数据机房18~27 ℃送风温度前提下,尽可能提高空调冷冻水温度,设计工况为18/24 ℃供回水,22 ℃送风,实际运行过程,根据IT负载情况以及机房送风温度情况调整供水温度。比如调整送风温度为25 ℃时,冷冻水温度可调整为21 ℃。

设计工况:满足18 ℃冷冻供水温度,室外环境湿球温度低于13 ℃时,可直接采用板式换热器与冷却塔自然散热;运行工况:当满足21 ℃冷冻供水温度,室外环境湿球温度低于16 ℃时,即可直接采用板式换热器与冷却塔自然散热。冷却塔+板换+DHU换热原理图如图8所示。

图8 冷却塔+板换+DHU换热原理图

3.2 延长自然冷源时间的相关因素

要降低数据中心PUE,应最大化采用自然冷源的时间。 自然冷却切换湿球温度等于冷冻水供水温度与板换换热温差和冷却塔冷幅高之差。因此,若想提升自然冷却时间,在选型阶段上要考虑以下三个因素。

(1) 提升冷冻水设计温度,可显著提升自然冷却时间,也能降低冷机制冷功耗。

(2) 选择低冷幅高冷却塔,降低冷却水出水温度与湿球温度的温差,但低冷幅高的选型也会增大冷却塔的体积和投资。

(3) 降低板换换热温差,板换换热温差由2 ℃降低至1 ℃,投资将增加1倍。

上海全年外环境湿球温度如图9所示。

图9 上海全年外环境湿球温度

为此全年自然冷却时间可达约166 d(4 000 h),为降低PUE做出很重要的贡献。

根据图9可知,上海全年外环境湿球温度低于13 ℃总时长为4 025 h,低于16 ℃总时长为4 793 h。

由此,可以看出采用以上自然冷源的工艺,完全可以达标上海规定的新建IDC使用的自然冷源时间大于3 000 h标准。

4 冷源节能技术

4.1 冷源配置

研究对象为2#机房楼,共布置3 000个机架,平均单机架6 kW,同时使用系数0.8,机房设备发热量约为16 200 kW,考虑围护结构冷负荷及电力电池室、变配电室并结果系统损失等冷负荷因素,2#机房楼空调冷负荷如下:机柜3 000个,单机柜功耗6 kW,IT设备发热量14 411 kW,机房设备发热1 800 kW,围护结构冷负荷1 620 kW,其他负荷1 620 kW,空调总冷负荷19 420 kW。

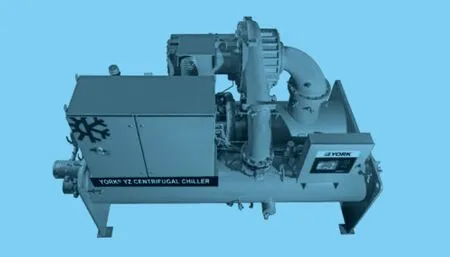

根据本案需求,选用磁悬浮变频离心式冷水机制冷量1 400RT(4 900 kW),功率587 kW,冷冻水温18 ℃供水,24 ℃回水,冷却水温32~38 ℃。磁悬浮变频离心式冷水机如图10所示。

图10 磁悬浮变频离心式冷水机

4.2 数据中心冷水机组选型设计考虑以下几个因素

(1) 磁悬浮离心机在提供制冷效率上是数据中心制冷的首选,其压缩机采用先进的磁悬浮和直流变频技术,减小了摩擦阻力,克服了传统离心式水冷机组的喘振缺点,同时采用磁悬浮可变压缩比的特性,使得主机在低压比工作时大大提高了机组的性能。

(2) 采用水冷机组高温冷冻水供水的设计,降低冷机制冷功耗。

(3) 工作在冷冻水温18 ℃供水,24 ℃回水,冷却水温32~38 ℃,磁悬浮变频式水冷机组COP(能效比)是8.3;传统离心式水冷机组COP是6.5左右;传统风冷机房专用空调机组COP是3左右;磁悬浮变频式水冷机组其COP值明显高于其他冷水机组,节能效应显著。

(4) 选择集成式冷冻站设计(集成式冷冻站:是将中央空调的机房设备,包括冷水机组、冷冻水泵、冷却水泵、冷却塔、定压补水系统、水处理系统、管道阀门及控制系统等设备系统化、智能化、集成化,在工厂预制生产从而形成一个完整的产品),可提高冷冻站制冷效率,达到冷源使用高效节能目标。

5 集成冷冻站节能技术

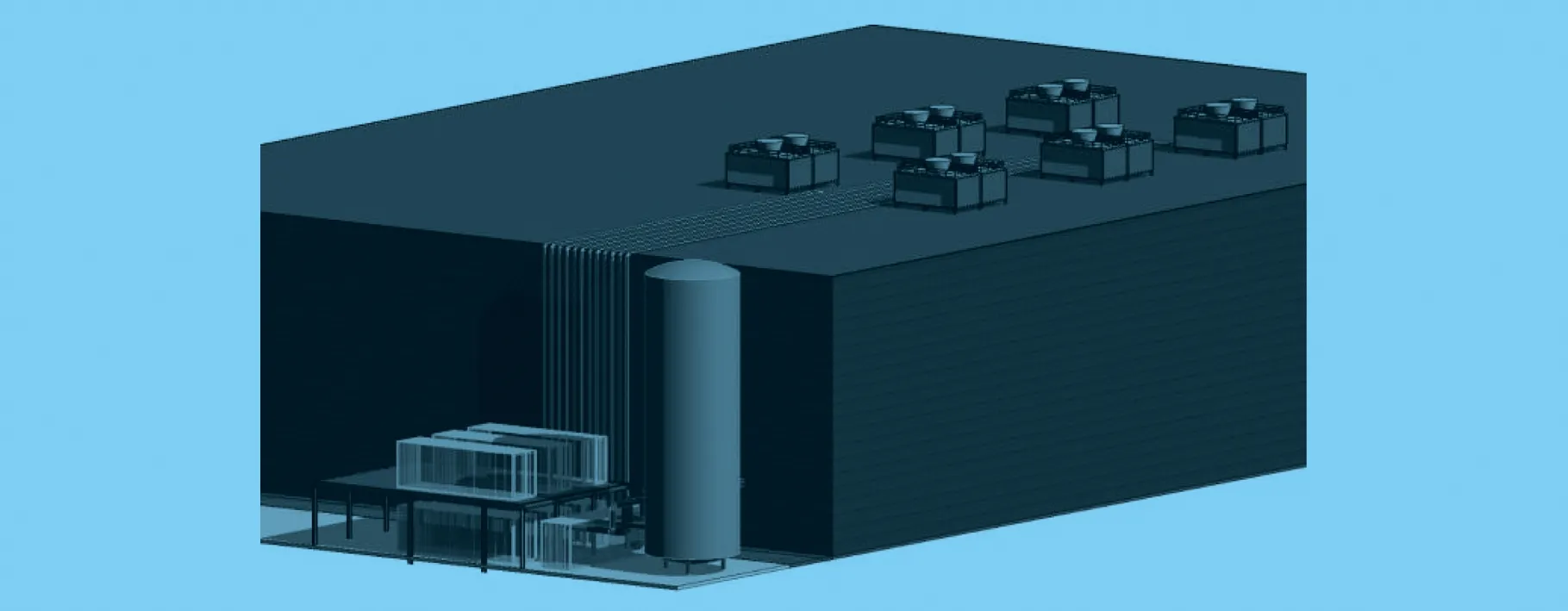

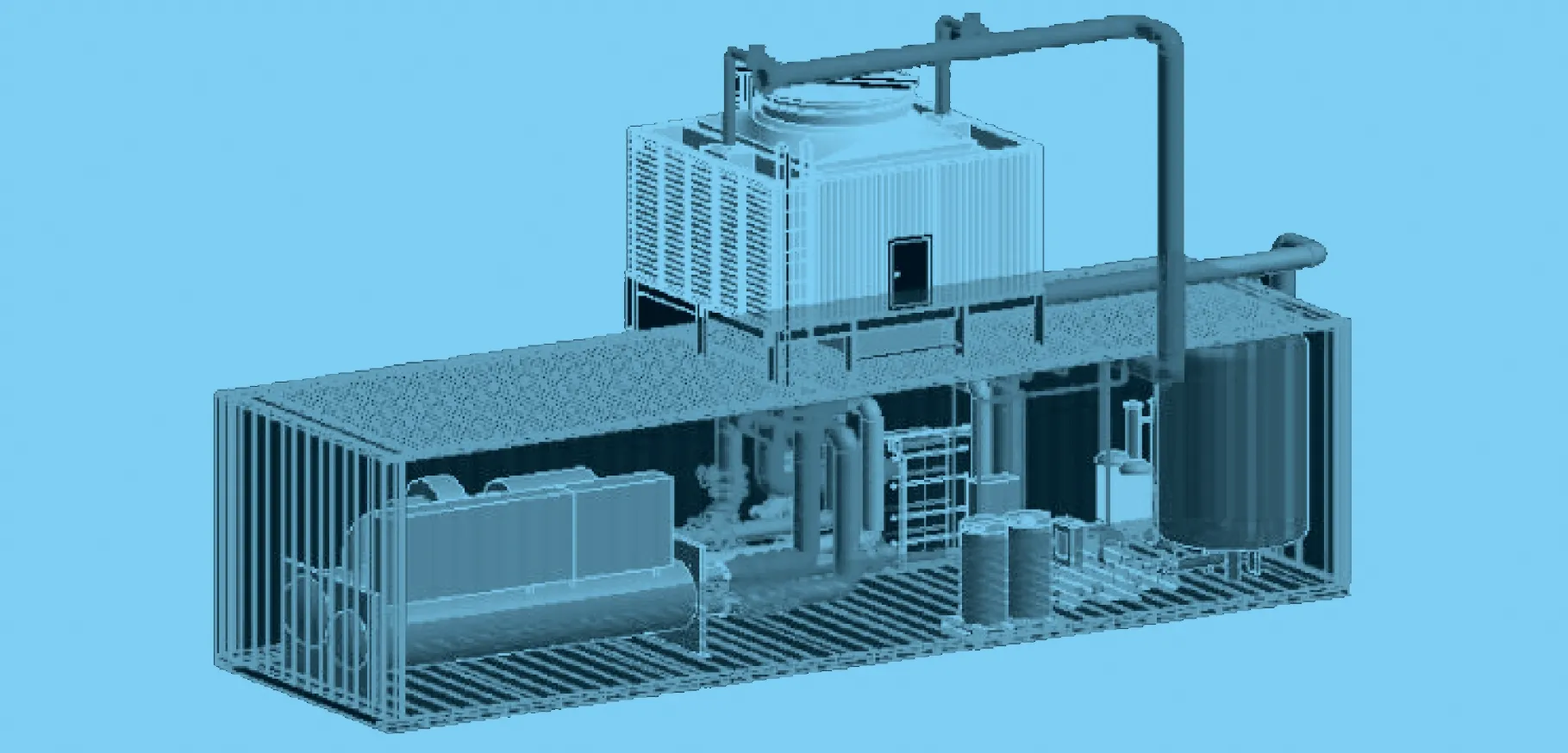

项目拟建空调工艺制冷机房,采用集装箱形式于2#楼东北侧室外。

5.1 冷冻站配置

依据计算结果,结合冷源的冗余备份遵循N+X(N≤10)的备份原则,每座冷站配置6台(4主2备)的磁悬浮变频离心式冷水机组。集装箱形式冷冻站布置如图11所示。

图11 集装箱形式冷冻站布置

冷源部分主要设备配置如表1所示。

表1 冷源部分主要设备配置

5.2 传统IDC冷冻站存在的问题

IDC暖通空调系统中的冷冻站由一个多设备构成,需要联合协调运行而体现综合性能的有机整体,本质上是一个系统工程。目前,国内IDC冷冻站存在问题:冷站占用IDC建筑物内面积,无法提高单位面积收益率;冷冻机房内设备独立招标,独立施工,整体协调性差;建造周期长,管道处理无法完全保证水质。

5.3 集中式冷冻机房优点

采购对象从一个个单体产品到单一集成产品;从工程项目到系统产品;从现场施工到工厂预制生产;从项目单设备控制到系统集成优化控制。集中式冷冻机房优点如下。

(1) 效率高,机房制冷效率提升20%左右。

(2) 安装成本低,安装成本节约30%以上。

(3) 可靠性强,全部组件(水机/水泵)出厂前测试。

(4) 节约空间。

(5) 降低安装风险,减少现场安装工程量。

(6) 可移动性及可再利用性好。

(7) 一站式服务,单一供货商。

(8) 自动化控制。

5.4 集成冷冻站的效率

集中式冷冻机房是以高效节能为核心,对各相关设备进行参数优化,通过工厂预制,模块运输,现场拼装的机电一体化系统解决方案。

5.5 集成冷冻站BIM设计步骤

(1) 从建模到管综优化,到出施工深化指导图,找到最优化的箱体尺寸、设备管道布置。

(2) 计算并优化管道局部阻力、沿程阻力。确认箱体内水系统阻力。

(3) 管综优化:通过初期的模型建立,对管道合理的空间布局进行优化,具体包括(所有管道共管共架,使支架的安装最经济性,考虑管道间的间距、检修空间,达到最大净高,所有设备需要建族,跟原型一模一样,并且参数化)。最后标注、定位、出施工深化指导图。

集成冷冻站BIM设计效果图如图12所示。

图12 集成冷冻站BIM设计效果图

6 数据中心AI群控系统节能技术

6.1 AI群控系统智慧运行功能

AI的核心是机器学习技术,其是使计算机具有智能的根本途径,是专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。在制冷模式切换前,是否满足切换条件需要进行多参数判断,而判断的依据便是各设备性能参数知识表。

通过机器学习,将采集的冷却塔、板式换热器等相关传感器数据进行云端存储、数据清洗、处理,形成精准的知识表数据,记录主机在不同负荷率、不同两器温差下的COP数据,当数据累计越多,数据的精度越高,对空调群控系统的控制提供了更有利的依据,同时对空调运维管理人员带来的管理帮助越大。

6.2 AI群控系统架构设计

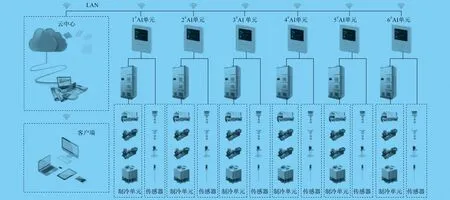

系统设计采用两层网络结构、三层设备结构的方式实现集中管理、分散控制的设备监控理念。

系统网络结构采用现场控制级和集中监控级(二层结构,采用C/S结构)。

集中监控级为一级网络,主要是实现管理层和控制层之间进行数据交换,通过六类四对UTP电缆实现物理连接,网络通信速率不低于100 Mbps,采用TCP/IP标准通信协议。现场控制级为二级网络,主要是实现控制层和现场设备之间进行数据交换,通过总线实现连接,采用Modbus RTU标准通信协议。同时,中央空调群控系统能够向大楼动环系统开放通信接口,其通信速率不低于100 Mbps,能支持Modbus RTU、Modbus TCP等多种标准通信协议。

6台AI装置通电后即刻自动组群,根据项目实际需要,6台AI装置将会组成一个独立的制冷群。群内每个AI都是对等的个体,通过以太网形成一个无中心对等网络结构,群内的AI装置通过群会话语言来协同工作,包括分享自身数据、建立共同控制目标、协商决策完成指令、协商决策完成失效代偿。无中心网络大幅度提高了系统的可靠性和供冷保障率,是空调机房全天候无人值守的技术核心。(每个AI独立控制1个制冷单元模组,每个制冷单元模组具备完整的独立启停、联动、供冷单元。各个供冷单元之间供冷没有耦合性,均独立自主。每个供冷单元模组控制1台制冷主机、1台冷冻水泵、1台冷却水泵、1组冷却塔,采集其控制设备的自身传感器。从数据采集到控制独立且完整。)

6.3 AI群控系统架构

群控系统架构如图13所示。

图13 群控系统架构

7 结 语

根据实践经验和理论分析,从规划设计上对水冷数据中心节能手段进行了设备选型,为水冷超大型数据中心的节能降耗提供了新的技术路线,机柜级(DHU)制冷节能技术方案,在上海已获批的18个项目之一得以实施应用,PUE设计值为1.281,预计今年底交付使用。