基于显著性多尺度特征协作融合的行人重识别方法

2021-06-18董亚超刘宏哲

董亚超,刘宏哲,徐 成

(北京联合大学北京市信息服务工程重点实验室,北京 100101)

0 概述

行人重识别指在不同的摄像头视角中匹配同一个目标人物的过程,在交通、公共安防和视频监控等领域发挥着重要作用。行人重识别的难点在于不同的摄像头产生的视角和光照不同,且遮挡和背景复杂等不利因素导致行人的姿态和外观存在巨大的差异,这些均会对行人重识别的准确性产生影响。

通过深度学习方法解决行人重识别问题的大致过程是先使用卷积神经网络(Convolutional Neural Network,CNN)提取每张图片的特征,然后对所查询行人图片特征和底库中的图片特征逐一进行距离相似性度量,根据距离远近排序出前K张与所查询行人最为相似的图片。目前,行人重识别方法主要分为基于表征学习、基于度量、基于局部特征学习和基于生成对抗网络(Generative Adversarial Networks,GAN)造图的四类方法[1]。

在基于表征学习的行人重识别方法中,文献[2]用Classification Loss 和Verification Loss 来训练网络,通过分类网络进行ID 预测,验证网络从而判断2 张图片是否属于同一个行人。考虑到仅靠行人ID信息学习得到的网络表达能力有限,文献[3]对行人图片进行属性标注,结合预测ID 信息和属性信息完成判定。文献[4]利用RGB 信息和灰度信息融合提取特征,以降低行人图像颜色相近所带来的干扰。

基于度量的学习方法在对2 张图片进行相似性度量时,使得2 张图片更加容易匹配或者区分开。常用的度量学习损失方法包括对比损失[5]、三元组损失[6]和四元组损失[7]等。文献[8]提出的Cricle Loss 中每个相似性得分以不同的步调进行学习,使得收敛目标更加明确。

为提高行人重识别方法的跨域能力、泛化能力以及克服姿态多变性问题,文献[9]使用GAN 生成8 个姿势的图像样本,用以代表所有摄像头视角下的行人姿势。文献[10]通过GAN 生成换衣数据,以更换行人衣服的颜色。

为提取更加细节的局部特征信息,文献[11]提出了分块卷积(PCB),其将特征在垂直方向上均匀切分为6 块并分别预测ID,通过这种方法可以提取更具鲁棒性的特征,但是其分块完后会出现图像不对齐的情况。文献[12]利用提取的人体关键点将图片分为头部、上身和下身3 个部分并分别进行特征提取。文献[13]先利用姿态估计模型估计行人关键点,然后通过仿射变换使得相同的关键点对齐。文献[14]提出多任务金字塔重叠匹配方法,以提取鲁棒性的局部特征。文献[15]提出多粒度网络,其将特征分成3 个分支,使用多个分类损失和三元组损失联合学习,最后整合所有特征。

上述切块模型存在如下问题:被切块的每个局部特征块享有相同的权重,导致模型不能聚焦到具有分辨力的特征块上,如帽子、背包这些具有分辨力的特征块不能被有效地凸显;在特征切块后,块与块之间的联系被破坏,容易丢失全局特征信息。

本文提出一种基于显著性多尺度特征协作融合的行人重识别方法SMC-ReID。在特征切块前,利用显著性检测提取行人图片的显著特征图,将其与全局特征进行融合,以对切块后的特征赋予不同的权重,增强具有区分力属性特征的特征块,抑制干扰网络从而判断背景特征块的权重。为挖掘多层次的局部特征,对特征进行多尺度切块,与传统切块方法不同,在切块后本文对每一部分的相邻块间再次进行协作融合,以保持块与块之间的联系和连续性。根据局部特征块和全局特征块的差异,本文采用3 种损失函数联合学习,以使全局和局部特征更加融合。最后在Market1501[16]、DukeMTMC-reID[17]和CUHK03[18]3 个公共数据集 上进行实验,以验证SMC-ReID 方法的行人重识别效果。

1 相关工作

1.1 显著性检测

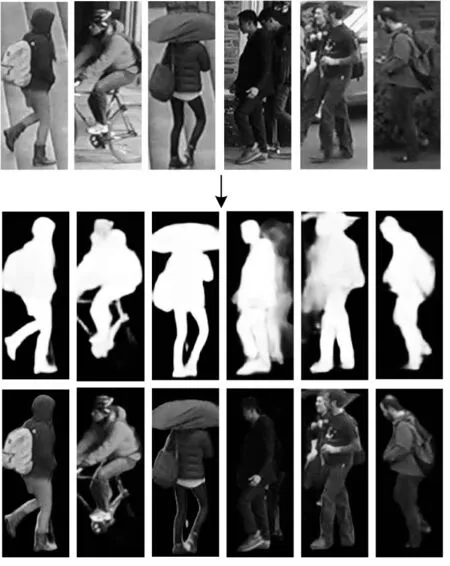

行人重识别中的一些特殊情况如图1 所示。由于存在背景复杂(图1(a)、图1(b)和图1(c))、姿态各异(图1(c))等问题,导致难以提取有效的特征。另外,行人图片中一些额外的辅助信息,如图1(b)、图1(d)和图1(e)中的背包、雨伞等特征,也可作为匹配2 个行人的有利因素。

图1 行人重识别中的一些特殊情况Fig.1 Some special cases in person re-identification

显著性目标检测通过人类视角检测出图片中具有区分力的醒目区域,目前,显著性检测已被应用于多种视觉任务中。本文使用显著性检测提取图片中具有区分力的显著性区域,抑制复杂的背景信息。

文献[19]将显著性目标检测应用于行人重识别领域,利用行人图像之间成对显著性区域的分布关系进行计算与匹配。文献[20]提出一种基于混合高阶注意力模型的方法,其对图像或特征图不同部分的共同作用机制进行注意力建模。与上述方法不同,本文不使用任何基于显著性区域匹配的方法,而是提取更深层的特征以编码行人特征。本文首先根据输入图像计算出显著性目标区域图,然后使用该特征图对中间层的CNN 网络参数权重进行加权。此外,本文的训练流程不包括显著性检测部分。

1.2 基于特征切块的行人重识别模型

由于在真实场景中采集的行人图片有严重遮挡、模糊甚至图像缺失的现象,使得全局特征或者单一局部特征难以完全体现出图片中的重要信息。文献[11-15]均基于特征切块进行行人重识别,但是特征切块容易造成特征块的不连续性,导致特征信息间断,从而对网络模型判断造成干扰。此外,在实际中需要根据特征切块尺度的不同使用相应的损失函数,促使各个损失函数学习进行相互作用。为此,本文将特征进行多尺度切块,切块后实现协作式融和,一方面提取一些被遮挡或忽略的特征,另一方面避免特征块的不连续问题。

2 方法实现

2.1 网络结构

如图2 所示,SMC-ReID 整体网络框架由显著性检测、骨干网络、降维层、全连接层(FC)和多损失函数构成,图中Reduce Dimension Operation 表示降维层,D表示特征向量的维数,特征提取骨干网络采用ResNet50,使用ImageNet 作为预训练模型。

图2 SMC-ReID 网络结构Fig.2 SMC-ReID network structure

本文对ResNet50 网络进行如下改进:1)移除ResNet50 中layer 4 后面的平均池化层和全连接层,改成相应的不同分支的最大池化层和适应不同尺度特征的全连接层;2)在ResNet50 中layer3 的后面增加提炼层(Refined Layer),其不与layer4 连接,该层由ResNet 残差结构中的Bottleneck 构成,一方面可以得到更大的特征图,另一方面能够统一特征维度,与Saliency Map 进行更好地融合;3)在更改后的全连接层前面增加降维层,其由卷积核为2×1 的二维卷积、批归一化处理和ReLU 激活函数构成,目的是将不同尺度的特征块降低到同一维度(512),既减少参数量的计算,又可以缓解网络的过拟合问题。

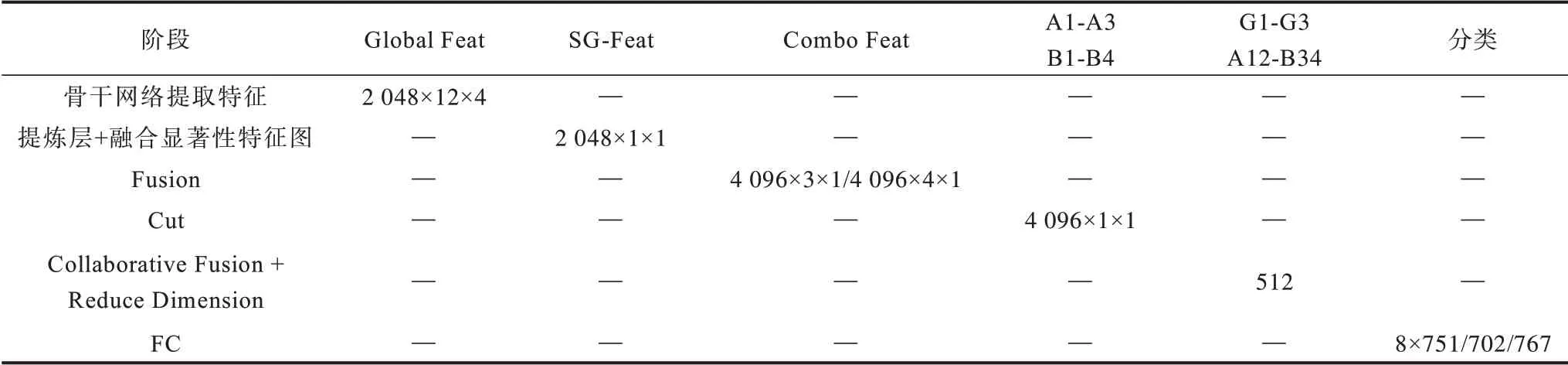

为了更清晰地展示图像在输入、特征提取、特征融合、特征切块等操作中特征向量维度的变化,表1给出不同阶段特征向量的变化过程。

表1 不同阶段的特征向量维度尺寸Table 1 Dimension sizes of feature vectors at different stages

如图1、表1 所示,将图片输入到CNN Backbone中,得到Global Feat 的维度为2 048×12×4,与此同时,将经过Refined Layer 的特征与经过显著性检测得到的Saliency Map 进行融合,得到SG-Feat,维度为2 048×1×1,然后将Global Feat 经过最 大池化(Max Pooling)得到维度为2 048×1×1 的特征,将其与SG-Feat 沿通道方向进行拼接融合得到Combo Feat,维度为4 096×1×1。Cut 操作中先将Combo Feat 进行上采样,得到特 征维度 为4 096×3×1 和4 096×4×1,对其进行不同尺度的切块,切块后得到A1-A3 和B1-B4,将其进行协作式融合,即A1 和A2协作融合得到A12,A2 和A3 协作融合得到A23,B1和B2 协作融合得到B12,B2 和B3 协作融合得到B23,B3 和B4 协作融合得到B34。在对上述进行降维处理后,得到共计8 个维度为512 的特征向量,均进行ID loss 和Label Smooth 分类学习,其中,将3 个Global Feat(G1、G2 和G3)再次使 用Triplet Loss 和Center Loss 进行联合学习,从而拉近正样本间的距离并增大负样本间的距离。

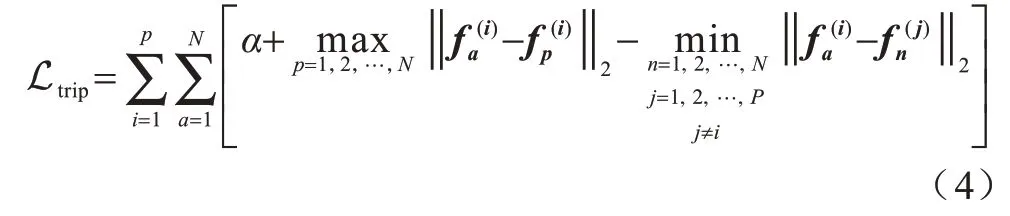

2.2 基于显著性检测的显著性特征图提取

行人重识别中由于背景复杂,全局特征不足以成为判断2 个人是否为同一个人的依据,一方面因为全局特征没有有效地将具有区分力的局部特征块凸显出来,另外一方面由于现有多数特征切块方法将每个特征块视为同一权重,导致如背包、帽子等重要的判断依据被忽视。如图3 所示,由于行人脸部不清晰,因此背包可作为重要的判断依据,现有的一些特征分块方法赋予每个块相同的权重,经过显著性特征图后可以自适应地赋予1、2、3 特征块更大的权重,尤其是背包所在的第3 块特征图。

图3 显著性特征图中的特征块权重Fig.3 Feature blocks weight in saliency feature graph

目前,显著性检测算法日趋成熟,本文使用在行人重识别数据集中表现良好的F3Net 网络[21]。考虑到行人重识别数据集中图片像素较低导致识别效果不明显的问题,本文对图片进行预处理,采用双线性插值法对其进行上采样以适应行人重识别数据集。此外,本文不将显著性特征图直接输入到网络中,而是将其进行灰度二值化,然后归一化并以特征向量的形式存储,最后将这些特征计算图与ResNet50 中间层layer3 进行向量矩阵相乘融合,使得不会有太多抽象信息同时也自适应地对原始特征图进行加权。

设一张图片经过layer3 计算后的特征图为τ∊Rh×w×c,一张显著性计算图为ω∊Rh'×w',为了使两者进行融合,对τ上采样将其转换为ω′∊Rh'×w'×c,然后通过特征向量矩阵相乘的方法使两者逐个元素融合。图4所示为显著性检测后的可视化图,可以看出,复杂的背景信息被抑制,具有区分力的信息被凸显。

图4 显著性检测的可视化效果Fig.4 Visualization effect of saliency detection

2.3 协作式多尺度特征融合和多损失函数联合学习

局部特征可以捕获到边缘细节信息,常用的局部特征提取方法包括基于图像切块、基于语义分割、基于姿态关键点等方法,其中,图像切块是有效且最常用的一种方法,但是,单一粒度的特征切块容易丢失结构信息。受文献[15]启发,本文采用多分支策略提取多尺度的局部特征。但与文献[15]不同,本文在特征切块前融合显著性特征图,使得每个特征块的权重不同,此外,为解决特征分块后丢失上下文信息的问题,本文在特征分块后再进行协作式融合,以加强特征块之间的连续性。如图2 所示,Global Feat、Combo Feat 以及Combo Feat 经 过Cut 操作后 的2 个特征分支尺度均不同,特征分块后将A1 和A2 进行通道连接得到A12,保留了A1 与A2 之间的连续性,其他特征块同样如此。

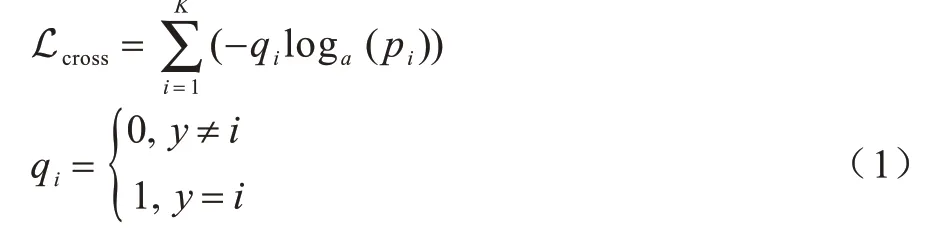

多尺度特征融合的重点在于损失函数,需要根据不同尺度的特征应用合适的损失函数。为此,本文联合多种损失函数并将其应用到多尺度特征块上进行数据集训练与网络模型优化。常用的行人重识别损失函数包括交叉熵损失(Cross-entropy loss)和Triplet loss 等。在Cross-entropy loss 中,本文以行人的ID 作为分类的类别。Cross-entropy loss 的作用是增大类间间距,其定义如式(1)所示:

其中,K为类别数目,即ID 数目,y为真值标签,pi为模型预测类别为i的概率值。

由于测试集中出现的ID 并未出现在训练集中,因此行人重识别是一项one-shot learning。如果训练好的分类网络对所有新加入的ID 都粗略地以0 或1 进行判断,则容易造成过拟合问题。因此,本文加入标签平滑(label smooth),其将式(1)中的qi改为:

其中,δ为设定的一个常数,本文将其设置为0.1,防止训练的模型过于相信训练集。本文采用ID loss,结合式(1)和式(2)得到式(3):

Triplet loss 的作用是不仅增大类间距离,而且拉近类内距离,因为Triplet loss 不能像ID loss 那样能达到全局最优约束,甚至使得类间距离小于类内距离,因此本文将ID loss 与Triplet loss 相结合以训练模型,从而使得模型学习到更具辨别力的特征。Triplet loss 定义如式(4)所示:

其中,B是最小批次图片数量,fj表示第j张图片的特征向量,yj是第j个图像的标签,为深度特征的第yj个类中心,其能有效描述类内变化,提高类内紧凑性。

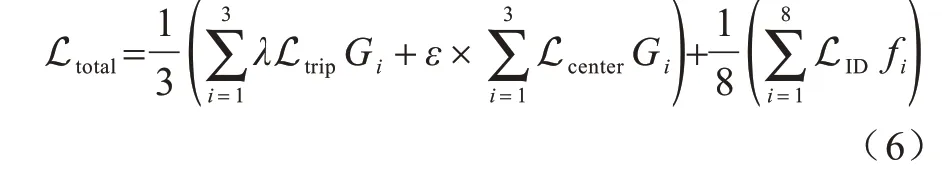

根据不同尺度特征块的特性,本文应用不同的损失函数。对于全局特征块G1~G3,本文利用Triplet loss 和Center loss 对其进行优化学习,原因是全局特征块更能拉近类间距离,另外局部特征块不适用于Triplet loss,甚至会影响模型性能。对于所有局部特征块和全局特征块,本文使用ID loss,这样整个网络模型的损失函数如式(6)所示:

其中,Gi表示全局特征块,fi表示除3 个全局特征块外 的8 个 局 部特征 快,λ是Triplet loss 的系数,ε是 为了平衡Center loss 的权重,设为0.000 5。

3 实验结果与分析

3.1 行人重识别数据集和评估指标

3.1.1 行人重识别数据集

为验证SMC-ReID 方法的有效性,本文在Market1501、DukeMTMC-reID 和CUHK03 3 个公开且常用的数据集上进行测试,3 个数据集的具体信息如表2 所示。

表2 Market1501、DukeMTMC-reID 和CUHK03 数据集的具体信息Table 2 Specific information of the Market1501,DukMTMC-reID and CUHK03 datasets

Market1501 是由5 个高清摄像头和1 个低清摄像头拍摄到的不同的1 501 个行人,共有32 668 个行人矩形框,训练集共有12 936 张图像,包含751 个行人ID,平均每个人有17.2 张训练数据,测试集有19 732 张图像,包含750 个行人ID,平均每个人有26.3 张测试数据,查询集共有3 368 张图像。

DukeMTMC-reID 共有36 411 张行人图像框,包含1 404 个行人ID,训练集包含702 个行人ID,图像数为16 522,测试集包含702 个行人身份,图像数为17 661,查询集包含的图像数为2 228。

CUHK03 数据集由2 个部分组成,一是手工标记的CUHK03-labeled,二是由DPM 算法检测到的CUHK03-detected,共由6 个摄像头拍摄而成。行人ID 数为1 467,包含14 097/14 096 个行人检测框,训练集总数为7 365/7 368,行人ID 数为767,测试集总数为5 332/5 328,行人ID 数为700,查询集包含1 400 张图像。CUHK03 的测试协议有新旧2 种,本文采用新的测试协议。

3.1.2 行人重识别评估指标

首位命中率(Rank-1)、平均准确率均值(mean Average Precision,mAP)和累积匹配特征曲线(Cumulative Matching Curve,CMC)是行人重识别任务中常用的评估标准,其中,CMC 常以Rank-k命中率的形式体现,表示在底库图像集合中与所查询图像匹配相似度最高的前k张图片命中查询图像的概率。mAP 的定义如式(7)所示:

其中,Q代表查询集的数量,AP 定义为:

其中,k为预测图片的排名,如果预测排名为k的图片与查询图片是同一ID,则rel(k)为1;否则,rel(k)为0。p(k)定义为:

CMC 可视为Rank list 的可视化,定义为:

其中,r代表Rank-k,m(r)是指在前r个排名中包含所查询图片的数目。

3.2 实验环境及参数设置

本文实验环境如下:操作系统为Ubuntu 16.04,深度学习框架为Pytorch 1.1.0,编程语言版本为Python 3.6,硬件基础为TITAN Xp GPU。

本文实验的骨干网络用ResNet50,并在ImageNet上预训练以初始化网络权重。为了得到更多的行人信息,本文将输入图片重新调整至384×128 大小,而显著性特征图的大小都重新调整至128×64。对图片数据的预处理操作包括随机翻转和像素归一化等。为应用三元组损失,每个训练批次选取8 个行人身份,并从训练集中随机为每个身份选取4 张图片,即训练批次大小为32。三元组损失函数边缘参数设置为1.2,中心损失权重值设为0.000 5。使用自适应梯度优化器(Adam)对网络模型进行优化,动量为0.9,权重衰减系数为0.000 5,初始学习率为0.000 2,在训练周期为320 和380 时对学习率进行指数衰减,衰减系数为0.1,训练总批次为400。测试阶段,将经过FC 层后的8 个特征向量进行通道连接组合,形成4 096 维向量并进行相似度匹配。

3.3 多尺度特征协作式网络的有效性实验

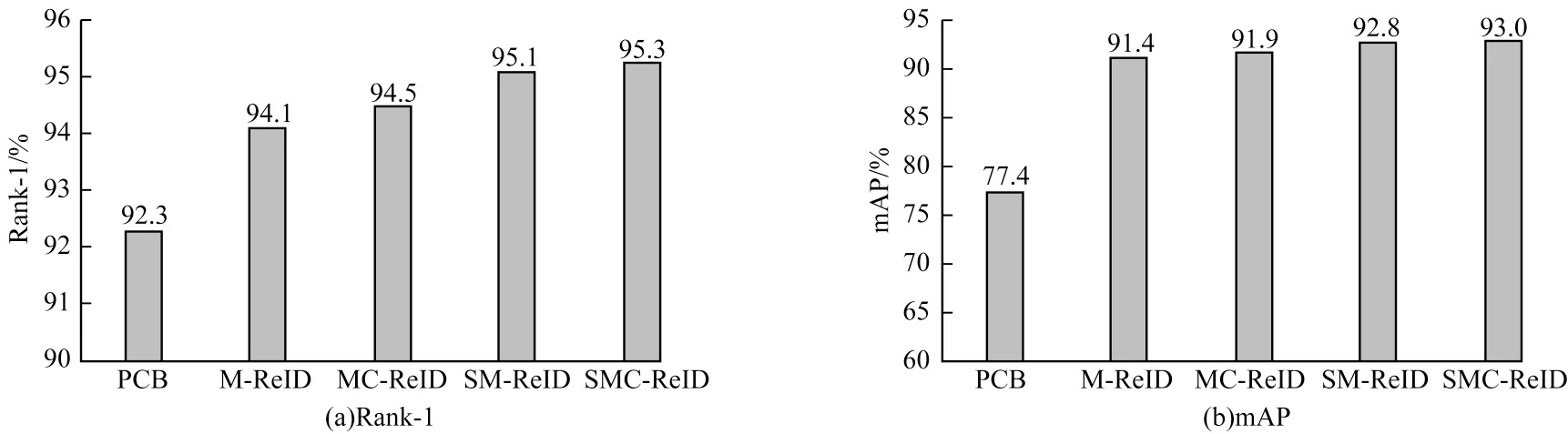

为验证SMC-ReID 方法中多尺度特征协作式融合的有效性,本文在Market1501 数据集和DukeMTMC-reID 数据集上分别进行对比实验。将基于单一尺度特征切块的PCB 模型、增加了多尺度特征切块方法的M-ReID 模型、在M-ReID 上使用协作式融合得到的MC-ReID 模型、在SM-ReID 上使用协作式融合得到的SMC-ReID 模型进行对比,实验结果如图5 和图6 所示。

图5 不同模型在Market1501 数据集上的性能对比结果Fig.5 Performance comparison results of different models on Market1501 dataset

图6 不同模型在DukeMTMC-reID 数据集上的性能对比结果Fig.6 Performance comparison results of different models on DukeMTMC-reID dataset

从图5 和图6 可以看出:

1)在Market1501 数据集上,相较于PCB,MReID 的Rank-1 和mAP 精度分别提高1.8 和14 个百分点,在DukeMTMC-reID 数据集上,分别提高3.1 和14 个百分点,证明了多尺度特征切块比单一尺度特征切块更加有效。

2)在Market1501 数据集上,相对于M-ReID,MC-ReID 的Rank-1 和mAP 精度分别提高0.4 和0.5 个百分点,即使在模型已经基本收敛的情况下,多尺度特征协作融合也可有效提高行人重识别的精度。在DukeMTMC-reID 数据集上,相对于M-ReID,MC-ReID 的Rank 1 和mAP 精度分别提高0.9 和1.4 个百分点,相对于Market1501 数据集增幅较高,原因是相比Market1501 数据集,DukeMTMC-reID 数据集的像素更高,多尺度协作融合方法更能提高特征块之间的连续性。

3)在DukeMTMC-reID 数据集上,在SM-ReID的基础上使用协作融和的方法后,Rank-1 和mAP 分别提高1.5 和3.3 个百分点,相比在M-ReID 上使用协作融合方法的精度增幅高一点,说明特征协作融合方法和显著性特征图相结合更能发挥作用,验证了协作式特征融合能够提升网络模型的性能,因为单一尺度特征切块的PCB 旨在解决由遮挡、姿态各异情况引起的特征信息提取不充分问题,而M-ReID 和MC-ReID 的精度优于PCB,因此也进一步证明基于多尺度协作融合方法的M-ReID 和MC-ReID 网络对于遮挡等情况具有有效性。

3.4 显著性特征图的有效性实验

为验证显著性特征图的有效性,本文在Market1501 数据集和DukeMTMC-reID 数据集上分别进行2 组实验,第1 组在M-ReID 基础上加入显著性特征图进行实验,第2 组在MC-ReID 基础上加入显著性特征图进行实验,结果如图5 和图6 所示。从图5 和图6 可以看出,在第1 组实验中,在Market1501数据集上,相比于M-ReID,SM-ReID 的Rank-1 和mAP 精度分别提高1.0 和1.4 个百分点,而在DukeMTMC-reID 数据集上,分别提高2.7 和3.7 个百分点。在另外一组实验中,相比于MC-ReID,SMCReID 在Market1501 数据集上的Rank-1 和mAP 精 度分别提升0.8 和1.1 个百分点,在DukeMTMC-reID 数据集上分别提升3.3 和5.7 个百分点。上述结果一方面证明了增加显著性特征图的有效性,另外一方面可以看出第2 组实验的增幅较第1 组实验高一些,证明了加入显著性特征图和使用协作式多尺度特征融合的有效性,也进一步体现了在背景信息冗余复杂的情况下,加入显著性特征图对于精度提升的有效性。由于DukeMTMC-reID 数据集的像素较高,因此加入显著性特征图后精度提升更加明显。

3.5 多损失函数性能分析

根据不同尺度特征的特性,本文使用多损失函数进行联合学习。为证明多损失函数联合学习的有效性,本文进行定量和定性分析。定量分析结果如表3 所示,从表3 可以看出,在单一的ID loss 上使用Triplet loss 后,mAP 和Rank-1 分别提高5.9 和4.2 个百分点,在此基础上增加Center loss 后,mAP 和Rank-1 分别提高0.5 和0.2 个百分点,证明了使用多损失函数联合学习对网络模型的有效性。进一步将Triplet loss 的系数调整为2,mAP 和Rank-1 分别提高1.3 和0.4 个百分点,一方面是因为Triplet loss 能够缓解类内间距大于类间间距的情况,从而使得类内更加紧密,另一方面是因为该系数平衡了多尺度特征块中ID loss 和Triplet loss 在混合loss 中的占比。

表3 不同损失函数在Market1501数据集上的性能对比结果Table 3 Performance comparison results of different loss functions on Market1501 dataset %

图7所示为使用ID loss后样本分布的可视化效果,可以看出,类内距离很大,并未完全学习到同一ID 的共同特征。如图8 所示,在加入Triplet loss 后类内距离减小,使得模型学习到更具鲁棒性的特征。

图7 使用ID loss 后的样本分布可视化效果Fig.7 Visualization of samples distribution using ID loss

图8 加入Triplet loss 后样本分布变化的可视化效果Fig.8 Visualization of samples distribution change after adding Triple loss

3.6 方法实时性分析

表4 所示为不同方法在Market1501 数据集上的测试时间比较,测试集包含751 个人,共有19 732 张图片,本次实验在相同的硬件条件下进行。从表4可以看出,本文方法运行速度处于居中水平,但是准确率比其他方法高。在实际应用中,存储行人数据集的底库数量是慢慢增加的,所以只需考虑新增的行人图像,本文方法的单张图片匹配计算时间为0.029 s,满足了一般算法对实时性的要求。

表4 不同方法在Market1501 数据集上的测试时间比较Table 4 Test time comparison of different methods on Market1501 dataset s

3.7 多种方法性能比较

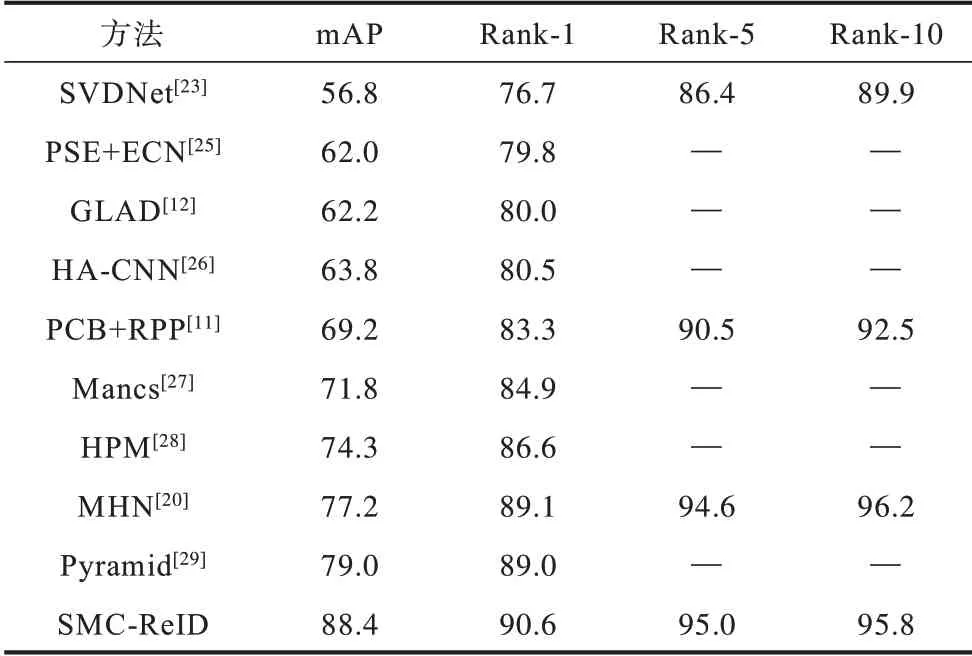

为验证本文SMC-ReID 方法的有效性,在Market1501、DukeMTMC-reID 和CUHK03 3 个行人重识别数据集上进行实验。其中,在Market1501 和DukeMTMC-reID 2 个数据 集上以mAP、Rank-1、Rank-5 和Rank-10 作为评估指标,在CUHK03 数据集上以mAP 和Rank-1 作为评估指标。对比方法包括Spindle[22]、SVDNet[23]、PDC[24]、PSE[25]、GLAD[12]、HA-C N N[26]、PCB[11]、PCB+RPP[11]、M ancs[27]、HPM[28]、MHN[20]和Pyramid[29]。对比结果如表5~表7 所示,其中,“—”表示原文献没有给出实验结果。

表5 Market1501 数据集上不同方法的性能比较结果Table 5 Performance comparison results of different methods on Market1501 dataset %

表6 DukeMTMC-reID数据集上不同方法的性能比较结果Table 6 Performance comparison results of different methods on DukeMTMC-reID dataset %

表7 CUHK03 数据集上不同方法的性能比较结果Table 7 Performance comparison results of different methods on CUHK03 dataset %

从表5 可以看出,在Market1501 数据集上,本文SMC-ReID 方法的mAP 精度达到93.0%,Rank-1 准确率达到95.3%,相较PCB+RPP 分别提高11.4 和1.5 个百分点,证明了显著性特征图和多尺度特征协作融合方法的有效性。

从表6 可以看出,在DukeMTMC-reID 数据集上,SMC-ReID 的mAP 精度达到88.4%,Rank-1 命中率达到90.6%,相较先进的Pyramid 分别提高9.4 和1.6 个百分点。通过对比可以看出,SMC-ReID 在DukeMTMC-reID 数据集上的性能提升幅度高于Market1501 数据集,原因是图片像素清晰时显著性特征图起到的作用更加明显。

从表7 可以看出,SMC-ReID 在CUHK03-labeled和CUHK03-detected 上分别取得了84.0%、82.4%的mAP 精度和81.8%、80.5%的Rank-1 命中率,优于多数方法,进一步证明了SMC-ReID 方法的有效性。

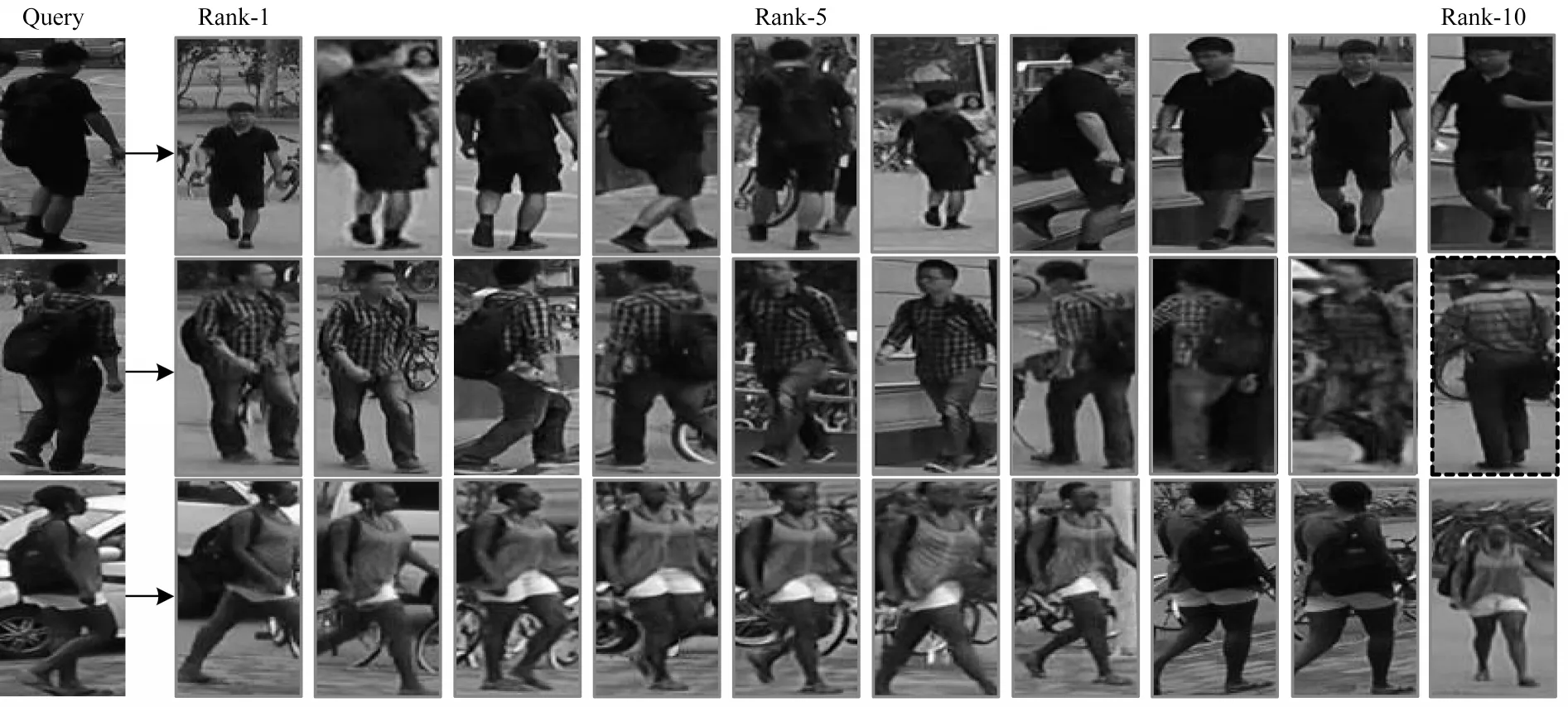

3.8 行人重识别结果的可视化分析

为更加直观地显示SMC-ReID 在复杂情景下的重识别效果,本文在Market-1501、DukeMTMC-reID和CUHK03 3 个数据集上展示部分查询结果的可视化效果,分别如图9~图12 所示,其中,虚线框为错误预测结果。

图9 SMC-ReID 方法在特殊情况下的部分查询结果可视化对比Fig.9 Visual comparison of some query results of SMC-ReID method in special cases

图10 SMC-ReID 在Market1501 数据集上的部分查询结果可视化对比Fig.10 Visual comparison of some query results of SMC-ReID on Market1501 dataset

图11 SMC-ReID 在DukeMTMC-reID 数据集上的部分查询结果可视化对比Fig.11 Visual comparison of some query results of SMC-ReID on DukeMTMC-reID dataset

图12 SMC-ReID 在CUHK03 数据集上的部分查询结果可视化对比Fig.12 Visual comparison of some query results of SMC-ReID on CUHK03 dataset

从图9(a)的匹配结果可以看出,对于同一个人在图片中的不同尺度,SMC-ReID 相较PCB 方法匹配准确率较高,此外,PCB 方法排名前6 的正确结果均为相同尺度的图像,而本文方法将尺度变化较大的图像排在更前的位置,证明了多尺度特征协作融合方法的优越性。从图9(b)的匹配结果可以看出,PCB 方法匹配错误的直观原因是背景混杂对匹配结果造成了干扰,甚至难以区分行人的轮廓,而SMCReID 方法能正确地匹配出同一行人的图像,证明了本文方法能有效减少背景冗余信息所带来的影响。从图9(c)的匹配结果可以看出,由于给出的查询图片被车辆、行人严重遮挡,导致PCB 方法难以提取鲁棒性的特征,使得其匹配正确率降低,而SMC-ReID能通过提取更细节的局部特征,从而正确地匹配出同一个人。在PCB 和本文方法都只有一个图片未成功匹配的情况下,本文方法出错位置排在Rank-9,而PCB 排在Rank-6。以上结果说明SMC-ReID 在多数复杂情景下均有较好的识别性能。

从图11可以看出,在姿态变化、行人相互遮挡、背景复杂的情况下,SMC-ReID 仍能准确匹配到多数正确结果,在第2组查询结果中,Rank-7由于该图片的行人ID为后面几乎完全被遮挡的人,而被遮挡的行人图片信息较少,导致匹配错误。图12中给出行人背面,SMC-ReID也能准确匹配到佩戴口罩的同一行人的ID 身份。

4 结束语

本文提出一种基于显著性多尺度特征协作融合的行人重识别方法,通过显著性检测得到图片中具有区分力的特征图,对多尺度特征分块后的权重进行分配,以协作融合的方法解决特征块不连续的问题,从而提取更具显著性和鲁棒性的特征。实验结果表明,该方法能获得较高的mAP 精度和Rank-1值,可有效提升行人重识别性能。下一步考虑将显著性特征图与原始特征图进行融合,以充分发挥显著性特征图的作用。