基于先验显著性的卫星视频微小运动车辆检测

2021-03-23雷俊锋董宇轩眭海刚

雷俊锋,董宇轩,眭海刚

(1.武汉大学电子信息学院,湖北武汉430072;2.武汉大学测绘遥感信息工程国家重点实验室,湖北武汉430079)

1 引 言

视频卫星作为一种新型对地观测卫星,通过“凝视”成像方式[1]对某一区域进行连续观测,特别适用于动态目标的观测。近年来,我国的视频卫星发展十分迅速,其中长光卫星技术有限公司于2015年发射的两颗视频卫星-吉林一号(1星,2星)的各项技术指标均达到较高水准。该实时视频卫星支持全球业务,包括石油储存检测、灾害响应、生态系统扰动检测和船舶车辆跟踪[2]等。

当今智能交通系统的主要数据源一般来自地面固定或空中的摄像机、传感器。这类图像的主要缺点是空间覆盖有限,因此研究人员开始关注更高的空间。卫星视频在广域监控领域具有巨大的优势和潜力,如城市的交通监控、建筑的三维重建[3]和地震救援工作等。为了有效地监控城市地区的场景,一个主要且关键的任务就是检测和识别卫星视频中捕捉到的移动车辆。然而,在卫星视频中检测微小运动车辆存在诸多挑战。

在卫星视频中,车辆目标非常小[4],每辆车通常只有几个像素。基于深度学习的目标检测算法诸如YOLOV3[5],FAST-RCNN[6]等,由于卷积操作的局限性很难完成对几个像素目标的特征提取,多被用于超过0.5 m分辨率的监测系统;基于全卷积网络的目标分割方法如边缘敏感的显著性网络BASNet[7],在背景复杂的卫星视频中常常会受到多种干扰,在先验信息不足的情况下大概率会将路障或者道路边的建筑误检为目标。

在这种情况下,运动信息常常是最稳健的特征,改进的视觉背景提取(Improved Visual Back⁃ground extractor,ViBe)等算法[8-10]可以实现视频中运动车辆检测,该类方法通过与建立的背景模型进行比较,在图像中搜索变化像素。但由于成像系统中噪声影响以及背景的运动,该类方法容易产生视差引起的虚影。文献[11]提出了针对成像系统的3种场景差别补偿和更新的检测方法,能有效处理强视差下的误检测,但在处理小目标时的检测能力不佳。

Larsen等人[12]用椭圆斑点的检测策略检测车辆,利用具有多种经典特征的KNN(K-Near⁃est-Neighbor)分类器将车辆与非车辆目标分离。Liu[13]提出了一种改进的形态学重建方法来建立复杂背景的卫星图像模型,采用归一化差分设计方向滤波器来生成用于形态学重建的车辆。然而在卫星视频序列中,存在着大量类似于车辆的物体,这可能会导致混淆。文献[14]则是关注于图像的明暗变化,采用半自动双阈值技术首先在掩蔽道路上检测出暗车和亮车。利用相邻关系和双区域滤波去除残留干扰(阴影、车道线和噪声)。为了解决道路外的干扰,文献[15]提出采用道路先验的方法完成预先道路区域的提取,消除了道路外的误检,但这种方法适用于长时间不动的凝视卫星,需要多帧的有效图片进行道路建模提取,在灵活度以及处理速度上有所欠缺。Teng等人[16]采用迭代多网格图像变形方法计算全局运动场,具有更准确、更省时的优点。文献[17]则是假设真实的数据存在于一个低维的子空间,通过降维的方法分割目标和背景,增强了数据的可处理性,但降维过程也常常会受到视频传输过程中的噪声干扰。

现有的多种算法都针对于目标的某一种特征(色彩、形状)或聚焦于卫星视频中最为稳健的运动信息,而在复杂的背景以及成像系统的偏移下并不可靠,基于这一情况,通过观察卫星视频[18]的特点,发现显著性映射也能在一定程度上为目标的检测提供有用的信息,结合运动信息能更好地消除误检,设计了一种基于多种先验约束显著性的卫星视频中微小运动车辆检测方法。本文对文献[19]提出的人眼视觉模型进行改进来获得感兴趣目标,并通过显著性映射的空间特性获得“区域稳定性”映射图,同时采用背景建模生成图像的运动热图并完成基于超像素的运动区域估计,最后结合多种先验信息获得最终的特征映射完成目标二值分割。实验结果表明,相较于现有算法,所提算法在图像场境适应性以及检测指标上取得了更好的结果,具有一定优势。

2 基于先验显著性的卫星图像微小运动车辆检测

2.1 人眼显著性模型[19]及边界相关性

现有的显著性检测方法,多是针对自然图像中的目标,其图像色彩鲜明,目标像素占比较大,并不适用于背景复杂、目标小的卫星视频。

图1 吉林一号卫星道路影像Fig.1 Road scenes in“Jilin-1”satellite video

图1 为吉林一号卫星视频某处道路场景,从图中可以看出,背景复杂且色彩晦暗,微小车辆(道路中间的白色目标)与边界拥有较少的“交互性”,与图像边界的联系较少。这里的边界不是广义上的图像线条而是能描述图像区域布局的界限。

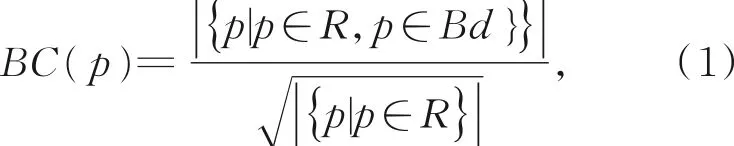

文献[19]提出了人眼视觉模型,使用边界相关性公式(1)来描述一个区域的重要性,定义为:

其中:Bd为某个图像区域边界的集合,p为其中的一个图像块,它表示某个区域与边界接触的长度与其面积平方根的比值。

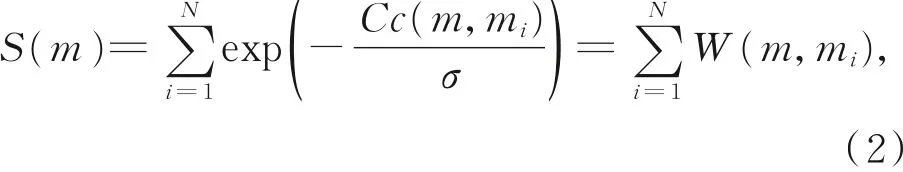

为了解决纯粹分割算法可能导致的误差校正和伪边界问题,Zhu[19]将图像抽象为一组规则的超像素来简化计算。定义每个超像素m所属的本征区域面积如式(2)所示:

其中:N为超像素的总数,W(m,mi)表示某个超像素mi对m所在的本征区域的贡献权重。连接所有相邻的超像素(m,n),计算出它们的平均颜色在CIE-LAB空间中的欧式距离E(m,n),计算出图像中所有超像素间的互相关性Cc(m,n),σ是贡献度的阈值。实验表明[19]当σ取值在[5,15]之间时对不同本征区域分离效果较好。

类似地,Zhu定义某个超像素对本区域边界接触的“长度”为:

其中:Q为与m相邻的超像素个数,δ(mi∈Bd)用来判断m与相邻超像素之间是否存在区域边界,存在则置为1,不存在则置为0。

文献[19]最终采用了简化公式(4)来代替式(1)计算超像素与边界的相关性:

通过简化后的公式(4)可以利用较可靠且快速的超像素分割来完成相关性模型的计算。

2.2 超像素分割以及参数选择

简单线性迭代聚类算法(Simple Linear Itera⁃tive Cluster,SLIC)[20]生成的超像素如同细胞一般紧凑整齐,领域特征比较容易表达,很适合将基于像素的计算方法拓展到基于超像素的方法。且需要设置的参数非常少,默认情况下只需要设置预分割的超像素数量NR和紧凑性参数NC。对于式(4)提出的计算方法,需要获得轮廓紧凑的超像素以及尽量避免不同的微小车辆被生硬地分割到相邻的超像素中,采用Stutz[21]提出的紧凑度(Compactness,CO)和边界召回率(Bound⁃ary Recall,BR)来作为超像素分割的评价指标进行参数选取。选取吉林一号卫星图像中两个不同数据集的道路区域进行了实验。图2是不同NR参数得到的CO指标对比。

图2 不同NR参数的CO指标对比Fig.2 CO index comparison of different NR parameters

从图2中的折线图可以看出,NR从200~400的过程中CO指标较为明显地上升,而在NR>600后,继续增加超像素数量对指标的提升很有限,且通过实验在超像素数量大于700后NR每增加100,计算时间大约增加11%。综合考虑后选择NR取值范围为[500,700],本文中选取600。

除了超像素数量的选择,分割紧凑性参数NC也会影响生成超像素的边界稳定性。对图2中的数据在NR为600的情况下选取了不同的NC参数进行了实验,获得不同BR指标如图3所示。

图3 不同NC参数的BR指标对比Fig.3 BR index comparison of different NC parameters

由图3的折线图可知,当NC取35~45之间时,能够获得最好的BR指标,这表明超像素的边界能更好地“包裹”住目标,而在NC>50后BR指标逐渐下降。综合考虑后选择NC的取值范围是35~45,本文中选取40。

2.3 多种先验信息约束

卫星视频传输过程中产生的多种噪声对单个像素的影响很大,为了将噪声的影响降到最低,本文在人眼视觉模型的基础上获得其他先验信息,定义不同的约束项来适应卫星图像的环境。

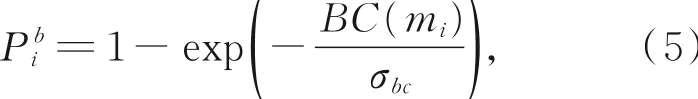

首先引入文献[19]定义的超像素与区域边界的相关性。背景概率Pib作为超像素mi边界相关性的映射,当超像素与边界的相关性很大时,很小时该项定义为:其中:σbc是映射超参数,当σbc∈[1,3]时,输出结果对该参数敏感,最终设置为2。同时,可以得到与之对应的前景概率Pio,当超像素与边界的相关性很大时,Pio→0,很小时,Pio→1。

由于超像素相邻区域可能会导致像素值的跳跃性变化。在某些情况下,道路中的车辆会处于邻接状态,位于不同超像素中的目标车辆可能产生边界融合。为了消除因相邻超像素间局部差异导致的边界干扰,本文提出了一个新的区域平滑约束项,将每对相邻的超像素之间的平滑约束定义为:

其中:σ为定义的权重,用欧式距离E(mi,mj)来表示同一个超像素中像素值的接近程度,μ是优化参数,通常取0.1,用来消除在前景背景中的小噪声。

通过融合多种类型约束,本文将第i个超像素的显著性定义为Si,构建整个图像的显著性代价函数,如式(7)所示:

式(7)中分别用平方差的形式定义了背景、前景和区域平滑三个约束项。用最小二乘法进行优化求解,得到需要的显著性目标图。

2.4 基于超像素的运动约束

然而某些显眼的建筑物或路障也可能获得和目标相似的显著性映射,而这些区域静止不动的特性可以通过生成运动热图的方法约束显著性结果。本文算法将像素引申到超像素,定义了一种基于背景模型的超像素运动热图生成方法,步骤如下:

Step1设定距离相近判定的阈值D和近似样本点数目判定的阈值minT。

Step2对于像素点p,定义OD(v(p))为以像素值v(p)为中心、D为半径的区域集合。

Step3计算像素点p背景模型样本集B(p)={v1,v2,…vN}中的样本落在OD(v(p))中的个数:

Step4若n 其中:Qi为某个像素的运动标志位,P为超参数中包含的像素个数。当时,认为该超像素属于运动区域。本文用与标记真实运动像素的准确率来验证这种方法的有效性,给出单像素判决和超像素判决的受试者工作特征(Receiver Operating Characteristic,ROC)曲线对比(彩图见期刊电子版)。 图4 不同策略的ROC曲线对比Fig.4 ROC curve comparison of different strategies 从ROC曲线对比可以看出基于超像素能提高对运动像素的检测准确度。 对于单个显著性映射或者运动热图来说,均存在由于方法缺陷导致的误检,例如显著性无法区分目标车辆和“显眼”的路障或建筑物,而运动热图在自我运动较为频繁的卫星视频中也常常有诸多因光照或者画面晃动导致的误检。需要充分利用这两部分特征完成信息的交流和互补。 获得的显著性映射能较好地反映道路中微小车辆的显著性强度,但仍然存在缺陷。即得到的显著性映射是灰度强度图像,需要进行阈值化操作来得到运动车辆的二值分割。 通过对显著性映射图的数据分析发现,采用绝对的阈值化操作是不可取的,相反地,在显著性映射中强度的多样性以及变化恰恰包含了更多的信息。通过与周围背景区域的对比[22]来评估局部图像像素的显著性,与边界相关性较大的区域将会被赋予较高的显著性值。如图5所示,少数中类似车道线的区域也会获得较大的显著性值,这些区域与其说是误检,更多的可以当做背景干扰,显然这些区域均为假警报,而当待检车辆与这些干扰背景融合的时候则会引入更多的区分困难。图中圆形区域以及矩形区域中的目标与道路中背景的关系密切。且均能从显著性映射图中获得像素的响应,基于卫星视频1.13 m的分辨率并考虑到现实中车辆的平均大小,本文取某个像素的3×3邻域,认为该尺寸能更好的契合微小车辆的在图像中的像素占比,反映目标周围像素的空间变化情况。 图5 背景融合情况示意图Fig.5 Schematic diagram of background fusion 将像素p的邻域定义为:其中,p位于9邻域的中心位置,下标0处。同时基于该邻域提出了一种区域稳定性映射,通过前后帧的显著性映射对比完成时间邻域滤波,如式(11)所示: 其中:M(pi)和Mn(pi)分别是当前帧以及下一帧中像素p下标为i的邻域像素值。 虽然由于卫星角度的变化,运动检测的结果充满了不确定性,但仍然包含了许多可以利用的信息。 图6 联合预测结果Fig.6 Result of joint prediction 对于某像素点的检测,我们需要同时考虑运动热图、显著性映射以及区域稳定性映射的结果,进行联合推断,完成更精确的微小车辆检测,如图6所示。图中利用运动热图、区域显著性图、以及显著性稳定特征为线索来构建最终的联合特征向量。充分利用了时间空间的信息,对大多数车辆均能完成有效地检测,特别是图中圆形框标记的与道路边界或车道线关系密切也能通过多种先验信息提取出车辆,但对于矩形区域中与道路边界背景基本完全融合的某些车辆则会漏检,但也因此减少了因边界预测将背景误检的概率,更多地关注于轮廓清晰的运动车辆。 为了选取最好的显著性稳定性阈值,选取不同的Pst进行实验,同时在标注好的数据集上进行受试者曲线面积(Area under Curve,AUC)指标测试,得到图7的折线图。可以看出当Pst选取15左右时,能够获得最高的AUC指标,完成目标的准确提取。 图7 不同Pst参数下的指标对比Fig.7 Comparison of indexes under different Pst param⁃eters 按上述步骤,设计的算法流程如下:输入为卫星视频当前帧图像Xd以及前一帧图像Xe,输出为二值化的车辆检测结果图Xo。 算法的主要步骤描述如下: Step1取输入的当前帧图像利用简单线性迭代的方法得到超像素分割结果,根据输入分辨率自适应地设定合适的分割参数。 Step2通过人眼显著性模型计算每个超像素与其本征区域的边界相关性数值,计算公式为:其中L(m)为超像素对本区域接触“长度”,S(m)为本征区域的面积。 Step4对当前帧图像Xd以及前一帧图像Xe利用背景建模的方法获得运动热图,并利用运动热图、区域显著性图、以及区域稳定特征为线索来构建最终的联合特征向量获得最终的预测输出。 为了衡量本文所提算法效果,在长光技术有限公司发射的“吉林一号”[23]第二批光学卫星原始图像中选取了世界各地不同城市的卫星视频进行测试。该数据包括美国、土耳其、巴林穆哈拉格等不同城市的影像数据。每一帧卫星图像的空间分辨率约为1.13 m,对这些视频截取了不同城市的道路场景视频来进行道路上车辆的检测。部分测试图像如图8所示。 图8 部分测试影像数据Fig.8 Part of the test image data 为验证所提算法(选取参数NC=40,NR=600以及Pst=15)的性能,与近年来部分优秀算法进行了结果对比,包括改进的高斯混合模型(Gaussian Mixture Model,GMMv2)[9](采用背景门限为0.7高斯模型个数为5的默认参数);运动目标提取ViBe算法[10](采用时间采样因子为16的默认最优参数);帧间背景融合差分(Differ⁃ence of Background Fusion between Frames,FBD)[8](采用方差阈值为0.01的默认参数),以及动态鲁棒主成分分析[17](Dynamic Robust Prin⁃cipal Component Analysis,DRPCA)。 当前的视频卫星虽然相较以前已达到了“高分辨”,但通常只能公开获得精度为米级的图像。并且卫星视频拍摄过程中状态通常难以预测,观测方式虽称为“凝视”,但常有细微的拍摄角度变化导致图像偏移。下面分别对稳定拍摄情况下和拍摄角度变化时获得的卫星影像进行算法比较。 在图8中显示的4种道路场景中,除了美国圣保罗的卫星数据有由卫星角度偏移产生的背景变化外,均为稳定条件下成像。图9为巴林穆 哈拉格图像的对比检测结果。 图9 巴林穆哈拉登卫星影像效果对比图Fig.9 Results comparison of Muharag satellite video in Bahrain 图9 的数据为在巴林穆哈拉登拍摄的卫星影像,此时卫星以较为平稳的状态对地“凝视”观测。从结果可以看出GMMv2算法对于运动目标的检测精度很高,但对于目标轮廓的勾勒较为粗糙;并且会由于光照或影像传输过程中引起的背景细微变化产生许多误检;ViBe算法召回率很高但道路中的误检也较多;FBD算法能达到较高的检测准确度但由此导致大量漏检;而基于主成分分析的DRPCA算法则是在道路中间能够准确地检测到运动目标,但也会引入建筑物光照变化产生的误检。而所提算法在只有少量漏检的情况下保持了较高的检测准确度,具有一定的优势。 为了进一步评估检测效果,选取检测准确率(Precision)、召 回率(Recall)和虚警率(False Alarm)来分析检测效果。其中Precision=TP/(TP+FP);Recall=TP/TA;False Alarm=FP/(TP+FP)。TA表示人工标注的目标总数;TP表示被正确检测的目标数目;FP表示把背景错误地检测为目标的数目。取之前4个城市道路中除美国圣保罗之外的3个道路影像各500 frame计算平均指标。结果如表1~表3所示。 从客观指标结果可以看出,GMMv2算法的召回率较高的同时虚警率也较高,ViBe算法的在召回率较高的前提下无法保证检测的精度,而FBD算法和DRPCA算法则是在保证准确率和虚警率无法拥有较高的召回率。所提算法在稳定图像环境下的三种客观指标相比于其他算法各种指标均较为稳定,在保证低虚警率的同时也能拥有相对较高的准确率和召回率,具有一定的优势。同时为了更清晰地说明各算法的性能对比,通过上述各数据集的受试者工作特征(Re⁃ceiver Operating Characteristic,ROC)曲线,计算平均曲线下面积(Area Under Curve,AUC)值。并给出了在配置GTX1050显卡计算机的平均运行时间,结果如表4,表5所示。 表1 准确率指标对比Tab.1 Comparison of Precision (%) 表2 召回率指标对比Tab.2 Comparison of Recall (%) 表3 虚警率指标对比Tab.3 Comparison of False Alarm (%) 表4 AUC值对比Tab.4 Comparison of AUC 表5 运行时间对比Tab.5 Comparison of time (ms) 从表4,表5的结果可以看出,反映综合检测效果的AUC值证明了所提算法在保持一定的运算速度的前提下,总体性能上具有一定的优越性。 卫星视频相较于传统的监控视频一个较大的不同则是拍摄过程中会伴随卫星角度的细微变化。而这种变化有时是可控的有时则是随机出现的。为了验证在该类场景下的对比结果,选取了美国圣保罗拍摄的具有微小角度变化的卫星影像。结果如图10所示。 图10 美国圣保罗卫星影像效果对比图Fig.10 Results comparison of Muharag satellite video in St.Paul,USA 美国圣保罗拍摄的卫星影像有明显的拍摄角度变化,对于人眼而言可能只是小小的图片整体偏移,但是对运动目标的检测会产生很大干扰。从图10可以看出,各种对比算法在这种恶劣图像环境下均无法获得较好的结果产生了大量误检。而所提算法虽然有少量误检但是整体而言具有较好的抵抗卫星拍摄角度变化的能力。由于其他算法在该环境下的结果较差难以统计,这里只列出所提算法的客观指标,计算方法同上:Precision=87.4%;Recall=88.6%;False Alarm=12.6%。 对于不同图像环境中的结果对比后,可以看出所提算法在稳定图像环境下的三种客观指标不仅稳定地获得较好的指标,对卫星拍摄角度发生变化的恶劣图像环境也表现良好,在算法的鲁棒性和适用性上有一定的优势。 卫星视频成像稳定且目标尺度小,将该方法应用到某些图像环境类似的检测任务,也能取得不错的效果,比较典型的是监控摄像头中的微小运动目标。这些目标由于尺度较小、特征缺失,很难直接用深度学习等方法完成检测分类。本文所提算法主要有其他两种应用方向: (1)对于某些目标尺度过低或者只需要完成目标位置的获取而忽略分类的情况下,可以通过该方法获得特定目标的二值分割图,确定目标的轮廓和位置。 (2)结合深度学习检测网络提升对小目标的检测性能,通过实验发现图像输入的尺寸对小目标在高分辨率图像中的检测影响很大,对于分辨率较大的图像,检测器也常常会忽略小目标。可以通过本文算法的输出结果提取可能存在目标的感兴趣区域,将该区域裁剪代替整图输入,完成对局部小目标检测的强化。 其他场景的部分实验结果如图11所示。 图11 其他场景下的部分实验结果Fig.11 Some of the experimental results in other scenarios 从实验结果可以看出,本文算法在某些类似场景下也能提取到运动的微小目标,具有一定的应用价值。 针对卫星图像的特点,提出了一种结合多种图像先验信息的卫星视频微小运动车辆检测方法。该算法在分辨率较低、含有如光照、拍摄角度变化、运动目标纹理特征缺失等特点的卫星视频上具有很强的场境适用性。并可以发散到图像环境类似的远距离监控视频、图像环境恶劣的模糊图像中。与近年来的许多优秀算法对比,所提出的算法能够在检测准确率和召回率达到85%的情况下保持低于10%的虚警率,稳定地获得0.97以上的AUC指标,同时对含有角度变化的卫星视频也有一定的抗干扰能力。但是本文算法由于定义了运动热图,需要相对较为稳定的成像环境,对于无人机、或者剧烈运动的成像系统无法获得置信度高的运动约束,可能会造成大片运动滞后造成的“鬼影”。同时,多种约束在较好地减少误检的同时也可能滤除某些响应较弱的目标,下一步还需要在运动补偿稳像以及约束阈值的自适应上进行深入研究。

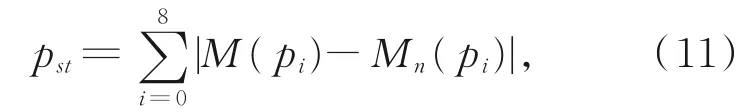

2.5 联合预测

2.6 算法流程

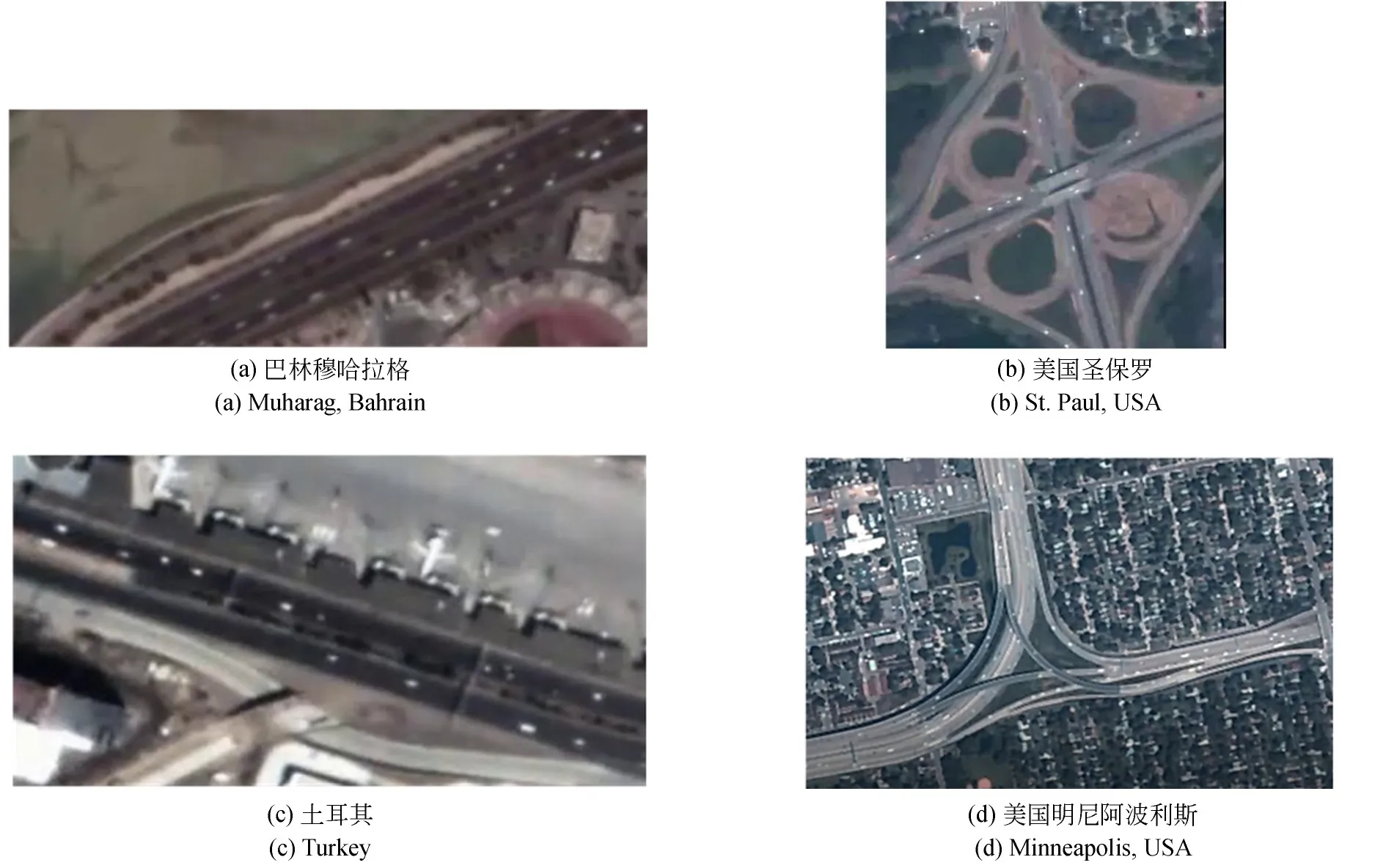

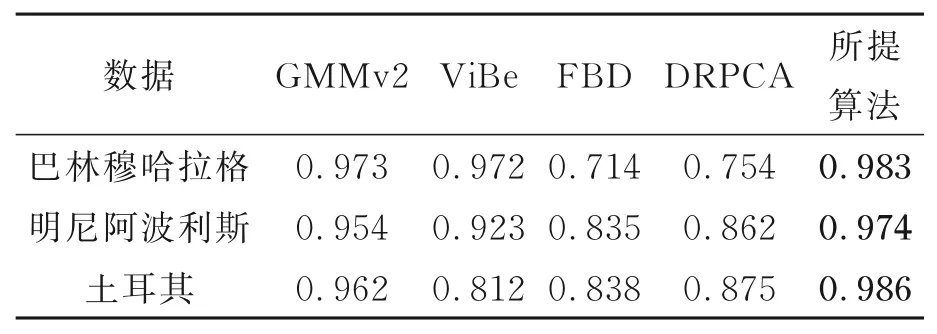

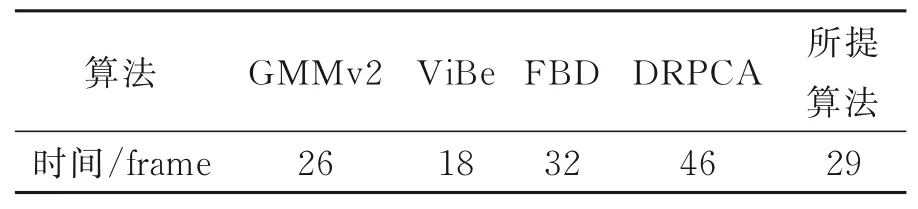

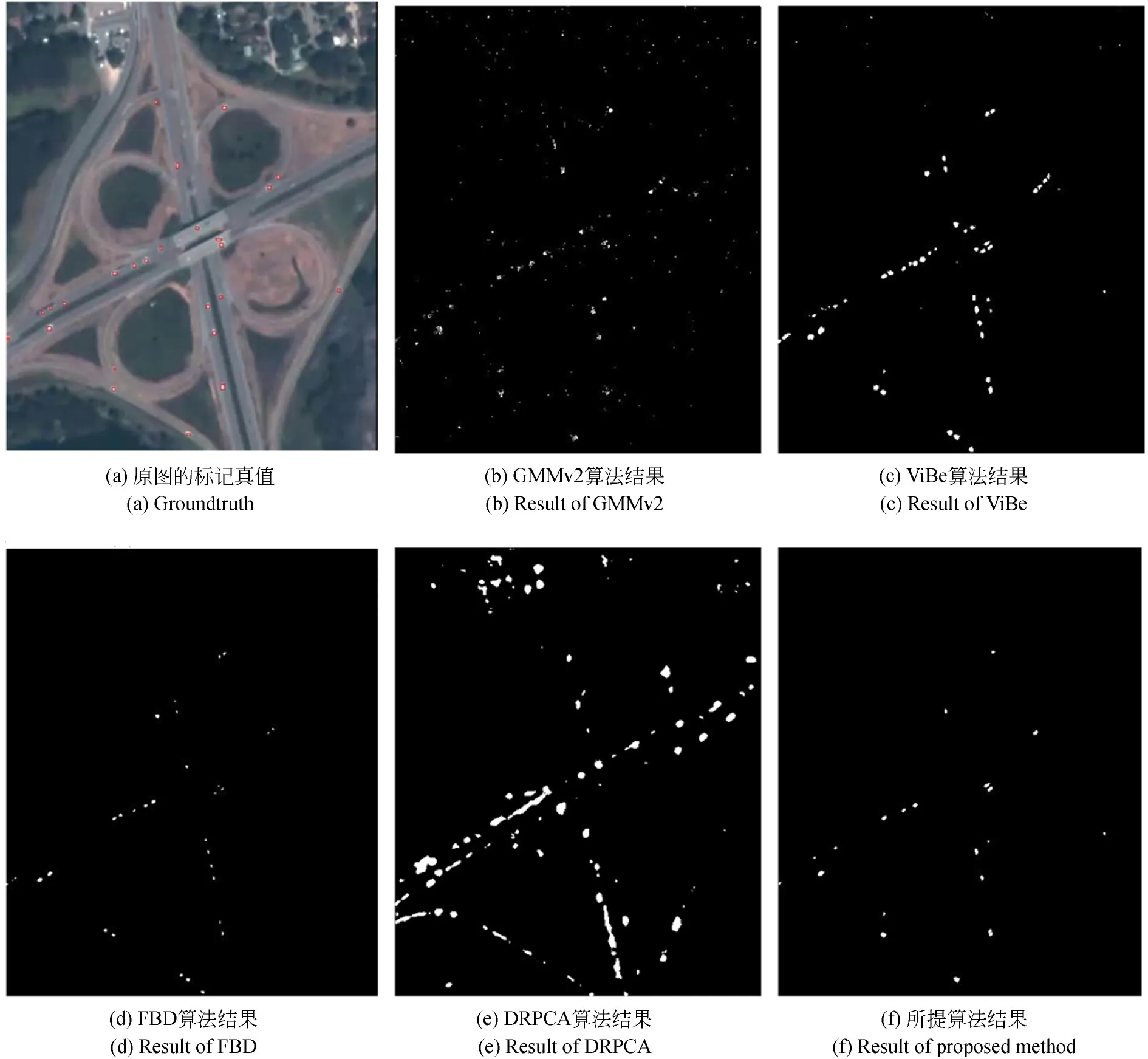

3 实验结果

4 其他场景的应用

5 结 论