基于注意力机制与特征融合的图像超分辨率重建

2021-03-18王诗言吴华东

王诗言,曾 茜,周 田,吴华东

(重庆邮电大学通信与信息工程学院,重庆 400065)

0 概述

图像处理技术快速发展,而人们对图像质量的要求也逐渐提高,如何获取高质量的图像成为迫切需要解决的问题。单幅图像超分辨率重建(Single Image Super-Resolution,SISR)指由低分辨率(Low-Resolution,LR)图像恢复出高分辨率(High-Resolution,HR)图像,该技术目前已被广泛应用于计算机视觉、医学成像、卫星图像和视频安全监控等多个领域。

目前,图像超分辨率重建方法主要有基于插值、基于重建和基于学习[1-2]三类。DONG 等人提出端到端卷积神经网络SRCNN 来学习LR 和HR 图像之间的映射关系[3]。SRCNN 体现了卷积神经网络(Convolutional Neural Network,CNN)在特征提取和表示方面的优越性,该网络结构可被看作是传统稀疏编码方法的扩展。此后,DONG 等人又提出了快速超分辨率卷积神经网络FSRCNN[4],通过在网络末端使用反卷积层,有效地获取了原始图像中的高频信息。随着卷积神经网络深度的不断增加,网络训练的难度也越来越大。针对这一问题,HE 等人提出了残差神经网络(Residual Neural Network,ResNet)[5],通过引入残差学习的思想加速网络的收敛。在此基础上,KIM 等人提出了深度卷积网络VDSR[6]。通过对残差学习的利用,该网络使用了20个卷积层,有效增加了网络深度。为减少网络参数数量,KIM 等人进一步提出了深度递归卷积网络(Deeply-Recursive Convolutional Network,DRCN)[7],通过使用递归结构,引入递归监督和跳跃连接。为解决实时超分辨率重建问题,SHI 等人提出一种高效的亚像素卷积神经网络(Efficient Sub-Pixel Convolutional Neural Network,ESPCN)[8],利用亚像素卷积的上采样方式实时恢复HR 图像。LEE 等人提出了增强深度残差网络(Enhanced Deep Residual Network,EDSR)[9],删除了批规范化(Batch Normalization,BN)操作,并大规模增加了每一层的输出特性。通过设计有效的网络结构,卷积神经网络在图像超分辨率重建中取得了优于传统方法的效果。

图像非局部特性在传统方法中得到了广泛使用[10-11],然而多数基于CNN 的超分辨率重建方法并没有充分利用图像固有的这一特征,并且集中于设计更深或更广的网络来学习更多的图像特征,较少利用高阶的特征统计量,而文献[12]表明,图像的高阶特征比一阶特征更具表征力。此外,多数基于CNN 的超分辨率重建方法只在单一尺度下提取图像特征,忽略了不同尺度下的图像细节信息。

针对上述问题,本文设计一种基于注意力机制和多尺度特征融合的网络结构。利用浅层特征提取模块提取图像原始特征,在注意力机制和多尺度特征融合模块中,通过注意力机制对图像的非局部特性和二阶统计特征进行融合,利用多尺度特征提取模块获取不同尺度下的图像特征信息。在此基础上,将提取到的深度特征通过重建模块实现图像重建。

1 相关工作

1.1 非局部先验

图像的非局部特征在传统图像重建领域中得到了广泛使用,其基本原理是在整幅图像中搜索相似的图像块,进而利用这些相似图像块所提供的互补信息来进行图像重建。BUADES 等人提出一种基于图像中所有像素的非局部平均操作来提高图像去噪能力的方法[10],对于某一个图像块,在整幅图像范围内搜索与之相似的图像块,然后根据图像块之间的相似性对不同的图像块赋予不同的权值,加权平均后得到去噪图像块,即图像非局部去噪方法。非局部思想是一种经典的计算机视觉方法,其在神经网络中具有广阔的应用前景。WANG 等人提出的非局部神经网络(Non-Local Neural Networks,NLNN)[13]可以很好地捕捉到较远位置像素点之间的依赖关系,由此将非局部操作融入到用于视频分类的非局部卷积神经网络中。

1.2 注意力机制

近年来,注意力机制被广泛应用于深度神经网络。上文提到的的NLNN,也是注意力机制的一种应用。HU 等人提出SENet[14]来学习信道间的相关性,通过网络的全局损失函数自适应地重新矫正通道之间的特征相应强度,该网络结构在图像分类方面较传统方法取得了显著的性能改进。WOO等人设计的提卷积块注意模块(Convolutional Block Attention Module,CBAM)[15]结合了空间和通道的注意力机制,相比于SENet 只关注通道的注意力机制可以取得更好的效果。ZHANG 等人将注意力机制引入超分辨率重建任务中[16],通过注意力机制来区别对待不同的通道,从而提高网络的表征能力。然而,这些网络只关注了图像的一阶特征(如全局平均池化),忽略了图像的高阶信息特征。DAI 等人证明二阶统计量能够更好地捕捉图像特征[17],并设计一个二阶注意力网络(Second-Order Attention Network,SAN),通过考虑比一阶更高的特征统计量来自适应地利用信道特征。

2 融合注意力机制与多尺度特征的网络结构

如图1 所示,本文设计的网络结构包含浅层特征提取(Shallow Feature extraction,SF)、深度特征提取(Deep Feature extraction,DF)和重建(Reconstruction,RE)3 个模块。

图1 本文设计的网络结构Fig.1 The network structure designed in this paper

2.1 浅层特征提取模块

令ILR表示输入图像,IHR表示输出图像。首先通过一个3×3 的卷积核来提取浅层特征FSF:

其中,HSF(·)表示卷积操作,WSF表示滤波器权重项,BSF为偏置项,f表示激活函数。本文采用ReLU 作为激活函数,其数学表达式为:

2.2 深度特征提取模块

在深度特征提取模块,提取到的浅层特征FSF经过注意力机制与多尺度特征融合模块(AMMS)进行深度特征提取:

其中,HAMMS(·) 表示AMMS 模块操作。对于AMMS模块,由图1 可见,其由两个多尺度特征融合模块(MSFF)和一个LS_AM 模块构成。下文将对这两个模块分别进行介绍。

2.2.1 MSFF 模块

在图像超分辨率重建中,需要在不同的特征尺度上进行特征信息提取。然而目前多数算法都只使用单一的卷积核进行特征提取。但实际上,图像的特征信息通常是不同尺度的,单一的卷积核只能提取单一的尺度特征,这样就会导致丢失多尺度下完整的特征信息。受GoogleNet 结构的启发,本文通过一个多尺度特征融合模块(MSFF)来提取不同尺度的信息特征,以更好地获取图像的结构信息。如图2所示,MSFF 模块主要由多尺度特征提取层、特征融合层和降维层3 个部分组成。

图2 多尺度特征融合模块结构Fig.2 Structure of multi-scale feature fusion module

对于多尺度特征提取层,采用3 个尺度的卷积核,分别为1×1、3×3、5×5。其中,1×1 的卷积核能够保留上一层的特征并与其他尺度的特征融合,使得网络包含与浅层特征相关的信息特征。在每个卷积核后采用一个非线性层提高模块的非线性映射能力。用F0表示多尺度特征融合模块中的输入特征,则经过该多尺度特征提取后的特征表示为:

其中,W1i和B1i分别表示第i个卷积核的权重和偏置项,*表示卷积操作,σ1i表示ReLU 非线性操作,数学表达式同式(2)。

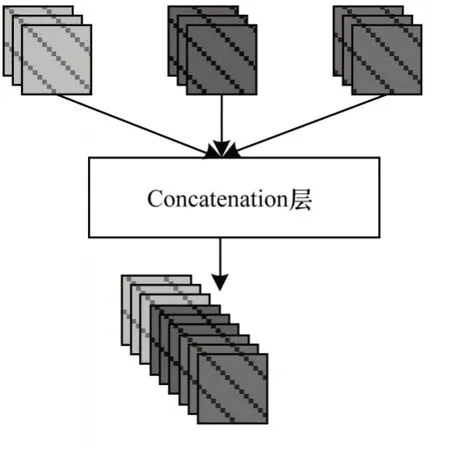

在提取到多尺度特征之后,需要对其进行特征融合。此处采用Concatenation 层将各个尺度下的特征图进行叠加,如图3 所示。

图3 Concatenation 层融合原理Fig.3 Fusion principle of Concatenation layer

假设上述多尺度特征提取层包含m个卷积层,则该多尺度特征融合层表示为:

降维层的主要作用是降低Concatenation 层的维度,其包含一个1×1 的卷积核。1×1 的卷积核可保持Concatenation 层的所有特征信息,同时由于其通道数较少,因此卷积得到的多尺度特征图也会减少。多尺度特征融合模块的数学表达式如下:

其中,W2和B2分别表示降维层中卷积核的权重和偏置项。

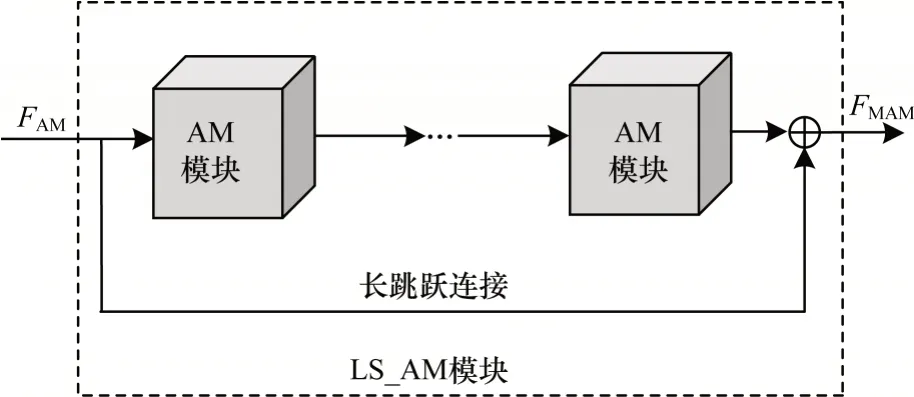

2.2.2 LS_AM 模块

LS_AM 模块结构如图4 所示,其由M个注意力机制模块(AM)和长跳跃连接(Long Skip Connection,LSC)构成。

图4 LS_AM 模块结构Fig.4 Structure of LS_AM module

分别用FAM和FMAM表示LS_AM 模块的输入和输出特征:

其中,HLS_AM()表示基于M个AM 模块和长跳跃连接的LS_AM 模块操作,HM_AM()表示M个AM 模块操作,WLSC()表示长跳跃连接操作。LSC 不仅能够稳定网络训练,而且其通过传递低频图像也丰富了低频信息特征。

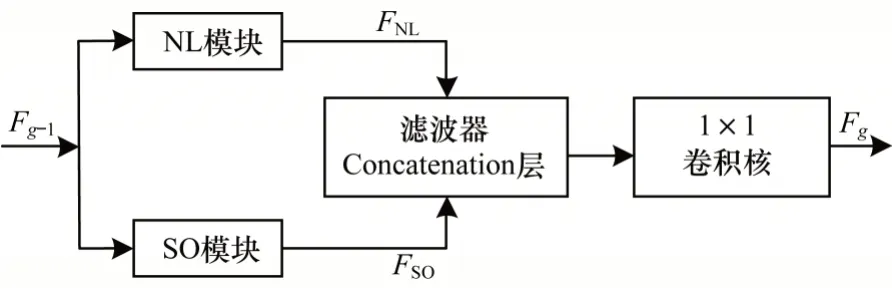

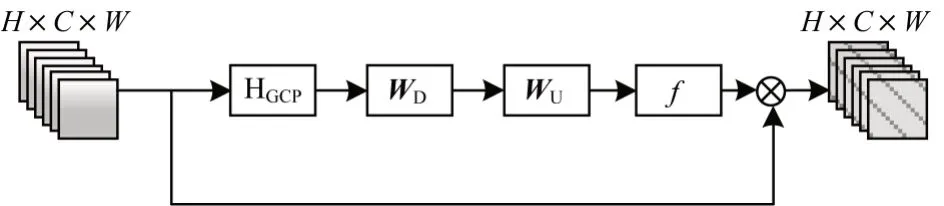

注意力机制模块结构如图5 所示,其通过两种方式提取图像特征,即非局部提取(NL)和二阶特征提取(SO),最后将提取到的特征进行融合,作为每一个注意力单元模块的输出。

图5 注意力机制模块结构Fig.5 Structure of diagram of attention mechanism module

以Fg-1和Fg分别表示第M个注意力模块中的输入和输出特征图。非局部和二阶特征提取操作是同步进行的,对于非局部特征提取分支,有:

其中,HConv_NL(·)表示非局部特征提取操作,FNL表示经过该操作得到的特征图。对于二阶特征提取分支,有:

其中,HConv_SO(·) 表示二阶特征提取操作,FSO表示经过该操作得到的特征图。

为充分利用非局部和二阶特征信息,采用Concatenation 层进行特征融合(其原理同2.2.1 节),则非局部和二阶特征融合表示为:

其中,Hff()· 表示Concatenation 操作。此外,一个1×1的卷积层被用于Concatenation 层的后面,这种卷积操作有利于减少特征图的参数量,以此减少计算损失。

通过注意力机制模块得到的特征Fg可以表示为:

其中,HAM(·)表示基于非局部及二阶特征融合的注意力模块操作。通过特征融合操作,非局部和二阶特征提取是同步执行的,因此,可以有效地利用图像的固有属性特征提高网络的性能。

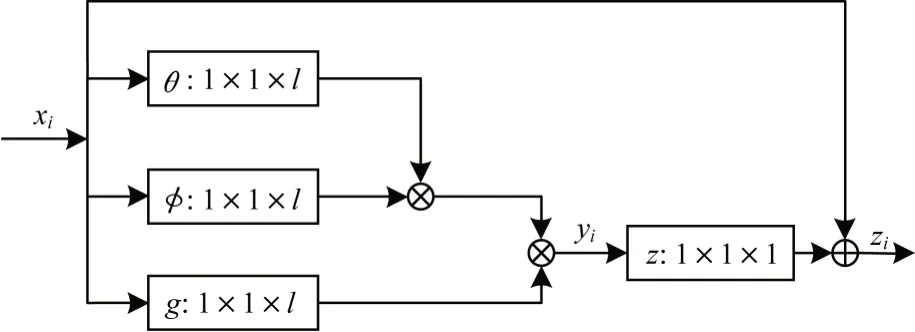

1)非局部操作

图像的非局部特性作为先验信息,可以提供自然图像中丰富的结构信息。本文利用图像的自相似性,将非局部操作合并到CNN 中计算整个图像的特征相关性。非局部操作过程如图6 所示。

图6 非局部操作过程Fig.6 Process of non-local operation

深度神经网络中的非局部操作可以表示为:

其中,x表示输入图像,y表示同x大小一样的输出图像,i代表输出特征位置索引,j代表全图中所有可能位置的枚举索引,函数f(xi,xj)用来计算xi和xj的相关性,函数g(xj)是对特征xi的变换函数,用来计算输入图像在位置j的表示。文献[11]中详细讨论了f和g的几种形式,此处考虑g(xj)为线性的情况,即:

其中,wg是一个可学习的权重矩阵。本文考虑f为embedded Gaussian,即:

其中,Wθ、Wφ表示可学习的权重项。非局部模块计算公式为:

其中,Wz表示可学习得到的参数矩阵,+xi表示残差连接,yi表示非局部算子。该非局部操作可以看作是一个残差模块,其能够在不影响原始网络结构的基础上,方便地嵌入到网络框架中,与网络一起训练。因此,整个非局部操作与网络一起通过反向传播进行参数更新,不会对反向传播训练产生影响。

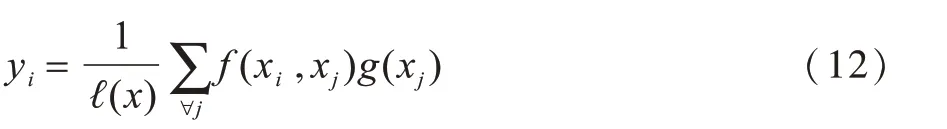

2)二阶特征提取

文献[12]表明,高阶特征比传统的一阶特征包含更多的统计特征,而传统的卷积和全局平均池化操作只能提取图像的一阶特征。因此,受文献[15]的启发,本文通过全局协方差池化(Global Covariance Pooling,GCP)操作来提取图像的二阶统计特征,如图7 所示。

图7 二阶特征提取操作过程Fig.7 Process of second-order feature extraction operation

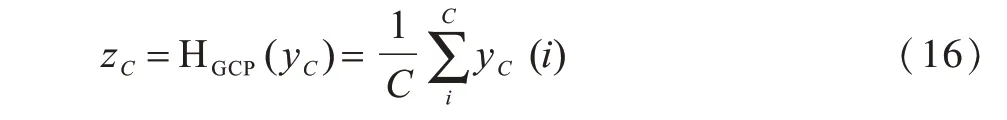

首先通过GCP 滤波器来提取二阶统计特征,则第C维的特征统计量为:

其中,HGCP(·) 表示全局协方差池化操作,yC表示输入特征,yC(i) 表示在位置i处的输入特征。为充分利用特征间的相关性,借鉴文献[14]方法,本文使用门函数来更好地提取特征:

其中,WU和WD是可学习得到的权重矩阵。此处WU、WD被分别设置为=4、C=64,f(·)、δ(·) 分别为Sigmoid 和ReLU 函数。利用Sigmoid 函数将其缩放到0 到1 之间,对特征图进行重新校准,将校准后的特征图与原来每个通道的特征图的值对应相乘。最后,得到的信道特征表示为:

其中,sC和xC分别表示尺度因子和第C维的信道特征。

2.3 重建模块

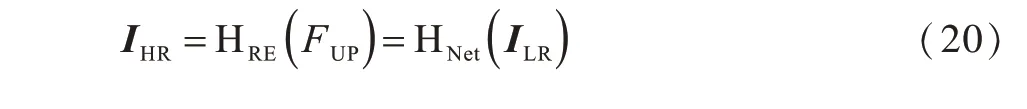

在重建模块,得到的深度特征首先经过上采样模块,如式(19)所示:

其中,HUP(·) 表示上采样操作。对于上采样操作的选择,有基于插值、基于反卷积、基于亚像素卷积等操作,但是用以上方法训练网络需要固定缩放因子,即一个放大因子对应训练一个模型。HU 等人提出的Meta-SR 模型[18],通过输入一系列与缩放因子及坐标相关的向量,可动态地预测不同数量的卷积滤波器权重,其根据缩放因子和坐标偏移量因子求出相应的映射参数,通过卷积便可获得最终的超分辨率图像。因此,本文使用该模型中的Meta-Upscale模块替代传统上采样操作,利用单一模型将特征图放大任意缩放因子。

将得到的上采样特征FUP经过一个卷积层进行重建,得到最后的超分辨率重建图像:其中,HRE(·)表示重建操作,其通过卷积便可获得最终的超分辨率图像,HNet(·)表示本文设计的网络结构。

2.4 损失函数

本文采用均方误差(Mean Square Error,MSE)作为损失函数,则网络优化目标表示为:

其中,Θ表示网络中所有的参数表示通过本文网络结构得到的高分辨率图像分别表示第i对重建图像和原始的高分辨率图像。

3 实验结果与分析

3.1 数据集

本文采用Timofte 数据集[19]中的91 幅图像以及BSD 数据集中的BSD200[19]作为训练集。在Set5[20]、Set14[21]和BSD100[19]标准数据集上进行测试,这三个数据集通常用于图像超分辨率重建。其中:Set5 数据集包含动植物图像;Set14 包含动植物和景物图像,比Set5 具有更多的细节信息;BSD100 数据集包含城市建筑图像,其边缘信息多,重构难度也较大。为与其他重建方法进行比较,本文采用PSNR和SSIM 指标来评价重建质量。沿用现有的方法,只对YCbCr 颜色空间中的亮度通道(Y 通道)进行超分辨重建,为便于显示,另外两个色度通道使用与其他方法相类似的双三次插值算法。

3.2 训练细节

本文通过最小化损失函数训练网络,以ADAM optimizer[22]作为优化方法,其中,β1=0.9,β2=0.99,ε=10-8。初始学习率设为10-4,然后每迭代2×105次,学习率减少一半。本文提出的网络模型是在NVIDIA GTX 1080 GPU 上使用Tensorflow 框架实现的。对于非局部和二阶特征操作,选取1×1 的卷积核进行卷积操作,同时用零填充特征图的边界,以保持特征图的大小。对于上述操作以外的卷积核,设定其大小为3×3,滤波器个数C=64。设置注意力机制模块的个数M=20。

3.3 网络结构

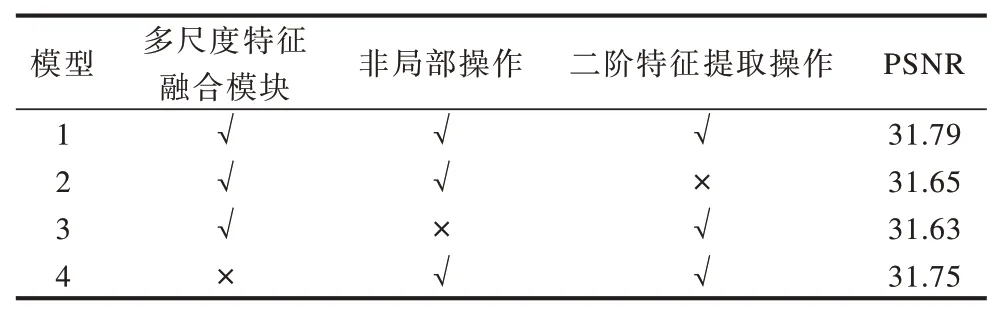

为研究注意力机制(包含非局部及二阶特征提取操作)以及多尺度特征融合模块对网络结构的影响,本文引入消融学习的思想,以尺度因子factor=4为例,在Set5 数据集上比较以上模块对PSNR 平均值的影响。由表1 可以看出,同时使用注意力机制以及多尺度特征融合的模型PSNR 值最高。

表1 Set5 上不同模块构成模型的PSNR 平均值Table 1 Average PSNR for the models with different module compositions on Set5dB

3.4 实验比较

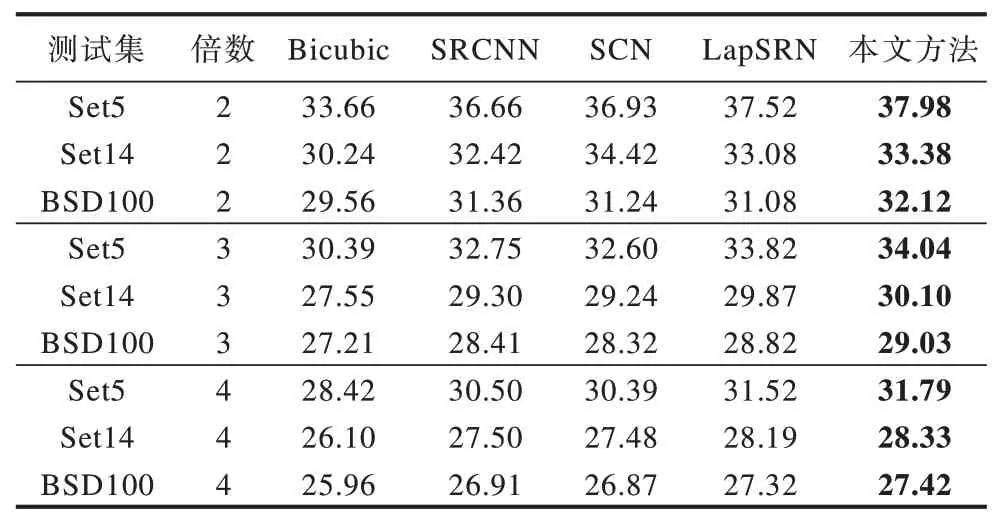

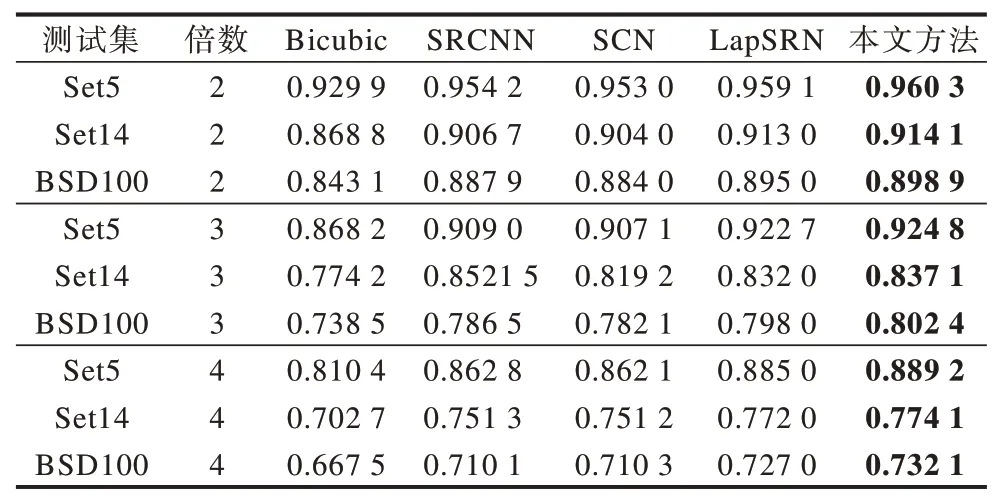

将本文提出的网络结构与Bicubic、SRCNN[3]、SCN[23]、LapSRN[24]4 种图像超分辨率重建方法进行比较。SRCNN 模型具有三层卷积结构,其将一个低分辨率图像通过双三次插值放大到目标大小作为网络输入。SCN 模型在SRCNN 三层结构的基础上结合了传统的稀疏编码思想,该模型具有五层卷积结构。LapSRN 模型在网络中融入了拉普拉斯金字塔模型的思想,该模型具有24层网络结构。Bicubic方法使用Matlab interp2函数实现,其他对比方法的实现均来自作者的公开源代码。表2 给出了Set5、Set14、BSD100 测试集上不同方法的PSNR 平均值。表3 给出了Set5、Set14、BSD100测试集上不同方法的SSIM 平均值,其中加粗数据为PSNR、SSIM 值最好的结果。

表2 Set5、Set14 和BSD100 上不同方法的PSNR 平均值Table 2 Average PSNR for different methods on Set5,Set14 and BSD100dB

表3 Set5、Set14 和BSD100 上不同方法的SSIM 平均值Table 3 Average SSIM for different algorithms on Set5,Set14 and BSD100

由表2 和表3 可以看出:当放大因子为2 时,本文方法在每个测试数据集上PSNR 和SSIM 的平均值都高于其他方法;当因子分别为3 或4 时,可以得到相同的结果,这说明本文方法设计的网络结构性能相较于其他方法有显著提升。

从Set5、Set14和BSD100这三个测试集中选择3张图片进行测试。将图像特定的区域进行放大,以更好地观察纹理细节的重建效果。图8~图10 展示了本文方法和其他4 种方法分别在尺度因子为2、3、4 情况下的重建效果。从主观视觉效果上来看,与其他4 种方法相比,通过本文方法重建的图像恢复了更多的高频细节并具有更清晰的边缘。因此,综合主观效果和客观指标两个方面可知,本文方法相对于主流超分辨率重建方法能够得到更好的重建效果。

图8 尺度因子为2 时不同方法的视觉重建效果Fig.8 Visual reconstruction quality of different methods when the scale factor is 2

图9 尺度因子为3 时不同方法的视觉重建效果Fig.9 Visual reconstruction quality of different methods when the scale factor is 3

图10 尺度因子为4 时不同方法的视觉重建效果Fig.10 Visual reconstruction quality of different methods when the scale factor is 4

4 结束语

本文结合注意力机制和多尺度特征,设计一个卷积神经网络用于图像超分辨率重建。通过注意力机制模块融合图像的非局部信息和二阶特征,对图像的固有属性特征进行探索并自适应地学习其他特征,使该网络更注重信息特征,并且具有更强的识别学习能力。同时,利用不同尺度的卷积核提取图像的特征,并对提取到的多尺度特征进行融合,从而保存多尺度完整的信息特征。实验结果表明,通过该方法重建的图像质量在视觉效果和定量指标方面较Bicubic、SRCNN、SCN和LapSRN 方法均有较大提升。后续将研究更深层次的网络结构,进一步优化图像重建效果。