基于通道权重融合特征的目标跟踪算法①

2021-01-21周盛宗

郭 利,周盛宗

1(福建师范大学 数学与信息学院,福州 350117)

2(中国科学院 福建物质结构研究所,福州 350002)

近年来,目标跟踪在视频监控、运动分析、人机交互、自动驾驶及交通安防等领域获得了长足发展.但大多数目标跟踪算法不但在面对光照变化、运动模糊、快速运动、背景混乱、遮挡等复杂环境下跟踪失败,而且在目标变形、旋转、姿势变化等剧烈变化时也表现欠佳.因此,有必要继续探索健壮的目标跟踪算法.

以往研究表明,有效的特征一般能较好的表示跟踪目标并快速运算,代表性的有颜色特征[1]、纹理特征[2]、灰度特征[3]、超像素特征[4]、Lab 特征[5]等.得益于特征引入频域,将矩阵乘法运算转化为点乘运算,基于相关滤波的目标跟踪算法获得了长足发展.譬如:基于单通道灰度特征的MOSSE[6]和CSK[7]、基于11 通道颜色特征的CN[8]、基于31 通道HOG 特征的KCF[9]、基于42 通道特征(31 维HOG 特征、10 维颜色特征、1 维灰度特征)的SAMF[10]、基于HOG 特征和颜色特征的Staple[11]、基于HOG 特征和Lab 特征的SACFT[12]等.这些算法一般将不同特征简单叠加或以固定比例组合,未考虑实时特征组合对目标跟踪的影响.针对该问题,赵高鹏等[13]基于峰值旁瓣比融合灰度特征和LBP 特征,陈法领等[14]基于峰值旁瓣比和相邻帧间的响应一致性融合纹理特征和颜色特征,尹宽等[15]基于融合特征器的可信度选择合适线性组合方式,常敏等[16]基于平均峰值-相关能量方法融合不同特征.与几位学者从特征类别层面融合特征的做法不同,本文算法从特征通道层面融合特征,该算法通过各通道对响应值的贡献度调整权重,构建实时特征组合,进而控制特征融合,从而提升跟踪效果.

本文算法的亮点主要表现在以下几个方面:(1)引入通道权重矩阵,不破坏循环矩阵性质,不影响闭合求解;(2)先对特征矩阵和权重矩阵点乘,不影响框架将矩阵乘运算转化到傅里叶域下求点乘;(3)基于各通道响应值构建权重更新策略,及时捕捉目标运动状态,灵活构建特征组合.

相关实验结果表明:通道权重在特征融合过程中,发挥着很大的作用;本文提出的特征融合算法在跟踪目标时能有效提升精确度和成功率.

1 基于通道权重融合特征的目标跟踪算法

为了能够使用多维度特征,Galoogahi 等[17]提出多通道相关滤波算法.该算法设定:

式中,N是样本数目,D是循环移位的位数,yi(j)是期望相关响应的第j个元素,K是特征通道数目,h(k)是第k通道的过滤器,是[第i]帧第k通道的向量化,Δτj表示循环位移操作,是对做j步的循环位移,λ是规范化系数.

在跟踪过程中,各个通道对响应值的贡献度不同,而该算法将各通道等同看待.因此,提出基于通道融合特征的目标跟踪算法.该算法的目标函数如下:

式中,N、D、yi(j)、K、、h(k)、、Δ τj、λ 同式(1)中变量意义相同,是对做j步的循环位移.

1.1 引入特征权重

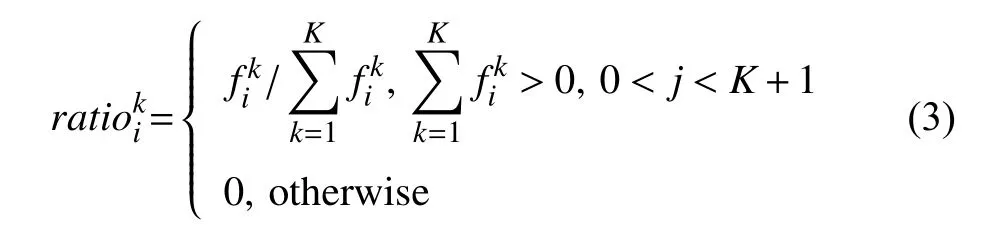

与式(1)相比,式(2)中添加了.该项通过各通道响应值占比(见式(3))构建,与相乘实现自适应特征组合,一定程度上发挥着特征权重的作用.具体实现如下:

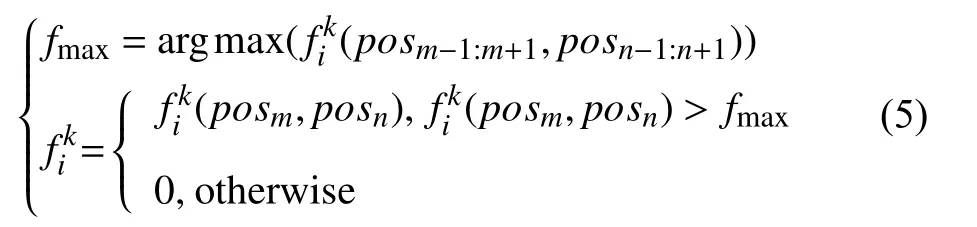

1.2 引入区域评估机制

为保证的准确性,对式(3)中的引入区域评估机制.该机制基于一个前提和一个区域特性.该前提设定如下:

式中,(posm,posn)是最佳坐标位置,M是搜索区域的宽度,N是搜索区域的高度,(m,n)是第i帧第k通道(m,n)处的响应值.

1.3 引入滑动窗口机制

为缓解这一问题,引入滑动窗口机制.该机制限定模型仅依据当前帧及其以前的部分帧,来更新通道权重.在减缓通道特征累加风险的同时,捕捉最近的模型变化,舍弃较久远的变化.该机制设定如下:

式中,是第I+1 帧第k通道的权重,是第k通道的初始值,ratiow是权重学习率,是第i帧第k通道的权重,n是参与权重更新的帧数目.

2 算法实现

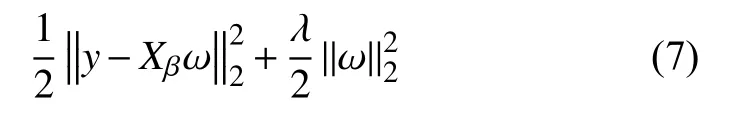

目标函数式(2)可以化简为:

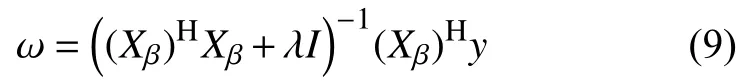

式中,y是回归目标yi的集合,Xβ是是的循环矩阵,ω是线性回归方程的投影矩阵.

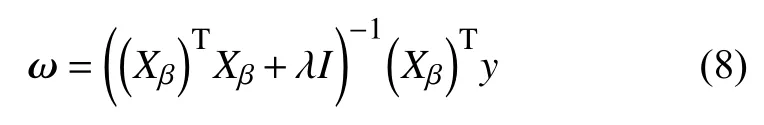

2.1 求解线性回归

求解式(7)得:

式中,X、Xβ、y同式(7)中对应变量意义相同,I是单位矩阵.

在复数空间的傅里叶域下:

式中,XH是X的复共轭转置,XH=(X∗)T.

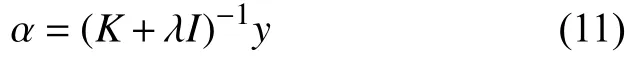

2.2 求解非线性回归

引入核机制[9],将线性问题的输入映射到非线性空间φ (x),则 ω可以表示为:

式中,α是对偶空间.

在傅里叶域下,有:

式中,帽 ∧表示对应的离散傅里叶变换.

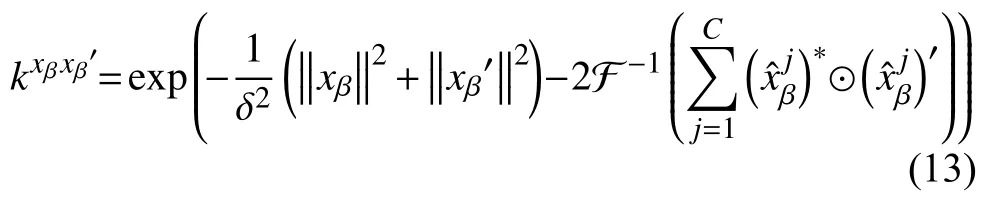

2.3 核函数选择

选择高斯核[9]:

选择线性核[9]:

式中,C表示特征通道数目.

2.4 检测阶段

选择高斯核[9]:

选择线性核[9]:

其中,z为样本的特征矩阵,zβ=z⊙β,表示对z的第j通道施加特征权重,C表示特征通道数目.

式中,f(z)表示样本特征z的响应值,F−1表示反傅里叶变换,帽 ∧表示对应的离散傅里叶变换.

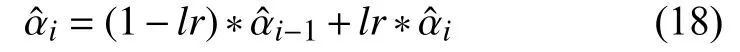

2.5 更新阶段

根据式(3)、式(5)、式(6)更新,并将代入式(12)得到,进一步更新模型:

2.6 算法流程

具体算法流程如算法1 所示.

算法1.本文算法Frame1 Frame2 FrameN y∈Rm×n cen0输入:视频序列,,…,,回归目标,初始帧的目标中心位置 .cencurframe输出:当前帧curframe 的目标中心位置 .For frame>0 1:N IF ① 在前一帧preframe 目标中心位置 的周围,划定检测区域并采集样本;Zhog∈Rm×n×31 Zcolor∈Rm×n×10 Zgrey∈Rm×n×1 Zcur=[Zhog,Zcolor,Zgrey]∈Rm×n×42 Zβ=Zcur⊙β Zβ ˆZβ cenpreframe② 对采集到的样本提取纹理特征、颜色特征和灰度特征,对特征执行 操作,再对 做FFT,得到频域特征;f(z)f(z)③ 使用高斯核时,利用式(13)、式(15)、式(17)求响应值;使用线性核时,利用式(14)、式(16)、式(17)求响应值;cencurframe=argmax④ End⑤ 利用式(3)、式(5)、式(6)更新通道权重;⑥ 使用高斯核时,利用式(15)、式(12)、式(18)更新外观模型;使用线性核时,利用式(16)、式(12)、式(18)更新外观模型;End(posm,posn)(f(z))

3 实验结果与分析

3.1 实验数据

实验选取了公开数据集OTB-2015[18]的100 组视频序列,围绕光照变化(Illumination Variation,IV)、尺度变化(Scale Variation,SV)、遮挡(Occlusion,OCC)、变形(Deformation,DEF)、运动模糊(Motion Blur,MB)、快速运动(Fast Motion,FM)、平面内旋转(In-Plane Rotation,IPR)、平面外旋转(Out-of-Plane Rotation,OPR)、超出视野范围(Out-of-View,OV)、背景杂乱(Background Clutters,BC)、低分辨率(Low Resolution,LR)等11 种挑战情况进行展开.

3.2 评价指标

本文主要用到3 个评价指标,分别是精确度(precision)、成功率(success rate)和跟踪速度(speed).精确度是在跟踪序列中准确跟踪到的帧所占的比重,这些帧的目标中心与真实位置的距离小于某个阈值,该指标越大越好;成功率是在跟踪序列中准确跟踪到的帧所占的比重,这些帧的跟踪框与真实框的重叠率大于某个阈值,该指标越大越好;跟踪速度是每秒跟踪的帧数,一般采用帧/秒(fps)表示.

(1)精确度

精确度求解如下:

式中,pre(j)是阈值取ε (j) 时的精确度.1 {bool}在bool等于true 时为1,bool等于false 时为0.表示第i帧的目标中心位置与其真实位置的欧式距离.表示所有欧式距离小于ε (j) 的帧数,frames表示某视频序列的帧数.

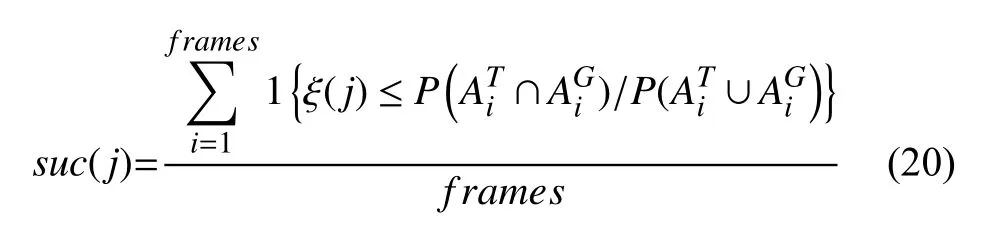

(2)成功率

成功率求解如下:

式中,suc(j) 是阈值取ξ (j) 时的精确度,1 {bool}在bool等于true 时为1,bool等 于false 时为0,表示第i帧的目标框,表示第i帧的真实目标框,∩表示交集,∪表示并集,P(B)为B框内的像素个数,表示像素比大于ε (j) 的帧数,frames表示某视频序列的帧数.

3.3 实验环境及参数设置

实验电脑的处理器是Intel(R) Core(TM) i7-7500U CPU(2.9 GHZ),内存是8 GB,开发软件为Matlab R2014b.算法参数设置如下:高斯核的方差 δ为0.5,Hog 特征的细胞单元大小为4×4,Hog 特征的方向为9,Hog 特征31 通道,gray 特征1 通道,颜色特征10 通道,模型的学习率lr为0.01,第k通道的初始值=1,通道的权重学习率ratiow=0.22.

3.4 实验结果分析

(1)定量分析

为了定量评估本文算法(WSAMF)的有效性,我们对比了WSAMF、SAMF、KCF、CN 在OTB-2015[18]数据集的100 组视频序列的表现.我们做了两组实验,第一组实验取距离阈值0 ≤ε(j)≤50像素、重叠率阈值0 ≤ξ(j)≤1,第二组实验取距离阈值0 ≤ε(j)≤15像素、重叠率阈值0 .5 ≤ξ(j)≤1.

第一组实验用于评估算法的综合性能,第二组实验用于测试算法的有效性.因为在实际的目标跟踪过程中,目标中心位置与实际中心位置的距离超过15 像素,算法基本跟踪失败;目标框与真实框的重叠率小于0.5 时候,算法基本无效;所以,我们在第一组实验的基础上,做了第二组实验.

第一组实验:距离阈值 0 ≤ε(j)≤50像素、重叠率阈值0 ≤ξ(j)≤1.结果如图1所示.

图1(a)为算法执行一次的精度图,该图显示算法随着距离阈值 ε (j)从0 像素到50 像素的精确度变化.图1(b)为算法执行一次的成功率图,该图显示算法随着重叠率阈值 ξ (j)从0 到1 的成功率变化.通过图1可以看出,相比SAMF、KCF、CN,WSAMF 在精确度上分别提升0.78%、8.5%、27.3%,成功率则分别提升1.3%、21.5%,42.9%.

图1 4 种算法的跟踪情况

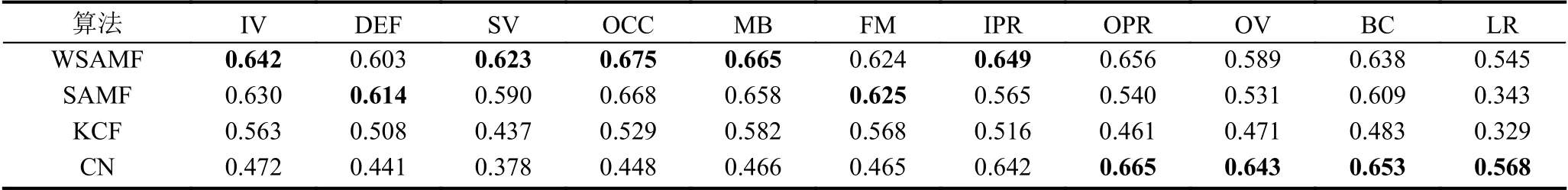

为了综合评估本文算法(WSAMF)的性能,在公开数据集OTB-2015 的100 个视频序列上,取距离阈值0 ≤ε(j)≤50 像素、重叠率阈值0 ≤ξ(j)≤1,对比WSAMF、SAMF、KCF、CN 在不同属性下精确度和成功率,WSAMF 都取得相对不错的跟踪效果,具体结果见表1、表2.

表1 4 种算法在11 种属性下的精确度

表2 4 种算法在11 种属性下的成功率

第二组实验:距离阈值 0 ≤ε(j)≤15像素、重叠率阈值0 .5 ≤ξ(j)≤1.结果如图2所示.

图2(a)为算法执行一次的精度图,该图显示算法随着距离阈值 ε(j)从0 像素到15 像素的精确度变化.图2(b)为算法执行一次的成功率图,该图显示算法随着重叠率阈值 ξ (j)从0.5 到1 的成功率变化.通过图2可见,相比SAMF、KCF、CN,WSAMF 在精确度上分别提升2.9%,27.6%,52.6%,成功率则分别提升5.6%,34.6%,63.8%.

为了测试本文算法(WSAMF)的有效性,在公开数据集OTB-2015 的100 个视频序列上,取距离阈值0 ≤ε(j)≤15像 素、重叠率阈值0 .5 ≤ξ(j)≤1,对比WSAMF、SAMF、KCF、CN 在不同属性下精确度和成功率,WSAMF 都取得不错的跟踪效果,具体结果见表3、表4.

图2 4 种算法的跟踪情况

表3 4 种算法在11 种属性下的精确度

表4 4 种算法在11 种属性下的成功率

通过以上两组实验可以看出,本文算法在综合性能、有效性上,都有一定提升.

(2)定性分析

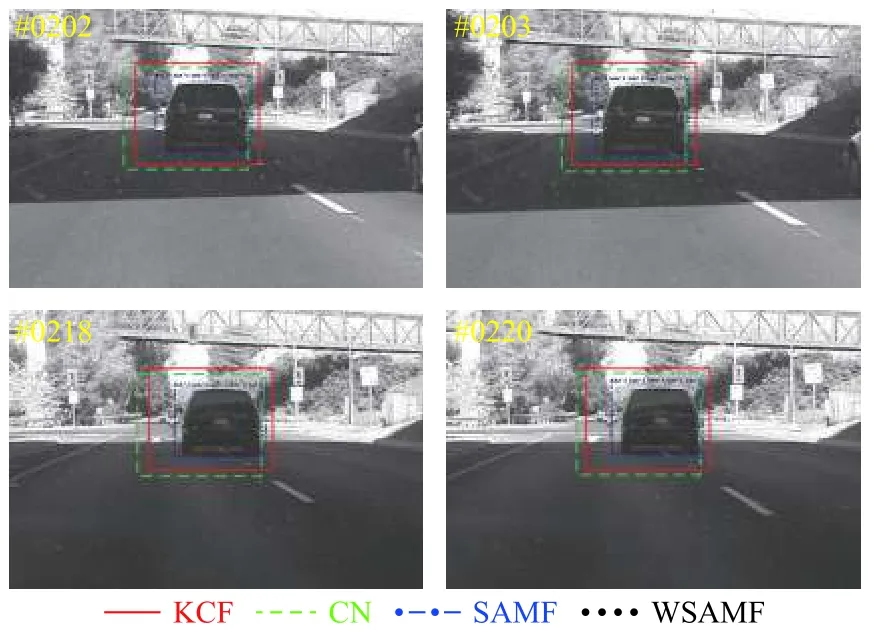

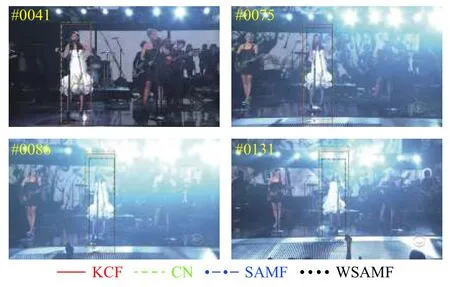

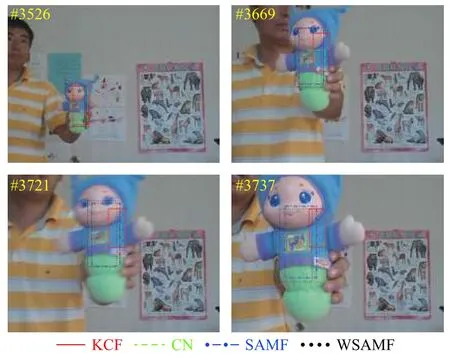

为了更加直观的评估算法性能,我们对KCF、CN、SAMF 和WSAMF 在basketball(DEF)、Jogging-2(OCC)、Car4(IV)、Singer1(IV)、boy(OPR)、doll(SV)和Walking2(SV、OCC)等7 个视频序列上进行了定性分析.为了区分4 种算法,我们选用不同的颜色跟踪框表示.其中,红色实线为KCF 算法,绿色虚横线框为CN 算法,蓝色点横线框为SAMF 算法,黑色虚点线框为WSAMF 算法.

图3中,目标在跟踪过程中发生了形变,KCF、CN 在第259 帧和第266 帧只定位目标局部,SAMF 在第271 帧和第547 帧则包含了相对多一点的背景信息,只有WSAMF 能够更好的跟踪这些目标.

图4中,目标在跟踪过程中发生了遮挡,KCF、CN 在第59 帧、第60 帧、第61 帧和第64 帧发生漂移,SAMF 则包含了相对多一点的背景信息,只有WSAMF能够更好的跟踪这些目标.

图5中,目标在跟踪过程中光照变暗,KCF、CN、SAMF 在第202 帧、第203 帧、第218 帧和第220 帧包含了相对多一点的背景信息,只有WSAMF 能够更好的跟踪这些目标.

图3 4 种算法在Basketball 序列上的跟踪情况对比

图4 4 种算法在Jogging-2 序列上的跟踪情况对比

图5 4 种算法在Car4 序列上的跟踪情况对比

图6中,目标在跟踪过程中光照增强,KCF、CN 在第41 帧、第75 帧、第86 帧和第131 帧包含了相对多一点的背景信息,SAMF 在第131 帧包含了相对多一点的背景信息,只有WSAMF 能够更好地跟踪这些目标.

图6 4 种算法在Singer1 序列上的跟踪情况对比

图7中,目标在跟踪过程中发生球面外旋转,KCF和CN 在第459 帧、第462 帧、第584 帧和第596 帧只跟踪到目标的一部分,而SAMF 则跟踪到多一点的背景信息,只有WSAMF 能够更好的跟踪这些目标.

图7 4 种算法在boy 序列上的跟踪情况对比

图8中,目标在跟踪过程中发生尺度变化,KCF、CN 在第3526 帧、第3669 帧、第3721 帧和第3737帧发生不同程度的漂移,SAMF 跟踪到少一点的目标信息,只有WSAMF 能够更好的跟踪这些目标.

图9中,目标在跟踪过程中发生遮挡、尺度变化,KCF、CN 在第375 帧、第487 帧和第489 帧发生不同程度的漂移,SAMF 在第206 帧、487 帧和489 帧跟踪到多一点的背景信息,只有WSAMF 能够更好的跟踪这些目标.

图8 4 种算法在doll 序列上的跟踪情况对比

图9 4 种算法在walking2 序列上的跟踪情况对比

(3)跟踪速度

为了直观的展示跟踪速度,在OTB-2015 数据集上任意选取basketball、Jogging-2、Car4、Singer1、boy、doll 和Walking2 等7 个视频序列上,对跟踪情况进行对比,具体情况见表5.

表5 4 种算法的跟踪速度(fps)

单从表中数据来看,4 种算法都达不到实时要求,这主要是受电脑硬件条件限制.在硬件条件获得一定提升后,WSAMF 应该可以满足实时性跟踪要求.

另外,需要补充说明的是,同一种算法在不同数据集下跟踪速度有一定差异,这主要是因为不同数据集的跟踪目标、搜索区域数据复杂度不同,导致计算量不同,进而导致跟踪速度有差异.

4 结语

本文算法根据各通道对响应值的贡献度调整权重,构建实时特征组合,进而控制特征融合.与现有的基于类别融合特征的算法不同,该算法从通道层面融合特征.实验表明该算法能够有效提升目标跟踪的精确度、成功率,整体性能优于对比算法.实验中发现,在目标趋近于完全遮挡的过程过慢时,由于算法未对目标中背景剔除,则容易出现不同程度的跟踪漂移甚至失败.因此,如何剔除目标中的背景信息或有效区分目标、背景,将是下一步研究的工作重点.