基于改进实例分割算法的智能猪只盘点系统设计

2020-12-25胡云鸽乔玉龙

胡云鸽,苍 岩,乔玉龙

基于改进实例分割算法的智能猪只盘点系统设计

胡云鸽1,2,苍 岩1※,乔玉龙1

(1. 哈尔滨工程大学信息与通信工程学院,哈尔滨 150001;2. 北京小龙潜行科技有限公司,北京 100086)

基于图像处理的动物资产计数方法,不仅可以减少人工投入,还可以缩短生物资产的计数周期,但该方法受光照条件影响严重,并且当动物间相互挤压、遮挡时,计数精度较差。针对这些问题,该研究提出了一种基于图像实例分割算法的生猪计数网络。针对光照和目标边缘模糊问题,利用拉普拉斯算子进行图像预处理。对Mask R-CNN网络的特征提取网络进行改进,在原始特征金字塔网络(Feature Pyramid Network, FPN)后面增加一条自底向上的增强路径,直接将低层边缘位置特征与高层特征相融合,提高对目标边缘轮廓的识别能力,对非极大值抑制过程和损失函数进行优化和改进,以提高分割精度。在河北丰宁、吉林金源和内蒙古正大3个试验猪场进行测试,验证本文网络的计数精度。采集设备在3个试验猪场共采集2 400张图像,经图像预处理去除模糊和光线差的图像,从剩余的图像中随机选取共1 250张图像作为原始数据集,其中丰宁猪场500张、金源猪场500张,正大猪场250张。将各猪场的原始数据集分别按2:2:1的比例分为3部分,包括训练集905张,验证集95张,测试集250张,对原始训练集和验证集进行数据增强,最终得到训练集图像1 500张,验证集图像150张,测试集图想250张。河北和吉林的试验猪场,每栏猪只数目为12~22头,各测试100张图像,完全准确清点的图像比例分别为98%和99%,满足实际应用要求。内蒙古试验猪场的单栏猪只密度大,每栏猪只数目平均80头,测试50张图像,完全准确清点的图像比例为86%。该研究所提出的猪只盘点系统,通过修改网络增强图像中目标特征信息提取和优化边界框回归过程,减少由于光线差和遮挡导致的目标漏检情况,解决了基于图像分割算法的猪只盘点中光照、模糊以及遮挡等问题,能够满足单栏饲养密度为1.03~1.32头/m2的养殖场的猪只盘点需求。

图像处理;算法;目标检测;实例分割;猪只计数;深度学习;特征金字塔网络

0 引 言

无论是农业审计还是大规模猪场的日常养殖和管理,生猪计数都有重要意义。标准化养殖和精细化饲养已经成为生猪养殖行业的发展趋势。根据计数结果制定合理养殖计划,采购适量饲料,可以提高养殖场收益。在精细育种方面,生猪计数有助于实时了解母猪生产信息,及时更新猪只数量[1]。传统的猪只计数采用人工点数的方式进行,耗费大量的人力和物力,并且效率低。2000年初,电子耳标成为动物身份标识的主要方式,大型养殖场通过电子耳标掌握猪只信息,实现生猪计数。在一定范围内,读取到的电子耳标数量即为猪只数量,该方法受距离影响较大,计数结果稳定性较差,并且耳标容易脱落,成本相对较高。近年来,随着人工智能技术的快速发展,基于图像和视频的智能计数方式逐渐开始应用于农业领域[2-10]。张天昊等[11]针对储备生猪,利用光学方法确定生猪的典型颜色特征,以此作为识别目标的RGB颜色分量相对比例判别依据,结合形态学算法和区域生长法进行目标数量的统计。梁炎森等[12]利用基于纹理特征的滤波方法实现了远程视频养殖场生猪的图像识别计数,但系统的平均识别率只有85%。为提高识别精度,人流量统计模型逐渐迁移到畜牧业领域中。基于图像和视频的人流量统计方法主要有基于递归模型[13-14]以及基于图像实例分割[15-21]。韩书庆等[22]采用决策树分割算法提取图像的猪体前景区域,通过分水岭分割算法处理黏连猪体图像,并根据检测得到的边界脊线,实现黏连猪体的分离。Miso等[23]利用Kinect采集猪只的深度图像,通过图像分割网络实现了对猪只的监测。Tian等[24]将RGB图像转换成为密度分布图的形式,利用改进的CNN网络,实现了15头猪只的精确计数。Chattopadhyay等[25]设计了一个基于感数思想的计数模型,用来解决自然场景中的目标数量,外形和尺度存在很大变化的情况。Kashiha等[26]采用椭圆拟合算法和模式识别技术对猪进行定位和识别。综上,基于深层神经网络的计数算法已经广泛应用于农业生产领域中。但猪只计数具有一定难度,猪只的皮毛颜色相似,个体之间不易区分;猪是群居动物,通常会挤靠在一起,造成严重的相互遮挡;发生体态变化或碰撞挤压时,猪体会发生形变,形状差异较大,不易识别。针对上述问题,本文提出了一种基于图像分割算法的猪只计数模型,在基于深度学习的实例分割算法Mask R-CNN基础上修改特征提取网络、非极大值抑制部分,损失函数和RPN网络参数,进一步精确分割目标边缘,减少相互遮挡目标间的互相影响,结合猪场图像特点,训练适用于不同场景的计数网络模型,实现猪只计数。

1 数据来源与预处理

1.1 数据来源

本文分别在3种不同密度的试验场地进行猪只计数试验:河北丰宁试验猪场、吉林金源试验猪场以及内蒙古正大集团化猪场。3个试验猪场群养栏的大小和饲养密度有较大差异,其中河北猪场群养栏的大小为5.5 m×1.8 m,单栏内平均饲养12头猪,猪只数量较少,饲养密度为1.21头/m2;吉林猪场群养栏的大小为5.5 m×3.9 m,单栏内平均饲养22头猪,饲养密度为1.03头/m2;内蒙古猪场群养栏的大小为11.4 m×5.28 m,单栏内平均饲养80头猪,饲养密度为1.32头/m2。所有图像均为自然光照条件采集,采集时间均为3个月。采集时间从早晨7点至傍晚19点,试验共采集2 400张图像,其中河北猪场1 000张,吉林猪场1 000张,内蒙古猪场400张。试验现场可见光摄像头吊装于猪栏的中间位置,每栏安装1个摄像头。

工作站远程控制摄像头在满足拍摄条件时采集现场图像,并将采集图像保存在存储设备硬盘柜中,采集图像以“摄像头编号+拍摄日期+拍摄时间”命名。图像数据传输存储方式是采集设备将图像远程传送到工作站预测,工作站将预测结果返回采集设备并保存。

1.2 数据预处理及数据集构建

对采集到的2 400张图像首先通过图像预处理剔除模糊和光线差的图像。将采集到的RGB图像转换为灰度图像后,计算图像灰度值经拉普拉斯算子卷积运算后与图像灰度均值的方差,该方差定义为图像清晰度(),如式(1)所示。

式中(,)表示坐标为(,)处图像的灰度值,*表示图像卷积运算,表示离散拉普拉斯算子的模板,为阈值,为图像灰度平均值。依据经验阈值取100,清晰度大于定义为清晰图像,小于定义模糊图像,直接移除,最终得到2 000张图像。

从预处理的图像中随机选取丰宁猪场500张、金源猪场500张和正大猪场250张共1 250张图像作为原始数据集。将数据集划分为3部分,包括训练集905张,验证集95张,测试集250张图像。训练集图像包括河北猪场362张,吉林猪场362张,内蒙古猪场181张、验证集图像河北猪场38张,吉林猪场38张,内蒙古猪场19张。测试集图像河北猪场100张,吉林猪场100张,内蒙古猪场50张。使用VGG Image Annotator(VIA)标注原始图像,生成json文件。

标注图像后,通过数据增强扩充训练集和验证集,随机挑选图像进行人工亮度提升和旋转,最终得到的数据集包括训练集1 500张,验证集150张和测试集250张共1 900张图像。

2 生猪计数网络结构的设计

2.1 网络结构总体框架

本文所提出的生猪计数网络基于TensorFlow框架的Mask R-CNN网络结构,针对猪只密度大、遮挡严重的特殊问题,采用ResNet-152作为Mask R-CNN特征提取网络,同时,在原始特征金字塔网络(Feature pyramid network, FPN)后面添加一条自底向上的增强路径,将底层定位特征向上传递,提高边界框定位的精确性,本文提出的基于Mask R-CNN改进算法的总体框图如图1所示。

图1 基于Mask R-CNN改进算法的总体框图

2.2 特征金字塔网络的改进

FPN通过将高层特征图上采样后与下层特征图相加实现不同网络层提取的特征融合,自顶向下将高层特征逐层向下传递,只增强了高层的语义信息,没有增强底层信息,而神经网络的底层信息多是边缘、形状等特征,这些特征对像素级的实例分割非常重要,尤其是本文应用场景中,受现场条件影响较大,比如光照条件较差,目标之间互相挤压遮挡严重,目标轮廓边缘经常不是特别清晰。针对此问题,本文根据PANet(Path Aggregation Network for Instance Segmentation)在原始FPN后面添加一条自底向上的增强路径,直接将低层边缘位置特征与高层特征相融合,以提高对边缘轮廓的识别能力。路径快速增强的特征金字塔网络总体结构图如图2a所示,虚线框内为增加的增强路径,图2b描述了特征图的运算过程。具体而言,设计N2层至N4层,N3层至N5层的快速增强路径,特征图N2尺寸与P2相同,经过步长为2的3×3卷积后,与P3经1×1卷积求和得到N3。同时,N2经过步长为4的5×5卷积后,与P4经1×1卷积求和得到N4;依次得到N5和N6。

2.3 RPN参数优化

RPN(Region Proposal Network)网络负责候选区域的生成,候选区域生成过程中采用“锚点(anchor) 机制”。本文网络的识别目标只有生猪,当猪只密度较大时,猪只之间互相挤压,造成身体的变形,目标的横纵比例会发生变化。当锚点的横纵比和目标横纵比差异较大时,容易产生目标漏检。

注:C1~C5层为图像卷积后的特征图,P2~P5层为C2~C5层通过上采样和卷积后的特征图,N2~N6层为P2~P5层通过下采样和卷积后的特征图。

Note: C1-C5 layers are the feature image after image convolution, P2-P5 layers are C2-C5 layers through up sampling and convolution, N2-N6 layers are P2-P5 layers after down sampling and convolution.

a. 路径快速增强的特征金字塔网络结构

a. Architecture of feature pyramid network with fast path enhancement

b. 特征运算过程

在猪只密度比较大的场景中,为了提高小目标的识别准确率,结合特征金字塔网络,本文采用在不同尺寸的特征图上,预测不同尺寸的目标。低层特征图缩放比例较小,小目标特征保存比较完整,在低层大尺寸的特征图上生成小尺寸的锚点,用于检测小目标;高层特征图缩放比例较大,但是可以学习到更多的语义信息,丰富大目标特征,在高层特征图上生成大尺寸的锚点,用于检测大目标。由各层特征图映射回原图的锚点尺寸如表1所示。

表1 各层特征图的锚点尺寸

2.4 改进非极大值抑制过程

Mask R-CNN算法中的非极大值抑制(Non-maximum suppression,NMS)过程是将和得分最高边界框的重叠度IoU(Intersection over Union)值大于设定阈值的预测框移除。当2个目标相互遮挡时,目标间边界框的IoU((Intersection over Union))较大,NMS过程中会移除相邻目标的边界框,造成漏检。针对此问题,本文对NMS过程进行优化,根据Soft NMS(Soft Non-Maximum Suppression)修改处理过程,当预测框和得分最高边界框的IoU大于阈值时,不直接移除预测框,而是修改预测框的得分。同时,为了减少冗余,采用IoU越大,得分越低的原则,预测框的新得分设置为原始分数乘以指数函数的形式,新得分设置为原始分数乘以指数函数的形式,如式(2)所示。

式中s为原始得分,为得分最高边界框,b为当前处理预测框,表示收敛系数,依据测试集上模型测试效果本文取值0.5。

2.5 损失函数

遮挡问题是深度学习领域面临的最严峻的问题,严重影响目标识别的准确率,当目标之间遮挡严重时,容易造成目标漏检,且检测到目标的边界框定位不准确,边界框位置偏向漏检目标。为了提高对遮挡目标的识别能力,本文对边界框回归的损失函数进行优化,在原有损失函数基础上引入排斥项(L)。排斥项使得预测框和对应真实目标边界框的距离缩小的同时,使之与相邻无关目标边界框(包括其他目标的真实边界框和预测框)的距离增大。优化后边界框回归损失由吸引项和排斥项组成,其计算公式如式(3)所示。其中L计算预测框与其真实目标框产生的损失值,使预测框与真实目标边界框更加接近;排斥项L为预测框与IoU第二大的真实目标边界框所产生的损失值,使预测框远离与之相邻的其他真实目标边界框。预测框靠近真实目标边界框的同时远离相邻目标的边界框,可以提高边界框定位精度,在一定程度上提高对相互遮挡目标的识别能力。

3 试验结果与分析

3.1 遮挡条件下的试验结果与分析

遮挡问题严重影响着生猪计数网络的识别精度,当目标之间遮挡严重时,目标的轮廓信息缺失。Mask R-CNN网络改进前后的检测效果如图3所示。由图可知,快速增强FPN网络对边缘模糊目标的检测效果有明显提升,图3a图像1上方栏杆附近的2头猪,由于互相彼此遮挡,并且图像有些模糊,在网络改进结构之前被识别成为1只猪,改进网络结构之后则可以区分为2只猪。类似地,图3a图像2中正上方的2只猪,由于拍摄期间目标运动产生图像模糊现象,改进网络能够正确区分为2个不同的目标,识别效果如图3c所示。

图3 Mask R-CNN网络改进前后的测试结果对比

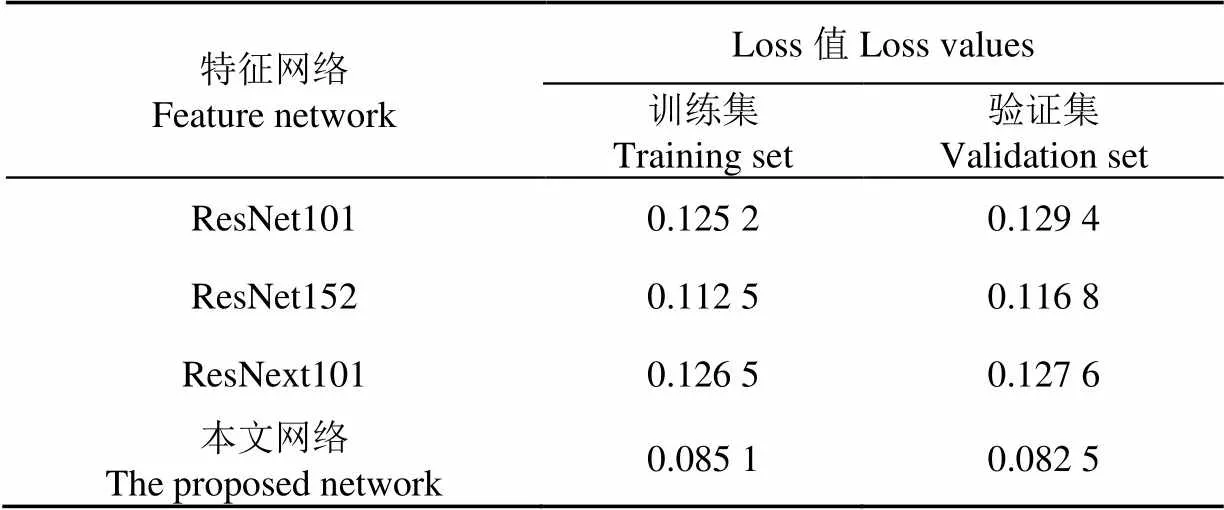

此外,在包含3个猪场的1 900张图像数据集上训练并测试了Resnet101、Resnet152、ResNext101和所提出的路径增强的Resnet152网络,各网络迭代90 000次后,在训练集以及验证集的loss值如表2所示。特征提取网络ResNet152训练集的loss收敛数值比原来的ResNet101网络低0.012 7,比ResNext101网络低0.014,验证集的loss收敛值比原来的ResNet101网络低0.012 6,比ResNext101网络低0.014。利用本文路径增强Resnet152网络采用路径增强的FPN结合ResNet152网络在包含3个猪场图像的数据集上训练90个循环(epochs),每个循环迭代1 000次,训练过程中的loss值变化如图4,由图4可知,训练集和验证集的loss值均降至0.1以下,训练集损失比ResNet152网络低0.027 4,验证集损失比ResNet152网络低0.034 3,收敛效果最好。

表2 不同特征提取网络的训练结果

3.2 不同猪场的测试结果与分析

河北和吉林猪场猪栏的正上方悬挂170°广角摄像头,距离地面2.2 m高度。内蒙古猪场群养栏由于拍摄面积过大,图像采集盒摄像头模组更换为210°鱼眼镜头。图5为3个试验场所采集的原始图像及相应的计数网络输出结果。表3为250张测试集图像的精度统计结果,其中河北和吉林猪场分别测试100张图像,河北猪场有2张图像漏检1个目标,计数准确率为98%,其中1张图像是由于目标被遮挡导致漏检,另1张图像的清晰度合格但由于其中1只猪快速运动导致边缘模糊造成漏检。吉林猪场有1张图像漏检1个被遮挡目标,计数准确率为99%,计数准确率满足实际应用需求。

图4 Loss值变化曲线

图5 本文网络在不同猪场的输出示例

表3 本文网络精度测试结果

对于猪只密度较大的内蒙古猪场,由于猪只挤压、变形以及遮挡现象很严重,并且现场图像背景干扰较多, 50张测试图像的计数准确率为86%,有7张图像存在漏检,4张图像漏检1个目标,3张图像漏检2个目标,模型精度有一定的提升空间,也是后期计数网络改进优化的重点方向。表4为相同试验条件下Yolov3,Faster R-CNN,Mask R-CNN和本文网络对250测试集图像的速度与精度对比。由表4可知,Yolov3检测速度非常快,但对于遮挡目标和密集目标检测效果较差,Faster R-CNN采用两阶段框架,检测效果有所提升,Mask R-CNN增加掩膜分支,精度进一步提高。本文对Mask R-CNN网络结构进行增强,增加了网络的复杂度,在提升精度的同时也导致运算成本增加,检测图像的平均耗时增加。

表4 不同生猪计数网络测试结果对比

4 结 论

本文利用像素级实例分割算法设计了一种生猪计数网络。采取图像预处理程序剔除模糊和光线差图像,针对猪只间的相互遮挡问题,目标边缘轮廓不清晰的问题,改进Mask R-CNN的主干网络,利用ResNet152网络进行特征提取,使用修改后的快速增强FPN网络方法,将低层的轮廓边缘特征与高层特征融合,提升边缘模糊目标的识别效果。通过改进非极大抑制过程,修改边界框回归损失函数和优化RPN网络参数解决遮挡目标漏检问题。本文网络在包含3个不同类型猪场采集的图像数据集上对所提出的生猪计数网络进行训练和测试,试验结果表明,本文提出的生猪计数网络对单栏12~22头猪只的计数精度达到98%以上,对单栏80头左右的猪只计数精度为86%。本文算法也有一定的不足,算法对小目标和高密度目标图像的检测效果仍有待提高。后续研究中,可通过进一步增强图像特征提取网络和级联训练网络逐步提高密集情况的猪只盘点准确率。

[1] 屠萍,祝海云. 智能盘点提高资产管理效率[J]. 通信企业管理,2016,352(8):41-43.

Tu Ping, Zhu Haiyun. Intelligent inventory improves asset management efficiency[J]. Communication Enterprise Management, 2016, 352(8): 41-43. (in Chinese with English abstract)

[2] Chen S W, Shivakumar S S, Dcunha S, et al. Counting apples and oranges with deep learning: A data-driven approach[J]. IEEE Robotics & Automation Letters, 2017, 2(2): 781-788.

[3] Mads Dyrmann, Henrik Karstoft, Henrik Skov Midtiby. Plant species classification using deep convolutional neural network[J]. Biosystems Engineering, 2016, 151: 72-80.

[4] Gemert J C V, Verschoor C R, Mettes P, et al. Nature conservation drones for automatic localization and counting of animals[C]//Proceedings of the European Conference on Computer Vision. Springer, Cham, 2015: 255-270.

[5] Kamilaris A, Prenafeta-Boldu F X. Deep learning in agriculture: A survey[J]. Computers and Electronics in Agriculture, 2018, 147: 70-90.

[6] Picon A, Alvarez-Gila A, Seitz M, et al. Deep convolutional neural networks for mobile capture device-based crop disease classification in the wild[J]. Computers & Electronics in Agriculture, 2019, 161(1): 280-290

[7] Rahnemoonfar M, Sheppard C. Deep count: Fruit counting based on deep simulated learning[J]. Sensors, 2017, 17(4): 905.

[8] 齐龙,蒋郁,李泽华,等. 基于显微图像处理的稻瘟病菌孢子自动检测与计数方法[J]. 农业工程学报,2015,31(12):186-193.

Qi long, Jiang Yu, Li Zehua, et al. Automatic detection and counting method of Magnaporthe grisea spores based on micro image processing[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE). 2015, 31(12): 186-193. (in Chinese with English abstract)

[9] Shen, Yufeng, Zhou, et al. Detection of stored-grain insects using deep learning[J]. Computers and Electronics in Agriculture, 2018, 145: 319-325.

[10] 张银松,赵银娣,袁慕策. 基于改进Faster-RCNN模型的粘虫板图像昆虫识别与计数[J]. 中国农业大学学报,2019,24(5):115-122.

Zhang Yinsong, Zhao Yindi, Yuan Muce. Insect recognition and counting of armyworm board image based on improved fast RCNN model[J]. Journal of China Agricultural University, 2019, 24(5): 115-122. (in Chinese with English abstract)

[11] 张天昊,梁炎森,何志毅. 图像识别计数在储备生猪统计的应用[J]. 计算机应用与软件,2016,33(12):173-178.

Zhang Tianhao, Liang Yansen, He Zhiyi. Application of image recognition counting in pig reserve statistics[J]. Computer Applications and Software, 2016, 33(12): 173-178. (in Chinese with English abstract)

[12] 梁炎森,张天昊,何志毅. 畜牧养殖场图像远程采集与目标计数系统[J]. 桂林电子科技大学学报,2017,37(6):10-14.

Liang Yansen, Zhang Tianhao, He Zhiyi. Remote image acquisition and object counting system for livestock farms[J]. Journal of Guilin University of Electronic Science and technology, 2017, 37(6): 10-14. (in Chinese with English abstract)

[13] Boominathan L, Kruthiventi S S, Babu R V. CrowdNet: A deep convolutional network for dense crowd counting[C]// Proceedings of the 24th ACM international conference, Multimedia, 2016: 640-644.

[14] Di K, Zheng M, Chan A B. Beyond counting: Comparisons of density maps for crowd analysis tasks-counting, detection, and tracking[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2019, 29(5): 1408-1422.

[15] Cholakkal H, Sun G, Khan F S, et al. Object Counting and instance segmentation with image-level supervision[C]. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach. CA, USA: CVPR, 2019: 12389-12397.

[16] Ooro-Rubio D, Roberto J López-Sastre. Towards perspective-free object counting with deep learning[C]// Proceedings of the European Conference on Computer Vision, Springer, Cham: ECCV, 2016: 615-629.

[17] Ma Z, Yu L, Chan A B. Small instance detection by integer programming on object density maps[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston: IEEE, 2015: 3689-3697.

[18] Xie S, Girshick R, Dollár, Piotr, et al. Aggregated residual transformations for deep neural networks[C]//Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2017: 5987-5995.

[19] Zhang C, Li H, Wang X, et al. Cross-scene crowd counting via deep convolutional neural networks[C]//Proceedings of the IEEE Conference on Computer Vision & Pattern Recognition, Los Alamitos, CA, USA: IEEE, 2015: 833-841.

[20] Zhang L, Shi M, Chen Q. Crowd counting via scale-adaptive convolutional neural network[C]//Proceedings of the 2018 IEEE Winter Conference on Applications of Computer Vision (WACV), Los Alamitos, CA, USA: IEEE, 2018: 1113-1121.

[21] He Kaiming, Gkioxari G, Dollár P, et al. Mask R-CNN[C]// Proceedings of 2017 IEEE International Conference on Computer Vision (ICCV), Venice, Italy: IEEE, 2017: 2980-2988.

[22] 韩书庆,张建华,孔繁涛,等. 基于边界脊线识别的群养猪黏连图像分割方法[J]. 农业工程学报,2019,35(18):161-168.

Han Shuqing, Zhang Jianhua, Kong Fantao, et al. Group-housed pigs image segmentation method by recognizing watershed ridge lines on boundary[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(18): 161-168. (in Chinese with English abstract)

[23] Miso J, Younchang C, Jihyun S. A kinect-based segmentation of touching-pigs for real-time monitoring[J]. Sensors, 2018, 18(6): 1746-1770.

[24] Tian Mengxiao, Guo Hao, Chen Hong, et al. Automated pig counting using deep learning[J]. Computers and Electronics in Agriculture. 2019, 163: 1-10.

[25] Chattopadhyay P, Vedantam R, Ramprasaath R S, et al. Counting everyday objects in everyday scenes[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Honolulu, HI: IEEE, 2017: 4428-4437.

[26] Kashiha, Mohammadamin, Bahr C, et al. Automatic identification of marked pigs in a pen using image pattern recognition[J]. Computers & Electronics in Agriculture, 2013, 93: 111-120.

Design of intelligent pig counting system based on improved instance segmentation algorithm

Hu Yunge1,2, Cang Yan1※, Qiao Yulong1

(1.,,150001,;2...,100086,)

The existing pig counting system based on image processing are seriously affected by light conditions, and the counting accuracy is poor when pigs are crowded and obscured.To realize the intelligent pig counting, the paper proposed a counting scheme based on the improved instance segmentation algorithm was proposed in this study. Aiming at the problems of image illumination and target edge blur, Laplace operator was used to preprocess the images. The feature extraction network of MASK R-CNN network was improved by using Resnet-152 as the Mask R-CNN feature extraction network, and the original Feature Pyramid Network(FPN) was followed by a bottom-up enhancement path, which directly fused the low-level edge features with the high-level features to improve the recognition ability of the target edge bluring. The non maximum suppression process and loss function were optimized and improved to improve the segmentation accuracy. The experiments were carried out at three different real pig farms to verify the counting accuracy, respectively in Hebei province, Jilin province and Inner Mongolia. The size of the cage in Hebei pig farm was 5.5 m × 1.8 m, with an average of 12 pigs in a single pen, with a feeding density of 1.21 pigs/m2; the size of the cage in Jilin pig farm was 5.5 m × 3.9 m, with an average of 22 pigs in a single pen, and the average rearing density was 1.03 pigs/m2; the size of the cage in Inner Mongolia pig farm was 11.4 m × 5.28 m, with an average of 80 pigs in a single pen, the average feeding density was 1.32 pigs/m2. The RGB camera is wa nstalled on the top of the pen and acquired the image in daytime. 2 400 images were collected in total, and 2000 images were selected after image preprocessing, and 1 250 images of three pig farms were selected as the original data set according to the ratio of 2:2:1. The training set and verification set were enhanced to 1 500 and 150 images and 250 images for the test set, The experimental results showed that 98 images could realize exact counting and 2 images missed 1 pig in the Jilin pig farm, the accuracy of pig counting was 98%. In Hebei pig farm, 99 images could realize the exact counting and the accuracy of pig counting was 99%. For Inner Mongolia pig farms with high feeding density, the accuracy of pig counting was 86%, among the 50 test images, 7 images missed detection, 4 images missed 1 target, 3 images missed 2 targets,The results can provide the application of the artificial intelligent in agriculture field.

image processing; algorithms; object detection; instance segmentation; pig counting; deep learning; haracteristic pyramid network

胡云鸽,苍岩,乔玉龙. 基于改进实例分割算法的智能猪只盘点系统设计[J]. 农业工程学报,2020,36(19):177-183.doi:10.11975/j.issn.1002-6819.2020.19.020 http://www.tcsae.org

Hu Yunge, Cang Yan, Qiao Yulong. Design of intelligent pig counting system based on improved instance segmentation algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(19): 177-183. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2020.19.020 http://www.tcsae.org

2020-05-10

2020-09-15

国家自然科学基金项目(61871142)

胡云鸽,研究方向为智能图像处理。Email:986113728@qq.com

苍岩,博士,讲师,主要研究方向为智能信息处理。Email:cangyan@hrbeu.edu.cn

10.11975/j.issn.1002-6819.2020.19.020

TP391

A

1002-6819(2020)-19-0177-07