基于T3认证的数据中心全容错物理隔离设计方法

2020-10-10周宏成黎致立肖锋

周宏成,黎致立,肖锋

(1.广东省电信规划设计院有限公司;2.广东邮电职业技术学院 )

1 设计必要性分析

从风险管理的角度,一个事件的持续时间的长度与风险发生的概率成正比。数据中心的运维周期可达10a~20a,在规划设计过程中主要设备采用容错/冗余设计,从拓扑构建和空间布置两个维度来解决业务运行持续性的问题。拓扑构建在设计过程中,往往容易得到重视,但空间布置这个涉及工艺平面设计、专业交叉等多主面的问题,在设计过程中的部分环节容易被忽视,以下内容将结合广东省电信规划设计院的设计实践,浅谈数据中心全容错物理隔离的设计方法。

数据中心全容错物理隔离,是在空间结构上将容错的机电设施、通信设施等直接影响数据中心可靠运行的基础设施进行物理隔离。采用全容错物理隔离设计标准的数据中心,能承受损毁性故障(如局部火灾,严重外力损坏、严重水患等);同时也可避免检修维护作业对正常系统的影响,提高整体抗风险能力。

全容错的物理隔离设计,需增设部分管井、线槽等,部分管道的路由的长度可能会增加。前期如规划得当,可以很好地控制造价的增加,其产生的正面效益贯穿整个数据中心的全生命周期,具有较好的经济效益。

2 总体设计物理隔离设计

根据《数据中心设计规范》(GB 50174-2017)4.3.2的规定:“容错系统中相互备用的设备应布置在不同的物理隔间内,相互备用的管线宜沿不同路径敷设”。需要做物理隔离的系统主要有拓扑结构中采用2N设计的系统,主要包括电气、空调、通信三大块[1]。上述系统一旦发生运行故障,会在短时间内引起宕机,造成业务中断,直接造成不同程度的损失。因此,物理隔离具有切实的意义,以下简单介绍一下各主要系统的全容错物理隔离的设计方法。

2.1 电气系统

电气系统是数据中心机房最重要的一个系统,其设计环节历时最长。在可研规划阶段,应规划园区或建筑物内需要有2个物理隔离的市电取电点,在市电供电的源头上开始进行物理隔离的保障。根据数据中心负荷等级不同,市电取电点主要有开闭所、高压房、低压房等。整个电气系统的设计主要可以分为高低压供配电系统、IT设备配电系统、空调设备配电系统这三块。

1)高低压供配电系统

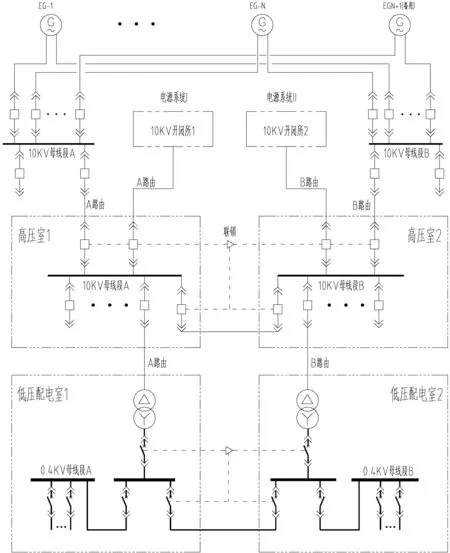

如图1所示,高低压供配电系统的流向主要分两部分,一部分是市电的供电流向:开闭所→高压室→低压配电室;另一部分是柴发供电的流向:柴发机房→高压室→低压配电室。

在设计时应分别设置2个独立的开闭所、高压室、低压配电室。开闭所→高压室、柴发机房→高压室、高压室→低压配电室均应设计2套独立路由,分别走不同管井/线槽。其中高压配电室、低压配电室的联络开关,应分别在两个配电室独立设置(如图1所示),确保在2N系统中的任意其中1N发生严重故障时,不会影响另1N系统的持续运行[2]。

2)IT设备配电系统

IT设备配电系统的配电流向也可分为两部分,一部分是市电的配电流向:低压配电室→UPS电力室→配电列头柜→IT机柜;另一部分是储能设备的配电流程:电池室→UPS电力室→配电列头柜→IT机柜。

图1 高低压供配电系统设计示意图

本部分的设计,与高低压系统的设计思路一致,应确保有2个物理隔离的UPS电力室、电池室、配电列头柜,并设置2套完全隔离的配电路由/桥架。部分后期需扩容或改动的IT机房,配电柜列头→IT机柜可设置2套不同的桥架(见图2),可避免在维护或扩容时同时影响A、B两路配电系统。

3)空调设备配电系统

空调设备配电系统的配电流向(见图3):低压配电室→互投动力柜→空调设备。空调设备的冗余一般都是N+1(4≥N≥2),在设计过程中,每个空调设备房应设置2个互投动力柜,对不同的空调末端设备进行奇偶交错供电,并且配电室→互投动力柜的流向应设置2套独立的路由/桥架[3]。

2.2 空调系统

空调系统是数据中心机房持续运行的重要系统,空调设备的冗余一般都是N+1(4≥N≥2),空调水循环系统多采用环网设计。空调系统主设备的运行可靠性不是空调系统的短板,所以空调设备间一般不做物理隔离。空调水循环管道系统因在现场焊接施工,且阀门众多,其可持续运行的风险相当高,应做物理隔离。

1)空调制冷系统管道设计

现阶段数据中心多以冷冻水空调系统为主,冷冻水空调系统主要由冷却水循环系统、冷冻水循环系统组成。两套水循环系统应分2个独立的管道路由/竖井,竖井宜设置在建筑物双侧。有连续制冷要求的数据中心,应设置2套独立的蓄冷设备,满足物理隔离的要求。此部分《数据中心设计规范》(GB 50174-2017)有相关描述,设计方法可参考相关规范。

2)空调补水系统管道设计

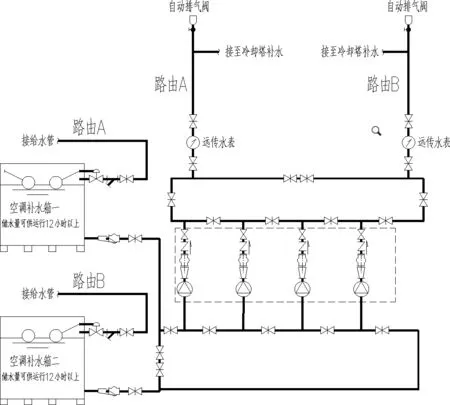

空调补水系统采用2N设计,设置2套独立补水水箱,从补水箱向冷却水循环系统补水的流向依次为:园区或建筑物补水管→空调补水箱→空调补水管道→冷却塔。各个节点的管道应设置独立的双路由(见图4),以确保补水系统运行的可靠性。

2.3 通信系统

数据中心不但是数据存储处理中心,同时也是网络通信中心,通信的可靠性是数据中心各项业务运行的基本保障。数据中心的通信系统均采用2N的拓扑架构,拓扑架构的缺陷显而易见,在设计过程中基本可以得到很好的落实,但物理隔离的风险不易排查,在设计过程中容易被忽视。

图2 IT机房双桥架设计示意图

图3 空调设备配电设计示意图

图4 空调补水系统管道设计示意图

简单地讲,数据中心的业务通信基础设施,可划分为外部通信基础设施和内部通信基础设施两部分。业务通信基础设施的路由错综复杂,如要达到全容错物理隔离的设计目标,在设计过程中应确保任意物理路由(竖井、管槽)发生严重损性故障,仍能保证数据中心通信业务不中断。

1)外部通信基础设施

外部通信基础设施是保障数据中心能对外通信的布线系统,其路由如下:建筑外墙通信孔井→进线间→网络核心机房→各IT机房,设计时应确保建筑外墙双通信孔井、双进线间、双网络核心机房,并分设A、B两个不同的路由,且有一定的间隔要求。网络核心机房至各IT机房,也应设计2套独立的综合线槽。

2)内部通信基础设施

内部通信基础设施是保障数据中心内部通信的布线系统。其结构由主分布区(MDA)、水平分布区(HDA)、设备分布区(EDA)组成。此部分《数据中心设计规范》(GB 50174-2017)有详细描述,可参照上述规范。主分布区(MDA)一般设置在网络核心机房,水平分布区(HDA)为一般网络列头柜、设备分布区(EDA)一般设置在各服务器机架内。相同的机柜冷通道单元,应设置2个网络列头柜,从网络核心机房至网络列头柜,应规划2套独立的路由,设计思路与外部通信基础设施一致。

图5 外部通信基础设施设计示意图

3 结语

数据中心属于重资产的建设项目,设计应考虑整个生命周期的效益。对于中小型的数据中心,其抗风险能力、运维能力相对比较薄弱。采用全容错物理隔离的设计方法,可以有效提升中小型数据中心抵抗损毁性故障风险的能力,并且减少运维过程的对正常系统的影响,提高数据中心的运行可靠性。