AI播音与人工播音的语音差异性考察

2020-09-12姜泽玮

姜泽玮

【摘 要】随着人工智能语音技术与播音行业的接轨,AI播音逐渐开始在新闻媒体中崭露头角。本文以新华社APP的AI新闻播音为对象,从中国播音学、汉语语音学的角度,通过定量定性结合的实证研究,从速度、语音、停顿、重音四个角度入手,对AI播音与人工播音的差异性作出分析。今后人工智能语音合成技术的研究应首先重点把握AI播音中的具象层面问题,从“词团内部语流速度”、“音节的声调调值”、“句中停顿”以及“重音的表现形式”四个角度入手,在现有的理论基础与技术条件下有针对性地进一步完善AI播音的质量。

【关键词】AI播音;语速;调值;停顿;重音

一、前言

近年来人工智能语音技术正不断与播音行业接轨,机器人主播这一新形态的播音主体应运而生。所谓AI(人工智能)播音,是基于智能语音技术中的语音合成技术(Text to Speech,TTS),首先由计算机对播音文本进行分析处理,再将已有语音库的声音样本通过各项合成规则与算法模型形成韵律、音节与波形,最终将合成的语音进行输出的过程。语音合成的发展经历了机械式语音合成、电子式语音合成和基于计算机的语音合成发展阶段,[1]近年来DNN深度学习网络以及“自适应说话人技术”的产生使语音合成技术进入了一个新的阶段。[2][3]但目前的人工智能语音技术仍然处于初级阶段,在播音领域内尚不能具备普适性的应用空间,但随着人工智能语音技术的科学研发不断进步,未来将能够拥有越来越广泛的应用空间。[4]对于AI播音的研究,不仅需要计算机科学的技术研究,也需要传媒、播音业界、学界从应用角度进行分析,進而对现有AI技术的研发成果提出问题,对今后技术的继续完善与开发提供借鉴。随着AI播音的应用与发展,国内近年来的相关研究基本围绕着AI播音未来的发展前景、应用方向以及传统播音主持业务、教育面对新技术应作出的调整等议题上进行了宏观层面的探讨。[5][6]在先前关于AI播音的讨论中,情感问题被普遍认为是AI播音工作的短板,[7]机器无法拥有人类的真实情感,只能通过“模拟”来仿造情感,[8]而语言的传播过程终究是一种建立在个人思想与情感之上的思维活动。[9]人工智能的情感在当前技术发展水平仍处于弱人工智能的前提下,难以做到大幅度提升与本质上的改变。除情感问题之外,AI播音的语言本身也存在问题,即播读速度、字音、声调、停顿、重音等问题。本文将通过微观层面的实证研究,以新华社APP中消息类新闻的AI语音播报为对象,从速度、语音、停顿、重音四个方面入手,基于中国播音学、汉语语音学的角度,定性定量结合地对AI播音与人工播音的具体差异作出实证分析。一方面为人工智能语音技术今后的开发研究提供借鉴,另一方面对先前学界关于AI播音的相关研究进行验证与补充。

二、新华社APP中AI新闻播音研究

(一)AI播音的速度考察

1.播音平均速度

播音平均速度指单个稿件中播音的平均速度,基于单个稿件的总字数与播音净时间计算,以字符/秒的单位呈现。播音平均速度可以反映出相同时间内信息传播量的多少,但由于播音工作中存在对稿件“重音停连”的处理,因而平均速度与受众听觉中的“快慢”、“舒缓”或“紧凑”有时不一定准确对应。本研究于2019年7月10日至8月10日的30天内在新华社APP时政类新闻的AI语音播报中每日随机抽取一篇新闻作为样本分析,统计稿件字数(标点符号记为1字符,空格不计字符)与播读净时间,并测算播读的平均速度,以“字符/秒”的形式进行统计。并同样于此30天内在CCTV《新闻联播》节目中的“联播快讯”板块内每日随机抽取一条新闻作为样本,以同样的方式对其播读时间、稿件字数进行统计,并计算出每条新闻的平均播读速度,以“字符/秒”的形式进行统计。之后将两组平均播读速度的样本数据录入IBMSPSS软件进行描述统计分析,生成两组数据的直方图,见组图1。

通过对上述两组平均播读速度样本的直方图对比,可以发现AI播音的平均语速慢于人工播音的语速,每秒相差0.82个字符;且AI播音样本的标准差为0.09,离散度较低,而人工播音样本的标准差为0.491,离散度较高。由此可以看出AI播音的风格存在同质化的问题,当受众听到每日的新闻播报都是同一个语速时,将可能产生听觉疲劳。而不同的人工播音员之间播读速度差异较大,即便是同一位播音员在不同时期、播读不同稿件时的播音速度也有较大差异。[10][11]

2.语句词团内部语流速度

汉语语句在声音传播的形式下会呈现出由多个“词团”构成的态势,所谓词团即汉语语句内部词与词之间的聚合情况。[12]语句词团内部语流速度则指这种聚合的快慢,也就是播音学中常常谈到的“语句停连”中“连”的部分的速度快慢。因为词团的构成不具有固定化的特性,[13]因而难以对词团内部语流速度作出量化分析。本研究对新华社APP中时政类新闻的AI语音播报与CCTV《新闻联播》中时政类新闻播音进行了对比考察,发现对于人工播音而言,其中不同词团内部的语流速度差异比较明显,简而言之便是有的词团内部播读速度相对较快,而有的词团播读速度则较慢,这种快慢之间的差异性远高于AI播音的语流。AI播音对于不同词团内部的播读速度并无太大区别,例如以下一段新闻文稿,摘自CCTV《新闻联播》节目2019年8月4日国内快讯:

“2019全球电竞大会今天(3日)在上海举行,同时启动上海电竞周活动。本次大会就产业发展、体系建设、商业思考、业态新增长等角度展开讨论。会上还发布了首个《电竞场馆建设规范》和《电竞场馆运营服务规范》。”

其中,“2019全球电竞大会”作为一个词语聚合的词团,播读速度相对较快;“产业发展、体系建设、商业思考、业态新增长”这一组并列关系的词语的播读速度较慢;“电竞场馆建设规范”、“电竞场馆运营服务规范”这两个词团的播读速度则明显缓慢。而对于AI播音而言,不同词团内部的播读速度则大体一致,并没有人工播音时那样显著的快慢区别。

2.句中停顿

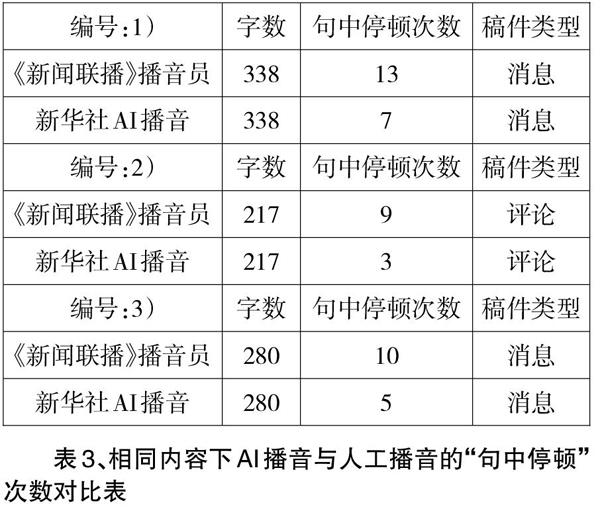

“句中停顿”指播音语流在没有标点符号的位置处进行停顿的现象,属于播音员对稿件的“创作”过程,人工播音与AI播音在停顿方面最主要的差异在“句中停顿”。“句中停顿”主要基于上文谈到的播音工作中对“词团”的划分,通常“词团”之间会产生停顿,“词团”内部会产生“聚合”。为更好地呈现AI播音与人工播音时“句中停顿”的差异,将新华社APP中时政新闻的AI语音播报与CCTV《新闻联播》节目的时政新闻播音做对比,分别抽取三篇(部分)内容完全相同的新闻稿:1)“李克强签署国务院令 公布《国务院关于修改〈烈士褒扬条例〉的决定》,2019-08-09”、2)“新华社评论员:美方践踏国际规则终将失败,2019-08-09”、3)“王岐山会见法国总统外事顾问,2019-07-19”的播音音频作为样本,对各自的“句中停顿”进行研究,见表3。

据表3中 AI播音与人工播音在“句中停顿”次数上的对比可以发现,AI播音的“句中停顿”次数远低于人工播音,且消息类新闻的“句中停顿”次数比例差高于评论类文章。除数量之外,《新闻联播》播音员对于“句中停顿”的时间处理更为灵活,而AI播音对于“句中停顿”的时间均呈现一致。人工播音员不仅在明显的“句中停顿”数量上远高于AI播音,在不作停顿处理的句子中因不同“词团”内部语流速度存在变化,最终在听觉上呈现的“节奏感”则远高于AI播音。

(四)AI播音的重音考察

播音工作中的“重音”是稿件中相对重要且需要被强调的字、词或短语。重音的强调、突出是在与非重音的对比中实现的,主要表现为轻重、虚实、长短 、抑扬等的对立统一。[15]在实际播读中通常会以降低播读速度、加大字音饱满度、提高音量、改变音色等表现手法来体现重音。笔者通过对新华社AI新闻语音播报的观察研究发现,现阶段的AI播音并非不存在重音的处理,只是对于重音的处理方式过于简单,基本上以单纯增大重音词语的音量为手段,导致听觉感受上的“突兀”。而人工播音员对于重音的处理更加多样化。决定停连和重音的原因是多方面、复杂的,[16]重音处理又与播音员情感的联系较为紧密,人类自然情感下的重音表现更加细腻。因而单纯从物理角度很难对重音的表现形式进行量化,重音问题也将是今后长期内AI播音难以突破的壁垒。但对于现阶段的人工智能语音合成技术而言,虽然不能做到完全模仿人类的自然情感,但仍然可以在字音饱和度、播读速度等方面对重音进行进一步的细化处理,使重音的表现形式更加立体、饱满。

结语

本文通过速度、字音、停顿、重音四个部分对AI播音与人工播音的差异性进行了定量定性结合的研究。综上所述,当前AI播音在一定程度上已经可以担起新闻播报的功能,但与国家级媒体的专业播音员相比仍然存在较大差距,在速度、重音、停顿以及字音四个方面均存在不同程度的差异性。除本文谈及的几个具象方面外,作为抽象存在的情感問题也是AI播音与人工播音员之间极其重要的差别,今后人工智能语音合成技术的开发研究应重点把握AI播音中的具象层面问题,从“词团内部语流速度”、“音节的声调调值”、“句中停顿”以及“重音的表现形式”四个角度入手,在现有的理论基础与技术条件下有针对性地进一步完善AI播音的质量。对于人工智能播音与播音员队伍之间的关系,在相当长的时间内并不会产生明显的替代性,随着技术的发展,未来会向着“人机协作、互补发展”的方向演进。人工智能播音作为一项传媒界的新鲜事物,今后的研发与应用将是一条漫长的道路,未来会面临更多的困难与挑战,需要多学科、多领域的长期不断研究、实践与探索。

注释:

[1]张斌,全昌勤,任福继.语音合成方法和发展综述[J].小型微型计算机系统,2016(01).

[2]FahimehBahmaninezhad,HosseinSameti,HMM-

based persian speech synthesis using limited adaptation[C].2012 IEEE 11th In- ternational Conference on Data Signal Processing(ICSP),2012:21-25.

[3]Junichi Yamagishi,TakashiNose,HeigaZen,et al. Robust speaker- adaptive HMM-based text-to-speech synthesis[J]. IEEE Transac- tions on Audio,Speech,and Language Processing,2009,17(6).

[4][5]翁佳.智能语音技术对播音主持专业与行业影响探究[J].电视研究,2017(12).

[6]李颖.人工智能技术在播音主持领域的应用[J].中国广播电视学刊,2018(11).

[7]谢晓旻,林小珏.人工智能为播音与主持艺术专业带来的新思考[J].当代电视,2018(11).

[8]刘悦笛.人工智能、情感机器与“情智悖论”[J].探索与争鸣,2019(06).

[9]樊强.语言学视域下言语行为的影像建构研究[J].西安外国语大学学报,2018(12).

[10]刘迎新.新闻播音语言停连模式的时代特点分析[J].现代传播,2015(03).

[11]刘琦.浅论广播新闻播音的时代语言与语速[J].中国广播,2009(07).

[12][13]樊强.人工智能(AI)播音语链内生成结构研究[J].电视研究,2019(02).

[14]宋欣桥.“普通话水平测试”评分中的几个问题[J].语言文字应用,1997(08).

[15]李水仙.新闻播音中的重音处理[J].河南大学学报(社会科学版),2002(01).

[16]姚喜双.文章做在耳朵上——听觉是确定播音停连和重音位置的重要依据[J].语言文字应用,1992(09).

(作者:西北大学新闻传播学院硕士研究生)

责编:姚少宝