基于虚拟化技术的信关站基带资源池设计与实现

2020-09-11王力权张志丽王艳君解立坤

王力权,翟 华,张志丽,王艳君,解立坤

(1.中国电子科技集团公司第五十四研究所,河北 石家庄 050081;2.北京跟踪与通信技术研究所,北京 100094)

0 引言

卫星移动通信,相对于地面移动通信系统,具有覆盖范围广、通信费用与距离无关以及不受地理条件限制等优点,能够实现对海洋、山区和高原等地区近乎无缝的覆盖[1-3],不仅能够传输电话、电报,而且能够传输高质量的电视以及高速数据等。卫星信关站是连接卫星网络和地面网络的枢纽,从网络互通角度,其包含基带处理单元和交换互联单元,主要完成传输算法、协议转换、网络交换及互联互通等功能[4]。基带处理单元是信关站中重要组成部分,实现信号的发送接收、编解码和协议处理等功能。

随着用户数量和应用数据规模等需求增长,卫星移动通信网络需要存在多种体制和规模,不同制式的网络相互重叠覆盖,这就导致卫星通信网络整体需要维持的基带资源总量和能耗巨大[5]。由于业务流量在地域上分布不均匀,导致了基础设施在数量或者时间上的冗余,造成信关站处理资源的闲置和浪费,增大运营和维护成本。基带资源池的建立,可将信关站基带处理中对实时性要求不高的部分,如分帧复接、MAC处理、RLC处理及PDCP处理等部署在通用服务器上,构建统一的资源池,进行联合协作分配和资源管理;同时也实现了软硬件解耦,提高了不同制式信关站的兼容性和可扩展性[6-7]。虚拟化技术是一种使基带处理单元能够灵活低成本支持多模或多制式的技术,基带处理单元占用的硬件资源通过虚拟化技术在物理资源池中进行高效的调度分配,对基带处理单元软件本身屏蔽其底层硬件资源的管理细节[8]。云计算是一种通过网络对共享资源池(如网络、服务器、存储)提供便捷、按需访问的计算模型,可实现与资源提供者快速交互,并通过较小工作量实现资源的快速释放和提供[9]。

本文通过虚拟化技术,将信关站基带处理单元虚拟化,进行资源整合,构建资源池。基于云计算平台,实现对虚拟基带资源池的管控,支持根据硬件负载情况的动态迁移功能。

1 虚拟基带资源池构建

基于内核的虚拟机(Kernel-based Virtual Machine,KVM)是一款Linux的开源虚拟化软件。在KVM中,虚拟机被视为常规的Linux进程,由标准Linux调度程序进行调度,虚拟机的每个虚拟CPU(vCPU)被视为一个常规的Linux进程。本质上,KVM是管理虚拟硬件设备的驱动,该驱动作为管理接口,负责虚拟处理器的创建、虚拟内存的分配、寄存器的读写以及虚拟处理器的运行[10-11]。

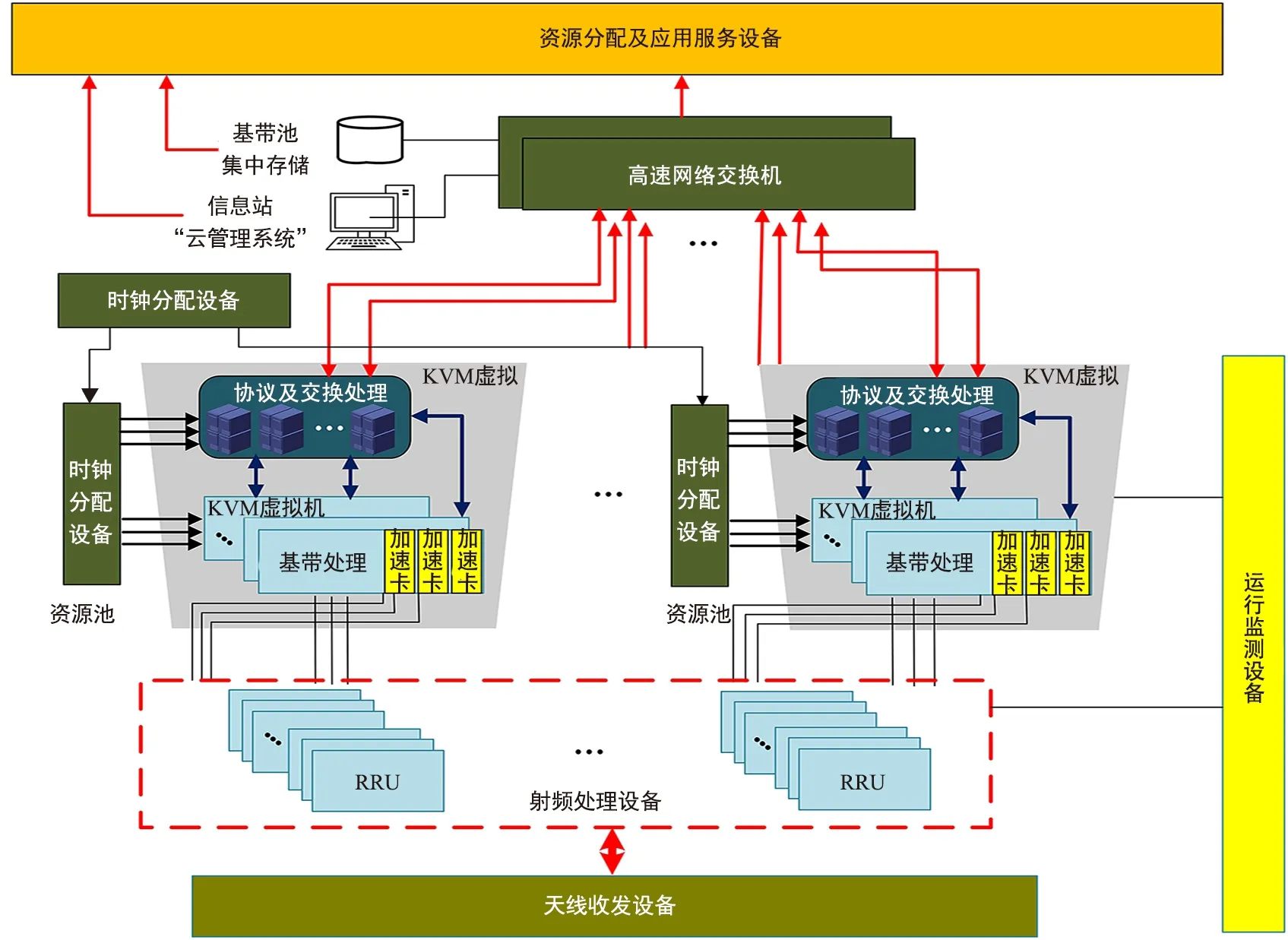

基于KVM的虚拟化技术的信关站总体架构如图1所示。部分基带处理以及协议与交换处理可通过KVM在基于X86架构的通用服务器集群上创建虚拟机,屏蔽物理设备的差异性,从而构建虚拟基带资源池。这不仅提高了物理设备资源的使用效率,还降低了卫星移动通信系统中信关站的能源开销,减少其建设费用和运营费用。

图1 虚拟化信关站总体架构Fig.1 Virtual gateway architecture

本文介绍基于KVM技术的信关站虚拟化平台架构和部署方式,并构建了测试平台,通过对虚拟化平台的负载性能测试和动态迁移性能测试验证了该虚拟化平台的资源和运行管控能力。

2 虚拟管控平台架构设计

2.1 虚拟管控平台总架构

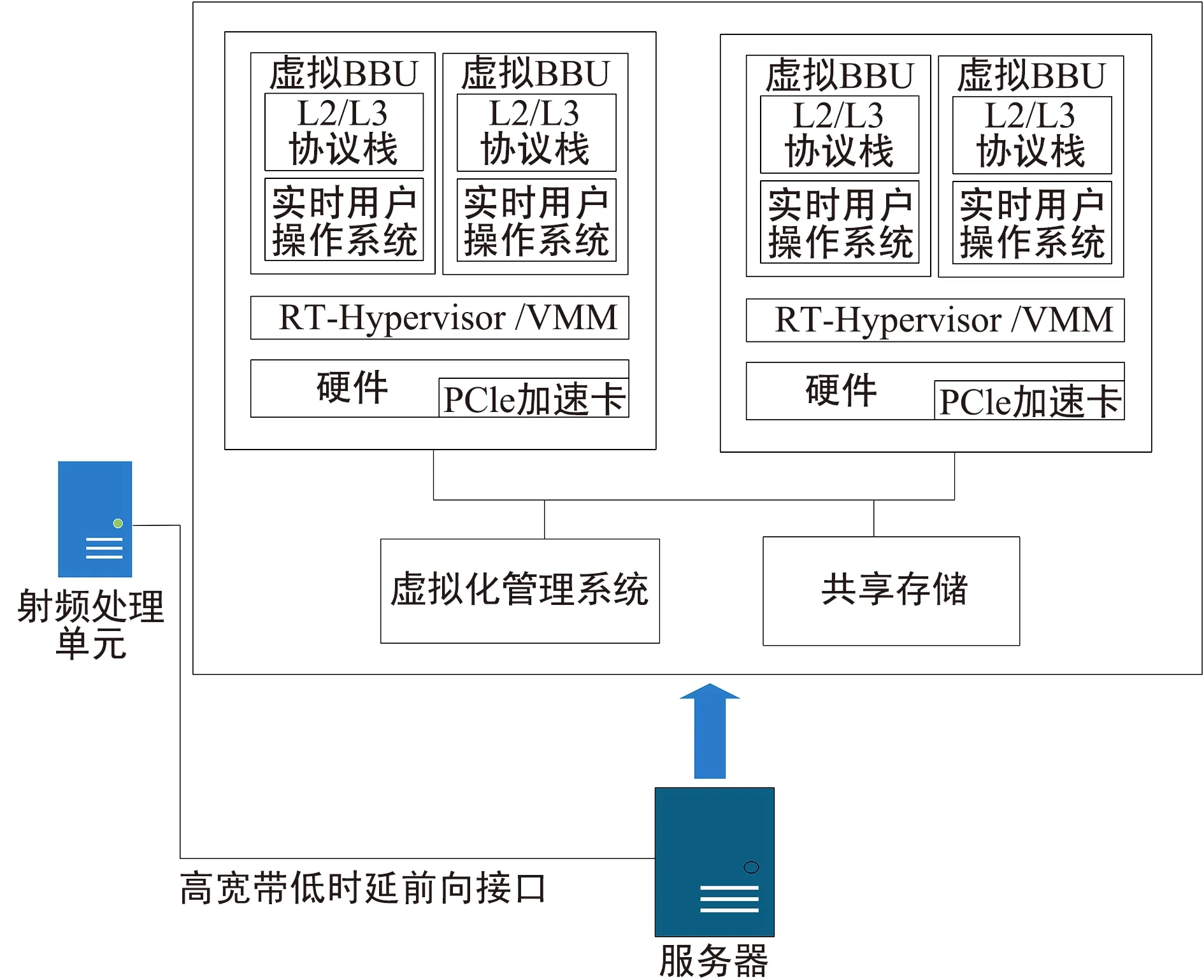

图2为信关站基带处理单元虚拟管控平台的架构图,图中管控平台是在基带处理通用服务器集群上构建虚拟层,并通过动态迁移实现资源管控。虚拟层上可运行多个虚拟机,一个虚拟机可处理一个BBU单元,也可处理L2/L3单元,虚拟机按照不同的粒度进行功能划分,有利于提高基带处理资源的利用率,从而提升虚拟化信关站的总体效能。

图2 信关站虚拟化架构图 Fig.2 Virtualization architecture diagram of gateway station

本文设计的虚拟化基带资源池通过OpenStack构建虚拟资源管控平台。OpenStack采用分布式架构,是一个开源的,旨在实现开放简单、具有大规模可扩展性及丰富特征集的云计算平台[12-13],虚拟管控平台按照功能的不同分为多个模块项目,可以根据实际需求进行项目组合,不同项目功能划分明确且耦合性低,OpenStack包含以下基本组件:

计算服务(Nova)在OpenStack中负责向用户按需提供不同规格的虚拟机。Nova的核心功能是将大量部署了KVM的物理服务器统一纳入管理,组成一个具有完整资源视图的逻辑资源池。在此基础上,Nova通过接收不同用户发起的请求,对资源池中的资源进行生命周期管理操作。

镜像服务(Glance)负责对系统中提供的各类镜像的元数据进行管理,并提供镜像的创建、删除、查询、上传及下载等能力。

身份认证服务(Keystone)负责对用户进行身份认证,并向被认定为合法的用户发放令牌。用户持Keystone发放的令牌访问 OpenStack的其他项目,以使用其提供的服务。

网络管理(Neutron)为用户提供不同层次的多种网络服务功能,包括L2组网、L3组网、内网DHCP管理、Internet浮动IP管理、内外网防火墙、负载均衡及VPN等。

用户界面(Horizon)提供基于Web自助服务入口连接底层的云计算服务,管理员可以管理云端服务当前的部署与状态[14-15]。

2.2 虚拟管控平台部署

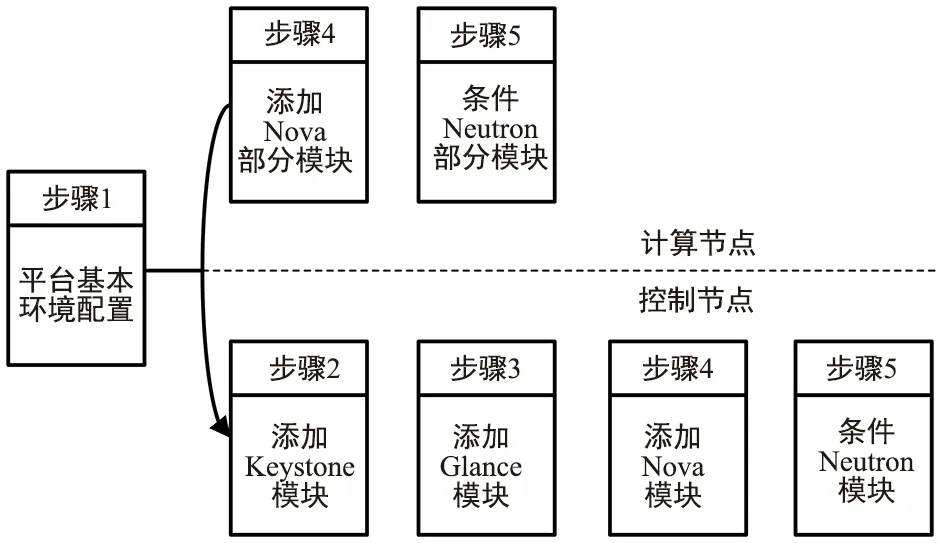

合理的部署架构是基带虚拟资源池稳定高效的基础,针对信关站基带处理单元多服务器环境,本文采用多节点的OpenStack部署架构。虚拟管控平台包含一个控制节点和两个计算节点共3台服务器。通过控制节点的Web界面对虚拟基带资源池进行管控。OpenStack的安装部署流程如图3所示。步骤1为基本准备阶段,需要网络时间协议、数据库等配置,以保证后续的服务模块正常运作。步骤2~5分别为添加身份认证、镜像服务,计算服务和用户界面,计算节点只需安装计算服务和网络服务的部分模块[16]。

图3 OpenStack部署流程 Fig.3 Deployment process of OpenStack

2.3 动态迁移方案

信关站虚拟资源池目的在于资源池内的资源共享,能够进行灵活调度,为此需要研究虚拟管控平台中的动态迁移方案。动态迁移是为了确保正常运行通过将虚拟机从一个物理机移动到另一个物理机时不会对虚拟机用户造成太大的影响[17],即保证资源灵活调度过程中,信关站服务的用户能够保持接续。本文将动态迁移所需要的源平台和目的平台的共用磁盘文件放置在一个共享存储节点(控制节点),实现数据的集中访问,减少调用过程中频繁传输对迁移性能造成的影响。本平台采用基于的客户端/服务器架构的NFS(Network File System)网络文件系统,支持通过网络实现跨物理机分享文件。动态迁移的实现主要涉及OpenStack的计算服务Nova。在迁移之前需要做好如下配置:① 指定vncserver_listen=0.0.0.0,以保证动态迁移正常工作;② 节点之间能够互相执行名称解析;③ 确保Nova和libvirt用户的UID和GID在各个节点之间相同;④ 确保可以免密码通过SSH实现节点的互通[18]。

3 虚拟化平台及管控平台动态迁移性能测试

3.1 虚拟化平台的负载性能测试

本节构建了信关站虚拟化基带资源池的测试环境,组建了虚拟化管控平台,分别测试同时运行1台、2台和4台虚拟机时,平台处理器、内存和磁盘I/O的性能。虚拟化平台的配置如下:

① 控制节点:处理器为Intel Core i5-6500,内存12 G,双网卡,ubuntu16.04操作系统;

② 计算节点:处理器为Intel Core i7-4770,内存8 G,双网卡,ubuntu16.04操作系统;

③ 虚拟客户机:vCPU均为1核,内存均为1 G,磁盘大小均为20 G,操作系统均为Ubuntu14.04。

本次测试将选取如下性能指标做分析:

① 处理器性能损耗:其中real time表示编译从开始到结束的总时间,包括期间其他进程所占用的时间和进程被阻塞的时间;user time表示被测试程序在用户模式下所占用的CPU时间,即进程执行的真正CPU时间;sys time表示进程在内核调用中所占用的CPU时间。

② 内存性能:内存的通信带宽表示内存的读取速度,访问操作时延表示存储数据的访问完成时产生的延迟,带宽值越大、延迟越低、内存性能就越好。

③ 磁盘IOPS和负载性能:IOPS指每秒的输入输出量或读写次数,是衡量磁盘性能的主要指标之一;负载性能是指在某项服务运行时,系统资源的使用情况,能反映出虚拟化平台在运行测试过程中不同负载情况下的承受能力。

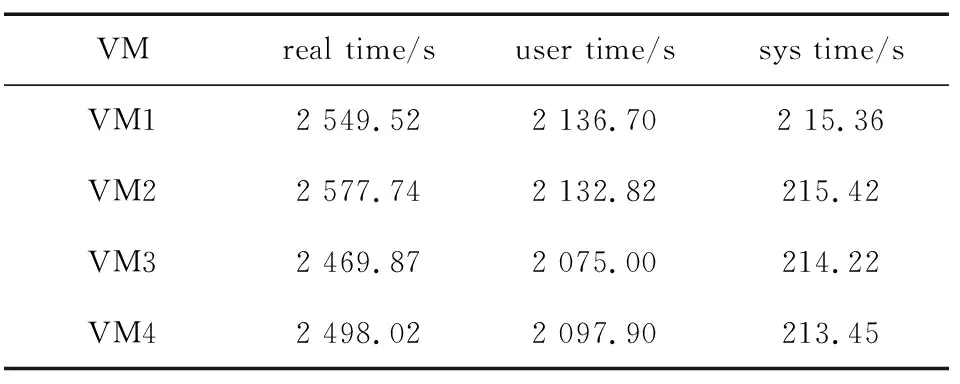

3.1.1 处理器性能损耗测试

虚拟化平台中分别同时运行1台、2台、4台虚拟客户机,每个客户机同时运行内核编译使CPU处于密集状态,观测虚拟化平台中内存的使用率由36.9%增长到76.6%,CPU的使用率由1.8%增加到24.7%,客户机的编译时间也逐渐增加。表1为虚拟化平台同时运行4台客户机编译所需时间。

表1 负载4台虚拟机的内核编译时间Tab.1 Kernel compilation time for 4 virtual machines

由于不同负载下每台客户机的编译所需时间相近,选取VM1的数据进行对比分析,如图4所示。每台虚拟机均处于CPU密集状态,随着负载数量增加,客户机编译内核的时间有所增加。对于虚拟机,同时运行4台虚拟机比运行1台虚拟机时处理器的性能有所下降,对于虚拟化平台,负载能力和内存及CPU利用率有所提高。

图4 不同负载下的VM1编译时间Fig.4 VM1 compile time under different loads

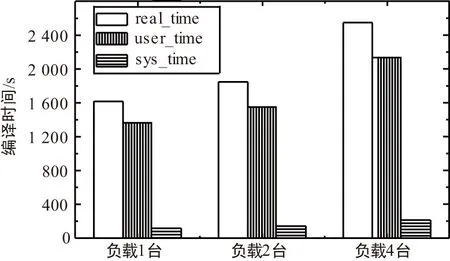

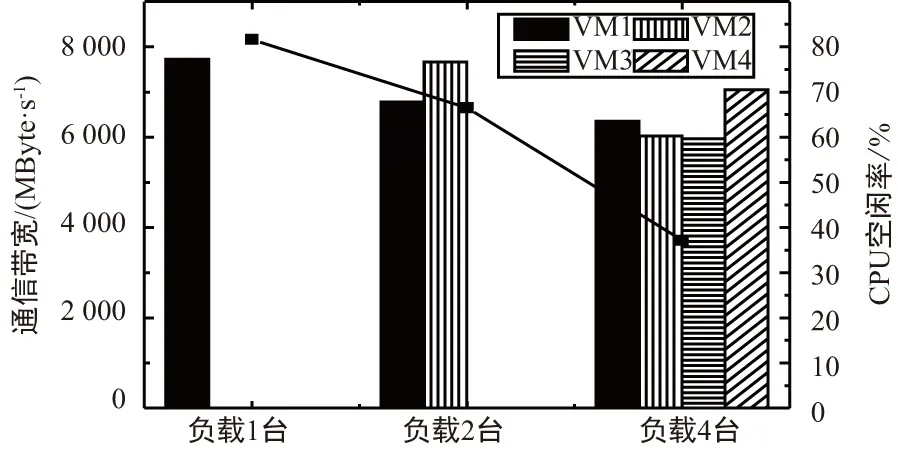

3.1.2 内存性能测试

选取内存测试工具LMbench,基于不同负载情况的虚拟化平台做测试,统计本地通信带宽、内存随机访问操作时延的数据。测试过程中,CPU空闲率从平台负载最小时的约81.6%到平台负载最大时的37.2%,有较大差距,说明在进行测试的过程中,负载的增加对平台的处理器性能产生较大影响。针对不同的负载平台,对本地通信带宽和操作时延两项数据进行分析,测试结果如图5和图6所示。

图5 不同负载下的本地通信带宽Fig.5 Local communication bandwidth under different loads

图6 不同负载下的内存随机访问操作时延Fig.6 Memory random access operation delay under different loads

以VM1为例,随着负载的增加,本地通信带宽呈现下降的趋势,而操作时延呈上升趋势。在高负载平台下,多个虚拟机同时进行页面的数据更新,相比于低负载平台情况产生了更多开销,出现较大时延,平台性能也会下降。

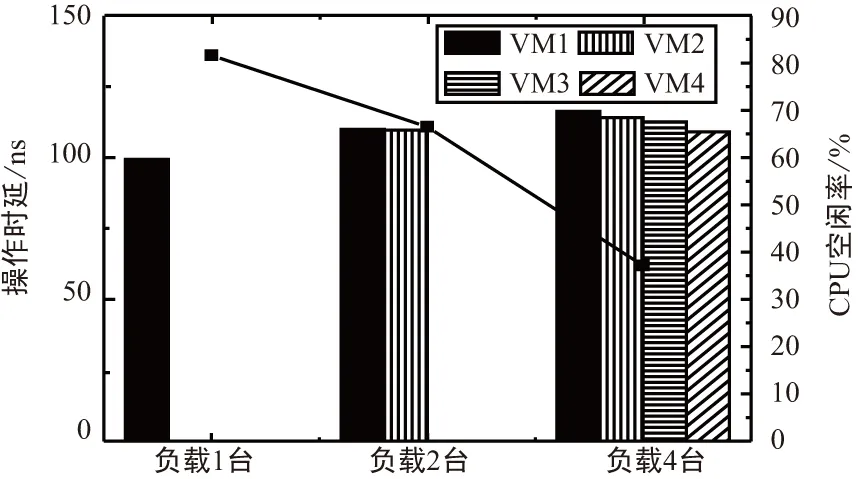

3.1.3 磁盘IO负载性能测试

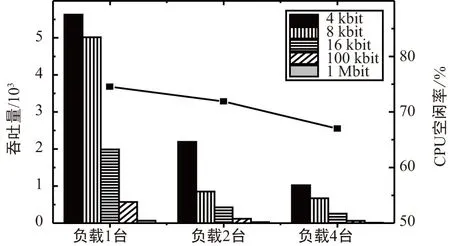

在不同负载情况的虚拟化平台中,分别以大小为4 kbit,8 kbit,16 kbit,100 kbit,1 Mbit的数据块进行读写操作,并对IOPS和CPU空闲率这两项的数据做统计。由于不同负载下的每台客户机的IOPS相近,故对于VM1基于不同负载环境下的IOPS值进行统计,如图7所示。

图7 不同负载下磁盘性能指标Fig.7 Disk performance index under different loads

随着虚拟化平台中负载的增加,CPU空闲率逐渐降低,说明当负载越高,虚拟化平台的处理器能力越处于高负荷状态。在相同负载情况下,单次I/O块文件越大,存储每秒主机访问次数就越少,IOPS越小;当负载增加时,出现不同虚拟机同时访问磁盘I/O的情况,从而导致通信阻塞,每个虚拟机的存储主机访问次数降低,IOPS值有不同程度的减小。说明虚拟化平台中,磁盘性能在一定程度上影响了数据读写。

3.2 动态迁移性能测试

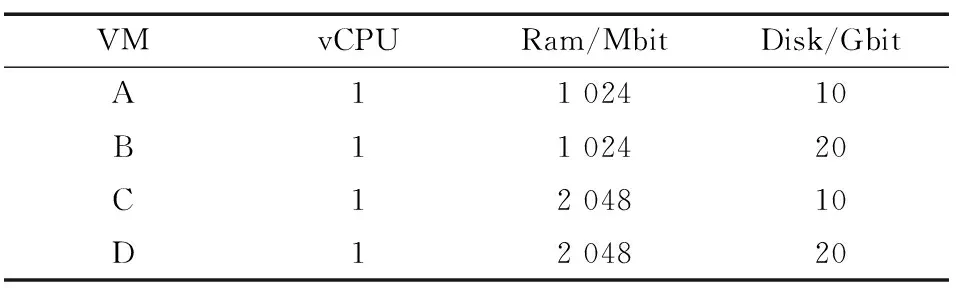

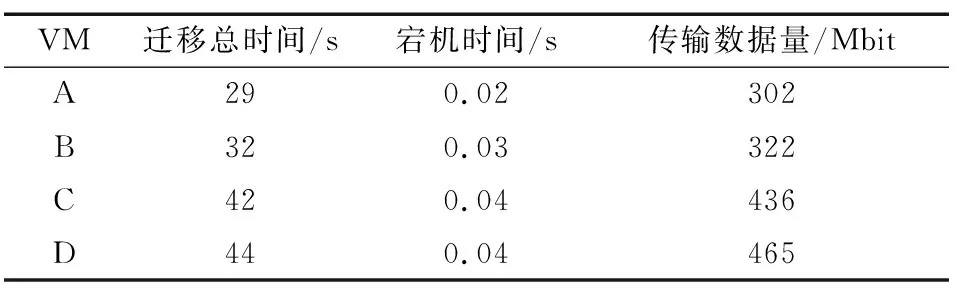

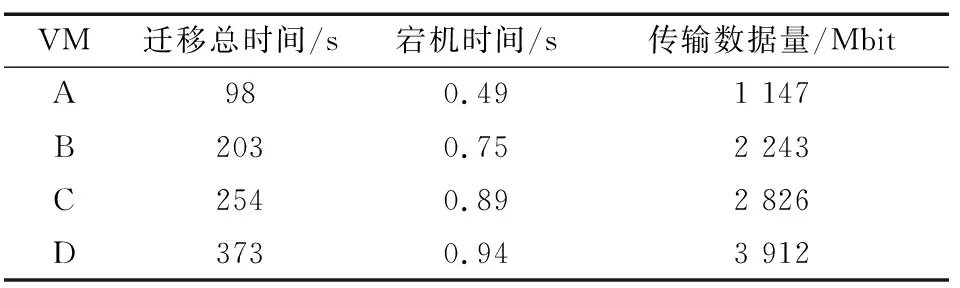

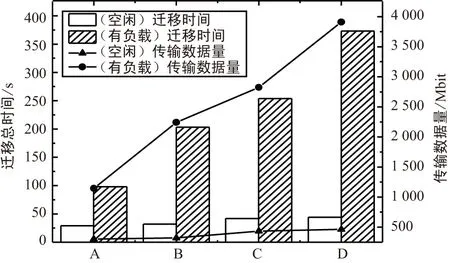

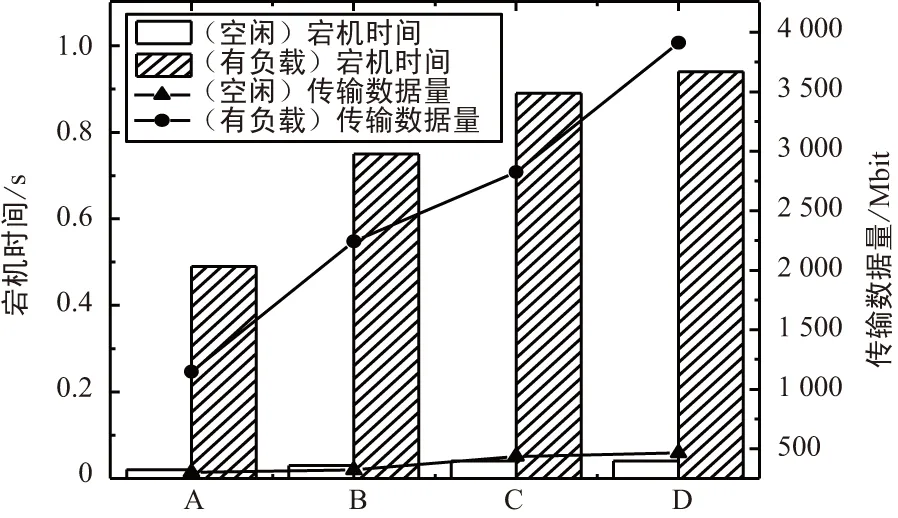

本文选取OpenStack作为虚拟基带资源池的管控平台,基于NFS共享存储的动态迁移,分别针对不同配置的客户机进行动态迁移,分析该管控平台中动态迁移性能。为减少误差,如表2所示虚拟机的配置,分别选取内存1 024 Mbit,2 048 Mbit及磁盘容量10 Gbit和20 Gbit的4种类型虚拟机作为测试样本,操作系统均为Centos7。针对虚拟机空闲状态和有负载(CPU使用率95%,内存使用率75%)的情况下,动态迁移性能测试。表3和表4是不同情况下的虚拟机动态迁移过程中对迁移总时间、宕机时间和传输数据量的统计。

表2 虚拟机配置Tab.2 Configuration of virtual machine

表3 空闲态下的动态迁移数据统计Tab.3 Statistics of dynamic migration data in idle state

表4 负载情况下的动态迁移数据统计Tab.4 Statistics of dynamic migration data under load

由图8和图9可知,虚拟机的内存大小和磁盘容量对迁移总时间和传输数据量均有一定的影响,而对于宕机时间影响不大。有负载的情况会导致相同配置的虚拟机在总迁移时间、宕机时间和传输数据量上存在较大差异。

图8 动态迁移总时间和传输数据量Fig.8 Total time of dynamic migration and the amount of data transferred

图9 动态迁移宕机时间和传输数据量Fig.9 Dynamic migration downtime and the amount of data transferred

4 结束语

基于KVM虚拟化技术,对信关站基带处理单元虚拟化进而构建虚拟基带资源池,可屏蔽物理设备之间的差异性,提高物理设备的使用效率。本文针对虚拟基带资源池的管控,提出基于OpenStack云计算平台的管控架构设计,可为信关站基带处理单元的实时管理和动态调度提供平台支撑。通过对虚拟平台性能测试和管控平台中动态迁移测试,验证了该方案具有一定的有效性与稳定性,从而可以有效降低设备的能耗和成本费用,增强对基带处理单元资源的灵活管控,本文的工作可为我国卫星移动通信系统信关站的建设提供技术和方案上的支持。