医疗保健中的人工智能—综述与预测性案例研究

2020-09-03荣国光ArnaloMenezElieBouAssi赵博MohamaSawan

荣国光, Arnalo Menez , Elie Bou Assi , 赵博, Mohama Sawan ,,*

a School of Engineering, Westlake University, Hangzhou 310024, China

b Institute of Advanced Study, Westlake Institute for Advanced Study, Hangzhou 310024, China

c Polystim Neurotech Laboratory, Polytechnique Montréal, Montréal H3T1J4, Canada

d Institute of VLSI Design, College of Information Science and Electronic Engineering, Zhejiang University, Hangzhou 310027, China

1. 引言

人工智能(artificial intelligence, AI)定义为机器的智能,而不是人类或其他生物的智能[1,2]。人工智能也可以定义为对“智能代理”的研究:任何能够感知和理解其周围环境并采取相应适当行动以最大限度地实现其目标的代理或设备都可以被称作人工智能[3]。人工智能也指机器在学习和分析过程中能够模拟人的思维,从而解决问题。因此,人工智能有时也被称为“机器学习”(machine learning, ML)[4]。

通常,人工智能涉及一个由软件和硬件组成的系统。从软件的角度来看,人工智能特别关注算法。人工神经网络(artificial neural network, ANN)是执行人工智能算法的概念框架[5]。这是一个模拟人脑的神经元网络,其中神经元之间有加权的通信通道[6]。一个神经元可以对来自邻近神经元的多个刺激作出反应,整个网络可以根据来自环境的不同输入改变其状态[7]。因此,神经网络(neural network, NN)可以产生输出作为它对环境刺激的反应,就像我们的大脑对不同环境变化的反应一样。神经网络通常是具有不同配置的分层结构。研究人员设计了能够进行三类功能的神经网络。①监督学习的神经网络:任务是根据输入和输出的示例推断一个函数,将输入映射到输出;②无监督学习:任务是从未标记、未分类的测试数据中学习,以识别数据中的共同特征,并且不是对系统反馈作出响应,而是根据已确定的共同特征在新数据中的存在或不存在作出反应;③强化学习:任务是在给定的环境中采取适当的行动,以最大化奖励和最小化惩罚,两者都具有某种累积性质[8]。随着计算能力的提高,神经网络变得“更深”,意味着更多的神经元参与到网络中来模拟人脑并进行学习。因此,产生技术术语“深度学习”[9,10]。

从硬件的角度来看,人工智能主要是在物理计算平台上实现神经网络算法。最简单的方法是在通用CPU上实现多线程或多核配置[7]。此外,对于大规模神经网络而言,GPU在卷积计算方面优于CPU [11]。有实验结果表明,CPU和GPU联合处理比单CPU处理效率更高,特别是对于脉冲神经网络[12,13]。此外,一些可编程或可定制的加速器硬件平台,如现场可编程门阵列(field programmable gate array, FPGA)和专用集成电路(application specific integrated circuits, ASIC),可以在计算能力、功率效率和外型尺寸方面以更高效的方式实现神经网络,以实现定制应用[14]。与GPU和CPU相比,这些平台可以针对特定的应用程序进行定制,因此比GPU和CPU更节能、更紧凑。如果需要在边缘设备[如无线网络中的移动电话或物联网(internet-of-things,IOT)中的传感器节点]中部署人工智能,则需要进一步提高电源效率和减小外型尺寸。研究人员尝试使用模拟集成电路[15,16]、自旋电子学[17]和记忆电阻器[18-20]来实现人工智能算法。其中一些新的平台,如记忆电阻器交叉线电路[21],可以将计算与内存合并,从而避免了传统von Neumann体系结构的“内存墙”问题。此类内存访问是更新计算所需参数而必须完成的操作。最近,研究人员试图通过减少用于数据表示的位数来提高人工智能实现的效率。结果表明,当数据表示从32位或16位下降到8位时,仍可以保持相当的计算精度。其优点是计算速度更快、功率更小、外形尺寸更小[22]。然而,“内存墙”的限制依然存在。另一方面,采用适当的训练方法,如深度而不是表面水平的训练[23]、预训练技术 [24],以及平衡的数据集[25]、足够的数据集[26]和恒定的数据集可用性[27]都是提高人工神经网络性能的重要考虑因素。

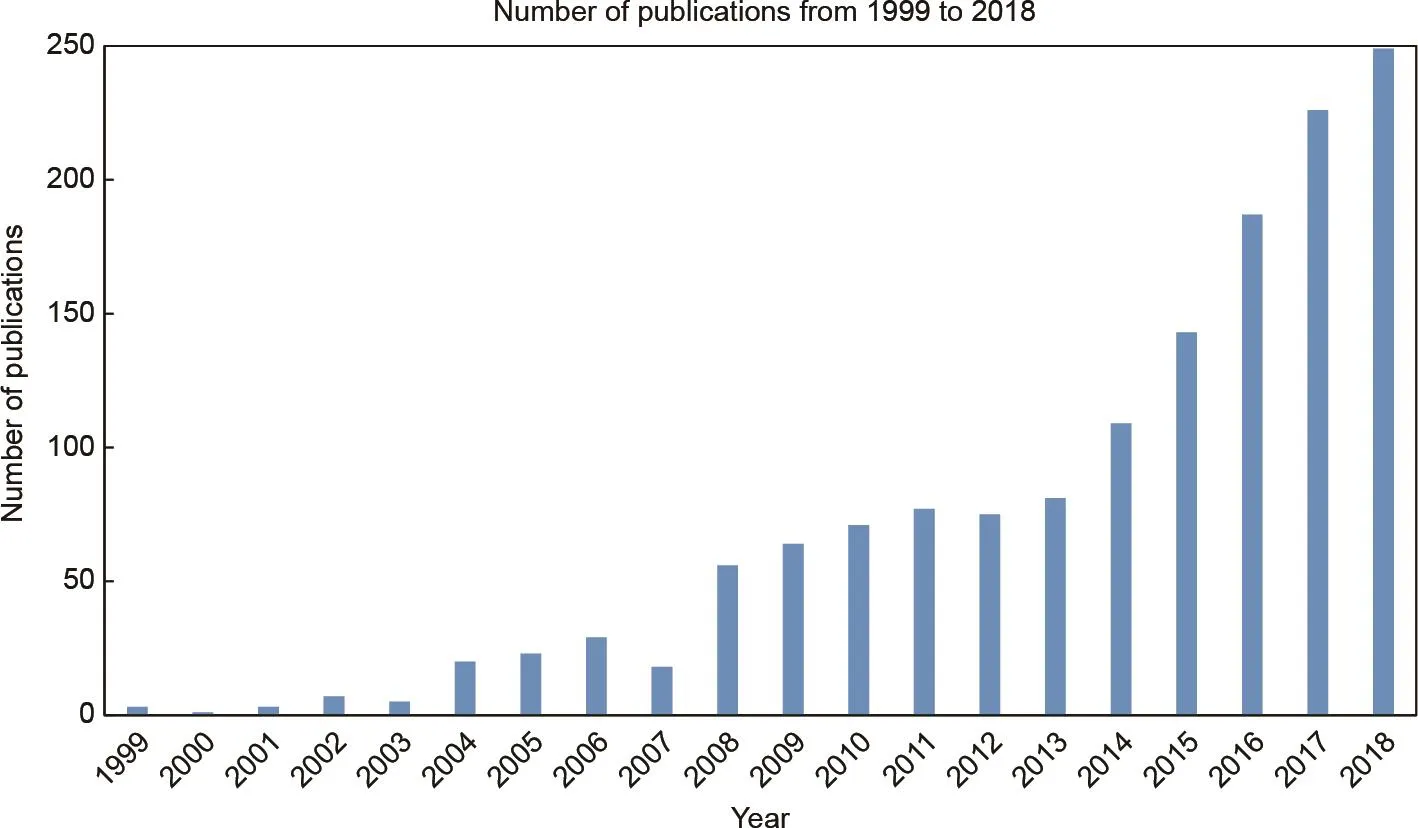

由于人工智能技术在软件和硬件方面的快速发展,它已被应用于各种技术领域,如物联网[28]、机器视觉[29]、自动驾驶[30,31]、自然语言处理[32,33]和机器人[34]。最有趣的是,生物医学领域的研究人员一直在积极尝试应用人工智能来帮助改善分析和治疗结果,从而提高整个医疗行业的效果[35-37]。图1显示了1999—2018年这一领域过去20年的出版物数量。从图中可以看出,此领域的研究兴趣有明显的增长,特别是在过去5年,增长非常突出。可以预测,该领域未来还将呈现出持续增长。早在几十年前,就有人设想了人工智能对生物医学的帮助[38]。事实上,一些已发表的综述论文回顾了人工智能在生物医学工程中的作用[36,37]。近年来,人工智能及其在生物医学中的应用取得了新的进展。

本文综述了人工智能在生物医学中应用的最新突破,包括生物医学工程和医疗保健的主要领域。

图1 . 近20年来,有关人工智能在生物医学中应用的研究越来越受到关注,这一问题的出版物数量也证明了这一点。文献检索是由Web of Science以“Artificial Intelligence”或“Machine Learning”为主题,并以“Biomedicine”或“Biomedical”为主题进行的。

医疗保健的目标是变得更加个性化、预测性、预防性和参与性,人工智能可以在这些方面做出重大贡献。从所取得的进展来看,我们估计人工智能将继续发展和成熟,成为生物医学的强大工具。本文的其余部分阐述了主要的人工智能应用,其中第2节的主题是信息处理和算法实现,第3节的主题是疾病诊断和预测,第4节报道了两种医疗疾病预测的案例研究,最后,第5节阐述结论和总结。

2. 信息处理与算法实现

人工智能在生物医学中的主要应用可分为4类。本节介绍的前三类方法旨在有效地处理大数据,并快速访问以解决与医疗保健相关的问题。这些应用涉及老年人和残疾人的生活辅助、自然语言处理技术和基础研究活动。人工智能的最后一类应用涉及疾病的诊断和预测,这部分将在第3节中进行分析。

2.1. 生活辅助中的人工智能

在老年人和残疾人生活辅助领域,使用相应智能机器人系统的人工智能应用程序正在为提高此类人群的生活质量铺平道路。最近发表的一篇综述介绍了为失去生活自理能力的人提供的智能家居功能和工具,以及基于无线传感器网络、数据挖掘和人工智能的智能解决方案模型[39]。神经网络可以通过特定的图像处理步骤进行训练,以将人类面部表情识别为命令。基于面部表情分析的人机界面(human machine interface, HMI)允许残疾人在没有操纵杆或传感器连接到身体的情况下控制轮椅和机器人辅助车辆[40]。

一个被称为“RUDO”的“环境智能系统”可以帮助盲人更好地融入视力正常的人的生活,并允许盲人在信息和电子等专业领域工作[41]。盲人可以通过一个单一的用户界面使用这个智能助手的多种功能。基于人工智能的“智能助手”可以帮助孕妇在分娩的关键阶段提供饮食和其他必要的建议。基于自身智能,并结合“所有相关人员之间的基于云的通信媒体”,它能够提供“高水平”的建议[42]。

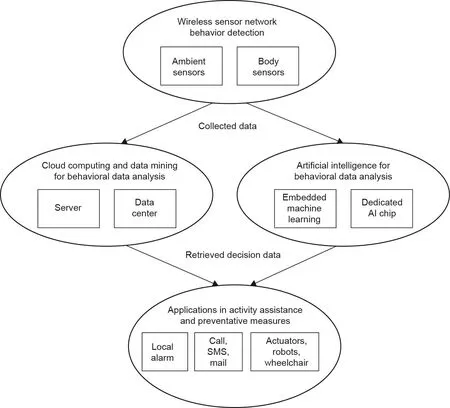

基于雷达多普勒时频信号和稀疏贝叶斯分类器的坠落检测系统可以降低老年人坠落的风险和并发症[43]。事实上,有报道已成功开发“环境辅助生活”(ambient assisted living, AAL)的“智能通信架构”系统,允许人工智能处理从不同通信渠道或技术收集的信息,从而确定网络环境中事件的发生和老年人的辅助需求[44]。智能家居引入的“环境智能”可以为老年人提供活动意识和后续活动帮助,这使得“就地养老”即在家养老在AAL环境下得以实现。例如,对老年人活动有意识的“筛选活动受限和安全意识”(screening of activity limitation and safety awareness, SALSA)智能机可以帮助老年人进行日常药物治疗活动[45]。此外,基于机器学习的运动分析和步态研究有助于警报危险行为并激活预防措施[46,47]。图2 [39]显示了环境辅助生活的模型。

在该情况下,传感器收集有关环境和人类行为的数据,然后通过云计算或边缘智能进行分析,最后决定需要采取哪些措施,并使用这些措施来激活警报或预防措施。基于人工智能的专家系统结合移动设备和个人数字助理(personal digital assistant, PDA),可以帮助记忆受损的人增强记忆能力,从而实现生活自理[48]。这是面向“非专家”用户的“记忆恢复专家系统”(expert system for memory rehabilitation, ES-MR)的重要扩展。

2.2. 生物医学信息处理中的人工智能

自然语言处理在生物医学应用方面已取得了一些突破。在生物医学问题解答(biomedical question answering, BioQA)领域,需要从文档和数据集的存储库中快速、准确地找到用户提出的问题的答案。因此,可以期望自然语言处理技术能够搜索富含信息的答案[49]。首先,需要将生物医学问题分为不同的类别,以便从答案中提取适当的信息。机器学习可以将生物医学问题分为4种基本类型,准确率接近90% [50]。然后,智能生物医学文献检索系统可以有效地检索最有可能包含生物医学问题答案的部分文献[51]。一种处理4种基本生物医学问答类型之一的新方案,即基于单词情感分析的“是”或“否”的答案生成器,可以有效地从二进制答案中提取信息[52]。

生物医学信息处理中一个非常重要的任务是收集较长的时间段内不同来源的临床信息,并进行信息合并、比较和冲突解决[53]。长期以来,这是一项由人来完成的耗时、费力且不令人满意的工作。人工智能已被证明能够高效率和准确地完成这些任务,其结果与专业评估人员所能做到的一样准确[54]。此外,需要对医学叙述数据进行自然语言处理,以使人类从跟踪时间事件同时保持结构和前因后果的挑战性任务中摆脱出来[55]。机器学习可用于处理高度复杂的临床信息(如文本及其各种相关的生物医学数据),将逻辑推理纳入数据集,并将所学知识用于多种目的[56]。

图2 . 一种适合当地老龄化的环境辅助生活模式原型[39]。SMS:短消息服务(short message service)。

2.3. 生物医学研究中的人工智能

除了能够作为疾病诊断、管理和预后的电子医生“eDoctor”,人工智能作为生物医学研究中的一个强大工具还有未被探索的用途[57]。在全球范围内,生物医学研究和创新活动中的人工智能可以加速学术文献的筛选和索引[58,59]。在这个方向上,最新的研究课题包括肿瘤抑制机制[60]、蛋白质-蛋白质相互作用信息提取[61]、人类基因组遗传关联的生成以帮助将基因组发现转移到医疗实践[62]等。在文献总结方面,生物医学研究人员可以有效地借助基于语义图的人工智能方法,对给定感兴趣的主题完成要求较高的任务[63]。此外,在论文数量超出可读性时,人工智能不仅可以帮助生物医学研究人员搜索到感兴趣的文献,还可以对其进行排序。这使得研究人员可以制定和测试切题的科学假设,这是生物医学研究的一个非常重要的部分。例如,研究人员可以在人工智能的帮助下,在不断增加的文献量中筛选和排列感兴趣的图表[64],以制定和测试假设。

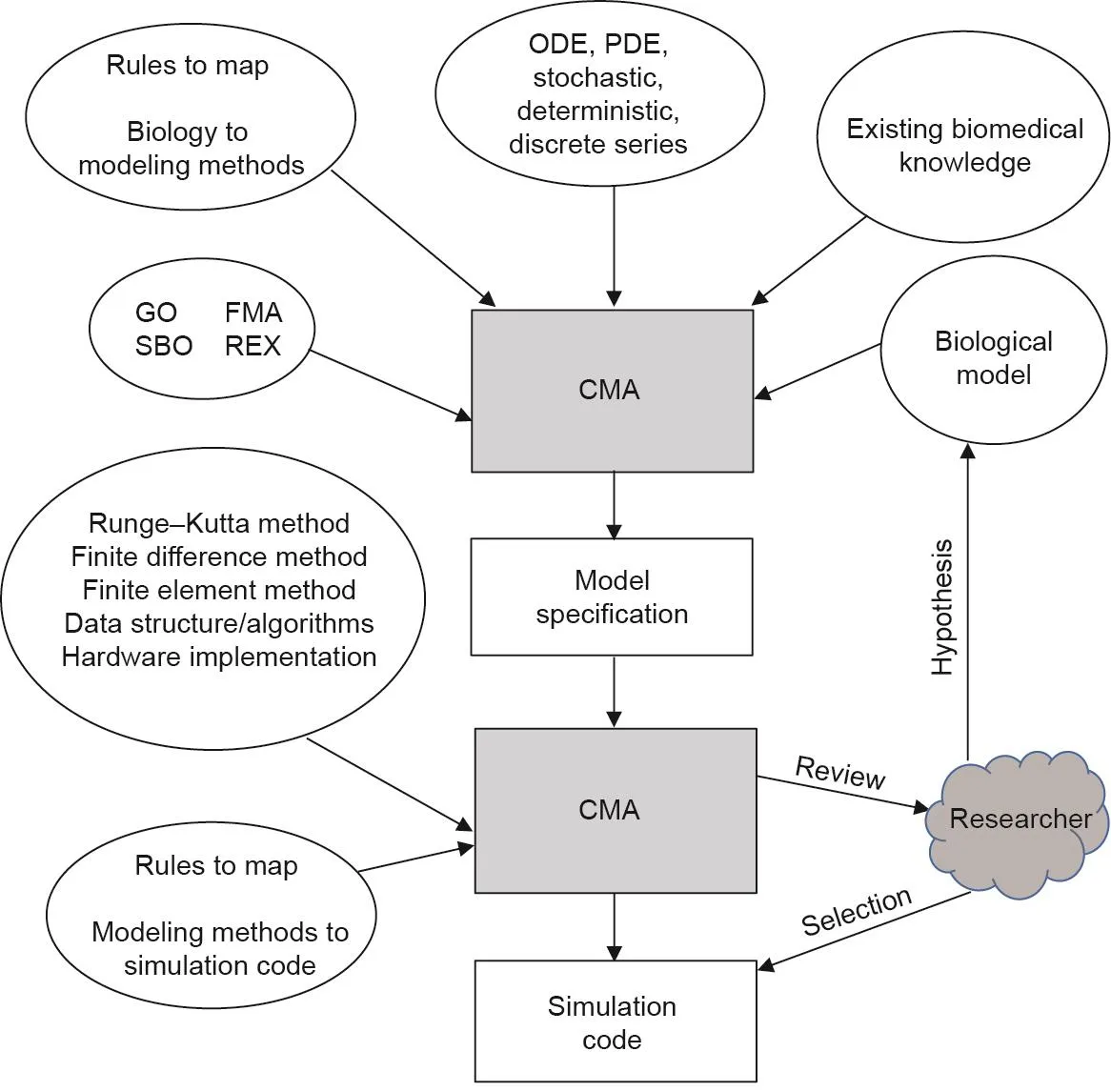

一些智能医疗设备正变得越来越“有意识”[65,66],可以在生物医学研究中对这种“意识”进行探索。被称为“计算建模助手”(computational modeling assistant,CMA)的智能代理可以帮助生物医学研究人员从他们的概念模型中构建“可执行”的模拟模型[67]。图3 [67]显示了CMA与人类研究人员之间的流程和交互的总体图。CMA拥有各种知识、方法和数据库。研究者的假设被表示为生物模型,也被提供给CMA作为输入。CMA的智能使所有这些知识和模型得以整合,并将研究者的假设转化为具体的模拟模型。然后,研究人员审查并选择最佳模型,CMA为所选模型生成仿真代码。通过这种方式,CMA能够显著加快研究过程并提高产出率。此外,一些具有直觉的机器可以指导生物医学成像、口腔外科和整形外科等领域的科学研究[68,69]。为了更好地理解这一发展的影响,有学者对人类意识和机器意识及其与生物医学工程的相关问题进行了讨论[70]。

3. 疾病诊断与预测

图3 . 从各种本体和知识数据库的角度[68],对研究者和CMA之间的过程流和相互作用进行了一般性的展望。ODE:常微分方程(ordinary differential equation);PDE:偏微分方程(partial differential equation);GO:基因肿瘤学(gene oncology);FMA:解剖学本体基础模型(foundational model of anatomy ontology);SBO:系统生物学本体(systems biology ontology);REX:物理化学过程本体(physicochemical process ontology)。

在生物医学领域,疾病诊断对人工智能有最迫切的需求。这一领域取得了许多有趣的突破。人工智能使卫生专业人员能够对多种疾病进行早期和更准确的诊断[71]。一类主要的诊断是基于使用生物传感器或生物芯片的体外诊断。例如,基因表达,这是一个非常重要的诊断工具,可以通过机器学习进行分析,其中人工智能解释微阵列数据以分类和检测异常[72,73]。另一个新的应用是将癌症微阵列数据分类用于癌症诊断[74]。

生物传感器和相关的床边诊断系统(point-of-care testing, POCT)在集成人工智能后,可用于早期诊断心血管疾病[75]。除了诊断,人工智能还可以帮助预测癌症患者的生存率,如结肠癌患者[76]。研究人员还发现了机器学习在生物医学诊断中的一些局限性,并建议采取措施将这些缺陷的影响降到最低[77]。因此,人工智能在诊断和预测方面仍有很大的潜力。

另一类重要的疾病诊断是基于医学成像(二维信息)和信号处理(一维信息)。这些技术已被用于疾病的诊断、管理和预测。在一维信号处理方面,人工智能已应用于生物医学信号特征提取[78],如脑电图(electroencephalography, EEG)[79]、肌电图(electromyography,EMG)[80]和心电图(electrocardiography, ECG)[81]。脑电图的一个重要应用是癫痫发作的预测。预测癫痫发作对减少其对患者的影响具有重要意义[82]。近年来,人工智能被公认是精确可靠的预测系统的关键要素之一[83,84]。现在可以通过深度学习进行预测[85],预测平台可以部署在移动系统中[86]。人工智能还可以在基于生物医学图像处理的诊断中发挥重要作用[87]。人工智能已被用于图像分割[88]、多维成像[89]和热成像[90],以提高图像质量和分析效率。人工智能还可以部署在便携式超声波设备中,这样未经训练的个人就可以使用超声波在欠发达地区作为诊断多种疾病的强大工具[91]。

除上述应用外,人工智能还可以帮助标准决策支持系统(decision support system, DSS)[92,93]提高诊断准确性,促进疾病管理,减轻人员负担。例如,人工智能被用于癌症的综合管理[94],支持热带疾病[95]和心血管疾病[96]的诊断和管理,支持诊断的决策过程[92]。所有这些应用都表明,人工智能可以作为一个强有力的工具,用于早期和准确的诊断、管理甚至预测疾病和患者状况。本文给出两个案例研究,详述如下。

4. 医疗卫生

人工智能正在覆盖广泛的医疗保健应用[97]。特别是,它被用于信号和图像处理,以及人体功能变化的预测,如膀胱控制[98]、癫痫发作[99]和中风预测[100]等。下面我们将介绍两个典型的案例研究,即膀胱充盈和癫痫发作预测。

4.1. 膀胱容积预测

当由于脊髓损伤或其他神经系统疾病、健康状况或老化导致膀胱储存和排尿功能失效时,会发生各种并发症,影响患者的健康状况。目前,可以通过植入式神经刺激器来实现药物难治性患者膀胱功能的部分恢复。为了通过有条件的神经刺激来提高所使用的神经假体的效率和安全性[101],需要一种检测存储尿液的膀胱传感器来提供一种反馈装置,仅在需要时才应用电刺激。该传感器还可用于感觉受损的患者在需要排空膀胱时或在不完全排尿后残余排尿量异常高时通知患者。

我们提出了新的方法[102]并开发了一个专用的数字信号处理器[103],利用膀胱中普通的神经根(机械感受器)的传入神经活动来检测尿液中的压力和充盈度,并可描述填充过程中的变化。

智能神经假体通常由两部分组成:一部分植入患者体内;另一部分作为可穿戴设备携带。这两个装置通常通过无线链路连接,该链路将数据和能量传输给植入物。内部单元执行多种功能:神经信号记录;传递感觉信息之信号的芯片内处理(取决于应用的不同程度);使用功能电刺激(functional electrical stimulation, FES)技术对适当神经进行神经刺激;与外部单元通信;植入装置的逻辑控制功能。当需要额外的信号处理来执行更复杂的算法时,需要额外的计算能力。由于尺寸、功耗、温升、电磁放电等原因,有些算法不适合在植入物内执行。内部单元将记录的信号发送给外部单元,外部单元将执行更复杂的计算,并将返回适当的神经刺激命令。外部基站集成了植入物用户界面和植入物计算机界面,以提高灵活性。

本节所述的工作旨在设计一种有效的膀胱植入式容积和压力传感器,能够向神经假体提供必要的反馈。该传感器最终可用于实施条件神经刺激方法以恢复膀胱功能,或用于对因上述几种疾病和条件而感觉受损的患者进行膀胱充盈感测。为了更好地满足患者对膀胱神经假体装置的需求,我们选择在植入式装置中实施一个优化的数字信号处理器,能够实时解码膀胱压力和容量。这种方法极大地影响了下面描述的最合适的预测方法的选择。

我们提出了基于机器学习算法的定性和定量监测方法,对膀胱自然传感器(即响应膀胱壁伸展的机械感受器)产生的神经传入活动进行解码。为了实现这些方法,需要对植入单元记录的神经活动进行检测、鉴别(分类),然后实时解码。提出的定性方法仅在三个层面(即低、中、高)对膀胱充盈度进行解码。这种方法允许使用更少的硬件资源并显著减少运算量,从而使功耗最小化。定量方法需要更复杂的算法来计算膀胱体积或压力,以反馈神经刺激的闭环系统,但由于采用了定制的硬件,因此在植入装置中可以以最小功耗运行。

用于定性和定量方法的监控算法首先实时执行离线学习阶段(也称为训练阶段)。在此阶段,传感器学习或识别用于实时监控的参数。在学习阶段,我们可以选择最好的算法,不管它们的复杂性和执行时间如何,因为它们是在通过外部单元连接到植入物的计算机中离线执行的。由于学习阶段的存在,我们可以将复杂度和硬件负担转移到离线处理中,从而使实时监控阶段能够以较低的复杂度和有效的预测算法以及优化的功耗来实现。学习阶段包括6个方面。

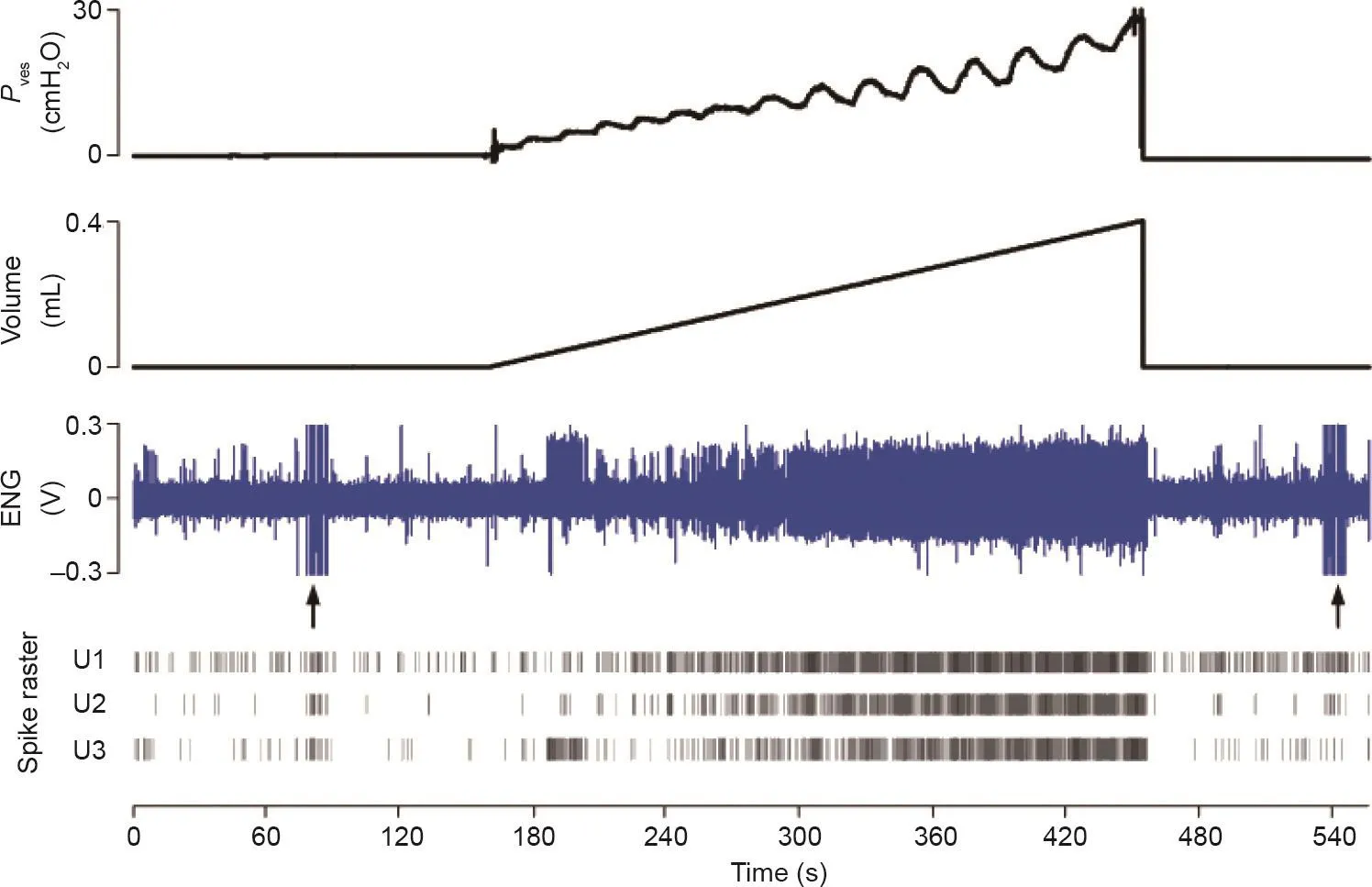

(1)数字数据调节:带通滤波、带非因果线性相位有限脉冲响应(finite input response, FIR)滤波器。

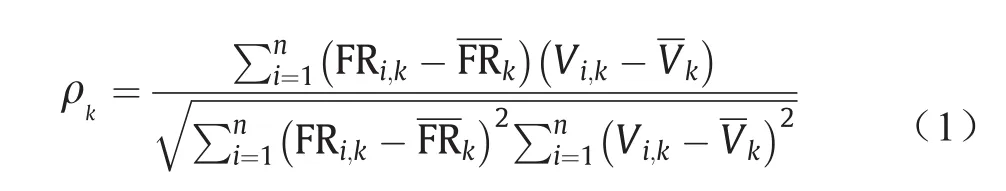

(2)识别与膀胱容积和(或)压力最相关的传入神经活动(图4所示示例中的单元1)。使用斯皮尔曼等级相关系数(ρ)而不是皮尔逊(线性)相关系数,因为前者更倾向于评估单调依赖性,而不一定是线性的,这提高了我们估计方法的鲁棒性。等式(1)用于计算斯皮尔曼等级相关系数:

式中,ρk为k类单元的斯皮尔曼系数;k为检测到的等级数;n为沿记录信号使用的时间帧数,此后称为帧数;FRi,k为装置使用的每秒放电率;Vi,k为同一帧数的平均体积;分别为相对k级的所有放电率和容积帧数的平均值。

(3)本底神经活动的计算:本底基线是由膀胱充装生理盐水前60 s的神经放电率(firing rate, FR)的平均值计算得到。

(4)使用帧数进行容积曲线量化。结果在有限数量的帧数中,选择适当的宽度,并以此定义为帧宽(bin width, BW)。

(5)FR积分:计算帧数内的FR(即所选单元帧数内检测到的尖峰数量),此后称为帧数积分率( bin-inte-grated-rate, BIR)。

图4 . 在膀胱缓慢填充中记录的传入活动记录(ENG),同时显示了识别的三个单元的尖峰扫描。在本例中,第1单元的活动与膀胱容积的相关性最好。ENG:电神经图;Pves:膀胱压力;U1:第1单元;U2:第2单元;U3:第3单元。

(6)体积或压力预测。如前所述,我们使用两种算法进行膀胱体积或压力预测,定性预测三个级别的膀胱充盈度,另一个用于量化。下面简要介绍两种算法。

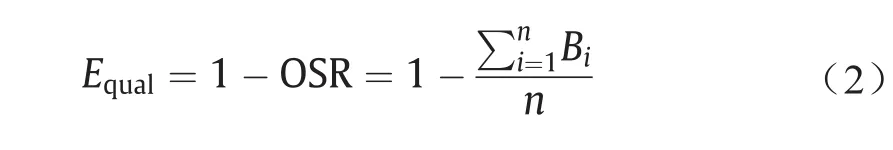

定性容积或压力预测算法预测三个代表膀胱充盈度的水平(低、中、高):低容积(舒适水平)、需要排空的容积水平(在预定的时间内)以及促使排空的高容积(尿液泄漏的风险)。设定的阈值对应于膀胱容积的0.25倍、0.5倍和1.0倍。通过在学习阶段使用基于线性回归的算法,我们计算了上述三个充盈度的BIR0.25、BIR0.5和BIR1.0。最后,通过在实时计算的BIR内找到最小距离,并存储参考值(BIR0.25、BIR0.5和BIR1.0),实现了定性体积或压力预测。基于这种方法,每个帧数被分配到三个充盈度级别中的一个。为了找到最佳的帧数长度,使用不同的间隔对帧宽BW进行扫描,并使用等式(2)得出最佳(最低)定性估计误差(Equal)。为了计算等式(2)中的Equal,我们计算了总体成功率(overall success rate,OSR)[104],即状态的所有良好分类与所有执行分类的比率。OSR是通过添加Bi并除以帧数的总数(n)来评估的,Bi是估计状态与实际状态匹配的帧数的数量。

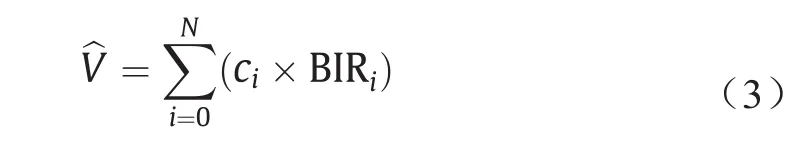

为了实现定量的体积和压力估计,利用较少的硬件资源,采用回归方法模型,如等式(3)所示:

式中,为估算体积;BIR如上文所定义;ci为回归模型系数。我们使用双夸尔鲁棒拟合方法来计算ci,并将异常值的影响最小化[105]。通过对动物模型的真实神经记录进行模拟(试验),得出回归模型的最佳顺序(N),如等式(3)所示。通过多次模拟试验,我们选择了最小N和最短BW,其估计误差最小。

用代替,等式(3)也可用于估算压力。压力估计所需的参数也可以在学习阶段计算。

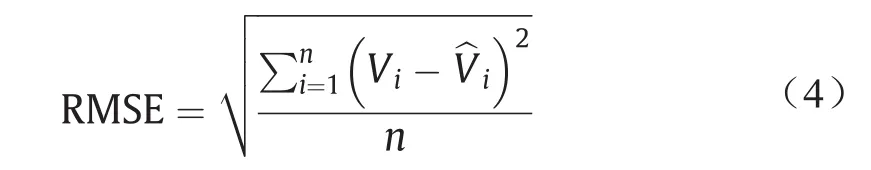

我们使用均方根误差(root mean square error,RMSE),这是用式(4)计算的,用于在实时测试运行中验证算法,在等式(4)中,Vi为帧数i的当前体积(或压力Vi);(或)为使用等式(3)计算的相同帧数i的体积(或压力)估算值;n为帧数的总数。

实时监测阶段运行以下步骤:①数字非因果滤波;②动态尖峰分类;③使用最佳BW进行BIR计算;④将BIR与基线进行比较,并对于较低值将体积设置为0,如果BIR较高,则继续;⑤使用等式(3)计算膀胱体积或压力。如图5 [106]中的示例所示,我们执行了几个运行来测试和验证算法。

图5 . 模拟实时数据处理实验中的定量体积估计[106]。第一个测量周期被用作一个训练阶段,随后是两个连续的周期,其中体积是从训练阶段计算出来的。使用6阶回归模型,该纤维的最佳BW为47 s。第一个周期的拟合误差和后两个周期的估计误差都很小,各周期的RMSEall分别为2%、3.9%和4.1%。

最后,利用麻醉大鼠的急性实验数据验证了所有的算法。有关这些实验和预测算法的更多详细信息,请参见文献 [102]。

当记录的输入活动显示斯皮尔曼相关系数为0.6或更好时,我们成功地在100%的试验中定性预测膀胱充盈的三种状态。我们还成功地利用适当选择的时间窗定量预测了膀胱容积和压力。

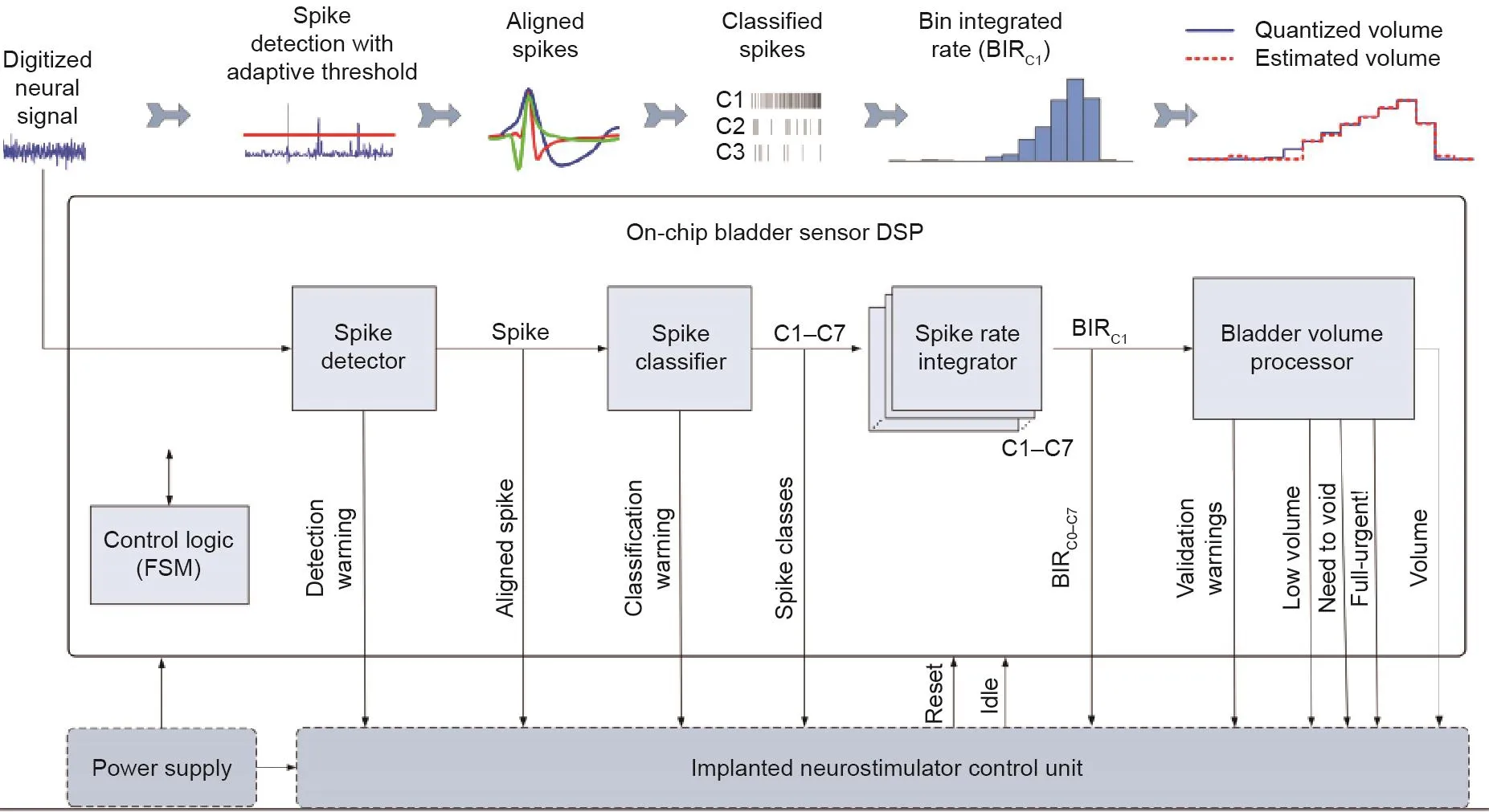

我们实现了一个专用的数字信号处理器(digital signal processor, DSP),如图6 [106]所示,运行上述算法用于监控膀胱容积或压力。DSP实时运行膀胱传入神经活动的动态尖峰分类和感测解码,以预测本节所述的体积或压力值。使用合成数据(已知先验基础事实)和来自膀胱传入神经的急性实验记录的信号验证专用DSP。

动态峰值排序算法在专用DSP上运行,与文献[103]中报道的其他工作相比具有优势。即使使用由高相关峰值波形和低信噪比(signal-to-noise ratio, SNR)组成的复杂合成信号,我们也获得了更高的精度(92%)。体积或压力预测模块在定量和定性估计方面的准确率分别为94%和97%。

4.2. 癫痫发作预测

癫痫是一种神经退行性疾病,是最常见的神经疾病之一,其特征是自发、不可预测和反复发作[107,108]。虽然首选治疗方案包括长期药物治疗,但药物治疗对超过1/3的患者是无效的。

另一方面,由于癫痫手术成功率非常低,并且伴有并发症,求助于癫痫手术的患者比例仍然相对较低。一个有趣的研究方向是探索预测癫痫发作的可能性,如果可行的话,可能会促使制定替代性干预策略[83]。虽然早期癫痫预测的研究可以追溯到20世纪70年代[109],但癫痫事件的数量有限、颅内脑电图(intracranial electroencephalography, iEEG)记录的缺乏以及发作间隔期的有限程度一直是充分评估癫痫预测表现的主要障碍。

有趣的是,通过ieeg.org在线门户网站[110]可获取植入动态监测装置(NeuroVista)的天然癫痫犬的iEEG信号。然而,癫痫发作区并未公开或可用。我们课题组已经调查了利用上述犬类数据预测发作的可能性。随后,我们对位于癫痫网络内的电极进行了基于直接传递函数(directed transfer function, DTF)的定量识别[111]。采用遗传算法对发作前状态的特征进行选择。提出了一种新的拟合函数,该函数对偏态数据分布不敏感。研究显示,在预警时间占比为10%的情况下,平均敏感度为84.82%,提高了先前的癫痫预测性能[111]。

为了寻找癫痫发作预测的新机会,我们还探索了基于高阶谱分析的新特征来跟踪癫痫发作前状态。然后将提取的特征作为多层感知器的输入进行分类。我们的初步发现显示,使用三种双谱提取特征中的每一种,发作间隔期和发作前状态之间存在显著差异(p< 0.05)。平均振幅、归一化双谱熵和归一化平方熵分别达到了73.26%、72.64%和78.11%的测试精度。此外,我们发现在相同的双侧犬iEEG记录中,癫痫发作前期和发作间隔期的平均相位-振幅耦合状态总是存在差异[112]。

图6 . 用于膀胱容积或压力监测的专用数字信号处理器[106]。

相比之下,我们还探索了在高密度记录中使用定量有效连通性测量来确定癫痫发作活动网络的可能性。此前,DTF用于量化iEEG记录之间因果关系的能力已经验证过。然而,分析信号的准平稳性仍然是避免iEEG触点间假连接的必要条件[113]。虽然在处理相对较少的接触时,可以识别固定的时间点,但在分析高密度iEEG信号时,它变得更具挑战性。最近,人们提出了一种时变DTF,即频谱加权自适应定向传递函数(spectrum weighted adaptive directed transfer function,swADTF)。swADTF能够处理非平稳性问题,并自动识别感兴趣的频率范围[113]。随后,我们通过在高密度记录上使用swADTF验证了发现癫痫发作活动发生区域和消亡区域的可能性[114]。该数据库由在蒙特利尔大学医院中心接受术前评估的难治性癫痫患者的数据组成。有趣的是,对于手术切除后没有癫痫发作的患者,确定的癫痫活动源在癫痫灶和切除体积内。相反,在术后仍有癫痫的患者中发现了额外的或不同的发生区域。我们的研究结果强调了使用swDTF精确识别癫痫发作发生和消亡部位的可行性。因此,在未来的癫痫预测研究中,推荐了基于有效连通性措施的电极选择方法。

最近的发现强调了利用iEEG记录预测癫痫发作的可行性;从发作间隔期到发作状态的转变包括一个“积聚”,可以通过高级特征提取和人工智能技术进行跟踪。然而,在将现有方法转化为真正的临床设备之前,需要在特征提取、电极选择以及硬件和深度学习实现等方面进行进一步的研究。

5. 结论

本文综述了人工智能在生物医学应用的最新进展,包括疾病诊断与预测、生活辅助、生物医学信息处理和生物医学研究。人工智能还在许多其他的生物医学领域有着有趣的应用。可见,人工智能在生物医学中发挥着越来越重要的作用,不仅是因为人工智能自身的不断进步,还因为生物医学问题固有的复杂性和人工智能解决此类问题的适用性。新的人工智能技术能力可为生物医学提供新的解决方案,生物医学的发展对人工智能的能力提出了新的要求。这一供求匹配和耦合发展将使这两个领域在可预见的未来取得显著进展,最终将有利于提高有需求的患者的生活质量。

Nomenclature

AAL ambient assisted living

AI artificial intelligence

AN artificial neural network

ASIC application-specific integrated circuits

BioQA biomedical question answering

BIR bin-integrated rate

CMA computational modeling assistant

DSP digital signal processor

DSS decision support system

DTF directed transfer function

ECG electrocardiography

EEG electroencephalography

EMG electromyography

ES-MR expert system for memory rehabilitation

CPU central processing unit

GPU graphical processing unit

FES functional electrical stimulation

FIR finite impulse response

FPGA field-programmable gate array

HMI human-machine interface

iEEG intracranial electroencephalography

IoT Internet of Things

ML machine learning

NN neural network

PDA personal digital assistant

PLA people with loss of autonomy

POCT point-of-care testing

RMSE root mean square error

SALSA screening of activity limitation and safety awareness

swADTF spectrum-weighted adaptive directed transfer function

FR firing rate

BW bin width

OSR overall success rate

致谢

本工作得到了西湖大学科研启动基金(041030080118)与西湖大学-博智林机器人联合研究院科研经费(10318H991901)的支持。

Compliance with ethics guidelines

Guoguang Rong, Arnaldo Mendez, Elie Bou Assi, Bo Zhao, and Mohamad Sawan declare that they have no conflict of interest or financial conflicts to disclose.