基于视频与图像的驾驶员姿态识别方法比较分析研究*

2020-07-27吴冠鹤周博见

张 军 何 杰 吴冠鹤 汤 慧 魏 琳 周博见

(河南交通职业技术学院交通运输发展战略研究中心1) 郑州 450015) (东南大学交通学院2) 南京 210018)

0 引 言

交通事故约80%是由驾驶员错误驾驶行为所导致,这些错误行为中又以疲劳驾驶、超速、错误驾驶姿态居多[1-3].不良的驾驶姿态会严重影响驾驶员的感知、判断,以及对突发状况的应急反应能力.

近年来,基于视频的驾驶人姿态检测的研究主要集中在驾驶人的眼部[4]、凝视方向[5]、面部朝向和头部姿态[6],利用头部信息去判断驾驶员的状态,多用来监测驾驶员的疲劳或分神状况[7-9].为了从驾驶员状态检测拓展到驾驶员行为检测,部分学者将研究区域扩展到由头部、双手臂、身体躯干组成的上半身,通常使用肤色检测方法提取驾驶员头部、手部区域,并以此作为特征图像识别驾驶员姿态[10-11].

文中结合项目组已有成果及具体实验案例,将驾驶员姿态识别流程分为数据采集、图像处理、特征提取和姿态分类四个阶段,对每个阶段使用的方法进行比较研究,具体分析包括图像数据集、视频数据集及两者的特征,归一化RGB模型和YCrCb模型二种肤色检测模型及其优劣性,全图像像素、连通域质心距离、双手(臂)质心坐标三种应用特征提取方法的区别,KNN、决策树和神经网络等姿态分类方法的适用场景.比较分析的流程和具体内容见图1.

图1 比较分析的流程和具体内容

1 图像和视频数据的采集

将驾驶员姿态识别数据集分为图像数据集I与视频数据集V,所拍摄的驾驶员姿态包括双手紧握方向盘、操纵档位和异常驾驶姿态(包括双手离开转向盘、单手驾驶、吃东西和打电话).其中,通过直接拍摄获得图像数据集I共m张图片;通过采集n段时长t(s),驾驶员驾驶视频h(帧/s),对n段视频依次处理,构成视频数据集V=(V1,V2,…,Vn),每段视频每隔h帧截取一张图像,其中第i段视频对应数据集Vi=(Vi1,Vi2,…,Vit),处理后视频数据集V共有n×t张图片.将数据集的80%用于训练,20%用于测试,比较分析驾驶员姿态识别方法.

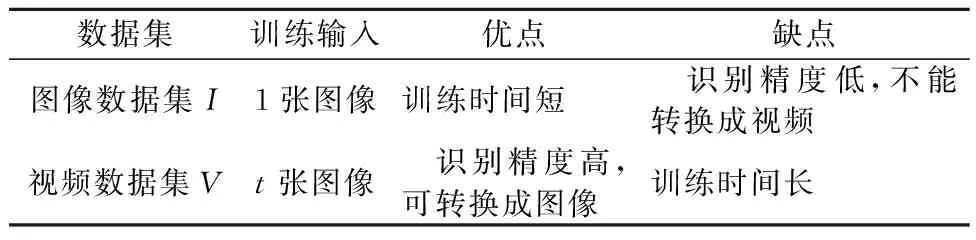

图片数据集I由于每次训练只输入一张图片,输入数据维度较小,模型训练速度较快,但也存在单张照片可能无法检测到驾驶员头部、双手三个肤色区域,导致识别精度较低的问题.而视频数据集V每个样本训练都会输入t张图片,均描述一种驾驶姿态,图片间可产生特征互补,当有x张图片不能检测到三个肤色区域时,仍然能有t-x张图片完成训练过程.因此,识别精度较高,但输入数据维度较大,训练时间较长.图像数据集与视频数据集的优缺点比较分析见表1.

表1 图像数据集I与视频数据集V比较分析

2 四种图像处理方法比较分析

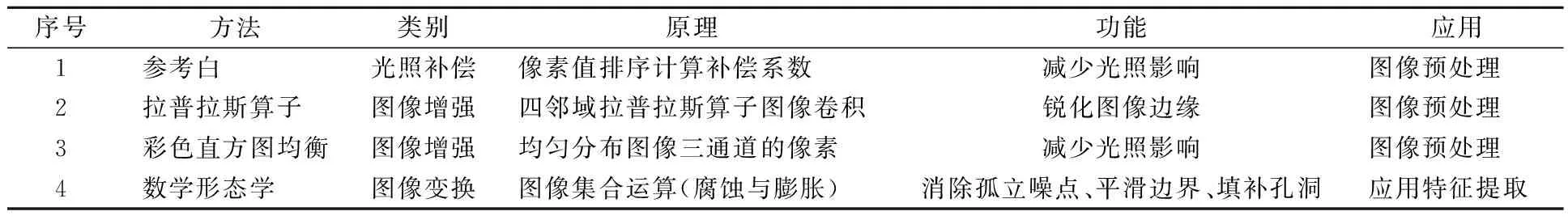

驾驶员图像处理主要是为了消除图片中由于外界环境变化导致的光照、噪音、振动以及图像模糊等问题,提高图像的检测精度.较有代表性的图像处理方法有参考白、同态滤波、均值滤波、中值滤波、数学形态学方法、直方图均衡化、图像平滑和锐化等.论文分别对上述方法进行了实验,依据处理结果最终选用参考白、拉普拉斯算子图像锐化、彩色直方图均衡以及数学形态学方法作为驾驶员姿态识别的图像处理方法.对这四种方法的原理、功能与运用场景的比较分析见表2.

表2 图像处理方法比较分析

结合模拟驾驶器图像数据集I1和真实驾驶场景图像数据集I2,得到参考白、拉普拉斯算子、彩色直方图均衡、数学形态学4种图像处理方法效果图.

3 特征提取方法比较研究

3.1 肤色检测方法

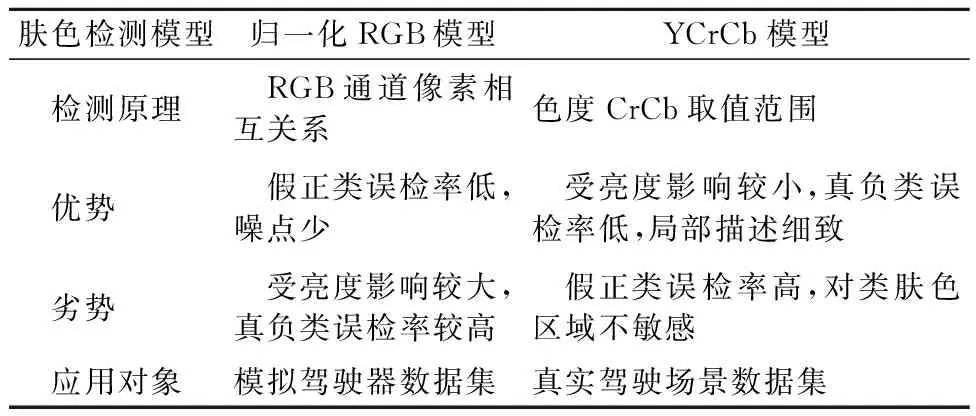

由于侵入式检测方法将对驾驶员产生侵扰,而可变形部件模型需要大量图像数据制作标签,故论文运用肤色检测模型提取出驾驶员人体特征.常见的肤色检测模型有RGB模型、归一化RGB模型、YCrCb模型、HSV模型.综合考虑实验结果,选取归一化RGB模型和YCrCb模型作为肤色检测模型.

归一化RGB肤色检测模型是通过计算RGB通道像素关系范围而得到,对驾驶人姿态的特征区域描述效果较好,不会出现较多的干扰点,但对细部描绘效果一般;而YCrCb肤色检测将色度与光度分离,通过色度检测肤色,虽然现实中改变光照,色度也会相应地产生改变,但仍在一定程度上可降低光度的影响[12].YCrCb模型方法对驾驶人姿态的细部描绘较好,能准确检测出驾驶人眼睛、耳朵、手指等微观区域,但是对类皮肤区域的去干扰能力较差,图像中的干扰成分较多.归一化RGB肤色检测和YCrCb肤色检测模型具体比较分析见表3.

表3 归一化RGB模型和YCrCb模型比较分析

结合模拟驾驶器图像数据集I1和真实驾驶场景图像数据集I2,分别运用归一化RGB模型和YCrCb模型进行肤色检测.

3.2 应用特征提取方法

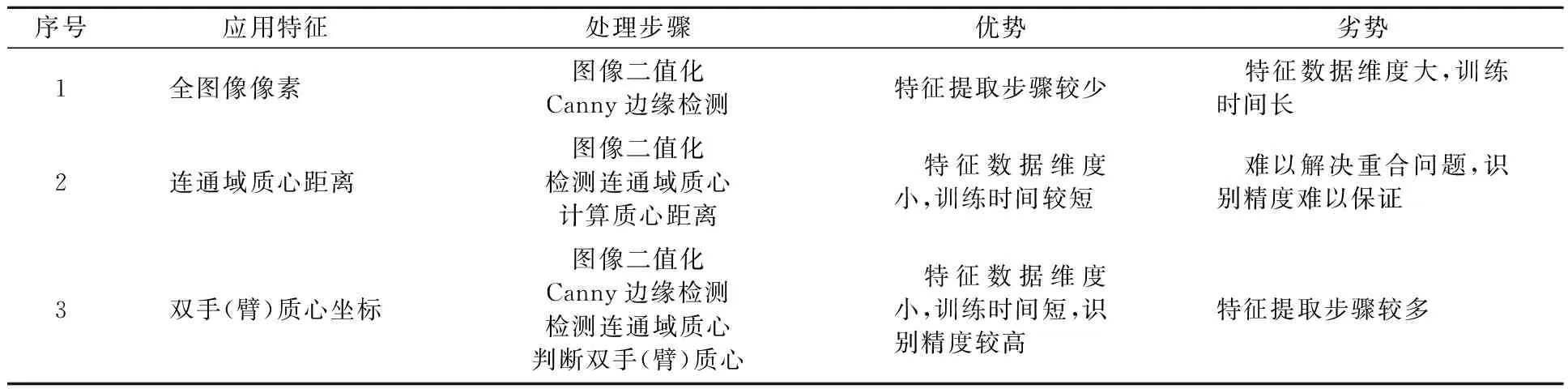

通过肤色检测模型提取到驾驶员肤色图像后,对图像进行应用特征再提取,再将该应用特征输入至分类器中进行训练.应用特征提取的方法包括全图像像素特征、连通域质心距离特征和双手(臂)质心坐标特征,意义在于简化驾驶员肤色特征,减少特征数据种类,降低特征数据维度,从而加快分类器的训练和识别速度.

全图像像素特征指将整张图片所有像素值作为输入特征进行训练,为了强化驾驶员姿态特征一般会进行简单的图像处理,包括图像二值化和边缘检测.图像处理的作用是将RGB三通道图像矩阵转换为单通道稀疏矩阵.

连通域质心距离特征指提取驾驶员头部、双手连通域质心的距离作为输入特征.该方法使特征数据从全图像像素转变为三个距离值,极大降低了特征数据的维度,加快了训练进程.然而,该应用特征提取方法分类精度较低,其原因是容易产生驾驶员不同身体部位连通域的重合,该情况下,算法只能提取到一个或二个连通域,无法提取三个质心距离特征,这极大影响了图像数据识别的准确度.应用视频数据集则可部分解决该问题.

双手(臂)质心坐标特征指仅提取双手(臂)质心坐标作为输入特征.在固定摄像机位置的情况下,驾驶员头部位置基本不变,双手(臂)位置有较大改变.由于相似特征对分类结果的影响很小,而差异化特征对分类结果的影响很大,因此利用双手(臂)的部件连通域质心坐标即可完成驾驶员姿态识别.为了解决身体部位连通域重合问题,可考虑驾驶员头部相对位置及各部位连通域面积,确定头部与双手的质心坐标.该方法极大降低了特征数据的维度,并能保证驾驶员姿态识别的精度.三种应用特征提取方法的处理步骤和优劣势比较分析见表4.

表4 三种应用特征提取方法比较分析

结合模拟驾驶器图像数据集I1、真实驾驶场景图像数据集I2以及视频数据集V,分别运用全图像像素、连通域质心距离和双手(臂)质心坐标三种应用特征提取方法.

4 姿态分类方法比较分析

通过比选SVM、KNN、决策树、朴素贝叶斯、随机森林、BP神经网络和MLP神经网络7中不同的分类器,确定适用于不同情况下的分类器,并结合图像数据集I和视频数据集V,对各种分类方法进行比较,见表5.

由表5可知,SVM分类方法在模拟驾驶器I1数据集上正确率达97%,应用效果较好.KNN分类器运用于真实驾驶场景I2数据集,提取双手臂坐标应用特征,准确率为88.27%,与BP神经网络相似,而训练耗时仅为1 ms,远远小于BP神经网络,是一种性能更好的分类器.在视频数据集V中,综合准确度和训练耗时情况,决策树分类器表现效果更优.

表5 不同分类器分类效果、应用及训练耗时比较分析

5 结 束 语

结合项目组已有成果及具体实验案例,将驾驶员姿态识别流程分为数据采集、图像处理、特征提取和姿态分类四个阶段,对每个阶段使用的方法进行了比较研究.基于分析可知,目前的驾驶员姿态识别仍处于理论研究阶段,距离形成成熟的产品还有一定的距离.主要问题是在于肤色模型还不能很好的适应各种真实驾驶场景下外界干扰带来的光线变化,识别精度不高以及系统识别驾驶员姿态的实时性还未达到实际应用的要求.未来,驾驶员姿态识别会着重向精度化、实时化、智能化方向展开研究.