基于BiLSTM-Attention的电商评论情感分析

2020-07-13史振杰董兆伟庞超逸张百灵孙立辉

史振杰,董兆伟,庞超逸,张百灵,孙立辉

(河北经贸大学 信息技术学院,河北 石家庄 050061)

1 研究现状

近年来,电子商务发展十分迅速,同时,越来越多的评价形成了巨量的文本数据,这些数据包含大量的隐含信息,商家可以根据这些信息来改善产品和经营模式,而消费者可以根据这些信息选择自己想要的产品。但是,仅仅靠人工是无法处理这样大量的信息,因此,利用计算机来帮助人们进行汇总、处理与挖掘这些信息,所以文本情感分析技术出现并成为人工智能领域的一个热点问题。

文本情感分析在许多的领域都有涉及,应用范围十分广泛[1-4],例如,心理学、智能机器人、智能司法等。英文的情感分析研究的比较成熟并且取得的不错的研究成果,而国内的研究比较落后。在情感分析领域,国外的研究比国内较早,对于英文的情感分析研究较为成熟,对于中文的研究还处于起步阶段,但是两者的研究方法相似,主要都是分为三种方式,基于情感词典的方法,基于机器学习以及基于深度学习的方法。

基于情感词典的分析方法主要是根据是否包含词典中的情感词语及情感强度,再根据公式评价情感倾向[5]。Bingliu等人[6]构建了基于顾客评价的词典,除了一般的词语外,还包含了拼写错误、语法变形、标记符号等,该词典在新社交媒体方面处理情感分析时具有很大的帮助。Saif[7]将语义信息引入到情歌分析中,并通过实验发现比对情歌主题进行分类的方法效果好。Kim[8]等人使用同义词,近义词等方式构建词典,并通过它判断词的情感倾向。闵锦和朱嫣岚[9]等人使用Hownat词典进行分析再次基础上进行了创新,提出两种新的计算方式,并证明具有很高的实践价值。朱艳辉[10]等人建立了一个新的词典,用新词典结合传统TF-IDF方法进行优化。王勇[11-12]等人在基础情感词典的基础上,扩展了情感词典,取得了很好的效果。使用情感词典进行文本分析虽然效率较高,但是分析的准确程度与情感词典的好坏有很大的关联,因此模型的鲁棒性不强。

基于机器学习的方法原理是采用有监督数据的方法进行学习,进而完成情感分析。Pang[13]等人最开始将机器学习方法引入到情感分析中去,采用机器学习实现了对电影影评的分类,结果表明SVM的分类效果最好,朴素贝叶斯进行分类效果最差。Jain[14]等人使用机器学习算法,对Twitter评论进行情感分析,构建了一个基于贝叶斯和决策树的情感分析框架,结果表明不仅准确率高并且速度快。Neethu[15]等人在某一特殊领域采用机器学习的方法进行情感分析,识别出这一领域中对于情感分析的作用,取得不错的效果。王刚[16]等人将集成学习与SVM相结合,提高了情感分析的准确度。李响[17]等人针对SVM模型,加入了三种对维吾尔语言学习的三种策略,在提高准确度的情况下还能够减少工作量,省时省力。一般情况下,采用机器学习的方法进行情感分析效果比单纯采用情感词典的方法好,但是需要使用大的语料库,因此实际上很难达到满意的效果。

随着计算机技术的提升,深度学习广泛用于文本的处理,深度学习可以经过多层次的学习,自动学习到数据的本质特征,能够在预测与分类任务中获得较高的准确率。Denil[18]等人提出一种多层次的CNN模型来抓取文本中的特征,通过构建多层次的结构来强化文本中对于关键信息的抓取。Kalchbrenner[19]将静态卷积网与动态卷积网相结合,对于解决不同文本的不同长度具有较好的效果。Zhou[20]等人提出了将CNN与RNN的特点相结合,先对文本用CNN进行分布特征的提取,再用RNN进行序列特征的提取,最后用于分类。李然[21]使用神经网络语言模型进行文本情感分析,经过自适应调整,提取更深层次的语义信息,在大规模的商品评论数据集上表明了深度学习的分类性能更好。胡朝举[22]等人提出了一种将CNN与LSTM相结合的方法,不仅能采用CNN捕捉句子的局部特征,而且能够较好的获取句子的上下文信息,实验获得了较高的F值。在以上的研究中,使用深度学习方法在不同领域都有很好的效果,但是都需要大量的语料进行学习,语料不足时很难达到满意的效果。

本文主要对以下内容进行研究论述:

1) 利用Word2vec对评论信息的句子进行向量化表达,然后采用双向LSTM网络对文本信息进行分析,对比单向LSTM网络,能够充分挖掘句子中上下文之间的信息。

2) 在BiLSTM网络的基础上,加入注意力机制Attention,通过注意力机制的使用对句子中不同特征分配权重,对于句子中倾向于用户情感的特征信息进行关注,有效改善识别效率,减少数据中噪声带来的不利影响,在京东某手机评论数据集中,实验表明融合注意力机制与包含上下文信息的Bilstm模型具有良好表现。

2 LSTM模型

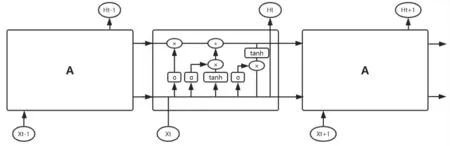

长短期记忆网络,即LSTM,它属于RNN的变种,是一种特殊的改进,能够解决RNN梯度的问题。在循环神经网络中,可以达到使用上文信息来用于输入与输出序列之间的映射,如图1所示。它的任务就是接受x并且输出h,并且内部A允许循环。但是,在标准的循环神经网络中,给定输入对隐层及网络输出的影响,当它以网络的循环连接,会出现梯度爆炸或衰减的问题。

图1 LSTM内部结构图

由于循环神经网络的不足,长短时记忆模型被提出。LSTM网络是由多个内存单元连接而成,每个单元包括输入门、输出门和遗忘门,并且三个门都是用可微分的激活函数,门结构可以达到不间断对数据进行读取、写入、复制的作用。从图1可以看出,在前向传播的过程中,除了包含隐藏状态,还包含一个细胞状态。

遗忘门能够决定信息的忘记,在细胞中,有一定的概率选择是否遗忘上一层的隐藏细胞状态,遗忘上一层细胞状态的概率用ft表示,上一个时刻细胞的输出为ht-1,当前细胞的输入用xt,W为权重,b为偏置,δ为激活函数,如下式所示,

ft=σ(Wf·[ht-1,xt]+bf)

(1)

输入门负责当前序列位置的输入,为输出门细胞的状态提供控制,I与C对细胞状态起作用,如下式所示,

it=σ(Wi·[ht-1,xt]+bi)

(2)

在输出门之前,将遗忘门和输入门得到的结果对当前单元进行处理,如下式所示:

(3)

当隐藏细胞状态进行更新后,可以由输出门进行输出,计算公式如下:

ot=σ(Wo·[ht-1,xt]+bo)

ht=ot*tanh(Ct)

(4)

最后,输出门决定下个隐藏状态的值,控制细胞状态的输出。通过激活函数进行相应的数据传递得到新的状态,再用Tanh进行激活确定应该输出的信息。

3 注意力机制

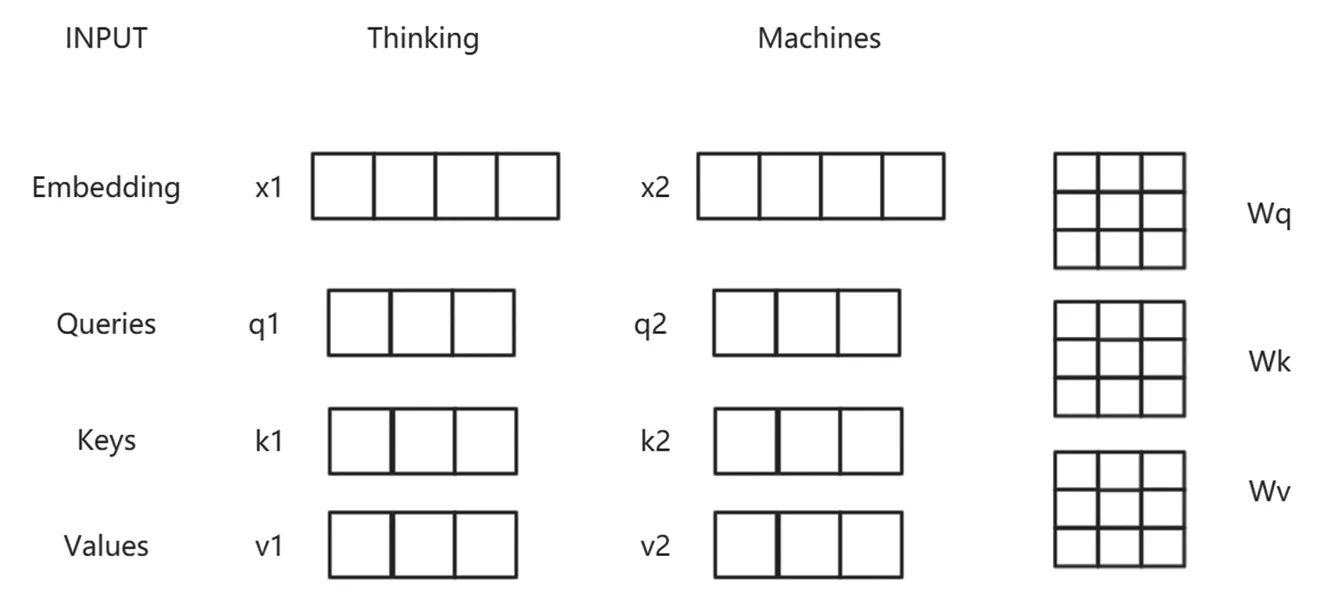

图2 注意力机制结构图

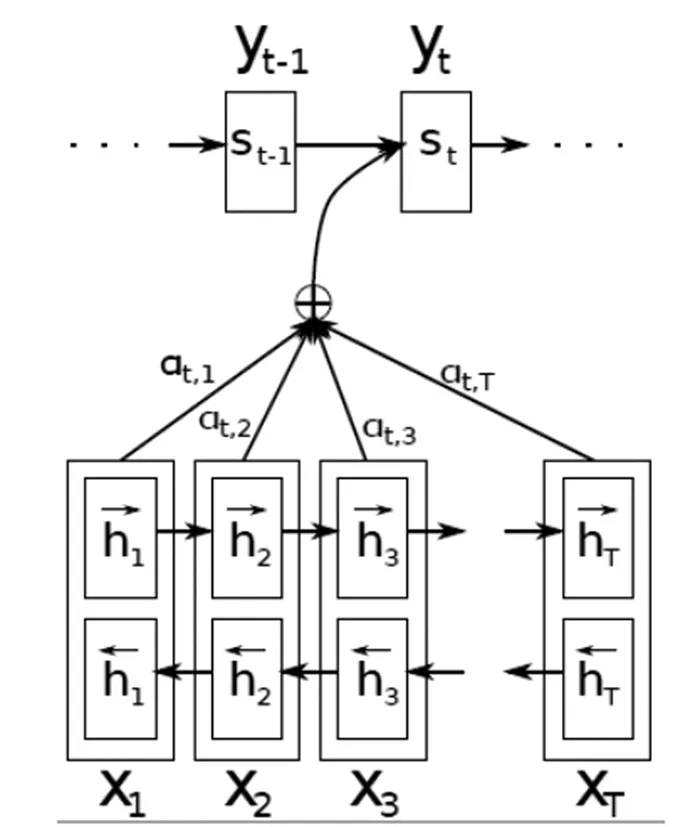

注意力机制为人们在RNN及CNN之后的解决问题中提供了新思路[23]。注意力,通俗理解,人类在观察环境时,大脑往往只关注某几个特别重要的部分,从而构建自己的印象。而Attention Mechanism也是如此,如图2所示,将输入信息分为查询值与键值,对于不同的键值分配不同的权重,然后再结合起来。

通用注意力机制需要三个二维矩阵Q,K,V,其中,K代表关键字,Q代表查询值,V代表权重值。如图3所示,这些二位矩阵的维度分别代表了句子的最大长度以及每一个句子对应的向量长度[24]。一般来说,K与V都是编码器的输出,也就代表了它们是一样的,而Q是解码器的隐状态,通过Q与K的每个时序的对应点积进行softmax即可得到两个时序序列的相似性权重。根据这种相似性的大小,从而对V矩阵中的每一行向量进行放大或缩小,然后将V的所有时序序列的表示向量进行加权求和。可以理解为,对于Q中的每一个序列,V中和该序列相似性高的会获得较高的概率,相似性低的获得较小的概率,然后加权求和新的序列Q的表示。这些权重就被称为注意力权重。也就是说,注意力机制中权重的大小就是一个序列对与他序列中的字符更加的相似或者不相似。

图3 Encoder-Decoder机制计算图

在自然语言处理,尤其是机器翻译的领域内,注意力机制使用广泛,随后在其他自然语言处理任务上也均有很好表现。注意力机制可以说是从大量特征中有筛选出重要的内容,并且聚焦在这些特征上,同时,对于不重要的内容进行远离。

在电商的评论信息中,存在许多对于商品和服务的情感词语,引入注意力机制可以使模型对文本信息中的情感特征进行捕捉,给予这些特征更多的注意,因此能够提高情感分类的效果。

4 BiLSTM-Attention模型建立

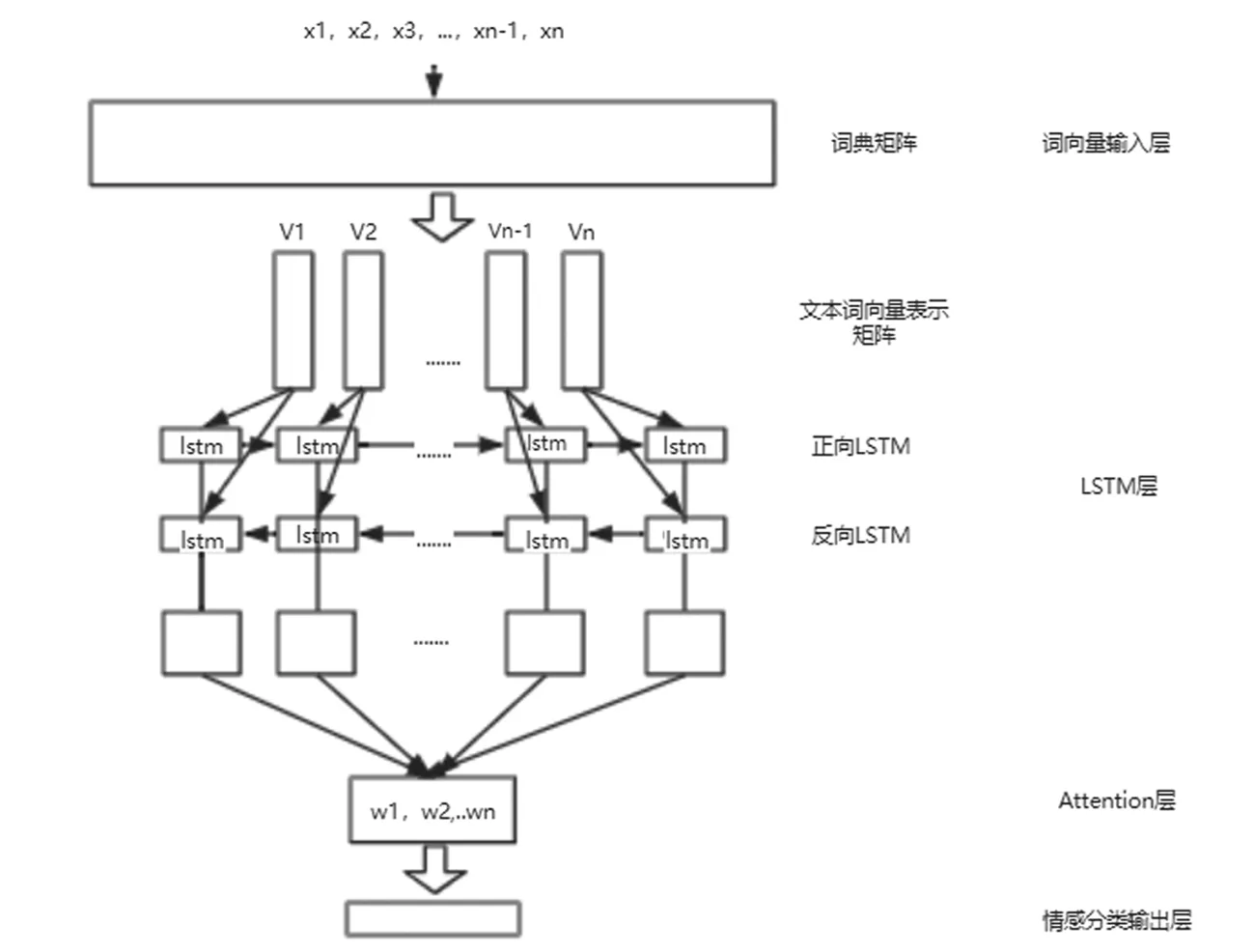

本文搭建的BiLSTM-Attention情感分析模型主要包括输入层(Inputer layer),词嵌入层(Embedding layer),BiLSTM层,注意力层(Attention layer),输出层(Output layer)5个部分,整体结构如图4所示。

图4 BiLSTM-Attention结构图

图5 Attention-BiLSTM层结构图

词嵌入是作为自然语言处理中必不可少的一部分。能够将句子中的所有信息嵌入到高维空间数据,可以作为单独的模型进行词向量的嵌入学习,也可以作为词嵌入模型的加载层,还可以作为训练的一部分,与模型一起进行学习。在本次实验中,词嵌入层作为加载词向量模型,将文本数据对应映射到向量空间中去,完成将词语转化为固定尺寸的向量。

模型的中间一层即为BiLSTM+Attention层。该层在模型中分为两个部分,第一部分由双向BiLSTM神经网络进行特征提取,第二部分需要注意力机制进行特征的更深一步学习,如图5所示。

模型BiLSTM有2个隐含层,组成了双层LSTM模型,也就是两个LSTM进行叠加,能够更好的抽取特征的表现。在训练模型时,设置正向传播的dropout取值为0.5,反向传播的dropout取值为0.5。根据长短期记忆网络的特点,得到LSTM双向信息,然后将其前后拼接,在与Attention的权重矩阵相结合得到有用的特征。

对于给定的n维输入(x1,x2,…,xn),时间为t,BiLSTM的输出为ht,计算流程如下式所示:

(5)

其中,权重矩阵为W,偏置向量为b,σ为激活函数,ht的两种代表正向与反向BiLSTM的输出。

将它们的输出进行拼接,输入到注意力机制中,对隐含层的不同时间的输出进行不同的权重分配,不同的权重代表了不同的注意程度,其中,注意力权重的构建方式如下,a为学习函数,由BiLSTM层的状态序列ht经过加权处理,得出注意力权值α,然后对所有序列中的结点隐含向量与注意力权值进行乘积,得到最终的特征向量s。

et=a(ht)

(6)

输出层由全连接层分类器进行数据的分类,输出层的计算公式如下式所示:

O=softmax(Wsh+bs)

(7)

在数据集中,输出层进行分类,经过分类器处理,可以得到属于哪一类情感的概率,如下式所示:

(8)

使用交叉熵损失函数作为评价函数,如下式所示:

(9)

其中,yti指代t时刻实际标签中的第i个值,preti指代t时刻预测的标签中的第i个值。

5 结果与分析

实验环境配置如表1所示。

表1 实验环境配置表

在京东某手机评论数据集中上进行实验,数据集中包含了8000条训练数据,测试数据为1600条。

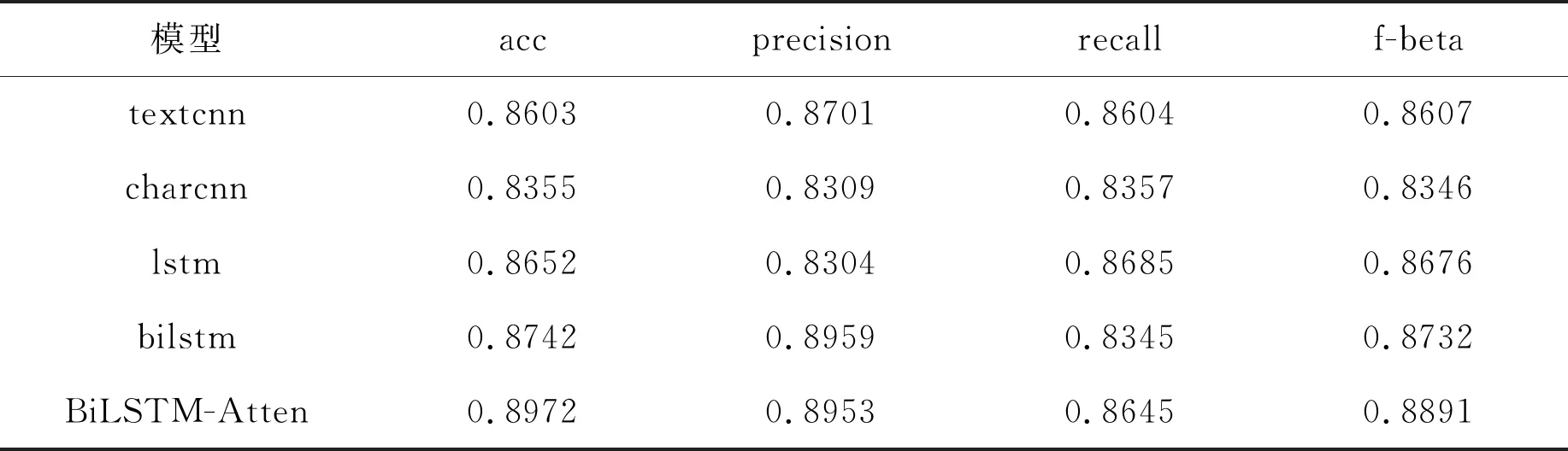

分别采取几种不同的模型进行实验,分析最后的结果。对于自然语言处理中情感分析任务,不仅要看最终的准确率,还应该以F值作为最终的评价指标,结果如表2。

表2 实验结果表

在RNN中,双向LSTM神经网络比单向LSTM神经网络的准确度与F值都高。这说明了,双向的LSTM结构在文本情感分析任务中相较于单向的LSTM具有更好的效果,双向的结构在时序处理过程中,不仅能够获取句子前面的信息,也能够获取句子后面的信息,因此,在电商评论数据集中的BiLSTM表现好于LSTM。

当加入注意力机制时,Attention-BiLSTM在准确率与F值均高于BiLSTM模型。这说明了加入注意力机制的BiLSTM可以捕获句子中对于情感表达更加重要的词语,Attention机制在BiLSTM网络的使用能够给予重要信息更高的注意,因此,BiLSTM-Attention的在本实验中的表现好于BiLSTM。

6 结束语

近几年来,随着互联网和计算机技术的发展,网上购物已经融入了人们的日常生活,因此,在网上出现的评论文本中挖掘有价值的信息也越来越受到人们的重视。为了更好的对电商评论信息进行挖掘,本文提出了一种融合Attention与BiLSTM的网络模型,对某手机评论文本数据进行情感分析,挖掘消费者的情绪,更加有效的对商家进行优化,增强竞争能力,也能给消费者决定是否购买提供参考。

文本先通过Word2Vec得到预训练词向量,将词向量输入到双向LSTM模型中去,利用注意力机制筛选出对文本情感分析重要的特征,分配较高的权重,然后送入到全连接中在进行情感极性分类。在某手机评论数据中,虽然相较于其他几种传统模型有一些提升,但是训练时间也相对较长,并且模型并不能实现同时对双向语义进行处理。因此,针对这些问题,还需要不断的研究和探索。