深度卷积神经网络模型发展综述

2020-06-19洪奇峰施伟斌吴迪罗力源

洪奇峰 施伟斌 吴迪 罗力源

摘要:随着移动互联网与硬件处理器技术的不断发展,海量数据处理与计算能力不断提高,深度学习备受关注。卷积神经网络是深度学习模型中最重要的一种结构,可用于目标特征提取。介绍了为提高卷积神经网络性能,不断增加卷积网络深度的模型,以及因此带来的新问题和解决方法。

关键词:深度神经网络:特征提取:目标识别:网络结构

DOI: 10.11907/rjdk.191659

开放科学(资源服务)标识码(OSID):

中图分类号:TP3-0

文獻标识码:A

文章编号:1672-7800(2020)004-0084-05

Review of the Development of Deep Convolutional Neural Network Model

HONG Qi-feng, SHI Wei-bing, WU Di, LUO Li-y uan

(School of Optical-Electrical and Co mputer Erzgineering , University of Sh angh.ai for Science and Technology,Shangh ai 200093.China )Abstract: With the continuous developmenf of' mobile Internet. hardware processor and other aspects, and the continuous improve-ment of massive data and computing power, deep learning has attracted more and more attention of the world. Especially after LeeSedol foughf against Alphago, it attracted worldwide attenfion. Convolutional neural network is the most important structure in deeplearning model. which is used to extract target features. With the continuous development of the deep learning field , this paper intro-duces the improvement of the perf'ormance of' the convolutional neural network. the convolutional network models with increasingdepth,as well as the new problems and their solutions.Key Words : deep neural network;feature extraction; object identification; network structure

O 引言

卷积神经网络( Convolution Neural Network,CNN)用于特征提取,从最早期的尺度不变特征变换…(Scale invariantfeature transform,SIFT)、Harr、方向梯度直方图[2](Histo-gram of oriented gradients,HOG)演化发展至今。1998年LeCun[3]提出LeNet-5,将卷积与神经网络结合在一起,这是一个划时代、影响深远的卷积神经网络结构,卷积和池化两个全新概念由此提出。其后随着深度学习理论的发展,2012年Alex Krizhevshvy[4]提出AlexNet,这是一个8层深的卷积神经网络,该模型一举夺下2012年ImageNet比赛冠军。白AlexNet之后,研究者从不同网络结构出发,陆续提出了各种性能越来越好的卷积神经网络模型,其中比较著名的有计算机视觉几何组(Visual Geometry Group,VG-GNet)、GoogLeNet、深度残差网络(Deep Residual network,ResNet)等[5-7]

1 VGG模型

CNN模型基础架构如图l所示,从图1可以看出,CNN模型是由一系列层不断堆叠而成的,模型中的每一层都代表一种数学运算,如卷积、全连接是线性运算,池化、激活是非线性运算。

VGG模型于2014年由牛津大学VGG研究组提出,与AlexNet类似,也是一种卷积神经网络,在AlexNet的基础上,旨在通过加深网络提高性能。该模型在2014年ILS-VRC定位和分类两个比赛上分别取得了第一名和第二名。与之前的网络结构相比,VGG模型错误率大幅下降。同时,该模型拓展性很强,迁移到其它图片数据上的泛化性非常好。除应用于最常见的特征提取(Feature Extractor)外,还被广泛应用于图像协同定位(C o-localization)、物体候选框生成、细粒度图像定位( Fine-grained Object Local-ization)等方面。

VGGNet核心思想是利用较小的卷积核不断堆叠增加网络深度,以此提升整个网络架构性能。VGG网络结构非常简洁,整个网络全都使用同样大小的卷积核与最大池化核,利用卷积层与最大池化层不断堆叠的方式,组合成II-19层深的卷积神经网络。

VGGNet各级别网络结构如表1所示,VGGNet有5段卷积,每段卷积包含1-4个卷积层,每段卷积后面接一个最大池化层用来缩小feature map尺寸和增强特征,后面有3个全连接层,前两层均有4096个通道,第3层共1000个通道,对应l000个标签类别,最后一层为Softmax层。

2.3 Inception V3

Inception V3[12]相对Inception V2没有显著改进,只是对原有网络模型结构进行卷积分解,用两个较小的卷积核l*n和n*1代替n*n,比如将7*7分解成l*7和7*l。优点是增加了网络非线性,减少过拟合与参数数量。其网络模型结构如图5所示。 3 残差网络ResNet

白AlexNet之后,卷积神经网络不断加深,网络拟合能力越来越强,但网络训练误差变大却是极不正常的。简单地堆叠网络层深度没有实质性作用,反而会使反向传播产生多个问题。反向传播的梯度计算是在上一层基础上进行的,网络深度加深会使梯度复乘,使梯度在多层反向传播时越来越小,最终导致梯度消失。因此网络层数越多,训练误差越大。

残差网络通过在标准的前馈神经网络上增加一个跳跃从而绕过一些层,实现快捷连接(Shortcut Connection),解决了以上问题。

3.1 高速路神经网络

残差网络创新点在于引进了恒等快捷链接(IdentitvShortcut C onnection),其设计是受瑞士教授Schmidhuher[13]提出的高速路神经网络(HighWay Network)启发。一般情况下认为增加网络深度可在一定情况下提高网络性能,但伴随着网络深度的增加,其训练难度也越来越大。Schmid -huber教授根据白己在1997年构建的长短期记忆网络(Long Short Term Memorv Network.LSTM)[14]中的门机制(gate)原理设计了HighWay Network。LSTM中的门结构负责控制某一单元的信息量,HighWay Network可通过类似LSTM中的门控单元控制网络中的信息流,即学习原始信息应保留的比例。

高速路神经网络的出现解决了深层神经网络难以训练的难题。假设常规卷积神经网络有K层,其中第i层(i∈l,2,…,K)的输入为X。卷积神经网络每层的激活函数均对输入X进行非线性映射变换,为了表述简单,本文忽略层数和偏置,则输出与输入之间的关系为:

v=H(X,WH)(1)

高速路神经网络修改了每一层的激活函数,在此基础上允许保留一定的原始输入X,则式(1)变为:

v=H(X,WH).T(X,WT)+X.C(X,Wc)(2)

其中T为变换系数,C为保留系数。令C=1-T,则:

y=H(X,WH).T(X,WT)+X.(1-T(X,WT》(3)

改进后的网络层比原始网络层灵活了很多,针对特定变换系数,式(2)变为:

一定比例的上一层信息可不经过矩阵乘法和非线性变换直接到达下一层,該结构仿佛是一条信息高速公路,因此命名为高速路神经网络。可以发现当变换系数T=O时,输出y与输入X为恒等映射v=X。

3.2 ResNet模型结构

图6是论文中的原图,通过图6可以发现,普通的卷积神经网络随着深度的增加,准确率达到饱和后迅速下降,随之出现了网络越深、错误率越高的退化现象。这是由网络增加过多层数造成的。

为了解决退化现象,残差网络引入了恒等快捷链接的核心思想,对于一个准确率已经接近饱和且较浅的神经网络,在后面加上几个恒等快捷映射(v=X)时,错误率不会因此增加,即网络深度的增加不会引起训练误差上升。加入恒等快捷连接的ResNet也与HighWay Network -样,将原始输入信息直接传输到后面。

卷积神经网络某一层输入为X,在经过网络传输处理之后,得到的期望输出是H(X)。与传统神经网络不同,残差网络引进恒等快捷连接,构造了残差模块。如图7所示,直接将输入X传人输出中并作为下一层的初始结果,则此时目标函数为:

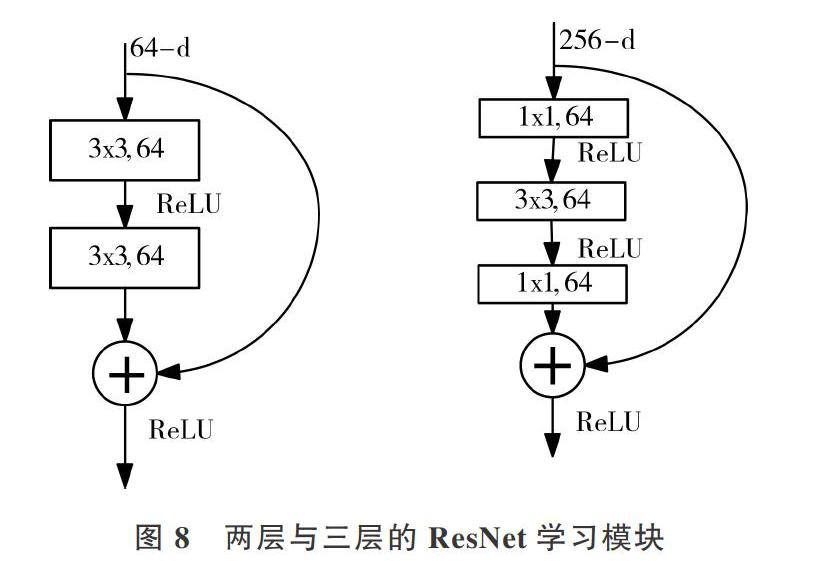

残差模块的引入改变了网络学习目标,使其不再学习一个完整的输出H(X),而是学习输出与输入之间的差别,即残差。图8左侧是残差函数,右侧为对输入的恒等映射,这两支路径经过简单的整合(对应元素相加)后,再经过非线性变换(激活函数),最后形成一个完整的残差网络模块。

残差网络有很多旁路的支线直接将上一层网络的输出连接到下一层或下面多层网络中,这种连接方式被称为快捷( Shortcut)或跳跃连接(Skip Connections)。

在一个残差网络模块中,一般快捷连接会跳跃2-3层甚至更多,但如果仅跳跃一层则意义不大,实验效果也不理想,因为2-3层可以提供更多的非线性,拟合更复杂的F(X)。图8左侧是两层残差学习模块,由两个输出通道数一致(残差网络是输出减去输入,这要求输出与输入的维度由保持一致)的3*3卷积网络堆叠而成。但这种残差网络模块在实际中并不是十分有效。右侧是3层学习模块,依次由1*1、3*3、l*l这3个卷积层构成。先用I*l的卷积降维(通道数降低)后,再作3*3卷积,最后用l*l的卷积提升特征通道数。

残差网络解决了因为卷积网络深度持续加深而导致的退化问题,在残差网络提出不久之后,Google融合ResNet和Inception V3版本,得到Inception V4[15]和Incep -tion-ResNet-V2[16],创造了在ImageNet数据集上TOP-5错误率3.08%的新低。

4 结语

本文回顾了卷积神经网络模型在近年的发展,该模型已成为深度学习在图像与白然语言处理等[17-20]领域最重要的研究对象,常用的CNN模型总结如表3所示。

CNN模型研究者致力于不断提升模型计算效率与识别精度,面对不同数据集的泛化能力,近期还涌现出DenseNet[21]、DPN[22](Dual Path Network),MobileNet v2[23]等模型。随着人T智能的不断发展及应用场景的不断拓展,用户对CNN模型的要求也会越来越高,CNN必将遇到各种新挑战,今后很长一段时间内卷积神经网络依然是深度学习领域研究重点。

[1]LOWE D G. Distinctive image features from scale-invariant key-points [J].International Journal of Computer Vision, 2004 . 60 (2) :91-110.

[2]DALAI N , TRIGCS B. Histograms of oriented gradients for human de-tection [c] . IEEE Conference on Computer Vision and Pattern Recog-nitinn.2005.1:886-893.

[3]LECLN Y. BOTTOU L, BENClO Y, et al. Gradient-hase learning ap-plied to document recognition [Jl. Proceedings of the IEEE,1998. 86(11) : 2278-2324.

[4]KRIZHEVSKY A, SUTSKEVER I, HINTON G. Imagenet classifica-tion with deep convolutional neural networks[Cl. ProceedinCs of theAdvances in Neural Information Processing Systems, 2012: 1097-1 105.

[5]SIMONYAN K, ZISSERMAN A. Very deep comnlutional networks forlarge-scale image recognition [DB/OL]. https://arxiv.org/pdf/1409.1556.pdf

[6]SZEGEDY C,LILT W,JIA Y Q,et al. Going deeper,vith convolutions[C]. Proceedings of the IEEE Conferenc.e on Computer Visinn and Pat- tern Recognition.2015: 1-9.

[7]HE K, ZHANG X. REN S,et al. Deep residual learning for image recognition [c]. Proceedings of the IEEE conference on computer ri-sion and pattern recognition. 2016:770-778.

[8]LIhr M, CHEW Q, YAN S Network in network[C]International Con-ference on Learning Representations, 2014: 1-10

[9]黃文坚,唐源.TensorFlow实战[M].北京:电子工业出版社,2017.

[10]IOFFE S, SZECEDY C.Batch norrnalization: ac:celerating deep net-work training by reducing internal cox'ariate shift[C] InternatinnalConference nn International Conference on Machine Learning. JMLR.org, 2015:1-9.

[11]BECK 0,PL RWINS H. Com-nlutional neural net works with hatchnormalization for classifying hi-hat, snare. and bass percussionsound samplesEC].Proceedings of the Audio Mosth, 2016:111-115.

[12]SZECEDY C. VANHOLiCKE V, IOFFE S,et al. Rethinking the In-ception architecture for computer rision[C]. Proceedings of theIEEE Conference on Computer Vision and Pattern Recognition,2016:2818-2826.

[13]RLPESH K S,GREFF K. JURGEhr S. Training very deep networks[C]. Proceedings of the Conference and yrorkshop on Neural Information Processing Systems,2017: 2377-2385

[14]HOCHREITER S,SCHMIDHL: BER J. Long short-term memory [J].Neural Computation,1997,9(8):1735-1780

[15]SZEGEDY C. IOFFE S,VANHOLCKE V. et al. Inception-v4, In-ception-Resnet and the impact of residual connections on learning[C]. Processdings of AAAl Conference on Artificial Intelligence,2017:4-12.

[16]XIE S, CIRSHICK R,DOLLAR P, et al. Aggregated residu al transfor-mations for deep neural networks[C].Pmceedings of the IEEE Con-ference on Computer Vision and Pattern Recognition, 2017:5987-5995.

[17]吴汉钊基于孪生卷积神经网络的人脸追踪[J].计算机工程与应用,2018, 54( 14): 175-179.

[18]庞亮,兰艳艳,徐君,等深度文本匹配综述[j].计算机学报,2017.40(4):985-1003.

[19] 李味味,章新友,仵倚,等.基于BP神经网络中药复方功效的预测研究[J].中医药导报,2016.22 16):38-41.

[20]高学,王有旺基于CNN和随机弹性形变的相似手写汉字识别[J].华南理工大学学报(自然科学版),2014(1):72-76.

[21] HUANG G,LIU Z. MAATEN L V D,et al. Denselv connected convo-lutional networks[C].Proceedings of the IEEE Conference on Com-puter Vision and Pattern Recognitinn, 2017: 1-9.

[22]CHEN Y, LI J, XIAO H. et al. Dual path networks[C]. Proceedingsof the IEEE Conference on Computer Vision and Pattern Recogni-tion.2017:4470-4478

[23]SANDIER M, HOWARD A. ZHU M. et al. MobilehretV2: invertedresiduals and linear bottlenecks[C].2018 IEEE/CVF Conference onComputer Vision and Pattern Recognition, 2018: 1-14

(責任编辑:江艳)

收稿日期:2019-05-27

作者简介:洪奇峰(1992-),男,上海理工大学光电信息与计算机工程学院硕士研究生,研究方向为深度学习、目标检测;施伟斌(1967-),男,上海理工大学光电信息与计算机工程学院副教授,研究方向为无线传感器网络、通信协议;吴迪(1995-),男,上海理工大学光电信息与计算机工程学院硕士研究生,研究方向为抗干扰通信协议;罗力源(1996-),女,上海理工大学光电信息与计算机工程学院硕士研究生,研究方向为低功耗通信。