一种基于目标检测的偏斜图像校准方法

2020-05-14徐振杰陈庆奎

徐振杰,陈庆奎

(上海理工大学 光电信息与计算机工程学院,上海 200093)

E-mail:xuzhenjie12345@126.com

1 引 言

随着物联网技术的发展,越来越多的视频设备被运用到了我们的生活当中,而一些视频设备由于安装不当或是长期裸露在自然环境中受到如风,雨等自然外力的影响导致视频设备偏斜,严重影响到工作人员的使用.而如果人为对视频设备进行检测,由于视频设备众多,不仅将耗费大量的人力物力,更加重要的是人为检测极为不准确.相反,通过计算机视觉的自动化方法相较于人工检测具有检测精度高,检测成本低等优点.因此一种自动化的图像偏斜检测方法迫在眉睫.所以本文希望通过目标检测的方法得到此场景下每个目标的偏斜角度,从而推断出图像的偏斜角度.

近年来在计算机视觉领域,深度学习的进展取得了极大的成功[1-3].在目标检测领域,越来越多的目光聚焦在基于深度学习的方法上,并且也取得了长足的进步.R.Girshick等人提出RCNN[4]为目标检测奠定了良好的基础.虽然RCNN在计算和存储空间方便有明显的缺陷,但是效果依然优于传统方法.Fast-RCNN[5]通过共享参数变量有效增强检测效率和减少了存储空间.Ren等人提出了Faster-RCNN[6]用RPN网络代替随机搜索提升了效率和准确率,也组成了两阶段网络中重要的两个部分:候选区域(region proposal)和区域分类(region classification).

上述方法对水平区域的检测有很好的效果,但是对于物联网场景下,图像的歪斜程度情况极不一致,导致运用上述方法时,目标与目标框由于冗余背景的原因使得匹配并不准确.因此针对这一问题,许多研究者对此做出了贡献,Jiang等人提出R2CNN[15]在文字检测上取得了很好的效果,但是R2CNN仍然采用水平边界框.Ma等人提出了RRPN[16]通过加入带有角度的边界框有效提升模型的性能,但是其在处理感兴趣区域时会导致信息损失.但是相比简单的文字检测场景,物联网场景更为复杂,有许多复杂背景和噪音目标的干扰,以及目标框的重叠和遮挡极大地影响了目标检测的效果.Yang等人提出R2oI池化采样提取判别特征从而能够对任意旋转角度的船体进行检测[17].但是单纯只带有角度的边界框缺少方向性,容易造成角度混淆,因为当图像旋转角度为90°和180°产生的边界框是没有区别的,所以不能准确得到每个目标偏斜的角度,更不能推断出整张特征图的偏斜角度.为了解决这一系列问题,本文提出了基于目标检测的偏斜图像自动校准框架.

图1 偏斜图像校准整体框架

本文提出的框架主要由4个部分组成:AFPN网络,偏斜感兴趣区域变换,边界框回归以及偏斜图像自动校准.与基于传统目标检测的卷积神经网络相比,本文所提出的框架更加适合于校准角度变化范围较广的大规模物联网场景下的偏斜图像.

本文做出的主要贡献有:

1)AFPN

本文设计的增强金字塔特征网络通过对FPN[7]网络进行改进,有效地结合了低网络层中的位置信息的多尺度特征和高网络层中的语义信息的多尺度特征,为目标检测提供了更加有效的特征信息.

2)偏斜感兴趣区域变换

偏斜感兴趣区域变换中包括了三个阶段,分别为偏斜感兴趣区域学习机,偏斜位置敏感感兴趣区域校准以及偏斜感兴趣区域计算.其中偏斜感兴趣区域学习机的作用是对从水平感兴趣到偏斜感兴趣区域转换过程的学习.偏斜位置敏感得分图主要是来保证网络中的特征偏斜不变性,由于考虑了偏斜特征,因此使分类和回归达到更佳的效果.偏斜感兴趣区域计算改变了传统的感兴趣区域计算,使得边界框回归更加精确.

3)偏斜图像自动校准

通过引入direction损失,使得边界框具有方向性.并通过对每一个目标框的预测角度和direction预测值综合计算得到每个目标偏斜角度,解决了已有研究中缺少方向性的问题.从而对一张特征图中的所有目标的偏斜角度加权平局最终得到特征图的偏斜角度,然后完成自动校准.

2 相关工作

深度学习近年来在目标检测领域的运用越来越广泛,有很多方法取得了很好的效果,有依赖于候选区域的方法如:RCNN[4],Fast RCNN[5],Faster RCNN[6],R-FCN[9].也有一些并不依赖于候选区域的方法如SSD[13],YOLO[14],甚至提出了基于多尺度融合网络FPN[7]的方法,但是以上方法检测偏斜目标是,由于大量冗余背景干扰,因此不具备检测偏斜目标的能力.

在传统偏斜校正中,有许多对车牌,身份证,纸币等简单图像的校正方法[20,21],大都是通过传统图像处理的方法并检测边界框,但不具备对多样化的大规模物联网场景下的图像进行偏斜校正能力.而在深度学习的领域中,对偏斜目标检测较为常见的是对偏斜文字检测如R2CNN[15],RRPN[16].但是由于文字之间相隔空间相对较大,而实际自然场景下的偏斜目标之间的距离非常密集,所以实际自然场景下的挑战更大.最近也出现了有许多方法针对航拍船体检测,如利用旋转边界框和判别网络来检测任意旋转角度的船体[18],Yang等人提出R2CNN++[19],利用旋转不变探测器并结合多尺度注意力机制,在船体检测上达到了很好的效果.但是以上方法仅仅在边界框中简单地加入角度损失,缺少角度的方向性,所以都不能对偏斜图像进行准确的校准.直到目前为止,并没有一种完整有效的适用于大规模场景的图像偏斜校准方法,因此文本是首个提出基于目标检测的偏斜校准框架的方法.

3 图像偏斜校准方法

在这一章中,我们首先在3.1小节中给出图像偏斜校准方法的整体框架.其次,在3.2和3.3小节中分别阐述AFPN和偏斜感兴趣区域变换的作用.最后,在3.4小节中介绍如何引入direction损失到损失函数以及在3.5小节中说明如何对偏斜图像进行校准.

3.1 偏斜校准方法整体框架

偏斜图像校准方法的整体框架如图1所示.整体框架由4个部分组成:AFPN网络,偏斜感兴趣区域变换,边界框回归以及偏斜图像自动校准.首先输入特征图通过AFPN网络,AFPN是一个能够有效将多尺度特征融合的网络,将低网络层的语义信息与高层网络的位置信息结合,确保了检测目标的有效性.之后通过本文设计的偏斜感兴趣区域变换保证了图像特征的偏斜不变性.然后通过对loss中加入direction损失使得边界框具有方向性并分类与回归得到特征参数.最后将通过对输入图中每个目标的特征参数进行计算得到图像的偏斜角度,从而根据偏斜角度实现对偏斜图像的校准,并得到最终的校准结果.

图2 AFPN结构图和级联细节

3.2 AFPN网络

由于低网络层中的位置信息和高网络层中的语义信息对目标检测的准确度有着至关重要的作用.而FPN通过对多层尺度的融合,使得它是一种十分有效的多尺度检测方法,因此我们以FPN为基础.但是,众所周知,低层的特征图保留位置信息,而语义信息一般出现在高层的特征图中.FPN虽然进行了多尺度融合,但是小目标一般在低网络层中预测,所以缺少语义信息,而大目标在高网络层中预测,缺少位置信息.而在复杂的物联网场景下,会产生大量大小不一的目标. 因此本文针对FPN进行改进,提出AFPN(Augment FPN),如图2所示.与FPN相比,AFPN有更强的泛化能力.在前馈自下而上的神经网络中,我们以ResNet为基础,并选择每个残差块的最后一层作为特征图{C2,C3,C4}.根据残差网络的结构,每一个特征图的步长为{4,8,16}像素.在自上而下的神经网络中,我们将同层特征图的连接和上下层特征图的连接得到{P2,P3,P4}.并且通过设置所有特征图的通道数为256来降低参数的数量.计算公式定义如公式(1)所示.

(1)

其中Ci和Pi表示特征图,Convk×k(.)表示卷积操作,k为卷积核的大小,Upsample(.)代表上采样,⊕表示级联操作.

3.3 偏斜感兴趣区域变换

本小节主要介绍偏斜感兴趣区变换,其中感兴趣区变换与三个部分组成:分别为偏斜感兴趣区域学习机,偏斜位置敏感感兴趣区域校准以及偏斜感兴趣区域计算.

3.3.1 偏斜感兴趣区域学习机

由于偏斜的原因,导致目标框匹配不准确,因此我们通过设计偏斜感兴趣区学习机来解决这一问题.我们不直接在水平感兴趣区域中对边界框进行回归,而是通过角度变换,将水平感兴趣区域转换为偏斜感兴趣区域,从而对减少了不必要的误差,让学习更加有效.

在传统RPN神经网络主要是为了第二阶段提取粗粒度的边界框,因此为了提高RPN层的效率,本文只考虑得分排名前13000个的边界框作为非极大抑制的输入并得到2000个感兴趣区域.特征图经过AFPN获得了n个水平的感兴趣区域,记为Hi,其形式为x(i),y(i),w(i),h(i),θ(i),与其相对应的特征图记为Fi,形式也与其相同.本文通过设计全连接网络完成从水平感兴趣区域到偏斜特征感兴趣区域的推断,因此设计偏移量学习回归函数如公式(2)所示.

(2)

对于每一个特征图Fi,{tx,ty,tw,th,tθ}为全连接层的输出,计算公式如公式(3)所示.

t=G(F;W)

(3)

图3 边界框回归示意图

其中G(.)表示全连接层,W为全连接层的权重参数,F为特征图.在每一次前馈网络得到t后,通过解码器得到解码后的偏斜感兴趣区域参数.

3.3.2 偏斜位置敏感感兴趣区域校准

一旦得到偏斜感兴趣区域中的参数,我们就能从特征图中提取偏斜不变特征.由于池化会丢失位置信息,而R-FCN[9]通过提出位置敏感得分图使得在池化中增加位置信息.Mask RCNN[10]为了解决RoI Pooling导致的量化误差不匹配问题而提出RoI Align.本文受到以上两点的启发,为了使得我们的框架能够适合目标密集的图像,因此提出偏斜位置敏感感兴趣区域校准来提取具有偏斜不变性特征.

图4 偏斜位置敏感感兴趣区域池化

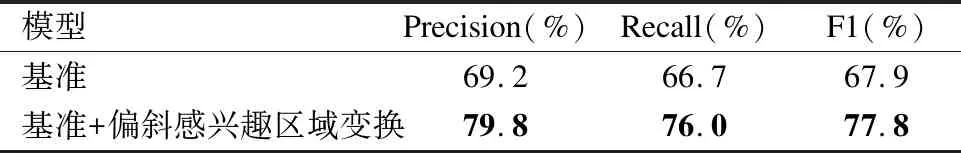

我们记输入D为用有H×W×C个通道的特征图,偏斜感兴趣区域的参数为(x1r,y1r,x2r,y2r,hr).通过偏斜位置敏感感兴趣区域池化将所得到的偏斜感兴趣区域分为k×k个大小相等的网格区域如图4所示,并输出特征图y,其形状为(K×K×C).对于每个网格,它的索引为(i,j)(0≤i,j≤k),输出通道为c(0≤c (4) (5) 与Mask RCNN的RoI Align相同,我们对公式(4)使用双线性内插法. 3.3.3 偏斜感兴趣区域计算 由于在本文场景下会生成不同角度的边界框,因此传统的感兴趣区域计算会导致偏斜的边界框的计算不准确,进而导致边界框的学习不准确.因此本文根据三角剖分法[11]设计了一种偏斜感兴趣区域的计算方法.对于给定一个边界框集合R1,R2,…,Rn,计算每两个边界框 为了更加关注目标的偏斜程度而不是目标的种类,因此本文采用二分类而不是多分类损失函数的端到端网络训练.由于上一节提到存在角度混淆情况,因此我们对边界框的四个方向进行标注,使得边界框具有方向性.如图6所示,我们为每一个边界框另外标注使其具有方向信息,具体将其标注为四个方向(direction0,direction,direction2,direction3).因此本文的损失函数设计如公式(6)所示. 图5 偏斜感兴趣区域计算示意图 (6) Lcls(p)=-logp (7) (8) (9) 每张输入图像通过上述网络我们可以分别从回归和分类网络中得到(x(i),y(i),w(i),h(i),θ(i)),direction(i)和p(i),其中通过θ(i)和direction(i)计算边界框偏斜的角度,如图6所示. 由图6很容易可以看出,偏斜框的最终角度是由所预测的direction和θ计算得到,计算公式为公式(10). (10) 式中θr为网络预测得到的角度,当预测direction得到direction1时,k值设为-1,当direction为direction0时,k值设置为0,当direction为direction3时,k值设置为1,当direction为direction2时,k值设置为3. (11) 图6 边界框偏斜角度计算 在本章中,我们将对所提出的偏斜图像校准框架通过一些对比实验对框架效果进行验证.本文中所有的实验都是在NVIDIA TITAN X GPU上完成的. 由于公开数据集中偏斜图像的数据集较为少见,所以我们通过视频采集得到1564张偏斜图像,主要场景为公共汽车,地铁,商场,上下扶梯等一些常见的拥有视频设备监控场景.为了获得更多样的偏斜状态下的图片使数据集更加充分防止过拟合,我们对一有数据集中的每张图像进行旋转,并每隔20°采样,因此得到28152张图像(1564×18). 我们所有的实验均在tensorflow[12]深度学习框架上搭建.我们首先将预训练好的ResNet-101初始化网络.梯度下降策略为随机梯度下降(SGD),并以0.001学习率和batch为16作为初始值迭代9万次.在迭代到6万次和8万次的时候分别将学习率改变为0.0001和0.00001.权重衰减和momentum分别设置为0.0001和0.9.优化器我们选择的是MomentumOptimizer. 由于低网络层中对目标位置回归较为准确,但是特征的语义信息有所牺牲.与之相反的是,在高网络层中,特征的语义信息充分,但是目标位置的预测却不尽人意.因此对特征图的选择尤其重要.本节中,我们选择6个不同的特征图的组合策略验证我们的结构,实验结果如表1所示. 表1 不同特征图组合策略的性能表现 Table 1 Performance of different feature maps combination strategies 组合策略Precision(%)Recall(%)F1(%)P269.557.763.1P375.364.869.7P471.660.165.3P2,P375.267.471.1P3,P477.673.475.4P2,P3,P479.876.077.8 从中可以看出,在只有单个特征图时,结果不尽人意.但是,由P3比其他两组的结果要好,说明在我们的数据集中边界框的匹配大都集中在P3中.由于大目标的预测一般在高层P4中,小目标的预测一般在低层P2中,又因为P3,P4的组合结果要好于P2,P3的组合,因此我们得以知道我们的数据集中被检测的大都为大目标.最终由P2,P3,P4的组合表现结果最优,准确率为79.8%,召回率为76.0%,F1为77.88%,因此说明我们所提出的的AFPN有非常好的效果. 我们以我们所设计的AFPN为基准网络,用传统目标检测中的RPN网络和损失函数,回归参数为(x,y,w,h),与本所设计的偏斜感兴趣区域对比,实验结果如表2所示. 表2 偏斜感兴趣区域变换的性能表现 Table 2 Performance of IPS ROI transform 模型Precision(%)Recall(%)F1(%)基准69.266.767.9基准+偏斜感兴趣区域变换79.876.077.8 从实验中可以明显看到,是否拥有偏斜感兴趣区域变换对检测效果具有非常大的影响.主要基准网络并有没有对偏斜特征进行考虑,使得对于偏斜对象的检测包含了太多的冗余信息.当图像中的目标密集时,这个缺点就被放大了,造成大量的边界框重叠,极大的影响了检测的效果.如图7所示,(a)和(b)分别是基准网络所检测的结果和标注图片,(c)和(d)分别是加入偏斜感兴趣区域变换的结果与标注图片.可以很明显的看到由于大量的遮挡,基准网络的结果中有许多目标并没有正确预测.而恰恰相反,由于加入偏斜感兴趣区域变换使得边界框中的冗余信息减少,也大大降低了检测的复杂程度,得到了比较好的效果.这说明我们所提出的方法对目标检测的准确性较好. 图7 与基准方法对比 通过横向对比,我们分别对RRPN[16]和R2CNN[19]在本文制作数据集中进行验证,如表3所示.可以看到我们所用的方法准确率略高于RRPN和R2CNN.我们认为是因为本数据集中包含了很多目标较为密集的图像,而上述两种方法主要是针对倾斜文字的检测,而文字之间的距离一般较大.而本文的方法中恰好是由于引入了偏斜位置敏感感兴趣区域校准,使得在池化时减少了对位置信息的损失,从而也使得对目标较为密集的图像检测效果相较于其他方法更好. 表3 与其他方法的对比 Table 3 Comparison with other method 模型Precision(%)Recall(%)F1(%)RRPN75.879.276.9R2CNN78.474.376.2Ours79.876.077.8 为了准确得到图像校准的精确度,我们从测试集中筛选出原本并不偏斜的图像,并通过旋转得到偏斜图像,从而我们能够知道该图像准确的旋转角度.我们从测试集中一共得到68张未偏斜图像,通过以20°为旋转步长,一共得到1224(68×18)张图片.我们分别设定预测的角度与真实的角度偏离阈值为±7°,±5°,±3°,±1°.如果预测的角度与真实角度的偏离值不超过阈值,则判定为正例,否则判定为负例,并计算预测准确率.并与是否在损失函数中加direction损失进行对比实验,实验结果如表4所示. 表4 不同损失函数偏斜角度预测准确率 Table 4 Accuracy of inclined angle prediction in different loss function ±7°±5°±3°±1°没有direction损失87.28%80.92%73.34%66.26%加入direction损失98.82%94.69%87.53%78.36% 从表中可以看出,由于没有加入direction损失,导致方向信息的缺失,从而导致角度预测的准确率较低.从横向数据来看我们的模型预测角度的偏差基本不会超过±7°,且大部分预测的偏差值在±3°到±5°之间,小于±1°偏差的准确率偏低.但是由于大部分角度预测偏差在±3°到±5°之间,所以我们认为该误差也是可以容忍的. 本文以解决物联网场景下的图像偏斜为背景,以神经网络目标检测的方法为切入点,提出了AFPN网络,有效地结合了低网络层中的位置信息的多尺度特征和高网络层中的语义信息的多尺度特征.并通过偏斜感兴趣区域变换去除了冗余信息并学习得到边界框角度,是偏斜图像校准的重要组成部分.虽然得到了角度,但是由于角度混淆,所以方法缺少方向性.因此通过在损失函数中加入direction损失,增加了边界框的方向性.最终通过对偏斜角度的加权平均,成功预测角度.该算法可以通过对偏斜图像中的偏斜目标成功预测偏斜角度,并得到偏斜图像的偏斜角度而且可以对图像自动校准,从而节省大量的人力校准图像.尤其是我们所提出的的框架具有一定的通用型,能够对大部分图像运用此框架.但是预测角度阈值在的准确率在±1°时还有待提高,这也是我们接下来进一步研究的方向并提高准确率.

3.4 损失函数

3.5 偏斜图像校准

4 实验及分析

4.1 数据集和训练细节

4.2 验证AFPN

4.3 验证偏斜感兴趣区域变换

4.4 偏斜图像校准准确率

5 结 语