光场成像原理及应用技术

2020-03-23张韶辉程雪岷

张韶辉,胡 摇,,曹 睿,程雪岷,郝 群,

(1.北京理工大学 光电学院 精密光电测试仪器及技术北京市重点实验室, 北京 100081;2.清华大学 深圳研究生院, 广东 深圳 518055)

光是一种于空间中分布和传播的电磁场,具有波长、振幅、相位、偏振位置和方向等多种属性[1]。通过利用物体所发出或反射、散射、衍射的光进行成像来获取信息,是一种非常重要的传感方式。

光包含多个维度的信息,传统成像方式属于降维采样,一方面,由场景发射出的光场中包括三维空间位置及两维空间传播方向信息,通过积分的方式记录在二维传感器,如胶片、CCD或CMOS上,所成像类似于三维空间中一个焦点固定的二维切片图,焦点部分清晰,离焦部分虚化,方向信息被压缩。这种成像方式对目标的信息还原度低,场景的三维立体分布信息无法获取;另一方面,时间、偏振以及波长等信息采用传统成像方式同样难以获取或者在很大程度上被压缩,传统成像装置不具备分辨光场的时间特征参数的能力,无法获得光从场景中各个区域传输到探测器上的时间差别。此外,传统CCD/CMOS等传感器无偏振及波长选择功能,虽然彩色传感器能够依靠滤光片获取RGB三色数据,但无论波长的探测精度还是探测范围仍然有很大的限制。

传统成像方式压缩了诸多光场参数,包括传输方向、波长、相位等在内的光场信息,通常携带着诸多重要场景目标信息,降维采样的方式获取信息的局限性越来越突出,因此无论从基础理论、描述模型及方法还是光场信息获取及高效利用等各个角度,对光场进行研究都具有非常重要的意义。

与传统方式相比,光场成像技术通过同时控制或记录包含位置和传播方向在内的多维度光学参量,相较于传统成像法能够获取更完备的信息[2]。光场的基本表述模型以及在此基础上发展出的各种光场采集以及控制方法,可极大地改变成像、测量以及显示的方式,在日常生活(光场相机获取空间位置及传播方向)、工业测量(结构光投影调制光场位置信息、偏振相机获取偏振状态)、自动驾驶(激光雷达获取光场时间信息)、军事国防(高光谱成像获取光场波长信息)、生命科学研究(显微测量获取空间位置及传播方向)、增强现实(Augmented reality利用光场信息进行3D显示)等方向上都有非常大的发展和应用前景。本文将对包含位置和传播方向的狭义光场信息表述、获取及利用进行综述。

1 光场理论发展历程

法拉第指出,光场指光在每个方向上通过每个点的通量。针对光的特性,逐渐形成和发展出了几何光学和物理光学两种描述光场的理论,几何光学将光场理解为光线的集合,而每条光线携带空间坐标以及传播方向信息,两者相互独立,该模型在描述非相干光时较为方便,但无法描述干涉、衍射等现象;物理光学将光描述为波,能够描述波长、相位、偏振等特征,其在描述及预测相干光干涉、衍射等行为上更为方便和准确,然而物理光学对于非相干光的描述较为复杂和繁琐。

将光场看作一系列光线集合的几何光学表述方法始于1936年,Gershun[3]在其著作《The Light Field》中提出光场的概念,指出光场是针对光通量空间分布的研究,认为光辐射能在时间及空间中是连续的,并且此辐射能的通量在空间不同点之间连续变化,在此基础上Gershun提出了光矢量的概念以及相应的计算方法,通过向量几何分析以及积分的方式能够得到各个位置的光场信息分布,但是由于庞大的计算量限制,该方法及理论未能得到实际的应用。

1991年Adelson,Edward H等[4]提出全光理论,该理论采用七维函数 来表征空间分布的几何光线,其中表示光线中点的空间坐标,表示光线的传输方向,表示光线的波长和传输时间,由于光线的波长在传输过程中不会改变,因此任意时刻的自由空间光线可由五维函数完整表示。

1996年Marc Levoy等[5]提出采用两个相互平行的平面上的点坐标来对光场进行参数化特征描述的方法,将五维光场函数降至四维,在此基础上提出了具体的光场信息传播、成像等操作的计算公式,此理论以及计算机技术的飞速发展使得计算光场领域飞速发展。

此外,Wigner分布方程也可用来同时描述多维光场信息,其能够同时体现光场的二维空间位置以及二维的空间频率,然而光场的空间频率与传播方向只有在相干光的前提下才具有对应的关系,因此Wigner分布方程通常只用于相干光场的描述。而基于几何光学的四维光场函数数学描述方法适用于非相干成像过程中。Marc Levoy等[6]在相干光情况下分析了四维光场描述理论同Wigner分布函数的等效关系。

四维光场理论在计算成像领域取得了很好的成果,基于该理论发展出的一系列光场技术在很大程度上改变了传统的光学成像和测量的理念和方式。

2 光场的几何光学表述

根据几何光学的光线假设,光场即为空间中所有光线辐射函数的集合,每条光线携带二维位置信息以及二维传播方向信息(θ,φ)。Marc Levoy等[5]提出的光场渲染理论指出空间中携带位置和方向信息的光线都可以用两个相互平行的平面来参数化表示。如图1所示,一条光线穿过两个平行平面上的两点,坐标分别为(u,v)和(s,t),两平行平面之间的间距为F,由两个点的位置坐标即可获取光线的二维角度信息,因此可用四维光场函数LF(s,t,u,v)表示。根据四维光场函数,从u,v面射向s,t面上某一点的图像辐射照度可以由光线辐射度的积分公式表示为:

(1)

图1 光场的四维参数化表示

由透镜面和传感器面定义的光场函数LF(s,t,u,v)与由透镜面和重聚焦面定义的光场函数LF′(s,t,u,v)之间的关系可通过几何变换获得,如图2所示,四维光场函数在空间中的传播相当于一个切变变换[7-8]。

LF′(s,t,u,v)=L(α·F)(s,t,u,v)=

LF(u+(s-u)/α,v+(t-v)/α,u,v)=

LF(u(1-α)+s/α,v(1-α)+t/α,u,v)

(2)

图2 四维光场函数在空间中的传播变换示意图

根据式(1)、式(2),可得到四维光场函数在任何位置的二维切片表述,此方法简洁高效,可以方便地采用数字化的方式描述和处理光场信息,因此以光线为基本假设的四维光场表达方式在计算成像领域发展迅速、应用广泛。

3 光场的获取方式

对光场理解和表述的差异决定了获取光场函数形式的不同,但无论采用何种方式描述,能够实现对四个维度的光场参数信息进行区分和测量的技术都属于光场获取技术的范畴。应用较为广泛的技术手段主要包括以下3种。

3.1 相机阵列或相机扫描

相机阵列获取光场信息是指通过多个相机在空间中的特定分布来获取不同视角下场景图像的方式,各相机获取的是四维光场在该相机相对于场景方向上的二维投影,将相机所得图像进行融合即可得到完整的四维光场数据。大尺度空间相机阵列主要用于合成孔径成像实现“透视”监测,或通过拼接实现大视角全景成像,紧密排布相机阵列主要用于获取高性能动态场景或者场景的三维分布和结构等信息。在相机阵列实现光场测量方向比较成功的有:MIT的8×8相机阵列[9]、卡耐基-梅隆大学的“3D Room”等[10-11],国内清华大学的戴琼海教授团队研制的基于相机阵列的光场显微镜[12]以及与南京大学的曹汛教授共同提出的3D+光场矩阵拍摄也取得了很好的成果[13-15]。

除多个相机阵列排布外,Marc Levoy[5]、Aaron Isaksen等[16]采用单相机扫描系统,通过相机在固定导轨上的移动分时获取不同空间视角下的场景图像,最终进行融合也可以实现同样的功能,但由于需要扫描,此种方法适合静态场景的光场测量,并且测量的精度受到相机移动定位精度的影响。图3和图4分别为相机阵列及单相机路径扫描方案实现光场信息获取的案例。

图3 相机阵列光场信息获取案例

图4 单相机扫描光场信息获取案例

3.2 微透镜阵列

相机阵列体积巨大,使得其应用场合受到很大限制,将相机阵列中各个成像单元之间的基线缩小,可实现在单个相机框架下通过微透镜阵列来实现光场信息的采集。图5为基于微透镜阵列获取光场信息的原理示意图,在普通成像系统主透镜的一次像面处插入微透镜阵列,每个微透镜单元及其后对应的传感器区域记录的光线对应场景中相同部分在不同视角(对应光线不同传播方向)下所成像的集合,因此采用二维透镜阵列能够得到同时包含位置和传播方向在内的四维光场数据。

图5 微透镜阵列成像原理示意图

1992年,Adelson等[17]首次提出基于微透镜阵列的光场相机模型;Ren Ng等[8]优化了该模型,通过优化光路缩小体积实现了手持式光场相机产品,于2010年成立Lytro公司[18],现已推出图6(a)和图6(b)所示的Lytro(Plenoptic1.0)与LytroIllum两款消费级相机,可实现“先拍照,后聚焦”的功能,在低光及影像高速移动的情况下,仍能准确对焦拍出清晰照片。

同Lytro所生产的消费级产品相比,德国Raytrix公司自2008年创立起即从事工业级光场相机研究和推广[19]。图6(c)与图6(d)所示为其推出的Raytrix R5、Raytrix R11系列光场相机,可用于立体显微、自动光学检测以及三维形貌检测等科研及工业领域,在人脸识别、交通监控以及瞳孔扫描等公共安全领域以及太空、军事等国防领域也都有相关的解决方案以及应用案例。

基于微透镜阵列的光场相机技术方案发展迅速,除Lytro及Raytrix外,诸多科技公司也陆续推出了光场相机或光场成像模块[20-25],图7(a)为Adobe magic lens光场相机[20],图7(b)为Cafadis基于微透镜阵列的镜头及相机[21],图7(c)、图7(d)分别为Toshiba[22]与Pelican[23]公司推出的光场成像模块。

图6 光场相机

图7 光场相机及模块原型样机

基于微透镜阵列的光场相机获取光场信息的方案,其优点是各成像单元间相对位置及角度关系稳定、系统体积小、可移植性强、相应的数据处理方法及软件成熟,缺点是通过牺牲空间分辨率来获得角度分辨率,在要求高空间分辨率的场合无法满足要求,为解决空间与角度分辨率不可兼备的问题,基于光场相机的超分辨理论研究也逐渐获得关注。

3.3 掩膜及其他

微透镜阵列获取光场方案通过牺牲空间分辨率来换取角度分辨率。与之相比,掩膜法通过在相机主镜头与传感器之间插入的光学掩膜来实现对进入相机系统中的光进行调制,并在感光元件记录之后通过算法进行四维光场信息的恢复。典型方案为VeeraraghavanAshok通过在普通相机光路中插入掩膜实现的光场相机[26]。如图8所示,基于掩膜的光场采集系统获取的图像看似与普通相机类似,但其频域呈规律性分布,与光场数据的频域特性类似,能够通过相关处理得到四维光场信息。此类方法的优点在于掩膜是非折射元件,硬件系统更加简单,初级数据处理更加容易,比微透镜阵列结构更容易实现。此外,Antony orth等[27-29]提出Light field moment imaging(LMI)采用在不同离焦位置采集二维图像的方式同样可得到四维光场数据,加州理工学院的Guoan Zheng等[30-32]提出傅里叶叠层成像技术(Fourier Ptychography imaging),通过采用不同传播方向的相干光照明样本或者扫描孔径的方式,得到了四维光场数据并实现了数字重聚焦。

图8 掩膜光场采集系统原理示意图

4 光场数据处理技术及应用方向

光场数据处理的主流方式都是基于光线假设的四维光场理论模型,依据用途区分,主要的处理方法大致包括数字重聚焦、3D成像、合成孔径、光场渲染、立体显示等五种。

4.1 数字重聚焦

根据测量得到的四维光场数据,进行数字重聚焦可以在不受主透镜景深的限制下获得各个平面的清晰图像,因此在测量时无需对特定平面进行对焦,摆脱了传统成像中景深的限制,并提供了三维成像的新思路[7,33,34]。数字重聚焦处理方式主要有两种:空域积分投影和频域切片变换。

空域积分投影在获取四维光场函数LF(s,t,u,v)之后,可根据式(2)进行变换进而得到各个重聚焦面上的光场函数LF′(s,t,u,v),在每个重聚焦面上根据式(1)积分,从而得到该特定面上的像。因此,此方案能够获得各个重聚焦面上的清晰图像。

然而空域积分投影所实现的光场数字重聚焦,计算量指数上升,计算速度慢。斯坦佛大学的Ren Ng将医学以及天文学中常用的傅里叶切片法引入到光场信息处理中,实现了在频域中的数字重聚焦,减小了计算量,可以快速获得各个面处的清晰像[7-8,18]。由于频域傅里叶切片成像法实现数字重聚焦的计算量要远小于空域积分投影法,因此,此方法目前已经成为光场函数数字重聚焦的主流。图9为单次获取四维光场数据后进行数字重聚焦所得到的各个深度的清晰成像结果。

4.2 3D成像

基于四维光场数据的3D成像核心为场景的深度信息提取,相关主流算法大致可分为3个方向:1)基于极平面图像的深度估计;2)基于多视图立体几何约束的深度估计以及3)光场数字重聚焦深度估计。

极平面图像(Epipolar Plane Image,EPI)为四维光场信息的二维切片,包括一个空间尺寸维度与一个角度维度,场景中一个物点在EPI中显示为一条倾斜的直线,该直线的倾斜度与该物点到相机的距离成比例[43],如图10所示。因此,从光场相机或者相机阵列所获取的四维光场数据中选取二维EPI切片,通过对应物点的斜率来获取其深度信息。此方法源自多视图几何理论框架,Sven Wanner[35],Michael W.Tao[33]等提出系列改进和优化算法,实现了较为清晰的深度图的获取,细节比较平滑,同时节约了深度信息提取的时间。

图9 各个重聚焦面的聚焦结果(A1~A5)和多个重聚焦面合成图像(B)

图10 EPI斜率与点三维坐标对应原理示意图

在相机阵列与单相机集成微透镜阵列方案中,光场获取装置可等效为多视图几何模型,其最简化版为双目视觉系统。双目视觉系统通过模拟生物眼睛产生立体视觉的效果,图11 为双目系统深度测量原理[36],目标物点在两个像面上成像位置不同,产生视差,通过视差数据以及各相机外参关系即可获取目标物点的深度数据。在立体匹配误差相同的情况下,由视差数据获取深度信息方法中,深度信息的精度与基线长度直接相关,基于微透镜阵列的光场相机中各等效子孔径间基线很短,采用传统匹配方案难以获取高精度的深度数据信息。因此,在此方向的研究主要集中于增加约束信息以获取更精确地视差图算法上,Adam Bowen,Tom E.Bishop 等人以颜色信息增加约束提取了全分辨率的深度图像[37-38];Francisco C.Calderon,Tom E.Bishop,NeusSabater等人充分利用光场相机的多个视角信息,对匹配点进行多重约束,提高了特征匹配的精度[39-41]。

根据光场相机得到的四维光场数据,以及傅里叶切片法可进行数字重聚焦,获取焦点堆栈图像,通过清晰度评价等像质评价方法以及成像系统物像关系特征,可计算重构出目标场景的深度图。在此框架下,Michael W.Tao采用梯度检测和图割的方式获取了全聚焦图像,并利用朗伯反射体表面特性以及光照和阴影信息分析数字重聚焦的角度关联性,将离焦与特征匹配相结合,得到了更为清晰和可靠的深度数据[33],如图12所示。

图11 双目系统深度测量原理示意图

图12 离焦与特征点匹配结合的深度效果图

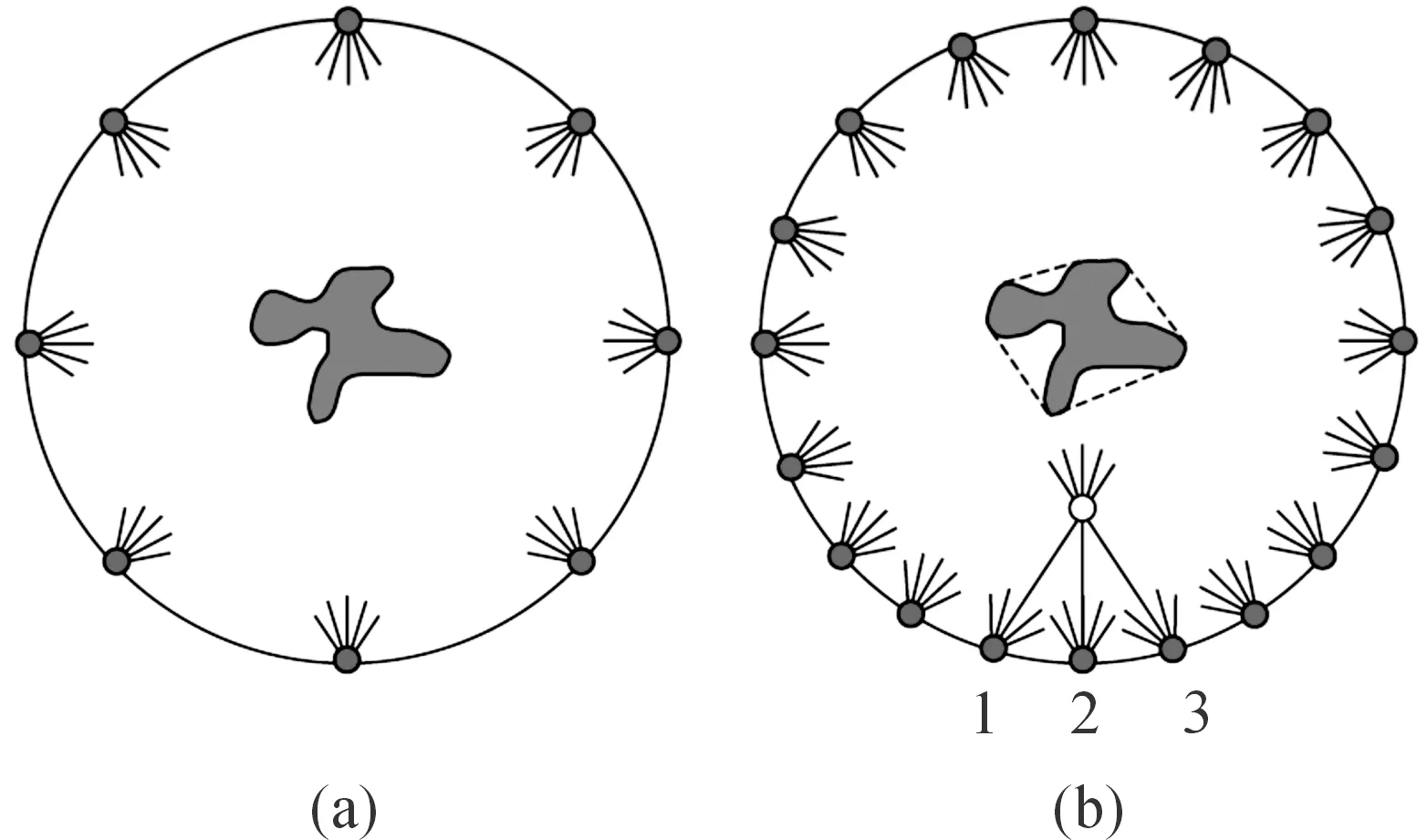

4.3 合成孔径成像

图13(a)展示了针孔成像的原理,光线通过一个针孔成像,形成一个弥散光斑,针孔半径越大,参与成像的光通量就越大,但是弥散斑的尺寸也就越大。图13(b)将小孔由透镜替换,理想的透镜能够实现“点物成点像”,物面上的点理想情况下在像面成完美的点像,如果有一点障碍物在景深范围之外的空间平面上,则其在像面上会形成弥散圆,从而失去遮挡的效果[2]。图13(c)中透镜孔径扩大至与物距可比拟,此时成像系统的景深很小,只有聚焦面及其附近的点能够清晰成像,其它偏离聚焦面的点则会形成弥散斑,图13中障碍物只能部分得遮挡由点物发射并进入到探测器的光。由于孔径很大景深很小,障碍物将在像面上形成一系列直径很大的弥散圆而不足以遮挡目标物,目标依然能够在像面上清晰成像。因此,原则上讲只要成像系统的孔径足够大,就能起到一定程度的跨越障碍物成像的目的。但增大单一成像系统的尺寸代价大且会附带明显的边缘相差等问题,图13(d)为采用合成孔径的方式扩大相机的“孔径”尺寸,将处于各个位置的子相机认为是一个超大孔径相机的一部分,将其各自所获取的图像进行合成,从而实现穿越障碍物对目标物体清晰成像甚至三维成像及定位。此外,相机阵列合成孔径还可以实现在保证分辨率的前提下扩展视场范围等功能。

图13 基于光场的合成孔径成像原理图

经典的光场相机阵列合成孔径成像系统根据设定的聚焦平面将从不同角度获取的场景图像投影到同一个图像平面上[2,42],使得观察者能够透过场景中的遮挡物看到被遮挡的物体。

图14为采用相机阵列实现的穿越障碍物对感兴趣区域进行成像的示例,依靠相机组成阵列的方式合成较大孔径进而实现穿过障碍物成像在军事、民用等多个领域都有应用,例如加州大学伯克利分校的Laura Waller等人开展了基于光场技术的穿过强散射介质进行成像的研究[43],这对于强雾霾天气以及多云天气机载光学雷达以及星载光学成像系统进行清晰成像和探测具有很大的帮助。

图14 相机阵列合成孔径穿越障碍物成像示例

4.4 光场渲染

图像渲染技术是指在不对目标进行建模的情况下,根据输入的原始图像数据集进行处理并得到输出目标图像。传统的图像渲染方法依据各次图像采集时相机之间的几何参数转换或者图像之间的匹配关系,如图15所示。Marc Levoy等人提出光场渲染的方法[5],在不需要图像的深度信息或精确匹配的情况下,通过构建多相机系统或者单相机位置扫描获取目标场景的原始光场信息,各原始图像构成四维光场数据,针对目标位置及角度的场景信息,从此四维数据中进行简单重采样即可获得从任意角度及位置观察目标场景的二维光场切片,此方法较为简单且鲁棒性强,渲染速度快,精度高。

图15 光场渲染原理示意图

4.5 立体显示

将相机阵列或微透镜阵列采集光场信息的过程反转可实现三维显示,采用阵列分布的投影装置同时进行二维投影,最终在特定的区域内能够实现三维真实场景的再现,利用这种增强现实的方法实现裸眼3D[44-46],可为军事对抗及模拟,单兵及机械实时地形现实等提供技术支持。图16为NVIDIA头戴式近眼光场显示原型及效果图[47];图17为南加州大学采用多视投影原理实现的真人1∶1光场显示系统[48]。

图16 NVIDIA 头戴式近眼光场显示原型

5 总结和展望

光场包含多个自由度的信息,而传统成像方式将光场进行降维积分采集到二维的胶片或电子传感器上,丢失了很多原始数据,这种认识客观世界的方式信息获取不够完善。光场成像理论的出现使得人类开始关注更加完备的光场信息获取及利用,通过采用一系列手段控制或者测量四维光场参量,能够获取更为丰富和全面的被测场景信息,这是一场关于光场原始信息采集的重大变革,改变了成像的思维方式,打开了新的认识世界的窗口。

图17 南加州大学真人1∶1多视投影光场显示系统

随着光场成像描述理论的完善以及光场控制和获取技术的发展,光场成像技术已经并正在逐步改变人类认识世界的方式。包括手持式光场相机、光场显微镜、结构光投影测量、相机阵列、合成孔径、AR3D显示等一系列技术及产品,在人们日常生活、科学研究、生产实践、军事国防等多个领域发挥了重大作用。

相对于传统的测量、成像及显示方式,光场技术优势明显,但并非成熟,无论从描述理论还是实现手段都仍存在很大优化空间。用于描述光场函数的两种方式各有利弊,基于光线假设的四维光场函数物理形象清晰,所得数据容易与计算模型相结合,但是无法完整地反应干涉衍射等现象,而基于Wigner分布函数的光场描述方式能够较为完备地涵盖光场的多维度信息,但是难以用于描述非相干光场,且与计算成像体系融合难度较大,虽然一些科学家将这两种理论进行了一定程度的互通和联系,但是依然存在着较大壁垒。在获取光场信息方面,获取及操纵四维光场信息以牺牲其它参数指标作为代价,例如采用微透镜阵列的手持式光场相机以及光场显微镜牺牲了空间分辨率来换取多视角视图,相机阵列在大程度上增加了系统的体积,Ptychography以及Fourier Ptychograph等方法则是通过延长测量时间来获得四维光场数据。如何权衡及兼顾牺牲与增强的参数类型是目前光场成像技术的研究热点,此外光场成像技术与计算成像相结合,具有非常大的计算量,这也使得数字存储以及处理器的速度在一定程度上成为光场成像技术发展的限制。

综上所述,光场成像是一个较新的理论及技术发展方向,目前已经在科学研究、生产生活、国防军事等方面发挥出了显著的作用,但在理论描述、技术实现、软硬件处理能力、商业化成本以及使用便捷性等方面仍然存在着诸多亟待解决的问题。光场理论及成像技术仍然处于飞速的发展阶段,随着时间的推移,光场技术将会更大程度地改变人们认知及改造世界的方式。

6 结论

整体而言,从原创性角度,在光场信息的获取、处理及应用等各个方面,国内相关研究都处于跟随者位置,从研究水平的角度看,也基本与国际前沿维持在同一个水平线上。

当前主流的光场信息获取手段为基于微透镜阵列的光场相机,然而国外企业已构建相对成熟和封闭的专利体系,并以德国的Raytrix和美国的Lytro公司生产的科研和消费级的系列产品为代表,垄断了绝大部分市场。光场信息的获取是处理和应用的前提,因此,国内光场领域的长期稳定发展需要在光场方法及装置方面进行更加深入的研究,如何在国外现有方法和专利体系保护的环境下,研制及构建出自主知识产权且具有一定市场竞争力的光场信息获取设备,是国内光场技术长期稳定发展的必要条件。在几何光场获取方式研究相对完善和饱和的情况下,通过将物理光学中相关光学传播规律及技术(利于光强传输方程)应用于光场信息的获取,或许为实现新型光场获取手段的可行方向及突破点。

目前而言,光场信息(仅考虑四维光场)获取的手段发展已比较完善,但其应用方向还有待进一步开发和拓展。数字重聚焦及三维重构为当前最主要的两个光场应用方向,数字重聚焦概念自Ng Ren提出以来发展较为成熟,已在Lytro产品中得以应用。三维重构则大多数以传统的多目立体视觉为理论基础开展,由于光场相机尺寸较小,各子视场间基线较短,限制了高精度视差图的获取,因此,目前此方面研究相对比较缓慢。针对这一现状,一方面,国内可在利用光场信息进行三维重构这一具体应用上开展更多的工作,例如,采用深度学习方法,充分利用光场信息进行多目立体视觉系统视差图的获取或许为可进行进一步尝试的方向。此外,将光场信息的应用领域进行拓展具有更大的意义,除数字重聚焦及三维重构外,由于其信息的丰富性,光场技术还有用于去雾成像、水下成像、三维物体识别、超分辨成像等诸多领域的潜力,拓展光场信息的应用范围,开展基于光场信息的新的研究方向亦为国内进行光场相关研究的方向之一。

此外,本文主要以四维光场信息为对象,相关的成像理论及光场信息利用方式都仅考虑光线的二维空间位置和二维传播方向。然而真实的光场包含更多维度的信息,从几何光学角度的四维光场信息到包含相位、偏振、波长等在内的物理光学角度的光场信息,其获取及应用具有非常重要的研究意义和应用前景。建立更为完善的光场理论模型,并充分研究更多维度光场信息的获取方式、处理手段以及应用方法是国内在光场领域进行尝试和探索的可行方向。