面向低视角场面监视的移动目标速度测量

2020-03-11张天慈丁萌钱小燕左洪福

张天慈,丁萌,钱小燕,左洪福

(1.南京林业大学 汽车与交通工程学院,南京210037; 2.南京航空航天大学 民航学院,南京211106)

机场场面监视是高级场面运动引导与控制系统(Advanced Surface Movement Guidance and Control System,A-SMGCS)的核心功能之一,也是确保安全、高效场面运行的重要基础。近年来,智能视频监视技术[1]的快速发展为机场场面监视提供了一种低成本解决方案。与多点定位、广播式自动相关监视(Automatic Dependent Surveillance-Broadcast,ADS-B)等协作监视方式不同,智能视频监视属于非协作监视技术,无需监视对象安装应答设备。同时,智能视频监视成本低廉,符合随通用航空器快速发展而出现的中小型机场的需求,也可作为大型机场的辅助监视手段[2]。目前,机场场面的智能视频监视研究主要围绕移动目标识别、跟踪、定位等几个方面。文献[3]通过在图像中检测航空器注册码进行航空器识别。文献[4]提出一种地图辅助的贝叶斯跟踪滤波算法实现移动目标跟踪。文献[5]通过摄像机标定确定航空器的三维空间坐标,并将视觉监视系统获得的定位信息与ADS-B系统获得的识别信息进行关联,实现航空器自动挂标牌。文献[6]利用背景减除和监督学习方法对停机坪区域的移动目标进行检测,并利用立体视觉算法确定移动目标的三维空间坐标。文献[7-9]研究了基于视频图像的停机坪运行监视技术,包括运动检测、跟踪与行为分析,以提供停机坪活动的位置、时间等信息。

近年来,机场自动化水平不断提升,以四维轨迹(4-dimensional trajectory)为基础的场面运行方式成为新的发展方向[10]。为实现基于四维轨迹的场面运行引导与控制,实时测量移动目标的运动速度显得十分关键。在机场场面视觉监视系统中,对移动目标进行准确的三维空间定位是速度测量的基础。现有研究一般通过目标检测与跟踪算法确定移动目标在图像中的边界框(bounding box),然后根据边界框中心点坐标确定移动目标位置[6,9]。摄像机视角较高时,能够获得移动目标的俯视图,移动目标高度或相对摄像机的方位对边界框的影响较小。此时,边界框中心即为移动目标几何中心,可近似认为位于地面上,通过单应矩阵即可确定其三维空间坐标[11]。而摄像机视角较低时,所得侧视图中移动目标边界框的中心点很少与移动目标中心重合,并且通常不在地面上。通过单目视觉难以确定边界框中心点的高度或距离。同时,边界框的位置、大小易受移动目标与摄像机的相对方位及目标检测算法稳定性的影响,准确计算移动目标位置较为困难[11-12]。

实际机场场面摄像机的安装高度与航空器机身高度相差不大,只能获得低视角的场面运行视频。针对这一特点,本文提出一种不依赖移动目标边界框的速度测量方法。该方法通过检测图像特征点及对特征点进行持续跟踪和分析,实现移动目标运动速度测量。与边界框相比,图像特征点具有较高辨识度、不易受观测角度变化等因素影响。同时,每个移动目标包含多个特征点,有利于避免个别特征点检测或跟踪错误导致的速度测量误差。

1 系统方案

本文移动目标运动速度测量的系统方案如图1所示,包括摄像机标定、特征点跟踪、轨迹聚类、速度计算等关键步骤。摄像机标定用于确定图像平面坐标到三维空间坐标的变换关系。本文中基于场面几何特征确定消失点(vanishing point),并根据消失点完成摄像机标定。特征点跟踪与轨迹聚类用于确定移动目标包含的特征点运动轨迹。在运动区域提取与特征点检测的基础上,利用基于光流的特征点跟踪算法获得每个特征点的运动轨迹,然后通过轨迹聚类确定特征点所属的移动目标,最后根据相关特征点的高度与运动距离,计算每个移动目标的运动速度。

图1 系统方案框图Fig.1 Block diagram of system scheme

2 摄像机标定与坐标变换

本文采用智能道路交通监视系统常用的基于消失点的摄像机标定方法。首先根据路面几何特征确定消失点,然后依次计算摄像机焦距、机场平面法向量和摄像机高度,完成摄像机标定。为此,定义如图2所示的三维空间坐标系o-xyz和图像坐标系oi-uv。三维空间坐标系o-xyz的原点o位于摄像机光心,z轴与摄像机光轴重合且与图像平面垂直,原点o到图像平面的距离为摄像机焦距f。图像坐标系oi-uv的原点oi位于图像的几何中心。

图2 空间坐标系与图像坐标系位置关系示意图Fig.2 Illustration of position relation between spatial coordinate system and image coordinate system

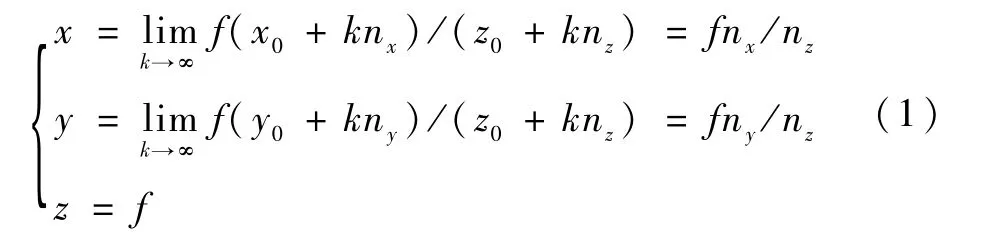

直线S的消失点定义为S上的无穷远点PS=(x∞,y∞,z∞)在图像平面的投影。假设直线S经过点(x0,y0,z0),方向向量为nS=(nx,ny,nz),则PS在图像平面的投影点(消失点)坐标为

若机场平面上两点之间的距离为d,且两点在图像中的投影分别为pa=(ua,va)、pb=(ub,vb),则有

根据上述分析,按如下步骤进行摄像机标定:

步骤1在2个正交方向分别选择一组路面标志线段,利用最小二乘法确定每组线段延长线在图像中的交点,得到消失点坐标。

步骤2利用式(2)~式(4)计算摄像机焦距f和机场平面法向量n。

步骤3在机场平面上选择距离已知的点对,利用式(6)计算摄像机高度h。

确定摄像机焦距f、机场平面法向量n和摄像机高度h后,若已知某点P在图像中的投影p=(u,v)和点P相对机场平面的高度hP,则可根据如下坐标变换关系确定该点的三维空间坐标:

由式(7)可知,低视角视频图像中,若摄像机高度h与点P高度hP相差不大,忽略hP会导致较大空间定位误差。

3 运动速度测量

3.1 特征点轨迹生成

为降低背景干扰,首先在视频图像中提取运动区域,确定移动目标在图像中的大致位置。采用ViBe算法[13]检测背景区域,通过背景减除及滤波、二值化、腐蚀、膨胀等后处理确定运动区域。上述方法能够有效抑制移动目标内部空洞,并较好地保留移动目标轮廓。

在运动区域内,基于FAST算法[14]检测图像特征点,并应用跟踪算法生成多组特征点轨迹。采用基于光流的特征点跟踪算法,根据当前帧的特征点位置和光流场确定下一帧的特征点位置。对于非整数坐标处的特征点,利用双线性插值确定亚像素光流[15]。为减少遮挡导致的跟踪误差,通过特征点跟随正、反向光流移动后的位置与初始位置的差异(双向误差)判断特征点是否被有效跟踪[16]。

3.2 聚类分析

li,j反映了特征点i、j平均每帧的运动差异。若li,j较小,特征点i、j属于同一移动目标的可能性较大;反之,i、j更有可能属于不同的移动目标。记ti与集合T中所有特征点轨迹的差异度为li=(li,1,li,2,…,li,M)。根据li可以确定ti相对T中所有 特 征 点 轨 迹 的 偏 好 向 量ri=(ri,1,ri,2,…,ri,M):若li,j小于给定阈值δc,则认为ti与tj属于同一移动目标,即ri,j=1;否则,ri,j=0。

按上述方法确定T中每个特征点轨迹的偏好向量,然后利用J-linkage算法[17]进行分层聚类。每个聚类c对应一个移动目标,且c中至少存在一条能够反映聚类特征的轨迹tc,使得c中特征点轨迹与tc的差异度均小于阈值δc。

3.3 速度计算

确定移动目标包含的特征点轨迹后,根据式(7)计算特征点轨迹的三维空间坐标,并以此为基础计算运动速度。

式中:Fr为视频帧率。可根据实际需要确定L取值,获得期望的速度更新频率。

基于低视角视频图像进行速度测量时,上述方法首先需要确定特征点高度。以移动目标与地面的接触点为参考点,根据不同特征点在三维空间运动距离相同这一前提条件,基于式(7)计算特征点高度。速度计算时,优先选择高度较低的特征点,并对多个特征点的速度取平均值。

4 仿真实验与分析

4.1 数据集

利用广州白云国际机场场面运行视频数据集,对本文提出的速度测量方法进行了验证。数据集共包含6段视频,由五号道滑行路口的摄像机cam2513和北外场的摄像机cam9915拍摄。各段视频的相关信息如表1所示。

表1 场面运行视频数据集Tab le 1 Dataset of surface operation videos

4.2 仿真结果分析

在三维空间中的2个正交方向分别选取5条平行直线段,用红、绿两色表示,如图3所示。根据式(2)、式(3)确定3个正交方向的消失点和摄像机焦距f,如表2所示。基于3条长度已知的路面分割线,根据式(6)确定摄像机高度h,如表2所示。图4以直观形式展示了2架摄像机的标定结果,其中红、绿、蓝色线段分别指向3个消失点,红、绿线段平行于机场平面,蓝色线段垂直于机场平面,黄色直线为地平线。

图3 用于摄像机标定的场面特征Fig.3 Surface features used for camera calibration

表2 摄像机标定结果Tab le 2 Cam era calibration resu lts

图4 摄像机标定结果图示Fig.4 Illustration of camera calibration results

本文方法的轨迹聚类结果如图5所示。图5(a)、(b)、(d)中只有一架航空器。图5(e)、(f)中包含多个移动目标,本文方法能够准确区分不同移动目标的特征点轨迹。图5(c)左上角3辆车包含在同一个运动区域内,其中最左侧车辆较小,未能检测到有效的特征点,另外2辆车的运动速度存在差异,聚类算法能够正确区分二者的特征点轨迹。图6进一步展示了用于速度测量的特征点轨迹在机场平面的投影,其中投影坐标系的横、纵坐标轴分别经过摄像机标定过程中确定的2个消失点。由于标定时选取的场面特征与滑行道平行,同时移动目标在运动过程中的侧向位移较小,图中轨迹投影均与横/纵坐标轴近似平行。

图5 特征点轨迹聚类Fig.5 Feature point trajectory clustering

针对各段视频的速度测量结果如图7所示,其中实线为本文方法的自动测量结果,虚线为手动标记移动目标接地点的位置变化得到的速度测量结果。图7(a)中,航空器距离摄像机较远,速度测量结果容易出现误差。图7(b)中,航空器距离较近,2种方法所得结果基本一致。图7(c)中,共有3辆车与1架航空器得到了有效的速度测量结果,其中车辆1和车辆3同时由静止开始运动,初始阶段二者速度相似,聚类算法未能区分二者的特征点轨迹,导致2种方法所得结果差别较大。图7(d)中,1架航空器与1辆车先后出现在视场范围内,其中航空器距离较远,从第200帧左右开始减速,直至离开视场范围;车辆与摄像机之间的距离较小,2种方法所得结果相似。图7(e)中,车辆1、车辆2先后进入视场,车速变化较小,2种方法所得结果较为接近。图7(f)中,先后出现2架航空器和1辆车,其中航空器2距离较远;第150帧左右,航空器2开始被航空器1遮挡,无法获得有效特征点轨迹,手动标记结果也存在一定误差。对于航空器1,初始阶段本文方法对特征点的位置估计偏高,导致速度测量结果偏大;随后,受阴影内特征点影响,速度测量结果偏小;在能够检测到移动目标接地点后,本文方法的速度测量结果开始接近手动计算结果。受阴影内特征点的影响,本文方法对车辆的速度测量结果偏小。

图6 机场平面轨迹投影Fig.6 Trajectory projection on airport surface

与基于目标边界框的速度测量方法进行对比。基于目标边界框的速度测量方法,首先利用YOLO算法[18]在运动区域中检测移动目标,确定移动目标边界框,然后基于ECO跟踪算法[19]确定后续帧的边界框位置。由于利用数据集中的单目视觉图像无法确定边界框中心点高度,选择理想高度为零的下边界中心点计算目标运动速度。图8对比了2种速度测量方法的误差。图中根据移动目标经过地面标记点的时间与标记点间距确定参考速度,将测得速度与参考速度之差视为测量误差。每个移动目标的速度测量误差均值与方差如表3所示。与基于特征点的方法相比,基于目标边界框进行速度测量时,边界框在相邻图像帧的大小和位置易出现突变,平均测量误差通常较大且测量稳定性较差。图8(a)、(d)中航空器和图8(f)中航空器2均距离摄像机较远,边界框的影响尤为显著,难以获得有效的速度测量结果。此外,边界框大小频繁变化也导致图8(c)中航空器与车辆1的速度测量误差出现较大幅度波动。

图7 移动目标速度测量结果Fig.7 Moving object speed measurement results

图8 速度测量误差对比Fig.8 Comparison of speed measurement errors

表3 移动目标速度测量误差均值与方差Tab le 3 M ean and variance of speed m easu rem en t errors for m oving objects

5 结 论

1)基于实际机场场面运行视频的仿真结果表明,当移动目标距离较近时,本文方法测速结果与手动标记测速结果基本一致,应用本文方法进行低视角速度测量是可行的。

2)与基于目标边界框的速度测量方式相比,本文基于特征点跟踪分析的方法在低视角速度测量的准确性与稳定性方面具有明显优势。

为使本文方法能够用于实际的机场场面视觉监视系统,仍需优化特征点跟踪分析的相关算法,减少特征点高度估计误差与阴影内特征点的影响,同时还需合理规划摄像机监视范围,并关联不同摄像机获取的信息。