基于超像素的联合能量主动轮廓CT图像分割方法

2020-01-17刘侠,甘权,刘晓,王波

刘 侠,甘 权,刘 晓,王 波

基于超像素的联合能量主动轮廓CT图像分割方法

刘 侠,甘 权,刘 晓,王 波*

哈尔滨理工大学自动化学院,黑龙江 哈尔滨 150080

为解决医学CT图像主动轮廓分割方法中对初始轮廓敏感的问题,提出一种基于超像素和卷积神经网络的人体器官CT图像联合能量函数主动轮廓分割方法。该方法首先基于超像素分割对CT图像进行超像素网格化,并通过卷积神经网络进行超像素分类确定边缘超像素;然后提取边缘超像素的种子点组成初始轮廓;最后在提取的初始轮廓基础上,通过求解本文提出的综合能量函数最小值实现人体器官分割。实验结果表明,本文方法与先进的U-Net方法相比平均Dice系数提高5%,为临床CT图像病变诊断提供理论基础和新的解决方案。

CT图像分割;超像素;卷积神经网络;主动轮廓模型

1 引 言

计算机断层扫描(Computed tomography,CT)图像拥有成像速度快、成像清晰等优点,CT图像是评估人体最重要的医学成像技术之一,已经成为日常检查的常用手段。人体CT扫描包含丰富的信息,如复杂的软组织、骨、血管和多个器官。对于计算机辅助诊断,在CT图像中分割感兴趣区域(region of interest,ROI)是十分重要的前提条件。因此,寻求一种可以取代人工分割的自动CT图像方法是当务之急。

在之前的研究中,研究学者已经提出了阈值分割、基于区域方法、轮廓和形状分割等方法来进行器官分割。阈值分割是以像素点灰度为分割依据的经典方法,Moltz[1]将阈值方法与形态学处理相结合,对肝脏肿瘤进行了确切的分割,该方法不需要考虑空间特征,涉及计算少,但是对噪声敏感。Chang[2]提出三维区域生长方法完成了肾脏、脾脏和其他三个器官的分割,该方法取决于种子点的选择,研究人员需要手动选择种子点来提高分割质量。Klaus[3]提出了一种自适应区域增长方法,当目标不均匀时会造成分割不足。Masahiro[4]将主动轮廓分割应用于四种器官分割。主动轮廓分割通常需要研究人员仔细选择标记为目标和背景[5]的种子点,且分割结果依赖于种子点的选择。后续研究人员将模糊理论融入主动轮廓模型中并提出基于模糊能量的主动轮廓模型[6-8],此模型对噪声和初始轮廓不敏感,可以实现快速收敛,但不能正确分割灰度不均匀图像,CT图像就属于灰度不均匀图像。

近年来机器学习已广泛应用于医学图像的分割领域[9-11],最近,深度学习已经显示出自动分类算法准确度高、适应性强的优势。卷积神经网络(convolutional neural network,CNN)是深度人工神经网络的有效分支。同时,某些特定的深度学习框架可用于分割[12-15]。Yu[16]使用基于CNN的方法实现了膀胱分割,Ronneberger[17]设计了U-Net来细分生物医学图像。基于全卷积神经网络(fully convolutional networks,FCN)的语义分割中,Milletari[18]提出V-Net用于3D体积医学图像分割的完全卷积神经网络,该网络在分割精度方面有所提高但收敛速度慢,十分耗时。

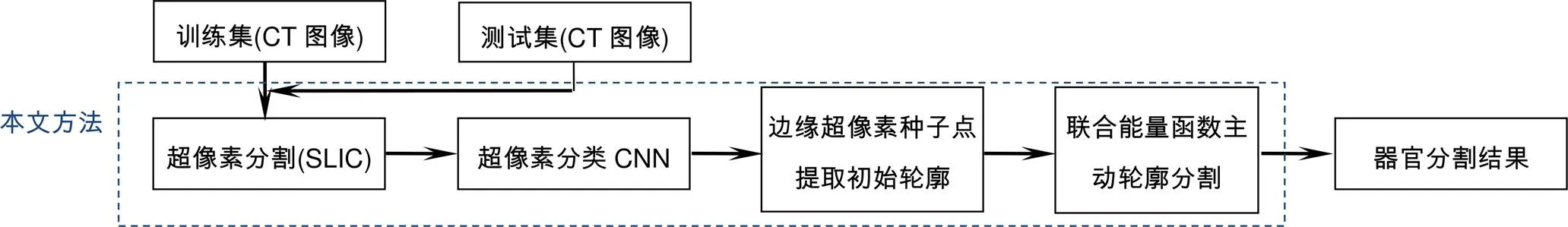

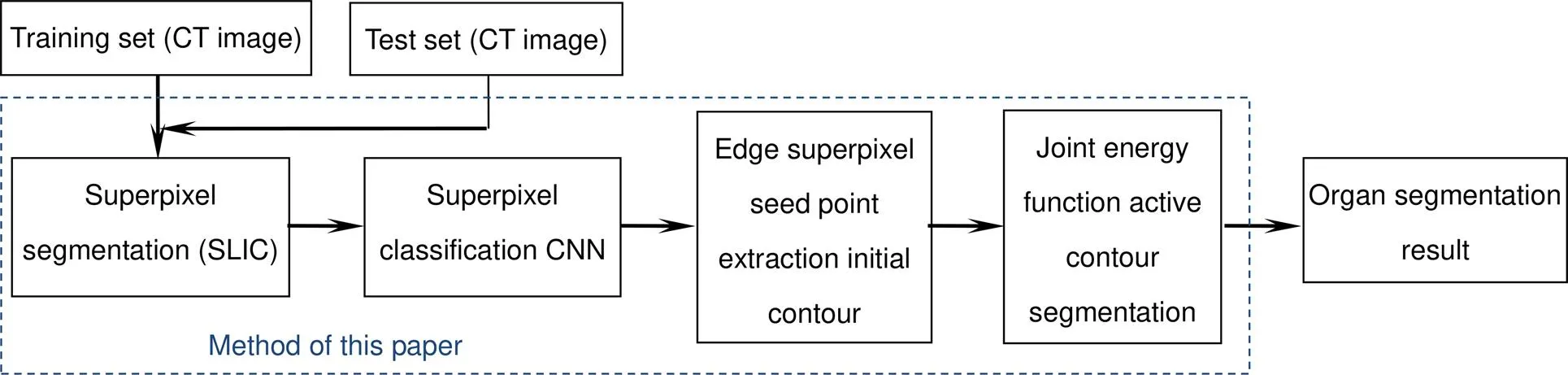

综上,本文提出一种全自动的人体器官CT图像分割方法,该方法最初基于超像素分割对CT图像进行超像素网格化,并通过卷积神经网络对产生的超像素进行分类确定边缘超像素;然后提取边缘超像素的种子点组成初始轮廓;最后在提取的初始轮廓基础上,通过求解本文提出的综合能量函数最小值实现CT图像中器官的分割。

2 本文方法

本文提出的人体器官CT图像分割方法流程如图1所示。该方法对CT图像超像素网格进行边缘超像素分类并提取种子点初始轮廓。之后,在提取的初始轮廓上迭代求解本文改进的综合能量函数最小值,实现CT图像中人体器官分割。

2.1 超像素分割

算法1 SLIC超像素分割

Step1:初始化

2) 初始化每个种子点邻域内的像素点类标签()=-1,()=¥。

Step2:重复

图1 本文方法示意图

Step3:更新

计算新的种子点;

计算残差;

直到£阈值。

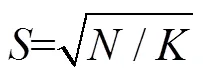

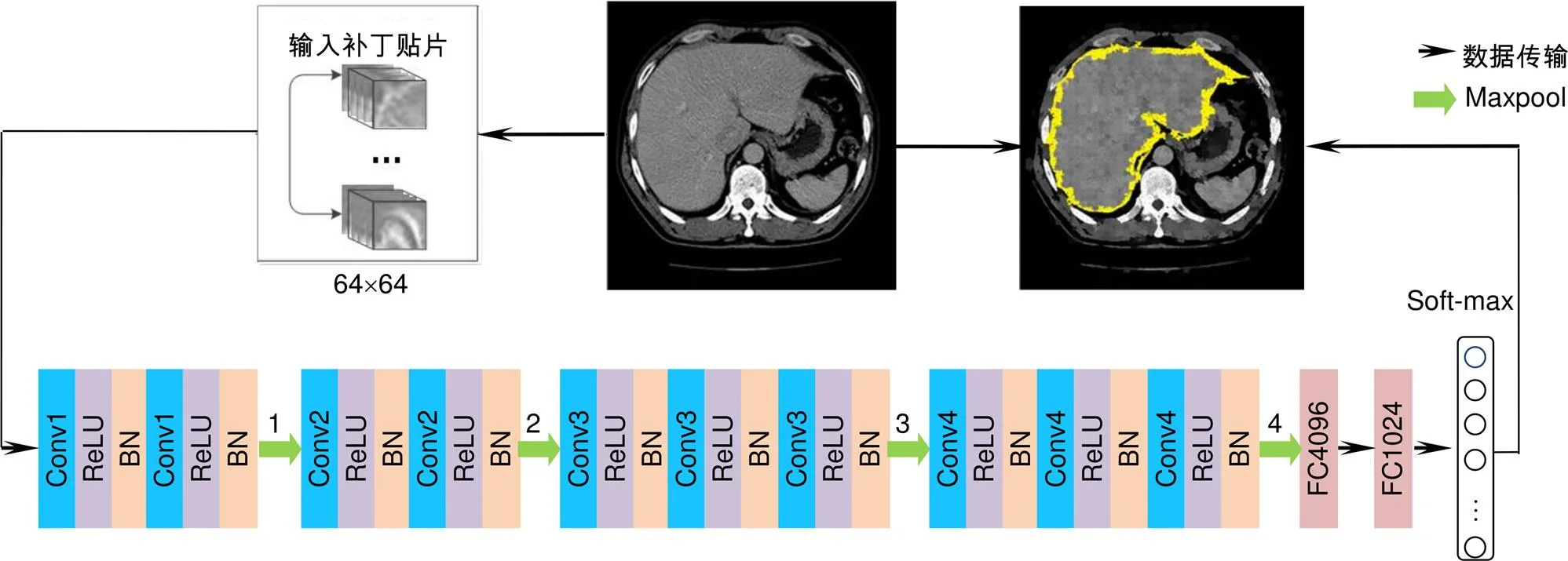

其中:是用于衡量该测量中灰度信息和空间信息的比例的平衡参数,取=10。最后,根据计算的距离为每个簇分配一个单独的标签。

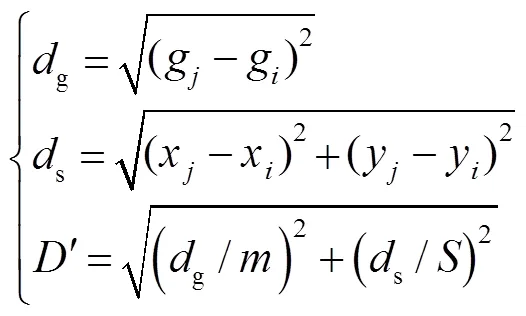

如图2所示,图2(a)、2(b)分别为=500与=2000时,不同参数对肝脏CT图像的网格化分割结果,图2(a)中的超像素网格较大,不能很好地表示器官边缘,图2(b)中的超像素网格较小,可以较为细致的表示器官边缘。

2.2 超像素分类CNN

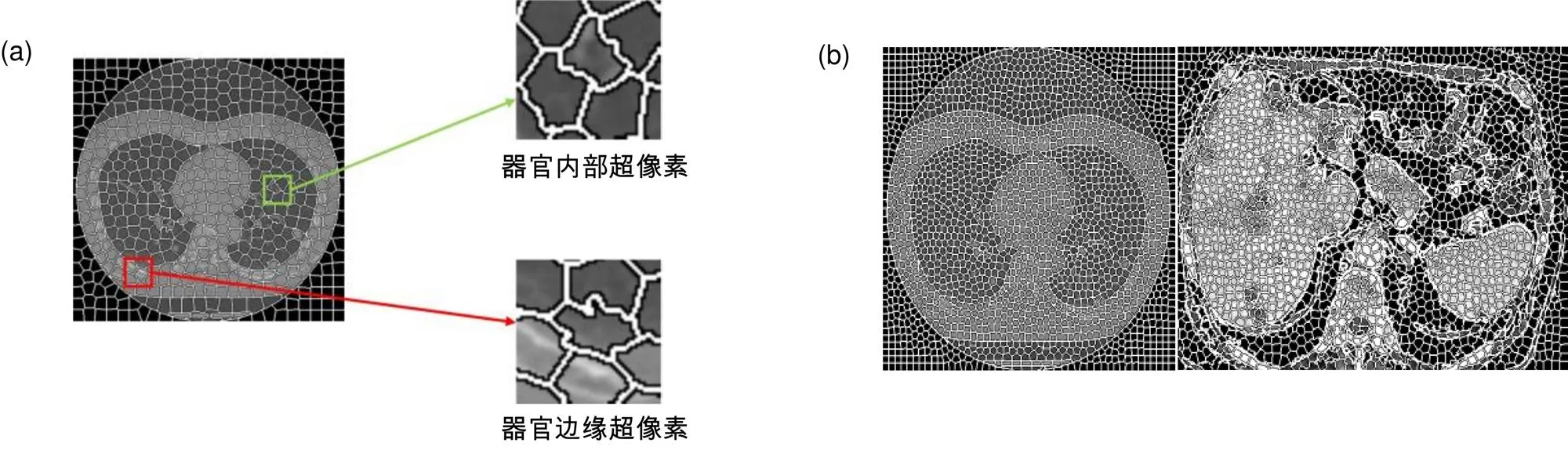

图像处理中正确分类一直是研究的热点问题,学者们先后提出过多种的分类方法,如Aadboost、随机森林、支持向量机(SVM)、CNN。其中CNN是近年发展起来,并引起广泛重视的一种高效识别方法,对于图像处理有出色表现。特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。本文提出的超像素分类CNN将超像素分为两大类:器官边缘超像素和非器官区边缘超像素(如图2(a)所示),分别标记为1和0。超像素分类CNN如图3所示,在卷积层后增加batch normalization(BN)层加快收敛速度。

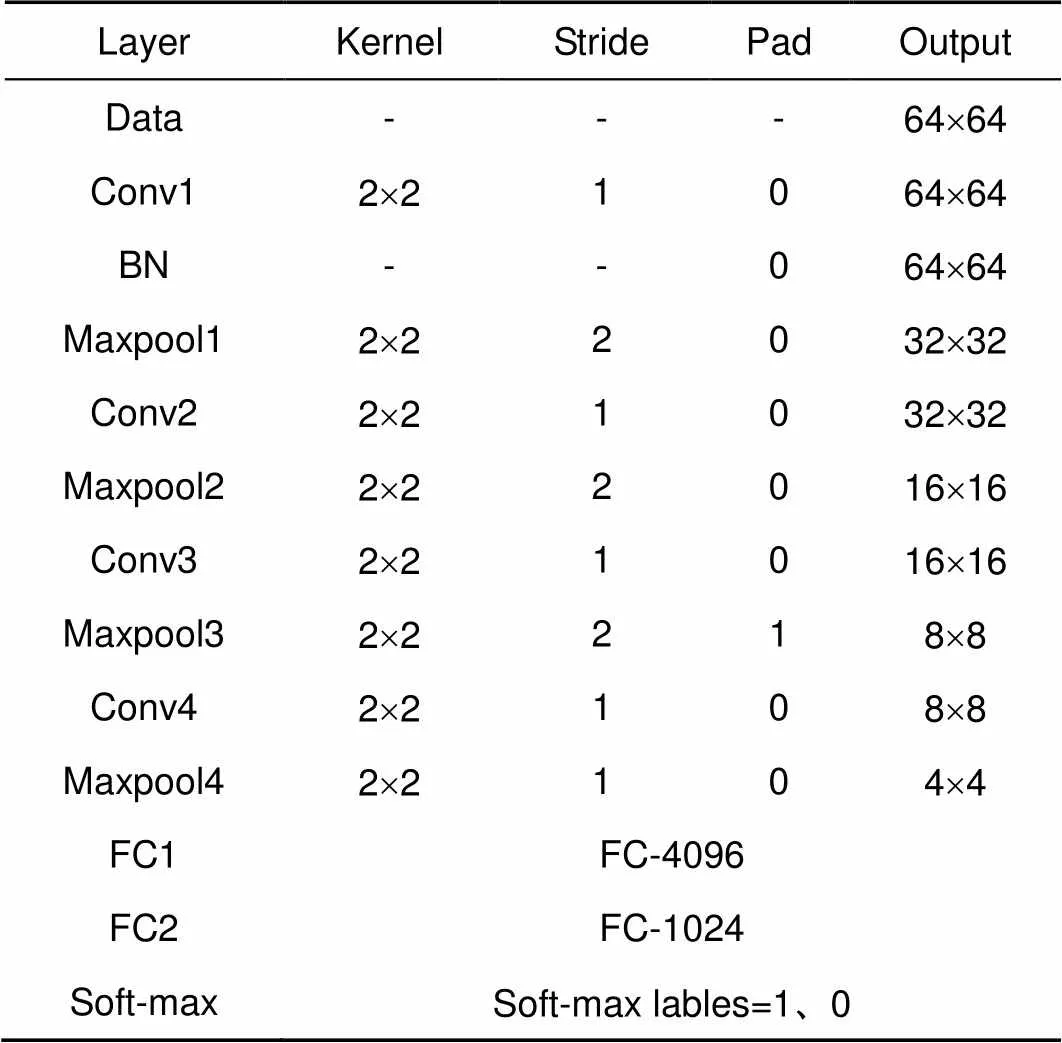

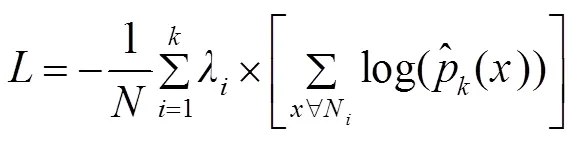

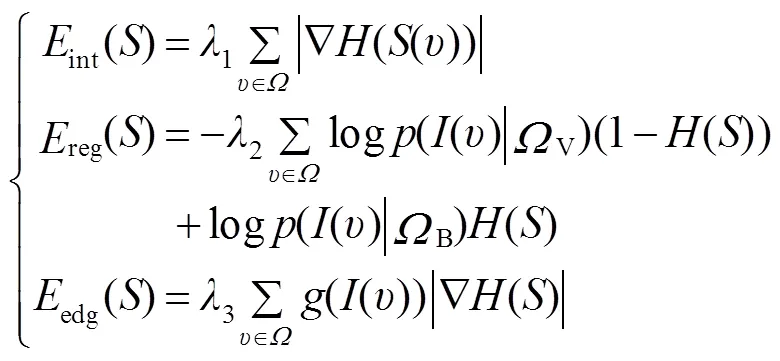

超像素分类CNN各层参数如表1所示。其中,soft-max层为二分类层,用于标记边缘超像素(标记为1)和非边缘超像素(标记为0)。本文数据集的分辨率为512´512,超像素网格化后超像素大小为128´128。CNN输入采用窗口滑动输入,滑动窗口为64´64,通过多次滑动直至数据集全部输入网络。

图2 不同参数K 的超像素网格化结果。(a) K=500 网格化结果;(b) K=2000 网格化结果

图3 超像素分类CNN网络

表1 超像素分类CNN网络结构参数

置为0.0005,动量设置为0.9,平衡权重1,2分别为0.5和0.5,训练次数设置为1000次。最终,通过超像素分类CNN得到边缘超像素。

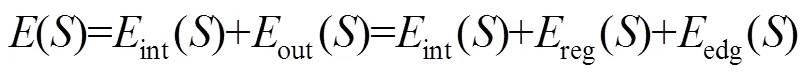

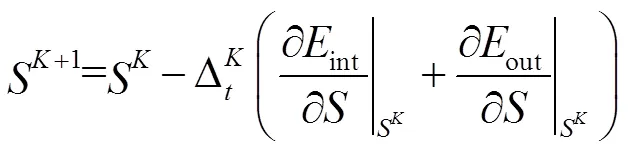

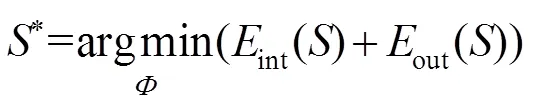

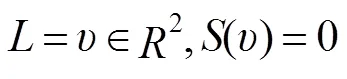

2.3 联合能量主动轮廓分割

图像分割即求取目标区域边界轮廓*,并将其转化为求最小化的问题。选择边缘超像素的种子点构造初始轮廓,计算其相应的符号距离函数0。从初始化0开始,对于Î进行遍历,通过式(5)更新,并使用梯度下降法通过式(6)求解的最小值S:

使用梯度下降法迭代更新每个像素的符号距离函数,与边界具有一对一的映射关系,最终的*产生最终轮廓*。一旦已知*,通过映射关系就可以得到L。该映射如下:

经过上述计算得到目标区域的分割轮廓,但是在轮廓演化的过程中可能使分割轮廓粗糙。本文最后使用形态学开操作、闭操作来平滑分割轮廓曲线。

综上所述,本文提出的基于超像素的联合能量主动轮廓CT图像分割方法,具体实现步骤如下:

Step1:导入训练集后,对图像进行超像素网格化;

Step2:构建超像素分类CNN,将Step1中产生的超像素分类为器官边缘超像素和非器官边缘超像素并标记;

Step3:提取被标记为器官边缘区域超像素的种子点并将种子点组成一个闭合轮廓,作为分割初始轮廓;

Step4:根据式(3)、式(4)定义联合边缘能量的主动

轮廓分割能量函数,并初始化参数;

Step5:以Step3得到的闭合轮廓构造初始轮廓计算0;

Step6:使用梯度下降法根据式(6)更新距离符号函数;

Step7:重复Step6,直至遍历全部像素,计算最小*;

Step8:将Step7计算的最小*按式(8)的一一对应关系映射分割边界*;

Step9:将Step8获得的分割边界曲线*进行形态学开操作、形态学闭操作来平滑分割轮廓曲线,得到最后的分割结果。

3 实验结果与分析

3.1 实验数据及评价指标

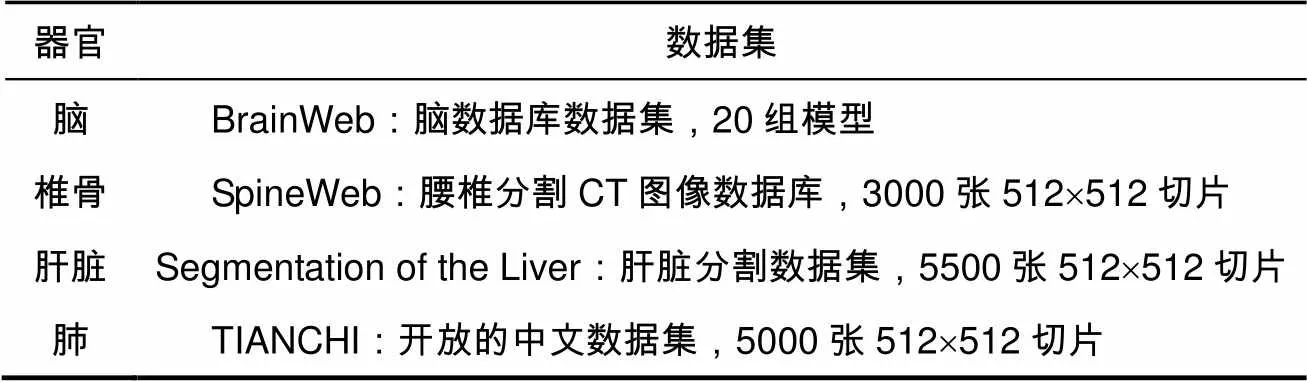

为全面评估本文方法对医学CT图像的分割效果,本文主要对四类器官CT图像进行分割实验,包括:脑部CT图像、肝脏CT图像、肺部CT图像、椎骨CT图像。本文实验所用数据如表2所示。

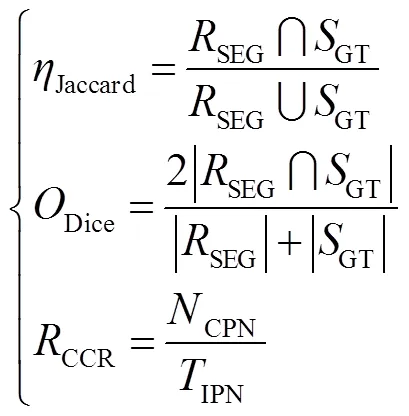

本文分割算法实验环境为Intel(R) Core(TM) 3.4 GHz CPU、32 GB RAM、16 GHz GPU、opencv32,caffe、Python3.5。分割结果评价指标分别为相关系数(Jaccard),重叠系数(Dice)和正确的分类系数(correct classification ration,CCR)(CCR)对本文提出的方法进行科学的评价。评价指标计算公式如下:

其中:SEG表示算法的分割结果,GT表示手动分割结果,即标准的参考结果,CPN表示正确分割的超像素个数,INP表示图像像素总个数。三种指标系数的取值范围均为0到1,越接近1表示分割效果越好。

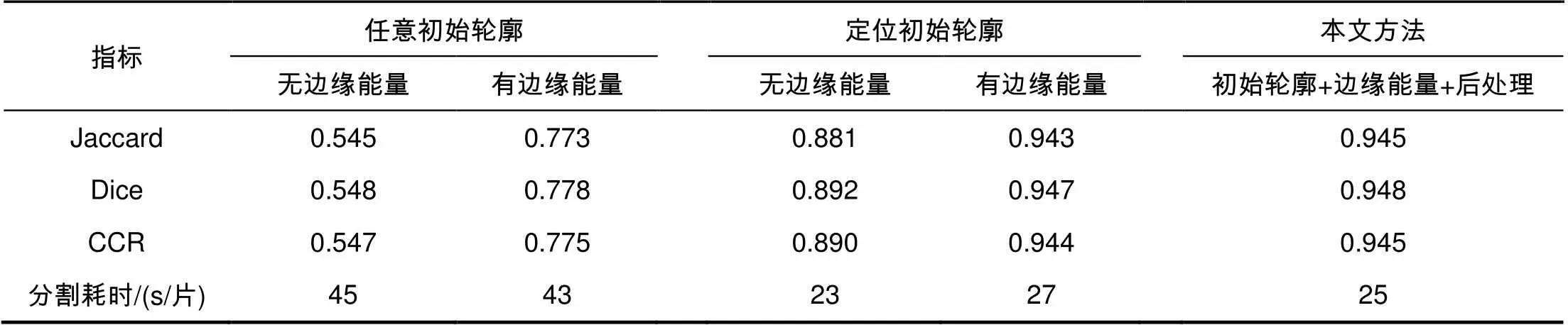

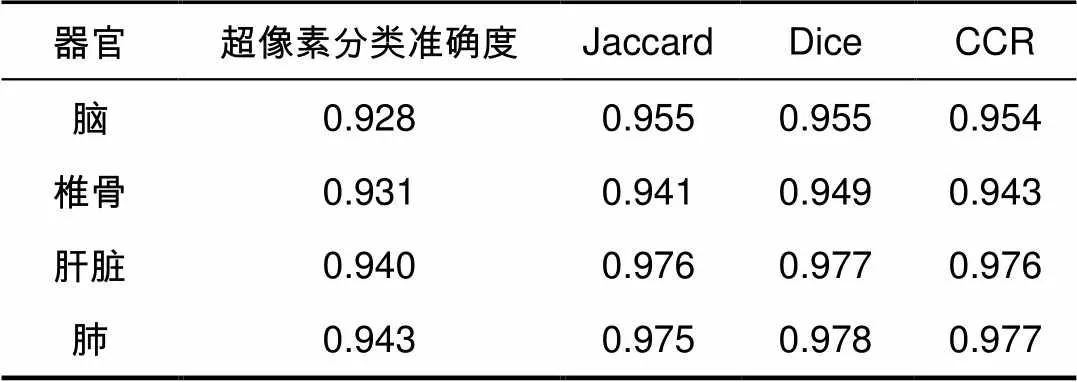

表3 定量实验分割结果

表2 数据表

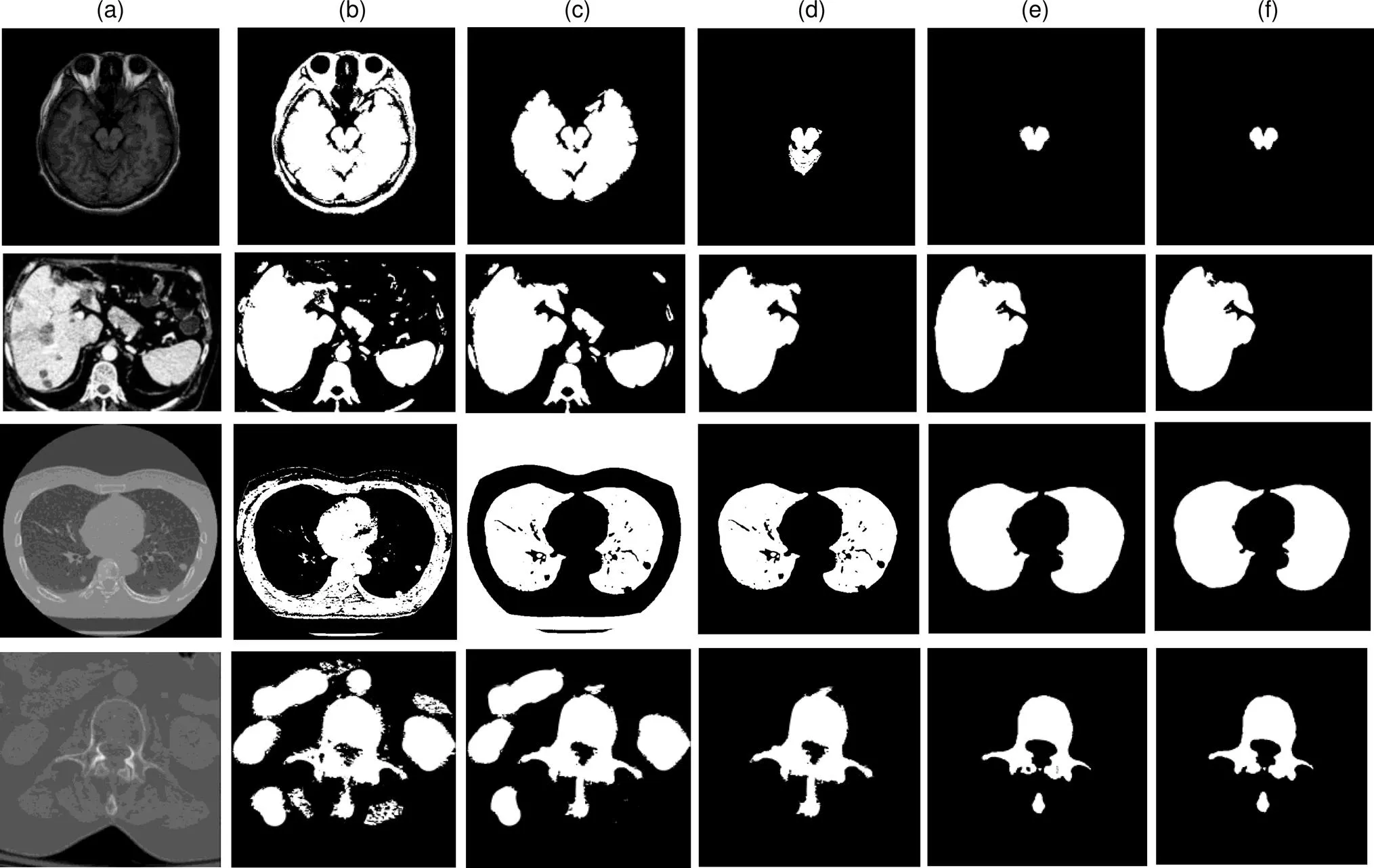

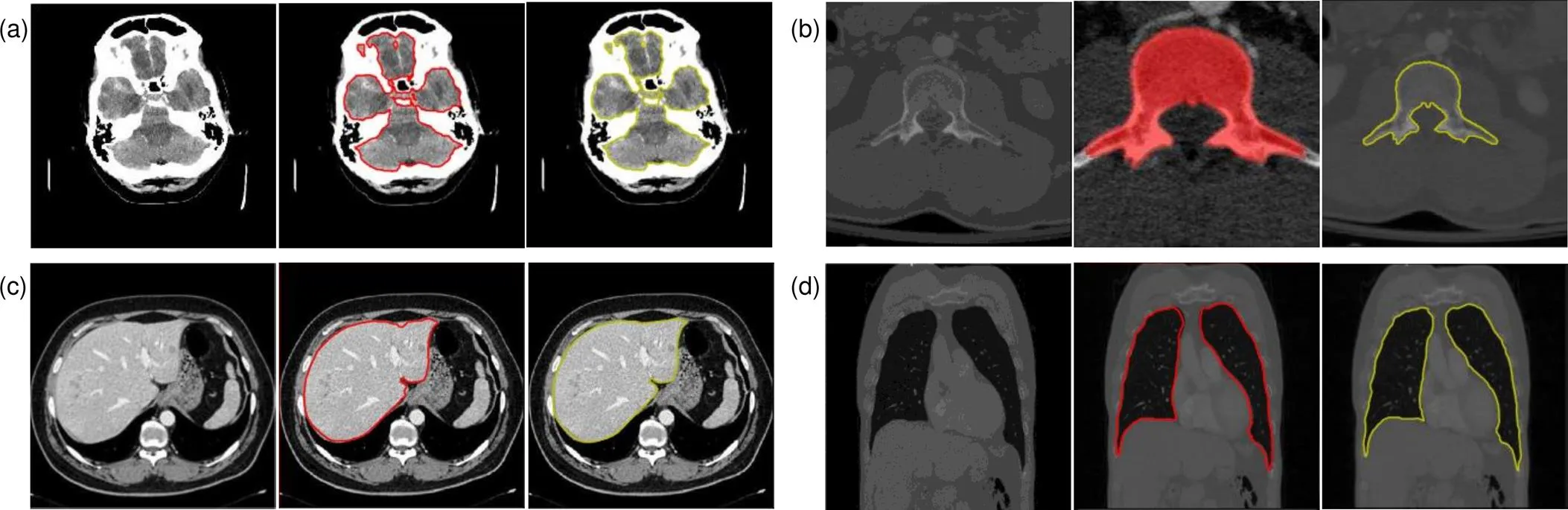

图4 定量实验分割结果图(从上到下分别为脑部、肝脏、肺部及椎骨的分割结果)

3.2 定量实验分析

3.2.1联合能量主动轮廓分割对实验结果的影响

将CNN得到的边缘超像素进行种子点提取,组成初始轮廓,并通过求解联合能量函数最小值寻找分割边界,最后用开操作和闭操作进行边界平滑。本文算法与任意初始轮廓联合能量主动轮廓算法和无能量边缘函数的分割算法进行对比,对比结果如表3和图4所示。

图4给出了多个器官的分割结果,图4(a)为原始CT图像,图4(b)为任意初始轮廓无边缘能量项方法分割结果,该方法效果较差,基本不能完成CT图像的器官分割。图4(c)为具有边缘能量项的任意初始轮廓的方法分割结果,该方法能够很好的约束轮廓,迭代找到完整准确地器官轮廓完成分割,不足的是有些非器官部位也被分割。图4(d)为具有超像素边缘初始轮廓无边缘能量项方法分割结果,该方法能准确找到器官位置,但器官周围小部分相似组织被作为器官区域一起分割。图4(e)为具有超像素边缘初始轮廓且有边缘能量项方法分割结果,该方法能够准确分割完成目标区域的提取,但分割边界不够平滑。图4(f)为本文方法分割结果,本文方法能够正确分割目标区域,通过后操作平滑边界,分割结果最好。

3.2.2边缘超像素分类CNN对分割结果的影响

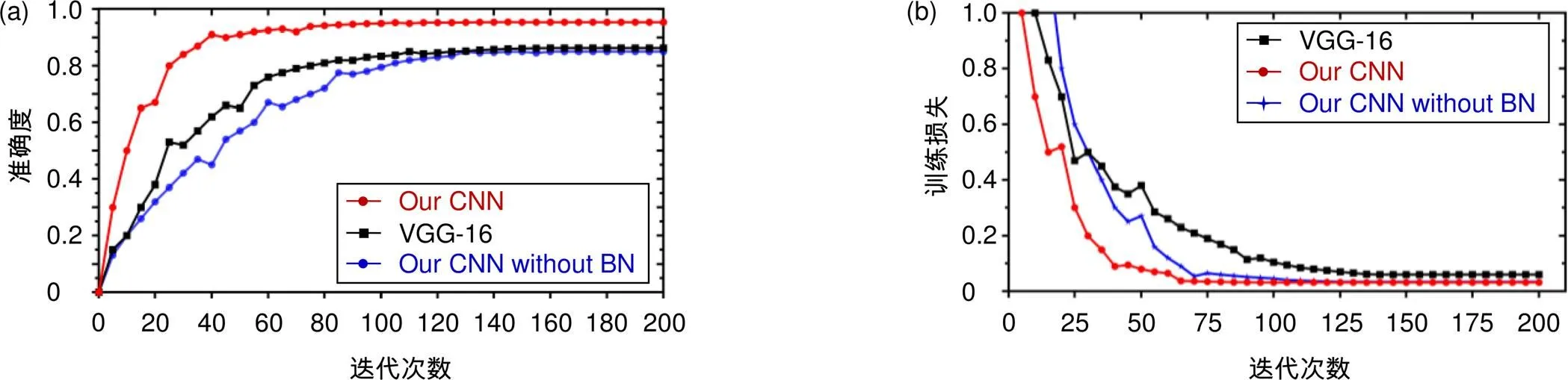

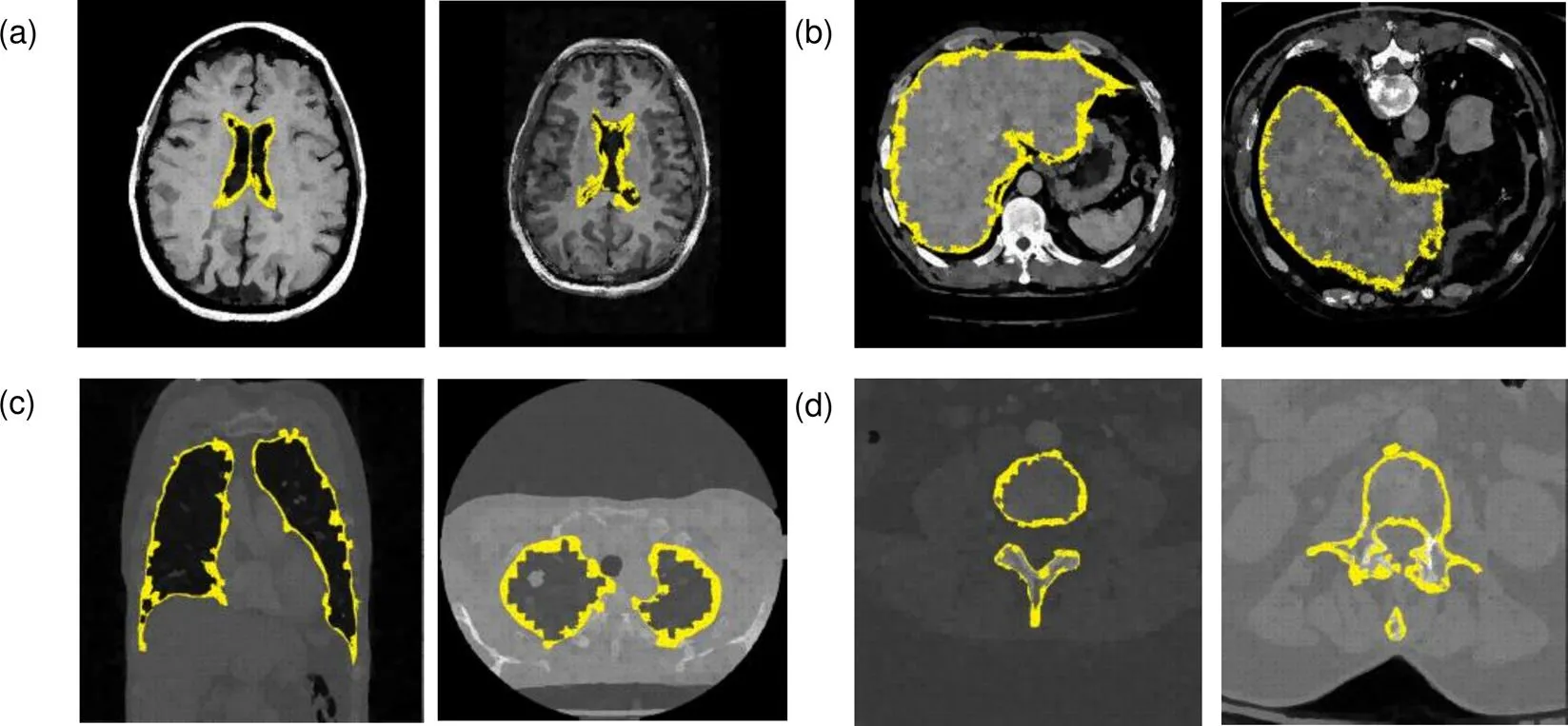

本文提出的超像素分类CNN,与先进的VGG-16[19]网络进行比较(本文将VGG-16最终的soft-max层改变二分类层,以适应本文的二分类任务),对肺部CT图像超像素的分类结果如图5所示。

本文超像素分类CNN对其他器官的边缘超像素分类结果如图6所示。本文在针对脑部CT断层图像边缘超像素分类时,首先进行MRI与CT的图像互相关归一化配准预处理,将待分割脑部CT图像与参考MRI图像进行图像配准。本文提出的改进的具有BN层的CNN在VGG-16的基础上减少网络层数,加入批量归一化的BN层,在80次迭代时,准确率和训练损失都趋于平稳达到收敛状态,而不具有BN层的CNN网络,在110次迭代时其准确率和训练损失逐渐达到平稳收敛状态。而对于VGG-16网络在接近120次迭代时才趋于平稳。达到收敛后,本文提出的超像素分类CNN在分类准确性方面略高于VGG-16,边缘超像素识别率达到95%左右。由此可知,在BN层的帮助下能够实现卷积神经网络的快速收敛。

与VGG-16结果相比,本文提出的超像素分类CNN能够对脑、肝脏、肺部和椎骨等器官边缘进行准确有效的分类,准确率提高8%,确定器官边缘大致位置,为下一步进行轮廓分割,提供先验知识信息。与VGG-16相比,本文提出的超像素分类CNN网络层数较少,更方便搭建、训练和测试,具有更大优势。

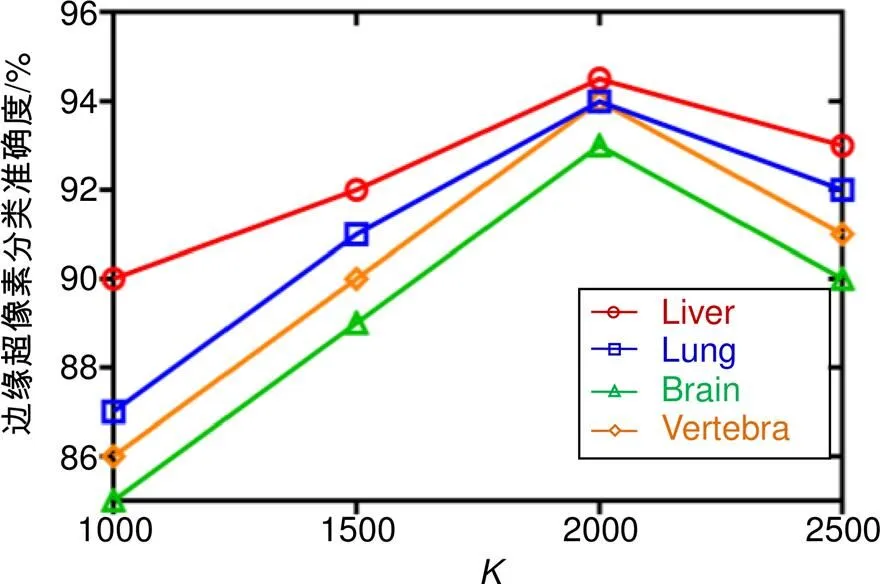

3.2.3值对实验结果的影响

为超像素的个数参数,的大小决定着超像素网格的数量和大小,越大则超像素尺寸越小,无法表现出足够的信息特征,越小则超像素尺寸越大,增加图像信息的复杂性,产生过度贴合现象。如图7所示,本文对不同值进行实验值范围在0~2500之间每隔500取一次,边缘超像素CNN分类准确度在=1000后明显上升直到=2000后又下降。显然,当的值为2000时,CNN对边缘超像素分类准确性最高,因此本文选择选择的值为2000。

3.3 实验结果及对比

3.3.1本文实验结果

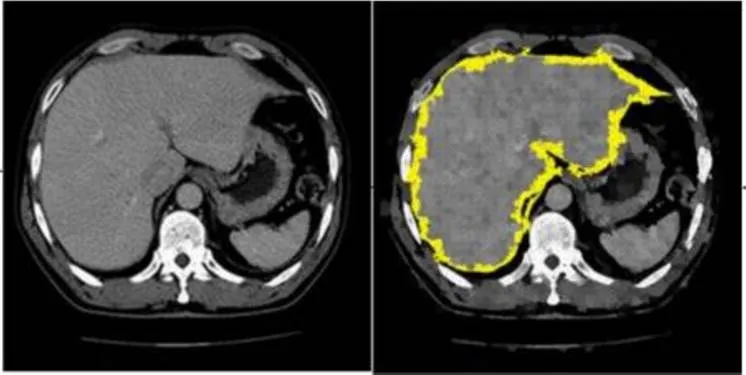

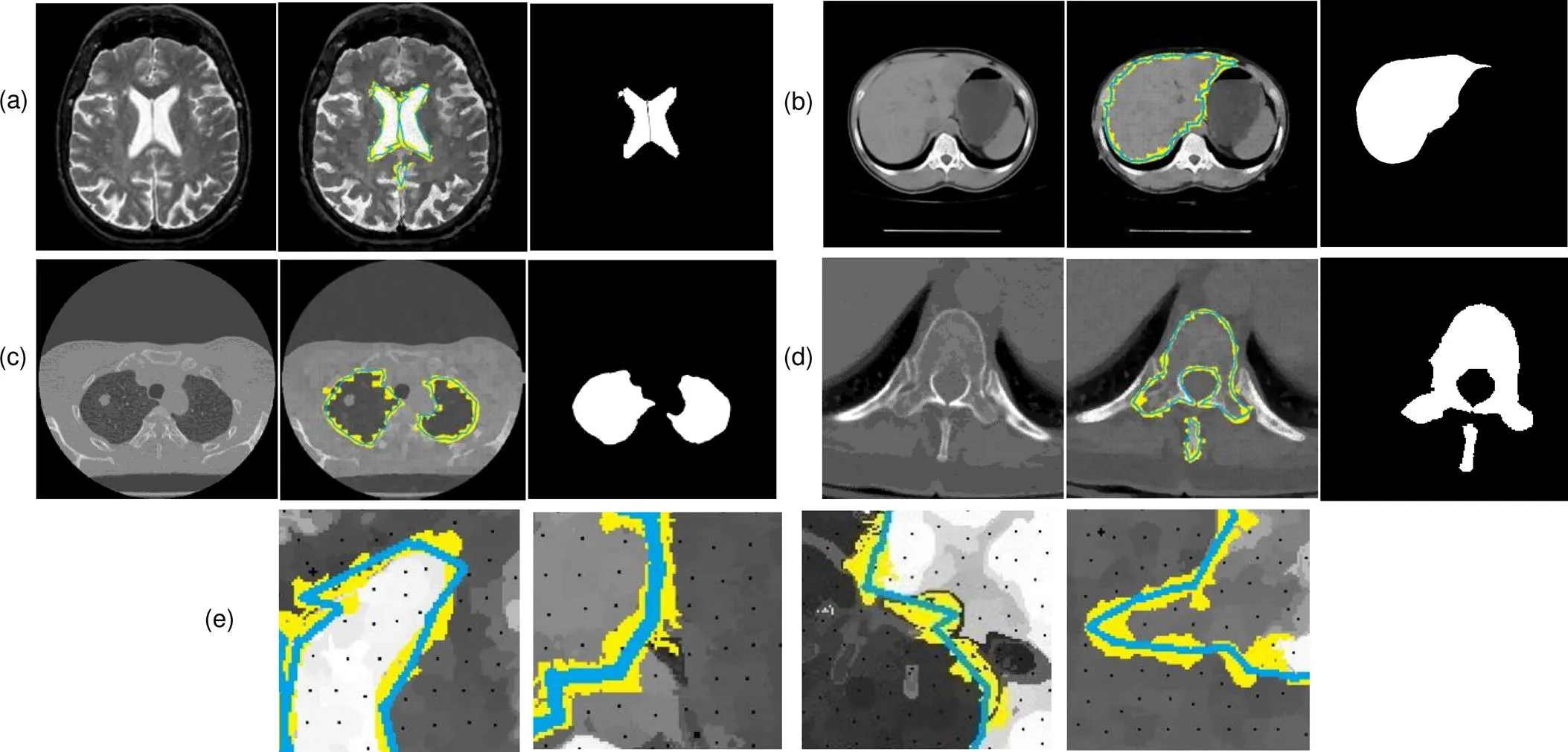

本文方法得到的各器官CT图像分割结果如图8所示,图8(a)~8(d)分别为脑部、肝脏、肺部和椎骨CT图像分割结果,自左到右分别为原始CT图、SLIC-CNN分类后的边缘超像素和初始轮廓、最终分割结果;图8(e)为局部放大图像。其中黄色为超像素分类CNN得到的边缘超像素,蓝色为边缘超像素种子点提取的分割初始轮廓,白色为本文方法得到的最终分割结果。本文方法得到各类器官CT图像分割评价指标计算结果如表4所示。

超像素分类CNN对于CT图像超像素的分类取得了较理想的结果,分类准确度可达92%,本文提取的超像素种子点组成的初始轮廓接近于器官边缘,在接下来的基于综合能量函数的求解过程中节省了大量的时间。对于脑、肝脏、肺部和椎骨的目标图像分割,本文方法能够准确地定位边缘超像素并完整提取边缘超像素种子点构造初始轮廓,通过最小化改进的综合能量函数求取分割轮廓,完成分割。本文方法对四类器官分割结果Dice系数在94%左右,分割一张512´512大小的CT切片图像仅需要25 s,在保证分割准确度的基础上,分割速度较快。

3.3.2 不同方法对比实验分析

本文方法使用与各文献中相同的CT图像进行分割,其结果对比分析如表5。

在脑CT图像分割中,本文和文献[21]均使用轮廓分割方法,文献[21]需人机交互操作而本文方法在保证分割准确度的同时完成自动分割,由于边缘超像素种子点初始轮廓接近最终分割结果,减少了迭代计算时间。在椎骨CT图像分割中,文献[22]提出基于Canny边缘+随机森林强度回归方法,边缘检测和随机森林回归消耗了大量时间,与之相比,本文方法分割速度提高2.5倍,在分割准确度上略小于该方法,但也在可以接受范围内。在肝脏和肺部CT图像中,文献[23]首先超像素网格化,接着SVM进行超像素分类,最终用CNN完成分类分割。而本文使用超像素和CNN直接进行超像素分类提取初始轮廓结合改进的联合能量函数主动轮廓分割提高了分割准确度,同时比文献[23]方法耗时缩短10 s。与U-Net方法相比,本文方法在肝脏分割结果上准确率提高5%以上。在同一数据集上,各文献结果与本文方法分割结果如图9所示,可以发现与不同研究者的分割结果相比,本文的结果基本令人满意。

图5 CNN分类准确度和训练损失

图6 超像素分类CNN边缘超像素分类结果

图7 K不同取值对CNN分类准确度影响

图8 本文方法分割结果。

表4 分割结果各评价指标

表5 不同方法对比实验结果

图9 不同方法对比实验结果

4 结 论

本文提出了基于超像素的联合能量主动轮廓CT图像分割方法,用于多种CT扫描图像的分割。通过超像素网格化和分类CNN得到边缘超像素,选择超像素种子点组成联合能量主动轮廓分割的初始轮廓,降低初始轮廓敏感性,使主动轮廓分割得到改善,减少分割耗时。用本文方法对包括脑、肝脏、肺部和椎骨的数据集进行分割。总体来说,本文方法在保证分割精度的同时减少了分割耗时,提高了效率。在后续研究中,将致力于在其他类型医学图像上测试这个框架,如MRI图像和超声图像。同时我们也期待提高准确性和效率,将框架纳入可以使患者受益的临床诊断中。

[1] Moltz J H, Bornemann L, Dicken V,. Segmentation of liver metastases in CT scans by adaptive thresholding and morphological processing[C]//(), 2008, 472: 195–222.

[2] Chang Y L, Li X B. Adaptive image region-growing[J]., 1994, 3(6): 868–872.

[3] Pohle R, Toennies K D. Segmentation of medical images using adaptive region growing[J]., 2001, 4322: 1337–1346.

[4] Oda M, Nakaoka T, Kitasaka T,. Organ segmentation from 3D abdominal CT images based on atlas selection and graph cut[C]//:, 2012, 7029: 181–188.

[5] Criminisi A, Shotton J, Robertson D,. Regression forests for efficient anatomy detection and localization in CT studies[C]//, 2011: 106–117.

[6] Tang L M, Tian X Q, Huang D R,. Image segmentation model combined with FCMS and variational level set[J]., 2014, 40(6): 1233–1248.

唐利明, 田学全, 黄大荣, 等. 结合FCMS与变分水平集的图像分割模型[J]. 自动化学报, 2014, 40(6): 1233–1248.

[7] Chen K, Li B, Tian L F. A segmentation algorithm of pulmonary nodules using active contour model based on fuzzy speed function[J]., 2013, 39(8): 1257–1264.

陈侃, 李彬, 田联房. 基于模糊速度函数的活动轮廓模型的肺结节分割[J]. 自动化学报, 2013, 39(8): 1257–1264.

[8] Sun W Y, Dong E Q, Cao Z L,. A robust local segmentation method based on fuzzy-energy based active contour[J]., 2017, 43(4): 611–621.

孙文燕, 董恩清, 曹祝楼, 等. 一种基于模糊主动轮廓的鲁棒局部分割方法[J]. 自动化学报, 2017, 43(4): 611–621.

[9] Jones J L, Xie X H, Essa E. Combining region-based and imprecise boundary-based cues for interactive medical image segmentation[J]., 2014, 30(12): 1649–1666.

[10] Tah A A, Hanbury A. Metrics for evaluating 3D medical image segmentation: analysis, selection, and tool[J]., 2015, 15(1): 29.

[11] Criminisi A, Robertson D, Konukoglu E,. Regression forests for efficient anatomy detection and localization in computed tomography scans[J]., 2013, 17(8): 1293–1303.

[12] Shin H C, Orton M R, Collins D J,. Stacked autoencoders for unsupervised feature learning and multiple organ detection in a pilot study using 4D patient data[J]., 2013, 35(8): 1930–1943.

[13] Wang Z, Yang J. Automated detection of diabetic retinopathy using deep convolutional neural networks[J]., 2016, 43(6): 3406.

[14] Kooi T, Litjens G, Van Ginneken B,. Large scale deep learning for computer aided detection of mammographic lesions[J]., 2017, 35: 303–312.

[15] Tao Y P, Jing Y, Xu C. CT image segmentation method combining superpixel and CNN[J]., 2019: 1–8.

陶永鹏, 景雨, 顼聪. 融合超像素和CNN的CT图像分割方法[J]. 计算机工程与应用, 2019: 1–8.

[16] Yu L Q, Yang X, Hao C,. Volumetric ConvNets with mixed residual connections for automated prostate segmentation from 3D MR images[C]//(), 2017: 66–72.

[17] Sevastopolsky A. Optic disc and cup segmentation methods for glaucoma detection with modification of U-Net convolutional neural network[J]., 2017, 27(3): 618–624.

[18] Milletari F, Navab N, Ahmadi S A. V-Net: fully convolutional neural networks for volumetric medical image segmentation[C]//(), 2016: 565–571.

[19] Ren M. Learning a classification model for segmentation[C]//, 2003: 10–17.

[20] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[Z]. arXiv:1409.1556, 2015.

[21] Aghaei F, Ross S R, Wang Y Z,. Implementation of a computer-aided detection tool for quantification of intracranial radiologic markers on brain CT images[C]//, 2017: 10138.

[22] Korez R, Ibragimov B, Likar B,. Interpolation-based shape-constrained deformable model approach for segmentation of vertebrae from CT spine images[C]//, 2015: 235–240.

[23] Liu X M, Guo S X, Yang B T,. Automatic organ segmentation for CT scans based on super-pixel and convolutional neural networks[J]., 2018, 31(5): 748–760.

Joint energy active contour CT image segmentation method based on super-pixel

Liu Xia, Gan Quan, Liu Xiao, Wang Bo*

School of Automation, Harbin University of Science and Technology, Harbin, Heilongjiang 150080, China

Schematic of the method in this paper

Overview:Computed tomography images have the advantage of fast imaging speed and sharp imaging. CT images are one of the most important medical imaging techniques for human evaluation and it has become a conventional means of daily inspection. For computer-aided diagnosis, interest towards segmentation of regions in CT images is an essential prerequisite. Therefore, it is imperative to seek an automatic CT image method that can replace manual segmentation. This paper presents a fully automated CT image segmentation method for human organs. Firstly, super-pixel meshing is performed on CT images based on the super-pixel segmentation, and super-pixel classification is performed by a convolutional neural network to determine edge super-pixels. Then, seed points of edge super-pixels are extracted to form initial contours. Finally, the initial contour is obtained based on the extraction by solving the minimum of the integrated energy function proposed herein. In order to comprehensively evaluate the segmentation effect of this method on medical CT images, this paper mainly divides CT image experiments into four organs, including the brain, liver, lungs, and vertebral body. The experimental results show that the super-pixel classification CNN has achieved excellent results in the super-pixel classification of CT images. The classification accuracy reaches 92%. The initial contour of the super-pixel seed points extracted in this paper is close to the organ edge, and the next contour based on a significant amount of time is stored in the solution of the integrated energy function. For the target image segmentation of brain, liver, lung, and vertebrae, the proposed method can accurately locate the edge super-pixels that completely extract the initial contour of the edge super-pixel seed point structure, and complete the segmentation contour subdivision by minimizing the improved integrated energy function. Compared with the advanced U-net method, the average Dice coefficient of the proposed method increase by 5%. It may provide a theoretical basis and a new solution for the diagnosis of clinical CT image lesions. In general, this approach can reduce time and improve efficiency while ensuring segmentation accuracy. In the future study, efforts would be made to test the framework on other types of medical images, such as MRI images and ultrasound images. At the same time, we also look forward to improving accuracy and efficiency and incorporating this framework into clinical diagnostics that benefit patients.

Citation: Liu X, Gan Q, Liu X,Joint energy active contour CT image segmentation method based on super-pixel[J]., 2020, 47(1): 190104

Supported by National Natural Science Foundation of China (61172167) and Heilongjiang Natural Science Foundation (QC2017076)

* E-mail: hust_wb@126.com

Joint energy active contour CT image segmentation method based on super-pixel

Liu Xia, Gan Quan, Liu Xiao, Wang Bo*

School of Automation, Harbin University of Science and Technology, Harbin, Heilongjiang 150080, China

In this paper, an active contour segmentation method for organs CT images based on super-pixel and convolutional neural network is proposed to solve the sensitive problem of the initial contour of the segmentation method of the CT image. The method firstly super-pixels the CT image based on super-pixel segmentation and determines the edge super-pixels by the super-pixel classification through a convolutional neural network. Afterwards, the seed points of the edge super-pixels are extracted to form the initial contour. Finally, based on the extracted initial contour, the human organ segmentation is realized by solving the minimum value of the integrated energy function proposed in this paper. The results in this paper show that the average Dice coefficient is improved by 5% compared with the advanced U-Net method, providing a theoretical basis and a new solution for the diagnosis of clinical CT image lesions.

CT segmentation; super-pixel; convolutional neural network (CNN); active contour method

TP391.41

A

刘侠,甘权,刘晓,等. 基于超像素的联合能量主动轮廓CT图像分割方法[J]. 光电工程,2020,47(1): 190104

10.12086/oee.2020.190104

: Liu X, Gan Q, Liu X,. Joint energy active contour CT image segmentation method based on super-pixel[J]., 2020,47(1): 190104

2019-03-12;

2019-05-17基金项目:国家自然科学基金资助项目(61172167);黑龙江省自然科学基金资助项目(QC2017076)

刘侠(1975-),男,博士,教授,硕士生导师,主要从事模式识别,图像处理的研究。E-mail:liuxia@hrbust.edu.cn

王波(1982-),男,博士,副教授,硕士生导师,主要从事模式识别、机器学习、医学影像分析与处理,以及自然语言处理等研究。E-mail:hust_wb@126.com