基于距离融合的图像特征点匹配方法

2019-12-23修春波马云菲潘肖楠

修春波 马云菲 潘肖楠

摘 要:针对ORB算法中特征点缺乏尺度不变性导致算法误匹配率高,以及二进制鲁棒独立基本特征 (BRIEF) 算法的描述子易受噪声影响的问题,提出了改进的特征点匹配方法。采用加速的具有鲁棒性的特征 (SURF) 算法进行特征点提取,利用带有方向信息的BRIEF算法进行特征点描述;在特征点邻域内选取随机点对,并对随机点对的灰度大小比较和相似度比较分别进行编码,采用汉明距离计算两种编码的差异;利用自适应加权融合的方式实现特征点相似性距离度量。实验结果表明,改进方法对于尺度变化、光照变化以及模糊变化的图像具有更好的适应性,与传统ORB特征点匹配方法相比能够获得更高的特征点正确匹配率,且该特征点匹配方法可用于改善图像拼接的性能。

关键词:特征点匹配;图像拼接;加权融合;汉明距离;尺度不变性

中图分类号:TP391.4

文献标志码:A

Image feature point matching method based on distance fusion

XIU Chunbo1,2*, MA Yunfei1, PAN Xiaonan1

1.School of Electrical Engineering and Automation, Tianjin Polytechnic University, Tianjin 300387, China;

2.Tianjin Key Laboratory of Advanced Electrical Engineering and Energy Technology(Tianjin Polytechnic University), Tianjin 300387, China

Abstract:

In order to reduce the matching error rate of ORB (Oriented FAST and Rotated BRIEF) method caused by the scale invariance of the feature points in the algorithm and enhance the robustness of the descriptors of Binary Robust Independent Elementary Features (BRIEF) algorithm to noise, an improved feature point matching method was proposed. SpeededUp Robust Features (SURF) algorithm was used to extract feature points, and BRIEF algorithm with direction information was used to describe the feature points. Random pixel pairs in the neighborhood of the feature point were selected, the comparison results of the grayscales and the similarity of pixel pairs were encoded respectively, and Hamming distance was used to calculate the differences between the two codes. The similarity between the feature points were measured by the adaptive weighted fusion method. Experimental results show that the improved method has better adaptability to the scale variance, illumination variance and blurred variance of images, can obtain a higher feature point correct matching rate compared with the conventional ORB method, and can be used to improve the performance of image stitching.

Key words:

feature point matching; image stitching; weighted fusion; Hamming distance; scale invariance

0 引言

圖像匹配是计算机视觉领域的核心技术问题之一[1-2],在图像拼接、智能视觉诊断、机器人视觉[3-5]等工程领域中有着重要的应用价值。常用的图像匹配算法有基于块匹配的方法和基于特征点的匹配方法两类。块匹配方法通常不具有旋转不变性,且当图像块较小时匹配结果易受噪声影响,而当图像块较大时图像之间的差异会导致匹配效果变差。因此,基于特征点的匹配方法成为当前研究的主流方法[6]。常见的特征点提取方法有尺度不变特征转换(ScaleInvariant Feature Transform, SIFT)算法、加速段测试的特征(Features From Accelerated Segment Test, FAST)算法和加速的具有鲁棒性的特征(SpeededUp Robust Features, SURF)等方法[7-9]。SIFT方法计算量较大,不适用于实时性要求较高的场合[10-11]; FAST方法计算速度较快,在ORB(Oriented FAST and Rotated BRIEF)描述方法中得到了应用,但FAST方法检测的特征点不具有尺度不变性,

因此,误匹配率较高[12]; SURF方法是SIFT方法的改进,不但具有较快的计算速度,而且所检测的特征点稳定性较好[13-15]; 传统的ORB方法采用带有方向信息的二进制鲁棒独立基本特征(Binary Robust Independent Elementary Features, BRIEF)描述子计算特征点领域内随机点对灰度大小比较的编码,但BRIEF特征描述子对噪声比较敏感,因此采用基于BRIEF特征描述子进行特征点匹配的效果有时并不理想[16-19]。

为此,本文提出了改进的ORB方法进行特征点匹配。为了克服FAST算法不具有尺度不变性的缺点,采用SURF算法进行特征点提取,并在BRIEF特征描述子中加入了特征点邻域内随机点对的灰度相似度的比较信息,分别采用汉明距离计算点对灰度大小和相似度比较的距离,将两个距离的自适应加权融合结果作为特征点的相似性度量,以此实现图像的特征点匹配,从而提高特征点匹配的正确率, 改善图像拼接等技术性能。

1 改进ORB特征点匹配方法

1.1 特征点提取

传统的ORB算法采用FAST算法进行特征点提取,利用带有方向信息的BRIEF特征描述子对特征点进行描述,并利用汉明距离计算特征点的匹配度。由于FAST算法所检测的特征点不具有尺度不变性,为此,提出采用SURF算法进行特征点提取的改进ORB方法。

通常,图像中的像素点(x,y)的Hessian矩阵计算为:

H(f(x,y))=2fx22fxy2fxy2fy2(1)

为了获得具有尺度不变性的特征点,选用不同尺度的滤波器对图像进行高斯滤波,然后计算Hessian矩阵。将Hessian矩阵判别式取极值的点确定为特征点。

1.2 特征点相似度量

BRIEF特征描述子根据特征点邻域内随机点对的灰度值大小比较组成编码。例如,在特征点邻域内选取n对随机点对,设f(xi)和f(yi)分别为特征点邻域内两个像素点xi和yi对应的灰度值。定义测试函数τ():

τ(xi,yi)=1,f(xi)-f(yi)≥00,其他 (2)

对于n对随机点对(xi, yi),可生成长度为n的二进制字符串,由此得到BRIEF特征描述子的编码为:

Ts=[τ(x1,y1),τ(x2,y2),…,τ(xn,yn)](3)

式(3)是根据特征点邻域内随机点对灰度大小比较所得的BRIEF特征描述子。当两个随机点对的灰度接近时,图像间光照的微弱变化等干扰会对像素点对灰度的大小关系产生较大影响,从而导致特征点匹配的准确率降低。为了提高特征描述子对干扰变化的鲁棒性,可在上述描述子的基础上融合随机点对灰度相似度的比较信息,弥补点对灰度大小比较信息的不足。定义相似度比较测试函数为:

τ′(xi,yi)=1,f(xi)-f(yi)>θ0,其他 (4)

其中:θ为相似度比较阈值,如果像素点对的灰度值差值大于θ,表示像素点对灰度差异较大;否则,表示像素点对灰度接近。因此,θ可选择最大灰度值的5%以内。

相似度比较描述子的编码为:

Tm=[τ′(x1,y1),τ′(x2,y2),…,τ′(xn,yn)](5)

其中: Tm编码值描述了随机点对中两个像素点灰度相似度的差异,即当相似度差异较大时,编码为1; 否则编码为0。Tm能够实现对Ts的信息补充,克服光照变化等干扰引起的编码不稳定。

特征点的相似性采用汉明距离进行度量。设两幅图像中待匹配特征点邻域内点对灰度大小比较的编码分别为Ts和Ts′,二者汉明距离为Ds,灰度相似度比较的编码分别為Tm和Tm′,二者汉明距离为Dm,其中,汉明距离可采用两个编码按位异或求和进行计算:

Ds=∑ni=1tsi⊕tsi′(6)

Dm=∑ni=1tmi⊕tmi′(7)

其中: tsi、tsi′分别为Ts和Ts′的第i位数值,tmi、tmi′分别为Tm和Tm′的第i位数值。将Ds与Dm两个汉明距离进行融合可求得待匹配特征点的相似性度量。常用的融合方法可采用加权求和的方式,即:

D=αDs+(1-α)Dm(8)

其中D为融合后的特征点相似性度量值。这种融合方式虽然简单,但由于缺少先验知识,融合系数不易确定。为此,提出具有自适应性的加权融合方式,即设:

α=Dm/(Ds+Dm)(9)

则:

D=2DsDm/(Ds+Dm)(10)

采用上述距离融合方式,较小的编码距离可获得较大的权重,而较大的编码距离则获得较小的权重,由此可有效均衡两种编码方式的作用强度,有利于提高特征点相似性度量的合理性。

2 实验结果分析

为了验证改进方法的有效性,将本文方法与传统ORB特征点匹配方法以及固定权值特征点匹配方法进行实验对比分析。其中,传统ORB特征点匹配方法以及固定权值特征点匹配方法均采用FAST特征点提取方法,本文方法采用SURF特征点提取方法。为了验证融合随机点对灰度相似度比较信息的作用,将固定权值特征点匹配方法的权值α选为0.75,相似度比较阈值θ=5。

2.1 尺度变化图像特征点匹配

图1为三张具有尺度大小变化的图像。

图1中,图像1与图像3的特征点匹配结果如图2所示。

由图2可见,传统ORB特征点匹配方法以及固定权值特征点匹配方法均有较多明显的错误匹配点对,而本文特征点匹配方法对图像尺度的变化具有更好的鲁棒性,因此匹配正确率较高。

图像1中的特征点分别与图像2和图像3中的特征点进行匹配,所得特征点正确匹配率如表1所示。

由表1可見,随着缩放尺度变化的加大,三种方法的特征点匹配正确率均有所下降,固定权值特征点匹配方法由于融入了灰度相似度比较信息,因此特征点正确匹配率较传统ORB方法有所提升,而本文方法由于采用尺度不变的SURF算法进行特征点提取,因此特征点正确匹配率能够得到进一步提升。

2.2 模糊图像特征点匹配

图3为测试集bikes(blur)组中的4张具有不同模糊程度的测试图像,图像的模糊程度逐渐增加。

采用三种方法对bikes1和bikes2进行特征点匹配,所得结果如图4所示。

从匹配结果可见,本文方法的特征点正确匹配率仍然高于传统ORB匹配方法和固定权值匹配方法。各图像间的特征点正确匹配率如表2所示。

由表2可见,随着模糊程度的增加,特征点的正确匹配率也逐渐减小,但本文方法采用自适应加权的方式实现了特征点邻域内点对的灰度大小比较和相似度比较的距离融合,并以此衡量特征点的相似性,因此具有更高的特征点正确匹配率,也说明本文方法对模糊图像具有一定的适应性。

2.3 光照变化图像特征点匹配

图5为测试集leuven(light)组中光照变化的五张图像,光照强度逐渐变弱。

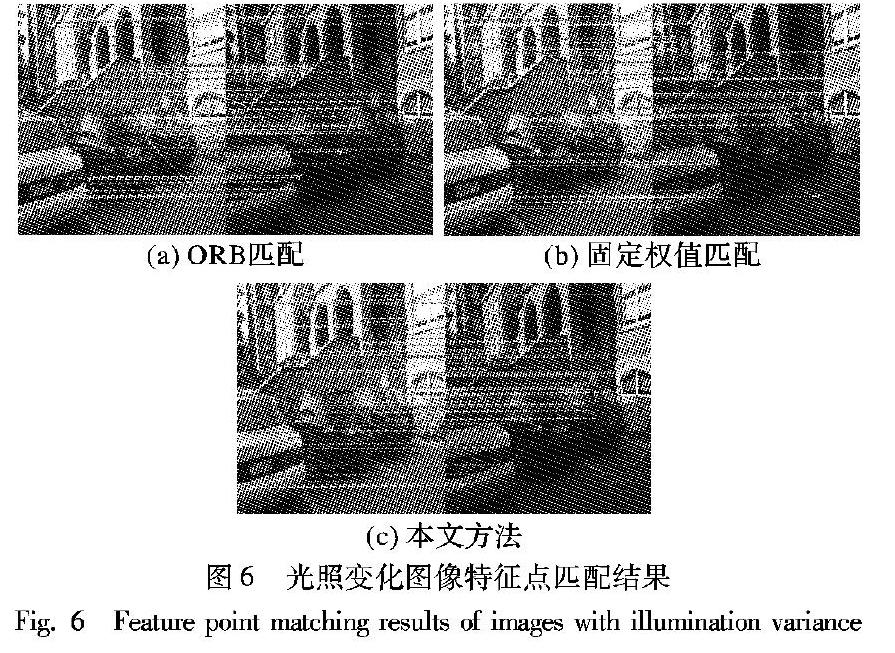

图6 给出了leuven1与leuven2中的特征点匹配结果。

从图6可见,虽然两幅图像的光照差异并不大,但光照变化对匹配结果仍然有着一定的影响:传统的ORB方法对光照变化比较敏感,误匹配的特征点数量最多;固定权值匹配方法通过融入点对的相似度比较信息能够在一定程度上降低光照变化对匹配结果的影响;本文方法特征点的正确匹配率最高,对光照变化具有更好的适应能力。

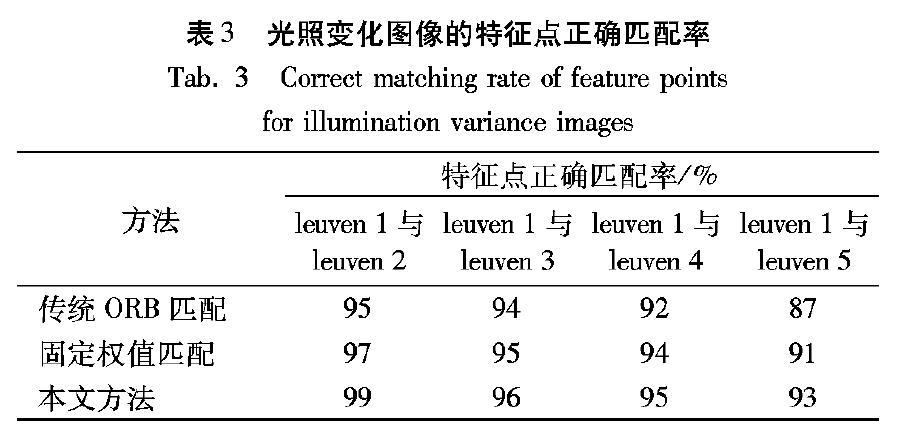

上述图像间的特征点匹配正确率如表3所示。

由表3可见,随着光照变化程度的增加,三种方法的正确匹配率均有所下降,但本文方法具有更高的正确匹配率,匹配结果对光照变化具有更好的鲁棒性。

3 基于特征点匹配的图像拼接

图7为测试集(input-42data)中的两张图像。

采用上述三种匹配方法对图7中的两张图像进行特征点匹配,随着特征点数量的增加,特征点匹配正确率的变化曲线如图8所示。

由图8可见,随着特征点数量的增加,三种特征点匹配方法的正确匹配率逐渐下降,但本文方法的匹配正确率明显高于其他两种对比方法。当特征点数量为160时,三种方法的特征点匹配结果如图9所示。

图9中,本文方法的特征点能够实现特征点的全部正确匹配,固定权值匹配方法有少量特征点发生匹配错误,而ORB匹配方法错误匹配特征点数量较多。基于上述匹配结果,实现的图像拼接效果如图10所示。

从图10和图11可见:基于ORB匹配的拼接图像,由于特征点正确匹配率低,其拼接效果较差,有明显的几何错位; 固定权值匹配方法的正确率较高,所得拼接效果也得到改善,虽仍有几何错位,但并不太明显; 而本文方法能够实现全部特征点的正确匹配,因此拼接效果最好,无明显的几何错位。

进一步采用基于距离加权的亮度融合方法,能够消除因亮度差异产生的拼接缝隙,得到最终的图像拼接结果如图12所示。

由此可见,本文方法能够有效提高图像特征点的正确匹配率,因此可改善图像拼接质量,抑制拼接产生的几何错位现象,提高图像拼接性能。

4 结语

本文针对传统ORB算法特征点匹配错误率较高、易受光照变化等干扰的问题,提出了改进的特征点匹配方法。采用SURF算法提取特征点,在BRIEF特征描述子中,融合了特征点邻域内随机点对的灰度相似度比较信息,并提出了灰度大小比较和相似度比较的编码距离自适应加权融合方式,提高了特征点匹配的正确率。实验结果表明,本文方法对图像尺度变化、光照变化以及模糊变化等均具有良好的适应能力,能够改善图像拼接的效果。

参考文献 (References)

[1]左川, 庞春江. 基于改进ORB的抗视角变换快速图像匹配算法[J]. 传感技术学报, 2018, 31(11): 98-104. (ZUO C, PANG C J. Fast image matching algorithm based on improved ORB for antiviewing transformation[J]. Journal of Sensing Technology, 2018, 31(11): 98-104.)

[2]董强, 刘晶红, 周前飞. 用于遥感图像拼接的改进SURF算法[J]. 吉林大学学报(工学版), 2017, 47(5): 1644-1652. (DONG Q, LIU J H, ZHOU Q F. Improved SURF algorithm for remote sensing image stitching[J]. Journal of Jilin University (Engineering Edition), 2017, 47(5): 1644-1652.)

[3]MENTZER N, PAYAVAYA G, BLUME H. Analyzing the performancehardware tradeoff of an ASIPbased sift feature extraction[J]. Journal of Signal Processing Systems, 2016, 85(1): 83-99.

[4]邹承明, 侯小碧, 马静. 基于几何学图像配准的SIFT图像拼接算法[J]. 华中科技大学学报(自然科学版), 2016, 44(4): 32-36. (ZOU C M, HOU X B, MA J. SIFT image stitching algorithm based on geometric image registration[J]. Journal of Huazhong University of Science and Technology (Natural Science Edition), 2016, 44(4): 32-36.)

[5]張勇, 王志锋, 马文. 基于改进SIFT特征点匹配的图像拼接算法研究[J]. 微电子学与计算机, 2016, 33(3): 60-64. (ZHANG Y, WANG Z F, MA W. Research on image stitching algorithm based on improved SIFT feature point matching[J]. Microelectronics & Computer, 2016, 33(3): 60-64.)

[6]曹君宇, 周浩, 高志山, 等. 基于SURF的图像拼接过程中配准算法的改进[J]. 云南大学学报(自然科学版), 2016, 38(6): 845-852. (CAO J Y, ZHOU H, GAO Z S, et al. Improvement of registration algorithm in image stitching process based on SURF[J]. Journal of Yunnan University (Natural Science Edition), 2016, 38(6): 845-852.)

[7]张博, 韩广良. 基于Mask RCNN的ORB去误匹配方法[J]. 液晶与显示, 2018, 33(8): 69-75. (ZHANG B, HAN G L. Based on Mask RCNN ORB error matching method[J]. LCD and Display, 2018, 33(8): 69-75.)

[8]王健, 于鸣, 任洪娥. 一种用于图像拼接的改进ORB算法[J]. 液晶与显示, 2018, 33(6): 73-80. (WANG J, YU M, REN H E. An improved ORB algorithm for image stitching[J]. LCD and Display, 2018, 33(6): 73-80.)

[9]WANG D, LIU H, CHENG X. A miniature binocular endoscope with local feature matching and stereo matching for 3D measurement and 3D reconstruction[J]. Sensors, 2018, 18(7): 2243-2250.

[10]SHAN Y, LI S. Descriptor matching for a discrete spherical image with a convolutional neural network[J]. IEEE Access, 2018, 6: 20748-20755.

[11]YU H, FU Q, YANG Z, et al. Robust robot pose estimation for challenging scenes with an RGBD camera[J]. IEEE Sensors Journal, 2019, 19(6): 2217-2229.

[12]ZHANG F, WAH B W. Fundamental principles on learning new features for effective dense matching[J]. IEEE Transactions on Image Processing, 2017, 27(2): 822-836.

[13]LEE W T, CHEN H I, CHEN M S, et al. Highresolution 360 video foveated stitching for realtime VR[J]. Computer Graphics Forum, 2017, 36(7): 115-123.

[14]KIM Y, JUNG H. Reconfigurable hardware architecture for faster descriptor extraction in surf[J]. Electronics Letters, 2018, 54(4): 210-212.

[15]BORGES F A S, FERNANDES R A S, SILVA I N, et al. Feature extraction and power quality disturbances classification using smart meters signals[J]. IEEE Transactions on Industrial Informatics, 2017, 12(2): 824-833.

[16]GARCIA J, GARDEL A, BRAVO I, et al. Multiple view oriented matching algorithm for people reidentification[J]. IEEE Transactions on Industrial Informatics, 2017, 10(3): 1841-1851.

[17]SRINIVASA K G, DEVI B N S. GPU basedngram string matching algorithm with score table approach for string searching in many documents[J]. Journal of the Institution of Engineers, 2017, 98(2): 1-10.

[18]曾慶化, 陈艳, 王云舒, 等. 一种基于ORB的快速大视角图像匹配算法[J]. 控制与决策, 2017, 32(12): 2233-2239. (ZENG Q H, CHEN Y, WANG Y S, et al. A fast large angle view image matching algorithm based on ORB[J]. Control and Decision, 2017, 32(12): 2233-2239.)

[19]杜承垚, 袁景凌, 陈旻骋, 等. GPU加速与LORB特征提取的全景视频实时拼接[J]. 计算机研究与发展, 2017, 54(6): 1316-1325. (DU C Y, YUAN J L, CHEN M C, et al. GPU acceleration and LORB feature extraction for panoramic video realtime stitching[J]. Journal of Computer Research and Development, 2017, 54(6): 1316-1325.)

This work is partially supported by the Tianjin Natural Science Foundation (18JCYBJC88300, 18JCYBJC88400).

XIU Chunbo, born in 1978, Ph. D., professor. His research interests include neural network, system modeling, chaos control.

MA Yunfei, born in 1995, M. S. candidate. Her research interests include image processing, pattern recognition.

PAN Xiaonan, born in 1992, M. S. candidate. Her research interests include neural network, target tracking.