融合了问句释义和词级别注意力的关系检测模型

2019-10-08李宽宇袁健沈宁静

李宽宇 袁健 沈宁静

摘 要: 在知识库问答系统任务中,由于自然语言表达方式的多样性与复杂性,语义相同表达方式不同的问句得到的答案可能不同,生成问句释义可以缓解这一问题。其次,关系检测是知识库问答系统中至关重要的一步,问答系统回答问题的准确性主要受这一步骤的影响,传统的基于注意力机制的关系检测模型没有考虑到答案路径不同抽象级别的不同重要程度。因此,本文提出了基于问句释义和词级别注意力机制的关系检测模型,用于知识库问答系统任务中,实验表明本文模型回答问题准确率较高。

关键词: 问句释义;词级别注意力;关系检测;知识库问答系统

中图分类号: TP391.1 文献标识码: A DOI:10.3969/j.issn.1003-6970.2019.05.013

本文著录格式:李宽宇,袁健,沈宁静. 融合了问句释义和词级别注意力的关系检测模型[J]. 软件,2019,40(5):7176

【Abstract】: In the knowledge base question answer system, due to the diversity and complexity of natural language expression, the question with the same semantic but different expressions may yield different answer. The generation of paraphrase can alleviate this problem. Secondly, relation detection is a crucial step in the knowledge base question answer system. The accuracy of the question answering system to answer questions is mainly affected by this step. The traditional attention-based relation detection model does not take into account the importance of different part of the different abstract levels of the answer path expression. Therefore, this paper proposes a relation detection model based on paraphrase and word-level attention mechanism, which is used in the knowledge base question answer system end task. Experiments show that the model has higher accuracy in answering questions.

【Key words】: Paraphrase; Word-level attention; Relation detection; KB-QA

0 引言

知识库问答系统以自然语言为基本输入方式,给用户返回一个精准的答案。随着越来越多的大规模知识库的发展,比如像Freebase[1]、yago[2]、DBpedia[3],基于知识库的问答系统使得传统的搜索引擎处于深度变革的尖端。不同于现有的基于关键字匹配的搜索方式,基于知识库的问答系统需要从语义角度对自然语言进行理解,然后从知识库中进行推理查询找出问题答案。常见的基于知识库的问答系统大致遵循两个步骤:(1)实体链接,将问句中的主题词对应到知识库中的节点实体,找出包含问题答案的候选知识库子图。(2)关系检测,检查知识库中某个节点到主题词节点之间的路径是否与问句中的谓词相匹配。

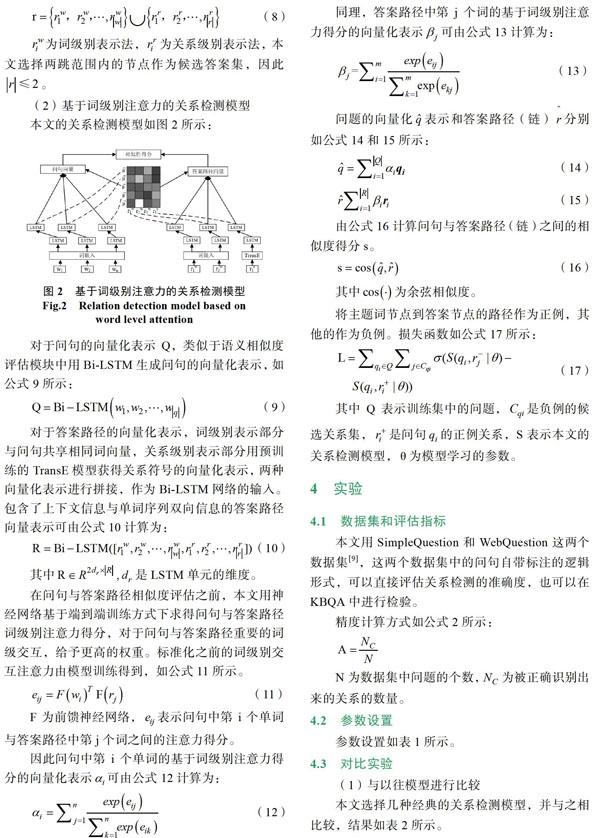

在自然语言表达中,相同的意思可以有多种不同的表达方式,例如“阿里巴巴的创始人是谁?”和“谁创建了阿里巴巴?”。这种情况在问答系统中普遍存在,对于语义相同但表达方式不同的句子,问答系统给出的答案可能会不同。在关系检测这一子任务中,需要依据某些规则对问句和知识库子图中候选答案到主题词节点之间的路径进行信息抽取,利用深度学习方式进行自动特征提取是近几年主流的研究方向,首先需要对自然语言问句和候选答案进行向量化建模,考虑到问句不同部分具备不同的重要程度,因此在深度学习模型中引入注意力机制。对于答案路径的向量化表示中,有两种不同抽象级别的表示方法,一种是关系级别表示法,另一种是词级别表示法,前者更考虑的是与问句全局语义信息进行匹配,而后者考虑的局部信息的匹配,目前很多文章结合这两种不同抽象级别的表达方式。传统注意力机制只考虑了问句各部分的注意力程度,没有考虑到不同表达方式问句适合用不同抽象级别答案路径表示来与它进行匹配。

为解决以上问题,本文为知识库问答系统提出了一种基于融入了问句释义(paraphrase)和词级别注意力的关系检测模型,用问题-答案对进行端到端的训练,将整个模型分成释义预测和关系检测模型两个部分,实验表明本文模型能提高问答系统回答问题的准确率。

1 相关研究

现有的知识库问答系统主要有两大分支:(1)基于语义分析的方式,例如有文献[4]文献[5]。(2)基于信息检索的方式,例如有文献[6]文献[7]。基于语义分析方式为了将自然语言翻译成包含语义信息的逻辑形式,需要大量带注解的逻辑形式作为训练数据,严重消耗人工成本。

语义分析方式最主要的缺点没有利用到知识库提供的背景知识,为此,Yao和Van Durme等人[6]提出信息检索的方法,通过实体链接缩小了查找范围。针对关系检测这一步骤,最开始Yao和Van Durme通过手工构建问题与候选答案路径的特征,构造分类器对问句中的关系谓詞进行识别,再与候选答案路径进行相似度匹配。为减少人工成本bordes等人[8]将问题和答案路径都映射到低维空间,通过模型的训练,学习到它们的向量化表示,向量相似度最高的那条答案路径对应的节点作为问题的答案。

用深度學习模型在知识库问答系统当中进行关系检测是目前主流的方法,Zeng等人[9]用CNN-RNN(卷积神经网络-循环神经网络)网络提取问句特征,依据候选关系对问句关系类型进行分类,Bordes等人[15]将自然语言问句与候选答案路径用神经网络映射到相同维度的向量空间,然后比较他们的相似度,Wang等人[10]在此基础上加入注意力机制对反应实体关系更重要的词基于更大的权重,从而提高关系检测的精度,Dong等人[9]用卷积神经网络(CNN)对自然语言进行建模,依据候选答案的三个方面分别求得相同问句不同部分不同的注意力权重,简单的将答案路径表示为固定的向量。

大多数深度学习方法都需要对自然语言和候选答案的答案路径进行相似度评估,在这之前需要对问句和路径信息进行向量化建模,以上这些方法重点在于对问句的向量化建模,对于答案路径的向量化表示,主要有两类,第一类将关系表示为一种语义单元,用提前训练好的神经网络模型例如TransE[12]生成它的向量化表示,另一类将关系表示为一系列的单词或者是一系列符号[13],与自然语言共享词嵌入,Yu等人[14]结合了两种不同的表示方法,但不能求得答案路径不同抽象级别的部分的注意力权重。

为了解决语义相同表达方式不同的问句获得的答案不同这一问题,很多深度学习模型将问句和它的释义都输入到问答系统模型当中进行训练,以求得问句与它的释义相似的向量化表示,如文献[9]文献[15]。现有的问句释义生成模型有很多,但将生成所有的释义同等看待并不合理,为此Chen等人[17]构建语法特征来评估其与原问句之间的相似性,Narayan等人[18]提出了一种基于深度学习的相似性评估模型,将与问句相似度高的释义作为最终的释义。然而这些模型没有充分利用问题答案对这种监督数据,生成的释义不能放到问答系统任务中检验其有效性。

本文提出了一种融合问句释义和答案路径词级别注意力模型,将模型分成两个模块:(1)首先生成问句的释义,基于神经网络的评估模型评估其与原问句之间的语义相似度,将问句与它的释义作为问答系统的输入,来预测候选答案子图中的答案概率分布,整个系统用问题-答案作为训练数据进行端到端的训练。(2)用已有的实体链接系统得到候选答案子图,然后用Bi-LSTM为自然语言和候选答案路径进行向量化建模,用交叉注意力模型求得他们之间的词级别注意力得分,最终求得他们之间带权重的向量化表示,用点乘积求它们之间的相似性得分,得分最高的作为最终答案。

2 模型概述

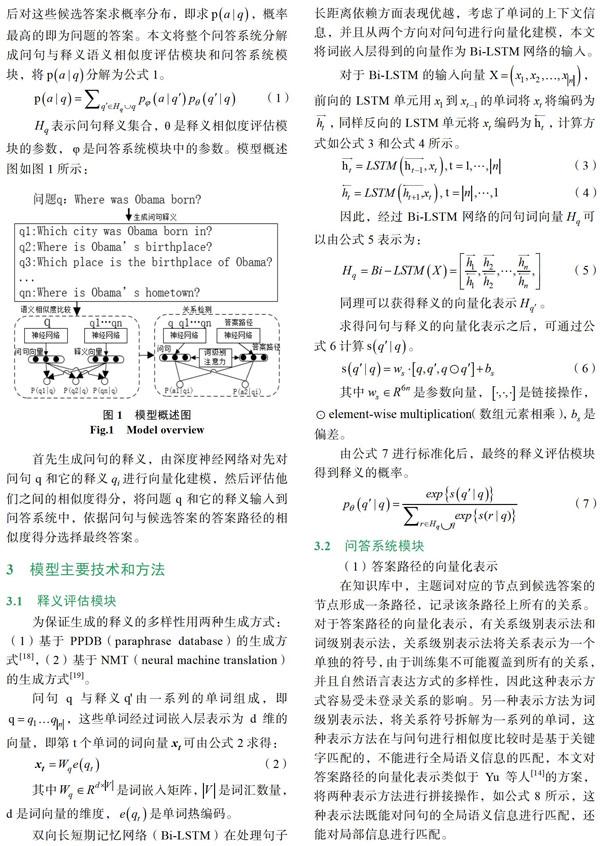

自然语言问句表示为q,答案表示为a。模型先通过实体链接找到对应的候选答案知识库子图,然后对这些候选答案求概率分布,即求 ,概率最高的即为问题的答案。本文将整个问答系统分解成问句与释义语义相似度评估模块和问答系统模块,将 分解为公式1。

Yih等人[13]提出的AMPCNN模型用CNN(卷积神经网络)最大池化操作对问句进行编码,在当时的基于答案路径注意力的一系列关系检测模型中取得了最高的准确度。Yu等人[14]利用了不同抽象级别的答案路径表示,为匹配不同抽象级别的答案路径表示,用HR-Bi-LSTM网络为问句进行建模。Zhang等人[20]提出的ABWIM模型,让比较操作在问句和答案路径的词级交互信息上进行。本文模型同样利用了问句与答案路径的词级交互信息,并且受益于融入问句释义这种端到端训练方式,增加了问句与谓词之间重叠的可能性,即使原问句不能生成正确答案,但它的某个释义却能生成正确答案,因此模型的精确度会提高。

(2)模型消融分析

为分析模型不同部分所起的作用,将对应部分替换为普通方法,并进行对比实验,结果如表3所示。

无注意力的模型将注意力矩阵中注意力权重都置为1,基于路径的注意力的模型只求问句不同部分的注意力权重,没有求答案路径方面的注意力得分,实验结果说明注意力机制在对于提高关系检测模型的准确度具有相当的作用,并且词级别注意力机制不仅求得更精确的问句向量表示,而且能更加精确地求得答案路径向量。本文的这种问句释义模型使得准确度提高了0.5%,说明本文这种融入问句释义的端到端训练模型具有一定作用。

5 结论

关系检测模型是知识库问答系统中最重要的一步,这一步的准确率直接影响知识库问答系统回答问题的准确度。从实验结果来看,可以得出如下结论:(1)同时使用词级别和关系级别的答案路径表示法,能充分匹配不同表达形式的问句。(2)若模型能充分利用问句与答案路径的词级别交互信息,并且求得带权重的细粒度的问句和答案路径向量表示法,对于提高关系检测的准确度起到非常大的作用。(3)本文融入的问句释义模型,并利用端到端的训练,生成了新的训练数据,提高了模型的准确度。

参考文献

[1] Bollacker, Kurt, Evans, Colin, Paritosh. Freebase: a colla-boratively created graph database for structuring human kno?w?ledge[C]// Sigmod Conference. 2008.

[2] Fabian M. Suchanek, Gjergji Kasneci, Gerhard Weikum. Yago: a core of semantic knowledge[C]// International Confere?nce on World Wide Web. 2007, pp. 697-706.

[3] Sren Auer, Christian Bizer, Georgi Kobilarov, Jens Lehmann, Richard Cyganiak, Zachary . DBpedia: A Nucleus for a Web of Open Data[C]// Semantic Web, International Semantic Web Conference, Asian Semantic Web Conference, Iswc + Aswc, Busan, Korea, November. 2007.

[4] Jonathan Berant, Andrew Chou, Roy Frostig, and Percy Liang. 2013. Semantic parsing on freebase from question- answer pairs[C]//Proceedings of the 2013 Conference on Empirical Methods in Natural Language Processing. 2013: 1533-1544.

[5] Wen-tau Yih, Xiaodong He, and Christopher Meek. Semantic parsing for single-relation question answering[C]//Proc?eedings of the 52nd Annual Meeting of the Association for Computational Linguistics (Volume 2: Short Papers). 2014, 2: 643-648.

[6] Xuchen Yao and Benjamin Van Durme. Information extrac-tion over structured data: Question answering with freebase[C]//Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). 2014, 1: 956-966.

[7] Kun Xu, Yansong Feng, Songfang Huang, and Dongyan Zhao. Hybrid question answering over knowledge base and free text[C]//Proceedings of COLING 2016, the 26th International Conference on Computational Linguistics: Technical Papers. 2016: 2397-2407.

[8] Antoine Bordes, Sumit Chopra, and Jason Weston. 2014a. Question answering with sub-graph embeddings[C]//Proc-eedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP). Association for Computational Linguistics, pages 615-620.

[9] Daojian Zeng, Kang Liu, Siwei Lai, Guangyou Zhou, and Jun Zhao. 2014. Relation classification via convolutional deep neural network[J]. In Proceedings of COLING 2014, the 25th International Conference on Computational Linguistics: Tec?hni?cal Papers. Dublin City University and Association for Computational Linguistics, Dublin, Ireland, pages 2335- 2344.

[10] Li Dong, Furu Wei, Ming Zhou, and Ke Xu. Question answering over freebase with multi-column convolutional neural networks[C]//Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 1: Long Papers). 2015, 1: 260-269.

[11] Linlin Wang, Zhu Cao, Gerard de Melo, and Zhiyuan Liu. Relation classification via multi-level attention cnns[J]//Pro-ce?edings of the 54th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Asso-ciation for Computational Linguistics, Berlin, Germany. 2016, pages 1298-1307.

[12] Antoine Bordes, Nicolas Usunier, Alberto Garcia-Duran. Translating embeddings for modeling multi-relational data[C]//Advances in neural information processing systems. 2013: 2787-2795.

[13] Wenpeng Yin, Mo Yu, Bing Xiang, Bowen Zhou, Hinrich Schütze, Simple question answering by attentive convolu-tional neural network[J]. arXiv preprint arXiv: 1606.03391, 2016.

[14] Mo Yu, Wenpeng Yin, Kazi Saidul Hasan, Cicero dos Santos, Bing Xiang, Bowen Zhou. Improved Neural Relation Detec?tion for Knowledge Base Question Answering[J]. In Procee?dings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), Associa?tion for Computational Linguistics, Vancouver, Canada, 2017, pp. 571-581.

[15] Antoine Bordes, Jason Weston, Nicolas Usunier. Open Question Answering with Weakly Supervised Embedding Models[C]//Joint European Conference on Machine Learning and Knowledge Discovery in Databases. Springer-Verlag New York, Inc. 2014.

[16] Shashi Narayan, Siva Reddy, and Shay B Cohen. Paraphrase generation from Latent-Variable PCFGs for semantic parsing[J]. arXiv preprint arXiv: 1601.06068, 2016.

[17] Bo Chen, Le Sun, Xianpei Han, and Bo An. Sentence rewriting for semantic parsing [C]//Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), 2016, pages 766-777.

[18] Ellie Pavlick, Pushpendre Rastogi, Juri Ganitkevitch, Benjamin Van Durme, and Chris Callison-Burch. PPDB 2.0: Better paraphrase ranking, fine-grained entailment relations, word embeddings, and style classification[C]//Proceedings of the 53rd Annual Meeting of the Association for Computa?tional Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 2: Short Papers). 2015, 2: 425-430.

[19] Dzmitry Bahdanau, Kyunghyun Cho, and Yoshua Bengio. Neural machine translation by jointly learning to align and translate[J]. arXiv preprint arXiv: 1409.0473, 2014.

[20] Zhang Hongzhi, Xu Guangdong, Liang Xiao, et al. An Attention-Based Word-Level Interaction Model: Relation Detection for Knowledge Base Question Answering[J]. arXiv preprint arXiv: 1801. 09893, 2018.