运用多层注意力神经网络识别中文隐式篇章关系

2019-09-05王体爽李培峰朱巧明

徐 昇,王体爽,李培峰,朱巧明

(1. 苏州大学 计算机科学与技术学院,江苏 苏州 215006;2. 江苏省计算机信息技术处理重点实验室,江苏 苏州 215006)

0 引言

作为自然语言处理中的一个基础任务,篇章分析专注于分析文本单元(例如,子句、句子、句群)之间的关系和结构,从而将文本解析为篇章树。篇章关系识别是篇章分析中一个重要的子任务,其目的在于识别出两个连续文本单元(称之为论元)Arg1和Arg2之间的语义联系。自动识别篇章关系可以为许多下游的应用提供帮助,例如,文本摘要和信息抽取。已有的研究表明,连接词是篇章关系识别中的一个重要线索,对于存在连接词的显式篇章关系识别而言,一个简单的基于频率的映射就能达到很高的分类精度[1],而对无连接词的隐式篇章关系的识别则一直是一个难题[2],因为其完全依赖于对文本的语义理解。例1给出了一个论元之间存在因果关系的例子,其中Arg1是Arg2的原因。

例1 [Arg1]上海浦东近年来颁布实行了涉及经济、贸易、建设、规划、科技、文教等领域的七十一件法规性文件,

[Arg2]确保了浦东开发的有序进行。

[隐式连接词]由此

[篇章关系]因果关系

目前,大部分的隐式篇章关系识别工作专注于直接识别两个论元之间的篇章关系,包括: ①抽取语言学特征后运用机器学习模型的传统方法[2-3]; ②通过对论元建模之后捕获论元之间语义联系的神经网络方法[4-7];也有部分工作先预测出连接词[8],或者使用标注的连接词信息来进行数据增强[9];还有一些工作利用未标记的数据,进行了多任务或无监督方法的探索[10]。传统方法依赖于手工构建的特征工程,不仅工作量大,而且浅层的语言学特征难以捕获论元的深层语义,因而在篇章关系任务上表现不佳。神经网络模型在论元表示上更具优势[4],并且能够从语义层面捕获论元之间的联系,因而相比于传统方法获得了可比较、甚至更好的性能,且存在很大的提升空间。

篇章关系识别本质上是一个“论元对”分类问题,因而对于神经网络方法来说,需要思考的就是如何对论元建模以及如何捕获论元之间的语义联系。已有的工作大多采用各种Bi-LSTM或者CNN的变体对论元进行编码[4,6],但是循环网络难以并行,而卷积网络在捕获全局信息方面存在不足。在捕获语义联系方面,常见的方法[5,11]是在两个论元之间运用记忆单元或Bilinear[12]等模型捕获向量之间的交互,或者直接通过注意力机制来对交互建模。特别地,考虑到大部分方法都仅模拟了对文本的单程阅读过程,难以胜任篇章关系识别这种需要深入理解文本语义的任务,Liu和Li[6]从人类阅读理解的角度出发,提出了重复堆叠注意力网络,用于模拟人类的重复阅读过程。Guo等[7]认为现有的方法大多在表示阶段忽略了论元之间的双向交互,因而从视觉感知的两阶段模型出发,提出了一种交互注意力(interactive attention)机制来增强论元的表示。

受文献[6-7]的启发,本文提出了一个三层注意力网络模型(TLAN),用于识别隐式篇章关系。首先通过Self-Attention层对论元进行初步编码,在一定程度上克服了Bi-LSTM和CNN的不足。之后在Guo等[7]工作的基础上,采用一种计算粒度更小的Interactive Attention层来模拟人类的双向阅读过程,从而在论元的编码过程中就考虑了论元之间的交互,并且通过非线性变换提取了论元对的外部记忆。最后通过Liu和Li[6]提出的包含外部记忆的注意力层来模拟人类的重复阅读过程,并且把论元对记忆作为一个贯穿全局的向量来引导论元最终表示的生成。

本文的主要贡献有:

(1) 提出了一个三层注意力神经网络模型,结合了模拟人类双向阅读和重复阅读过程的方法;

(2) 使用Self-Attention层对论元进行编码,使得输出序列不仅保留了论元的原始信息,还包含了全局的信息;

(3) 使用Interactive Attention层对论元之间的交互建模,采用细粒度的计算方法,对于每一个注意力权重向量都生成对应的语义表示。

1 相关工作

随着语料库PDTB[13]和RST-DT[14]的发布,许多工作采用传统方法[2-3,15]或者神经网络方法[4-7,9]对英语隐式篇章关系识别任务进行了探索。

Zhang等[4]提出了一个浅层卷积网络用于识别篇章关系,通过结合多种卷积操作来获得论元不同层面的语义特征信息。Chen等[5]提出了一个带有门控单元的神经网络模型,在论元之间同时捕获线性和非线性交互信息,从而产生匹配矩阵来分析论元之间的语义联系。Li等[16]在包含注意力机制的Bi-LSTM的基础上,通过基于张量的转换函数来捕获论元之间的语义交互特征。Qin等[9]提出了一种新颖的对抗方法,通过与显式关系网络进行对抗,使得隐式关系网络能够模仿学习到将显式连接词的可辨性转化为隐藏特征的能力。

针对中文,目前隐式篇章关系识别的研究工作主要在CTB[17]和CDTB[18]两个语料库上进行,由于语言资源的缺乏,已有的研究工作数量较少,而且大多借鉴了英语任务上采用的方法。

已有的研究工作[19-21]大多采用传统方法,其中Kong等[21]提出了一个端到端的篇章分析器,使用上下文、词汇和依存树等手工构建的语言学特征,通过最大熵分类器对篇章关系进行识别。也有部分工作[11,22]采用神经网络方法进行了研究。其中,Rönnqvist等[22]提出了包含注意力机制的Bi-LSTM模型,通过插入特殊标签的方式连接两个论元,然后使用注意力机制来捕获序列上的重要信息。Liu[11]提出了一个记忆增强注意力模型,通过门控单元来对存储论元交互信息的记忆槽进行检索,利用记忆槽中学习到的特征来帮助判断篇章关系。

2 基于多层注意力神经网络的中文隐式篇章关系识别

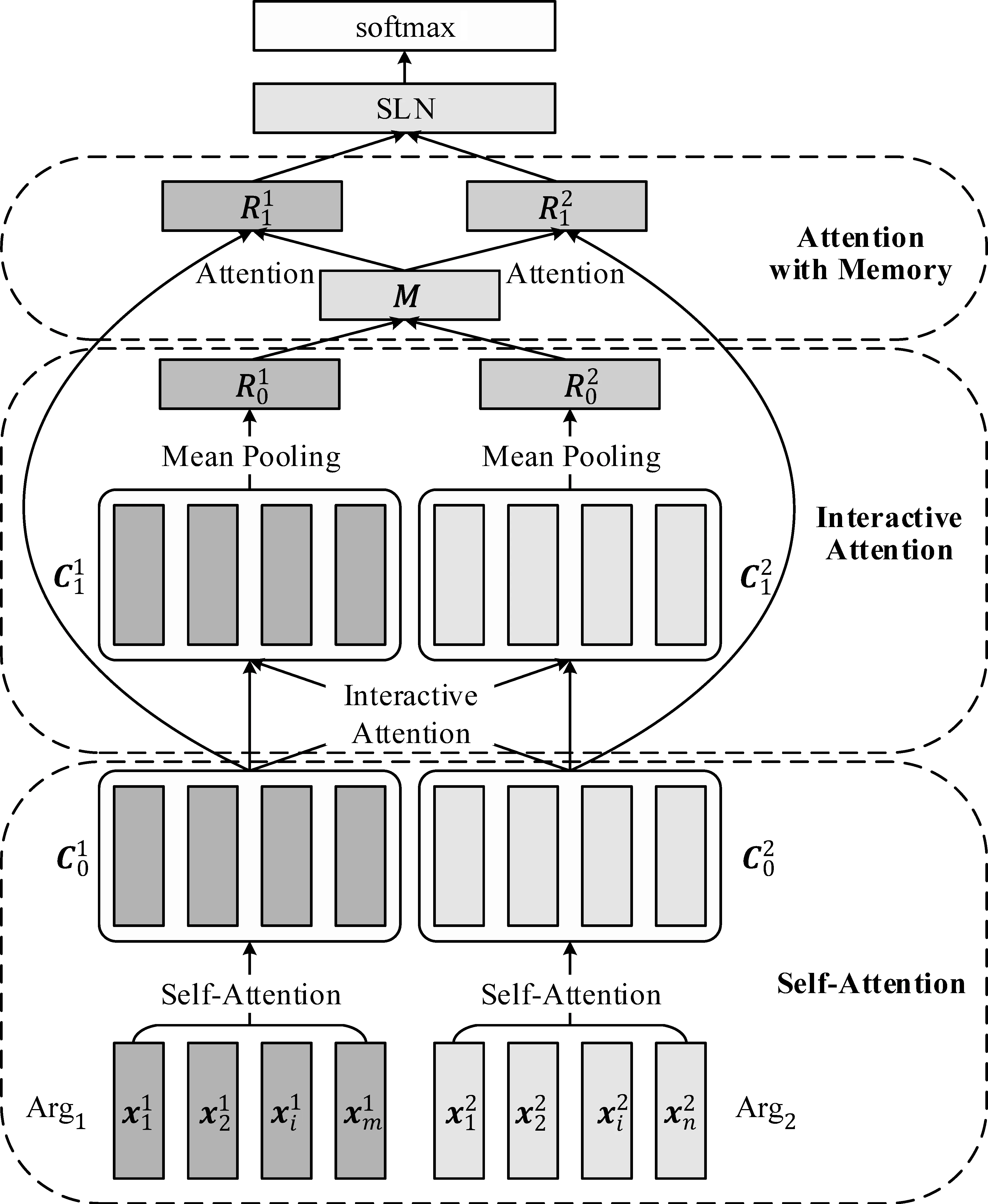

本文提出了一个用于识别隐式篇章关系的三层注意力神经网络模型(TLAN),其整体结构如图1所示。

图1 三层注意力模型整体结构

2.1 Self-Attention层

目前的工作[4,6]大多采用Bi-LSTM或者一维CNN来对输入序列进行编码,但是它们都存在一些不足: Bi-LSTM因为其循环结构训练费时;而CNN因为卷积核的视野有限,在捕获全局信息方面存在不足。因而最近的一些工作[23-24]尝试通过注意力机制直接对输入序列进行编码,如式(1)所示。

(1)

xi=[wi,pi]

(2)

Self-Attention采用式(1)对输入序列进行编码,输入的query,key,value序列是同一论元对应的词语序列E1(或E2),如式(3)所示。

(3)

2.2 Interactive Attention层

早期的神经网络方法忽略序列之间的交互,对两个序列分开进行编码[4,6],因而最近的很多工作[5,7]将焦点放在如何对这种交互进行建模。常见的方法是在两个序列的向量之间运用Bilinear[12]和Single Layer Network[25]等模型捕获向量之间的线性和非线性交互,然后在生成的匹配矩阵上通过卷积操作来捕获交互特征[5]。

也有部分工作尝试通过注意力机制直接对序列之间的交互建模,并且提出了一些Interactive Attention[7,26]。Guo等[7]从人类阅读的角度入手,发现人类在判断两个论元之间的关系时往往需要来回阅读这两个论元,特别是考虑两个论元中联系紧密的词语之间的语义联系,因而提出了一种模拟双向阅读的Interactive Attention。

(4)

(5)

(6)

相比于Guo的模型,本文采用了一种更细粒度的语义相似度计算方法,因而得到的论元表示更加准确,能够充分捕获论元之间的语义联系。并且本文还通过非线性变换来进一步捕获对论元对的理解,使得最终获得的论元对记忆能够存储丰富的论元交互信息。

2.3 包含记忆的注意力层

已有的工作大多模拟了人类的单程阅读,虽然能够快速地理解文本,但是难以胜任篇章关系识别这种需要深入分析文本语义信息的任务。受Liu和Li[6]的启发,本文构建了一个包含外部记忆的注意力层来模拟人类的重复阅读过程。研究[28]表明,当人类读者以特定的学习目标进行重复阅读后,不仅可以提高阅读的流畅性,还可以加深对文本的理解。因此对于篇章关系识别任务,进行重复阅读是有帮助的。因为简单的单程阅读难以充分捕获重要的语义线索,即使是人类通常也需要通过多次阅读,才能准确把握文本中词语对于判断论元之间关系的重要性。

(7)

(8)

其中,Wt∈R∈Rwt×2ds,bt∈R∈Rwt,Ws∈R∈Rc×wt,bs∈R∈Rc是层中的参数,c是篇章关系类别的个数。

2.4 模型训练

对于包含k个样本的训练集,本文使用Adam优化器[29],通过最小化AM-Softmax损失函数[30]来优化网络中的参数,如式(9)所示。

(9)

其中,t是softmax层的输入,Wj是参数矩阵Ws中对应每一个类别的参数行,c是分类类别的个数。为了防止过拟合,在输入到softmax层的参数向量之上进行了dropout操作。在实验部分,本文会报告模型中所有超参数的设置。

3 实验

3.1 实验设置

本文在CDTB[18]上对模型中文隐式篇章关系识别的性能进行了评估。

CDTB采用连接依存树的形式对抽取自CTB[17]中的500篇新闻文本进行了标注,共标注有隐式篇章关系5 496个,关系类型分为两层,包含4大类17小类。跟随之前的工作[20-21],本文选择相同的450篇文章作为训练集,50篇文章作为测试集,在最上层的3个类上进行了实验(剔除了占比极低的转折类),并且将所有的非二叉树都转换为左二叉树。3类隐式篇章关系的统计信息如表1所示。

表1 CDTB中隐式篇章关系的数量统计

词向量的维度设置为300,使用Word2Vec[31]进行预训练,词性向量的维度设置为50。在Self-Attention层和Interactive Attention层中,转换矩阵映射到的维度ds和di都被设置为350。外部记忆的维度dm被设置为700,非线性变换中的wt被设置为256。参照原论文[30]中的设置,将AM-softmax中的参数s和m分别设置为30和0.35。droupout率设置为0.5。本文使用HanLP(1)https://github.com/hankcs/HanLP对CDTB语料进行了预处理,包括分词和词性标注,使用Keras库(2)https://keras.io/来实现模型。

3.2 实验结果

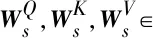

为了展示本文提出模型的有效性,本文选取了Bi-LSTM和CNN作为本文的基准,此外还包含三个已有工作中提出的模型: ①Kong: Kong等[24]提出的端到端篇章分析器,使用上下文特征、词汇特征和依存树特征通过最大熵分类器识别隐式篇章关系; ②Liu和Li: Liu和Li[6]提出的重复堆叠注意力模型,在通过Bi-LSTM编码后的论元上堆叠包含外部记忆的多层注意力机制来模拟人类的重复阅读过程; ③Rönnqvist: Rönnqvist等[22]提出的包含注意力机制的Bi-LSTM模型,通过插入特殊标签的方式将论元对连接起来,然后使用包含注意力机制的Bi-LSTM识别篇章关系; ④Guo: Guo等[7]提出的神经张量网络,通过Bi-LSTM和交互注意力机制对论元建模,之后通过神经张量网络捕获论元之间的交互信息。

在CDTB上进行的四分类实验结果如表2所示,可以看到本文提出的模型在Micro-F1和Macro-F1上都取得了最好的性能。相比于依赖人工构建语言学特征的传统方法,神经网络模型表现出了可比较的性能,特别是在“解说”关系上F1值获得了从2.1到5.8的提升,充分说明了神经网络方法能够有效地捕获论元中的深层语义信息,对于篇章关系识别任务是有效的。

表2 模型的实验结果

CNN凭借卷积核强大的特征捕获能力,取得了与传统方法接近的性能表现,在Micro-F1上还有小幅的性能提升。相比于基础的循环网络模型Bi-LSTM,Rönnqvist、Guo、Liu和Li模型在Micro-F1和Macro-F1上均有性能提升,这是因为注意力机制能够从Bi-LSTM的输出序列上挑选出重要的语义信息。特别地,Guo的模型使用交互注意力机制在编码过程中就考虑了论元之间的交互,并且通过神经张量网络(NTN)进一步提取交互特征,在Micro-F1和Macro-F1上相比Rönnqvist分别获得了2.2和1.0的性能提升;而Liu和Li模型使用多层注意力机制,并且引入包含论文对信息的外部记忆,在Micro-F1和Macro-F1上相比Rönnqvist分别获得了2.7和0.9的性能提升。

本文提出的模型在Micro-F1和Macro-F1上超过了所有的基准模型,在Micro-F1上取得了从0.7到3.6的性能提升,在Macro-F1上取得了从1.4到5.1的性能提升。相比侧重于直接获得论元语义表示的Bi-LSTM、CNN和Rönnqvist,本文的模型通过交互注意力机制,能够获得包含论元交互信息的论元表示。相比于Guo,本文通过包含外部记忆的注意力层将论元交互信息融入对论元的重复编码中,因而不仅模拟了双向阅读,还模拟了人类的重复阅读过程。相比于Liu和Li,本文的模型在包含交互信息的论元表示上,通过非线性变换来捕获论元之间的差异特征和交互信息,因而能够获得包含对论元对充分理解的外部记忆。

3.3 实验分析

本文也比较了不同类型篇章关系的识别性能,从表2可以看到,本文的模型在“因果”和“并列”类别的识别上相比于其他基准取得了近似的性能,在“解说”类别的识别上取得了从1.7到5.8的显著提升。其中“因果”类别相比于采用传统方法的Kong甚至还有0.8的性能下降,而“并列”类与Liu和Li相比只有0.4的微小提升,因而本文提出的TLAN模型主要是提高了“解说”类关系的识别性能。这可以从两方面进行解释: ①相比于抽取语言学浅层特征的传统方法来说,神经网络模型能够挖掘到更深层次的语义信息,这对于在数据集中占比较小的 “解说”类 (22.6%) 来说,更容易通过神经网络模型捕获到细微的语义特征,从而获得性能上的提升,而“因果”类 (13.9%) 样本数量过少,难以通过训练捕获到足够的特征。②本文提出的TLAN模型通过Self-Attention和Interactive Attention结构对论元进行编码,它们都是通过度量词语之间的语义联系来生成注意力权重,相比于其他两类关系,存在“解说”关系的两个论元的词语之间通常存在更强的语义关联,因为“解说”本质就是进一步的解释说明。

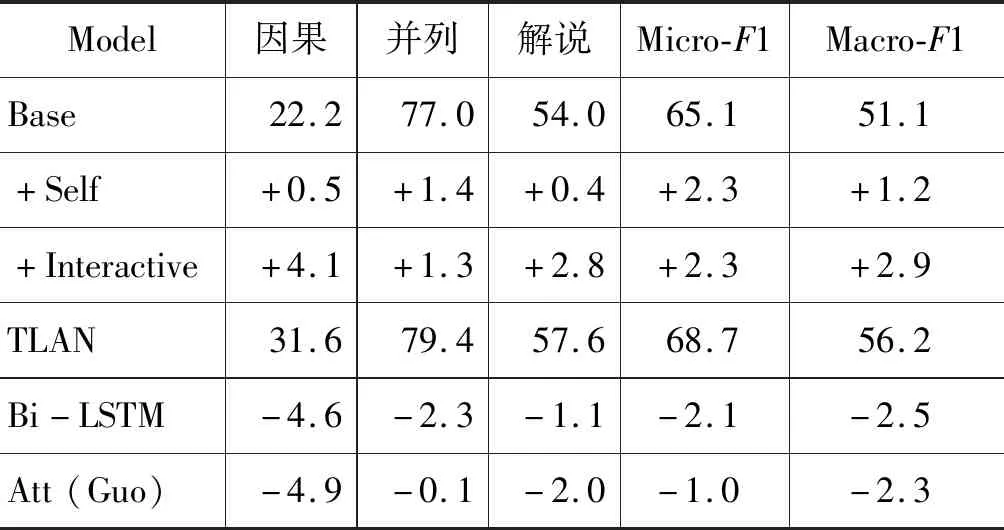

为了分析每一个注意力层对整个模型的贡献,本文还在多个模型的变体上进行了实验,结果如表3所示。首先以循环网络Bi-LSTM作为基础模型Base,通过在其上添加TLAN模型中的Self-Attention层和Interactive Attention层来分析注意力机制在篇章关系识别任务上的性能。为了与TLAN模型进行直观的比较,本文还构建了: ①Bi-LSTM将模型的Self-Attention层替换为Bi-LSTM;②Att(Guo) 将模型的第二个注意力层替换为Guo[7]提出的Interactive Attention层。

表3 TLAN模型变体的实验结果

Self-Attention层通过度量每一个词语与周围所有词语的相似度,使得重新编码后的序列包含了论元的全局信息,因而在添加到基础模型Base之后,增强了论元经过Bi-LSTM编码后的结果,在三个类别上都获得了小幅的性能提升。Interactive-Attention层在对论元的重新编码中,还考虑到了两个论元之间的语义联系,而这种语义联系正是对篇章关系识别任务非常有用的语义线索,因而在添加后取得了显著的性能提升(Micro-F1 2.3,Macro-F1 2.9),这说明TLAN模型模拟人类双向阅读的方法是有效的,特别是在两个占比较少的类别的识别性能上有明显的提升(因果4.1,解说2.8),这充分说明Interactive-Attention模型能够捕获论元之间的交互信息。TLAN模型中的包含外部记忆的Attention层直接使用了Liu和Li[6]提出的模型结构,其在篇章关系识别上的有效性已经得到了证明,因而本文没有对其做单独的分析。

Bi-LSTM使用Bi-LSTM替换Self-Attention来对论元进行初步编码,在Micro-F1和Macro-F1上出现了2.1和2.5的性能下降,这也验证了基础模型Base的实验结果,表明简单的循环神经网络模型难以有效地捕获论元与篇章关系识别相关的语义线索,而Self-Attention在这个任务上是更有效的论元编码模型。

Att(Guo) 将Interactive Attention层替换为Guo[7]提出的版本,在Micro-F1和Macro-F1上分别有1.0和2.3的性能下降。与本文采用的模型一样,Guo也是通过度量两个论元的词语之间的语义相似度来生成注意力权重,但是Guo通过计算平均值的方法直接得到最终的权重向量,因而计算粒度较大。而本文采用的方法对于每一个权重向量都先生成对应的语义表示,最后再通过Mean Pooling得到最终的论元表示,因而得到的语义表示更准确。特别是在样本占比较小的因果和解说类别的识别上,相比于本文的TLAN模型,Guo的模型分别出现了4.9和2.0的性能下降,这说明本文模型中Interactive Attention层的细粒度计算方法是更有效的捕获论元之间语义联系的方法。

表4展示了本文提出的TLAN模型在中文隐式篇章关系识别上的错误统计。

表4 错误分类样本的比例(%)

从表4中可以看到,54.4% 的因果关系类样本和 34.3% 的解说关系类样本被TLAN模型错误地识别为了并列类,这说明错误主要是出在判断一个样本是不是并列关系上。这主要是由两个原因导致的: ①训练集中的并列关系类样本超过半数; ②许多论元之间虽然不是并列关系,但是语义上很相似。例2给出了一个这样的例子。

例2 [Arg1]甘肃省积极实施科技兴农战略,推广地膜覆盖、节水灌溉、集雨节灌等农业适用技术和增产措施,

[Arg2]农业获得较好收成,全年粮食总产量达七十六点六亿公斤。

[隐式连接词]因此

[篇章关系]因果关系

例2中Arg1是Arg2的原因,因而论元之间的篇章关系为因果。但是从语义层面来看,Arg1中的 “农业”“灌溉”“增产”等词语,与Arg2中的“收成”“粮食”“产量”等词语存在非常强的语义相似度,而本文模型中的注意力层会将这种高相似度视为“并列”关系的特征,进而将其篇章关系错分为并列。

最后本文将模型运用到PDTB上,进行了英语隐式篇章关系识别的实验。PDTB是最大的篇章关系英语语料库,对来自于华尔街日报的2 312篇章文章进行了标注。跟随之前Pitler等[2]的工作,本文选择2~20章作为训练集、21~22章作为测试集、0~1章作为开发集,在最上层的4个类别上进行了one-versus-all的二分类实验。实验结果显示,相比于目前的性能最优系统,本文的模型取得了介于普通神经网络方法[4,6]和对抗方法[9]之间的性能。这是因为: ①对抗方法针对该任务做了精心的设计,表现出了比普通神经网络模型更好的性能; ②本文提出的模型可能存在一定的语言相关性,中文通常在句法上更加自由,因而本文提出的模型专注于捕获文本的语义信息,在捕获语言学特征方面可能存在不足。

4 结论

本文针对中文隐式篇章关系识别任务,提出了一个三层注意力神经网络模型TLAN。首先通过Self-Attention层对论元进行初步编码,使得模型充分阅读每一个论元,并尽可能保留了原始输入的信息。然后通过Interactive Attention层来模拟人类的双向阅读过程,通过度量两个论元词语之间的语义联系来生成包含交互信息的论元表示,并且进一步通过非线性变换获得“论元对”信息的外部记忆。最后,通过包含外部记忆的注意力层来模拟人类的重复阅读过程,在重复阅读论元初步编码信息的基础上,把论元对记忆作为一个贯穿全局的向量来引导论元最终表示的生成。在CDTB的实验中,本文提出模型在Micro-F1和Macro-F1上超过了多个强基准模型,在PDTB上本文的模型也取得了与其他性能最优系统可比较的性能,充分说明了本文提出的模型在隐式篇章关系识别任务上的有效性。