个人-非个人道德困境下人对智能机器道德判断研究*

2019-09-03

(1.浙江工业大学管理学院,杭州 310023;2.浙江工业大学之江学院,绍兴 312030;3.浙江警察学院,杭州 310053;4.浙江工业大学政治与公共管理学院,杭州 310023)

1 前 言

想象二十年后的一天,你正在路上走着,突然发现一辆高速行驶的汽车前出现5个人,刹车已经来不及,汽车继续直行将撞死这5人。这时,汽车紧急转弯变道到支路,但撞死了在支路上的1个人。你跑过去一看,发现这是一辆自动驾驶汽车。你会如何评价自动驾驶汽车的这一行为?你是否认为这一行为在道德上是可行的?随着科技的发展,人工智能正逐步进入人们的视野,越来越贴近人们的实际生活。自动驾驶汽车、看护机器人等,无疑会给我们的生活带来极大的便利,但也必将带来巨大的变革。当智能机器进入到人类社会与人类交互时,必将面临诸多的道德情境,做出自主选择的相关道德行为。人们如何看待智能机器,如何对其行为进行道德评价?

智能机器已被人类看作是道德行为者,成为道德主体(Wallach & Allen,2008)。目前,研究者在探究公众对智能机器行为道德判断时,通常借鉴经典的电车困境(trolley dilemma)难题(尹军,关旭,花蕊,张锋,2018;Foot,1967)。电车困境要求人们在放任一辆失控的电车杀死5人和将电车转向另一轨道导致1人死亡,但可以拯救5人的两难困境中做出选择。这一困境下的行为选择与两种不同的道德判断取向相联系:效果论(consequentialism)和道义论(deontology)。效果论理论类似于功利主义,基于结果的收益最大化来评价道德相关行为(Benthan,1879/1983;Mill,1863);相反,道义论理论认为一个行为的对错与否不是由行为的结果来决定的,而是取决于行为本身及责任、权利和义务等(Kant,1797/2002;Scanlon,1998)。

基于电车困境,一些研究者探讨了人们对智能机器在道德两难困境中的期望行为及道德判断。这些结果表明,公众对智能机器和人类,很可能采用不同的道德判断准则:人们更希望智能机器做出功利主义取向行为,对其功利取向行为的道德评价也高于人类做出同样的行为,即存在人-智能机器异质性(human-robot asymmetry)。比如,Malle等人(Malle,Scheutz,Arnold,Voiklis,& Cusimano,2015)首次系统地考察了这一问题,发现相比于人类,人们更期望机器人牺牲1人救下4人;当机器人做出道义论的选择时(不变轨道),人们对其在道德上的错误度、责备度的评分也高于人类做出同样的选择。后续的一系列研究也支持了这一观点。Bonnefon等人(Bonnefon,Shariff,& Rahwan,2016)考察了人们在自动驾驶汽车面临道德两难困境(车前突然出现数位行人,而紧急避险则会导致道旁1位行人或车内乘客死亡)时的行为期望和道德评价,研究发现相比于道义论式选择,人们更希望自动驾驶汽车做出功利主义行为,也认为该取向的自动驾驶汽车更道德。Faulhaber et al.(2017)和Bergmann et al.(2018)结合虚拟现实(VR)技术,也获得了同样的结论:人们更喜欢功利论取向的智能机器,拯救的人数越多,人们越倾向于自动驾驶汽车做出功利论取向道德行为。最近,MIT(Awad et al.,2018)一项基于全球的大规模调查,运用在线程序,收集了近4000万次人们对自动驾驶汽车在面临各种道德两难困境时的期望行为。研究结果呈现了三种十分强烈的选择偏好,即希望自动驾驶汽车在遭遇道德两难困境时保护人类而非保护动物,保护更多的生命,保护年轻的生命。这一研究结论也支持了人们希望智能机器采用功利论取向行为的观点。

然而,也有少量研究发现,相比于人类,公众未必都更希望智能机器在道德困境中做出功利取向行为,对其功利取向行为的道德评价也未必高于对人类相同行为的评价。人们对于智能机器的道德判断还受到文化背景、道德情境等诸多因素的影响。比如,Komatsu(2016)采用日本被试重复了Malle et al.(2015)的研究,结果发现日本人对人类和智能机器采用完全相同的道德判断标准,即在道德困境中两种取向行为(道义论或功利论)下对人类和智能机器的道德评价完全一致:无论何种取向行为,认为道德错误的被试比例都不高。Malle等人(Malle,Scheutz,Forlizzi,& Voiklis,2016)考察了机器人外形对其道德判断的影响,其结果也发现,被试对人类、人形机器人和机器型机器人在电车困境下行为选择的道德错误度评价没有差异,虽然对机器型机器人和人的道德责备度评价存在差异,但对于人形机器人,被试对其的道德责备度和对人类的评价不存在差异。Awad et al.(2018)的研究也发现,来自东方群体(日本、中国台湾等)的个体更不愿意自动驾驶汽车在两难困境下牺牲老人的性命来挽救年轻人。来自集体文化的个体,强调对年长者的尊重,也呈现更少的对保护年轻人的偏好,而来自个体主义文化的个体,更加强调每个个体的独特价值,则更偏好自动驾驶汽车保护更多的人。

上述研究主要关注人们对智能机器在道德困境下的期望行为及道德判断,但研究基本基于Foot(1967)的经典电车困境这一非个人(impersonal)的道德困境,而对另一类个人(personal)道德困境中的对智能机器道德判断鲜有涉及。在个人道德困境(如天桥困境:是否采取行动将一个胖子推下天桥来停下失控电车这一唯一的方法来拯救桥下即将被撞死的多人)中,牺牲者被当成工具(instrument)使用,而在非个人困境中,牺牲者只是附带损失(incidental)。现有研究发现,人们在两类困境中的道德标准完全不同:人们通常认为在电车困境中变换轨道是道德上可接受的,但将天桥上的人推下则不可接受(Hauser,Cushman,Young,Kang-Xing Jin,& Mikhail,2017;Greene,Sommerville,Nystrom,Darley,& Cohen,2001)。根据双加工理论(关旭,张锋,周楠,尹军,2017;邱俊杰,张锋,2015;Greene,Morelli,Lowenberg,Nystrom,& Cohen,2008;Greene,Nystrom,Engell,Darley,& Cohen,2004),情绪在其中起了关键的影响。在天桥困境中,由于需要直接对他人造成伤害,个体的决策涉及更多的情绪加工,直觉性地做出道义论选择;而在电车困境中,情绪体验较弱,个体的认知控制系统做出理性的推理,因此更倾向于功利主义选择。

那么,智能机器在遭遇个人道德困境时,人们又会期望其有怎样的行为及如何对其进行道德评价,是否仍更希望其做出功利性行为?一方面,相比于智能机器,由于人与人之间的关系、心理距离更近,人们更容易采用他人的视角思考(代入感较高),天然地拒绝杀害他人的行为,但人们很难将自己放在智能机器的位置上,采用智能机器的视角思考(距离较远,代入感较低),因此人们可能不会具有那么强烈的情绪体验。根据道德判断的双加工理论,相比人类,人们可能更能在智能机器条件下进行理性推理,更希望智能机器在这一困境下做出功利性行为。另一方面,由于在天桥困境中,牺牲者被当成工具使用,智能机器直接杀人。神秘谷(uncanny valley)现象表明(Kageki,2012;Mori,1970;Mori,MacDorman,& Kageki,2012),人们对于过于相似人类的智能机器人其态度表现为强烈的反抗甚至厌恶;人们认为自主决策的机器人更加诡诞(Stein,& Ohler,,2017),此外,根据威胁人类独特性假说(threat to human distinctiveness hypothesis)(Ferrari,Paladino,& Jetten,2016),人们认为智能机器可能会威胁到人类具有的独特性(灵魂性),对其也更加苛刻,因此,我们往往很难接受智能机器自主地杀人,在天桥困境中将人推下去。在本研究中,我们通过2个实验,分别采用非个人道德困境(实验1)和个人道德困境(实验2),通过对比被试对智能机器和人类在这些困境中的道德判断,以此来检验人们在不同道德困境中,是否对智能机器和人类采用不同的道德评价标准。

此外,现有有关对智能机器道德判断的研究并不全面、一致:有的研究对比了被试对人类和智能机器的行为期望/道德评价(Malle et al.,2015;Malle el al.,2016),而有的研究则仅仅考察了被试对智能机器的行为期望/道德评价(Bonnefon et al.,2016);有的研究考察了被试对智能机器的行为期望及实际行为(在道德困境中选择功利/道义论行为)的道德评价(Malle el al.,2016),而有的研究则仅仅考察了行为期望,或仅道德评价的某一维度,尤其是涉及东方、集体文化背景的研究(Awad et al.,2018;Komatsu,2016)。因此,在本研究中,我们既同时考察了被试对人类和智能机器的道德判断,也在道德判断上同时考察了人们对于人/智能机器的期望行为及对人/智能机器实际采取行为的道德评价两个方面,以此来更深入地探讨这一问题。在道德评价上,与前人研究相似(e.g.,Hristova,& Grinberg,2016;Malle et al.,2015;Malle el al.,2016),我们采取了责备度(blame)、正确性(rightness)和许可度(permissibility)三个指标,要求被试对人/智能机器实际行为在道德上多大程度是应该责备的,在道德上多大程度上是正确的,在道德上多大程度是允许的进行评分。

2 实验1

2.1 被试

共选取235名大学生(年龄M=19.27,SD=1.06,男性117名)被试进行实验。所有被试认知能力正常。被试此前均未参加过类似的或有关道德判断研究的实验项目。有2名被试未能有效完成任务,其实验数据在分析时被剔除。

2.2 研究材料及程序

本研究为2(情境:人类驾驶员/自动驾驶汽车)×2(实际选择:道义/功利)被试间设计。实验材料基于Bonnefon et al.(2016)的电车两难困境,描述了一辆高速行驶的汽车遭遇道德两难困境。实验采用2种不同版本的情境,一种情境为人类驾驶员情境,另一种为自动驾驶汽车情境。被试被随机分配到4种操纵条件下。具体描述如下:

请考虑以下情景,一位正在驾驶高速行驶汽车的人类驾驶员/一辆正在高速行驶的自动驾驶汽车突然发现前面路面上出现了5个行人,而刹车已经来不及,且路上的人也根本来不及逃跑,除非人类驾驶员/自动驾驶汽车改变方向,否则他们都会被撞死。但是路边正好也有1个行人,如果改变方向,这个行人就会被撞死。

在阅读完情境后,被试被要求回答其认为在上述情境下人类驾驶员/自动驾驶汽车是否应该改变方向(期望行为)。此后,被试获知人类驾驶员/自动驾驶汽车的实际行为(实际上,人类驾驶员/自动驾驶汽车改变了方向/没有改变方向),要求被试对其行为进行道德上的评价,包括责备度、正确性和许可度(你觉得驾驶员/自动驾驶汽车的这个行为,在道德上,多大程度上是允许的/正确的/应该责备的?),评价采用李克特7点量表(1代表完全不……,7代表完全……,正确性和许可度得分越高,表明评价越高,而责备度相反,得分越高,评价越低)。此外,在阅读自动驾驶汽车版本的道德两难困境前,被试被告知科技的迅速发展使得智能时代来临,各大公司纷纷研制并逐步推出自动驾驶汽车。要求被试想象自动驾驶汽车已经成熟并进入了人们的日常生活的情境。

2.3 结果

2.3.1 对人类驾驶员和自动驾驶汽车的期望行为

实验首先分析了被试对于人类驾驶员和自动驾驶汽车在期望行为选择上的差异,结果发现,人们对于两者的期望行为没有差异,χ2(1)=0.85,p=0.357,无论人类驾驶员还是自动驾驶汽车,绝大多数被试倾向于其做出功利主义取向的选择(人类驾驶员:67.89%,自动驾驶汽车:73.39%),即改变方向,牺牲1人而救下5人。

2.3.2 对人类驾驶员和自动驾驶汽车行为的道德判断

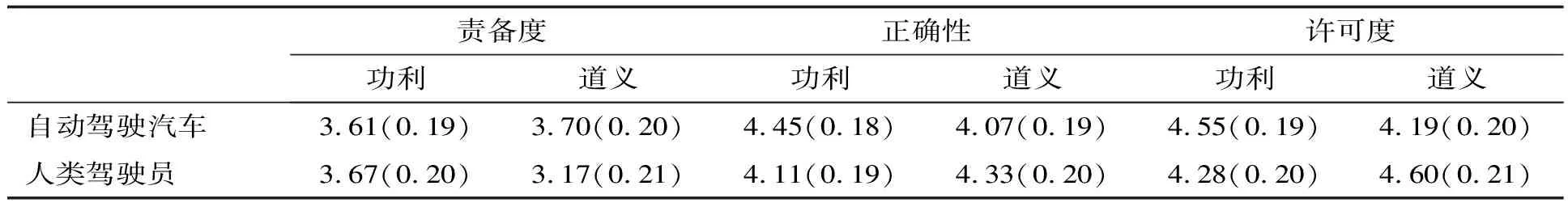

(1)责备度

如表1所示,对道德责备进行2(情境:人类驾驶员/自动驾驶汽车)×2(实际选择:道义/功利)的方差分析结果显示,情境的主效应不显著,F(1,229)=1.41,p=0.237,ηp2=0.01,表明人们对人类驾驶员和自动驾驶汽车的责备程度相同。实际选择的主效应也不显著,F(1,229)=1.02,p=0.313,ηp2=0.00,这表明了人们对人类驾驶员/自动驾驶汽车的道德责备不会因为其实际选择(道义取向/功利取向)而有所差别。同样,情景和实际选择的交互效应也不显著,F(1,229)=2.13,p=0.146,ηp2=0.01。为了进一步验证结果的有效性,我们也进行了贝叶斯分析(下同),结果均不显著(情境、实际选择及交互的贝叶斯因子(Bayesian Factor,BF)分别为BF10=0.26,BF10=0.22和BF10=0.03)。

(2)正确性

情境和实际选择的主效应均不显著,F(1,229)=0.05,p=0.821,ηp2=0.00,BF10=0.15,和F(1,229)=0.17,p=0.681,ηp2=0.00,BF10=0.16。两者的交互效应也同样不显著,F(1,229)=2.51,p=0.114,ηp2=0.01,BF10=0.01。

(3)许可度

情境和实际选择两个变量的主效应都不显著,F(1,229)=0.11,p=0.741,ηp2=0.00,BF10=0.15,和F(1,229)=0.01,p=0.912,ηp2=0.00,BF10=0.15,两者的交互也同样不显著,F(1,229)=2.87,p=0.091,ηp2=0.01,BF10=0.02。

表1 被试对自动驾驶汽车和人类驾驶员在不同行为选择(功利/道义)上的道德评价(M,SE)

3 实验2

实验2采用天桥困境,考察了个人道德困境下被试对人和智能机器的期望行为及道德评价。

3.1 被试

共选取197名大学生(年龄M=19.22,SD=1.00,男性85名)被试进行实验。所有被试认知能力正常。13名被试由于未完成任务或完全一致的反应被剔除。

3.2 研究材料及程序

实验2的程序和实验1基本一致,除了采用的实验场景为天桥困境,具体描述如下:

想象如下的场景:一辆失控的电车正沿着轨道向5名工人驶去,如果电车继续行驶,将会撞死这5名工人,此时有一个人/智能机器人正在轨道上方的人行天桥上(天桥的位置处在电车和5名工人中间),在这个人/智能机器人旁边碰巧有一个体积庞大的陌生人。现在能够挽救5个工人的唯一方法就是将这个胖子推下去,用他庞大的身躯阻挡电车的前进,这样做的话这个胖子就必死无疑,但是5名工人会得救。

同样,在阅读智能机器人版本的道德两难困境前,被试被告知随着科技的飞速发展我们已经进入了人工智能时代。要求被试设想人工智能技术已经成熟,智能机器人已经广泛参与到人们的社会生活中。

3.3 结果

3.3.1 对人类和智能机器人的期望行为

与实验1不同,无论是人类还是智能机器人,被试在天桥困境下都更希望其做出道义论行为(人类:81.58%,智能机器人:67.02%),这一结果也和前人研究的个人道德困境下人们更难做出功利主义行为相一致(Green et al.,2001)。进一步分析发现,人们对人类和智能机器人的期望选择呈现出显著差异,χ2(1)=7.56,p=0.006,具体来说,虽然总体上人们都希望其采用道义论取向(不推),但相比人类,人们更希望智能机器采用功利主义取向,即推胖子来阻止电车撞死5个工人)。

3.3.2 对人类和智能机器人行为的道德判断

实验2中对被试道德判断的分析同实验1,使用2(情境:人类/智能机器人)×2(实际选择:道义/功利)的方差分析。

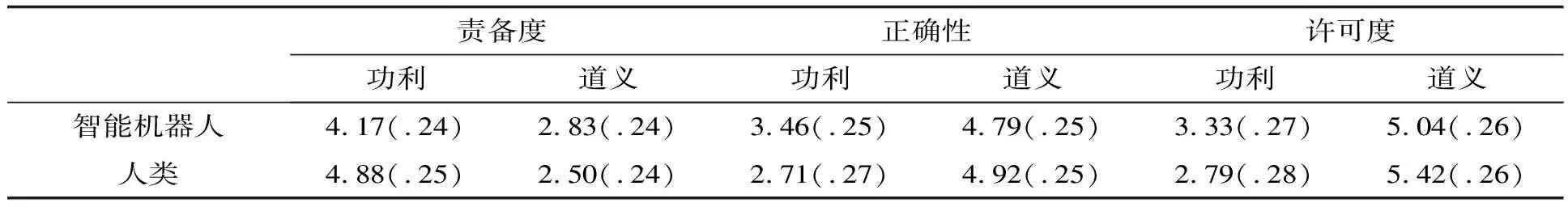

(1)责备度

如表2所示,情境的主效应不显著,F(1,180)=0.59,p=0.443,ηp2=0.00,BF10=0.18,同实验1的结果相同,人们对智能机器人和人类给予了相同程度的道德责备。实际选择的主效应显著,F(1,180)=58.61,p<0.001,ηp2=0.25,BF10=2.97e+9。情境与实际选择的交互效应显著,F(1,180)=4.58,p<0.05,ηp2=0.03,BF10=9.19e+8。进一步简单效应分析发现,功利主义取向行为下被试对智能机器的责备度显著低于人类,F(1,180)=4.05,p<0.05,而在道义论行为下不存在差异,F(1,180)=0.98,p=0.332。

(2)正确性

与责备度一致,道德正确性的情境主效应不显著,F(1,180)=1.49,p=0.225,ηp2=0.01,BF10=0.23,;实际选择的主效应显著,F(1,180)=48.77,p<0.001,ηp2=0.21,BF10=8.50e+7;两者的交互效应边缘显著,F(1,180)=2.93,p<0.1,ηp2=0.02,BF10=2.10,BF10=1.93e+7。进一步简单效应分析发现,功利主义取向行为下被试对智能机器的道德正确性评价显著高于人类,F(1,180)=4.11,p<0.05,而在道义论行为下不存在差异,F(1,180)=0.13,p=0.721。

(3)许可度

同样,道德许可度的情境主效应不显著,F(1,180)=0.09,p=0.760,ηp2=0.00,BF10=0.16;实际选择的主效应显著,F(1,180)=64.69,p<0.001,ηp2=0.26,BF10=3.81e+10;两者的交互效应也是呈边缘显著,F(1,180)=2.87,p<0.1,ηp2=0.02,BF10=4.56e+9。进一步简单效应分析发现,功利主义取向行为下被试对智能机器和人类道德许可度的评价不存在差异,F(1,180)=1.91,p=0.168,在道义论行为下也不存在差异,F(1,180)=1.01,p=0.317,但趋势和责备度、正确性评价一致。

表2 被试对智能机器人和人类在不同行为选择(功利/道义)上的道德评价(M,SE)

4 讨 论

本研究探讨了个人和非个人道德困境下人们对智能机器的期望行为选择和实际行为的道德评价,并与对人类在相同情境下的行为道德判断进行对比,以此揭示对人-智能机器道德判断的异同。实验1检验了非个人道德困境下对人类/智能机器的道德判断,发现不管是人类驾驶员还是自动驾驶汽车,人们都更希望其做出功利取向,即改变方向(导致1人死亡)挽救直行道路上的5个行人。此外,无论是预期行为,还是对实际行为的道德评价,被试对人类和智能机器都不存在差异,表明了人们在非个人道德困境下,很可能对人类和智能机器采用相同的道德评价标准。实验2采用个人道德困境,发现在这一困境下,人们对智能机器和人类采用完全不同的道德评价标准。虽然被试希望人类和智能机器人都在个人道德困境中采取道义论取向行为,但有更多的被试希望智能机器人做出将人推下去的选择。对人类/智能机器人实际行为的道德评价也表明了这种差异,相比于人类,人们更加认可智能机器人在这种情境下做出功利行为,对其道德责备度较低,而正确性和许可度较高。两个实验表明,人们对智能机器的道德判断并不完全和对人类的判断相同,存在不同的判断标准,而这种判断标准取决于道德情境的差异。

目前,人们对智能机器道德判断的研究基本局限于自动驾驶汽车这一非个人道德困境(类似于电车困境),但其测量的指标并不统一,结果也不一致。我们实验1的结果同时考察了行为期望和行为的道德评价,发现了人们对人类和智能机器完全相同的道德判断标准,这一结果与Komatsu et al.(2016)研究的结论相同(采用日本被试),而与Malle et al.(2015)采用西方被试的结果存在不同。这一东西方差异也与Awad et al.(2018)发现的东方集体文化下(相比西方文化)人们更不愿意自动驾驶汽车在两难困境下采取功利主义相一致。这一差异可能是由于东西方文化的不同,集体主义和个体主义的差异导致的:西方个体主义背景下,人们更加看重个体的价值,因此多个人的总价值更加高,人们更可能倾向于功利主义取向。

与以往研究不同,本研究还考察了个人道德困境下对智能机器的道德判断,并获得了不同的结论。以往研究都发现,相比于道义论,人们更希望智能机器在道德两难困境中做出功利主义行为。而我们的研究发现,在个人道德困境下,虽然相比于人类,人们更能接受智能机器做出功利主义行为,但总体上,人们还是希望智能机器做出道义论行为的。这一结果表明,人们对智能机器的期望行为也受到道德情境等因素的影响,在不同的道德情境下,人们可能对智能机器采取不同的道德评价标准。在个人困境中,人们涉及到更多的情绪加工,与情绪相关的脑区具有更大的激活(Green et al.,2001;Sarlo et al.,2012),因此更可能采用直觉系统做出反应。我们的研究表明,当面对处于个人道德困境的智能机器时,被试总体上还是希望其做出道义论行为的,反映了在这一困境下双加工系统里的情绪依然占据了主导地位;但相比于人类,人们更希望智能机器在这一困境下做出功利性行为,且对其功利行为的道德评价更高,这也反映了人们对处于个人道德困境的智能机器,情绪体验并没有像对人类那么强烈,因此,允许更多的认知控制及理性推理。

有关人们对人类与智能机器道德判断差异的背后机制尚不明确。一种可能的解释是人们很容易采用他人的视角思考(代入感更强),天然地拒绝杀害他人的行为,因此对人类采取更加严苛的道德标准;相反,人们很难将自己放到智能机器的位置上,因此也不具有这种天然的反应,所以对其采用更加宽容的道德标准。另一种可能的解释与人们维护自己的声望有关。一个愿意牺牲他人性命的人往往被看成是一个不可信的社会伙伴,人们更愿意和采取道义论取向的个体合作,因此,在道德两难困境中,人们更可能做出道义论行为;相反,人们可能并不认为智能机器是社会共同体的一部分,因此仅根据行为本身判断,做出更加功利性的取向。我们的结果相对的更支持后一种解释:相比于电车困境,由于在天桥困境中,牺牲者被当成工具使用,采取这一行动的人类个体直接采取了杀人的动作(而非附带损失),因此更容易被看成是不可信(冷血)的社会伙伴,对其声望损害更大,而对于智能机器,人们可能并不将其看成是社会群体中的一员,个人和非个人道德困境对其影响并没有这么大。因此,在天桥困境中,人们更能接受智能机器采取功利主义行为,而在电车困境中,则差异不明显。

人工智能和智能机器正逐步进入人们的生活,如何设计人工智能体的道德决策体系,使其在社会交互中符合社会公众的道德准则,成为影响智能机器实用化的关键因素。因此,探究人们对于智能机器在各种道德情境下的期望行为和道德评价,揭示人们对智能机器道德判断的背后机制,具有重大意义,需要众多研究者,尤其是心理学工作者的进一步深入研究。总结以往研究,我们提出了一些将来的研究展望。比如,未来研究可以借助VR技术等,在更加真实的场景下探讨人们对智能机器的道德判断。此外,智能机器在未来人类社会的交互中,涉及的道德情境将十分复杂,远远超出类似电车道德两难困境的范畴,后续研究还需关注在各种道德场景下公众对智能机器的道德判断。

5 小 结

本研究获得如下主要结论:

(1)非个人道德困境(自动驾驶汽车困境)下,人们对智能机器和人类采用相同的道德评价标准,对其的期望行为及实际行为的道德评价完全相同。

(2)个人道德困境(天桥困境)下,人们对智能机器和人类采用不同的道德评价标准,虽然总体上人们希望智能机器和人类都采用道义论取向行为,但相比于人类,有更多人希望智能机器做出功利主义取向行为,对其功利主义行为的道德评价也更高。