一种融合深度信息的视频目标压缩跟踪算法

2019-07-12段范存宁爱平

段范存,张 雄,宁爱平

(太原科技大学电子信息工程学院,太原 030024)

视频目标跟踪广泛应用于智能交通、视频监控、人机交互和医疗诊断等各个方面。目标跟踪[1-2]是使得计算机模仿人的视觉机制感知并稳定跟踪目标物体位置。在跟踪中,物体遮挡、光照变化、形态变化以及背景杂波是造成跟踪效果差的常见原因。因此找到一种能够应对复杂环境影响的鲁棒、实时的目标跟踪算法是目前亟待解决的难题。

Matthews利用图像灰度值通过全局模板匹配应用于目标跟踪[1-3]。Mei提出用稀疏表示方法处理目标遮挡,但是较高的算法复杂度使得该算法不能实现实时跟踪[4]。以上视频目标跟踪算法在运行过程中未利用背景信息,跟踪的鲁棒性和准确性较低。Babenko提出多示例学习(Multiple Instance Learning, MIL)跟踪算法[5],利用正负样本包提取样本haar-like特征并更新分类器,获得了较鲁棒的效果,但由于计算量较大而难以得到实际应用。张开华提出压缩跟踪(Real-time Compressive Tracking, CT)算法[6]和快速压缩跟踪(Fast Compressive Tracking , FCT)算法[7],两种算法具有较高的有效性、准确性和鲁棒性。以上算法由于特征单一,当目标遭遇复杂环境影响时容易导致跟踪失败。

随着深度传感器的出现,深度数据已应用到视觉跟踪中,Luber提出基于RGB-D的行人跟踪[8],但是在复杂环境下跟踪效果降低。

本文提出了融合深度信息的视频目标压缩跟踪算法。该算法融合灰度图像和深度图像的互补特征,丰富了目标外观模型。多弱分类器加权组合为强分类器,使得目标分类结果更加准确。实验证明,融合深度信息的目标外观模型对复杂环境下的目标跟踪结果更加的鲁棒。

1 相关算法介绍——CT算法

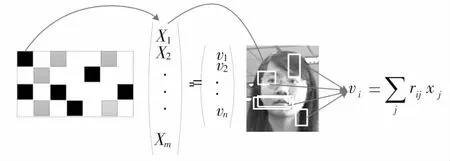

CT算法采用多尺度图像特征建立外观模型,是一种简单且高效的跟踪算法。外观模型利用多尺度滤波保存目标原始图像特征空间信息。通过稀疏测量矩阵得到的压缩特征,利用朴素贝叶斯分类器进行目标和背景的分类识别,得到最大分类分数的候选目标即为跟踪目标。CT算法在时间、准确性和鲁棒性等方面表现优异。算法流程如图1所示。

1.1 压缩传感

压缩感知理论[9]是一个K稀疏信号可以由一个数目小的随机测量矩阵重构出来。一个随机矩阵R∈Rn×m(n≪m)可以将高维特征空间中向量x∈Rm投影到低维特征空间v∈Rn,即:

v=Rx

(1)

CT算法中采用的稀疏测量矩阵R定义如公式(2).

(2)

在公式(2)中,s在2~4之间以平均概率取值。p代表rij取某个值的概率。稀疏测量矩阵R将高维特征x降为低维特征v.如图1中,算法仅需储存矩阵R中的非零条数和对应输入图像矩形滤波器位置。

图1 CT算法流程图

Fig.1 The flow chart of CT algorithm

图2 特征压缩图示

Fig.2 Illustration of compressing feature

1.2 分类器建立与更新

CT算法提取到目标的正负样本集,每一个样本降维后的特征表示为v=(v1,...,vn)T∈Rn.设定v中的所有元素独立分布,由朴素贝叶斯分类器建立的模型表示如公式(3).

(3)

(4)

(5)

四个参数每完成一次跟踪进行增量更新,

(6)

其中λ>0表示学习速率,(μ1,σ1)由式(7)得到较好估计。负样本参数更新方式与正样本参数更新方式相同。

(7)

CT算法的优势在于利用压缩感知理论降低数据维度,以最大概率保持特征不变性的同时实现跟踪的实时性。但是,该算法仍存在缺陷:第一,单一特征不足以表示物体外观,灰度图像对光照变化极其敏感;第二,统计模型基本固定,容易将弱特征引入到分类器中,降低跟踪的准确性。

2 融合深度信息的视频目标压缩跟踪算法

提出的融合深度信息的视频目标压缩跟踪算法是基于灰度图像特征和对应深度图像特征的多特征融合建立目标外观模型的实时压缩跟踪算法,算法流程如图3所示。该算法提取灰度图像和对应深度图像的正负样本,通过多尺度滤波得到样本的多尺度图像特征,利用稀疏测量矩阵实现特征的降维处理,得到正负样本压缩特征,利用马氏距离赋予弱分类器权值,近似优化似然函数,提高分类器性能,实现正负样本准确分类,最终将最大分类分数的候选样本作为目标位置。

2.1 深度特征

深度图像像素值表示目标物体与摄像头之间的距离。深度图像不易受到光照和阴影的影响,可以很好地解决物体在彩色图像中亮度、色度和饱和度会随着距离的改变而改变的情况。深度信息的加入不仅丰富了目标外观表示,而且获得了距离信息,降低了目标单一灰度特征的不稳定性。

深度图像特征是一系列图像块的加权组合,特征选取的方式为公式(8)所示:

(8)

其中,变量BLOCK为候选目标区域提取到的图像块。变量s表示提取到深度图像块的数目。矩阵R的每一行最多有4个元素的值参与计算,其余为0的元素不需要存储和计算,节省了计算量,提高了算法速度。

CT算法中,稀疏测量矩阵R1内元素rij都为1或 -1时,提取特征表现为图像灰度的均值,当rij的取值既有1又有 -1时,特征表现为图像块之间的差异,体现目标纹理特征。该算法中70%的特征表示为纹理特征,但是,纹理特征易受到环境或自身纹理变化影响,表现不稳定。

图3 融合深度信息视频目标压缩跟踪算法

Fig.3 Video target compressive tracking algorithm with fusion depth information

为了增强算法的鲁棒性,结合文献[10]中的特征提取矩阵R2的生成方法,如公式(9),提取深度图像压缩特征。

(9)

其中,i表示为特征提取矩阵的第i行,k表示为第i行中第k个非零值。矩阵R2与R1的分布特性正好相反,深度图像提取的特征中70%为灰度特征,其余为纹理特征,由此形成互补特征。因此,复杂环境下融合深度信息的目标外观模型的稳定性得到了补充,从而提高了跟踪的鲁棒性。

2.2 马氏距离加权

公式(3)中似然比最大的正样本即为跟踪结果。因此似然比值的大小对于算法的跟踪效果起到至关重要的作用。融合深度信息的视频目标压缩跟踪算法对不同似然比予以不同的权值w,提高有效弱分类器权重,增强整体分类器性能。本文算法利用马氏距离表示权值。

每个特征训练一个弱分类器,分类器权值如公式(10)所示:

(10)

2.3 特征融合

融合深度信息的视频目标压缩跟踪算法设定特征中的所有元素都是独立分布的,算法利用目标彩色图像的灰度特征和深度图像的空间特征分别构建贝叶斯分类器H(v)、H(u),将灰度特征和空间特征进行加权融合得到新的分类器H(V),实现目标外观模型多特征融合。

(11)

(12)

(13)

(14)

(15)

(16)

分类器参数(μi,σi)和(ψj,ζj)按公式(6)和(7)进行更新。算法在每一帧都进行分类器的更新,由此避免错误累积,影响跟踪效果。

为了得到准确、鲁棒的跟踪结果,算法使用加权似然比进行特征级融合,融合后的分类器分数为公式(17)所示。

(17)

将得到最大分类分数所确定的候选目标作为目标的位置。

2.4 算法流程

本节详细介绍了融合深度信息的视频目标压缩跟踪算法。具体步骤如下:

步2:从t=2,...,T开始。

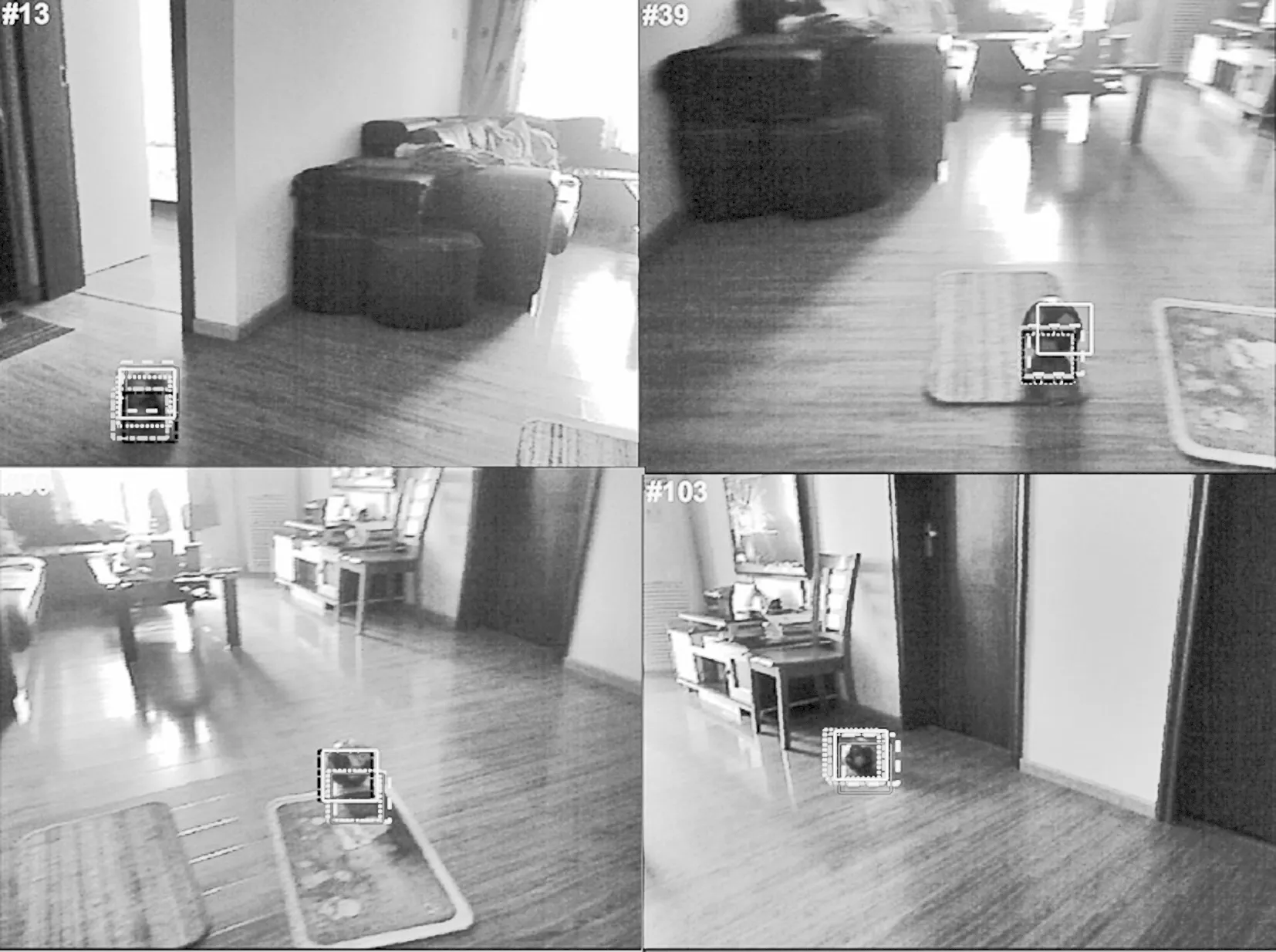

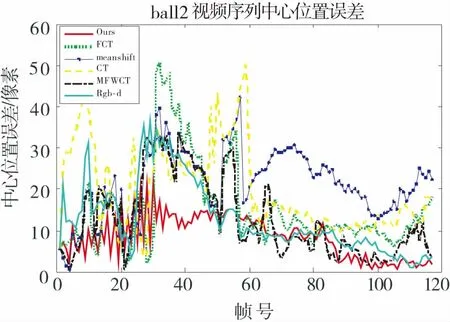

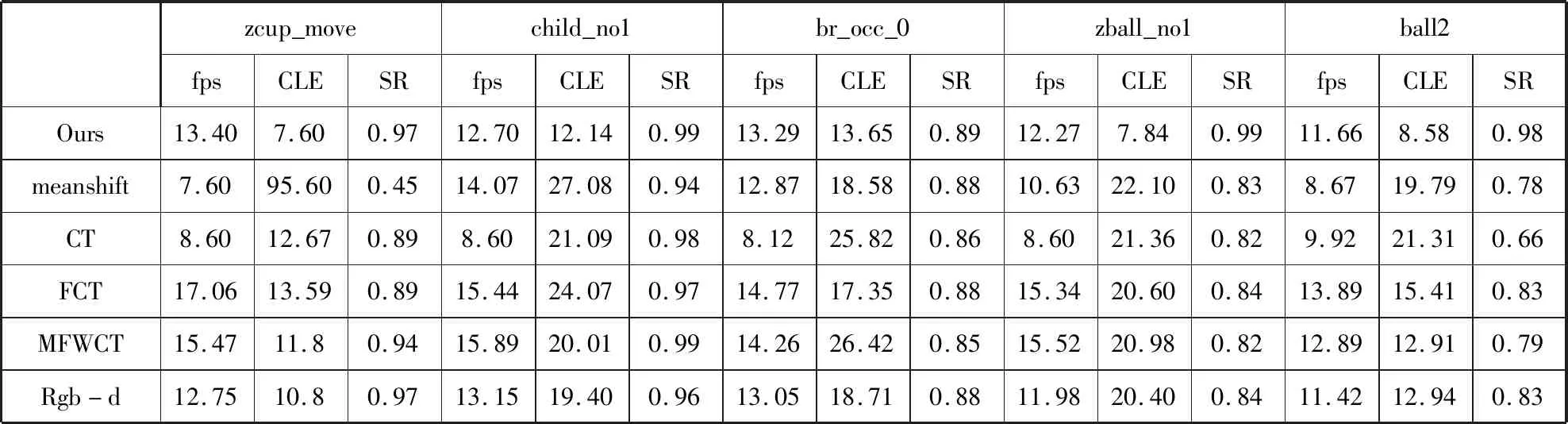

步3:在上一帧目标位置lt-1移动Δc、Δd个像素选定彩色图像块Drc={X|‖l(X)-lt-1‖ 步4:利用公式(11)和(12)建立分类器(H(v),H(u)),计算马氏距离得到H(V),定位到目标位置lt′. 步5:在上一帧目标位置lt′移动Δs、Δt个像素选定彩色图像块Drs={X|‖l(X)-lt′‖ 步6:利用公式(11)和(12)建立分类器(H(v),H(u)),计算马氏距离得到H(V),定位到目标位置lt. 步7:利用公式(6)和(7)更新分类器。 步8:输出:第t帧跟踪目标位置lt. 步9:若t≤T,重复步骤2;否则,结束。 为测试融合深度信息的视频目标压缩跟踪算法在视频序列中的性能和更好的评价算法,与四种流行的跟踪算法进行比较,其中包括均值漂移目标跟踪(Meanshift)算法[11]、CT算法、FCT算法、多特征加权外观模型的快速压缩跟踪(Fast compressive tracking based on multi-feature weighted appearance model ,MFWCT)算法[12]、和未使用马氏距离加权的融合深度信息目标跟踪(Rgb-d)算法。测试序列来自文献[13]中的视频序列。测试序列跟踪难点如表1所示。所有算法均是在配置为Intel(R)Xeon(R) CPU E3-1280 v3 3.60 GHz、32GB RAM的 64位操作系统计算机上的MATLAB R2014b平台中实现的。 本文算法的参数设置如下:算法实现中分别选取了45个正样本和50个负样本。正样本选择范围是半径为4个像素的圆形区域,负样本是远离正样本的内外半径为8和35个像素的环形区域。算法采用由粗略到精细的搜索策略,粗搜索时样本选择的区域半径为25个像素,步长为4个像素;细搜索时半径为10个像素,步长为1个像素。 表1 测试视频跟踪场景 序列跟踪场景zcup_move目标与背景相似、尺度变化child_no1光照变化、姿态变化、尺度变化br_occ_0遮挡、背景杂乱、外观形变、突然运动zball_no1旋转、光照变化、ball2突然运动、运动模糊、光照变化 视频目标跟踪算法性能要从算法速度、准确性和鲁棒性三个方面来度量。 3.2.1 算法速度 目标跟踪算法中,能否实现实时跟踪是算法好坏的指标之一。若算法运行时间较长,即造成目标跟踪准确率下降,甚至发生漂移和跟丢目标等不良效果。 表1 中fps表示不同算法最佳状态下的跟踪速度(帧/s).目标跟踪中,在保证跟踪精度情况下跟踪速度值越大越好。在不同测试序列下,meanshift算法跟踪速度平均值为11.15 帧/s,CT算法跟踪速度平均值为8.76 帧/s,FCT算法跟踪速度为15.29 帧/s,MFWCT算法跟踪速度平均值为14.80 帧/s,Rgb-d算法跟踪速度平均值为12.46 帧/s,本文算法跟踪速度平均值为12.66 帧/s,可以看出,算法运行速度居中,满足算法实时性的需求。 3.2.2 算法定性分析 在四个序列上测试了六种算法在遭遇背景相似、部分遮挡、姿态变化和光照变化等方面的跟踪结果,如图5~图9.跟踪结果图直观的表现出序列在不同算法下的跟踪结果。如图4所示,蓝色实线框、亮蓝色虚线框、绿色点线框、黑色点划线框、粉色实线框和黄色实线框分别表示meanshift算法、CT算法、FCT算法、MFWCT算法、Rgb-d算法和本文算法的实验结果。 图4 不同算法跟踪框表示 图5中跟踪目标是与背景颜色相似的杯子。基于颜色直方图建模的meanshift算法出现漂移现象。CT、FCT和MFWCT算法由于目标远离镜头但目标框大小不变时弱特征的引入使得总体表现不稳定。而融合深度信息的目标跟踪算法Rgb-d和本文算法由于引入深度信息,均得到较准确和鲁棒的效果。 图6中跟踪目标为灰色兔子,目标在12~62帧遭遇左侧兔子遮挡。由跟踪结果图直观看出本文算法在目标运动过程中表现鲁棒。 图5 不同算法对zcup_move 序列跟踪结果 图6 不同算法对br_occ_0序列跟踪结果 图7中目标为运动过程中产生姿态变化的小男孩。由跟踪结果图显示,51帧开始meanshift算法出现漂移现象。84帧后CT和FCT算法表现不稳定。本文算法在目标运动过程中表现良好。 图8 zball_no1序列中皮球遭遇光照影响,32帧后meanshift算法发生漂移,61帧后,CT、FCT、Rgb-d和MFWCT算法表现出不同程度的漂移。跟踪结果图显示本文算法较其他算法表现鲁棒。 图9中跟踪目标为室内光照变化下突然运动的皮球,60帧之前目标运动剧烈,meanshift、CT、FCT和MFWCT算法表现不稳定,本文算法通过多特征加权融合,外观模型表现鲁棒,算法性能较好。 图7 不同算法对child_no1序列跟踪结果 图8 不同算法对zball_no1序列跟踪结果 图9 不同算法对ball2序列跟踪结果 由各序列在不同算法下的跟踪结果图可以看出,本文算法在复杂环境下表现良好。MFWCT算法虽利用灰度特征和纹理特征的多特征融合表示目标外观,但总体表现与本文算法相比较弱。深度特征的加入使得算法不易受到光照影响,同时目标远离镜头时多特征融合算法表现稳定。未加入权值的融合深度信息的目标跟踪算法由于弱特征的等权值引入使得算法总体表现不稳定。加权弱分类器使得目标分类更加准确。实验结果表明本文算法的准确性高,鲁棒性好。 3.2.3 算法定量分析 对目标跟踪算法的定量分析可以更加准确和客观的反映跟踪算法性能。在跟踪算法的精确度评估中,本文采用中心位置误差和成功帧率两个指标进行评估。 (1)中心位置误差定义为公式(18)所示: (18) 其中(xT,yT)是跟踪算法得到的目标中心位置,(xG,yG)是人工标注的目标的准确位置。中心位置误差越小,代表算法的准确性越高;误差越大,代表算法的准确性越低。 表2中CLE表示各序列在不同算法下的中心位置误差值(/像素)。Meanshift算法平均中心位置误差值为36.63个像素,CT算法平均中心位置误差值为20.44个像素,FCT算法平均中心位置误差值为18.20个像素,MFWCT算法平均中心位置误差值为18.42个像素,Rgb-d算法平均中心位置误差为16.44,本文算法中心位置误差为最小值9.95个像素,在各算法中表现最优。 各序列在不同算法下跟踪结果的中心位置误差图如图10~图14所示。由图可以看出,本文算法的中心位置误差值最小,算法表现鲁棒。 图10 zcup_move序列中心位置误差图 图11 br_occ_0序列中心位置误差图 图12 child_no1序列中心位置误差图 图13 zball_no1序列中心位置误差图 图14 ball2序列中心位置误差图 (2)成功帧率同样可以测试目标跟踪系统的精度,成功帧率定义为公式(19): (19) 其中,ROIT是算法跟踪框面积,ROIG是目标真实位置跟踪框面积。本文设定,成功帧率大于0.5,即为跟踪成功,算法成功帧率越高,表示算法效果越好。由表1可见,在不同序列测试下, meanshift算法平均成功帧率为0.77,CT算法平均成功帧率为0.83,FCT算法平均成功帧率为0.87,MFWCT算法平均成功帧率为0.88,Rgb-d算法平均成功帧率为0.89,本文算法跟踪成功帧率平均值为最高值0.96,在各算法中表现优异。 表2 不同算法的跟踪速率、中心位置误差和跟踪成功帧率 zcup_movechild_no1br_occ_0zball_no1ball2fpsCLESRfpsCLESRfpsCLESRfpsCLESRfpsCLESROurs13.407.600.9712.7012.140.9913.2913.650.8912.277.840.9911.668.580.98meanshift7.6095.600.4514.0727.080.9412.8718.580.8810.6322.100.838.6719.790.78CT8.6012.670.898.6021.090.988.1225.820.868.6021.360.829.9221.310.66FCT17.0613.590.8915.4424.070.9714.7717.350.8815.3420.600.8413.8915.410.83MFWCT15.4711.80.9415.8920.010.9914.2626.420.8515.5220.980.8212.8912.910.79Rgb-d12.7510.80.9713.1519.400.9613.0518.710.8811.9820.400.8411.4212.940.83 提出了一种鲁棒的融合灰度特征和深度特征的视频目标压缩跟踪算法。通过特征融合,增强了目标的外观描述能力。利用融合后的特征构建加权朴素贝叶斯分类器,提高分类精度。算法利用压缩感知降低特征维度,提高算法速度。实验表明算法在实时性、准确性和鲁棒性等方面表现优异。3 结果分析

3.1 对比的跟踪算法和参数设置

Tab.1 The scenes of testing sequences

3.2 算法性能分析

Fig.4 Different tracking boxes

Fig.5 Different tracking results on zcup_move

Fig.6 Different tracking results on br_occ_0

Fig.7 Different tracking results on child_no1

Fig.8 Different tracking results on zball_no1

Fig.9 Different tracking results on ball 2

Fig.10 Center location error plots of zcup_move

Fig.11 Center location error plots of br_occ_0

Fig.12 Center location error plots of child_no1

Fig.13 Center location error plots of zball_no1

Fig.14 Center location error plots of ball2

Tab.2 Comparisons ondifferent algorithms in terms of speed, center location error and success rate

4 结束语