基于改进堆叠独立子空间分析模型的行为识别

2019-05-24郭晶晶刘欢欢

郭晶晶 刘欢欢

摘 要:视觉特征提取与特征表达方法在图像分类及识别中十分重要,从特征学习和特征表达角度出发,提出一种基于改进堆叠独立子空间分析模型提取特征的行为识别算法。首先采用两层独立子空间神经网络构建堆叠网络,在特征学习过程中融入正则化约束项,并结合时空卷积算法,获取视频时空层次化不变性特征基元;然后以堆叠卷积网络两层特征基元的非线性映射获取一种规则网格划分下的视频块状局部特征描述符;最后结合时空金字塔匹配模型构建时空层次特征,采用一对多支持向量机分类方法对视频中的动作进行分类。在KTH视频数据库中进行实验。结果表明,该算法学习到的特征基元可对视频构建低维高效的特征描述符,与现有多种行为识别算法进行对比,改进行为识别算法有效性进一步提高。

关键词:行为识别;堆叠独立子空间分析;时空卷积;正则化;时空金字塔

DOI:10. 11907/rjdk. 191103

中图分类号:TP317.4 文献标识码:A 文章编号:1672-7800(2019)005-0192-05

Abstract: Aimed at the importance of effective feature extraction and expression method of visual features in an image classification and recognition, a behavior recognition algorithm based on improved stacking independent subspace analysis Model to extract features is proposed. First of all, this algorithm adopts two layers of independent subspace neural networks to form stacked networks. The regularized constrained items are assimilated into in the process of learning features, and the spatio-temporal hierarchical invariant feature primitives of the video are obtained by combining with spatio-temporal convolution algorithm. Then, the video block local feature descriptors are obtained by the nonlinear mapping of the two layer feature primitives of the stacked convolutional network. Finally, the spatio-temporal hierarchical feature descriptors are constructed based on the spatio-temporal pyramid matching model and the actions in the video are classified by using a one to many support vector machine classification method. Experimental results on KTH video database show that the proposed algorithm can form the feature descriptor with low dimension and efficiency, and compared with a variety of existed algorithms, the proposed algorithm is proved to have better effectiveness.

Key Words: action recognition; stacked independent subspace analysis; spatio-temporal convolution; regularization; spatio-temporal pyramid matching

0 引言

人體行为识别指从输入视频提取描述行为特征的信息,通过机器学习理解特征信息,并依据学习到的特征对新的视频进行识别[1]。随着模式识别和机器学习的发展,包括稀疏编码、局部感受野、视觉信息层次式处理等新思想被引入特征提取研究中[2]。总体上,视觉特征研究经历了3个阶段:基本视觉特征提取阶段、视觉特征表达阶段、视觉特征学习阶段。其中,有效的特征表达可提升图像分类与识别性能[3]。特征学习相对于基本视觉特征提取而言,在方法上具有通用性,即针对不同形式的输入图像,可采用同样的网络进行特征提取,无需对问题储备较强的先验知识,可减少人工设计特征的复杂性。因此,特征表达与特征学习具有广泛的应用价值,成为重点研究方向。

经典特征表达方法有基于词汇包的词带(BOW)模型[4]。Lazebnik[5]在此基础上引入金字塔模型,提出空间金字塔匹配模型(Spatial Pyramid Matching,SPM)。常见的特征学习包括两种结构:单层网络结构的特征学习与深度学习的特征学习[6]。单层网络结构参数少,特征学习速度较快,且能够取得较好的效果,最典型代表为斯坦福大学Coates等[7]描述的一层单层网络学习框架,包括网络训练阶段和特征提取阶段。在训练阶段,通过单层网络从图像块学习一个特征映射矩阵,该映射矩阵即为学习核心部分,然后对新输入的图像按照一定规则通过特征映射矩阵映射成一个特征向量。独立成分分析[8](ICA)是一种可有效学习单层网络映射的结构。Hyvarinen等[9]在ICA基础上提出独立子空间分析(Independent Subspace Analysis, ISA),这是一种可以有效模拟人类视觉系统V1区简单细胞与复杂细胞感受野响应模式的层次化结构模型。

本文从特征学习和特征表达的角度出发,构建一种堆叠独立子空间分析网络(stack Independent Subspace Analysis,SISA),该网络可直接作用于原始视频图像,并结合时空卷积算法提取局部抽象特征,在优化过程中引入正则化函数项,并采用时空金字塔匹配模型对视频图像进行分类,将其应用于高维度数据可获得较好的分类效果。

1 理论与方法

1.1 独立子空间分析

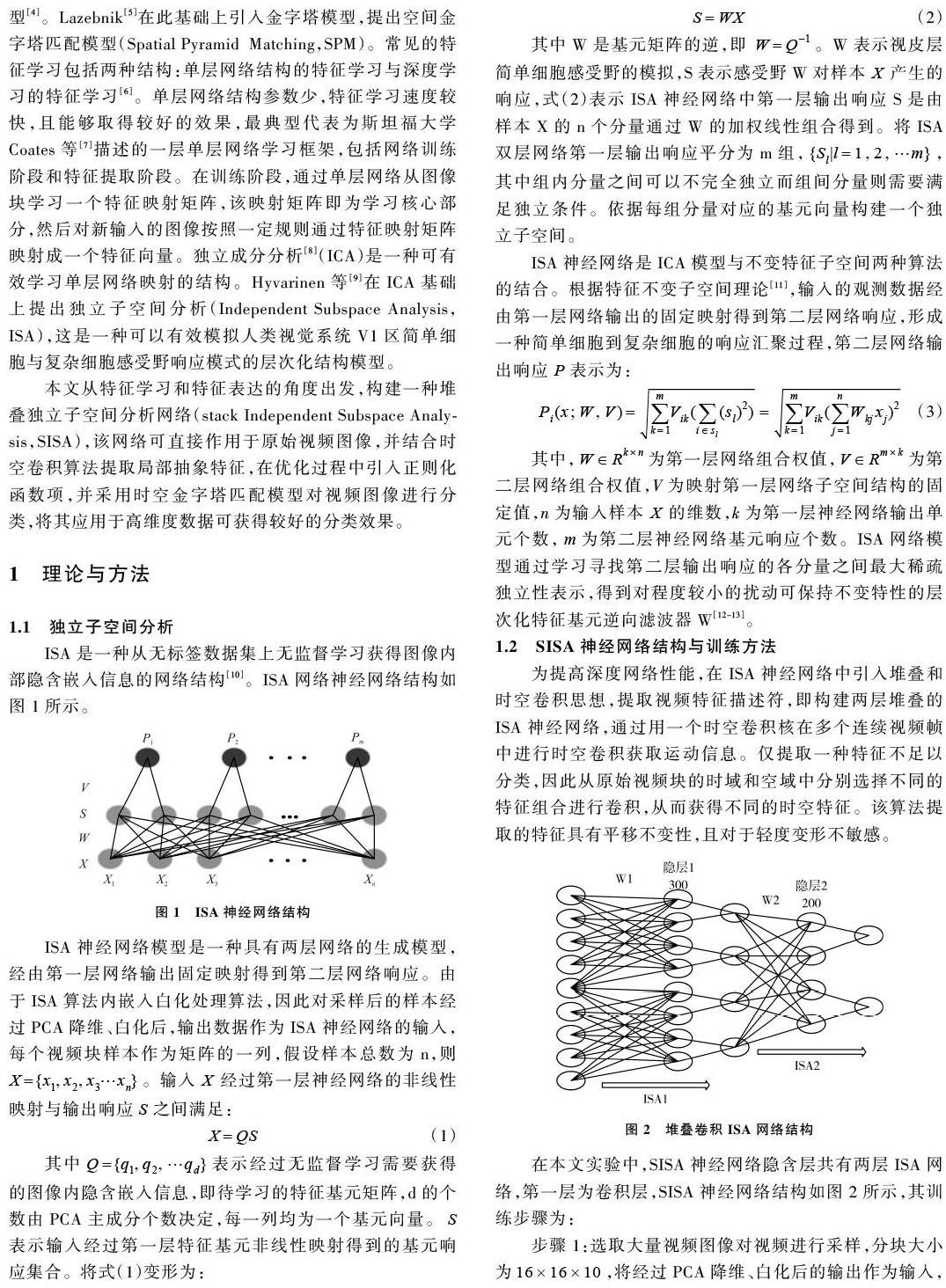

ISA是一种从无标签数据集上无监督学习获得图像内部隐含嵌入信息的网络结构[10]。ISA网络神经网络结构如图1所示。

1.2 SISA神经网络结构与训练方法

为提高深度网络性能,在ISA神经网络中引入堆叠和时空卷积思想,提取视频特征描述符,即构建两层堆叠的ISA神经网络,通过用一个时空卷积核在多个连续视频帧中进行时空卷积获取运动信息。仅提取一种特征不足以分类,因此从原始视频块的时域和空域中分别选择不同的特征组合进行卷积,从而获得不同的时空特征。该算法提取的特征具有平移不变性,且对于轻度变形不敏感。

在本文实验中,SISA神经网络隐含层共有两层ISA网络,第一层为卷积层,SISA神经网络结构如图2所示,其训练步骤为:

步骤1:选取大量视频图像对视频进行采样,分块大小为[16×16×10],将经过PCA降维、白化后的输出作为输入,训练单层ISA神经网络获得特征基元。

步骤2:把步骤1得到的特征基元作为ISA1卷积神经网络卷积核,对原视频重新采样,分块大小为[20×20×14],将采样得到的视频块作为输入,通过不同组合的卷积映射得到对应输出响应。

步骤3:把步骤2得到的输入响应作为ISA2网络的输入,训练ISA2网络获得特征基元。

步骤 4:获取SISA的特征基元之后,把视频块以不同的输入组合分别带入式(3)中,计算ISA1基元响应P1,将P1再次带入式(3)中,计算 ISA2基元响应P2,把两层网络得到的基元响应经过PCA降维,作为视频块特征描述子,用于后续分类任务。

2 算法设计

2.1 正则化批量投影特征学习算法

在SISA神经网络基元特征训练过程中,一般情况下通过梯度下降的优化算法学习特征基元,由于视频数据特征量较大,在寻找目标函数极小值时,学习得到的特征基元大小不一,导致该优化算法泛化能力较差(对未知数据的预测能力降低)[14]。因此本文对目标函数增加一个L2正则项,防止数据在迭代过程中造成過拟合现象,使整个网络可学习到一个更好的权值矩阵,增强泛化能力。

按照金字塔划分方法对视频进行划分,得到不同的层,第一层有1个子部分,第二层仅从时间维度上划分,得到2个子部分,第三层、第四层分别从时间和空间维度上划分,各自得到4个子部分和8个子部分。图3中的金字塔为4层,对每个子部分在SISA神经网络中的特征描述符构造一个K维词频直方图,在金字塔级数为L的模型中,统计所有视频词汇在金字塔级别下所有子部分的直方图,最后结合所有子部分直方图生成特征向量维数为[D=(2L-1)K],该向量为输入视频的STPM表达。

提取训练样本在SISA神经网络局部特征描述符,通过K-means聚类的方法计算得到字典,对新输入的视频进行STPM表达,用于后续分类任务。该匹配模型可与支持向量机判决算法很好地结合,完成不同动作的分类。

3 仿真实验与结果分析

3.1 测试数据集

为验证本文算法的有效性,采用KTH视频数据库对本文模型进行仿真试验。KTH数据集共有600个视频片段,在4种不同场景下采集25个人的6种不同行为,每种行为重复若干次,图4给出了KTH视频库6类行为,分别为拳击(box)、拍手(clap)、挥手(wave)、慢跑(jog)、跑(run)、走(walk)。

3.2 特征学习与分析

本实验基于Matlab平台实现,如图5、图6为梯度下降特征学习算法和本文提出的正则化批量投影特征学习算法在KTH数据集上经过300次迭代之后学习出的权值(即大小为[300×2560]的矩阵[W]),选出权值的前12行,并将每行转换成图像块进行显示,这些图像块是将原始视频块的像素块映射到隐含层的一个节点。图中每个小块大小为[16×16]。将梯度下降(Gradient Descent)特征学习算法简写为GD特征学习算法[20],将基于正则化(Regularization)的优化学习算法简写为RGD优化学习算法。从图中看出,本文优化算法较原算法能够更好地学习出视频块局部、边缘及方向性特征。

比较两种特征学习算法在SISA神经网络下的识别效果,在特征表达阶段采用经典BOW模型构建词频直方图,并结合SVM分类器对视频进行分类。两种优化算法迭代次数均为300次,结果如表1所示。

由表1可知,在设置迭代次数相同的情况下对SISA网络进行训练,本文提出的优化算法高于梯度下降算法约两个百分点。总体上看,由于迭代次数影响,该算法没有达到很高的识别准确率要求。

3.3 测试结果分析

本文基于正则化批量投影特征学习算法训练SISA神经网络,获取训练视频特征描述符,采用经典BOW模型和本文设计的STPM,在不同字典数下对测试视频进行特征表达,比较平均准确率。两种特征表达算法均采用Average Pooling的方法构建视频词频直方图,结合SVM分类器对视频进行分类,统计不同字典维数上两种特征表达算法平均识别准确率,如图7所示。

图7的两条曲线分别表示STPM特征表达算法和经典BOW模型在不同字典数目下的识别准确率,从平均识别准确率随字典变化的情况看,两种算法随字典数目的增加识别率均有提高,本文算法在字典维数为3 000时效果最佳,平均识别率高于BOW模型特征表达算法最优效果。

为了更进一步说明本文算法对视频中行为识别的有效性,利用本文算法在KTH数据库进行仿真实验,将其结果和其它识别方法在KTH数据库的实验结果进行对比,如图8所示,分别列出Harris3D+HOG特征[22]、3DCNN[23]和本文算法在KTH数据库的6种动作识别率,本文算法对拳击、挥手、跑3个动作的识别率明显高于其它两种算法,拍手、走两个动作识别率略低或持平于其它两种算法,由此说明本文方法能够准确把握视频中动作基本成份,给出有效的场景编码表达。

表2展示了本文算法和现有行为识别算法在KTH数据集上的平均识别率。由于文献[21]在特征学习过程中,对特征基元没有约束性限制,使得代过程中泛化能力较差,降低了分类准确率。文献[21]在对视频进行表达时,针对一个整体视频进行量化,而本文算法对视频进行金字塔划分,然后对划分的金字塔子区域进行量化,因此总体上较原算法提高了最终分类效果。从表2可以看出本文算法在识别精度上超越了部分现有算法,说明本文算法在动作识别方面的有效性。

4 结语

本文结合SISA网络和时空卷积,并在特征学习中引入正则化约束项学习层次结构化的特征基元,该算法在保证稀疏特征学习的同时对基元矩阵进行约束,增强了算法泛化能力;然后以层次特征基元的非线性映射获取局部特征描述符,解决了特征自动选择和高层特征提取的难题,构造了低维高效的特征描述子;最后在特征表达阶段,采用平均池的时空金字塔匹配模型对视频进行多尺度划分提高分类效果。

本文网络模型可自动化和层次化提取、选择特征,高层次不同类别之间共享低层次特征,使高层次特征比低层次特征具有更高的全局性与不变性。如何实现合理的网络框架、高效的特征学习算法和有效的特征表达算法是下一步研究重点。

参考文献:

[1] 朱煜,赵江坤,王逸宁,等. 基于深度学习的人体行为识别算法综述[J]. 自动化学报,2016, 42(6):848-857.

[2] 张盛博,刘娜,霍宏,等. 基于层次形状特征提取模型的图像分类[J]. 高技术通讯,2016,26(1):81-88.

[3] 李钦,游雄,李科,等. 图像深度层次特征提取算法[J]. 模式识别与人工智能,2017,30(2):127-136.

[4] LI F F, PERONA P. A Bayesian hierarchical model for learning natural scene categories[C]. Proceedings of the IEEE Computer Society, 2005:524-531.

[5] LAZEBNIK S, SCHMID C, PONCE J. Beyond bags of features: spatial pyramid matching for recognizing natural scene categories[J]. IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2006, 2:2169-2178.

[6] 李寰宇,畢笃彦,杨源,等. 基于深度特征表达与学习的视觉跟踪算法研究[J]. 电子与信息学报, 2015, 37(9):2033-2039.

[7] COATES A, LEE H, NG A Y. An analysis of single-layer networks in unsupervised feature learning[C]. Proceedings of the Fourteenth International Conference on Artificial Intelligence and Statistics, 2011: 215-223.

[8] HYVARINEN A,OJA E. Independent component analysis:algorithms and applications.[J]. Neural Networks,2000,13(4-5):411-430.

[9] HYVARINEN A, HOYER P. Emergence of phase and shift invariant features by decomposition of natural images into independent feature subspaces[J]. Neural Computation, 2000, 12(7): 1705-1720.

[10] 钟忺,王灿,钟珞. 一种图像场景的独立子空间ISA分类方法[J]. 小型微型计算机系统, 2018, 39(7):205-210.

[11] 仿射不变子空间特征及其在图像匹配中的应用[J]. 红外与激光工程, 2014, 43(2):659-664.

[12] LEE H, GROSSE R, RANGANATH R, et al. Convolutional deep belief networks for scalable unsupervised learning of hierarchical representations[C]. Proceedings of the 26th Annual International Conference on Machine Learning. 2009: 609-616.

[13] LE Q V,NGIAM J,CHEN Z, et al .Tiled convolution neural networks[C]. Workshop on Neural Information Processing Systems, 2010:1279-1287.

[14] RANZATO M,HUANG F J,BOUREAU Y L,et al. Unsupervised learning of invariant feature hierarchies with applications to object recognition[C]. Computer Vision and Pattern Recognition Conference,2007:1-8.

[15] 孙艳丰,张坤,胡永利. 基于深度视频的人体行为特征表示与识别[J]. 北京工业大学学报,2016, 42(7):1001-1008.

[16] 程海粟,李庆武,仇春春,等. 基于改进密集轨迹的人体行为识别算法[J]. 计算机工程,2016, 42(8):199-205.

[17] YANG J C,YU K,GONG Y, et al. Linear spatial pyramid matching using sparse coding for image classification[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2009: 1794-1801.

[18] WANG H,ULLAH M M,KLASER A, et al. Evaluation of local spatio-temporal features for action recognition[C]. London:British Machine Vision Conference, 2009.

[19] 赵晓丽,田丽华,李晨. 基于稀疏编码局部时空描述子的动作识别方法[J]. 计算机工程与应用, 2018(7):29-35.

[20] 王功鹏, 段萌,牛常勇. 基于卷积神经网络的随机梯度下降算法[J]. 计算机工程与设计, 2018, 39(2):441-445+462.

[21] LE Q V,ZOU W Y,et al. Learning hierarchical invariant spatial-temporal feature for action recognition with independent subspace analysis[C]. Computer Vision and Pattern Recognition,2011,42: 3361-3368.

[22] LAPTEV I,MARSZALEK M, SCHMID C,et al. Learning realistic human actions from movies[C]. Computer Vision and Pattern Recognition, 2008:1-8.

[23] JI S, YANG M, YU K. 3D convolution neural networks for human action recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(1):221-231.

[24] WANG J, CHEN Z Y, WU Y. Action recognition with multiscale spatio-temporal contexts[C]. IEEE Computer Society Conference on Computer Vision and Patter recognition.,2011,32(14): 3185-3192.

(責任编辑:江 艳)