某云数据中心空调系统架构及运行调优

2019-03-14冯瑞军

冯瑞军

某云数据中心空调系统架构及运行调优

冯瑞军

(北京世纪互联宽带数据中心有限公司 北京 100015)

概述了北京某大型云数据中心的基本情况和暖通空调系统架构,深入分析了系统形式、设备选型配置、节能技术措施等;通过系统研究及设计数据测算,评估能效水平。在运行管理阶段,理论分析结合运行经验对设计架构及运行模式进行了优化。实现了系统架构高稳定性并极大提高了能效指标,保障了云数据中心的稳定高效运行。最后利用一个整运营年度运行数据进一步验证了该项优化改造的合理性。

云数据中心;空调系统架构;管理策略优化;节能降耗

0 引言

近年来,由于AI、大数据、区块链、云计算等蓬勃发展,云数据中心处于高速发展阶段。随着中大型云数据中心的日益增多,作为重点用能单位,日益引起国家相关部门及社会高度关注,对已运营云数据中心进行节能改造,对新建云数据中心提出更高的能效指标及技术等级要求,成为行业及国家的政策鼓励方向。云数据中心的能耗主要包括:IT能耗、暖通系统能耗、配电系统能耗[1]。作为云数据中心核心基础设施的空调系统,其能耗在云数据中心总能耗中约占35%以上。在当前能源短缺,电力资源日益紧缺的大环境下,提高空调系统的能效势在必行。作为发展下一代绿色云数据中心的前提就是要在云数据中心全生命周期内对节能降耗贯彻执行。

规划设计和运行管理是云数据中心全生命周期中最重要的两个环节。规划设计的水平直接影响着云数据中心的架构和能耗水平,运行管理的能力关系到设计目标的实现及进一步超越。如何保证云数据中心在高可用性的前提下,以最高效的方式不间断运行成为了暖通工程师的重大挑战。本文以北京某云数据中心暖通空调系统设计及采用的节能优化措施为例进行分析研究,并通过运行管理中的优化调整完善了设计缺陷,提高了能效水平。

1 暖通空调系统设计

1.1 项目概述

该云数据中心建筑面积约为24000m2,地址在北京朝阳区某科技园,共6层,包含IT机房、空调间、高低压配电室、UPS间、钢瓶间、冷冻站、ECC、办公区、接待大厅等功能区域。本文将该云数据中心5层(二期)作为研究对象进行分析,4个IT模块分别为501,502,503,504。其中501模块的面积为450m2,502模块的面积为515m2,503模块的面积为500m2,504模块的面积为576m2。中央空调处理设备、辅助设备及冷却塔等所在的冷冻站,位于大楼屋顶。云数据中心机房模块区域平面图如图1所示。

1.2 制冷空调系统设计

1.2.1 机房室内设计参数

根据设计规范GB50174规定,机房内设计温度为23±1℃,相对湿度为40%~80%。对于有冷热通道划分的,其冷通道温度为18~25℃,湿度为40%~80%,热通道温度为28~32℃,湿度为40%~80%[1]。

图1 云数据中心机房平面图

1.2.2 冷负荷和风量的计算

数据机房按照“整体国标A级(满足TIERⅢ),局部TIER IV”的标准设计,机房模块形式包括以下类型:

标准机房模块503和504,以标准机柜交付,单位面积功率为800W,模块503面积为500,模块504面积为576m2,布置于本次南侧;

高可用机房模块501,以白空间形式交付,单位面积功率2kW,机房使用面积为450m2,布置在本层北侧。

高可用机房模块502,以白空间形式交付,单位面积功率2.5kW,机房的使用面积为515m2,布置在本层北侧。

IT设备组成主要为内部计算设备及风扇,其中约5%电力被风扇消耗,其他电力都转换为热。在计算IT模块负荷时,将整模块耗电量作为制冷量基数,另外根据建筑面积和面积热指标估算得出建筑传热冷负荷(四个IT模块面积依次为450,515,500,576m2),最终得出4个IT模块的冷负荷依次为900,1287.5,400,461kW。在温湿度参数等已定的情况下,根据公式计算出冷气循环量。在此基础上,考虑冗余以保证补充由于泄露、老化、衰减等造成的损失。

1.2.3 暖通空调系统方案

云数据中心暖通空调系统架构及技术方案的确定原则:首先满足工艺参数要求、系统高可用性,其次采用先进技术措施,最大化的节约TCO,找到可用性、成本及扩展性的平衡点。

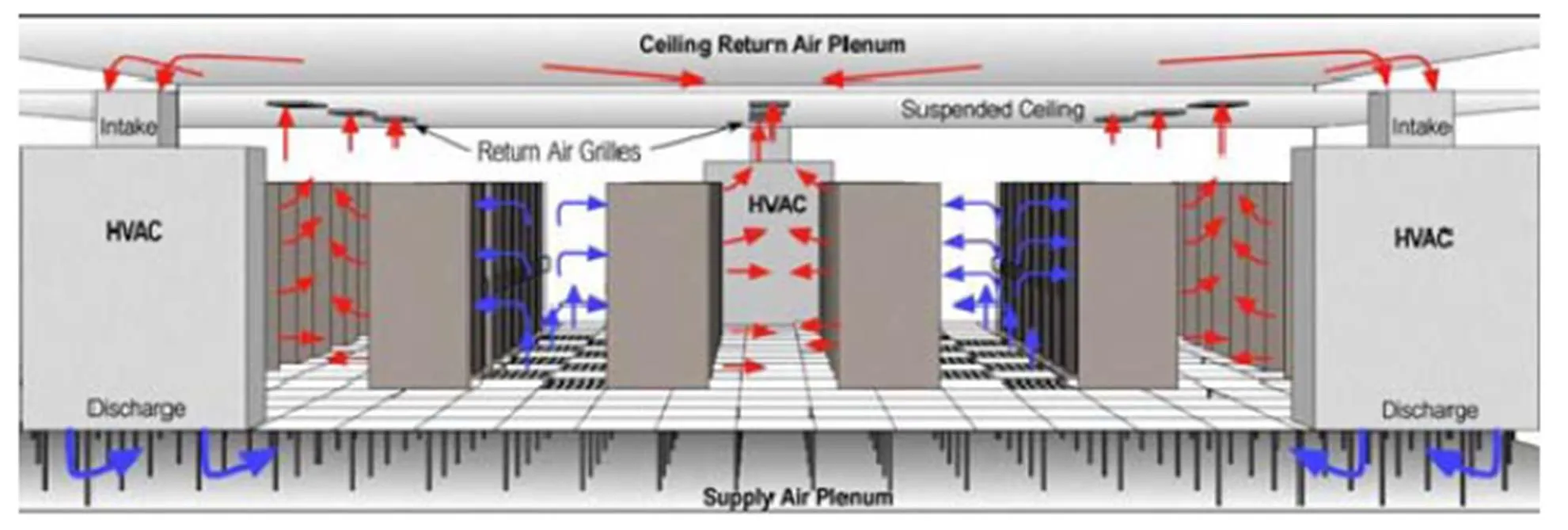

(1)气流优化及新风供冷

IT模块内采用封闭冷通道模式,热通道开放,IT机柜以面对面方式成列布置,冷通道上方设置钢化玻璃隔断,将冷、热通道完全隔离[2]。

精密空调送风到IT模块内防静电地板下,机房内防静电地板下形成静压腔。在封闭冷通道内,放置通风地板,静压腔内冷空气通过通风地板,送至每台服务器机柜。每块通风地板配有调节装置,可以人为或者自动调节每个风口的送风量,极限为开孔地板最大通风量。由服务器机柜排除的热空气,依靠精密空调的动力,从机房内上部空间回到精密空调回风口。经过精密空调处理后重新形成冷气输送到机房,完成循环过程。

室外新风经过风侧直接供冷机组处理后,通过连接的送风管道输送到末端,然后进入精密空调。不同室外条件下,BMS系统自控判断模式,并与冷水自控系统等联动,可以实现补充新风用途,更可利用室外自然冷源满足低温季节时室内供冷需求。机房气流分布如图2所示。

图2 机房气流组织图示

(2)设备配置

IT机房制冷采用精密空调机组,安装于IT机房模块对应的精密空调室。空调设备均为定制化产品,具备制冷及除湿功能,室内加湿功能由专门配置的湿膜加湿机承担。标准IT模块(503模块、504模块),选用水冷型精密空调机组,根据设计温度进行定制化关键部件(主要是换热盘管),每个IT模块采用4+1冗余配置。高可用性的IT机房模块(501模块、502模块),末端制冷选择水冷型精密空调机组,根据冷冻水设计温度进行定制化关键部件(主要是换热盘管),每个IT机房模块采用4+2冗余配置,每个模块设置两台风冷机房专用空调机房作为独立备份[2]。

设置针对云数据中心的风侧直接供冷系统,设计最大承担云数据中心30%的制冷负载。在空调间内设置进风管道和排风管道,并在云数据中心建筑楼顶配备空气处理机组进行新风引入及处理,空气处理机组自带变频控制系统及其他功能段。在室外温度低于室内设计温度时,通过机组变频控制系统实现风侧直接供冷自动调节[2]。

云数据中心的冷源采用螺杆式冷水机组提供冷冻水,设计参数供回水温度10℃/16℃,其他辅助用房采用风冷氟制冷空调。冷冻水系统主要服务2个常规密度模块和1 个中密度高可用性模块及1个高密度高可用模块;氟制冷系统主要服务配电室、UPS室及电池间等辅助功能区。

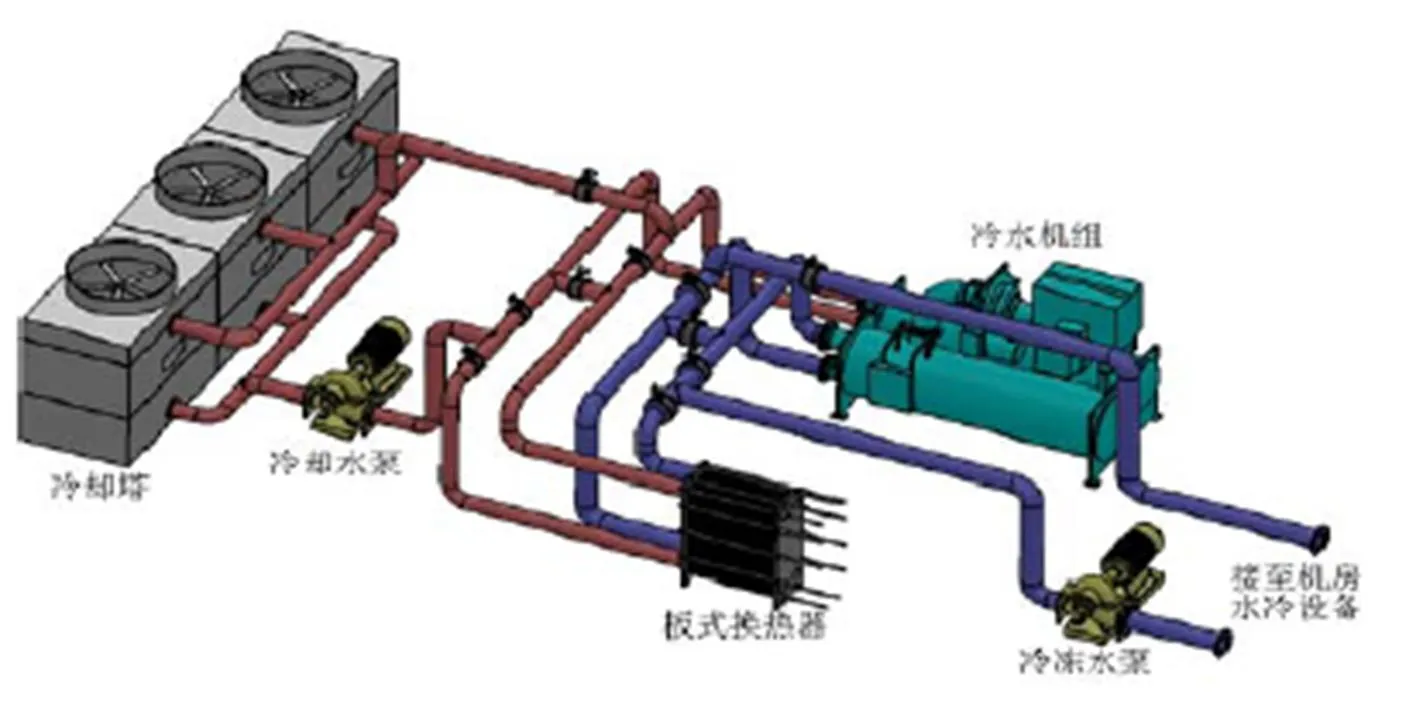

云数据中心机房区冷负荷估算值约为3000kW,考虑冗余系数,总冷负荷为3300kW。依据设计手册及厂家产品手册,选用水冷螺杆式冷水机组3台,单台制冷量为500USRT。按照冷水机组与冷冻水泵、冷却水泵、冷却塔一一对应,并能通过阀门进行切换,形成多种不同组合,另外冷却塔选用开式冷却塔,并将3套冷却塔供回水管路用管道进行连接,实现灵活配置及低温季节最大化供冷。对应每台冷水机组,配置一台1800kW的板式换热器,实现低温季节应用水侧自然冷却功能。为了保证高可用性,根据GB50174A级机房对空调系统冗余要求,设置2+1的冗余配置,并将冷冻水、冷却水管路设计为环形管路。基于此架构方案,可以实现分期部署,灵活配置,适应客户多样性需求。

(3)免费冷源冷却

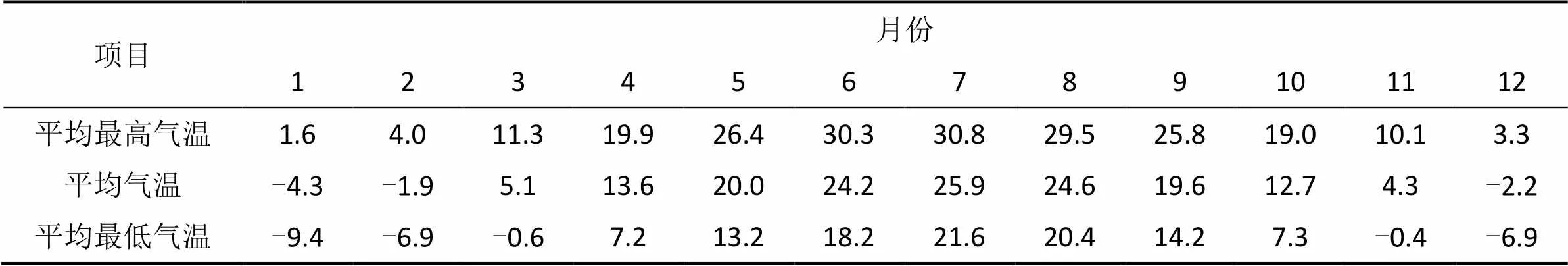

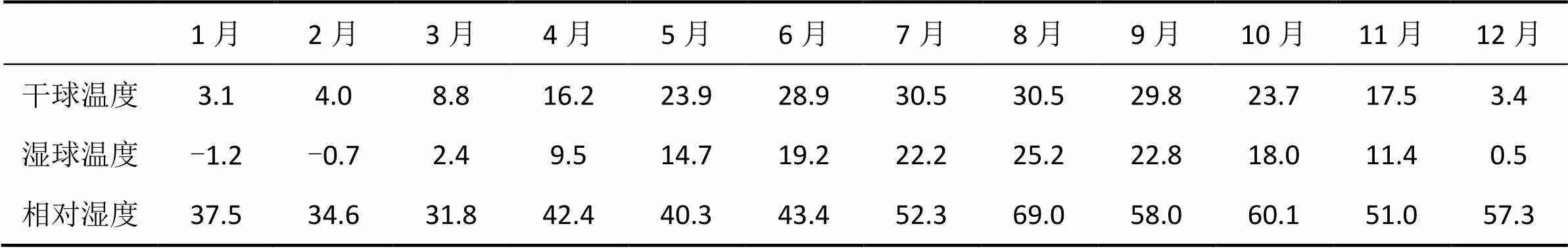

表1 北京市气象统计数据(月均)

注:气象站位置北纬39.8 ,东经116.5 ,海拔54m。

暖通空调系统的主要服务对象为IT设备,约占到90%以上。根据气象数据的判断,最大化利用自然冷源,减少高位电能的使用,是目前数据中心行业的主流节能思路,效果也是非常明显的。通过分析所在地区的历年气象数据,本项目采用开式冷却塔间接供冷的节能技术。设计在室外湿球温度低于10℃时,部分使用室外自然冷源,湿球温度低于4℃的时候开始全部使用自然冷源,完全依靠冷却塔直接供冷承担数据中心全部负荷。因项目实施地点位于北京,采用北京典型年气候条件及实测气温数据为设计依据[3]。

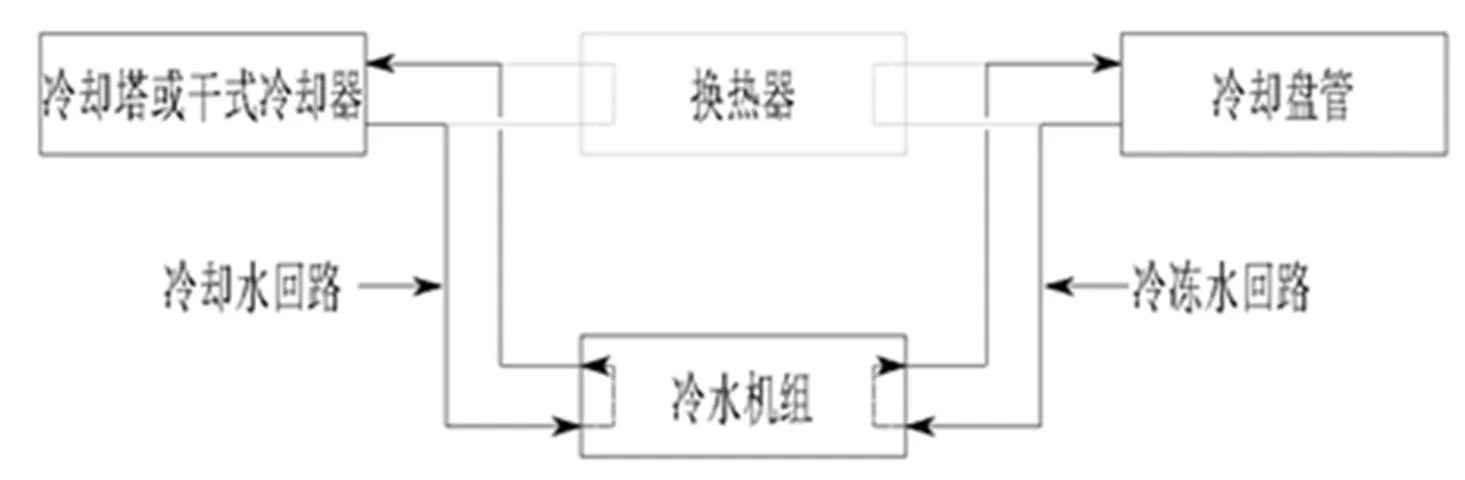

水侧自然冷却功能,通过增加一台水—水板式换热器实现,以前在工业领域应用较多,目前国内外多数的数据中心都已经采用该技术,架构原理如图3所示。

图3 冷却塔间接供冷原理图

上述带水侧自然冷却系统能实现以下三种工作模式:

夏天使用机械制冷,通过电动阀控制板式换热器不工作。

图4 冷水机组供冷模式示意图

冬天完全自然冷却,机械制冷关闭,通过电动阀切除冷冻机组,使用板式换热器工作。

图5 板式换热器(冷却塔供冷)供冷模式示意图

过度季节部分自然冷却。板式换热器和冷冻机组串联,室外低温冷却水先在板式换热器里与高温冷冻水换热一次,处理后的冷却水和冷冻水再进入冷冻机组。

图6 板式换热器(冷却塔供冷)与冷水机组联合供冷模式示意图

由于室外气温在不断的变化,上述三种工作方式也将根据气温变化,按照控制策略进行模式转化。系统管路上所有主要阀门采用电动阀(手动阀备份),所有采集仪表都为电子式,可自动采集并远程传送,通过冷水自控系统按照最佳运行策略自动运行。

(4)空调系统的控制

精密空调自带智能控制器,能够自动控制机组本身的所有功能,并通过通讯接口将信息远传给动力和环境监控系统。动力和环境监控系统可以显示精密空调的实时运行状态,可以人工远程启停、轮循等控制策略,也可以设定策略由系统自动控制单台/多台精密空调动作。高效冷水机组内置控制器对压缩机、冷凝器等进行控制以实现机组的正常运行,PLC控制系统对空调制冷系统进行统一的集中监测控制。动力和环境监控系统用于采集室外温湿度,空气质量数据,精密空调的运行数据,it模块环境温湿度,冷水自控系统运行数据,控制精密空调运行、空气处理系统运行。

2 云数据中心PUE

测量云数据中心的能耗指标,主要采用绿色网格组织提出的PUE(Power Usage Effectiveness)。PUE是总能耗与IT能耗的比值,已经成为国际上比较通行的数据中心电力使用效率的衡量指标[4]。本文所述项目IT供电容量为3500kW。若同等规模的IT容量,使用旧系统架构及技术手段,测算出的数据中心PUE超过1.7,这也基本反应了国内大多数数据中心的能耗水平现状。

基于本项目的基础数据,采用的先进架构设计,定量测算该云数据中心的能耗指标。

表2 本项目设计PUE测算表

注:假设条件:(1)高压计量表所含(不含办公用电);(2)冷冻水中央空调系统,使用自然冷却技术(本项目);(3)使用风冷空调系统,或无自然冷却技术(旧有架构);(4)关键设备为主流品牌型号;(5)机房满负载。

假设机房满载时,根据上述条件测算得出设计年均PUE为1.5,部分季节最佳PUE为1.35,远低于行业一般水平。

3 运行优化及能效收益

本云数据中心采用的主要节能措施有BMS智能监控系统、中央机房系统智能控制、水侧自然冷却技术(FREE COOLING)、风侧直接供冷系统、冷热通道隔离技术、一次泵变流量系统、冷却塔风机带变频器、带专利盘管的精密空调、EC风机、高温供冷技术等,并在运行阶段引入机器学习技术,探索对数据中心空调系统智能预测及控制的可行性。本文把风侧直接供冷系统和水侧自然冷却技术作为重点,进行节能优化效果分析和运行收益计算。

3.1 风侧直接供冷系统的节能优化

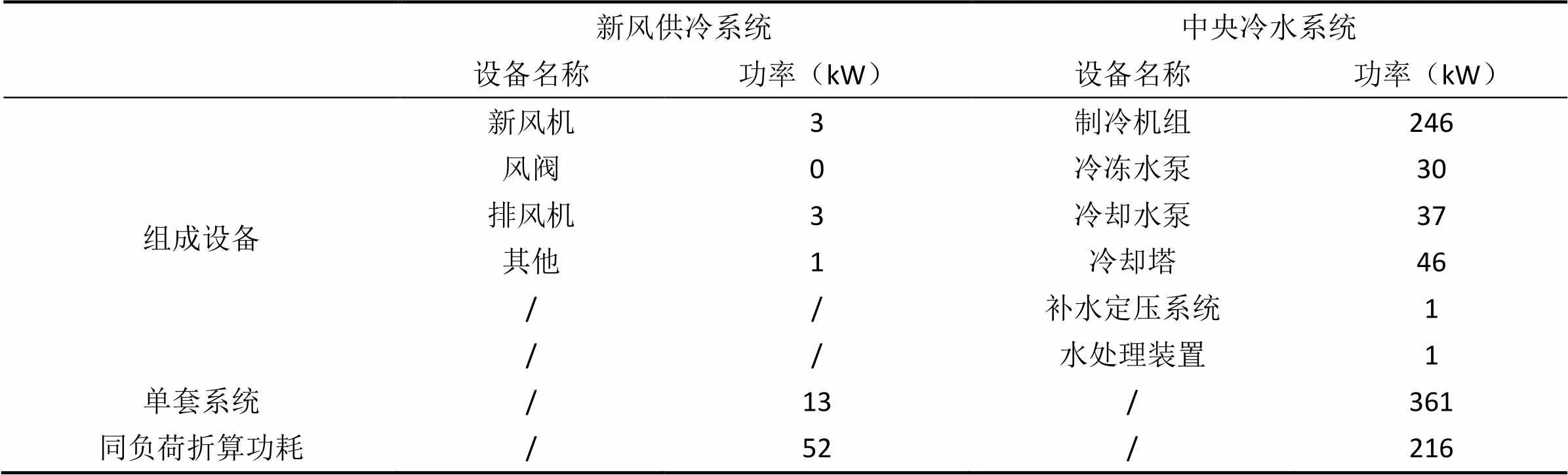

采用风侧直接供冷系统时,空调系统耗能设备仅仅是机房空调和空气处理机组。当室外的气象参数达到设计参数阈值时,数据中心空调的冷源可以采用室外的自然冷源。云数据中心将设置1套BMS系统作为中央控制系统控制云数据中心空调系统所有相关设备、仪器仪表。室外的气象参数值由风侧直接冷却处理机组上的传感器采集,中央控制系统逐时比对室内外空气参数,并根据比对结果,控制风侧直接冷却处理机组的关键功能部件动作并反馈运行参数。基于设备铭牌参数,分析对比风侧直接供冷系统和冷水机组系统的耗电量组成。采用风侧直接供冷系统承担部分供冷时,耗电量只包含了空气处理机组的用电量和剩余热负载的常规冷源耗电量;采用机械制冷时,耗电量包含2台1500kW冷水机组、2台冷冻水泵、2台冷却水泵、2套冷却塔。表2提供了两种系统同等供冷量情况下的功率对比。

表3 两种系统设备功率统计

从表中可以明显的看出,两种系统运行时的功率情况差距非常大,使用风侧直接供冷系统是是中央冷水系统供冷功耗的25%左右,节能效果非常显著。但是,由于北京地区空气质量问题,排除空气质量不达标天数,按照平均全年运行1个月估算,最大可节省电量为118080kWh。

3.2 水侧自然冷却系统节能优化

采用水侧自然冷却。尽量减少机械制冷的运行时间。按照原模式转换温度阈值,采用原有空调系统自控系统策略时,免费冷却模式运行时间达到120天,联合制冷冷却模式约运行60多天。机械制冷运行时间为185天。

表4 北京地区实测气温数据

当采用水冷自然冷却系统时,耗电量主要是减少了制冷主机的耗电量,其他耗电量包含了冷水泵、冷却水泵、冷却塔及其他辅助装置。对比常规全年冷水主机制冷模式,按照原设计模式采用自然冷却全年可以节省的能源约为1771200kWh。按照工业用电平均1元/kWh计算,可以节省多的电力成本为1771200元。相当于本云数据中心一个月的总电力成本,节能效果已经非常显著。

通过理论分析和实际测试,在保障末端温度稳定的前提下,将机房内温度标准调整为24℃,将冷冻水供回水温度由原来的10℃/16℃调整为15℃/21℃。同时,调整了控制系统的控制逻辑及其他关键参数。例如。精密空调启停逻辑,水泵、冷却塔变频逻辑等。完全自然冷却时间变为了6个月,部分自然冷却时间增加为3个月。全年同比可节省电费约254万。

3.3 冷水自控系统优化

(1)冷冻水供水温度按18或19℃,回水温度按24或25℃;必要时冷机优先数量、变频调节方式;

(2)根据负荷情况,必要时不同制冷单元采用不同制冷模式,适当调低预冷或制冷模式时水温,保证混合后水温18~19℃;

(3)低负荷时,采用蓄冷罐间歇性放冷(放60~70%),开启充冷模式;

(4)冷塔风机(双风机独立运行)、水泵极限调频按25Hz计算、EC风机按50%转速、冷机按15%负荷。

3.4 数据中心运行能耗分析及收益

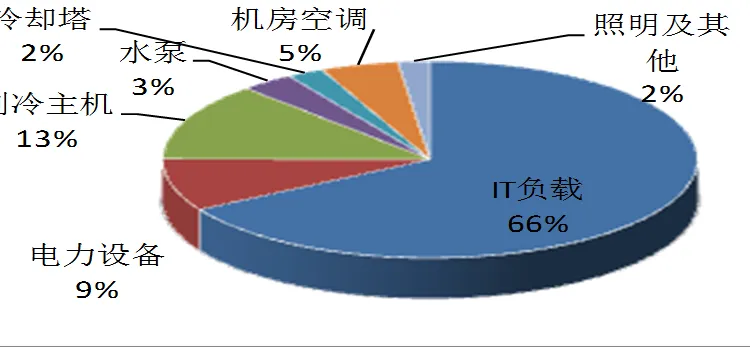

对云数据中心在未进行优化前的第一年度运行电量进行了分析,原始运行数据统计如表5所示,得出的分析结论见图7。

表5 本云数据中心某年度用电量统计表

该图给出了数据中心主要组成系统及设备的能耗占比,该云数据中心年均PUE为1.51,冬季自然冷却阶段平均PUE为1.36。主要的耗电设备是IT设备本身,所占比例为66%,23%的空调耗电量成为节能重点,通过对设计参数的优化,控制系统的优化,降低空调系统的能源消耗。

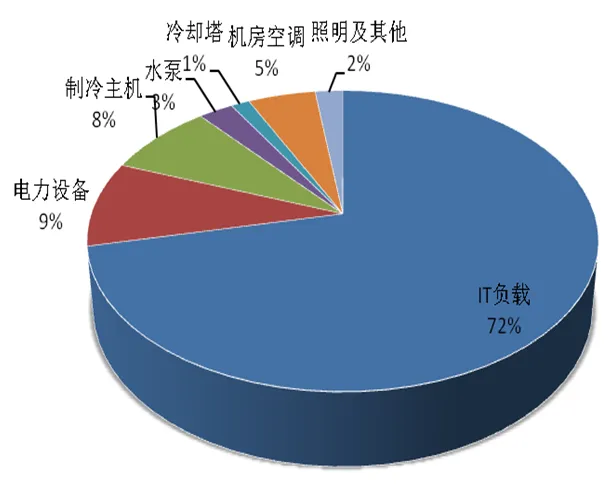

经过对空调系统运行策略及部分设备运行状态优化后,全年能耗统计见图8。下图给出了该云数据中心优化后的耗电量分布,其中该云数据中心本年平均PUE为1.35,主要的耗电设备是IT设备本身,所占比例为72%,使用节能措施后,空调能耗由原来的23%下降到17%。年电费支出可减少254万元,空调系统电费支出降为原来的七成左右。

图7 本云数据中心某年度能耗统计

图8 本云数据中心某年度能耗统计(节能优化后)

4 结论

本文介绍了云数据中心的暖通空调系统架构及关键技术,并从架构、气流优化、关键设备选用原则、绿色节能技术及能耗分析等方面进行了详细描述,并通过对空调系统的实际运行,优化管理策略,提升了该数据中心能效水平,节省了可观的运行费用。云数据中心具备高显热和不间断运行的特点,针对数据中心这样的应用场景,风侧直接供冷技术和水侧自然冷却技术的合理应用可以大幅度节约运行费用。此外数据中心空调系统设备及技术的更新换代,不同领域节能技术的应用,如高效率变频冷水机组、高效率的EC电动机、冷热通道设计以及智能的综合监控BMS系统,结合科学高效的运行管理策略,使得数据中心行业的整体能效水平逐步提升,能效优化又降低了云数据中心的运营成本,产生了极好的社会经济效益。

云数据中心包含多个专业领域,需要全生命周期的统筹考虑。针对于数据中心空调系统,既要设计架构先进合理,也要科学严谨的建设,更需要专业高效的运行管理。希望越来越多的新技术、新理念能够应用到云数据中心领域,推动云数据中心整体技术及管理水平,特别是空调系统的绿色节能事业的不断向前发展。

[1] GB 50174—2008,电子计算机机房设计规范[S].北京:中国计划出版社,2009.

[2] ANSI/TIA- 942- 2005 Section 5.11.2, Telecommunications infrastructure standard for data centers[S].2005.

[3] 龚伟力.某云数据中心空调系统设计分析[J].制冷空调与电力机械,2011,138(32):45-49.

[4] 钟景华,朱利伟,曹播,等.新一代绿色云数据中心的规划与设计[M].北京:电子工业出版社,2010.

[5] 周兰兰;潘毅群.某数据中心空调系统设计与节能优化分析[J].暖通空调,2009,(10):102-107.

[6] 赵荣义,范存养,薛殿华,等.空气调节[M].北京:中国建筑工业出版社,2000.

[7] 陈需霖,岳孝方.空气与制冷技术手册[M].上海:同济大学出版社,1999.

[8] 赖柏年,张剑麟,陈文,等.数据中心水冷空调末端的CFD模拟及应用分析[J].制冷与空调,2017,(6):565-575.

[9] 郭彦玲.某数据中心项目空调冷却塔方案选择[J].制冷与空调,201

HVAC System Architecture and Operation Optimization of a Cloud Data Center

Feng Ruijun

( Beijing Century Interconnection Broad Band Data Center Co, Ltd, Beijing, 100015 )

This paper introduces the basic situation of a large cloud data center in Beijing and the HVAC system architecture, and deeply analyzes the system form, equipment selection and configuration, energy-saving technical measures, etc.; In the operational management phase, theoretical analysis combined with operational experience to optimize the design architecture and operating mode. It achieves high stability of the system architecture and greatly improves energy efficiency indicators, ensuring stable and efficient operation of the cloud data center. Finally, the rationality of the optimization and transformation was further verified by using the operational data of the whole operation.

cloud data center; HVAC system architecture; management strategy optimization; energy saving

1671-6612(2019)01-049-7

TU831

A

冯瑞军(1986.04),男,硕士,工程师,E-mail:fengruijun421@163.com

2018-11-30