基于深度神经网络的图像碎片化信息问答算法

2018-12-20王一蕾卓一帆吴英杰陈铭钦

王一蕾 卓一帆 吴英杰 陈铭钦

(福州大学数学与计算机科学学院 福州 350108)

近年来,随着智能设备的飞速发展和大数据时代的到来,信息传播的媒介已经从过去的文字拓展到了图像、视频、音频等形式,与此同时,人们所能获取到的信息量呈爆炸式增长,信息的内容也逐步趋向分散,知识的体系越来越碎片化,以文本、图像、视频、网页等不同模态高度分散在多个数据源中.碎片化知识对人类社会的发展存在着两面性,一方面有助于人们快速了解相关领域知识的概貌;另一方面碎片化知识往往存在着片面性与非完整性,会对接受信息者的思考与判断产生一定影响,并且潜移默化地影响他们的知识体系结构.若能有效地将大量碎片化的知识去粗取精,提取出关键有效的信息,并构建出完备的知识体系结构,将有助于提升人们的学习效率.这已成为人工智能中知识密集型应用的新兴问题.

随着深度学习在各个领域取得不断的突破,如何利用计算机视觉和自然语言处理领域相关知识实现对不同模态的碎片化信息的融合与理解成为了一个重要的研究趋势.因此,近年来许多研究通过构建视觉问答系统(visual question answering, VQA),以实现对多模态碎片化信息的提取、表达和理解.视觉问答任务以一张图片和一个与图片相关的问题作为输入,以推理相应的答案作为输出.该任务针对给定图像的内容回答与图像相关的问题,不仅涉及更多的知识和推理技巧,还需要对人工智能不同领域的知识进行融合,因此成为当前人工智能领域一个十分热门的研究课题.

本文拟在现有关于视觉问答任务的前沿研究背景下,进一步研究结合变分推断方法与注意力机制的视觉问答算法并实现完整的视觉问答系统框架.重点深入研究视觉问答任务中,图像与问题的特征提取、多模态的特征融合和答案推理4个子流程的模型与算法,以期实现对图像和文本中碎片化信息的提取、表示,并提升视觉问答系统答案推理的准确率.

1 相关工作

近年来,国内外的众多研究人员对视觉问答进行了深入的研究,提出了基于神经网络的基础视觉问答模型[1-3].这类模型的基本思路是使用卷积神经网络(convolutional neural network, CNN)[4]提取图像特征,使用循环神经网络(recurrent neural network, RNN)[5]提取问题文本特征,并融合2种不同模态的特征用以推理产生答案.该模型的整体框架主要分为图像特征提取、问题文本特征提取、多模态特征融合等模块,并成为之后视觉问答研究的主流框架.

现有的视觉问答模型使用各种不同结构的卷积神经网络提取图像特征.早期的视觉问答模型采用预训练的VGGNet[6]提取图像特征.VGGNet是一个自底向上的19层CNN,该网络中不同隐层的神经元能够提取到图像中不同层次的特征信息,越深层次的网络能够提取到越丰富的图像特征.2016年文献[7]提出了使用ResNet提取图像特征,设计残差块结构并加入到卷积神经网络中,有效解决了随着神经网络层数增加所导致的梯度弥散问题,在视觉问答任务中取得了更高的准确率,因此成为当年视觉问答模型的基准方法.目标检测任务中的R-CNN[8]模型,将传统的单目标图像特征进一步扩展到多目标图像特征,为视觉问答任务的图像特征提取模型提供了新的思路.

针对问题文本特征的提取,早期的视觉问答模型主要利用词袋模型提取问题文本特征.词袋模型假定句子中每个单词相互独立,无法提取到问题文本的上下文关联信息.为解决该问题,现有的视觉问答模型主要采用循环神经网络RNN来提取包含上下文信息的问题文本特征.原始的RNN结构随着序列长度增长易导致梯度弥散,为了突破该局限性,RNN出现了许多变种模型,主要包括门控循环单元(gated recurrent unit, GRU)[9]和长短期记忆网络(long short-term memory, LSTM)[10].LSTM相比GRU网络参数更多,更适用于数据量较大的视觉问答任务,因此被广泛应用在目前的视觉问答模型中.RNN结构对于句子各个级别的语义信息缺乏较好的理解方式,文献[11]提出了Hierarchical Co-Attention模型使用了分层结构对语义信息进行提取,提升了文本不同层次信息之间的关联性.目前视觉问答任务中对于语义信息分析的研究较为缺乏,仍存在很大的研究空间.

视觉问答任务的关键流程是将提取到的图像与问题文本2种不同模态的特征,融合为包含图像与问题关联信息的特征.基础的视觉问答模型对图像与问题特征的融合只使用简单的拼接方法,这种方法得到的融合特征会丢失掉图像与问题的关联性.随着研究的深入,已有若干研究工作在视觉问答模型的多模态特征融合过程中引入注意力机制,使视觉问答模型的答案更关注与其相关性强的信息,从而避免被相关性弱的信息干扰.文献[11]提出了一种图像和问题协同注意的分层架构,该方法可以使图像特征和问题文本特征产生彼此的注意力权重,并利用该权重对相应的原始特征进行加权,有效提高了视觉问答准确率;文献[12]提出以问题为导向的空间注意力机制,该方法根据问题文本的特征为图像特征分配注意力权重;文献[13]提出了SAN模型,该模型通过不断迭代修正注意力权重,实现图像区域的注意力权重分配;文献[14]提出了基于多目标图像特征建立的注意力机制模型,这种注意力机制更具有针对性,因此该方法取得了显著的效果,为视觉问答模型中多模态特征融合提供了新的思路.

在答案推理流程中,现有的视觉问答模型[1-2]将数据集出现频率较高的答案提取出来构造答案集合,并在该集合上进行分类,将分类结果作为推理的答案.该方法可以简化视觉问答的模型结构,并确切地计算出视觉问答模型的准确率用于模型评估,因此成为目前答案推理的通用方法.

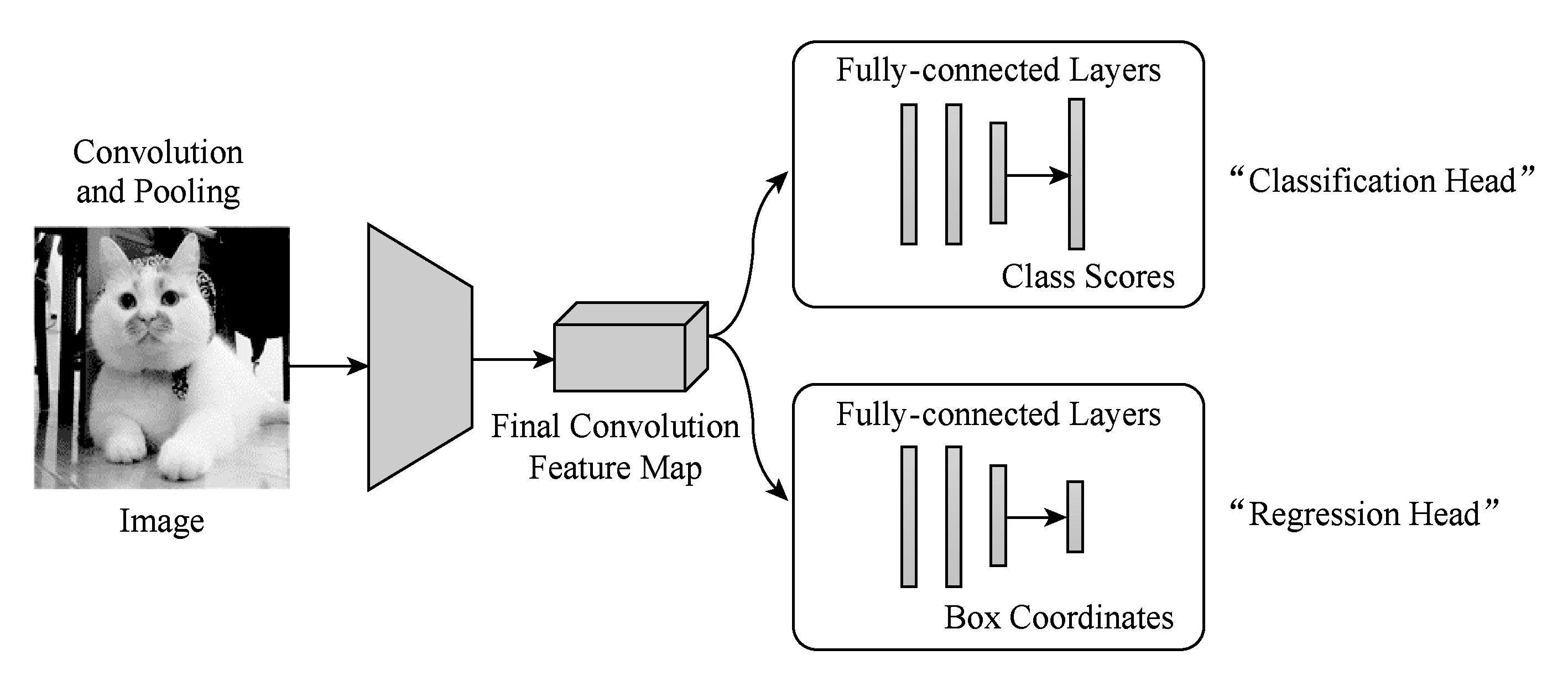

Fig. 2 Basic model structure for object detection tasks图2 目标检测任务基础模型结构

2 基础知识与模型

完整的视觉问答任务可分解为图像特征提取、问题文本特征提取、多模态特征融合和答案推理4个流程.本节将对用于提取图像和问题文本特征的卷积神经网络、循环神经网络,以及用于多模态特征融合和答案推理的注意力机制与变分推断方法的相关基础知识进行介绍.

2.1 卷积神经网络CNN

CNN概念由Lecun[4]提出,在图像处理方面得到了广泛的运用.CNN的特征提取器由卷积层与子采样层组成:卷积层包含了若干个维数较小的二维卷积核,每个卷积核在二维的特征平面上进行平移并通过卷积运算,将计算出的数值组合成新的特征平面并进行叠加组合,形成新的图像特征.对图像特征进行子采样,降低特征的维度.采样操作通常使用最大值子采样和均值子采样.

完整的卷积神经网络由多个特征提取器叠加而成,将最末端的特征提取器输出的特征平面通过全连接网络生成最终的图像特征.CNN有多种不同的网络结构,用于视觉问答任务的网络结构主要包含VGGNet,ResNet以及Faster-R-CNN.

2.1.1 VGGNet

VGGNet由多个卷积块与子采样层堆叠而成,每个卷积块中包含若干个卷积核尺寸为3×3的卷积层,每个卷积块的输出特征输入到尺寸为2×2的子采样层.设置不同卷积块与卷积层数量,得到不同深度的模型,用以提取不同层次的特征信息.

2.1.2 ResNet

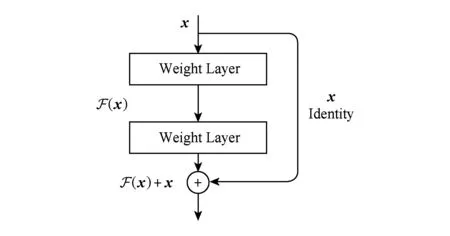

ResNet的基本思想是引入了带有“跳跃链接”的残差块,如图1所示.部分梯度在卷积神经网络中跳跃传递,将原始输入向量x直接累加到之后的权重层上,一定程度上避免了梯度弥散的问题.

Fig. 1 Residual block图1 残差块

2.1.3 Faster-R-CNN

计算机视觉中目标检测任务在对图像中的对象进行正确分类的基础上,还需要找出目标在图像中的位置.通过在传统图像分类的模型中加入回归器可有效解决该问题,总体模型结构如图2所示:

早期的目标检测方法使用穷举法选取目标对象的候选边框.2014年文献[8]提出了R-CNN模型,该模型使用选择性搜索极大降低了选取边框的数量;文献[15]提出的Fast-R-CNN模型在R-CNN模型基础上优化了特征提取结构,进一步提升了效率;文献[16]提出Faster-R-CNN模型,将选取候选框的过程合并到神经网络中,利用图像特征信息计算候选框信息,在目标检测领域中建立了完整的端到端训练的神经网络模型.

2.2 循环神经网络RNN

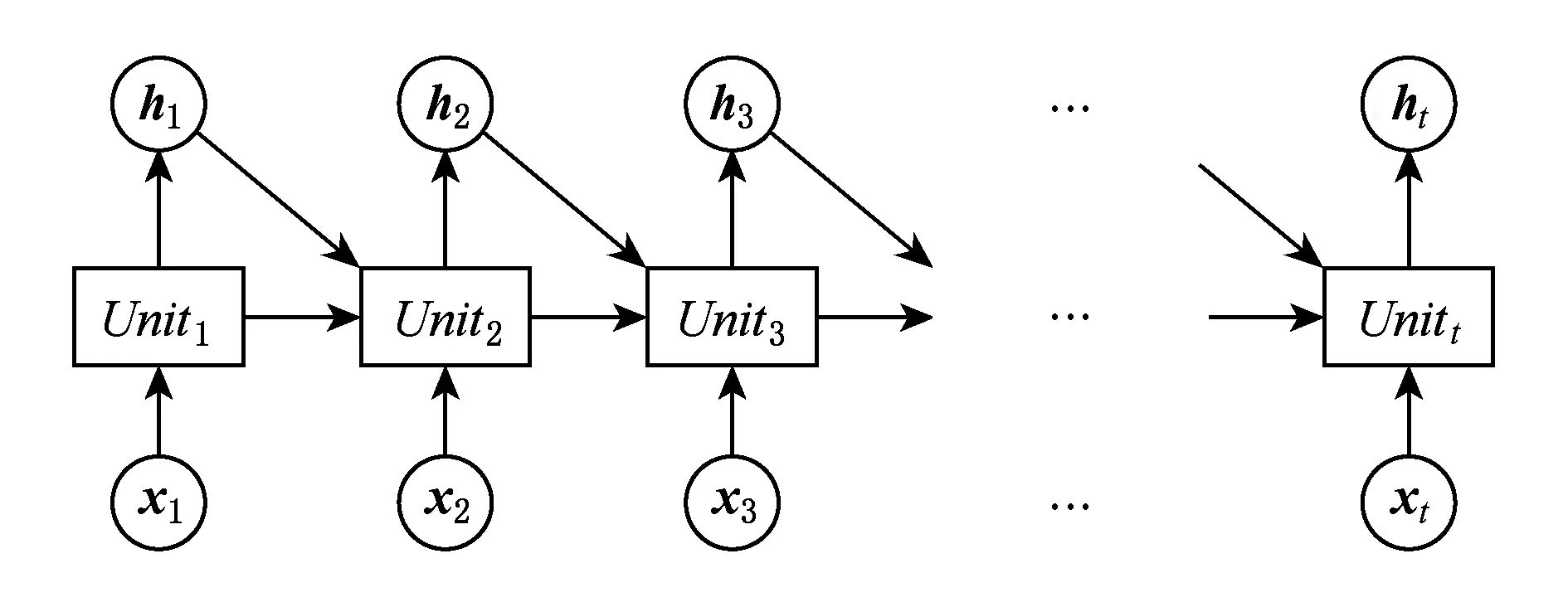

RNN将当前信息xi和前缀序列特征值hi-1输入到单元模块Uniti,计算出当前序列特征值hi,i的取值范围为1到t.因此每个单元模块输出的特征信息包含前缀所有位置的信息,RNN展开的模型结构如图3所示:

Fig. 3 Recurrent neural network图3 循环神经网络

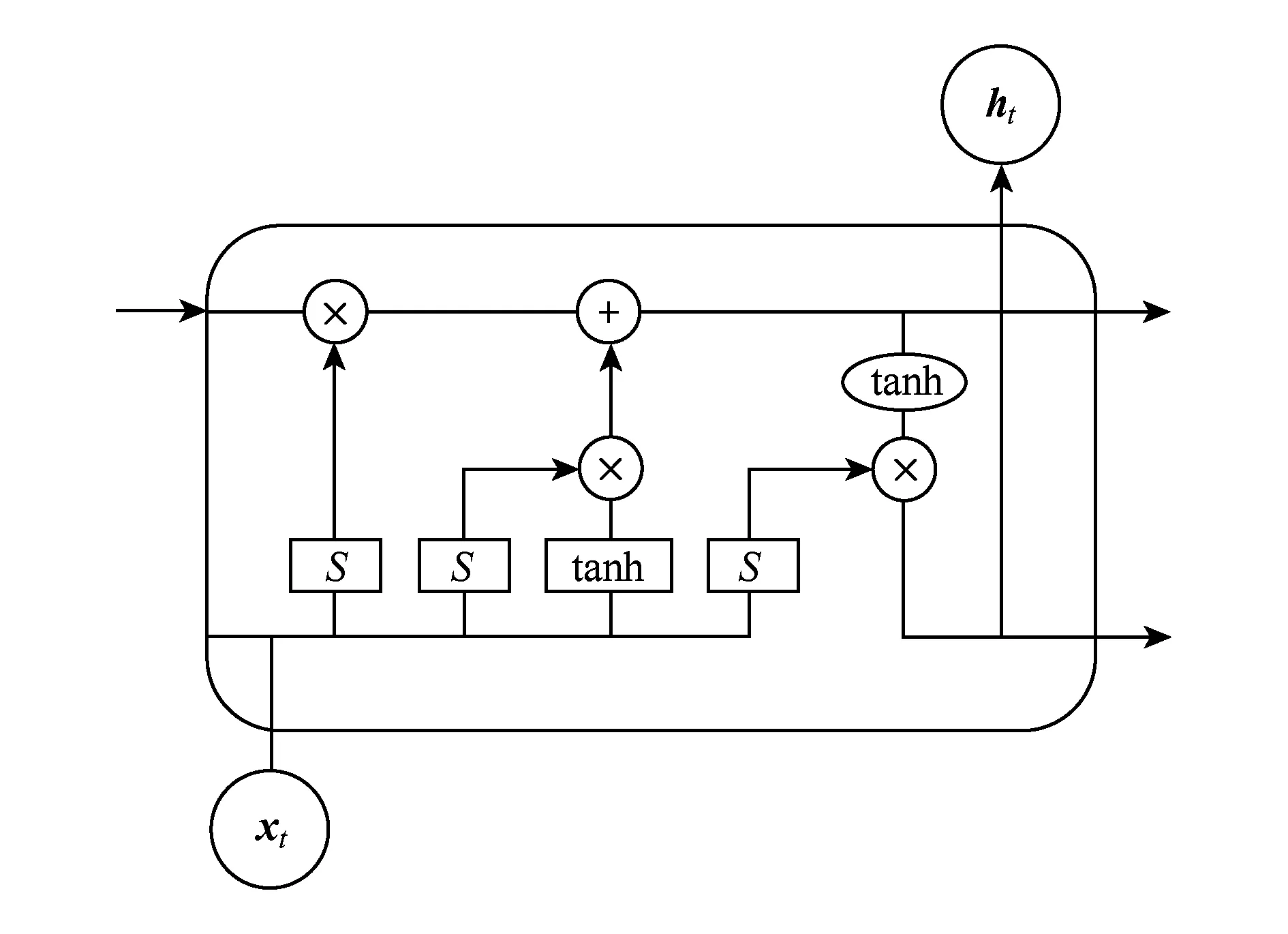

为解决传统RNN梯度弥散的问题,模型出现了许多变种,主要有门控循环单元(gated recurrent unit, GRU)[9]和长短期记忆网络LSTM[10].通过在循环神经网络单元中加入门控单元模块,以控制梯度的传播,一定程度上避免了梯度弥散的问题,图4展示了门控单元模块结构,S为sigmod激活函数,tanh为tanh激活函数,每个单元输入原始向量x,输出特征向量h.

Fig. 4 Gated unit module图4 门控单元模块

2.3 注意力机制

注意力机制是通过对每个时刻的特征进行加权,表示每个特征对当前时刻的重要程度,提取出更为关键的特征信息,从而提升模型效果.

注意力机制在机器翻译领域中主要通过自编码框架实现.输入特征向量x进行编码,用每一时刻编码结果和前一时刻解码结果计算注意力权重矩阵并进行特征加权,得到解码的特征向量y.具体的模型结构如图5所示:

Fig. 5 Attention mechanism on machine translation图5 机器翻译中的注意力机制

注意力机制在机器翻译中取得了显著的效果,成为该领域的基准方法之一.在视觉问答任务中,图像的多目标特征与问题文本特征均可转化为序列特征,因此该注意力机制同样适用于视觉问答任务.

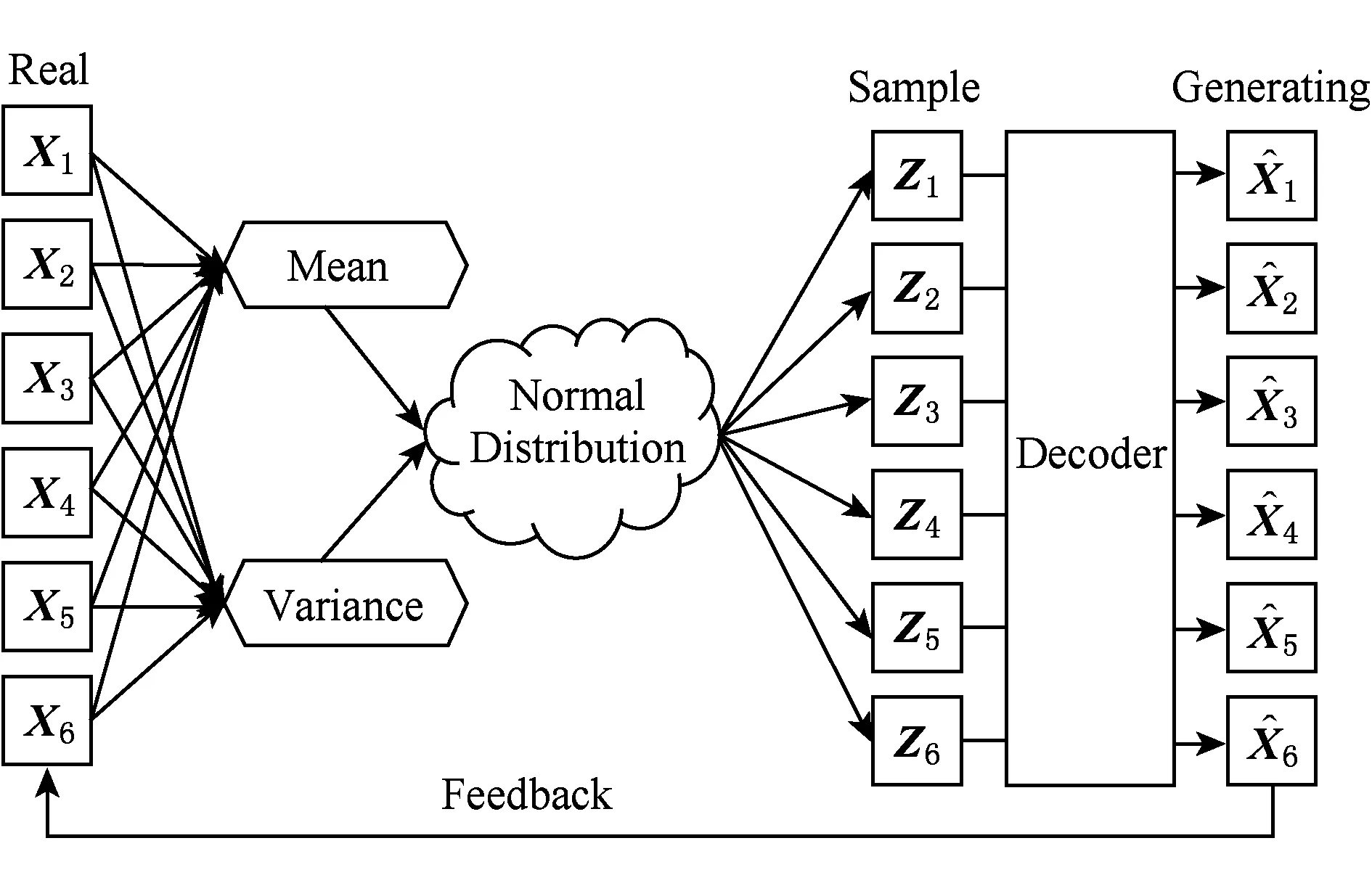

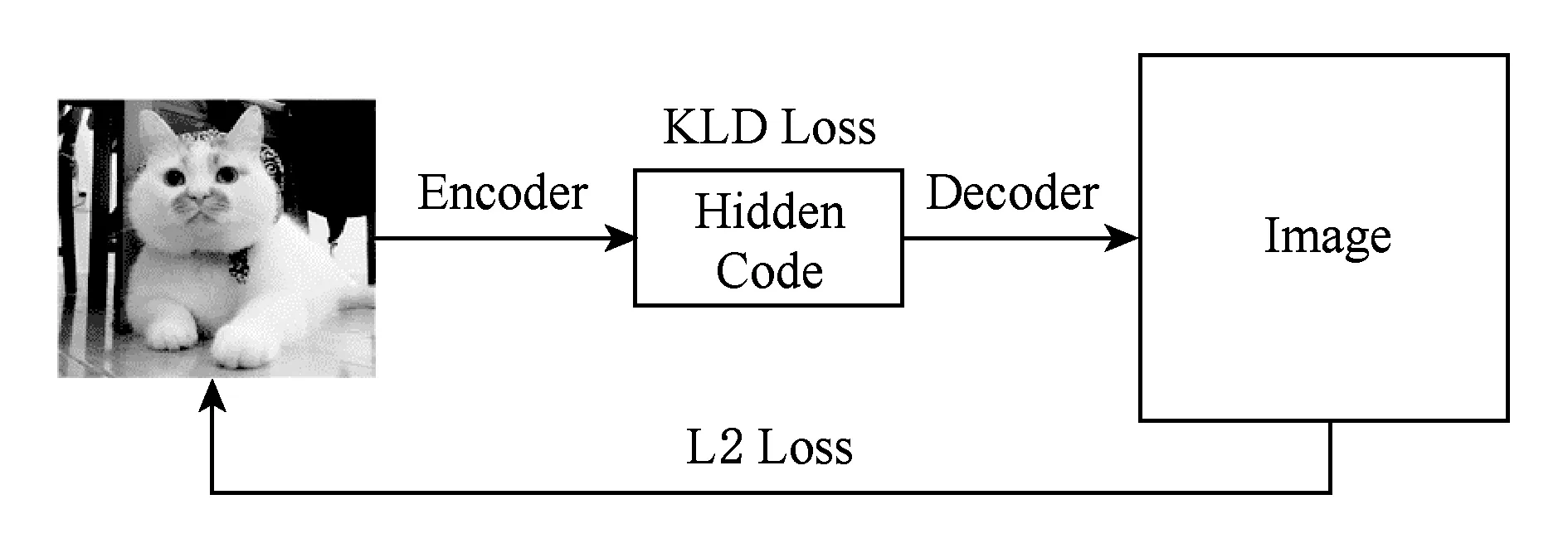

Fig. 6 Variational auto-encoder图6 变分自编码器

2.4 变分推断

假设z是符合概率分布p(z|x)的高维向量,带有高维随机变量z的概率分布积分难以计算.变分推断是一种求解近似概率分布的方法,它的核心思想是利用简单概率分布q(z)来近似表示复杂概率分布p(z|x).文献[17]提出变分自编码器 (variational auto-encoder, VAE),通过使用多层神经网络拟合高斯分布的均值与方差,用以表示近似复杂的后验概率分布.VAE模型能够表示数据分布的隐向量编码的概率分布,在该分布上进行采样即可得到隐向量编码,模型结构如图6所示:

3 基于深度神经网络的视觉问答模型

本文提出一种基于深度神经网络的视觉问答模型,模型包括基于LSTM的图像特征提取方法、基于RNN+CNN的问题文本特征提取方法、结合注意力机制与变分推断的多模态特征融合方法,以及使用分布距离作为神经网络损失值的答案推理方法.

3.1 基于LSTM的图像特征提取

本文所提出的图像特征提取方法流程如下:使用Faster-R-CNN提取多目标图像特征,并基于LSTM对多目标图像特征进行融合,同时设计权重调整调整方法平衡各个目标的特征权重.

3.1.1 Faster-R-CNN提取多目标图像特征

将图像输入到训练好的Faster-R-CNN模型,计算出k个用以表示目标位置的边框信息.根据每个边框位置得到k张局部图像,并利用CNN进行图像特征提取,最终得到k个的图像特征.

3.1.2 基于LSTM的多目标图像特征融合

图像中不同的目标之间存在关联信息,为了保留这些信息,将图像特征作为长度为k的序列(V1,V2,…,Vk),利用LSTM从该序列中提取多目标组合的图像特征.

3.1.3 权重调整

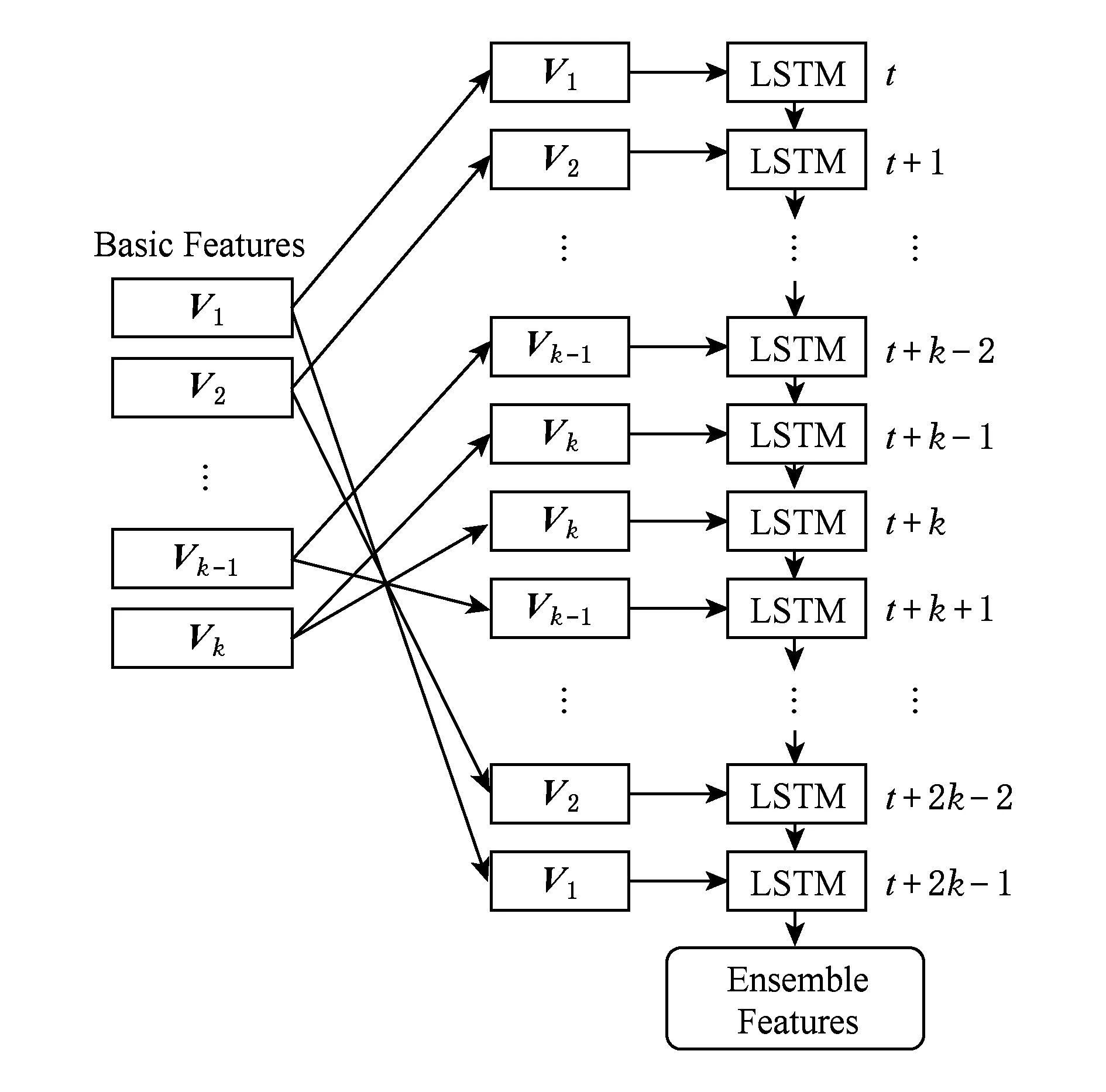

利用LSTM提取出的特征可以有效保留多目标特征之间的关联性,将每个目标特征当成LSTM单元输入,输入靠后的图像特征将会获得更大的权重,对输出结果产生更大的影响.而所有的目标特征应具有相同的权重,因此需要对模型中每个时刻输入的图像特征进行权重调整,使其能够均衡处理每个目标特征.本文使用拓展时序与BiLSTM两种方法:

1) 拓展时序

模型如图7所示,将图像特征序列(V1,V2,…,Vk),进行反转得到(Vk,Vk-1,…,V1),与原特征序列拼接得到新的图像特征序列(V1,V2,…,Vk-1,Vk,Vk-1,…,V2,V1),作为LSTM的输入.这种模型结构令每个目标的图像特征在序列首尾均出现一次,起到了均衡每个目标特征权重的效果.

Fig. 7 Weight adjustment by extended sequence图7 扩展时序调整权重

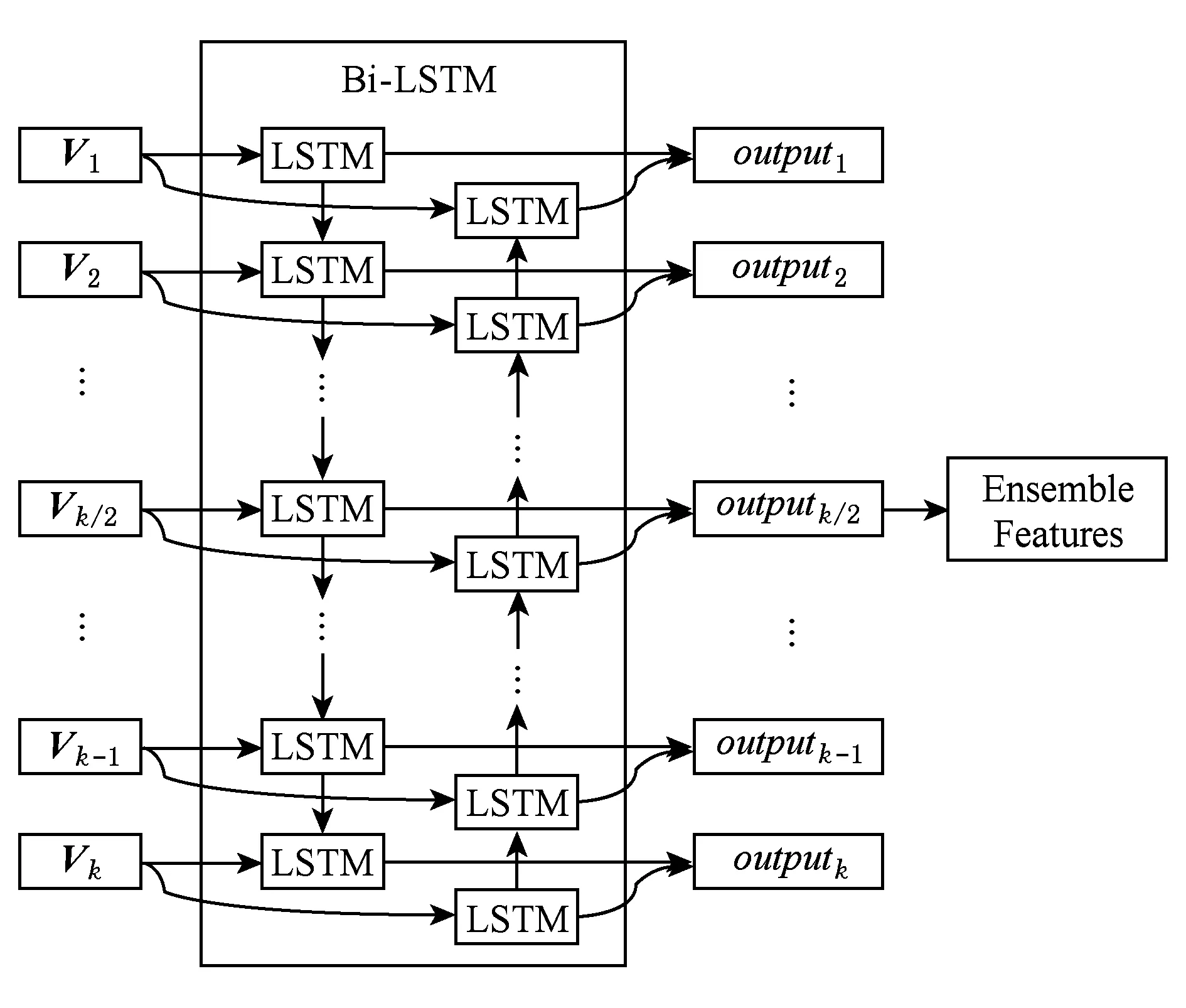

2) BiLSTM

BiLSTM是双向的LSTM模型,序列分别从两端输入到2个不同的LSTM中.将前向传递的输出与反向传递的输出进行拼接,作为当前时刻的输出.本文使用BiLSTM来进行多目标图像特征融合,使用k/2位置的LSTM单元输出作为融合的图像特征,整体的模型如图8所示.通过减少每个目标特征到达输出时刻的距离,起到均衡权重的效果.LSTM的单元输出为output,使用k/2位置的LSTM单元输出outputk/2作为融合的图像特征.

Fig. 8 Weight adjustment by BiLSTM图8 BiLSTM调整权重

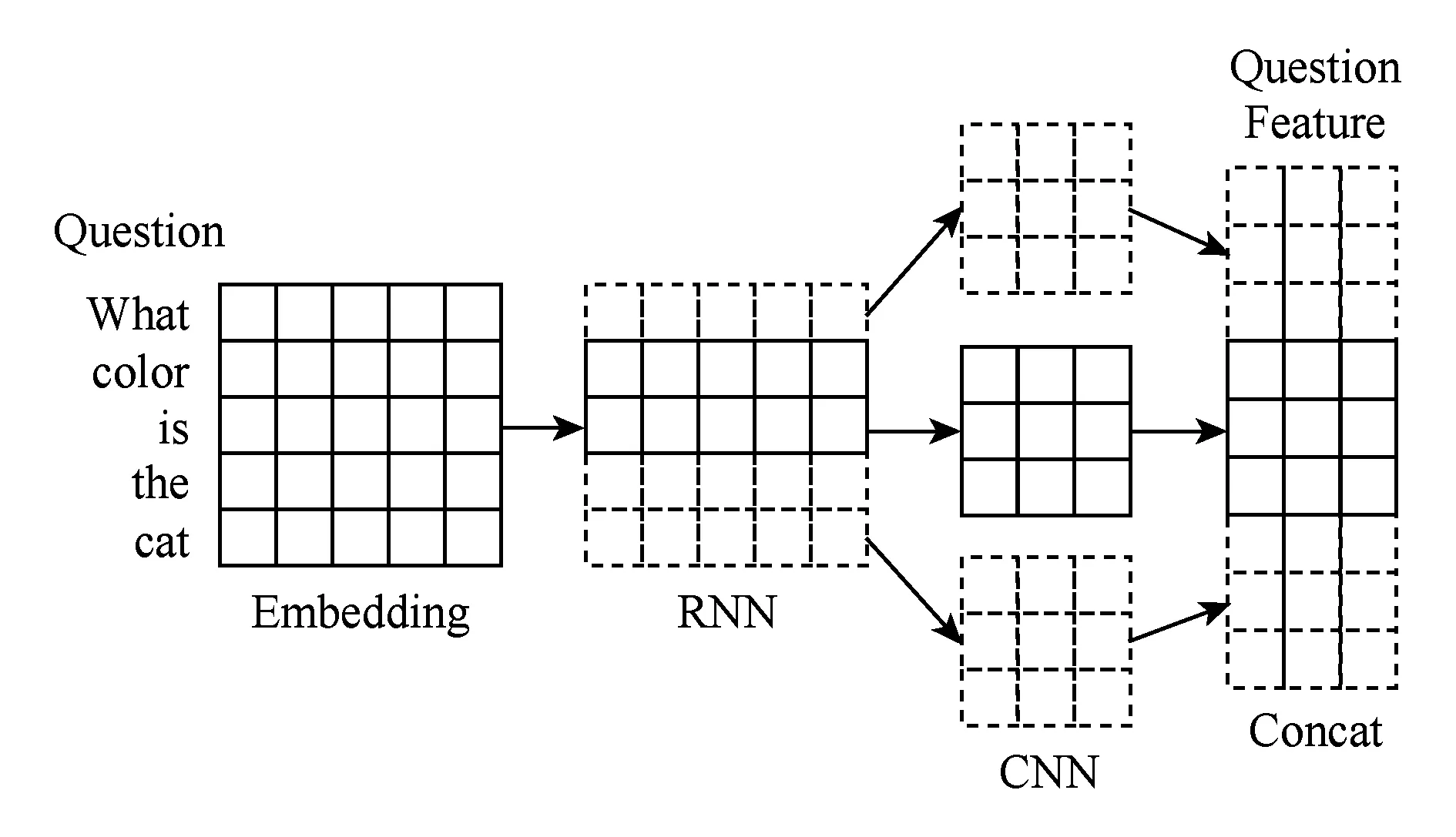

3.2 基于RNN+CNN的问题文本特征提取

本文所提出的问题文本特征提取方法流程如下:首先将问题的单词转换为词向量,并将词向量序列输出到RNN中提取初步的文本特征,最终使用CNN进行文本特征的组合.

3.2.1 提取词向量

问题是由多个单词组成的序列,使用word2vec[18]将问题单词序列转换为词向量序列,将该序列作为RNN的输入.

3.2.2 RNN提取初步文本特征

RNN的输入输出都是一个序列,把输入序列标记为(x1,x2,…,xt-1,xt,xt+1,…,xT),输出标记为(o1,o2,…,ot-1,ot,ot+1,…,oT),RNN中的隐层状态集合标记为(s1,s2,…,st-1,st,st+1,…,sT),其中xt表示时刻t的输入,ot表示时刻t的输出,st表示时刻t的隐层状态,T为序列的最大时间索引.

st=f(Uxt+Wst-1),

(1)

ot=softmax(Vst).

(2)

如式(1)所示,在时刻t隐层节点的输入包括输入层的xt和时刻t-1的隐藏层状态值st-1,U为输入层和隐层之间连接的参数矩阵,W为隐层单元之间连接的参数矩阵.如式(2)所示,时刻t的输出ot与st和V有关,其中V为隐层与输出层之间连接的参数矩阵.通过编码可得到(o1,o2,…,ot-1,ot,ot+1,…,oT)作为初始文本特征,其中softmax函数为非线性激活函数,计算为

(3)

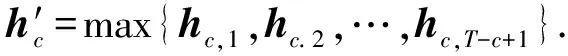

3.2.3 CNN组合文本特征

利用3个CNN对初始文本特征进一步提取,其中时刻t大小为c的卷积核的输出为

hc,t=tanh(WcOt:t+c-1+bc).

(4)

窗口大小为c的卷积核的所有时刻输出为

hc=(hc,1,hc.2,…,hc,T-c+1).

(5)

将最大池化应用于的时间维度上输出为

(6)

将不同窗口大小的CNN输出进行拼接得到最终的问题文本特征:

(7)

整体流程如图9所示.

Fig. 9 Problem text feature extracting process图9 问题文本特征提取流程

3.3 多模态特征融合

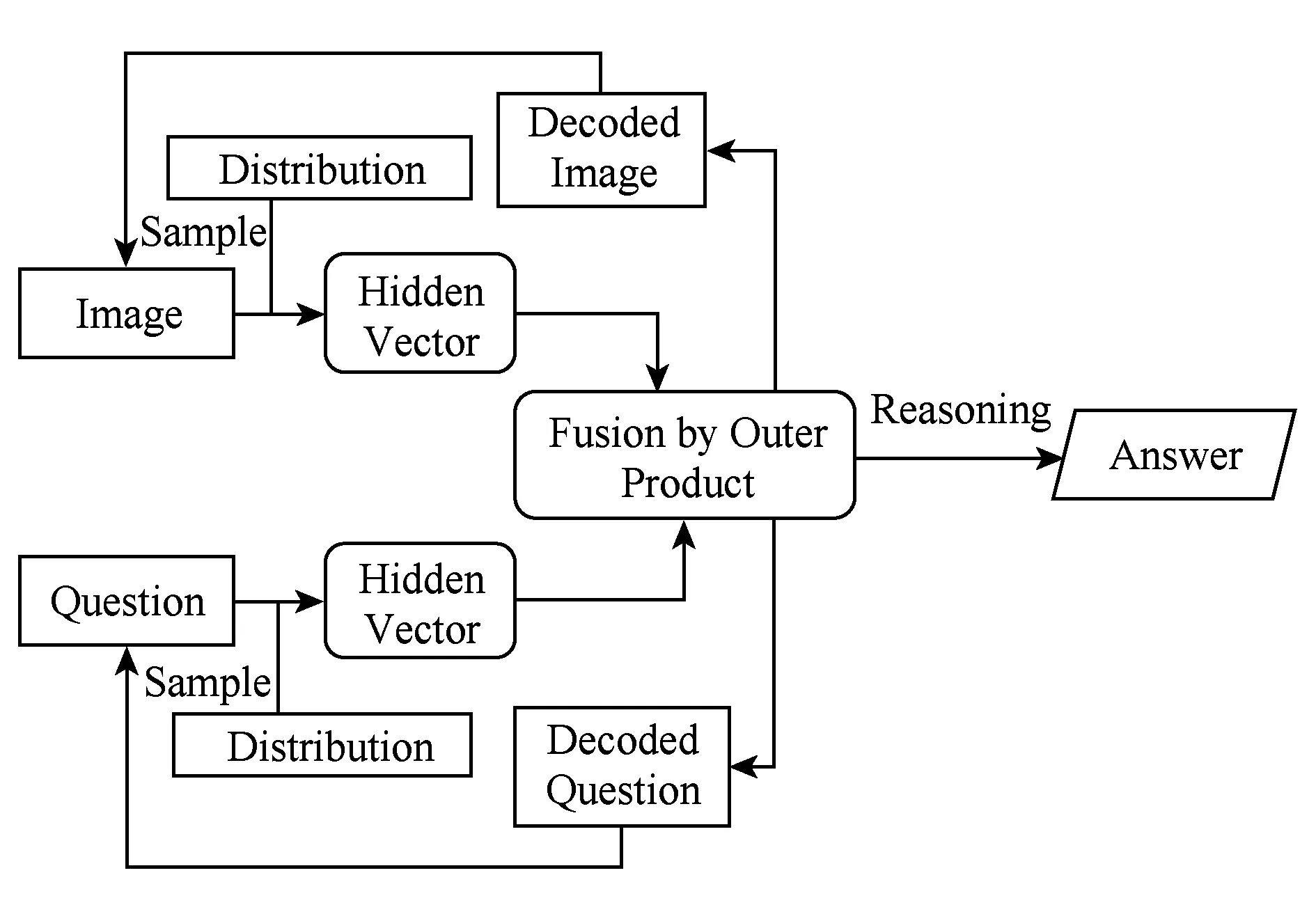

本文所提出的多模态特征融合方法主要有:结合问题文本信息,使用注意力机制对图像特征进行加权.基于变分自编码器计算图像与问题的隐向量概率分布,在隐向量上进行特征融合.

3.3.1 基于注意力机制的图像特征加权

通过前2个步骤提取图像中的k个目标特征和问题文本特征,将每个目标特征分别输入到全连接层,转换为与问题特征相同的维度n并将特征相乘,得到图像与问题初步融合的特征Vk n.

3.3.2 基于变分自编码器的特征融合

假设经过注意力机制加权的图像特征向量为I,问题文本特征为Q,隐向量编码z是表示问题特征与问题文本特征关联性的隐含向量.它的概率分布表示为p(z|I,Q),该概率分布过于复杂无法计算,因此基于变分推断方法,利用简单概率分布q(z)近似表示该概率分布.

变分推断的基本思想是利用Kullback-Leibler(KL)散度值描述2个概率分布之间的相似度:

KL(p(z|I,Q)‖q(z)).

(8)

KL散度值越小则表示2个概率分布越相似,式(8)经过推导可得:

(9)

进一步化简得到:

KL(p(z|I,Q)‖q(z))=KL(q(z)‖p(z)).

(10)

最终将问题特征与问题文本特征联合概率分布的计算转换为优化KL(p(z|I,Q)‖q(z))的最小值.

为获取图像特征与问题文本特征的维数为d的融合编码z,需要近似出可供采样的概率分布q(z).假设p(z)是正态分布,q(z)是标准正态分布N(0,I),则可对式(10)进一步推导得到:

(11)

通过最小化KL散度值,计算参数σ与参数μ,得到图像特征与问题文本特征联合表示的隐含向量编码z的近似概率分布.

计算隐向量编码z可视为对特征编码的过程,为了构建完整的自编码器的模型还需要构造解码器用于解码隐向量编码,模型结构如图10所示:

Fig. 10 Encoder-Decoder structure图10 自编码结构

在解码的过程中,直接对融合特征隐向量编码的概率分布进行采样解码,将无法计算梯度,从而导致神经网络无法正常训练.为解决该问题,本文借鉴文献[17]的思想对采样过程进行重参数化,分为2个过程:

1) 在标准正态分布N(0,I)上采样,获得一定数量隐含向量编码z.

2) 对隐含向量编码z重参数化:z′=μ+σz,将z′作为新的隐含向量编码.

通过神经网络对隐向量编码进行解码,使用反卷积解码为新的图像特征,使用多层神经网络解码为新的问题特征,并对2种特征分别计算它们与原始特征的平方差距离并作为整个神经网络模型训练损失值的一部分.

将提取到的低维的图像与问题文本特征的隐含向量编码进行外积相乘,输入到全连接层,全连接层中的参数可以表示图像特征与问题文本特征每个位置之间的关联性.最后将二维特征向量水平转换为一维特征向量,作为图像特征与问题特征的融合特征向量,这个阶段完整模型如图11所示:

Fig. 11 Model structure of multi-model feature fusion图11 多模态特征融合模型结构

3.4 答案推理

统计数据集中的答案,将出现频率最高的3 000个答案作为答案集,答案推理转换为多分类问题.

4 实验与结果分析

对于视觉问答的4个阶段,本节通过实验的方式分别将文中所提出的模型与算法跟基准模型进行实验对比,以验证模型与算法的有效性.最终将这些模型与算法整合到完整的视觉问答模型中,与现有的视觉问答模型进行实验对比分析.

4.1 数据集

实验采用COCO -VQA-V2数据集[2],该数据集中的图像来自于MS-COCO数据集,主要包括123 287张图像,其中72 738张用于训练、38 948张用于测试.数据中图像数量庞大、内容繁杂,包含大量碎片化信息.每张图像都有一个对应的问题与答案.该数据集的子数据集test-standard和test-dev,在EvalAI上提供了可以提交答案的评估系统.本文实验均使用该系统进行评估,将测试数据集作为已训练好的模型输入,输出对应的答案文件,并提交到系统评估模型准确率,从而验证模型的有效性.

答案的评估分为3种类型:Yes/No,Number,Other,分别对应判断问题、计数问题、开放式问题.对于每一类问题分别统计准确率,并统计出该模型在所有问题(All)上的准确率,根据准确率评估模型效果.

4.2 图像特征提取

为验证基于LSTM的图像特征提取模型的有效性,使用基础的RNN模型进行问题文本特征提取,基础的拼接方法进行图像问题特征融合.将LSTM图像特征融合方法结合设计的2种权重调整方法:基于正反序列的权重调整(Reverse),基于双向LSTM的权重调整方法(BiLSTM)与求和(Sum)、拼接(Concat)这些基础方法进行对比实验,实验结果如表1所示.

表1的实验结果表明:基于LSTM的图像特征提取方法相比原始的拼接与求和方法有着显著的提升,使用权重调整方法进一步提升了准确率,并且使用BiLSTM进行权重调整取得了最高的准确率58.49%.

Table 1 Accuracy on the Method of Feature Extractby LSTM

4.3 问题文本特征提取

为验证基于RNN+CNN的问题文本特征提取模型的有效性,我们使用基础的ResNet进行图像特征提取、基础的拼接方法进行图像问题特征融合.文本特征提取所使用的RNN模型为LSTM,并将RNN+CNN方法与原始LSTM进行实验对比,实验结果如表2所示:

Table 2 Accuracy on RNN+CNN Model表2 RNN+CNN模型准确率 %

表2的实验结果表明:将RNN与CNN结合的模型对问题文本特征的提取效果优于原始的LSTM,并且进一步提升视觉问答算法的准确率.其中,BiLSTM和CNN结合的文本特征提取方法使得视觉问答准确率达到57.31%,相比于基础方法有所提升,因此该方法将用于后续视觉问答实验中文本特征提取.

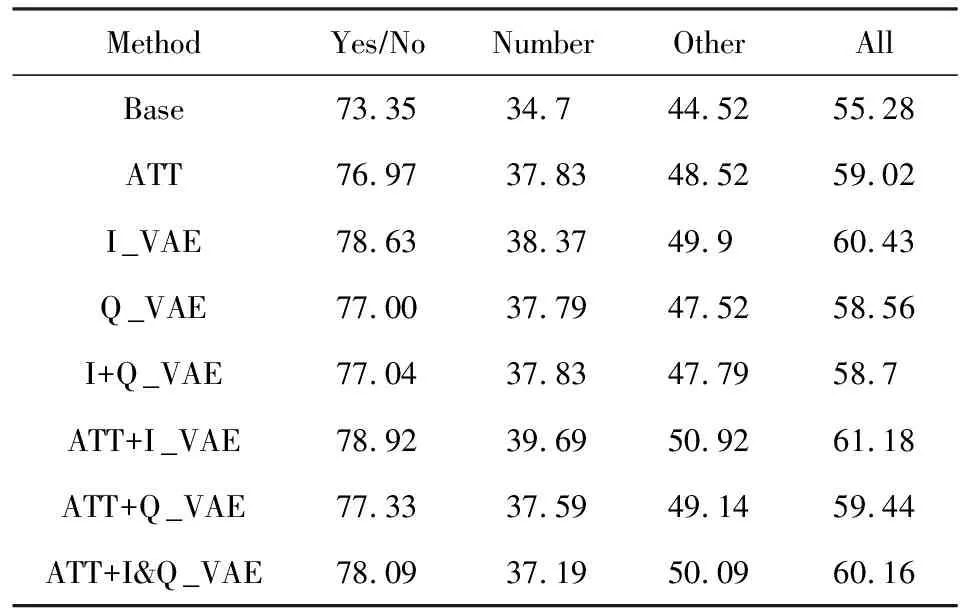

4.4 特征融合

本文使用Faster-R-CNN作为图像特征提取的基础模型,并针对这种图像特征设计的注意力机制得到新的图像特征,使用基础的RNN模型进行问题文本特征提取,并使用变分编码器分别对图像与问题文本对隐向量特征信息进行提取与融合.

模型针对是否使用注意力机制(ATT)、是否使用变分自编码器(VAE)对图像特征(I)与问题文本特征(Q)进行隐向量编码的提取进行对比实验,实验结果如表3所示:

Table 3 Accuracy on Multi-Model Features Fusion Method表3 多模态特征融合方法准确率 %

表3的实验结果表明:注意力机制显著地提升了视觉问答的准确率,在此基础上对图像特征提取隐向量编码的融合方法,取得了最优效果.

将实验效果最好的Att+I_VAE模型,在隐向量的抽样过程,考虑隐向量维数大小与隐向量编码抽样次数2个参数,进行对比实验.

对模型设置不同的隐向量维度,并以模型在视觉问答任务中的准确率作为指标进行实验对比,图12给出了不同隐向量编码维度实验结果:

Fig. 12 Results on differently hidden vector dimension图12 不同隐向量编码维度实验结果

图12的实验结果表明:随着隐向量编码的维数上升,模型的准确率呈现上升趋势,一开始上升的趋势变化较大,随后便逐步衰减.由于2种特征的隐向量编码需要外积计算,因此隐向量编码维数不宜过大.将隐向量编码的维数设置在100左右,保证模型的准确率的同时,避免模型的空间复杂度过大.

对模型设置不同的隐向量抽样次数,并以模型在视觉问答任务中的准确率作为指标进行实验对比,图13给出了不同抽样次数实验结果.

Fig. 13 Results on differently sample time图13 不同抽样次数实验结果

图13的实验结果表明:隐向量编码的抽样次数对模型准确率本身没有太大影响.这是由于数据规模足够大,多次对隐向量编码进行抽样实际上起到的是一个增强数据的作用,对拟合数据的分布并没有太大的影响.抽样的次数与模型的训练时间是成正比的,进行多次抽样将会降低模型的训练效率,将模型采样次数设置为1次,模型在准确率基本不变的前提下时间效率达到最优.

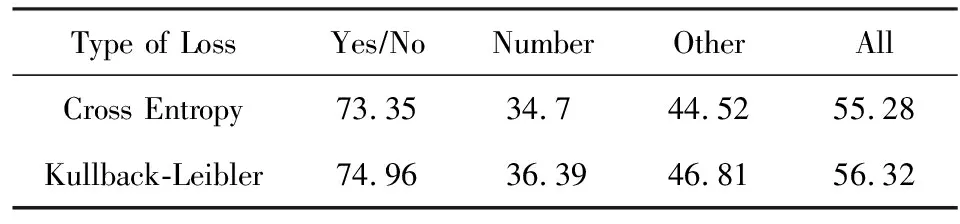

4.5 答案推理

针对答案推理过程,本文主要针对使用衡量概率分布距离的Kullback-Leibler散度值与传统多分类任务所使用的交叉熵Cross Entropy两种损失值对模型效果的影响.在视觉问答其他流程中用相同的基础方法,对比了模型使用2种不同损失值的准确率,实验结果如表4所示:

Table 4 Accuracy on Reasoning Answer表4 答案推理准确率 %

表4的实验结果表明:使用Kullback-Leibler散度能够更准确地衡量模型预测答案与真实答案的偏差值,将此作为损失值反馈给神经网,进一步提升了答案推理的准确率.

4.6 整体模型

将以上4个流程中的模型算法整合成完整的VQA模型:使用BiLSTM进行权重调整并融合多目标图像特征;使用LSTM+CNN提取问题文本特征;在多模态特征融合阶段,结合注意力机制与变分推断方法,使用上述方法中最优的ATT+I_VAE模型进行特征融合;在答案推理阶段利用KL散度值衡量2个答案分布的差异并作为损失值反馈回神经网络进行训练.

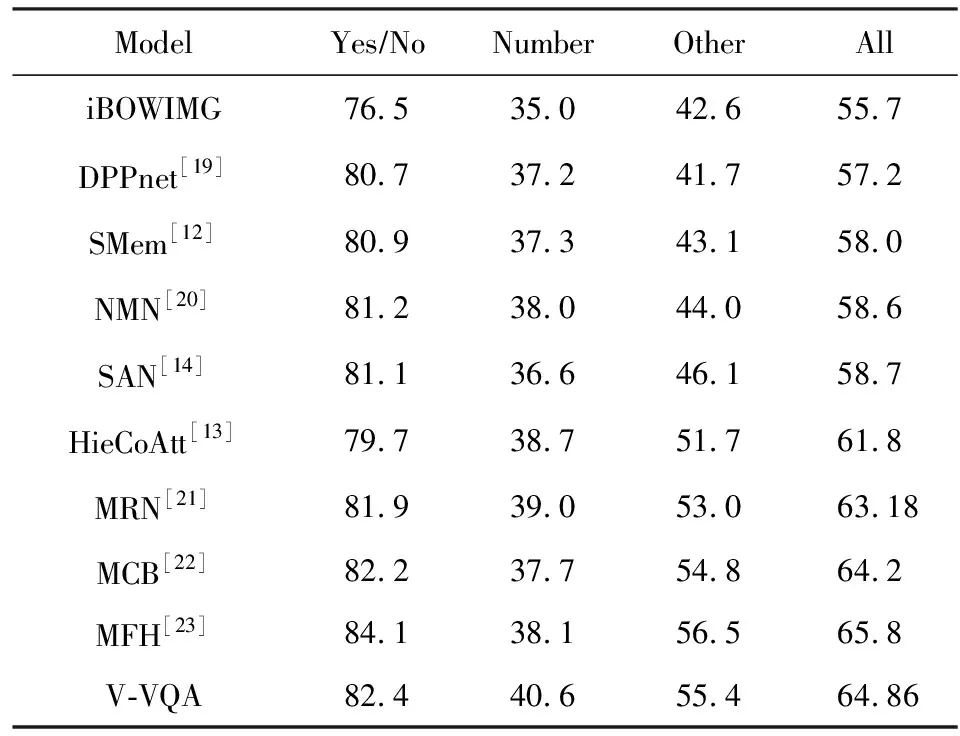

该模型的核心方法是特征融合过程中所使用的VAE,将该模型命名为V-VQA并与其他现有的基准模型进行对比实验,实验结果如表5所示.

表5的实验结果表明:本文所提的模型V-VQA在COCO-QA-V2数据集上的整体准确率为64.86%,优于现有的大部分视觉问答模型,通过实验表明该模型是有效的视觉问答模型.

Table 5 Accuracy on V-VQA Model表5 V-VQA准确率 %

4.7 结果展示

抽取COCO-QA-V2中的若干条图像与问题数据,通过训练好的模型进行答案推理,图14给出了单一形式问题的展示结果.

Fig. 14 Example 1 of VQA图14 视觉问答示例1

图14的结果表明:本文所提出的视觉问答模型对于涉及到物体识别、位置判定以及简单逻辑处理等基础问题能够推理出准确的答案.但是对于图像信息存在一定程度遮挡,或需要结合更多先验知识类型的答案推理,该模型容易出现错误.如图14(d)问答所示,摩托车数量正确答案是4,由于其中一辆摩托车存在较多遮挡,模型给出的答案是3.因此该模型仍有进一步提升的空间.

针对一张图像,根据提问的方式可以得到多种答案,图15展示了针对同一张图片多种形式问题的视觉问答任务.

Fig. 15 Example 2 of VQA图15 视觉问答示例2

从图15可以看出:本文所提出的模型对各种形式的问题均能给出较为准确的答案,有助于提取出图像中所蕴含的碎片化信息.

5 总 结

本文针对目前互联网中存在的不同模态、高度分散、结构无序、内容片面的图像与问题文本数据,提出构建视觉问答系统用以实现对多模态碎片化信息的提取、表达和理解.针对视觉问答任务流程的图像特征提取、问题文本特征提取、多模态特征融合、答案推理等步骤,基于深度神经网络,设计用以提取图像与问题文本特征的模型,结合注意力机制与变分推断方法,设计多模态特征融合方法,并使用分布距离作为神经网络损失值,设计答案推理方法.仿真实验结果表明各个过程中所使用的模型及算法是有效可行的,利用这些模型与算法整合得到的完整视觉问答模型也有效提升了该模型针对视觉问答任务的准确率.