基于时空关联度的视频车祸识别算法

2018-11-28,,

,,

(1.江苏省交通工程建设局, 南京 210004; 2.长安大学 电控学院,西安 710000)

0 引言

我国是一个交通事故多发的国家,据统计,2010~2015年,因车祸事故死亡的人数都在20万以上[1]。车祸识别可以快速地为车祸现场管理提供准确的依据,提高车祸现场快速处理的能力,减少因车祸处理不及时而造成的人员伤亡,有效避免二次事故发生。近年来,车祸识别方法已成为交通安全领域研究的热门问题,受到了很多专家的重视。

目前,车祸识别主要有基于射频、物联网,以及基于视觉图像等识别方法[2-4]。相比之下,基于视觉图像的车祸识别方法因具有直观、省时高效、设备要求低、获取信息准确等优势[4]而得到了广泛的研究。在基于时间的视频识别方法研究中,时间受限的聚类法[5]将镜头相似的镜头聚类到一个固定的时间窗口中,而位于窗口外的镜头相似性不予考虑,因此聚类结果不够完全;为了克服时间受限镜头聚类算法的不足,YongRui等提出了时间自适应算法[6,7],即镜头的相似度随着它们之间的时间距离的改变而变化,距离越大,相似度越小。在基于空间的视频识别方法研究中,镜头聚类的方法将镜头的关键帧合并为一个图像,然后对合并后的图像分块,求出镜头关键帧图像之间距离最小(相似度最大)的块;镜头分类[8]与镜头聚类不同,它是对镜头与镜头之间特征的相似性进行比较,将特征不同的镜头分成不同的类。以上研究均仅在时间维或空间维的单一维度上进行,对车祸现场细小碎片的可识别特征难以准确分割,导致识别虚警率较高。

基于时空关联度的视频识别方法可以有效的避免维度利用过低的问题[9-10],Mehmet C等将时空关联度应用到无线传感器网络中[11],Sadiq Ali等将时空关联度应用到多天线频谱感知中[12],Matoba O等将时空关联度应用到快速安全通信中[13]。而对于基于时空关联度进行视频车祸识别,目前鲜有研究。

本文将利用时空关联的方法实现车祸识别。首先为了将视频转化为更易表达的静态序列,利用镜头分割算法[14]将视频在时间维上分为视频帧图片,然后为了更准确地识别车祸,对获得的时间维上的帧序列提取多种空间特征,将这些特征串联融合,从中筛选出需要的最优特征。实验结果表明,利用本文算法进行车祸识别,能够有效提高车祸识别精度,为车祸现场管理提供了准确依据。

1 时空特征提取算法

1.1 车祸局部特征点提取

视频中的目标物体存在旋转、缩放、平移、视角变化、局部遮挡等情况,这会使得视频识别出现误识别的现象[15]。为了解决这些问题,利用3DSIFT算法提取局部特征点。SIFT描述子可以在关键点的临近区域内进行梯度直方图统计,从而可以构建出方向唯一的特征向量,具有较好的方向稳定性。通过对车祸视频进行3DSIFT特征提取,可得出车祸视频的特征直方图,特征直方图可以描述车祸发生前后的特征变化。

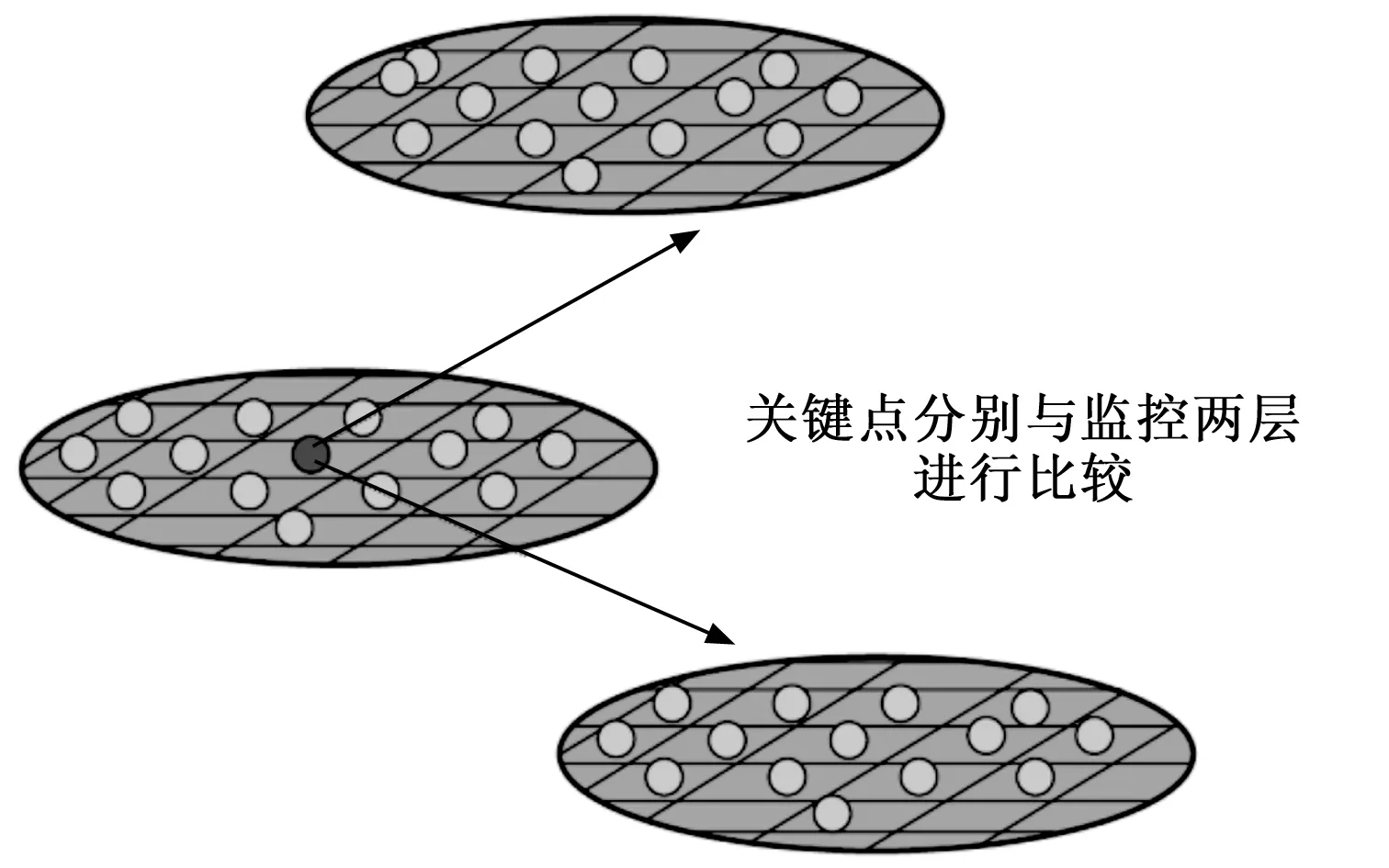

在局部特征点提取算法中,首先在高斯差分(DoG)尺度空间内,检测图像的关键点。为了确保关键点的准确性,SIFT描述子需要对DoG空间相邻图像进行采用和比较。通过比较临近区间内的点,可得出该区间内的极大值点或极小值点,并且将不符合条件的或符合程度低的点删除,得出的极值点即所需关键点。如图1所示。

图1 基于DoG空间内的极值点检测

得出图像的关键点后,为了保证SIFT特征的方向稳定性,需要对SIFT描述子在关键点临近区域内进行尺度方向直方图统计,然后求取特征点的主方向。这个过程将图像均分为多个小块,将不同小块内的方向向量提取出来,然后在将这些小块以及它们的方向向量合并到一起,从而构建出唯一的,具有代表性的特征向量。如图2所示。

图2 SIFT特征描述子构建

通过尺度方向直方图统计得出特征点的主方向后,需要根据求取出来的这个主方向构建梯度直方图,即生成关键点描述子。计算关键点p的k邻域点pi(i=1,2…,k),为了保证旋转不变性,将关键点p的k邻域点旋转至关键点主方位,邻域点坐标变换公式如式(1)所示。

(1)

1.2 车祸局部特征的时空角点检测

为了检测车祸视频中撞车细节的局部特征,采用STIP(space-time interest poinet)时空角点检测算法,需要先将图像兴趣点的检测从2D空间兴趣点转化为3D空-时兴趣点。采用Harris-Corner兴趣点检测,在图像的的X轴和Y轴的基础上添加时间T轴,并消除视频图像结构中存在的加速度,从而将二维特征转化为三维特征。

在进行Harris-Corner兴趣点检测前,需要先创建一个空-时兴趣点特征描述器,求得兴趣点的特征描述向量。对于每一个样本点(x,y,t,σ,τ),特征描述器描述的是关于中心点(x,y,t)周围区域的3D空间,空间大小△x(σ)和△y(σ)是σ的函数,时间长度△t(τ)是τ的函数。在这里描述器的大小将由式(2)(3)所示。

△x(σ)=△y(σ)=2·ceil(3σ)+1

(2)

△t(τ)=2·ceil(3τ)+1

(3)

根据这些描述器求得兴趣点的特征描述向量。得到空-时兴趣点特征描述器后再进行Harris-Corner兴趣点检测,如式(4)所示。

(4)

建立一个空-时图像序列模型,如式(5)所示。

(5)

得出3维Harris-Corner检测的三阶矩阵,如式(6)所示。

(6)

为了检测兴趣点,需要搜索区域中具有现在特征值λ1,λ2,λ3的μ,并扩展式(5)中空间STIP兴趣点,检测成为空-时STIP兴趣点检测,如式(7)所示。

H=det(μ)-ktrace3(μ)=λ1,λ2,λ3-k(λ1,λ2,λ3)3

(7)

得出H的极大值点,然后检测、选择及排除得到需要的时空角点。

1.3 车祸局部特征点描述

为了将图像空间中的三维兴趣点特征转化为描述符向量,采用局部特征点描述HOG3D算法。HOG3D三维梯度方向直方图描述器将视频空间看做一个正N面体,然后对该正N面体进行均匀分割,将它切成均匀的小块,然后在这些小块里面进行统计梯度直方图。一般先在视频空间或图像空间里进行区域检测,然后对其感兴趣的区域里进行兴趣点采集,从而得到其三维兴趣点,具体流程如图3所示。

图3 HOG3D三维梯度方向直方图描述器

在计算HOG3D特征时,首先从图像中定位出一个大的目标区域Block进行图像分块,将图像按照它的大小尺寸等进行均匀的分割。然后,均分Block至较小的块Cell,直至均分Cell形成最小的块Pixel,也就是像素点。

对图像进行打块后需要在Block内进行归一化直方图。对每个小块进行直方图提取,再将这些直方图经过串联的方式组合为一个完整的特征向量。算法通过局部打块的方式逐一获取整个系统的图像特征,不仅获取了整体特征,同时获得了局部细节特征;由于进行了直方图归一化的操作,可有效避免因为外界光线变化所带来的系统干扰。

1.4 算法流程

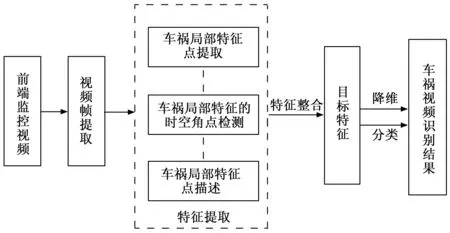

本文算法以车祸视频帧分割算法的时间特征为基础,结合局部特征点提取、检测和描述算法,实现对车祸视频的准确识别。算法流程如图4所示。

图4 基于时空关联度的车祸识别流程图

步骤1:视频帧提取。为了将视频在时间维上依次转化为对应的时间帧序列,采用镜头分割算法将视频转化为系统帧图片。

步骤2:空间特征提取。为了解决车祸视频中因目标物体存在的旋转、缩放、平移、视角变化和局部遮挡等造成的特征方向不稳定的问题,提出局部特征点提取算法;为了在从车祸视频中具有加速度的车辆上获取其撞车细节的局部特征,提出时空角点检测算法;为了将图像空间中获取的三维时空兴趣点转化为描述符向量,提出局部特征点描述算法。

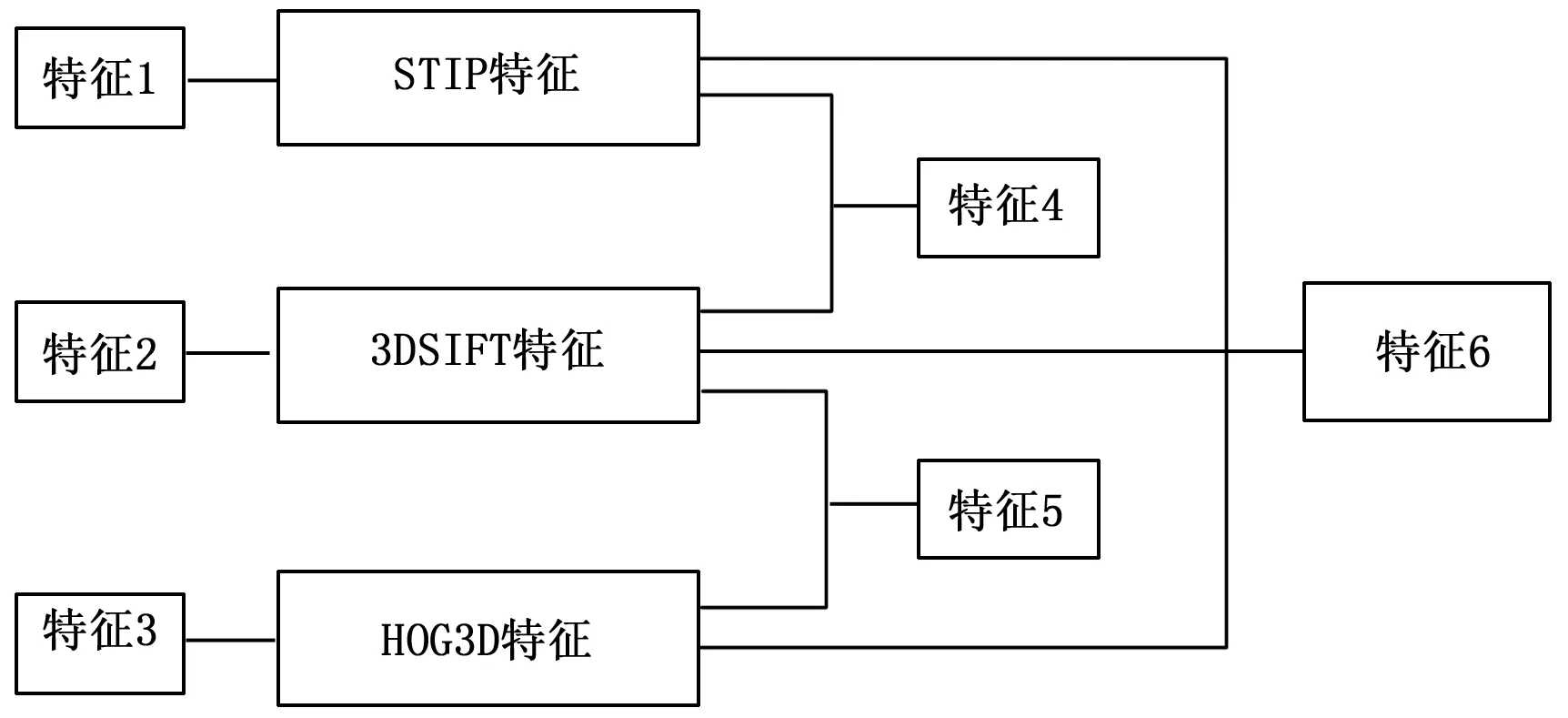

步骤3:特征融合。串联融合车祸视频中提取的多种特征,如图5所示。

图5 串联特征融合方案

步骤4:降维处理。为了解决视频特征数量过多的问题,对融合后的视频特征进行降维聚类。

步骤5:车祸识别分类。将车祸视频识别的结果分为发生车祸与未发生车祸两类,得出识别结果。

2 算例

2.1 视频帧提取

镜头分割即检测镜头的边界,然后将视频从检测到的边界处分割开,形成独立镜头的过程。经过分割转化后的结果如图6所示。

图6 经分割转化后的视频帧

将动态的车祸视频转化为镜头帧序列对其进行转存。结果如图7所示。

图7 转存后的视频帧文件

2.2 车祸局部特征点提取

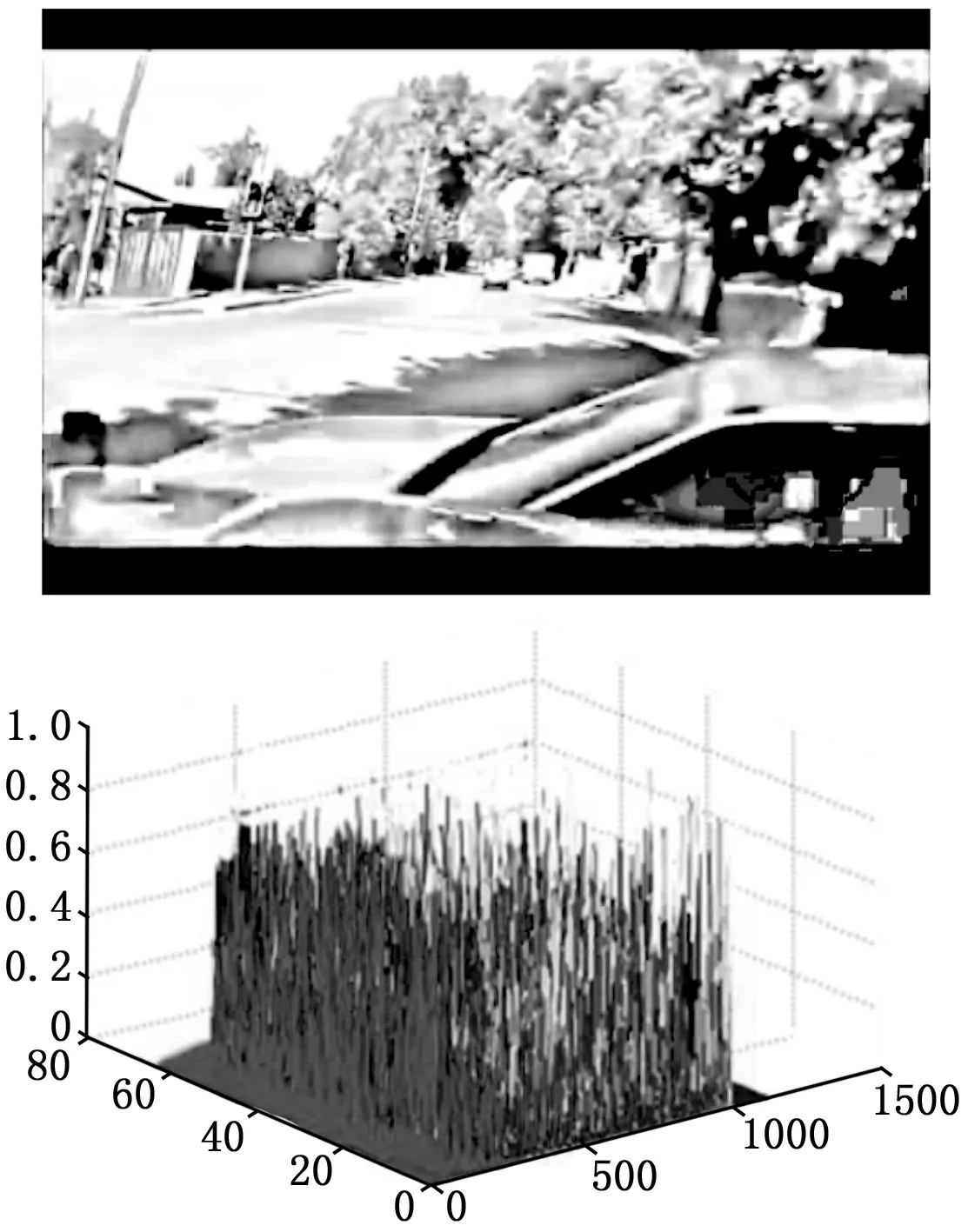

通过对车祸视频进行3DSIFT特征提取后,可以得出车祸视频的特征直方图,如图8所示。

图8 车祸视频的特征图

从图中可以看出,在横坐标2 000之前特征图基本都是黄色,表明此时视频处于平缓的状态,此段视频中的对象并没有发生剧烈的颜色、形状及位置突变;而在2 000~2 500区域时,特征颜色明显的发生了突变,表明在这个时刻视频内现场场景发生了剧烈变动,从而得出在2 000时为车祸异常的时刻。

2.3 车祸局部特征的时空角点检测

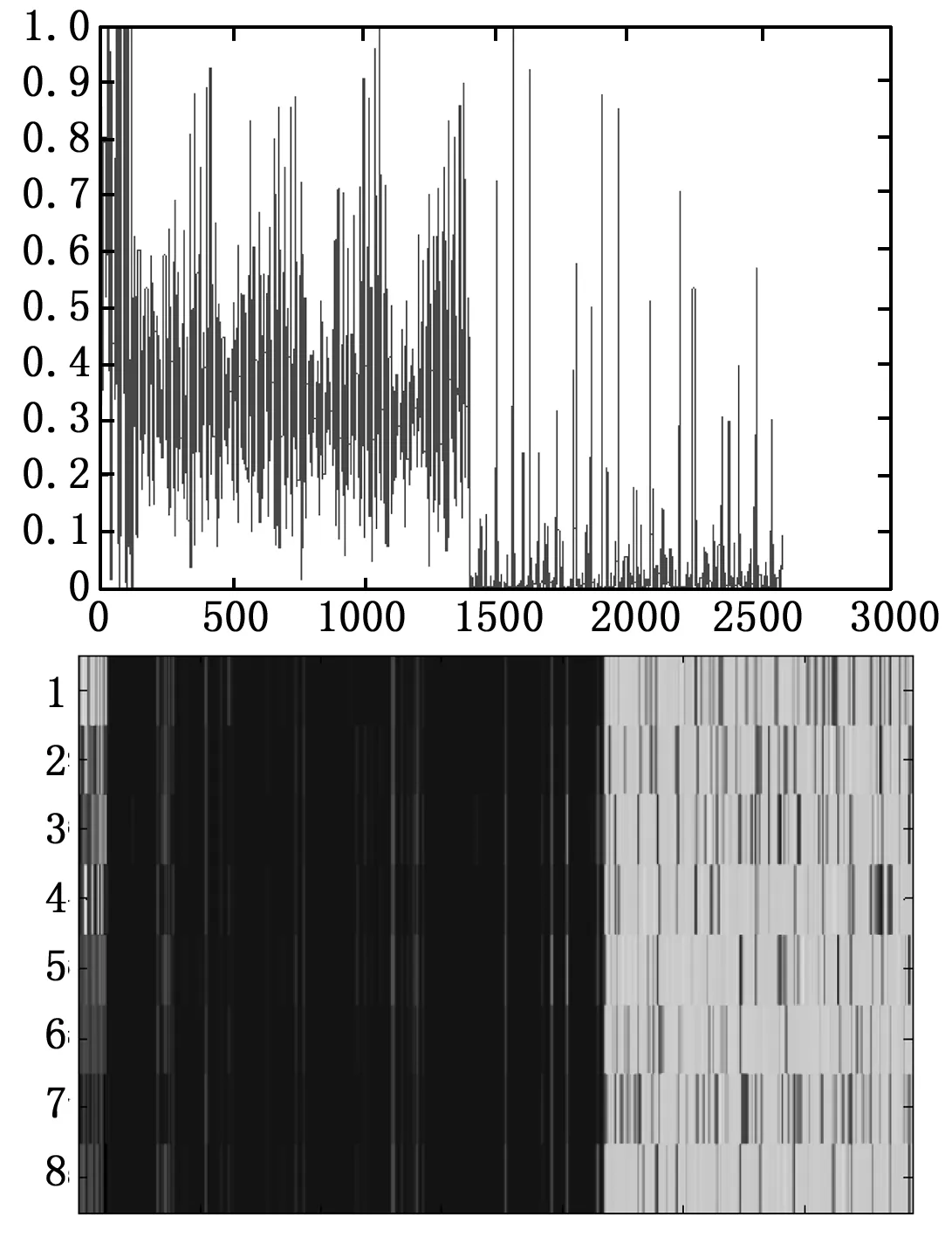

通过STIP算法得出车祸视频的统计时空特性,如图9所示。从图中可以看到,将车祸发生前与发生后的帧图片进行了分隔归离。

图9 统计视频时空特性

该车祸视频的时空特征点检测图如图10所示。图中可以看到,除了传统的x轴和y轴外,增加了时间轴,这些时空特征点邻域的像素值在时间和空间都有显著的变化。在该算法中,邻域块的尺度大小能够自适应时间维和空间维。

图10 时空特征点检测图

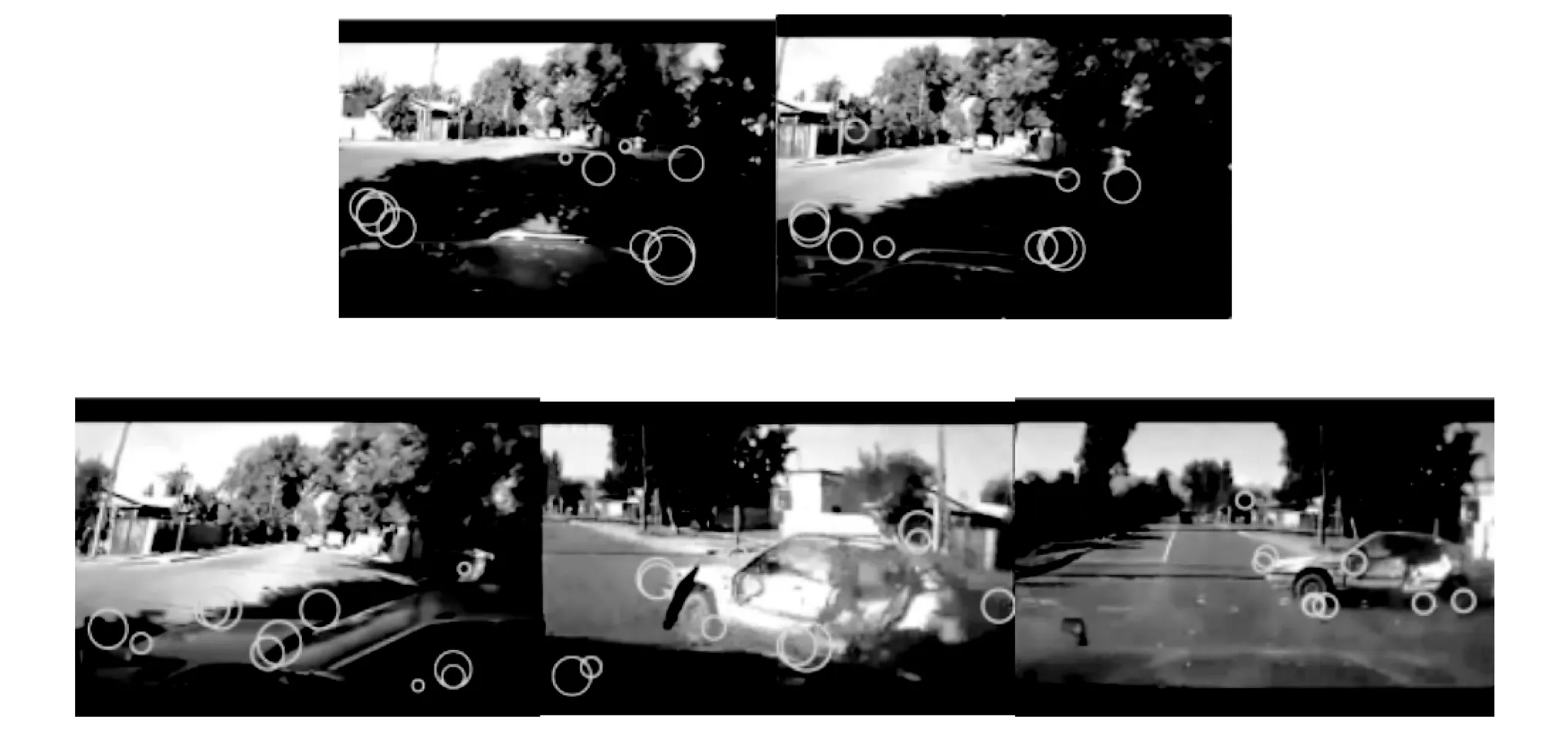

通过STIP算法求得车祸视频的检测兴趣点,结果如图11所示。

图11 车祸视频中第3、59、121、131、150帧兴趣点提取结果

图中圆环即STIP算法在视频内检测到的点。因为各点在x、y轴的坐标距离都不同,所以生成的圆环的彼此的直径也不相同。从图中可以看到,兴趣点能够找到车的车头、车轮、车尾这些重要部位,准确得出车祸中车辆的局部细节。但也有少数兴趣点的检测位置并不在车身上,这是因为视频内的车辆在进行平移直线运动或者匀速运动时,周围的环境没有显著变化,算法会暂时将周围环境归到车辆本身。但在车祸发生后,周围环境发生了空间突变,兴趣点会因此而重新定位,并正确标记到车辆上。因此STIP算法检测到的兴趣点具有很好的准确性。

2.4 车祸局部特征点描述

实验中所用到的车祸视频的帧图像大小为480×640,把图像里面的每16×16个元素组成的对象编入为1个Cell块,从而生成了30×40个Cell块,一共有(30-1)×(40-1)=1 131个Block,每个Block是16×4=64维,计算得到样本图像HOG特征向量维数是1 131×64=72 384。最终提取的车祸图片的1 131×64维HOG特征的网络图如图12所示。

图12 提取图像HOG特征

从图中可以看出,HOG3D算法提取出了车祸发生的这一瞬间的帧图片,而右边HOG特征的网络图中前半部分为深色区域,而后半部分为浅色区域,这表示前后两部分视频内的时空场景发生了剧烈的改变,即在颜色发生改变的位置是视频内容突变前车祸发生碰撞的瞬间。

3 实验结果

经过特征融合会得到5种特征,对这5种特征进行K-MEANS聚类和KNN识别,然后从中选出最优的融合方案。如图13所示。

图13 特征融合后的示意图

图13即3DSIFT和STIP融合以及3DSIFT、STIP及HOG3D三者融合后的识别结果。从3DSIFT与STIP的融合结果可以看出,图像的前半部分和后半部分具有显著的差异,即车祸发生前与发生后的特征具有明显的变化。而在3DSIFT、STIP、HOG3D3种特征融合后可以很清晰的看到车祸前与车祸后的分界点,这表明将3种特征融合在一起时可以提高车祸识别的准确率。

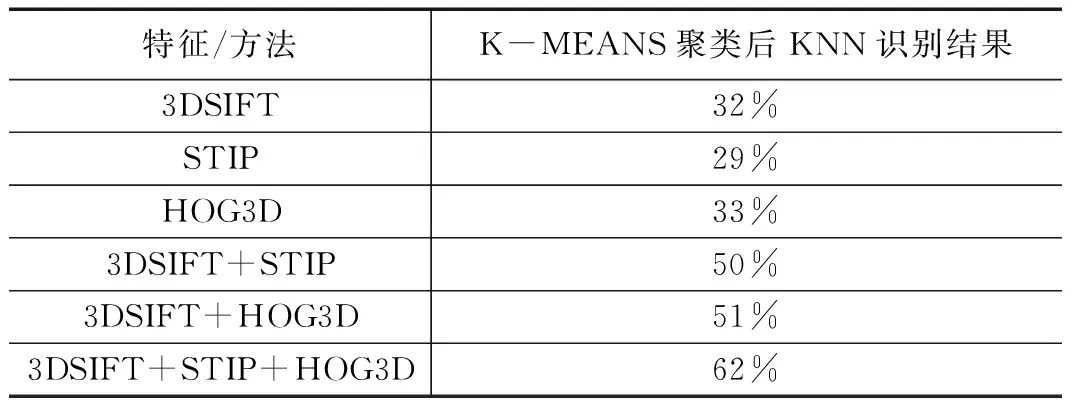

本文针对不同特征得出的车祸识别率,做了10组车祸视频的实验,其中每组实验先仅使用3DSIFT、STIP和HOG3D中的一种特征进行识别,再使用二维和三维两种特征进行识别,最后使用3种特征的融合特征进行识别。实验所得结果如表1。

表1 各类特征在K-MEANS聚类与KNN识别之后的结果比较

从表中可以得出,在只使用一种特征时,识别率都低于50%;进行特征融合后识别率有了明显的提高;而在将3种特征全部融合起来后其KNN识别率达到最高,为62%,这对比传统算法所得到的33%,具有很大的提高。因此可得出结论,将3DSIFT、STIP和HOG3D三种特征融合后其融合特征能够很大程度上提高车祸识别精度。

4 结论

本文以提高车祸视频识别率为目的,针对传统视觉图像技术车祸识别方法的缺点,提出基于时空关联度的车祸视频识别算法,利用视频分割算法将视频分割为时间帧序列,再对视频图像的空间局部特征进行检测、提取和描述后,然后进行融合处理,可以有效利用视频的时空特征。对比实验表明,本文车祸视频算法有效地提高了算法识别精度,对于交通事故实时识别与紧急救援具有重要作用。