改进稀疏超完备词典方法识别奶牛跛足行为

2018-10-10温长吉张金凤李卓识于合龙姜海龙

温长吉,张金凤,2,李卓识,3,娄 月,于合龙,姜海龙

改进稀疏超完备词典方法识别奶牛跛足行为

温长吉1,张金凤1,2,李卓识1,3,娄 月1,于合龙1※,姜海龙4

(1. 吉林农业大学信息技术学院,长春 130118;2. 长春建筑学院图书馆,长春 130607;3. 吉林大学工程仿生教育部重点实验室,长春 130012; 4. 吉林农业大学吉林省动物营养与饲料科学重点实验室,长春 130118)

监测与发现奶牛异常行为是实现疾病早期防控的关键,其中尤以跛足行为发现与识别较为典型,但是当前家畜异常行为识别仍然存在在线性能较差的问题。针对这一问题,该文提出2种改进策略。首先提出一种基于共轭梯度追踪算法的稀疏超完备词典学习算法(conjugate gradient pursuit-KSVD, CGP-KSVD)用于跛足行为特征的语义级描述和表示,即在稀疏编码构建阶段引入共轭梯度追踪算法寻找优化搜索方向,同时避免存储和计算大规模Hessen矩阵带来的计算负载,从而提升稀疏超完备词典学习算法的收敛速度。其次通过时空兴趣点与稠密轨迹图二次提取时空兴趣点相融合实现视频底层特征提取和表示,在保留丰富细节特征信息的基础上减少冗余特征降低计算负载。在1 200个时长10 s的标注视频样本集上测试结果显示:该文提出的算法识别准确率达到100%,识别平均响应时间为0.043 s,对比基于基追踪算法(basis pursuit-KSVD,BP-KSVD)和正交匹配追踪算法(orthogonal matching pursuit-KSVD, OMP-KSVD)稀疏编码序列优化策略算法在识别平均响应时间分别提升1.11和0.199 s,在90 h回放视频和在线测试视频上跛足行为识别准确率分别为93.3%和92.7%,明显优于对比算法。试验结果表明该文提出的跛足行为识别算法框架具有较高的识别准确率和较好的在线响应时间,可以为相关研究工作提供借鉴意义,相关技术可以成为接触式传感器监测及其他技术的必要补充。

图像处理;算法;畜牧养殖;跛足识别;CGP-KSVD;时空兴趣点;稠密轨迹

0 引 言

奶牛跛足是众多疾病的初期表征,主要表现为行走或站立过程中拱背和步态异常,因此早期防控至关重要。传统人工观测方法存在成本高、工作强度大、易疲劳等问题。为有效解决上述问题加快人工干预响应时间,当前主要通过接触式传感器监测技术[1-5]和机器视觉技术实现家畜日常体征行为监测。接触式传感器监测技术主要通过附着在家畜身体部位上的三轴或六轴加速计、以及其他体征监测传感器采集和记录家畜的运动行为数据,并对采集传感数据利用机器学习方法进行分析,从而实现家畜个体行为的分类识别,相关研究包括Martiskainen等[1-3]对于奶牛行为的分类识别。Cornou[4]和郭东东[5]等对于包括猪和羊个体基本行为识别。研究表明上述工作尽管取得一定的研究效果,但利用接触式传感器技术会影响家畜的日常活动,且佩戴在家畜身上的传感部件易受晃动、碰撞等因素产生噪声数据,影响家畜异常行为识别的准确性。

机器视觉技术具有非接触免打扰的优点,因此在家畜行为识别中具有重要的研究意义和广阔的应用前景。当前国内外比较有代表性的成果有,Viazzi等[6]使用摄像系统提取行走过程中的奶牛背部姿势进行视觉运动评分来区分奶牛的跛足行为,但该方法所采用的俯视特征提取方式区分度较差。Stavrakakis等[7]则通过跟踪家畜行走过程中颈部、背部和盆骨的运动轨迹用于跛足行为识别,但是由于运动过程中身体部位对体感传感器传输信号造成遮挡,从而影响识别精度。温长吉等[8]提出了一种改进的时空局部二值模式用于视频中家畜行为特征描述和个体基本行为识别,特定视角下基本行为识别率达到94.6%,随机视角基本行为平均识别准确率为88.3%。赵凯旋等[9]将卷积神经网络技术应用于家畜基本行为识别,通过帧间差分法实现在大规模数据集试验中取得了较好的结果,视频帧图像识别准确率达到93.55%。于欣等[10]利用Lucas-Kanade 光流法和统计特征对鱼群异常行为进行监测,鱼群异常行为监测率达到99.5%以上,但是光流特征提取易受水纹噪声影响。劳凤丹等[11]和郁厚安等[12]将机器视觉技术应用于禽畜的行为轨迹跟踪和基本行为识别取得了一定的成果。研究表明当前研究工作仍然存在在线识别性能较差,试验环境设定较为严格,对实际养殖生产环境的适应性较差等问题。因此,研究高效行为特征的提取和表示成为当前研究热点之一。

当前机器视觉技术中用于视频中运动行为特征提取和表示比较有代表性的工作包括时空兴趣点[13-16](spatial-temporal interest point,STIP)和稀疏编码与表示,稠密轨迹[17-19](dense trajectory)以及基于深度学习[20-22](deep learning)的特征提取和表示技术。传统时空兴趣点[13-16]方法检测出的兴趣点数量较少,同时易受背景噪声干扰,影响行为识别的准确性。优化策略的选择对稀疏编码算法收敛速度和性能具有较大影响[23-28]。稠密轨迹[24]特征在行为细节特征描述和表示上具有明显的优势,但是产生大量的冗余特征,增加系统的计算负载。基于深度学习的特征提取和表示技术对训练样本集规模上的严格要求,在针对小样本集分类识别问题上往往表现不佳。

本文提出将时空兴趣点与稠密轨迹图二次提取时空兴趣点相融合用于底层行为特征描述,同时借鉴超完备词典下的稀疏信号表示方法[29-31],利用CGP-KSVD构建稀疏超完备词典用于行为的语义特征描述和表示,实现奶牛跛足行为的监测识别。

1 试验材料

1.1 视频采集

试验视频采集自吉林省新源牧业松原前郭奶牛养殖基地的500头随机选取的黑白花成年奶牛,奶牛个体通过耳标进行身份确认,采集时间为2016年4月至2016年9月,每天上午7:00-8:30,下午14:00-15:30,在此时间段集中将奶牛经匝道由棚舍区引导至棚外自由放牧区,同时将摄像机固定在匝道距限位栏1.5 m处的半身高位置以采集奶牛从棚舍通往自由放牧区的匝道处侧体位影像,奶牛经过镜头区域时长跨度约为10 s,利用人工方式对采集视频分类标注。

1.2 试验环境

视频采集设备主要包括三星HMX-F90XL摄像机,分辨率为720╳480 pixel /帧;海康威视DS-7908N-K4型号的硬盘存储设备和Intel Corei3-7100处理器,16 GB内存,1 TB硬盘容量的台式计算机。试验所用软件环境为Open CV和MatlabR2014a,其中,Open CV用来实现稠密轨迹以及相关特征的获取,MatlabR2014a用于快速实现原型试验框架搭建。

2 试验方法

本文提出了一种基于共轭梯度追踪算法的稀疏超完备词典方法对奶牛拱背和步态异常[29]表现下的跛足行为进行识别。具体实现步骤如下,首先对训练测试样本分别提取时空兴趣点和稠密轨迹图上二次提取的时空兴趣点,联合HOG特征描述子构建融合特征矩阵用于步态行为特征描述。然后利用CGP-KSVD算法构建稀疏超完备词典用于行为的语义特征描述和表示。最后训练libSVM分类器实现跛足行为监测与识别。算法执行流程如图1所示。

图1 跛足行为识别算法框架流程图

2.1 视频行为特征提取与描述

2.1.1 时空兴趣点检测

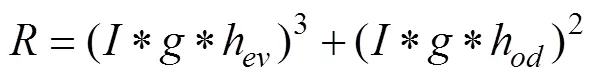

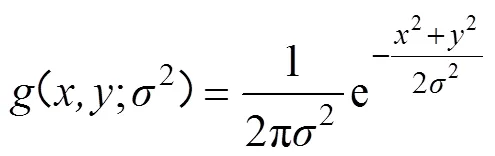

时空兴趣点(STIP) 指附带时域信息的角点、角点处灰度强度变化的显著点。时空兴趣点比较有代表性的研究包括,Laptev[13]和Dollar[16]等的亚那就。Laptev等[13]将 Harris的角点检测思想扩展到了时域,该方法认为,时空兴趣点在三个正交方向上灰度信息变化较为显著,但是该方法提取的时空兴趣点较少,信息量损失较为严重。本文采用 Dollar等[16]提出的时空兴趣点检测方法。Dollar兴趣点检测应用可分离线性滤波器计算响应函数

其中(,;)是一个二维的高斯平滑核函数,作用于空间维度,,联合表示帧图像上点的空间坐标,其表达式为:

h(;,)与h(;,)是一对一维的正交 Gabor 函数分量,作用于时间维度,其表达式为:

令=4/后响应函数只有2个参数,对应空间尺度,对应时间尺度,表示视频帧对应时刻,用于标记视频帧中点的时间坐标。响应函数取得局部极大值且大于某一阈值的点被检测为兴趣点,通过阈值可以控制检测出的兴趣点数目。

2.1.2 稠密轨迹图二次兴趣点检测

稠密轨迹指密集采样的兴趣点轨迹方法[18,32],是在多尺度下提取兴趣点轨迹,并在单位边长为像素的网格下对特征点进行跟踪采样。首先进行稠密样本点采样,依据文献[32]当=5时,采样密度效果最佳,从而获取大量采样点;然后将采样点分为8维尺度空间,其中采样点定义为P=(x,y),即在第帧图像上对应坐标点为(x,y);然后使用一个基于稠密光流场的中值滤波器来实现从点到+1点的跟踪,表达式为:

式中=(u,v)为中值滤波器,为滤波器核函数;然后将采样点连接形成轨迹,即(P,P1,P2,∙∙∙),为了避免轨迹在跟踪过程中偏移初始点,设定轨迹长度为。试验表明,跟踪轨迹长度限定为15帧时可以较好地避免偏移初始点这一问题。帧长的轨迹表达式为

式中ΔP=P1P=( x1x, y1y)为位移量。图2为视频稠密轨迹提取示意图,算法详细执行参见文献[24];最后在稠密轨迹图基础上二次提取时空兴趣点。

图2 视频帧稠密轨迹提取示意图

稠密轨迹图基础上二次提取时空兴趣点,可以保留视频中行为的丰富细节信息,同时减少冗余特征降低计算负载。相对稠密轨迹采用的稠密采样,Dollar时空兴趣点检测和提取特征点具有稀疏性,导致特征信息的丢失。稠密轨迹方法对于稠密采样点利用光流场跟踪形成轨迹图,对每个稠密采样点跟踪形成的轨迹利用HOG、HOF(histogram of flow)和MBH(motion boundary histograms)进行特征描述和表示,将会引入庞大的特征表示矩阵,从而提高计算负载。本文所提出的稠密轨迹图二次提取时空兴趣点,通过将原始视频提出的稠密轨迹视为一个新的视频用于量化行为特征,其每帧图像为稠密轨迹点在二维面上的投影,因此通过在稠密轨迹形成的时空图上提取Dollar时空兴趣点,将降低采样规模,并且利用HOG描述二次采样的时空兴趣点也进一步降低原有通过HOG、HOF和MBH的计算规模。因此融合特征在提升原有时空兴趣点特征信息量的同时,进一步降低稠密轨迹特征提取和表示的计算负载。

2.1.3特征融合

特征融合实现方式是在初始兴趣点检测及稠密轨迹图二次兴趣点检测的基础上,利用HOG[33]进行特征描述和表示。其中利用HOG进行特征描述和表示是在兴趣点周围取固定大小的时空块,然后对时空块划分为大小为3×3×2的时空网格,并采用8维区间量化计算每个时空网格的HOG特征,最后获得该兴趣点18×8=144维的HOG特征,即X=(1,2,∙∙∙, X),其中为检测出的兴趣点数,用于视频行为的底层特征描述,并用于构建稀疏超完备词典。

2.2 基于改进的稀疏超完备词典学习

稀疏超完备词典算法一般包括稀疏编码和词典更新2部分,为提高算法的运行效率,本文根据GP[27]的实现过程,在稀疏编码阶段利用共轭梯度追踪算法 (conjugate gradient pursuit, CGP)[28]实现稀疏系数编码。CGP算法在GP算法的基础上,优化了每次迭代搜索的方向,从而加快了收敛速度,减少了计算时间,弥补了梯度追踪算法收敛性差的缺点。

2.2.1 稀疏表示模型

稀疏表示[34-35]是最近几年信号处理领域的热点之一,主要包括词典的生成和信号的稀疏分解2个部分。Davis[23]等证明0范数表示下的稀疏问题求解本质上是一个NP难题。为有效解决NP问题,Donoho[36]等提出利用1范数代替0范数,将原来的问题变成线性规划的凸优化问题,转化模型表达式如下,其中表示词典,为稀疏系数向量,为样本向量,是考虑引入噪声后误差项而引入的一个很小的正数。

如果考虑噪声因素,得到如下模型:

为解决该凸优化问题,一种方式是利用基于凸优化求解问题的思想,代表性算法包括基追踪算法(basic pursuit, BP)[25];另外一种方式是基于贪婪迭代的算法,例如匹配追踪算法(matching pursuit, MP)[6],正交匹配追踪算法(orthogonal matching pursuit, OMP)[23,24]和基于梯度下降的迭代算法[26,27],如共轭梯度追踪算法( conjugate gradients pursuit, CGP)[28]。

2.2.2 CGP-KSVD稀疏超完备词典学习

词典学习的过程主要包括稀疏编码和词典更新2个阶段:

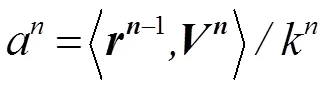

稀疏编码:共轭梯度追踪算法(Conjugate Gradient Pursuit ,CGP)是介于最速下降法与牛顿法之间的一个方法。CGP[28]算法的基本思想是:寻找与负梯度方向和上一次搜索反向共轭的方向作为新的搜索方向;然后沿着该方向作一维搜索,再确定下一轮的搜索方向并进行一维搜索,直到满足终止条件,即最大迭代步数或者达到设定值。

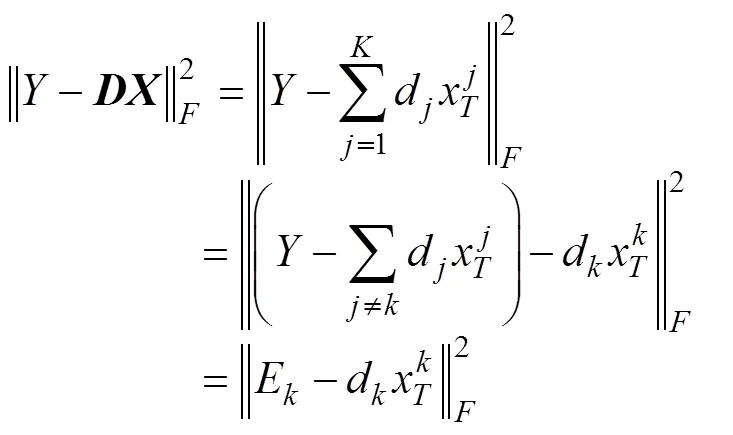

词典更新:初始词典往往不是最优的,满足稀疏性的系数矩阵表示的数据和原数据会有较大的误差,需要在满足稀疏度的条件下对初始词典逐行逐列更新优化,减小整体误差,逼近目标词典[37-38]。首先假设系数矩阵和词典都是固定的,将要更新的是词典的第列d,系数矩阵中d对应第行为x,则

可以看出被分解成了个秩为1的矩阵相加,根据假定条件,其中有1项是不变的,剩下的一项即是待处理的词典第列,E表示剔除原子d后产生的误差。词典学习的目的即是更新词典原子d和稀疏系数x。为了避免经过奇异值分解后的矩阵稀疏性发生改变,在进行奇异值分解前,执行如下操作:

定义集合ω={1≤≤N, x()≠0}为用d进行线性表示的所有样本y的下标所构成的集合,即x()≠0的点的索引值。定义Ω为×|ω|矩阵,其在(ω(),)处值均为1,其他位置均为0。定义x=xΩ,Y=YΩ,E=EΩ,其中x,Y和E分别为x,和E中去掉0值输入后的结果,Y为当前用到d进行线性稀疏表示的样本集合,E为去掉无需d原子表示的样本后所带来的误差,x的长度为|ω|,Y和E为×|ω|阶矩阵,则式(8)转换为:

在变换成式(9)基础上对E使用奇异值分解以更新原子和稀疏向量[37]。基于CGP-KSVD词典学习算法的步骤如下,其中详细CGP算法参见文献[18]。

算法初始化:0=,初始索引值集合为空集,0表示初始残差,1表示初始迭代步数0=rand(0,1),随机生成初始稀疏向量,其中训练样本为维的样本向量,0为╳维的初始随机生成词典,稀疏稀疏矩阵为=[1,2,∙∙∙ , x],其中x(1,2,∙∙∙,)表示稀疏向量。

2.2.3 执行算法

Step1:稀疏表征

①计算残差:g=Dr+1;

②搜索最大索引:I=argmax|g|;并更新下标集:-1∪I;

③确定共轭搜索方向:

⑦CGP-KSVD算法更新词典和稀疏系数矩阵。

Step2:词典学习

②依据SVD算法实现词典更新

令E=EΩ,为x中非零元素构建的新矩阵,最后对E进行SVD分解,得出更新词典。

2.3 跛足行为检测识别

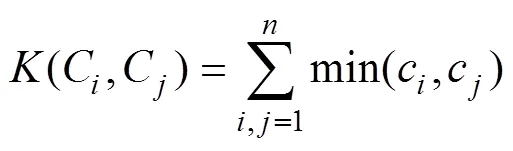

本文工作选用基于直方图交互核的支持向量机[39-42]对跛足行为进行检测识别,直方图交互核函数适用于衡量直方图的相似程度,所选用直方图交互核函数[43-45]如式(10)所示。

式中C,C用于表示HOG对兴趣点进行描述和表示后经CGP-KSVD稀疏编码学习后形成的稀疏编码特征直方图,c,c(=1,2,∙∙∙,)用于表示稀疏编码特征直方图各自对应的单柱纵坐标值,即该单词出现频次的归一化值。正常奶牛步态行为与跛足步态行为视频帧示意图和稀疏编码特征直方图如图3所示,通过稀疏编码特征直方图可以较为直观看到方框圈定区域存在差别。以稀疏编码模型特征直方图作为直方图交互核支持向量机的输入,用于训练和测试识别。

图3 跛足行为特征与数据特征对应关系示意图

3 试验与结果分析

通过试验验证本文算法在识别准确率和算法计算时间复杂度方面的性能。

3.1 试验数据预处理

首先对采集的视频通过回放观察法进行分拣整理,截取正常奶牛与跛足奶牛的视频进行人工分类标记;然后从收集到的正常奶牛和跛足奶牛的行走视频中,取出1 000个正常步态视频和50个跛足行为视频,其中50个跛足行为视频是经过专业人员进行人工确认和标注后获取,且均为轻中度跛足。由于跛足异常样本在视频采集时间范围内获取困难,主要是由于现代规模化养殖场对于家畜疾患的及时有效人工干预,异常跛足样本数量较少。因此为有效解决类间样本不平衡问题,试验中采用重采样方法对50个跛足源视频进行预处理获取200个跛足行为变尺度视频。其中预处理采用如下方式:即影像明暗度变化(模拟不同气象条件下采光问题)、影像适度尺度拉伸与旋转(模拟监测个体可能出现多视角问题)以及视频帧重采样重构视频(模拟行为变时长问题)。共计1 200个视频作为奶牛行为样本,通过10折交叉验证得到分类模型,视频的时长为10 s,帧速率为25帧/s,表1为试验视频的详细信息。

表1 试验视频信息

3.2 试验设计

3.2.1算法框架的有效性验证

为验证本文识别算法框架的有效性,对比其他4种识别算法框架进行10折交叉验证结果取均值进行分析。CGP-KSVD算法初始参数设定,随机初始词典0,词典规模为256,初始样本抽取特征集0=,0=,0=rand(0,1),01。其他4种算法包括,经典稀疏编码方法LLC(Locality-constrained linear coding)[46]和K-SVD[37,47],其中算法参数设定依据引用文献中算法框架初始化设定。另外2种算法框架采用本文提出的全局时空兴趣点(Sptia-temporal interesting poing, STIP)和稠密轨迹图提取时空兴趣点的融合方式作为LLC和K-SVD的底层特征输入,本文融合特征简记为fusion STIP+HOG。

3.2.2 算法小样本泛化性能验证

在实际养殖生产环节,家畜异常行为样本获取是制约机器视觉及其相关技术应用的主要因素,因此本节设定不同规模样本训练集验证本文算法框架有效性。训练样本1 000个正常步态和50个跛足行为一致性采样下,依次随机选择50个、70个和100个视频,采用5折交叉验证,完成5轮25次试验取均值。

3.3 数据集构建

10折交叉验证样本构建方式,首先从1 000个正常奶牛和200个跛足奶牛行走视频中随机一致性[48]构建训练和测试集,训练和测试样本构成方式为{100(P)+100(N)}/组,P表示正常行为,N表示跛足行为,其中正常行为1 000个视频样本等分为10份,200个跛足视频样本等分成2份分别与1 000个正常样本重采样结合。5折交叉验证样本构建方式,以100个样本规模为例,首先将1 000个正常步态行为视频分成5个200(P)/组,然后分别与200个跛足步态视频经随机一致性采样{10(P)+10{N}}/组构成5折验证的1个视频,样本结构如图4所示。

注:P表示正常行为,N表示跛足行为。

3.4 评价指标

试验分别从准确率(Accuracy),查准率(Precision),查全率(Recall)等分类器性能指标来进行评价。

Accuracy=(TP+TN)/(11)

Precision=TP/(TP+FP) (12)

Recall=TP/(13)

其中TP为正确分类的正例个数,TN为正确分类的负例个数,FP为错误分类的正例个数,FN为错误分类的负例个数,实际正例个数可表示为

=TP+FN (14)

实际负例个数可表示为

=FP+TN (15)

实例总数可表示为

=+(16)

3.5 结果与分析

3.5.1算法框架的有效性验证结果

试验最终对比结果如表2所示,图5为对比算法的PR曲线。

表2 算法识别率对比

在对比试验中,本文提出的CGP-KSVD算法框架识别准确率比经典稀疏编码方法LLC[46]高出5.5个百分点,对比K-SVD[37,47]高出3.9个百分点,以本文提出的融合特征fusion SITP+HOG作为LLC和K-SVD的底层特征输入,试验结果显示本文提出的识别框架在平均识别精度上依次高出3.8和1.4个百分点。对于本文算法高识别精度的试验结果进行分析,也可以得出如下结论,即由于视频样本的数量限制,以及为有效消除样本不均衡问题所采用的重采样方法也带来过拟合问题,因此使得本文算法的识别精度稳定在100%。但是从试验对比结果仍然可以验证本文算法通过特征融合增加行为描述的细节特征信息,以及采用优化稀疏编码和词典学习框架对于解决二分类问题,提升整体识别精度的具有重要的意义。

图5 五种算法PR曲线

3.5.2 算法小样本泛化性能验证结果

在1 200个视频样本中,随机顺次选择50个、70个和100个视频,采用5折交叉验证试验结果取均值。识别结果如表3所示。

试验结果表明,本文提出的方法在小训练集下的识别准确率为91.6%(训练样本数为50个),随着训练样本数的增加(训练样本数为100个),识别准确率达到98.7%。

3.5.3 算法时间复杂度对比分析

为验证分析本文提出CGP-KSVD算法在计算时间复杂度上的有效性,分别对比经典算法BP和OMP在1范数约束下计算时间复杂度,理论计算值如表4所示。

表3 小样本试验结果

表4 3种算法计算时间复杂度

注:表示词典规模,即词典所含单词数量,为样本维度。

Note:represents the size of the dictionary, that is, the number of words contained in the dictionary, andas the sample dimension.

在1200个视频时长为10 s,25 p/s的视频集上随机选择50个视频,测试算法响应时间,其中词典规模依次设定为=256、512、1024,对比算法响应时间和识别准确率计算结果如表5所示。

表5 三种算法执行时间对比和识别精度

从试验结果可以看出,CGP-KSVD算法平均响应时间最短为0.043 s,对比基于凸优化的BP-KSVD和基于贪婪搜索算法的OMP-KSVD分别快1.11和0.199 s。从算法识别精度上,BP-KSVD算法优于后两者,平均识别精度达到95%,分别高于OMP-KSVD算法2.5个百分点,CGP-KSVD算法1.9个百分点,CGP-KSVD计算精度高于经典词典学习算法OMP-KSVD[37,47]算法0.6个百分点。

综上试验结果,本文算法在不太损失识别精度的前提下算法响应速度更为优异。分析上述差异原因在于BP-KSVD算法其凸优化求解思想尽管带来的高识别精度,但是对比迭代优化算法OMP-KSVD和CGP-KSVD,其算法响应时间明显滞后,另外同是贪婪迭代算法的CGP-KSVD由于采用共轭梯度寻优搜索路径,因此其不论从算法响应时间到识别精度都要优于仅是采用共轭残差匹配的OMP-KSVD算法。

3.5.4 算法在线实时性验证

为验证本文算法在线识别性能,将采集自2016年5月至2016年6月时长为90 h用于训练测试的视频进行回放测试(奶牛30 000头)。将采集自2017年5月至2017年6月时长为90 h的视频进行在线测试,该段视频未用于算法的预训练。上述回放视频和在线视频均使用视频拼接方式获取,去除不利天气条件如雨天等因素下的视频片段。对比BP-KSVD和OMP-KSVD进行比较分析,以fusion STIP+HOG作为3种算法的特征输入。对比试验结果如表6所示。

表6 CGP-KSVD算法在线检测识别精度

注:2016、2017年经人工识别跛足奶牛头次分别为15和14头。

Note:In 2016 and 2017, the number of lame cows was 15 and 14 respectively.

试验结果显示,在回放视频和在线视频测试上本文提出的CGP-KSVD算法均获得较高的识别率,分别为93.3%和92.7%,对比BP-KSVD和OMP-KSVD算法分别高出33.3、13.3个百分点和35.6、14.1个百分点,显示本文提出算法框架具有较高的识别准确性。同时本文提出的CGP-KSVD算法对比回放视频和在线视频识别准确率仅相差0.6个百分点,分析其原因在于回放视频部分视频样本应该在算法的预训练阶段出现过,因此相对识别率较高,但是仍然验证本文算法具有较好的稳定性。另外,BP-KSVD算法在分阶段训练和测试中均获得高于CGP-KSVD算法的识别准确率,但是在回放和在线视频测试过程中,其准确率分别低33.3和35.6个百分点,分析其原因在于对比分阶段样本测试,回放和在线长时视频测试需要算法具有较高的时间响应度,而BP-KSVD算法自身计算时间复杂度较高,因此识别率较低。

4 结 论

本文提出的奶牛跛足行为识别算法框架涉及一种基于共轭梯度追踪算法的稀疏超完备词典学习算法用于跛足行为特征的语义级描述和表示,以及一种融合时空兴趣点与稠密轨迹图二次提取时空兴趣点的视频底层特征提取和表示方法。对比试验结果显示,在1 200个视频样本上,本文提出的CGP-KSVD算法框架识别率比经典稀疏编码方法LLC(locality-constrained linear coding)高5.5 个百分点,对比K-SVD高3.9个百分点,对比LLC fusion SITP+HOG和K-SVD fusion SITP+HOG平均识别精度上依次高3.8和1.4个百分点。

对比算法计算时间复杂度,采用{fusion STIP+HOG}作为行为特征,在不同规模词典上CGP-KSVD算法平均响应时间为0.043 s,对比BP-KSVD和OMP-KSVD分别快1.11和0.199 s。从算法识别精度上,BP-KSVD平均识别精度达到95%,分别高于OMP-KSVD算法2.5个百分点,CGP-KSVD算法1.9个百分点,CGP-KSVD计算精度高于经典词典学习算法OMP-KSVD算法0.6个百分点。

对比长时视频测试算法的在线性试验中,在回放视频和在线视频测试上本文提出的CGP-KSVD算法均获得较高的识别率,分别为93.3%和92.7%,对比BP-KSVD和OMP-KSVD算法分别高出33.3、13.3个百分点和35.6、14.1个百分点。

[1] Martiskainen P, Järvinen M, Skön J P, et al. Cow behaviour pattern recognition using a three-dimensional accelerometer and support vector machines[J]. Applied Animal Behaviour Science, 2009, 119(1): 32-38.

[2] Chapinal N, Passillé A M D, Pastell M, et al. Measurement of acceleration while walking as an automated method for gait assessment in dairy cattle[J]. Journal of Dairy Science, 2011, 94(6): 2895-2901.

[3] Thorup V M, Munksgaard L, Robert P E, et al. Lameness detection via leg-mounted accelerometers on dairy cows on four commercial farms[J]. Animal An International Journal of Animal Bioscience, 2015, 9(10): 1704-1712.

[4] Cornou C, Lundbye-Christensen S, Kristensen A R. Modelling and monitoring sows’ activity types in farrowing house using acceleration data[J]. Computers & Electronics in Agriculture, 2011, 76(2): 316-324.

[5] 郭东东. 基于三轴加速度传感器的山羊行为特征识别研究[D].太原:太原理工大学,2015.Guo Dongdong. Research on 3D Acceleration Sensor Recognition for Goats'Behavior Recognition[D].Taiyuan: Taiyuan University of Technoloy, 2015. (in Chinese with English abstract)

[6] Viazzi S, Bahr C, Hertem T V, et al. Comparison of a three-dimensional and two-dimensional camera system for automated measurement of back posture in dairy cows[J]. Computers & Electronics in Agriculture, 2014, 100(1): 139-147.

[7] Stavrakakis S, Li W, Guy J H, et al. Validity of the Microsoft Kinect sensor for assessment of normal walking patterns in pigs[J]. Computers & Electronics in Agriculture, 2015, 117(C): 1-7.

[8] 温长吉,王生生,赵昕,等. 基于视觉词典法的母牛产前行为识别[J]. 农业机械学报,2014,45(1):266-274. Wen Changji, Wang Shengsheng, Zhao Xin, et al. Visual dictionary for cows sow behavior recognition[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(1): 266-274. (in Chinese with English abstract)

[9] 赵凯旋,何东健.基于卷积神经网络的奶牛个体身份识别方法[J]. 农业工程学报,2015,31(5):181-187.Zhao Kaixuan, He Dongjian. Recognition of individual dairy cattle based on convolutional neural networks[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2015, 31(5): 181-187. (in Chinese with English abstract)

[10] 于欣,侯晓娇,卢焕达,等. 基于光流法与特征统计的鱼群异常行为检测[J]. 农业工程学报,2014,30(2):162-168.Yu Xin, Hou Xiaojiao, Lu Huanda, et al. Anomaly detection of fish school behavior based on features statistical and optical flow methods[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2014, 30(2): 162-168. (in Chinese with English abstract)

[11] 劳凤丹,滕光辉,李军,等. 机器视觉识别单只蛋鸡行为的方法[J]. 农业工程学报,2012,28(24):157-163.Lao Fengdan, Teng Guanghui, Li Jun, et al. Behavior recognition method for individual laying hen based on computer vision[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2012, 28(24): 157-163. (in Chinese with English abstract)

[12] 郁厚安,高云,黎煊,等. 动物行为监测的研究进展——以舍养商品猪为例[J]. 中国畜牧杂志,2015,51(20):66-70.Yu Houan, Gao Yun, Li Xuan, et al. Research progress of animal behavior monitoring: A case study of commercial pigs[J].Chinese Journal of Animal Science, 2015, 51(20): 66-70. (in Chinese with English abstract)

[13] Laptev I. On space-time interest points. IJCV[J]. International Journal of Computer Vision, 2005, 64(2): 107-123.

[14] Willems G, Tuytelaars T, Gool L V. An efficient dense and scale-invariant spatio-temporal interest point detector[C]// European Conference on Computer Vision. Springer-Verlag, 2008: 650-663.

[15] Rapantzikos K, Avrithis Y, Kollias S. Dense saliency-based spatiotemporal feature points for action recognition[C]// Computer Vision and Pattern Recognition, 2009. CVPR 2009. IEEE Conference on. IEEE, 2009: 1454-1461.

[16] Dollar P, Rabaud V, Cottrell G, et al. Behavior recognition via sparse spatio-temporal features[C]// Joint IEEE International Workshop on Visual Surveillance and PERFORMANCE Evaluation of Tracking and Surveillance. IEEE, 2006: 65-72.

[17] Darrell T, Demirdjian D, Checka N, et al. Plan-view trajectory estimation with dense stereo background models[C]// Computer Vision, 2001. ICCV 2001. Proceedings. Eighth IEEE International Conference on. IEEE, 2001:628-635.

[18] Wang H, Kläser A, Schmid C, et al. Action recognition by dense trajectories[C]// Computer Vision and Pattern Recognition. IEEE, 2011: 3169-3176.

[19] Klaser A, Marszałek M, Schmid C. A spatio-temporal descriptor based on 3D-gradients[C]//BMVC 2008-19th British Machine Vision Conference. British Machine Vision Association, 2008.

[20] Hinton G E. Learning multiple layers of representation[J]. Trends in Cognitive Sciences, 2007, 11(10): 428-434.

[21] Deng L, Yu D. Deep learning: Methods and applications[J]. Foundations & Trends in Signal Processing, 2014, 7(3): 197-387.

[22] Schmidhuber J. Deep learning in neural networks: An overview[J]. Neural Netw, 2015, 61: 85-117.

[23] Davis G, Mallat S, Avellaneda M. Adaptive greedy approximations[J]. Constructive Approximation, 1997, 13(1): 57-98.

[24] Tropp J A. Greed is Good: Algorithmic results for sparse approximation[J]. IEEE Transactions on Information Theory, 2004, 50(10): 2231-2242.

[25] Chen S S, Donoho D L, Saunders M A. Atomic decomposition by basis pursuit. Reprinted from SIAM J. Sci. Comput. 20[J]. Siam Review, 2001(1): 129-159.

[26] 聂静,苏东林,李红裔,等. 电路测试响应信号的GP-KSVD稀疏重构算法[J]. 北京航空航天大学学报,2017,43(7):1336-1347.Nie Jing, Su Donglin, Li Hongyi, et al. Circuitry test response signal reconstruction based on GP-KSVD algorithm[J].Journal of Beijing University of Aeronautics and Astronautics, 2017, 43(7): 1336-1347. (in Chinese with English abstract)

[27] Rosen J B. The Gradient Projection Method for Nonlinear Programming. Part I. Linear Constraints[J]. Journal of the Society for Industrial & Applied Mathematics, 1961, 9(4): 514-532.

[28] Blumensath T, Davies M E. Gradient Pursuits[J]. IEEE Transactions on Signal Processing, 2008, 56(6): 2370-2382.

[29] Mallat S G, Zhang Z. Matching pursuits with time-frequency dictionaries[J]. IEEE Trans on Signal Processing, 1993, 41(12): 3397-3415.

[30] Schuldt C, Laptev I, Caputo B. Recognizing human actions: A local SVM approach[C]// International Conference on Pattern Recognition. IEEE, 2004: 32-36.

[31] Zhu Y, Zhao X, Fu Y, et al. Sparse coding on local spatial-temporal volumes for human action recognition[C]// Computer Vision - ACCV 2010 -, Asian Conference on Computer Vision, Queenstown, New Zealand, November 8-12, 2010, Revised Selected Papers. DBLP, 2011: 660-671.

[32] Heng Wang, Alexander Kläser, Cordelia Schmid, et al. Dense trajectories and motion boundary descriptors for action recognition[J]. International Journal of Computer Vision, 2013, 103(1): 60-79.

[33] Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]// IEEE Computer Society Conference on Computer Vision & Pattern Recognition. IEEE Computer Society, 2005: 886-893.

[34] Tang Y Y, Yuan H. Manifold-based sparse representation for hyperspectral image classification[M]// Handbook of Pattern Recognition and Computer Vision(5th Edition) :331-350.

[35] Yang M, Zhang L, Feng X, et al. Sparse representation based fisher discrimination dictionary learning for image classification[J]. International Journal of Computer Vision, 2014, 109(3): 209-232.

[36] Donoho D L. For most large underdetermined systems of linear equations the minimal1-norm solution is also the sparsest solution[J]. Communications on Pure & Applied Mathematics, 2010, 59(6): 797-829.

[37] Aharon M, Elad M, Bruckstein A. K-SVD: An algorithm for designing overcomplete dictionaries for sparse represent- tation[J]. IEEE Transactions on Signal Processing, 2006, 54(11): 4311-4322.

[38] Wang L, Lu K, Liu P, et al. IK-SVD: Dictionary learning for spatial big data via incremental atom update[J]. Computing in Science & Engineering, 2014, 16(4): 41-52.

[39] Souza F D M D, Chávez G C, Jr E A D V, et al. Violence detection in video using spatio-temporal features[C]// Graphics, Patterns and Images. 2011: 224-230.

[40] Nievas E B, Suarez O D, García G B, et al. Violence detection in video using computer vision techniques[C]// International Conference on Computer Analysis of Images and Patterns. Springer-Verlag, 2011: 332-339.

[41] Hassner T, Itcher Y, Kliper-Gross O. Violent flows: Real-time detection of violent crowd behavior[C]// Computer Vision and Pattern Recognition Workshops. IEEE, 2012: 1-6.

[42] Wang T, Snoussi H. Detection of abnormal visual events via global optical flow orientation histogram[J]. Information Forensics and Security, IEEE Transactions on, 2014, 9(6): 988-998.

[43] Shi F, Petriu E, Laganiere R. Sampling strategies for real-time action recognition[C]// IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer

[44] Society, 2013: 2595-2602.

[45] Barla A, Odone F, Verri A. Histogram intersection kernel for image classification[J]. Icip, 2003, 2: 513-516.

[46] Swain M J, Ballard D H. Color indexing[J]. International Journal of Computer Vision, 1991, 7(1): 11-32.

[47] Wang J, Yang J, Yu K, et al. Locality-constrained linear coding for image classification[C]// IEEE Computer Society Conference on Computer Vision & Pattern Recognition IEEE Computer Society Conference on Cvpr. 2010: 3360-3367.

[48] Qiu Q, Jiang Z, Chellappa R. Sparse dictionary-based representation and recognition of action attributes[C]// IEEE International Conference on Computer Vision. IEEE, 2011: 707-714.

[49] Torr P H S, Murray D W. The development and comparison of robust methods for estimating the fundamental matrix[C]// International Journal of Computer Vision, 1997: 271–300.

Behavior recognition of lameness in dairy cattle by improved sparse overcomplete dictionary method

Wen Changji1, Zhang Jinfeng1,2, Li Zhuoshi1,3, Lou Yue1, Yu Helong1※, Jiang Hailong4

(1.,,130118,; 2.,,130607,; 3.,,130012,; 4.,,130118,)

It is the key to prevent and control dairy cow diseases by real-time monitoring and detection of abnormal behavior early. In this field, it is the most common for the detection and recognition of lame behavior especially. However, the technology of the livestock abnormal behavior recognition is still facing the problem of poor real-time performance. Regarding the above problems, 2 improvement strategies were proposed in this paper. Firstly, a sparse overcomplete dictionary learning algorithm based on conjugate gradient pursuit-KSVD (CGP-KSVD) algorithm was proposed which was used to description and representation of lame behavioral semantic features.The proposed idea was to optimize search direction in the stage of sparse coding construction though introducing a conjugate gradient pursuit algorithm. Meanwhile, the proposed method could avoid the computational load caused by storing and calculating large-scale Hessen matrix effectively. By this way, it achieved the high convergence speed of the sparse overcomplete dictionary learning. Secondly, the basic features of representing the videos were extracted by the fusion of spatio-temporal interest points and spatio-temporal interest points extracted in the dense trajectory map. With the proposed method, it is possible to reduce the redundancy features and the computational load while retaining the rich details. To verify the proposed algorithm, we designed 3 experiments. Experiment 1 was used to achieve the recognition accuracy by comparing the proposed algorithm with the classical sparse dictionary learning algorithms. Experiment 2 and Experiment 3 were used to study the efficiency of the algorithm. In the experiments, 500 black and white adult cows were selected randomly and a total of 1200 video samples were achieved for training and testing by the manual marks. In Experiment 1, the average accuracy of the algorithm proposed in this paper is 5.5 percentage points higher than that of LLC (locality-constrained linear coding) and 3.9 percentage points higher than that of K-SVD. The fusion feature proposed in this paper was used as the basic features of LLC and K-SVD and the above methods were recorded as LLC + fusion feature and K-SVD + fusion feature. The experiment results show that the average accuracy of the proposed algorithm is 3.8 and 1.4 percentage points higher than that of LLC + fusion feature and K-SVD + fusion feature, respectively. In Experiment 2 and 3, the theoretical analysis results show that the algorithm proposed in this paper has the lowest computational time complexity, and the average response time of the CGP-KSVD algorithm is 0.043 s, faster than the 2 other algorithms, BP-KSVD (basis pursuit-KSVD) and OMP-KSVD (orthogonal matching pursuit-KSVD). And the 90-hour video test results show that the CGP-KSVD algorithm has the highest recognition rates of 93.3% and 92.7% respectively with the playback video and online test video, which are increased by 33.3 and 35.6 percentage points compared with the BP-KSVD algorithm, and 13.3 and 14.1 percentage points compared with the OMP-KSVD algorithm.

image processing; algorithms;Livestock breeding; lame recognition; CGP-KSVD; Spatio-temporal interest point; dense trajectory

10.11975/j.issn.1002-6819.2018.18.027

S275.6

A

1002-6819(2018)-18-0219-09

2018-05-11

2018-08-22

国家重点研发技术专项(2017YFD0502001、2018YFF0213606);国家自然科学基金面上项目(11372155、61472161);吉林省自然科学基金(20180101041JC);吉林省教育厅科研规划重点课题(2016186)

温长吉,男(汉),吉林长春人,副教授,工学博士,研究方向为模式识别、农业信息化。Email:chagou2006@163.com

于合龙,男(汉),吉林长春人,教授,工学博士,研究方向为机器视觉、农业物联网工程。Email:264496469@qq.com

温长吉,张金凤,李卓识,娄 月,于合龙,姜海龙. 改进稀疏超完备词典方法识别奶牛跛足行为[J]. 农业工程学报,2018,34(18):219-227. doi:10.11975/j.issn.1002-6819.2018.18.027 http://www.tcsae.org

Wen Changji, Zhang Jinfeng, Li Zhuoshi, Lou Yue, Yu Helong, Jiang Hailong. Behavior recognition of lameness in dairy cattle by improved sparse overcomplete dictionary method[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(18): 219-227. (in Chinese with English abstract) doi: 10.11975/j.issn.1002-6819.2018.18.027 http://www.tcsae.org