视觉与激光雷达信息融合的目标领航车识别方法*

2018-07-13贾子永任国全李冬伟程子阳

贾子永,任国全,李冬伟,程子阳

(陆军工程大学石家庄校区,石家庄 050003)

0 引言

随着智能无人系统技术的发展,军用地面无人平台自主跟随相关技术研究工作备受关注。军用地面无人平台自主跟随指的是在编队环境下车辆领航-跟随的行车模式,主要用于战场环境下编队行军过程中的车辆引导-多车自主跟随的行军模式,有效减轻士兵长途驾驶的负担。军用地面无人平台自主跟随系统主要研究内容包括:领航车辆的识别和定位、跟随车辆的控制和局部路径规划等。

军用地面无人平台自主跟随系统中领航车辆状态检测识别,是跟随地面无人平台自主驾驶的基础和前提。多种传感器用于车辆的检测,包括摄像机[1]、激光雷达[2]、超声波[3]、红外摄像机和立体摄像机[4]。 Sun Z H 等[5]全面阐释了基于视觉的车辆检测方法。文献[6-7]均提出利用Haar特征对车辆进行识别,然后利用积分图像对是否为车辆进行判断。利用视觉检测车辆主要依靠车辆的颜色、纹理、梯度等特征对行驶中的车辆进行识别,该方法获取信息量大,识别精度高,有效地降低了车辆的误检率。但是基于图像的车辆检测得不到检测车辆相对摄像机的深度信息,且车辆行驶速度快,所拍摄的照片较模糊,对视觉算法的实时性要求较高。文献[8-9]利用激光雷达的扫描数据对车辆的行驶进行监控,分析车辆在激光雷达数据的形状变化,再利用SVM分类方法进行车辆识别。但是此方法紧靠激光雷达扫描形成的形状很难准确判断出目标是否为车辆。鉴于单一传感器不能同时满足车辆的准确定位和准确辨识,文献[10]利用毫米波雷达和视觉融合对车辆进行检测,取得了较好的效果,但毫米波雷达由于波长的差别,其测距精度和成像能量不如激光雷达,只能应用到简单环境中。

军用地面无人平台常用于非标准道路条件下,应用环境复杂,目标车辆检测难度高。领航车辆检测识别过程中,跟随车辆周围环境中存在着目标领航车辆用于引导跟随车辆自主控制,也可能存在着其他车辆、丛林、行人、岩石等背景数据干扰目标车辆的检测识别。传感器获得的数据主要包括3类:目标领航车辆数据、背景数据和噪声干扰。为快速实时地把目标车辆从背景中区别开来,准确检测出目标领航车辆所在的位置,本文结合激光雷达能够精确获取目标的距离与角度信息,摄像机能够获取目标的颜色和梯度信息。设计了基于激光雷达和摄像机传感器信息融合的目标领航车辆检测识别系统。利用激光雷达确定假设目标的初始位置,然后利用图像处理提取假设目标对称性、角点特征的参数,最终对假设目标进行多特征级联分类识别方法进行验证。

1 传感器的安装和联合标定

1.1 传感器的型号及安装

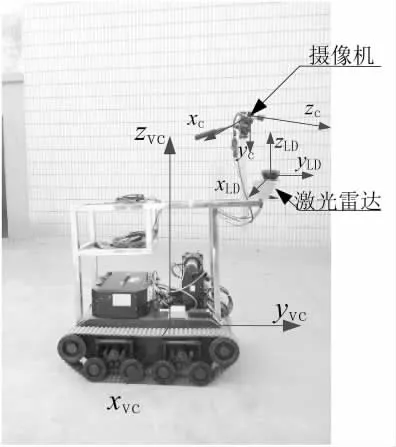

激光雷达和摄像机用于感知跟随车辆周围环境,采集车辆行驶环境的信息,本实验选用LMS151型激光雷达,其最大测量距离为50 m,角度分辨率为0.25°,扫描频率为25 Hz。摄像机分辨率为1 294×964,镜头的焦距为6 mm。实验选用的目标领航车辆为实验室中型差速履带车,跟随车辆选用的是一辆小型履带车。激光雷达固定于跟随车辆的正前方且居中,摄像机利用二轴云台固定在激光雷达上方,激光雷达和摄像机左右方向两者大致重合,激光雷达在摄像机的前方,如图1所示。

图1 激光雷达、摄像机安装位置图

1.2 激光雷达和摄像机的联合标定

为了确定激光雷达数据和摄像机空间对应关系,需要对激光雷达和摄像机进行联合标定。摄像机和激光雷达与车体刚性连接,两者与车体的相对姿态和位移固定不变。任意的激光雷达扫描点,在车体坐标系中存在唯一的点与之对应,在摄像机图像中也存在唯一的一个像素点与之对应。因此,对于在摄像机视角范围内的激光雷达扫描点,在图像像素坐标系中都存在一个像素点与之对应。

本实验选用梯形棋盘格标定板对激光雷达和摄像机进行联合标定,利用激光雷达在梯形板上的扫描信息,获取激光雷达安装的俯仰角和安装高度,利用梯形棋盘格上的黑白棋盘格标定出摄像机的内外参数,详解过程见文献[11]。得到激光雷达数据到摄像机图像像素之间的对应变换关系为:

其中:(u,v)表示图像像素坐标;fx和fy分别为x方向和y方向的等效焦距;(u0,v0)为图像像素中心的坐标。Rveh→cam为 3×3 的坐标旋转矩阵,Tveh→cam为 1×3坐标平移矩阵。(ρn,θn)表示在极坐标下激光雷达扫描点的距离和角度;δ为激光雷达安装的俯仰角;h为激光雷达安装的高度。

2 基于激光雷达数据感兴趣区域的确定

2.1 激光雷达数据预处理及假设目标的确立

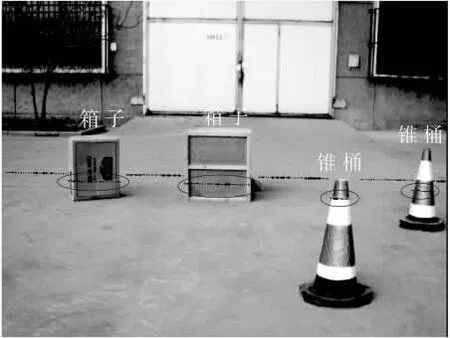

将激光雷达原始目标数据投影到图像中,得到激光雷达数据和摄像机图像的像素级融合,融合效果如图2所示。图中黑色点集为激光雷达扫描点映射到图像的结果,黑色椭圆圈出的是激光雷达点融合到对应的物体上的融合点。由图可以看出,如果把激光雷达原始数据直接融合到图像中,即包含激光雷达探测到的锥桶、地面、纸箱等信息也包含激光雷达扫描到的地面等噪声,为了减小噪声的干扰和确定假设目标的个数,需要对激光雷达数据进行预处理。

图2 激光雷达和图像的像素级信息融合效果图

为了从激光雷达数据中分析得到周围目标的外形特征,需要对激光雷达的数据进行分割和聚类处理。激光雷达根据设定的角度分辨率,对环境进行连续扫描,连续障碍物返回点比较密集、非连续障碍物之间存在较大的间隙,根据这一特点对激光雷达数据进行最近邻域法聚类分析。最近邻域法聚类的主要思想是把第1个数据点作为第1组的聚类中心,若下一个点到该点的距离小于聚类半径R则为同一物,则把这个数据放到这个组中并更新为新的聚类中心,否则把数据作为新一组的聚类中心。聚类算法如式(2):

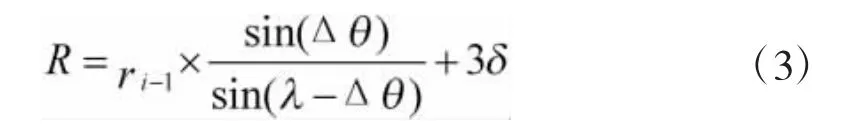

其中,ρi为当前扫描的距离,ρi-1为前一扫描检测点的距离,R为分割半径。如果式(2)成立,则两个扫描点为同一障碍物。其中,聚类半径R根据每个激光反射点的距离而自适应变化,R为:

式中,ri-1为ρi和ρi-1的最小值,σ为余量。实验时,取λ=10,σ=0.03 m。

激光雷达数据聚类分析后,提供了清晰的环境信息。周围物体表示方式为(x,y,z,w),其中(x,y,z)表示激光雷达聚类点的中心点,w表示聚类的宽度。由先验知识可以确定目标引导车辆在激光雷达成像聚类后的宽度为1.5 m,为了防止漏检和虚检,扩大目标领航车辆检测的阈值范围为(1.3 m,1.7 m)。如果目标在激光雷达的聚类结果满足阈值条件则假设该物体为假设目标,否则判断该物体为障碍物,可以有效地剔除与目标引导车辆差别较大的障碍物或者非目标车辆。

2.2 自适应感兴趣窗口的选取

车辆识别感兴趣区域的确定包括区域位置和区域大小的确定,激光雷达数据聚类预处理确定假设目标的中心位置和类的宽度(x,y,z,w)。由于车辆在加减速、弯道行驶和经过起伏路面时,会造成悬架和轮胎的变形,导致摄像头的外参数发生变化。为了保证感兴趣窗口能够完整地包含假设目标,同时也要保证系统处理的实时性,提出了自适应感兴趣窗口的确立方法。

理论上预处理后的激光雷达目标映射到图像中,中心点位于图像目标轮廓中心,因此,把该点作为车辆识别感兴趣区域的中心。目标领航车辆的实际高度可以通过先验知识测量得到为0.8 m,通过车辆的中心点、宽度和高度进行扩展而形成假设目标感兴趣区域。中心点向其左右两边各扩展5/6个宽度w,向上向下扩展1个高度h。利用透视原理将该区域投影到图像中,得到像素尺寸为m×n,中心为O的矩形图像窗口,如下页图3所示。图3中,方框内代表假设目标感兴趣区域的选定,可以看出该窗口足以容纳车辆在图像中的投影。

图3 感兴趣区域的选取

3 基于特征的目标领航车辆识别与验证

3.1 感兴趣区域预处理

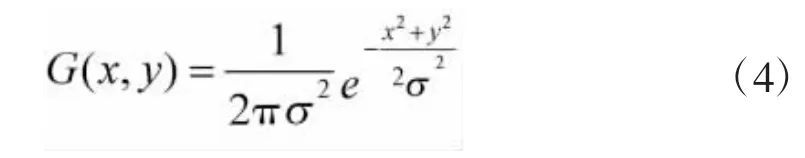

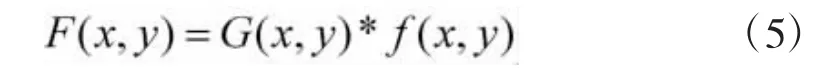

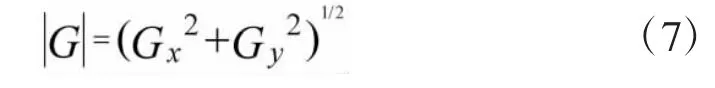

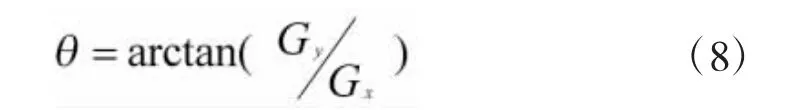

图3中的履带车辆为本实验检测的目标领航车辆,观察其尾部,如果直接利用灰度图像进行分析,可能造成精度低,运算量大。Canny算子是一个经典的轮廓提取算子,具有自适应功能。通过两个相关的阈值来确定边缘点,通过高阈值定位边缘区域,并利用低阈值找出边缘线的边缘点。实际应用中,Canny边缘提取算子主要的步骤为:

1)对图像进行高斯滤波,把二维高斯函数

与原始图像进行卷积:

以消除噪声;

2)利用Sobel算子进行边缘提取,采用3×3区域模板:

进行卷积近似求沿x,y两个方向偏导数Gx,Gy,并求出该点梯度值大小:

计算梯度方向:

3)梯度方向上进行极大值抑制;

4)设定两个阈值精确定位图像的边缘位置。

对目标领航车辆进行Canny算子边缘提取效果如图4所示。

图4(a)显示的是局部感兴趣区域窗口,图 4(b)为进行Canny算子之后的二值化图像。由于边界较模糊,遂对其进行膨胀,效果如图4(c)。

图4 Canny算子提取的目标领航车辆边缘

3.2 目标领航车辆车辆特征提取

1)对称性检测。车辆轮廓的左右对称性可以帮助对车辆的识别,排除非对称物体的干扰。图像在Canny算子处理后得到二值化边界图像,基于区域垂直边缘[7]和左半边和右半边两部分的关系,对称性特征值为:

其中:w 为图像的宽度;h 为图像的高度;I(i,j)表示垂直边缘图中坐标为(i,j)处的像素值;φ为像素差值的阈值,由经验可知,对称特征值越大,对称性越好。

2)角点检测。角点是反应图像信息的重要特征。Harris角点提取算法主要利用水平、竖直差分算子对图像每个像素进行滤波,求得水平与竖直的灰度梯度Ix和Iy,进而得到矩阵:

对矩阵m中的4个元素进行高斯滤波处理。利用新的m,计算每个像素的角点量,如果角点量大于阈值且角点量是某邻域内的局部极大值的点被认为是角点。

利用Harris角点提取方法,提取感兴趣窗口内车辆上的角点个数,得到感兴趣区域内的角点个数为N,则角点特征值为:

式中,w为感兴趣局部窗口的像素宽度;h为感兴趣局部窗口的像素高度;Pconern代表角点的特征值。

3.3 多特征级联分类识别验证目标领航车辆

多特征级联分类识别目标领航车辆是将一系列单级分类器级联起来,在车辆检测过程中保证较高检测率的情况下尽可能降低误检率,流程如图5所示。该结构将一系列单级分类器级联起来,当被判断为非目标领航车辆时,该目标窗口立即被排除。多特征级联分类识别过程中,由于车辆目标领航车辆在图像中只占很小的一部分,利用激光雷达初步筛选出假设目标,剔除了大量的背景图像和与车辆外形区别较大的障碍物目标,提高了后续车辆检测速度。依据车辆尾部的对称性缩小检测范围,排除岩石等非对称物体。由于车辆尾部的角点数不随车辆的远近改变而改变,最终利用提取出的车辆尾部角点数对其进行最终判断。如果感兴趣区域图像逐级满足条件即判断假设目标为目标领航车辆,否则为障碍物。

图5 多特征级联分类目标领航车辆流程图

4 车辆识别结果

本文利用4个指标来直观地表示目标领航车辆算法精度:检测率,表示不同时间和场景准确检测到车辆数目占实验次数的百分比;漏检率,表示没有被检测到的车辆数目占总实验次数的百分比;误检率,表示被错误检测到的车辆占总实验次数的百分比,算法运行时间。实验与其他两种方法进行对比,方法1[9]利用车底阴影区域确定车辆感兴趣区域并对感兴趣区域进行多特征级联分类方法;方法2[10]利用激光雷达确定车辆的感兴趣区域但对图像特征并行运算,给予特征值不同的权重。实验采集不同时间和工况下的500帧数据对其统计分析,对算法运行时间进行统计,得到算法运行的平均时间,统计分析的结果见表1。从表中可以看出本方法在目标领航车辆检测的准确性方面高于方法1,在检测的实时性方面高于方法2,说明该方法满足检测目标领航车辆的准确性和实时性的要求[11-15]。

表1 不同方法目标领航车辆检测方法

5 结论

本文提出了一种基于摄像机和激光雷达信息融合检测识别目标领航车辆的方法,利用激光雷达确定假设目标,根据激光雷达的数据自适应确定感兴趣区域窗口的大小。根据感兴趣区域窗口的对称性特征值、角度特征值,利用多特征级联分类识别方法对目标领航车辆与跟随车辆环境进行区分。实验结果表明,该方法在不同的工况和光照条件具有较好的适应性和准确性。本文只对目标领航车辆的检测展开研究,在后期的研究中将基于目标领航车辆检测结果的车辆跟随研究。