基于双目立体视觉的取走物检测技术研究

2018-06-20张爱升张艳彬

张爱升,张艳彬

(南京邮电大学 通信与信息工程学院,江苏 南京 210003)

0 引 言

随着计算机视觉技术的快速发展,各种先进的视频序列处理技术被应用到视频监控领域,在一定程度上能够保障财产的安全。目前,在视频监控领域中,人们大多通过在RGB图像中进行前景检测来对场景中的物品进行监控[1],这种方法基于背景建模的取走物检测方法,但有些取走物检测方法只能对划定好的感兴趣区域进行监控,不够智能化。同时其抗干扰性较差,检错率较高。

立体双目视觉技术是一种非常实用的计算机视觉技术,利用两个摄像头捕捉同一场景的画面,能够计算出图像中的深度信息。双目立体视觉技术能够提取深度信息,这为取走物检测方法提供了新的思路。目前,双目立体视觉技术不仅广泛应用于三维测量及工业测量距离[2]等领域,而且在目标跟踪[3]、行人检测[4-5]等视频监控领域也应用广泛,但关于取走物检测的研究比较欠缺。

对此,文中提出了基于双目立体视觉技术的取走物检测方法,通过RGB图像信息结合深度图像信息判断室内物品的状态,对物品进行监控。在取走物检测中,采用改进的surendra算法快速提取前景目标,并结合深度信息排除其他运动物体的干扰,以有效提高检测的准确率。

1 取走物检测流程

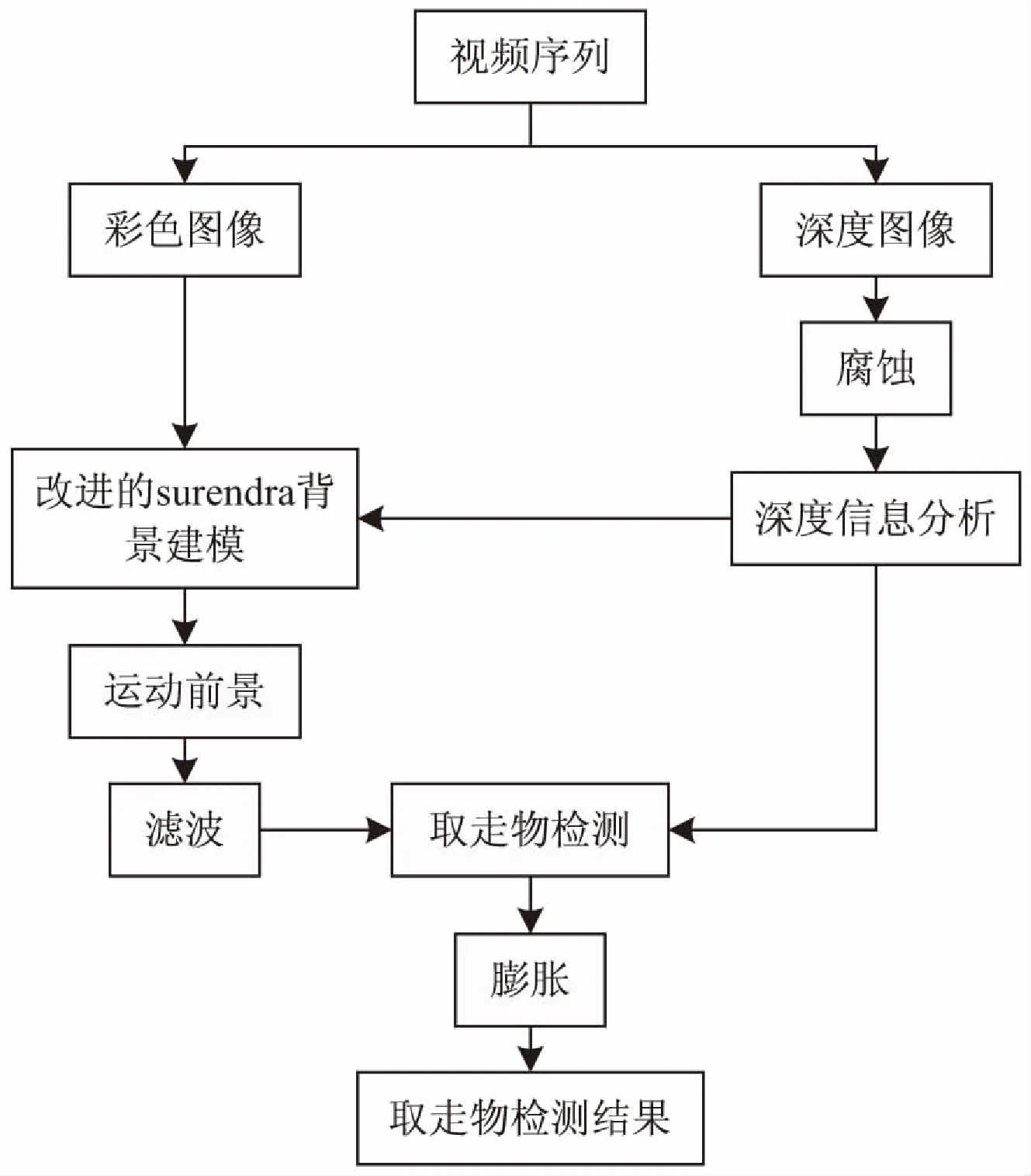

取走物检测流程分为两个子流程,一个是彩色图像的运动前景提取,另一个是深度图的分析。获取场景的彩色图像后,利用改进的surendra算法求得运动前景,再加以滤波去除噪声。同时利用双目立体视觉技术将采集的左右两幅图像进行处理,得到深度图,并进行腐蚀操作,去除深度图中的噪声后再进行分析。深度图的分析结果有两方面的作用:第一个是在更新背景时,深度减小且差分二值图像值为1的区域不需要更新背景,其余的区域都需要更新;第二个是在利用背景减除法获得运动前景之后,在前景区域中,属于深度增加或基本不变的区域,都认为是取走物区域。再对检测到的取走物区域进行膨胀操作,得到取走物检测结果。

取走物的检测流程如图1所示。

图1 取走物检测流程

2 立体匹配和深度图的生成

双目立体视觉技术先对摄像机进行立体标定[6-7],获得摄像机的内外参数,通过对准同一目标的两个角度的相机采集图像,再对获得的图像进行立体矫正和立体匹配等[8-12],达到获取深度信息的目的。其中最关键的部分是立体匹配,立体匹配是在图像上找到与另一视角的图像上相对应的像素点,其结果可以计算出视差图[13-15],再将视差图做变换可得到深度图。

文中采用的立体匹配算法是基于动态规划的全局立体匹配算法[16],该算法能够形成较为致密的视差图,符合取走物检测方法的需求。为了提高取走物检测的效率,采用每次只在一行像素上寻找最优路径的动态规划算法。

动态规划算法基于极线约束,其思想就是把求解整个图像深度值的过程分解为一些子过程,然后逐渐实现每个子过程,通过在视差图像上寻找最小代价路径,最终得到深度图。

算法步骤如下:

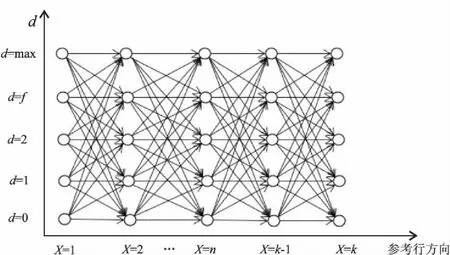

(1)将立体匹配全过程分解成若干个子过程。为了提高效率,每次匹配只匹配图像中一行的像素点。如图2所示,以像素点的行方向作为横坐标方向,纵坐标表示视差值的大小,依次将整个过程分为k个阶段。

图2 动态规划原理图

(2)将上述各个阶段所处的匹配阶段用不同的状态表示,共有三种状态:相互匹配M,左可见右遮挡为L,即在右图中没有与之相匹配的点,右可见左遮挡为R,即前一个点的匹配点在后一个点的匹配点的后面。

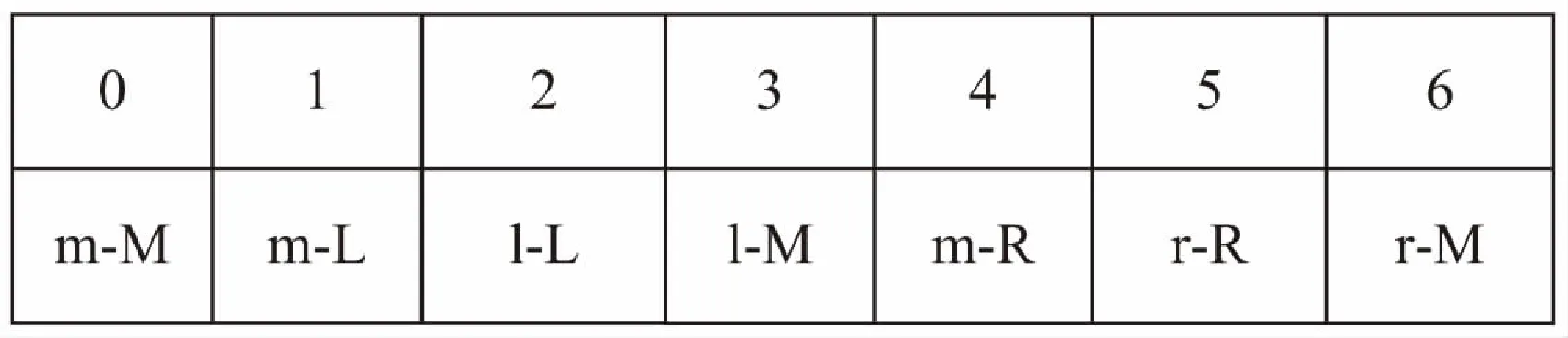

(3)根据前一阶段的状态确定当前阶段的状态,根据顺序性约束,允许的状态转移形式有7种,如图3所示。

图3 状态转移图

图3中小写字母的状态代表前一时刻的状态,大写字母的状态代表后一时刻的状态。0为正确匹配,1、2为匹配产生左图像遮挡点,4、5为产生右图像遮挡点,3、6为图像由背景进入前景,视差跳变产生不连续点。

(4)按顺序自左向右,计算相似性测度函数和平滑函数的最小值,当所有阶段都计算完成后,选取全局能量函数最小的一条匹配路径,作为匹配结果。

全局能量函数如式1所示:

E(d)=E(data)+E(smooth)

(1)

其中,E(data)为数据约束项,代表像素之间的相似性,为了保证取走物的实时监测,采用亮度特征衡量像素之间的相似性,亮度差越小越相似;E(smooth)为相邻点间的平滑约束项,采用顺序性约束评估平滑约束项的大小。最后全局能量最小的一条路径上的点为一行像素的匹配结果。

为了保证能正确找到匹配点,根据实验场景与摄像头的距离和左右两个摄像头之间的距离,在每一行上寻找匹配点只考虑距离在0~36之间的点,因此视差的取值范围是0~36,将视差值乘以7,生成像素值范围在0~252的深度图。

3 surendra运动前景提取算法

surendra运动目标检测算法[17-18]利用帧差法更新背景图像,利用背景减除法获得运动前景,能够捕捉快速移动的目标,应用在取走物检测中,有利于检测出被迅速取走的物品。

surendra算法流程如下:

(1)先利用帧差法得到差分二值图像。

(2)

其中,Ii(x,y)和Ii-1(x,y)分别为第i帧图像和第i-1帧图像在(x,y)处的亮度值;Ts为可自行设定的阈值。

(2)利用二值差分图像Ci更新背景图像Bi。

(3)

其中,Bi(x,y)为背景图像在(x,y)处的亮度值;α为背景更新率,α越大,背景更新的速度就越快。

然后将当前图像与背景图相减,若差值大于阈值,则该点属于运动前景区域,从而检测出运动目标。

4 取走物检测方法

4.1 深度图像的分析

分析深度图时,只将深度图与特定参考帧进行对比分析,将原始无人场景的深度图作为参考帧。文中取深度图序列中的第一帧作为参考帧,每帧深度图像素取值范围是0~252。设D0(i,j)为参考帧在(i,j)位置的深度值,Dt(i,j)为第t帧在(i,j)位置的深度值,Td为设定的阈值,为正数。若Dt(i,j)-D0(i,j)>Td,深度信息增加,考虑有物品被取走;若|Dt(i,j)-D0(i,j)|≤Td,深度信息基本不变,可能是较薄的物体被取走或是存在噪声干扰,需结合运动前景进一步判断,若此区域在彩色图像中为运动前景区域,则判断为取走物区域,否则为噪声干扰区域;如果D0(i,j)-Dt(i,j)>Td,深度信息减小,则考虑为其他情况,如进入场景的人体区域。

4.2 改进的surendra算法

surendra算法在提取运动前景上具有效率高的优点,但是要将surendra算法应用到取走物检测上,必须进行改进。文中将深度信息分析与背景更新相结合,对surendra背景更新进行改进,公式如下:

Bi(x,y)=

(4)

从式4可以看出,背景更新不再只根据帧差法得到的差分图像进行更新,而是只有深度信息明显减少且是运动前景的区域不进行更新,其他区域全都进行更新,使得进入场景的物体区域(如人体区域)不会更新到背景模型中。

surendra算法中的背景更新部分改进之后,利用背景减除法得到运动前景,再对运动前景区域进行深度变化分析,将深度增加或基本不变的前景区域视为取走物区域。

5 实验结果及分析

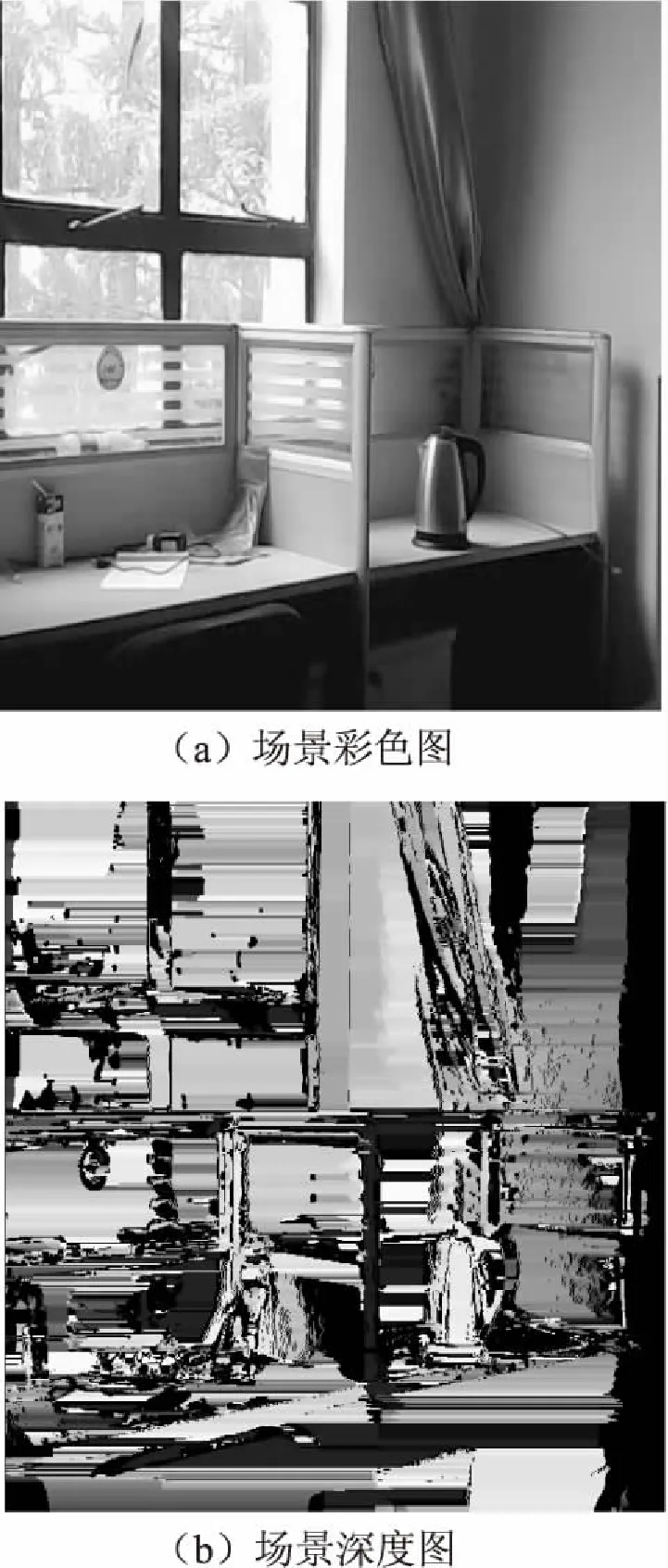

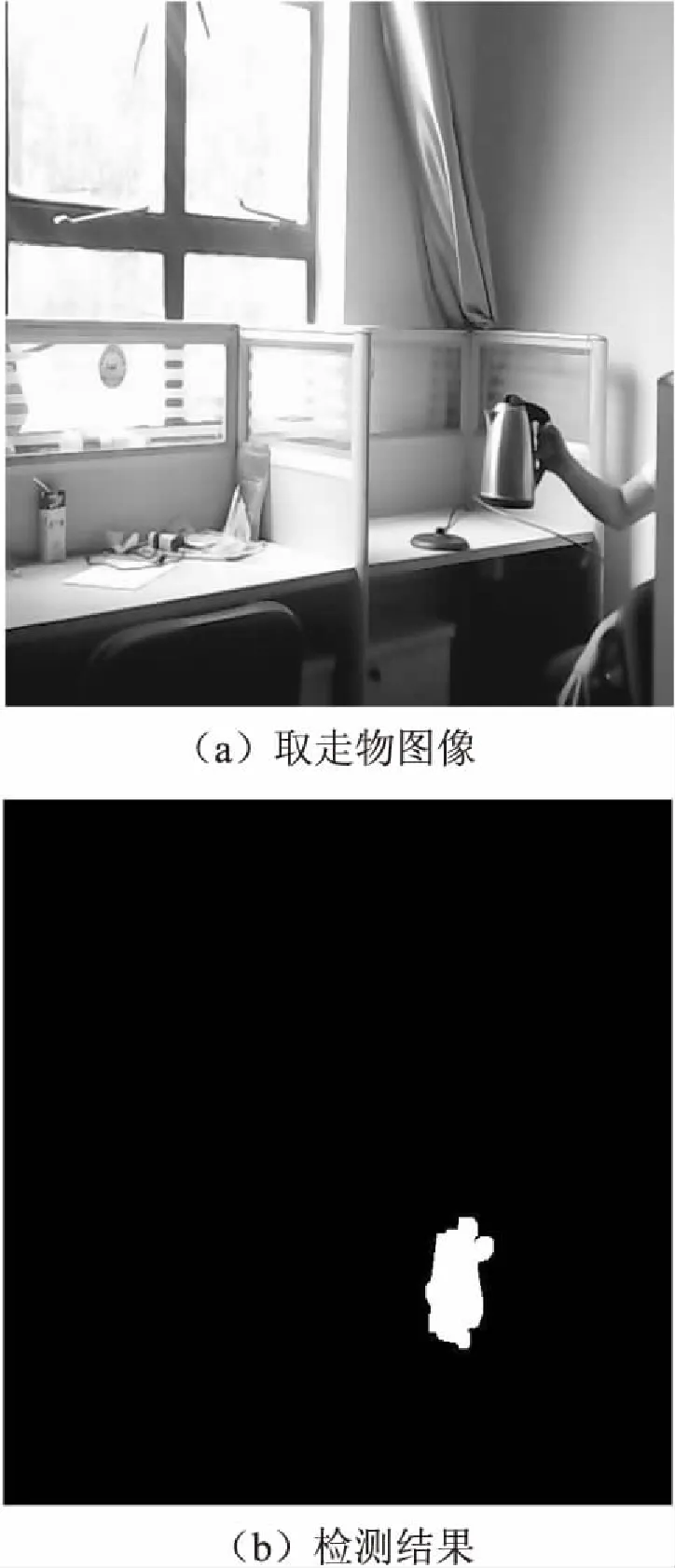

实验是在光线合适的室内进行的,取走物品为室内的电热水壶。取一幅室内的原始场景图像,并生成深度图像,如图4所示。

图4 监控场景及深度图

图5为取走物检测结果。图中可以显露出被取走物体的大体形状,surendra运动前景检测算法和基于单行像素匹配的动态规划立体匹配使得文中取走物检测算法计算效率较高,能够满足实时检测的需求。但是需要在取走物场景光线合适的条件下,才能获取较好的深度图,文中的取走物检测方法才能有效检测出被取走的物品。

图5 取走物检测结果

6 结束语

围绕着取走物检测这个主题,将双目立体视觉技术应用到取走物检测中,提出了新的取走物检测方法。利用深度信息改进surendra运动前景提取算法,得到运动前景后,再次利用深度信息结合运动前景,判断是否有原始场景中的物品被取走。最后对提出的取走物检测方法进行了实验,证明该方法取得了较好的检测效果。

参考文献:

[1] JOSHI K A,THAKORE D G.A survey on moving object detection and tracking in video surveillance system[J].International Journal of Soft Computing and Engineering,2012,2(3):44-48.

[2] HU Yanqiang,MA Yue,XU Min,et al.Measurement algorithm of mounting holes based on binocular stereo vision[C]//2016 IEEE international conference on cyber technology in automation,control,and intelligent systems.Chengdu,China:IEEE,2016:489-492.

[3] GOVINDIYA B,SHAIKH N.Real-time distance measurement with tracking using binocular stereo vision[J].Interna-

tional Journal of Emerging Technologies and Innovative Research,2015,2(6):1920-1923.

[4] ZHANG Zhiguo, TAO Wenbing. Pedestrian detection in binocular stereo sequence based on appearance consistency[J].IEEE Transactions on Circuits and Systems for Video Technology,2016,26(9):1772-1785.

[5] 张 华.基于立体视觉的人头检测与统计方法研究[D].长沙:湖南大学,2015.

[6] HORAUD R,CSURKA G,DEMIRDIJIAN D.Stereo calibration from rigid motions[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2000,22(12):1446-1452.

[7] ZHANG Ke, ZHAO Gao. The comparison of calibration method of binocular stereo vision system[C]//2015 3rd international conference on material, mechanical and manufacturing engineering.Manchester,UK:[s.n.],2015:896-901.

[8] 夏春容.双目立体视觉处理关键技术研究[D].南京:南京大学,2014.

[9] YE Qing,DONG Junfeng,ZHANG Yongmei.3D human behavior recognition based on binocular vision and face-hand feature[J].International Journal for Light and Electron Optics,2015,126(23):4712-4717.

[10] 耿英楠.立体匹配技术的研究[D].长春:吉林大学,2014.

[11] 洪 磊,嵇保健,洪 峰.一种基于亚像素角点的SIFT立体匹配算法研究[J].计算机技术与发展,2016,26(1):48-52.

[12] 王雅宁,梁新刚.基于交互式图像分割的立体匹配方法[J].计算机技术与发展,2016,26(9):163-166.

[13] KATO D,BABA M,SASAKI K S,et al.Effects of generalized pooling on binocular disparity selectivity of neurons in the early visual cortex[J].Philosophical Transactions of the Royal Society of London,2016,371(1697):20150266.

[14] MU Taijiang,SUN Jiajia,MARTIN R R,et al.A response time model for abrupt changes in binocular disparity[J].The Visual Computer,2015,31(5):675-687.

[15] 赵 戈,蔺 蘭,唐延东,等.一种基于曲率与置信度传播的视差估计方法[J].模式识别与人工智能,2013,26(12):1154-1160.

[16] 何高奇,杨 宇,倪 佳,等.基于动态规划的实时立体匹配算法[J].华东理工大学学报:自然科学版,2013,39(5):601-609.

[17] 徐方明,卢官明.基于改进surendra背景更新算法的运动目标检测算法[J].山西电子技术,2009(5):39-40.

[18] YANG Mingyang.A moving objects detection algorithm in video sequence[C]//International conference on audio,language and image processing.Shanghai,China:IEEE,2014:410-413.