最新无模型深度强化学习研究:从零开始训练机器人“玩乐高”

2018-06-11TuomasHaarnojaVitchyrPongAurickZhouMurtazaDalalPieterAbbeelSergeyLevine

□文/ Tuomas Haarnoja、Vitchyr Pong、Aurick Zhou、Murtaza Dalal、Pieter Abbeel、Sergey Levine

当人类学习一项新技能,往往是不断试错与计划的交织,机器也是如此。强化学习有基于模型的方法和无模型的方法。近日伯克利大学最新提出无模型深度强化学习方法——soft Q-learning(SQL)算法,该算法可以对模拟和现实世界的任务执行组合性,同时在该算法基础上提出了一种使用具有表达性的神经网络策略学习机器人操作技能的学习框架。该学习框架为学习各种机器人技能提供了一种有效的机制,并且在实际机器人系统的样本效率方面优于目前最先进的无模型深度强化学习方法。

现如今,经过长期的研究实验证明,无模型深度强化学习在视频游戏、模拟机器人操纵和运动等领域具有良好的性能表现。然而,众所周知,当与环境的交互时间有限的情况下,无模型方法的表现并不佳,就像大多数现实世界中的机器人任务一样。在本文中,我们研究了如何使用soft Q-learning训练的最大熵策略应用于现实世界中的机器人操纵任务。这种方法之所以能够在现实世界中应用,主要得益于soft Q-learning的两个重要特征:首先,soft Q-learning可以通过学习具有表达性的基于能量的模型(energy-based models)所表示的策略,从而学习多模式探索策略。其次,我们展示的通过soft Q-learning所学习的策略可以组成新策略,并且最终策略的最优性可以根据组合策略之间的分歧来界定。这种组合性为现实世界的操纵任务提供了一个特别有价值的工具,其中,通过对现有的技能进行组合进而构造出新的策略,可以在从零开始的训练中提供效率上的大幅提高。我们的实验评估结果表明,相较于以往的无模型深度强化学习方法,soft Q-learning具有更高的样本效率,并且可以对模拟和现实世界的任务执行组合性。

具有表达性的通用目的函数近似器(如神经网络),与可用于获取复杂行为策略的通用目的无模型强化学习算法的交集,有望实现广泛的机器人行为的自动化:强化学习提供了用于推理序列决策的形式主义,而大型神经网络提供了表征,原则上,可以用于使用最少的手动工程来表示任何行为。然而,经过实践证明,将具有多层神经网络表示(即深度强化学习)的无模型强化学习算法应用于现实世界中的机器人控制问题,这一过程是非常困难的:无模型方法的样本复杂性相当高,并且由于大容量函数近似器的包容性,复杂性还将进一步提高。在以往的研究中,专家们试图通过在多个机器人上并行化学习来缓解这些问题,比如利用实例演示,或模拟训练,并依靠精确的模型实现向现实世界的迁移。所有这些方法都带有附加的假设和局限性。那么,我们是否可以设计出一种无模型强化学习算法,这种算法能够在不依赖模拟、演示或多个机器人的情况下,直接对现实世界中的多层神经网络模型进行高效训练?

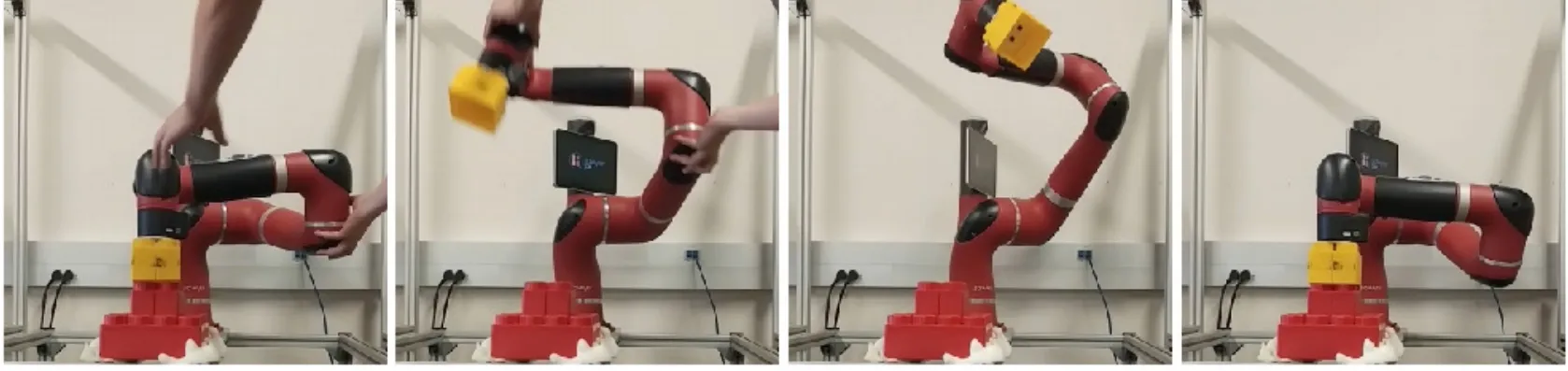

我们使用一种称为soft Q-learning的最大熵强化学习算法,对Sawyer机器人进行训练使其能够将乐高积木叠加在一起。从零开始对一个策略进行训练需要不到两个小时的时间,并且已学习事物策略干扰(左图)具有很强的鲁棒性。我们还展示了该如何将学到的策略组合起来形成新的复合技能,例如在避开乐高积木塔的情况下进行堆叠操作(右图)。

我们假设,基于以下两点性质,最大熵原理可以为实际的、现实世界的深度强化学习提供一个有效的框架。首先,最大熵策略通过玻尔兹曼分布(Boltzmann distribution)表达了一个随机策略,提供了一种内在的、明智的探索策略,其能量对应于reward-togo或Q函数。此分布为所有操作分配一个非零概率,但期望回报更高的操作更可能被采样。因此,该策略将自动把探索引向回报更高的区域。这种特性可以被看做是探索和开发的软组合,在实际应用中是非常有益的,因为它提供了比贪婪探索(greedy exploration)更多的结构,并且正如我们实验所展示的那样,这大大提高了样本的复杂性。其次,正如我们在文章中所展示的那样,独立训练的最大熵策略可以通过增加Q函数而将其组合在一起,从而为合并后的奖励函数产生一个新的策略,该策略被证明近乎于相应的最优策略。在实际应用中,控制器的可组合性尤为重要,而这在标准强化学习中是不可能的。在这些应用中,重复使用过去的经验可以极大地提高任务的样本效率(这些任务可以自然地分解为更简单的子问题)。例如,拾取和放置的策略可以分解为:(1)到达指定的X坐标;(2)到达指定的Y坐标;(3)规避障碍。因此,这种可分解的策略可以分三个阶段学习,每个阶段产生一个子策略,而这些子策略随后可以在需要与环境进行交互的情况下进行离线组合。

对两个独立的策略进行训练,从而相应地推动圆柱到橙色线和蓝色线。彩色圆圈显示了针对相应策略的圆柱到达最终位置的样本。当策略组合在一起时,生成的策略会学习将圆柱体推到线的下交叉点(绿色圆圈表示最终位置)。没有来自环境的附加样本用于对组合策略进行训练。组合策略学习满足两个原始目标,而不是简单地平均最终圆柱位置。

本文的主要贡献是在最新提出的soft Q-learning(SQL)算法的基础上,提出了一种使用具有表达性的神经网络策略学习机器人操作技能的学习框架。我们证明了,该学习框架为学习各种机器人技能提供了一种有效的机制,并且在实际机器人系统的样本效率方面优于目前最先进的无模型深度强化学习方法。我们的实验结果表明,在很大的程度上,SQL的性能要远远优于深度确定性策略梯度(DDPG)和归一化优势函数(NAF),这些算法过去曾被用于利用神经网络探索现实世界中的无模型机器人学习。我们还演示了对SQL算法的全新的扩展,即利用它对以前学习过的技能进行组合。我们提出了一个关于组合策略和组合奖励函数最优策略之间差别的理论界限,它适用于SQL和其他基于软优化的强化学习方法。在实验中,我们利用最大熵策略在模拟领域和物理领域的组合性,展示了不同技能的鲁棒性学习,并且在样本效率方面超越了现有的最先进的方法。

在本文中,我们探讨了如何将soft Q-learning扩展到现实世界中的机器人操作任务中,既可以学习单个操作任务,也可以学习能够组成新策略的组合任务。我们的实验表明,本质上来说,soft Q-learning的性能要远远优于无模型深度强化学习。在模拟到达任务中,soft Q-learning具有比NAF更好的性能,其中包括多个策略组合以到达新位置的情况。除此之外,在Sawyer机器人进行评估的真实世界任务的执行中,soft Q-learning在性能上胜过DDPG。该方法具有更好的稳定性和收敛性,并且通过soft Q-learning获得的对Q函数进行组合的能力可以使其在现实世界的机器人场景中特别有用,其中针对每个新奖励因素组合的新策略进行再训练是耗时且昂贵的。

当在Sawyer机器人上进行训练以将其末端执行器移动到特定位置时,DDPG(绿色)、NAF(红色)和SQL(蓝色)的学习曲线。SQL的学习速度比其他方法快得多。我们还通过将期望的位置连接到观察向量(橙色)以训练SQL达到随机采样的末端执行器位置。SQL学会尽快解决这个任务。SQL曲线显示10个轮数中的移动平均值。

在不到两个小时的时间里,就可以学会一个乐高堆叠策略。学习到的策略对干扰具有很强的鲁棒性:当机器人被推进到一个与典型轨迹完全不同的状态后,它能够恢复并成功地将乐高积木堆在一起。

在研究最大熵策略的可组合性时,我们推导出了组合策略与组合奖励函数的最优策略之间误差的界限。这一界限表明熵值较高的策略可能更容易进行组合。在未来,一项有意义的研究方向是探寻这一约束对组合性的影响。例如,我们是否可以推导出一个可应用于组合Q函数的修正,以减少偏差?回答这样的问题,会使得从先前训练过的构建块中创建新的机器人技能变得更加实际,这使得机器人更容易获得通过强化学习学到大量行为。