未成熟芒果的改进YOLOv2识别方法

2018-04-11薛月菊涂淑琴杨阿庆朱勋沐杨晓帆陈鹏飞

薛月菊,黄 宁,涂淑琴,毛 亮,杨阿庆,朱勋沐,杨晓帆,陈鹏飞

未成熟芒果的改进YOLOv2识别方法

薛月菊1,2,3,4,黄 宁1,2,涂淑琴5,毛 亮1,杨阿庆1,朱勋沐1,杨晓帆1,陈鹏飞1

(1. 华南农业大学电子工程学院,广州 510642; 2. 广东省现代养猪数据化工程技术研究中心,广州 510642; 3. 广东省智慧果园科技创新中心,广州 510642; 4. 广东省农情信息监测工程技术研究中心,广州 510642; 5. 华南农业大学数学与信息学院,广州 510642)

在果园场景下,由于光照的多样性、背景的复杂性及芒果与树叶颜色的高度相似性,特别是树叶和枝干对果实遮挡及果实重叠,给未成熟芒果检测带来极大的挑战。本文提出果园场景下未成熟芒果的改进YOLOv2检测方法。设计新的带密集连接的Tiny-yolo网络结构,实现网络多层特征的复用和融合,提高检测精度。为克服遮挡重叠果实检测困难,手工标注遮挡或重叠芒果的前景区域,然后用样本的前景区域训练YOLOv2网络,减小边界框内非前景区域特征的干扰,增强对目标前景区域卷积特征的学习。并以扩增的数据集,采用增大输入尺度和多尺度策略训练网络。最后,对本文方法进行性能评价与对比试验。试验结果表明,该方法在测试集上,芒果目标检测速度达83帧/s,准确率达97.02%,召回率达95.1%。对比Faster RCNN,该方法在杂物遮挡和果实重叠等复杂场景下,检测性能显著提升。

神经网络;特征提取;估产;芒果;密集连接;YOLOv2网络

0 引 言

芒果是常见的热带水果,在国内外水果市场中占有较大比重。而传统的芒果种植、施肥施药、采摘以及后续一系列生产加工过程,都耗费着大量的人力、物力和其他资源[1-2]。在芒果精准种植中,要对芒果进行智能喷施、生长态势监测,尽早地进行芒果估产及采摘劳动力需求预测,就必须首先对未成熟芒果进行精确检测。计算机视觉为水果自动检测提供了一种非常有效的手段,但果园场景下遮挡或重叠果实检测一直以来都是水果检测的难题[3-5]。

对于自然场景下的芒果目标检测研究,近年来已取得一定进展[3-7]。Hussin等[3]利用颜色特征去除与芒果颜色无关的背景,使用圆形Hough变换进行目标检测,检测精度约为60%。但从不同视角获得芒果图像时,果实形状并非标准的圆或椭圆,且在芒果重叠情形下,各果实区域会合并而形成连通区域,极易导致错误检测。Payne等[4-5]利用纹理和颜色特征,对收获前3周的淡红色芒果进行识别;为消除非树冠区域对芒果检测的影响,利用人工照明在夜间采集芒果图像,基于颜色匹配和Hessian滤波器对芒果进行检测。但获取夜间图像需额外的照明设备,影响了该方法的实用性。Sa等[6]利用RGB和NIR图像信息,分别用前期、后期融合的方法训练多模态Faster RCNN模型并检测了芒果,但此方法对大面积遮挡的情形并无满意的检测结果。Stein等[7]用多视点方法解决芒果遮挡问题,通过多个视点的多个图像序列对果实进行关联和跟踪,但此方法需要复杂的辅助设备,实时性能不高。另外,针对苹果、桃子、草莓、柑橘等遮挡重叠水果的检测方法相继被提出[8-14]。Xu等[10]利用HOG特征与SVM分类器研究草莓的检测,将草莓分成5个感兴趣区域分别训练SVM分类器,并在组合分类器后进行草莓检测,达到87%的精确率,但此方法只能有效检测轻微重叠的草莓。Gong等[11]采用改进Freeman 8邻域链码方法进行了簇生重叠水果数量的计算。但该方法依赖于分割精度,不准确的分割将导致果实边缘编码错误,影响计数精度。卢军等[12]提出轮廓恢复的方法进行遮挡柑橘的检测,首先使用Canny算子检测边缘,然后用自适应直线拟合和边界跟踪算法构造边缘片段集,最后应用椭圆拟合方法检测目标,轮廓恢复相对误差达5.34%。但上述研究中,果实大多接近成熟或已成熟,果实颜色在果园场景中较为明显,而本文中未成熟芒果颜色与树叶颜色高度相似,形状并非标准的圆或椭圆,甚至果实被树叶、枝干遮挡或果实相互重叠。这些因素均给芒果检测带来很大困难。

近年来,深度卷积神经网络(convolutional neural networks,CNN)在目标检测上显现出巨大的优越性,主要包括两大类。一类为基于区域生成的检测方法,首先生成许多可能包含目标的候选区域,然后用CNN对每个候选区域进行分类[15-17]。另一类为基于回归的方法,利用CNN对整个图像进行处理,在实现目标定位的同时预测目标类别[18-20],其速度往往快于前类方法。为弥补后类方法检测精度上的不足,研究者利用深层CNN,如He等[21]和Szegedy等[22]等网络提高精度。但深层CNN往往导致更高的计算复杂度,且数据信息在多层传播后很可能会逐渐消失。DenseNet(densely connected convolutional networks,密集连接卷积网络),通过密集连接,让网络每一层都能接受到它前面所有层的特征图,并以特征拼接(concatenate)的方式进行数据聚合,强化了特征传播,有效解决了梯度消失问题,并实现了特征复用,显著提高了网络分类精度[23]。

为解决果园场景下未成熟芒果快速、高精度检测问题,本文选择基于回归的方法中检测速度快的YOLOv2算法[20],提出密集连接的Tiny-yolo网络结构,以及用遮挡重叠果实目标前景区域样本加强前景区域特征学习的方法,融合数据扩增[24]和多尺度训练策略[20],并训练了改进的YOLOv2芒果目标检测网络。在杂物遮挡与果实重叠2类干扰场景下,本文方法的检测效果显著提升。

1 试验数据

1.1 试验数据采集

试验果园位于肇庆市莲塘镇,共有芒果树80株,芒果品种为四季蜜芒,果实呈长椭圆形。未成熟果皮呈绿色,近生理成熟期时果皮呈灰绿色,成熟后果皮呈鲜黄色。于2016年6月12日、19日和26日及2017年6月22日,分别使用SONY NEX-5T和Kinect2.0设备,距离每个树冠1~2 m、按东南西北4个不同方向、采集成熟前3至7周青绿色或灰绿色的芒果图像共960张。图像采集时的天气包括晴天、多云和阴天,采集时段为8:00-18:00,涵盖了顺光、逆光与侧光等可能的光照情况。从960张芒果图像中随机挑选660张作为原始训练图像(含3 702个芒果目标),将剩余300张作为测试图像(含1 713个芒果目标)。

1.2 图像增强

训练样本图像增强可提高样本的质量及多样性,有利于CNN检测精度提高[24-26]。如,Stern等[24]用亮度变化扩增样本,Ding等[25]将昆虫样本图像进行白平衡处理,来提高昆虫检测精度。果园自然光照下,特别是光照很强时,由于芒果互遮挡或逆光拍摄导致果实表面产生阴影,使果实颜色与正常光照下漫反射区域的颜色有很大差异,影响了芒果样本图像的质量。而训练样本的质量则会影响模型的检测效果。本文用自适应直方图均衡化,对芒果图像进行增强,减小光照对图像质量的影响。且,对图像进行自适应直方图均衡化,相当于调整了图像亮度,增加了样本图像光照的多样性。因此,本文用该方法提升样本图像质量及扩增样本数量。

1.3 样本标注

为提高YOLOv2芒果检测精度,本文在样本标注过程中充分考虑了目标的各种外观和形态。首先,对660张原始训练图像中的3 702个芒果目标进行了边界框标注(目标被遮挡面积≥50%时不作标注);并对其中遮挡重叠1 077个芒果标注了目标前景区域,即对目标背景区域像素值置0(详见2.2节),形成原始的训练集,见表1中的A组数据。另外,手工标注300张测试图像中的1 713个芒果目标边界框(目标被遮挡面积≥50%时不作标注),作为测试集,用于评价模型的检测精度。测试集无须标注目标前景区域。

本文采用人工标注、交互式标注与Matlab编程相结合的方式进行标注:1)使用自行开发的样本标注软件,标注芒果目标边界框;2)利用Photoshop软件的快速选择工具对遮挡重叠目标芒果,自动生成果实的边缘闭合曲线;但对表面颜色和光照不均匀果实,难以自动生成准确的边缘,需手工标注果实边缘轮廓;3)利用Matlab编程,读取果实边界框信息和边缘信息,并对目标果实边界框中的边缘轮廓曲线外区域的像素置0。

对原始训练集3 702个芒果目标的边界框标注约需8.23 h,对其中1 077个遮挡重叠果实的边缘轮廓标注约需2.55 h。在边界框和边缘轮廓标注完成后,边界框内边缘轮廓外的区域置0处理可通过Matlab编程自动完成。

1.4 数据扩增

本文扩增了训练样本[24,26]。考虑到树冠上大部分芒果呈竖直悬挂姿态,而部分芒果因枝干或其他芒果的阻挡呈多角度倾斜悬挂姿态,故本文对训练样本进行了水平镜像翻转、以及±10°、±20°旋转操作。并对旋转后的图像进行居中截取。经旋转处理后,图像中靠近边缘的目标若出现残缺或完全丢失情况,则放弃标注。

1.5 数据集准备

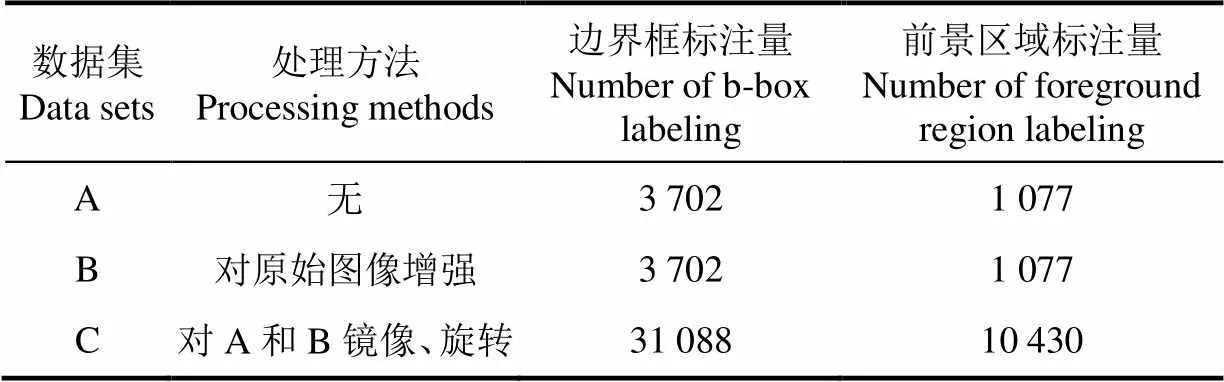

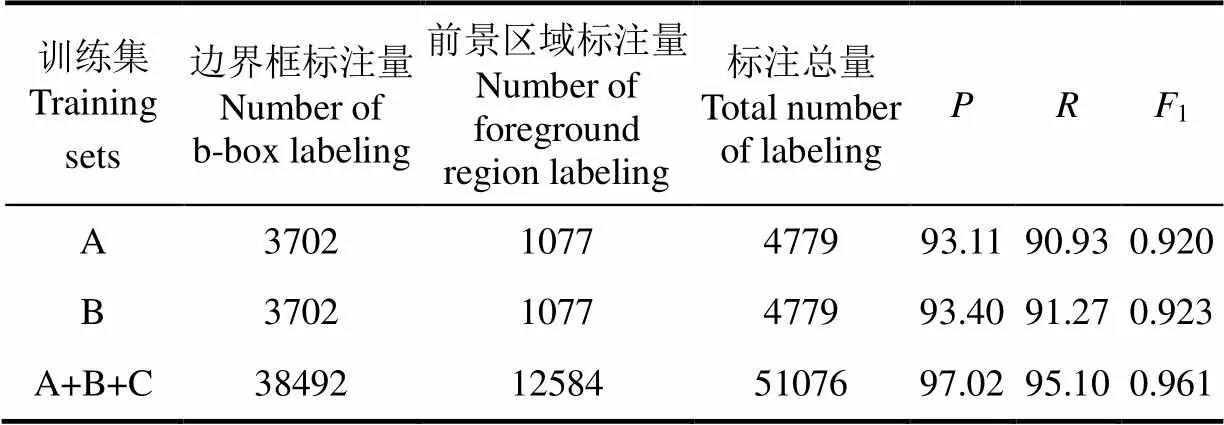

通过对训练样本的增强和扩增处理,分别获得3类数据集,如表1所示。数据集A是原始图像中的芒果目标训练集,数据集B是对原始图像进行自适应直方图均衡化增强后的芒果目标样本集,数据集C是对数据集A和B扩增的芒果目标样本集(不包含数据集A和B)。在数据集A和B中,芒果目标边界框的标注数量均为3 702个,并对遮挡重叠芒果(共1 077个)标注目标前景区域。在数据集C中,芒果目标边界框的标注数量为31 088个,前景区域标注数量为10 430个。

表1 数据集及其数据量

2 改进的YOLOv2芒果检测网络及训练

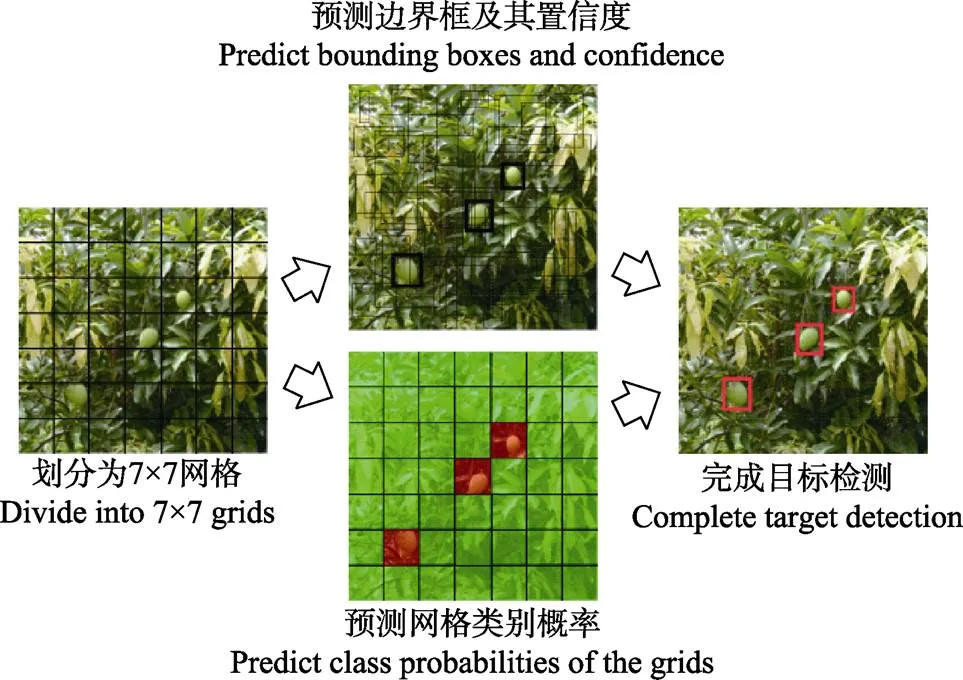

YOLOv2网络的前身是YOLO网络[18]。YOLO网络无需区域生成,直接在整个输入图像中回归预测目标,极大提高了检测速度。如图1所示,该网络将重置尺寸后的输入图像划分成×(= 7)的网格,在每个网格中预测2个边界框及其置信度,以及(= 2)种类别的条件概率,最后使用非极大值抑制法过滤阈值较低的边界框,得到最终的目标预测框。

图1 YOLO检测模型

为解决YOLO网络检测易遗漏、定位不精准的问题,YOLOv2中引入锚点框、锚点框高宽维度聚类、高分辨率分类器及改进位置坐标预测方法等。在YOLOv2训练时,采用了多尺度训练策略[20]。为提高检测速度,YOLOv2设计了只包含卷积层和池化层的Darknet-19和Tiny-yolo网络结构。在VOC2007测试集上,YOLOv2 416×416[20]的检测精度和速度,均优于Faster RCNN[17]、SSD[19]和YOLO等主流算法。但YOLOv2对果园场景下未成熟芒果,特别是遮挡或重叠芒果的检测精度有待提高,为此本文提出:1)结合密集连接的Tiny-yolo网络结构;2)标注训练样本遮挡重叠芒果目标的前景区域,以加强前景区域特征的学习。

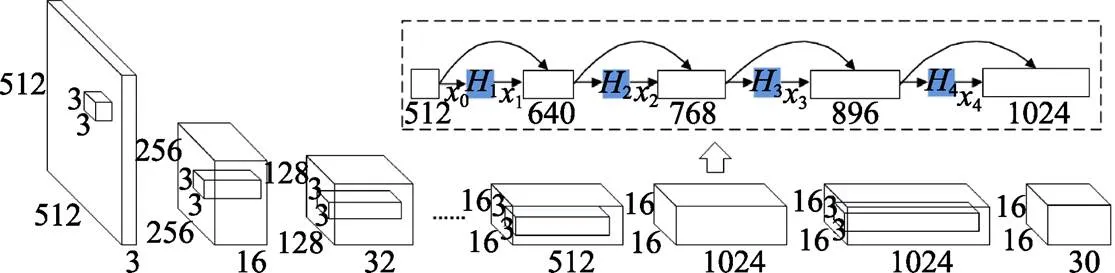

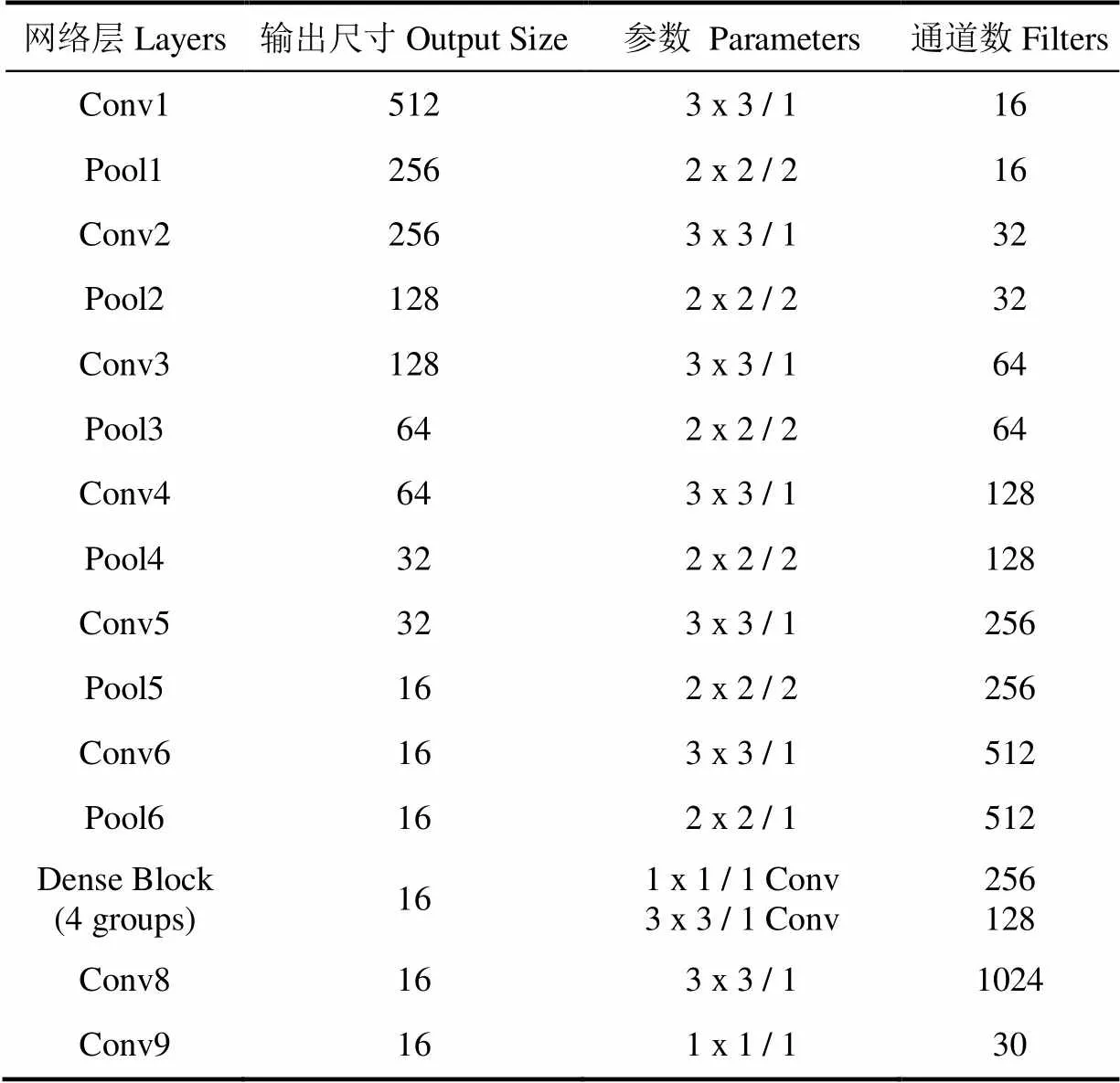

2.1 YOLOv2网络结构改进

为实现果实在线检测,本文选取结构较为简单、运算复杂度较低的Tiny-yolo作为YOLOv2的基础网络。Tiny-yolo由9层卷积层和6层最大池化层交替组成前馈网络,导致信息在传递时逐层丢失,未能更好地利用多层的特征信息,降低了检测精度。为实现多层特征复用和融合,且避免新增结构带来的计算复杂度,本文借鉴Huang等[23]提出的密集连接思想,仅在Tiny-yolo网络特征图分辨率较低的深层嵌入密集模块,即用密集模块(见图2虚线框)替代Tiny-yolo的第7卷积层(分辨率为16´16),构建带密集连接的Tiny-yolo-dense网络(见表2),使第8卷积层能接收密集连接块输出的多层卷积特征,实现特征复用和融合,如图2所示。在密集模块中:

x = H( [01……x-1] ) , (= 1,2,3,4) (1)

其中0为模块输入特征图,x表示第层的输出。[0,1……x1]表示对0,1……x1的拼接。H(·)为BN(batch normalization,批量归一化)、ReLU(rectified linear units)及卷积的组合函数,实现第层非线性变换。本文的H(·)操作为BN-ReLU-Conv(1,1)- BN-ReLU-Conv(3,3)。

例如,在第2层组合中,由特征图0和第1层输出特征图1拼接成的640个通道特征图,即[0,1]作为2的输入;2对[0,1]进行BN操作和激活函数ReLU非线性映射后,用256个1×1卷积核卷积生成256个特征图,再进行BN和ReLU操作后用128个3×3卷积核进行卷积,输出128个特征图2。然后,2与[0,1]拼接为768个通道特征图[0,1,2],作为3的输入。类似地,3也输出128个通道特征图3,以此类推。

图2 Tiny-yolo-dense网络结构

表2 Tiny-yolo-dense网络参数

2.2 训练样本目标前景区域标注

根据Hariharan等提出的R-CNN[15]与SDS[27]目标检测网络,本文针对果实遮挡或重叠给芒果检测带来的困难,提出用训练样本目标前景区域标注加强芒果前景区域卷积特征学习的方法。首先,通过手工标注方法,对目标背景区域的像素置零,获得目标前景区域样本,并使用目标前景区域样本对改进YOLOv2网络进行训练,降低边界框内非前景特征的干扰,以增强网络对前景特征的学习,得到芒果检测网络。样本标注时,将标注边界框内目标背景区域的像素置0,而前景区域像素保持不变,如图3所示。如此,当改进YOLOv2网络进行卷积特征提取时,可以降低树叶、枝干或重叠的非本目标果实等无关信息特征对目标特征提取的影响。同时,为了保留芒果目标边缘及其邻域的颜色、形状和纹理等信息[28],边界框内目标前景区域包括了目标轮廓外围一定区域(5~10个像素),以加强YOLOv2对包括目标边缘的前景区域特征的学习。

2.3 芒果检测网络训练

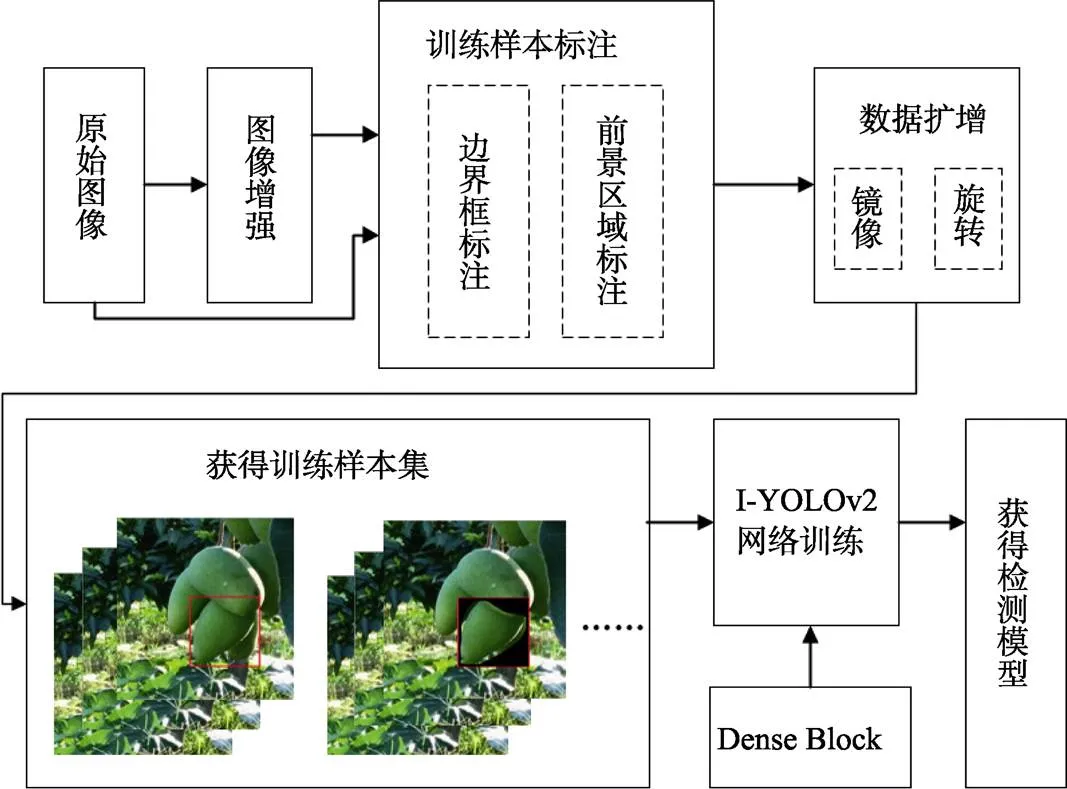

芒果目标检测网络的训练流程如图4所示。对训练集中原始图像进行自适应直方图均衡化后,手工标注训练样本,包括边界框标注和前景区域标注;对标注样本进行数据扩增;以Tiny-yolo-dense为训练网络,设计I-YOLOv2(improved YOLOv2)检测模型;采用多尺度训练策略,用训练样本集的边界框和前景区域信息进行I-YOLOv2训练。

图3 目标前景区域标注

图4 芒果检测训练流程

1)试验平台。本文在Darknet框架上实现YOLOv2和YOLO算法[29],服务器平台配置为:Intel® Xeon(R) CPU E3-1245 v3@ 3.40GHz处理器,32GB运行内存,2T硬盘容量,12GB GTX Titan X GPU,系统为Ubuntu 14.04。

2)网络训练参数设置。训练阶段采用动量项为 0.9 的异步随机梯度下降,权值的初始学习率为0.001,衰减系数设为0.0005。

3)网络训练策略。针对复杂自然场景中芒果尺度存在差异、个别目标尺度较小等特点,I-YOLOv2网络训练主要采用以下策略:一是增大输入尺度。在512×512的分辨率下微调网络,以适应检测中更高的输入分辨率。此策略可提高检测精度,但也降低检测速度[20]。二是多尺度训练。在训练迭代中,网络每隔10个批量,从设定的多尺度集{384, 416……672}中重新随机更换一个尺度继续训练。此策略使模型在不同的输入分辨率下均具有较好的检测效果,以适应多尺度芒果目标检测。

3 结果与分析

分别以训练集A、B和A+B+C(见表1)训练YOLOv2芒果检测网络,进行与改进基础网络结构、目标前景区域训练样本的对比试验,重点分析遮挡重叠果实检测的性能,并与Faster RCNN、YOLO、Adaboost等检测模型进行性能比较。将300张(1 713个芒果目标)测试集图像输入训练好的网络,进行芒果目标的位置回归,当模型预测的目标边界框与手工标注的边界框IOU(交并集比)≥0.7时,则认为检测正确,否则为错误,得到试验结果。选取准确率(precision,)、召回率(recall,)、1值[30](1-measure,1)和检测速度作为评价准则。其中,1值为平衡准确率与召回率的度量函数,定义为

1= 2×(+)(2)

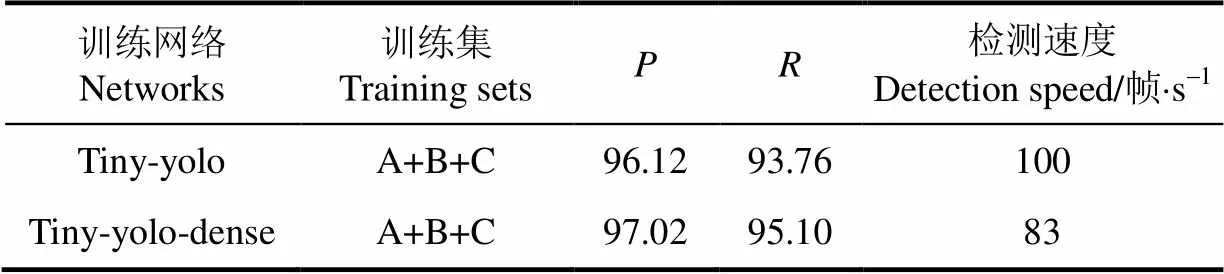

3.1 改进网络结构的检测结果

分别以Tiny-yolo和Tiny-yolo-dense为基础网络的检测结果如表3所示。改进后准确率和召回率相比改进前分别提高了0.9%和1.34%。密集连接实现了多层特征的拼接,进行了特征复用,减少前面层特征信息的流失,因此有利于I-YOLOv2检测精度的提高。同时,密集连接模块对检测速度影响很小,达83帧/s。Tiny-yolo-dense增加的密集连接模块中包含8层卷积层,新曾加的8层分别用1×1和3×3的卷积核在空间分辨率很小的16×16的特征图上进行卷积操作,使Tiny-yolo-dense相比Tiny-yolo具有更小的参数量,因而在提高检测精度的同时保持了很好的实时性。

表3 改进网络的检测结果

注:为准确率(precision)、为召回率。下同。

Note:is precision rate, %;is recall rate, %. The same bellow.

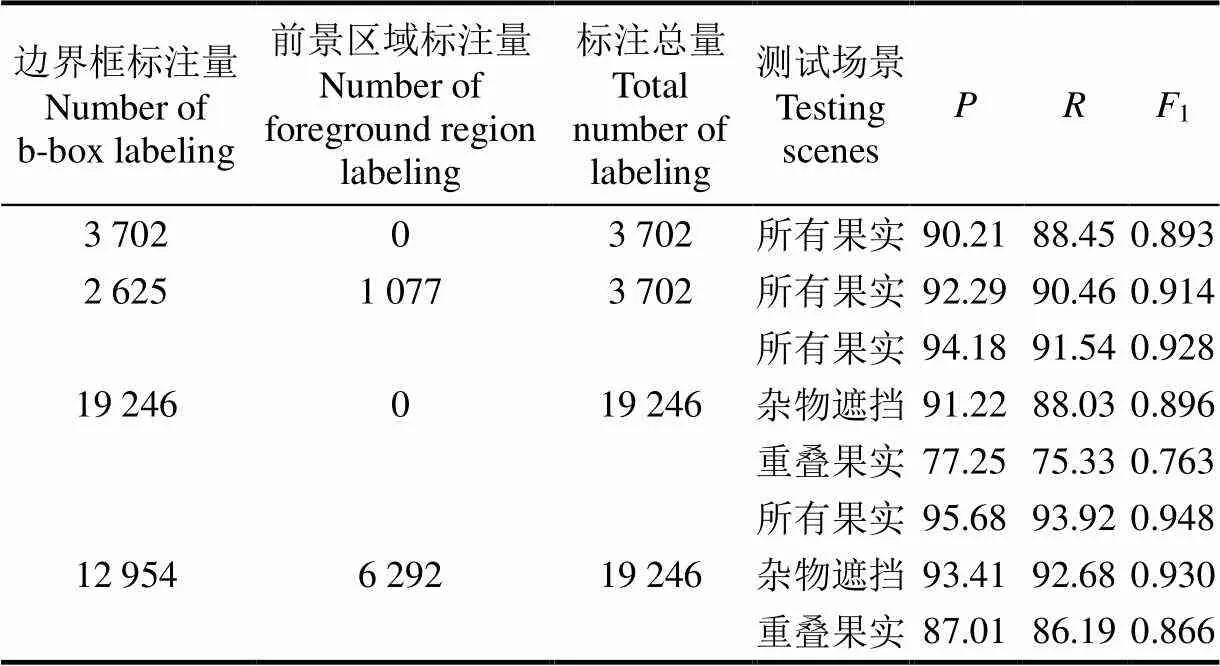

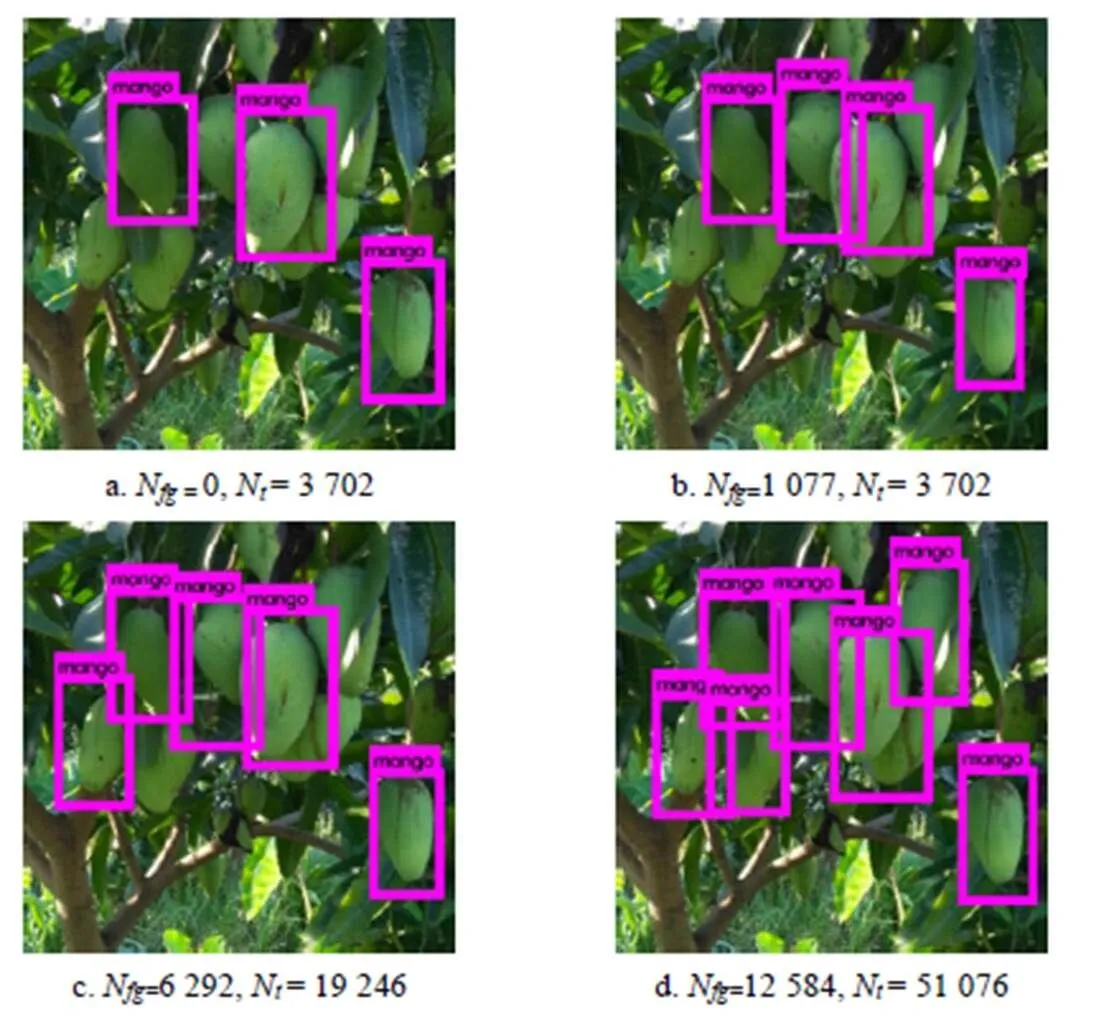

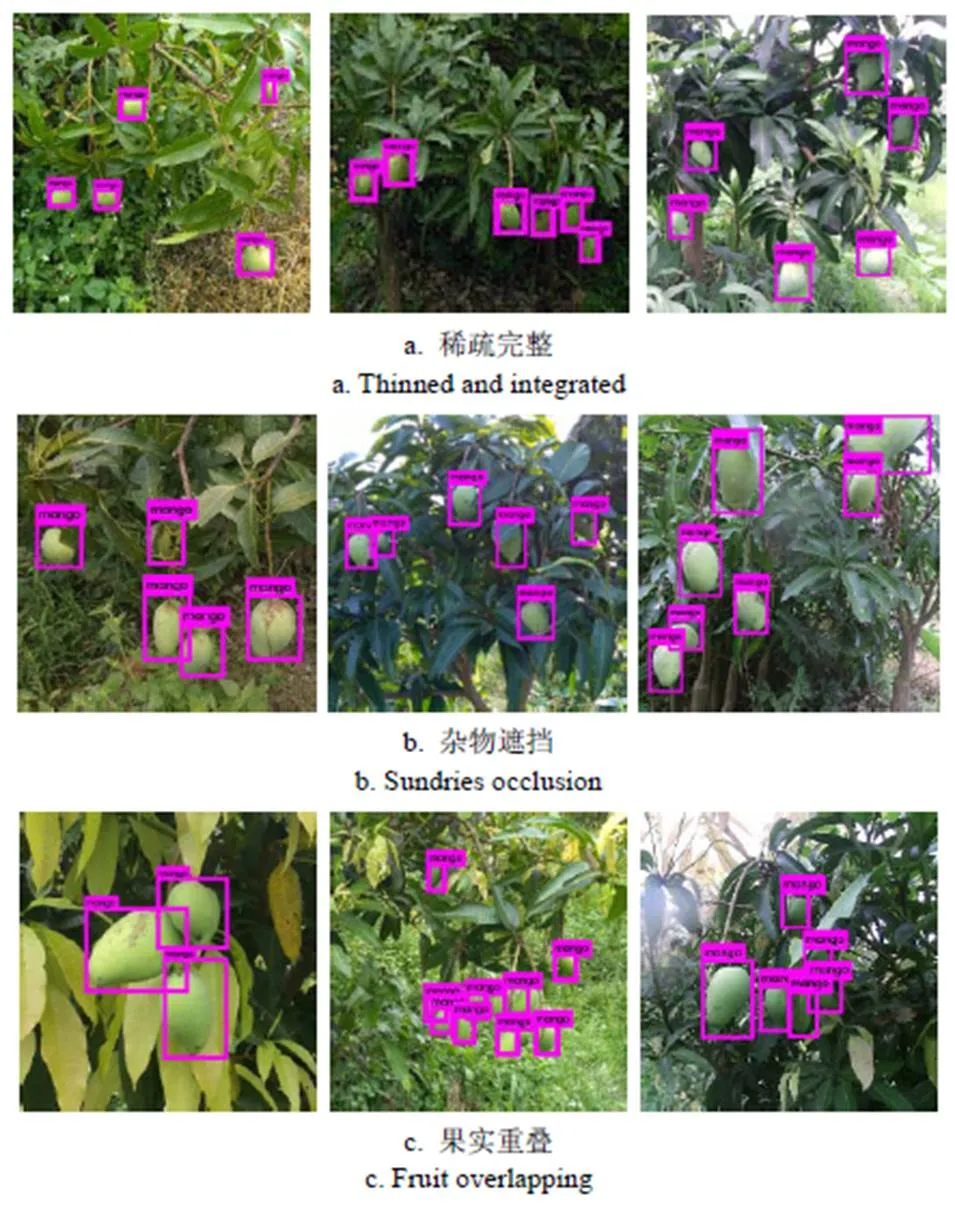

3.2 使用目标前景区域训练样本的检测结果

为验证前景区域训练样本对检测精度的作用,进行对比试验,结果见表4。原始图像中的3 702个训练样本,1组训练集仅包含3 702个样本的边界框标注,另1组包含1 077个遮挡重叠样本的前景区域标注和2 625个单个未遮挡样本的边界框标注,并对这2组样本分别进行数据扩增。用这4组训练集分别训练以Tiny-yolo-dense为基础网络的I-YOLOv2,在测试集上,检测效果示例见图5a~5c。可以看出,通过芒果训练样本目标前景区域标注,I-YOLOv2网络训练中,由于减小边界框内非前景区域特征的干扰,明显提升了检测精度,克服了遮挡重叠果实检测的困难。数据扩增后,使用前景区域标注的训练集获得的模型,检测精度相比未使用前景区域标注的模型有显著的提升,对测试集中所有果实准确率和召回率分别提高了1.5%和2.38%,对杂物遮挡果分别提高了2.19%和4.65%,对重叠果实分别提高了9.76%和10.86%。

3.3 扩增数据集的检测结果

以Tiny-yolo-dense为基础网络,进行了扩增数据前后的对比试验。由表5可以看出,对原始图像数据(A)增强处理后(B),训练模型的准确率和召回率分别提高了0.29%和0.34%。经过数据扩增后(A+B+C),准确率和召回率相比扩增前(A)分别提高了3.91%和4.17%,检测效果如图5d所示。结果表明,图像增强、镜像、旋转等处理方法可进一步提高检测精度。

表4 使用前景区域训练样本的检测结果

注:1值为平衡准确率与召回率的度量函数,1= 2×(+)。

Note:1is metric function of precision rate and recall rate,1= 2×(+).

注:Nfg为前景区域标注量,Nt 为标注总量。

表5 不同训练集的检测结果

3.4 遮挡重叠芒果检测结果

在果实稀疏完整、树干或枝叶等杂物遮挡以及果实重叠密集场景下,用数据集A+B+C训练的I-YOLOv2,在测试集上均有良好的检测性能,见图6和表6。对重叠果实的检测,I-YOLOv2依然达到90.17%的准确率和87.63%的召回率,但其检测精度明显低于果实稀疏完整及受树枝树叶遮挡情形下的精度。

图6 I-YOLOv2模型在不同场景下的检测示例

表6 I-YOLOv2与Faster RCNN的检测结果比较

3.5 与其它检测方法的对比试验

本文用扩增训练集(A+B+C)训练了Faster RCNN检测模型,并在测试集上与I-YOLOv2的结果进行了对比。如表6所示,在果实稀疏完整的场景下,I-YOLOv2与Faster RCNN在测试集上(包含顺光、逆光、侧光等情形)均有较高检测精度,可见基于CNN的检测模型对光照变化具有较强的鲁棒性,但果实的遮挡、重叠却对检测精度有着显著影响。在果实稀疏完整、杂物遮挡和果实重叠3类场景下,本文方法的准确率和召回率均高于Faster RCNN方法,分别提高了1.97%和1.14。特别是在果实重叠场景下,本文I-YOLOv2的准确率和召回率分别高出3.84%和4.12%。

I-YOLOv2与Faster RCNN模型训练时间分别是16.37和10.92 h,检测速度为用训练好的模型进行前向计算、目标位置回归的速度,分别为83和7帧/s。本文I-YOLOv2的检测速度比Faster RCNN提高了约11倍,具有更优越的实时性。原因在于:1)在Faster RCNN中,首先用区域生成网络生成2 000多个可能包含目标的候选区域,然后检测器Fast RCNN用CNN对每个候选区域进行分类,这个复杂的框架,增加了网络的计算量。而YOLOv2利用CNN对整个图像进行处理,判断目标可能的位置,缩减了可能图像块的个数,大大降低了计算复杂度[18,20]。2)Faster RCNN往往以VGG-16为训练网络,而本文以Tiny-yolo-dense为I-YOLOv2的训练网络,参数量远远小于VGG-16[29]。所以,本文I-YOLOv2相比Faster RCNN检测速度大幅度提升。

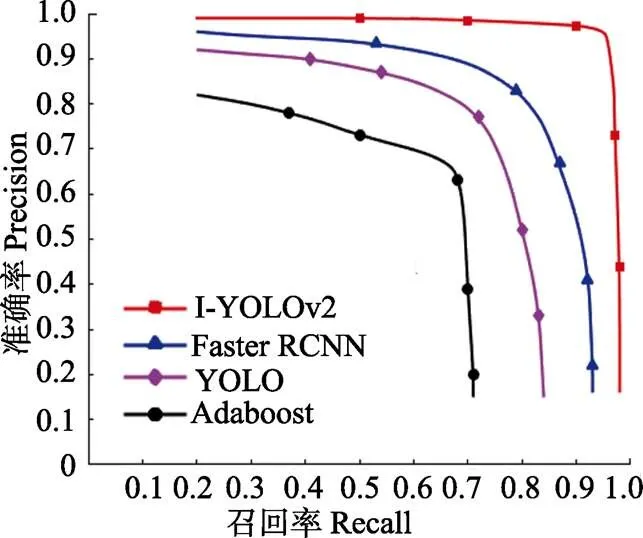

另外,用训练集A+B+C还训练了YOLO和以HOG为特征的Adaboost模型,图7为在测试集上各模型的P-R(Precision-Recall)曲线。可以看出,本文的I-YOLOv2检测精度远远高于其他模型。利用CNN进行卷积特征提取的I-YOLOv2、Faster R-CNN和YOLO的精度明显高于Adaboost。由于CNN可同时提取颜色、纹理和形状特征,优于HOG特征,故用CNN检测方法性能更加优越。

图7 P-R曲线

4 结 论

本文提出了基于改进的YOLOv2芒果目标检测方法。试验表明该模型检测精度高、速度快、对遮挡和重叠干扰具有更强鲁棒性,准确率和召回率分别达到了97.02%和95.1%,且检测速度达83帧/s。

1)提出带密集连接的Tiny-yolo-dense网络,相比Tiny-yolo网络,准确率和召回率分别提高了0.9%和1.34%。

2)提出用训练样本目标前景区域标注加强芒果前景区域卷积特征学习的方法,避免了非目标特征的提取,提高了YOLOv2芒果检测模型在重叠遮挡场景下的性能,对杂物遮挡果实检测的准确率和召回率分别提高了2.19%和4.65%,对重叠果实的准确率和召回率分别提高了9.76%和10.86%。

3)与Faster RCNN相比,本文的I-YOLOv2芒果检测网络,在杂物遮挡场景下检测准确率与召回率分别高出1.97%和1.14%,在果实重叠场景下分别高出3.84%和4.12%,检测速度提高了约11倍,体现出本文方法的快速性。相比YOLO和Adaboost模型,本文方法检测精度优势更为显著,这也为其他水果检测的研究提供了思路。

YOLOv2作为一种有监督深度学习方法,对训练数据的质量、数量与多样性均有较高要求,而样本标注是建立有效数据集必要而又耗时的工作。本文目标前景区域训练样本的使用,虽然增加了一定的样本标注工作量,但极大地提高了遮挡果实,特别是重叠果实的检测精度,而遮挡重叠的果实检测长期以来都是基于计算机视觉的水果检测的一个难题。今后,农业场景下基于半监督或无监督学习的深度网络检测方法,将成为降低手工标注样本工作量的有效途径。

[1] 李日旺, 黄国弟, 苏美花, 等. 我国芒果产业现状与发展策略[J]. 南方农业学报, 2013, 44(5): 875-878.

Li Riwang, Huang Guodi, Su Meihua, et al. Status and developmental strategies of mango industry in China[J]. Journal of Southern Agriculture, 2013, 44(5):875-878. (in Chinese with English abstract)

[2] 施茹萍. 如何提高芒果种植效率[J]. 农业与技术, 2017, 37(8): 45, 69.

Shi Ruping. The way to improve mango planting efficiency [J]. Agriculture and Technology. 2017, 37(8): 45, 69. (in Chinese with English abstract)

[3] Hussin R, Juhari M R, Kang N W, et al. Digital Image Processing Techniques for Object Detection From Complex Background Image[J]. Procedia Engineering, 2012, 41: 340-344.

[4] Payne A B, Walsh K B, Subedi P P, et al. Estimation of mango crop yield using image analysis-Segmentation method[J].Computers & Electronics in Agriculture, 2013, 91(2): 57-64.

[5] Payne A, Walsh K, Subedi P, et al. Estimating mango crop yield using image analysis using fruit at 'stone hardening' stage and night time imaging[J]. Computers & Electronics in Agriculture, 2014, 100(2): 160-167.

[6] Sa I, Ge Z, Dayoub F, et al. DeepFruits_ A Fruit Detection System Using Deep Neural Networks[J]. Sensors, 2016, 16(8): 1222.

[7] Stein M, Bargoti S, Underwood J. Image Based Mango Fruit Detection, Localisation and Yield Estimation Using Multiple View Geometry[J]. Sensors, 2016, 16(11): 1915.

[8] Tabb A L, Peterson D L, Park J. Segmentation of apple fruit from video via background modeling[C]// Asabe Annual International Meeting. 2006:1-12

[9] 谢忠红, 姬长英, 郭小清, 等. 基于改进Hough变换的类圆果实目标检测[J]. 农业工程学报, 2010, 26(7): 157-162.Xie Zhonghong, Ji Changying, Guo Xiaoqing, et al. An object detection method for quasi-circular fruits based on improved Hough transform[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2010, 26(7): 157-162. (in Chinese with English abstract)

[10] Xu Y, Imou K, Kaizu Y, et al. Two-stage approach for detecting slightly overlapping strawberries using HOG descriptor[J]. Biosystems Engineering, 2013, 115(2): 144-153.

[11] Gong A, Yu J, He Y, et al. Citrus yield estimation based on images processed by an Android mobile phone[J]. Biosystems Engineering, 2013, 115(2): 162-170.

[12] 卢军, 桑农. 变化光照下树上柑橘目标检测与遮挡轮廓恢复技术[J]. 农业机械学报, 2014, 45(04): 76-81. Lu Jun, Sang Nong. Detection of citrus fruits within tree canopy and recovery of occlusion contour in variable illumination[J]. Transactions of the Chinese Society of Agricultural Machinery, 2014, 45(04): 76-81. (in Chinese with English abstract)

[13] Roscher R, Herzog K, Kunkel A, et al. Automated image analysis framework for high-throughput determination of grapevine berry sizes using conditional random fields[J]. Computers & Electronics in Agriculture, 2014, 100(1): 148-158.

[14] 马翠花, 张学平, 李育涛, 等. 基于显著性检测与改进Hough变换方法识别未成熟番茄[J]. 农业工程学报, 2016, 32(14): 219-226. Ma Cuihua, Zhang Xueping, Li Yutao, et al. Identification of immature tomatoes base on salient region detection and improved Hough transform method[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2016, 32(14): 219-226. (in Chinese with English abstract)

[15] Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]// IEEE conference on Computer Vision and Pattern Recognition. 2014: 580-587.

[16] Girshick R. Fast r-cnn[C]// IEEE Inter-national Conference on Computer Vision, 2015: 1440–1448

[17] Ren S, He K, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Trans on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137-1149.

[18] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]// IEEE conference on Computer Vision and Pattern Recognition. 2016: 779-788.

[19] Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector[C]//European conference on computer vision. 2016: 21-37.

[20] Redmon J, Farhadi A. YOLO9000: Better, Faster, Stronger [C]// IEEE Conference on Computer Vision and Pattern Recognition. 2017: 6517-6525

[21] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]// IEEE conference on Computer Vision and Pattern Recognition. 2016: 770-778.

[22] Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C] ]// IEEE conference on Computer Vision and Pattern Recognition. 2014: 1-9.

[23] Huang G, Liu Z, Weinberger K Q, et al. Densely connected convolutional networks[C]// IEEE conference on Computer Vision and Pattern Recognition. 2016: 4700-4708.

[24] Stern U, He R, Yang C. Analyzing animal behavior via classifying each video frame using convolutional neural networks[J]. Scientific Reports, 2015, 5(1): 1-3.

[25] Ding W, Taylor G. Automatic moth detection from trap images for pest management[J]. Computers & Electronics in Agriculture, 2016, 123(C): 17-28.

[26] Bargoti S, Underwood J. Deep fruit detection in orchards[C]// International Conference on Robotics and Automation. 2017: 3626-3633.

[27] Hariharan B, Arbeláez P, Girshick R, et al. Simultaneous detection and segmentation[C]//European Conference on Computer Vision. 2014: 297-312.

[28] Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]// IEEE conference on Computer Vision and Pattern Recognition. 2005: 886-893.

[29] Redmon J. YOLO: real-time object detection[EB/OL]. https://pjreddie.com/darknet/yolo/. 2017-10-24

[30] Hripcsak G, Rothschild A. Agreement, the f-measure, and reliability in information retrieval[J]. Journal of the American Medical Informatics Association, 2005, 12(3): 296.

Immature mango detection based on improved YOLOv2

Xue Yueju1,2,3,4, Huang Ning1,2, Tu Shuqin5, Mao Liang1, Yang Aqing1, Zhu Xunmu1, Yang Xiaofan1, Chen Pengfei1

(1.5106422.510642,351064245106425510642)

Automatic target detection of immature mangoes on the trees is one of the key steps of early estimation or intelligent spraying of mangoes. In orchard scenes, it is extremely difficult to detect immature mangoes because of variability of light, complex background and high color similarity between mangoes and leaves. Especially, detection of occluded and overlapped mangoes is a challenging task. An immature mango detection model based on improved YOLOv2 with high speed and accuracy was proposed. By introducing dense connectivity pattern into Tiny-yolo, Tiny-yolo network with dense blocks (Tiny-yolo-dense) was designed. And the dense block was used to replace the 7thconvolutional layer with low-resolution feature map in Tiny-yolo to avoid adding more extra computational complexity. In the dense block, each layer receives the feature-maps of all preceding layers and passes on its own feature-map to all subsequent layers, which improves flow of information, and encourages feature reuse and multi-level features fusion. To overcome the difficulty of occluded or overlapped mango detection, foreground region samples of occluded or overlapped fruits were manually labeled, and then the foreground region samples were used to train YOLOv2 model. Feature extraction only for foreground region can avoid extracting redundant feature of non-target region in bounding box, which can enhance feature learning from foreground region of occluded or overlapped fruits. The steps of our work were stated as follows: Firstly, to reduce the influence of natural lighting variations on mango images, adaptive histogram equalization was used to improve the quality of training sample images and the variety of illumination. And foreground region and bounding box of training samples were manually labeled. The original training set including 3 702 bounding box labels of all mango targets and 1 077 foreground region labels of occluded or overlapped fruits from 660 images was constructed, and testing set for model validation including 1 713 bounding box labels of mango targets from other 300 images was also set up. In addition, training data size was augmented by horizontal flipping and multi-angle rotating according to the variety of suspension postures of mangoes. Image rotation with angles of ±10° and ±20° was used for data augmentation. And then, Tiny-yolo-dense was applied as a basic network to design the improved YOLOv2 for the mango detection. Moreover, by higher resolution inputs and multi-scale strategy, foreground region and bounding box of training samples were used to train improved YOLOv2 network. Every 10 batches, the present training scale was exchanged randomly by another one before continuing training. In this paper, input scale of 512×512 and training scales of {384, 416……672} were selected. Lastly, the trained networks were used to detect mango on testing set. The experimental results showed that the proposed algorithm had better performance for mango detection in natural scenes. At a detection rate of 83 fps, the precision rate reached up to 97.02%, and the recall rate reached up to 95.10%. Our algorithm was 11 times faster than the Faster RCNN(circular convolutional neural network), and achieved better detection performance in condition of complex scenes with occlusion and overlapping of mangoes. Moreover, our method also significantly outperforms YOLOv2 and Adaboost classifier based on HOG(histogram of oriented gradient) features. Our work provides an effective method to quickly detect mango under orchard scenes.

neural networks; feature extraction; estimation; target detection; mango; dense connectivity pattern; YOLOv2 network

薛月菊,黄 宁,涂淑琴,毛 亮,杨阿庆,朱勋沐,杨晓帆,陈鹏飞.未成熟芒果的改进YOLOv2识别方法[J]. 农业工程学报,2018,34(7):173-179.doi:10.11975/j.issn.1002-6819.2018.07.022 http://www.tcsae.org

Xue Yueju, Huang Ning, Tu Shuqin, Mao Liang, Yang Aqing, Zhu Xunmu, Yang Xiaofan, Chen Pengfei. Immature mango detection based on improved YOLOv2[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE),2018, 34(7): 173-179. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2018.07.022 http://www.tcsae.org

2017-10-24

2018-01-24

国家自然科学基金-广东联合基金(U1301253);广东省科技计划项目(2015A020209148);广东省科技计划项目(2015A020224038);广州市科技计划项目(201605030013);广州市科技计划项目(201604016122)

薛月菊,女,新疆乌苏人,教授。研究领域为机器视觉与图像处理。Email:xueyueju@163.com

10.11975/j.issn.1002-6819.2018.07.022

TP391.4

A

1002-6819(2018)-07-0173-07