气象数据中心节能实践与展望

2018-04-02王晶别毅孔令军

■ 王晶 别毅 孔令军

从源头性节能、技术性节能和结构性节能三方面对气象数据中心节能技术进行了综合概述,分析了气象部门数据中心已有的节能实践,展望了尚未应用的节能技术,提出了四点关于气象数据中心节能的进一步思考。

2015年,工信部联合国家能源局、国家机关事务管理局印发了《国家绿色数据中心试点工作方案》,其中指出:“全球数据中心建设步伐明显加快,总量已超过300万个,耗电量占全球总耗电量的1.1%~1.5%。”国际上普遍通过应用节能、节水、低碳等技术产品以及先进管理方法建设绿色数据中心,实现能源效率最大化和环境影响最小化。例如,美国政府实施了“数据中心能源之星”、“联邦数据中心整合计划”,欧盟实施了“数据中心能效行为准则”,国际绿色网格组织开展了数据中心节能标准制定和最佳实践推广,建立了绿色数据中心的推进机制,引导数据中心节能环保水平的提升。目前,美国数据中心平均电能使用效率(PUE①PUE,Power Usage Effectiveness,电源使用效率已成为国际上通行的衡量数据中心节能的主要指标。PUE值是指数据中心消耗的所有能源与IT负载消耗的能源之比。PUE值越接近于1,表示数据中心的节能程度越高。)已达1.9,先进数据中心PUE已达到1.2以下。我国大多数数据中心的PUE仍普遍大于2.2,与国际先进水平相比有较大差距,节能潜力巨大”。

气象部门数据中心作为数据中心界的一个独特分支,有着自身显著特点,需制定适合的节能策略,打造出绿色气象数据中心。

1 数据中心节能技术综述

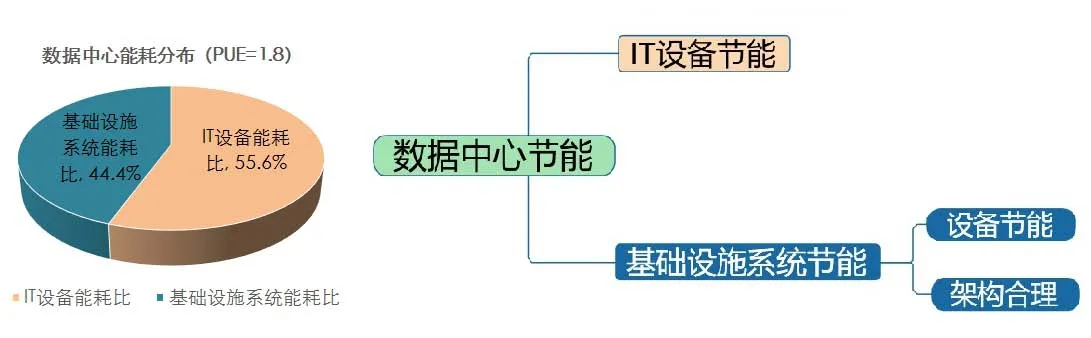

数据中心的能耗通常来自两个方面:IT设备能耗和基础设施系统能耗(主要为空调系统能耗和电气系统能耗)。以PUE为1.8的数据中心为例,其IT设备与基础设施系统能耗比例如图1所示。数据中心节能同样应从这两方面展开,其中,基础设施系统节能又可分为基础设施设备节能和基础设施架构合理。

图1 IT设备与基础设施设备能耗比(PUE=1.8)

1.1 源头性节能——IT设备

IT设备是数据中心所服务的对象,IT设备节能主要包括以下三方面:一是IT设备自身技术发展带来的节能效益,如:芯片能效比的提升、分布式存储技术的应用等。二是数据中心遇到了节能瓶颈,需从IT设备突破解决方案,反向促使了IT设备探索最新的节能技术,如:耐高温服务器的研发、液冷服务器的应用等。三是数据中心迫切的节能需求使得直接对IT设备尝试了节能方案,而进一步的节能方案还需IT设备厂家做出配合改进,如:IT设备从交流供电变为直流供电等。

1.2 技术性节能——基础设施设备

基础设施设备包括数据中心运行所必需的电气系统、空调系统、安防系统、消防系统、监控系统等。数据中心基础设施设备节能以空调系统和电气系统为主。基础设施设备节能主要包括以下三方面:一是对清洁能源的使用,如:太阳能光伏微电网、合理利用自然冷源等。自然冷源技术分为空气侧、水侧及热管的应用。二是精准、高效的节能技术,如:供电架构的变化、各种冷背板技术以及CFD(计算流体动力学)气流组织仿真的应用。三是不容忽视的辅助节能技术,如:电缆的路由的立体设计,封闭冷热通道、设置盲板等以及有关CRAC(机房空调)的综合节能(适当调高送风温度、变频器变频驱动、EC风机、管路设计、室外机组放置空间及雾化喷淋等)。

1.3 结构性节能——基础设施架构

数据中心节能不仅是节能产品和节能技术的应用,更应该是结构化的节能,从基础设施的架构设计入手,将以设备为中心的节能转到以架构为中心的节能。合理的架构不但能使维护变得简易和便捷,还能取得可观的节能收益。合理的基础设施架构设计包括两方面:1)基础设施资源的合理分配,如以等级而非属性划分机房,从而取得可靠性与节能性的平衡(N、N+X、2N等架构的选择);2)基础设施建设模式,如数据中心模块化、基础设施系统模块化等。

2 气象数据中心节能实践与展望

气象部门数据中心部署于全国各地,以国家气象信息中心(NMIC)建设的国家级气象数据中心为核心数据中心,该数据中心IT设备主要类别有:高性能计算机(HPC)、存储资源池等服务器(以下简称存储设备)、通信服务器(以下简称通信设备)等。除国家级气象数据中心外,各省也建有自己的小规模数据中心,主要以通信设备为主,个别省份也部署了较小规模的HPC。

NMIC数据中心节能实践可分为三类,分别为:高功率密度机房节能、低功率密度机房节能和通用机房节能。

2.1 高功率密度机房节能

高密度IT设备的代表是HPC,其冷却系统越来越接近热源,已从最初的环境冷却发展到冷背板冷却、芯片液冷等方式。毫无疑问,由于液冷具备冷却效率高、噪声低等优势,它将是IT设备冷却节能的主要方向,在今后的数据中心建设尤其是高密度机房建设领域将成为主流。环境冷却和冷背板冷却已应用在NMIC以往的HPC建设中,芯片液冷也即将应用在最新引进的国产HPC建设中。

2.1.1冷背板

冷背板冷却作为一种机柜级冷却方式,广泛应用于数据中心,尤其针对高密度HPC机柜,其特点是贴近热源,输送损耗小,冷却效率高。2013年,NMIC采购并安装了一套峰值计算能力为1.1 P的进口HPC系统,该系统共安装了76台机柜,单机柜功率高达30 kW,末端制冷采用水冷背板冷却方式,单背板冷量达30 kW,承载单机柜95%以上的热负荷。由于水冷背板贴近机柜,为避免背板表面结露,背板供水温度不低于15 ℃,背板的出风温度不高于27 ℃。

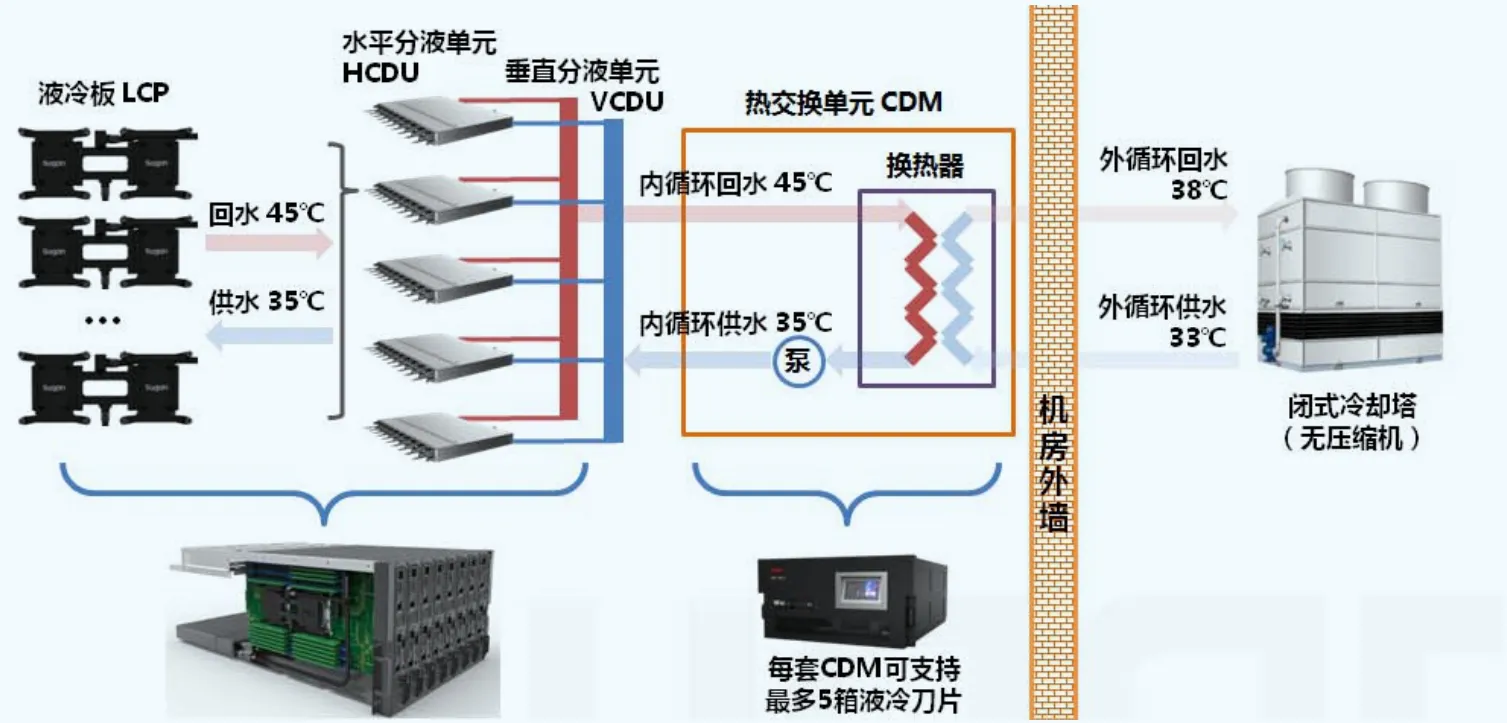

2.1.2芯片液冷

传统的服务器是依靠空气来冷却的,当IT设备的功率密度不断增大时,空气冷却已不能满足要求,只能采用液冷方式冷却,目前,服务器液冷主要有冷板液冷和浸没式液冷两种方式。NMIC即将采购的国产HPC系统采用了芯片液冷方式:CPU和内存均安装冷板,芯片液冷可带走设备65%~80%的热量。另外,由于HPC端的供水温度可以提高至35~45 ℃,因此,需要独立建设一套供水温度为33~38 ℃的高温水冷源作为该系统的专用冷源。该国产HPC系统的架构如图2所示。相比于传统的低温水(由冷水机组提供12 ℃冷水)芯片液冷HPC系统,该系统可最大限度的利用自然冷源,由全年50%时间自然冷却提升至100%自然冷却,年均PUE值由1.4可提升至1.2,节能效果显著。但由于需单独建设一套高温水冷源,相比于利用统一冷水机组提供的低温水冷源,初始投资会有所增加。

图2 高温水芯片液冷HPC冷却系统架构

对目前两个主流国产HPC厂商的高温水芯片液冷HPC产品进行了初始投资和投资回报周期测算,当HPC的采购规模为8 P时,相比于利用统一的低温水系统,新建一套独立的高温水系统的初始投资将增加183万~274万元,但节电和节水效果很显著,年运行费用节约160万~200万元,投资回收期在2年以内,节能效益明显。因此,在初始投资和场地空间建设条件允许的前提下,高温水芯片液冷HPC系统具有很高的节能效益。

2.2 低功率密度机房节能

低功率密度机房节能通常侧重于“分区风冷”和“避免损失”,因此,低密度机房针对CRAC的节能是重中之重,另外,低密度机房建设方式通常为渐进式增长,因此,模块化机房建设方式也是节能不可或缺的一部分。

低功率密度IT设备的代表是:网络、存储、通信以及普通服务器等设备,这些设备通常采用CRAC冷却,围绕CRAC的节能包括:封闭冷(热)通道以便分区冷却;为机柜安装盲板、封堵等防止冷空气短路、回流或混流;安装室外机组雾化喷淋系统降低冷凝器周围空气的温度;避免过长的管路设计以降低损耗等。以上这些节能技术在NMIC均已应用,模块化机房建设方式尚未在NMIC得以应用,但是,由于其可以较好的解决容量浪费、效率低、交付时间长、初设投资大等问题,相信在今后的建设项目中会得以应用,并取得较好的节能效益。

2.2.1封闭冷通道

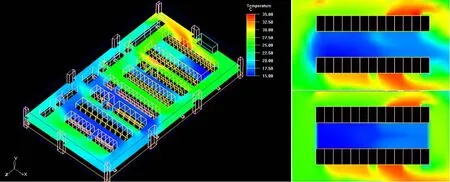

由于封闭冷(热)通道具有较好的节能效果、建设成本低、可在线安装等优势,使它几乎成为所有低密度机房节能的必选方案。2011—2017年,NMIC先后在老楼二层、三层机房共建成8组封闭冷通道,用以改善机房气流组织,隔绝冷热气流,从而达到降低送风温度、提高CRAC制冷效率、降低CRAC能耗的目的。由于冷通道封闭措施节能效果明显,且安装过程不影响IT设备运行,安全可靠,因此,该节能措施也逐步推广至各省局低密度机房的建设中,具有很强的通用性。通过CFD模拟软件,可直观看出封闭冷通道对IT设备进风区送风温度的降低和机房气流组织的改善效果。图3为NMIC神威机房神威区域的CFD建模仿真及封闭冷通道前后温度场对比,通过距地板1.5 m处的温度场对比可得出以下结论:

图3 神威机房温度场模拟及封闭冷通道前后温度场对比

1)封闭冷通道后,冷通道内温度场与周边区域完全隔离,冷通道两侧及顶部不存在回风短路现象(地板送风口出风未经过机柜换热直接回到空调回风口),冷通道顶部不存在出风回流现象(机柜出风直接回到机柜进风口)。

2)封闭冷通道后,机柜的送风、出风温度明显降低,提高了精密空调送风效率、显著降低了压缩机运行时间,使该区域空调机组能耗减少约10%。

目前,NMIC增加的8组冷通道区域对应CRAC共13台,均无备份,全年7×24 h不间断运行,总功耗约300 kW,封闭冷通道后节能约10%,全年CRAC运行可节电约263000 kW·h,每年可节约电费24.4万元。

2.2.2室外机组雾化喷淋

空调室外机组雾化喷淋系统是利用蒸发降温的原理,将水以雾状喷洒在空气中,雾粒气化时吸收热量,降低了冷凝器周围空气的温度,低温空气吸收冷凝器翅片的热量,达到对金属表面降温的作用,冷凝器散热效果的增强使得精密空调冷凝压力降低、压缩机输入功率降低,从而提高了制冷量,有效提升了空调的能效比,实现节能的目的。

在北京市发改委“2015年公共机构数据中心节能低碳示范改造工程”的支持下,室外机组雾化喷淋系统在NMIC机房空调系统中得到应用,建成了3套雾化喷淋系统覆盖NMIC老楼的全部57台CRAC室外机和6台冷水机组,并实行分区管控。

空调室外机组雾化喷淋系统由软水机组、过滤器、微雾主机、微雾高压水管、微雾喷嘴、压力、温度控制器组成。该系统耗水量低,相当于直接水喷淋冷却系统的1/60,且喷雾量可根据空调机组运行工况进行调节。经过实测发现,在夏季运行工况下(室外干球温度30 ℃),雾化喷淋系统关闭时,冷凝压力一直保持在20~22 bar,接近系统压力上限,雾化喷淋系统开启后,冷凝压力为15~18 bar,冷凝压力降低2~4 bar。通过压缩机分析软件可计算得出当冷凝压力变化时,压缩机输入功率和制冷量的变化量。计算工况如下:制冷系统过热度为8 ℃,过冷度为3 ℃,空调运行蒸发压力6.84 bar,冷凝压力21 bar。通过计算结果可知,开启雾化喷淋系统后,压缩机输入功率降低10%,制冷量增加8%。该系统全年开启时间为每年的5月15日—10月15日,每天开启时间为5 h,年耗水量约1000 ton,全年可节约用电量183000 kW·h,节约电费17万元。

2.2.3模块化机房

为解决机房设计、建设与使用时间不匹配问题,模块化机房应运而生。此模块化机房包含两个概念,其一为模块化IT机房,其二为模块化基础设施设备。模块化IT机房是指:大楼的主体和基础水电一次性建成,机房由多个集成功能的模块组成,通常情况为:将两排机柜封闭,组成一个模块,模块内配置配电、空调、布线、监控和照明等系统,使机房可以快速部署和灵活扩展,每一个模块可看作一个独立的机房,相对独立运行。模块化IT机房可以按需求灵活部署、渐进增长、降低了运维压力、提升了资源利用率。模块化IT机房中的每个模块中都有独立的基础设施设备,如:机房配电柜、专用空调、消防设备等,而与这些前端基础设施设备相连的低压配电柜、UPS、冷水机组等后端设备基础设施也可以进行模块化配置,即:模块化基础设施设备,配置小容量的基础设施设备既可以应对小规模系统,也可以灵活组合应对大规模系统。基础设施系统模块化可以使建设方式固定、系统功能独立又相互依托,化整为零,增强通用性和灵活性。

模块化机房已在国内外得到了广泛应用,Google在美国俄克拉荷马州的数据中心采用了厂房式大开间框架结构部署微模块,SwitchNap在拉斯维加斯的数据中心同样采用了易于扩展的模块化建设方式,IBM、ebay、Microsoft、腾讯等众多数据中心都应用了模块化建设方式。NMIC数据中心一直面临基础设施系统建设时间与IT设备引进时间不匹配问题,用模块化的建设模式可以得到较好解决。按IT设备的引进时间,建设模块化IT机房。模块化IT机房与IT设备匹配度更高,解决了容量浪费、效率低、交付时间长、初设投资大、运维成本高等劣势,相对传统机房一并建成、陆续安装IT设备的方式,更为合理、节能。另外,在NMIC历次机房建设过程中,都是根据IT设备需求来设计基础设施设备规模的,待IT设备淘汰时,基础设施设备还要继续为新引进的IT设备服务,由于基础设施设备规模是依据已淘汰的IT设备规模设计而成,有可能出现无法满足新引进IT设备需求的情况发生。若采用了基础设施系统模块化,选择小规模、通用性强的容量作为基本模块容量,根据IT设备规模灵活组合,实现了利旧使用、效率最大化,达到了节能目的。

2.3 通用机房节能

既适用于高密度机房,又适用于低密度机房的节能技术即为通用机房节能技术。NMIC实践的通用节能技术主要为自然冷却Free Cooling。直流供电与光伏微电网作为一种效果显著且方向明朗的通用节能技术,NMIC已对其进行技术跟踪和实地调研,同时,希望气象数据中心能够尽快应用,并取得节能效益。

2.3.1直流供电与光伏微电网

数据中心“以UPS为核心”的传统供电架构在之前几十年的机房建设领域里一直都是通用建设模式。但是,随着向IT设备直接提供直流电源的成功尝试,数据中心电气架构进入 “一路直流供电+一路市电直供”的节能供电架构。由于直流供电的电力转换比传统UPS少,蓄电池直接连接至母线,拓扑结构简单,无变压器等器件,而且向IT设备输入的电源为直流电,不存在功率因数及谐波的问题,因此,供电效率高、电能损耗少。当输入电源为市电直供方式时,整体供电系统损耗更小,仅有线损。因此,这种“一路直流供电+一路市电直供”的供电架构是一种非常节能且建设成本低的架构。该供电架构已经在腾讯天津数据中心、百度阳泉数据中心、阿里千岛湖数据中心得到了广泛应用,取得了很好的节能效果和较高的经济效益。

随着太阳能光伏技术的发展以及对极致效率的追求,由太阳能光伏阵列构建的微电网作为公用电网的一种有效补充形式已经为国外众多数据中心接受并应用。由于光伏受自然条件所限,从系统整体可靠性角度,当光伏阵列直接向IT设备供电时,IT设备的另一路电源宜采用市电供电,其供电架构为:“一路光伏直供+一路市电直供”。光伏架构无需逆变环节,太阳能光伏阵列发电后经过DC/DC变换,直接向IT设备电源模块供电,免去了电力变换,最大限度的提升了效率,而且,去除了传统架构和现有架构的前端电源设备,如:变压器、低压配电柜等,光伏直供架构作为最新的供电架构使电气节能达到极致。

利用太阳能光伏发电构建微电网在国外数据中心界有着非常广泛且大规模的应用。美国境内的大型数据中心基本均会采用绿色能源供电且节能效果显著。2015年,百度云计算(阳泉)数据中心太阳能光伏建成,成功并网发电,成为国内首个采用光伏发电系统为数据中心供电的项目,这对国内绿色数据中心建设具有里程碑式意义。

我国也十分鼓励绿色能源的使用,从国家层面给予了光伏发电优惠政策和大力支持,根据国家能源局和发改委的最新政策,分布式光伏发电按照全电量补贴。

气象部门数据中心目前仍处于传统供电架构,若能够使部分IT设备采用“一路直流供电+一路市电直供”模式,部分IT设备尝试“一路光伏直供+一路市电直供”将为数据中心节约大幅电能。以一个楼顶可用面积为4000 m2的数据中心为例,一块尺寸约为1.2 m×0.8 m的非晶硅太阳能板,每小时发电量约为140 W,楼顶至少可以安装1000个太阳能板,每小时总发电量约为140 kW,根据北京的日照情况,按平均每日4小时发电计算,理论每日可发电560 kW·h,仅电费每年可节约19万元。

虽然,数据中心部署光伏微电网也许不能满足数据中心全部用电需求,但是,应用光伏是数据中心跨入绿色节能的一个明显标志,使用清洁可再生能源是节能的终极方向。直流供电与光伏微电网作为一种通用的节能技术,将成为数据中心节能不可或缺的方向之一。若气象部门数据中心在今后的建设项目中能够以“服务器电源模块可以直接由中低压直流供电”作为采购IT设备的一项必备指标,则会使数据中心节能效果得到大幅提升,并且降低了项目前期建设成本、减少了电气损耗。另外,气象部门还需发挥在气象和日照预测领域拥有的天然优势,为光伏供电和市电供电提供调度信息,并借助国家给予分布式能源发展前所未有的推动力以及多项国家政策,推动自身的绿色数据中心建设。

2.3.2自然冷却

自然冷却是利用自然界的低温冷源进行的冷却。它采用旁通的方式,当室外温度较低时,开启旁通循环,部分或全部承担压缩机制冷循环的冷负荷,这样,通过降低机械制冷的运行时间实现全年能耗降低。自然冷却可以分为空气侧自然冷却、水侧自然冷却和热管自然冷却。其中,空气侧自然冷却可以分为直接式和间接式;水侧自然冷却分为直接水冷式、空冷式和冷却塔式。

NMIC即将引进的国产HPC系统将使用以离心式水冷冷水机组为核心的冷冻水系统,同时采用热交换器作为水冷冷水机组旁通的自然冷却技术。该系统共配置3台离心式冷水机组,旁通板式换热器,建设3套完全独立的冷却水循环,根据室外温度和机房负载自动调控运行模式:当室外温度在18 ℃以上时,全压缩机运行;当室外温度在10~17 ℃时,部分自然冷却;当室外温度在10 ℃以下时,全自然冷却,并降低冷却水温度。预计该自然冷却技术将节约制冷系统约30%的能耗,HPC机房年均PUE值预计小于1.4。

NMIC老楼三层存储机房和二层网络机房采用了次级盘管作为CRAC压缩机旁通的节能型精密空调机组,该空调将压缩机制冷系统与乙二醇自然冷却系统并联,通过循环水泵和室外干冷器将室外低温免费冷源间接带入机房,对机房设备进行冷却。目前,机房内共安装了4台节能型精密空调,总冷量320 kW,预计全年可节约电量245000 kW·h,节约电费约22.8万元。

3 关于气象部门数据中心节能的进一步思考

气象部门数据中心有着自身显著特点,其节能除了应关注前述源头性节能、技术性节能和结构性节能外,还应该利用其在气象和日照预测领域拥有的天然优势,提供预测服务和调度信息,做出不同于众的节能成绩。

3.1 充分发挥自有机房优势,实现全方位节能

数据中心分类的依据较多,例如:从功率密度角度可分为高密度数据中心、低密度数据中心和混合全密度数据中心;从建设规模角度可分为中小规模数据中心、大规模数据中心和超大规模数据中心;从数据中心归属角度可分为自有数据中心和租赁数据中心。目前,凡具有较大规模且欲谋求更大发展的组织均会选择自建数据中心,如:以银行、证券部门为代表的金融机构;以三大运营商、能源部门(中石油、中石化)为代表的大型国企;以百度、阿里巴巴、腾讯为代表的互联网公司等全部选择自建数据中心,显然,自有数据中心从灵活可控、安全可靠以及运维成本角度更胜于租赁数据中心。

气象部门作为一个服务于国计民生的行业,每天都会产生大量的气象数据,气象数据中心的重要性不言而喻,虽然气象数据中心重要性很高,但其规模却属于中小型,因此,自建数据中心不但适合气象数据中心特性,而且从节能角度,自有数据中心贯彻节能号召更为主动、系统、高效。自有数据中心能够充分发挥系统性节能优势,从设计、建设到运维、改进,可以将节能渗入数据中心的每一方面,以全局视角打造有特色的绿色节能型气象数据中心。

3.2 加快整合机房资源,提高系统利用率

多处零散的小规模数据中心必然带来IT系统和基础设施系统的重复建设、效率低下等劣势,若能将机房资源进行有效整合,建设统一的数据中心,配置规模合理的基础设施设备,使其利用率达到较佳水平,既有利于统一管理、调度,又可以降低基础设施设备的系统功耗,达到节能的目的。

3.3 梳理业务需求,重新定位可靠性

业务需求决定了数据中心IT设备的可靠性,如银行、证券等部门将数据中心可靠性列为首要关注指标,而同样拥有实时业务的互联网公司对数据中心的可靠性并不特别关注,而是综合考量可靠性、节能性、运营成本等诸多因素的平衡。目前,NMIC气象数据中心所有IT设备均要求高可靠性,这使得为其服务的所有基础设施系统均需按高可靠性设计和配置,这必然会影响其它因素,如:节能、系统效率、运维成本等。因此,若能尝试梳理业务真正需求,重新定位IT设备的可靠性,并以IT设备保障等级作为气象机房划分依据,不同等级机房予以不同保障等级,机房的建设成本和维护成本也依据不同等级而不同,节约了基础设施资源,从源头上实现了数据中心节能。

3.4 节能需向“科学化的运维和管理”延展

数据中心节能除了设备节能、技术节能、架构节能外,还应该关注科学化的运维和管理,包括以下三个方面:1)IT设备的系统级节能,如:通过资源调度,降低空闲能耗;根据进程能耗调整CPU任务队列,实现能耗均衡以及虚拟化技术等;2)基础设施运维级节能,如:根据监控系统精细化的能耗监控,有针对性的局部解决问题,而非针对整个机房采取规模性的节能方案;3)建立科学化的运维体系,充分发挥体系的规范机制,激发人的能动性,发现并处理问题于无形阶段,使设备一直处于较佳模式,避免极端问题的发生,从而实现节能。

深入阅读

段轶伊, 姜俊海, 李瑞雅, 2014, 等. 数据中心空调节能技术的应用实例. 制冷与空调, (9): 18-21.

谷立静, 杨宏伟, 胡姗, 2015. 美国数据中心节能经验和启示. 中国能源, 37(6): 26-29.

黄冬梅, 杨超, 2015. 计算流体动力学在数据中心的应用. 现代建筑电气, 6(9): 6-11.

李新鹏, 侯振宁, 陈硕, 2014. 冷热电三联供在数据中心的应用. 通信电源技术, 31(4): 75-78.

张海南, 邵双全, 田长青, 2016. 数据中心自然冷却技术研究进展.制冷学报, 37(4): 46-57.