IPv6车联网中视频智能处理系统的设计与分析

2018-03-09许珂蒲霖张琳

文/许珂 蒲霖 张琳

针对自动驾驶车辆视野范围强依赖于硬件配置和部署场景的局限性,设计了一个基于IPv6融合人工智能的车联网视频智能处理系统—— IPv6_See_Through,利用IPv6的动态自动配置地址以及增强的组播流媒体控制技术,车辆融合多路视频后通过深度学习进行目标检测,进而增大自动驾驶汽车的驾驶感知范围、提高感知信息的准确性,解决依赖自身传感器无法解决的问题,如盲区监测、不良视线检测等。分析表明本系统可保证视频画面实时性与检测准确性,具有一定实用价值。

随着现代传感技术、数据分析、人工智能等技术与设备的飞速发展,近年来智能交通系统(ITS)的学术研究和行业发展十分突出,对提高交通服务智能化的各个方面产生了深刻的影响。在国外,谷歌、特斯拉、Mobileye自动驾驶系统,基于传感器、雷达和摄像头的各种信息输入,通过人工智能技术决策,单车自动驾驶已经在一定程度上实现。在国内,2016年9月28日,华为、奥迪、宝马、戴姆勒、沃达丰、爱立信、英特尔、诺基亚、高通宣布结成了5G汽车联盟(5GAA)。各公司将在车联网通信解决方案的开发、测试、促进销售方面展开合作,并支持标准化,加快商用化和向全球市场推广。目前已涵盖主要车企、运营商与设备商成员40多家。

然而,通过车辆自身传感器等硬件设备获得环境信息具有很大的局限性,车辆视野范围强依赖于硬件配置和部署场景。在晚上、雨雪天、雾天等恶劣天气下,在交叉路口、拐弯处等场景,雷达、摄像头存在看不见,看不清,看不准的情况。特斯拉曾发生过的一次致命事故,即为在强烈的日照条件下,自动驾驶未能识别卡车的白色车身,因此未能及时启动刹车系统所导致。针对这些场景开发性能更强的传感器,成本会高到消费者无法承受的地步。

针对上述问题,利用V2X通信(V2I,V2V,V2P)技术,能够提供远超出当前传感器感知范围的信息。本质上可以把V2X视为一个拉长拉远的“传感器”,通过和周边车辆、道路、基础设施的通讯,获取比单车能得到的更多的信息,大大增强对周围环境的感知。同时,相对于IPv4网络协议,IPv6协议更大地址空间、动态地址自动配置、加强的组播以及对流媒体控制的特性,使IPv6在车联网视频传输中提高网络整体吞吐量、支持构建动态合作式视频处理系统、改善视频传输性能与质量。更进一步的,通过深度学习的方式使车辆更加智能化的自主判断道路状况并做出应急措施。

本文设计了一个基于IPv6融合人工智能的车联网视频智能处理系统—— IPv6_See_Through,增大自动驾驶汽车的驾驶感知范围、提高感知信息的准确性,解决依赖自身传感器无法解决的问题。最后给出数据分析表明系统的可靠性。

IPv6_See_Through系统设计

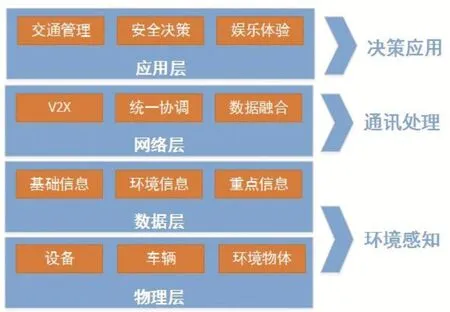

自动化驾驶车辆应犹如人一样具有感知和决策能力。眼睛可以看见视野范围内的各个物体即环境感知能力,耳朵可以收到其他物体传来的讯息即通讯能力,大脑则将收集到的所有信息分析处理、最终做出决策以控制行动即决策应用能力。本文将上述能力概括为ITS的五层概念模型如图1所示,用于表征自动驾驶系统的典型架构和主要组件。

图1 IPv6_See_Through系统概念模型

物理层:物理层封装ITS中涉及的各种物理实体,如数据采集设备(数码相机、摄像头、传感器、雷达、pad),车辆和其他公共环境物体(交通信号灯)等。各物理实体为数据生成的源头。该层通过实体间的合理配置,快速获得高质量高可靠性的数据信息。比如车辆视频的获取可通过安装固定摄像头,也可通过常用具有摄像功能的手持设备(pad、手机等)。

数据层:将物理层得到的信息划分为三类。基础信息,即时间、速度、GPS位置等,一般为文本类信息;环境信息,即道路状况、交通灯、建筑物等可看见的信息,一般为图像视频类信息;重点信息,即事故、提醒等由其他设备直接报告的信息,文本、图像、声音等信息均可。该层相关技术包括数据存储技术、数据处理技术(视频数据压缩、数据格式选择)等。视频数据在处理(融合、人工智能)之前,需保存于可靠位置,以保证与其他数据的后续融合处理。又由于数据冗余性会占用带宽且给其他通讯设备造成无效信息处理的负担,所以需要用到视频压缩等关键技术以保证可靠性和安全性。

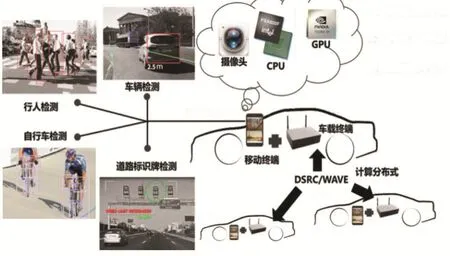

图2 IPv6_See_Through系统实现

网络层:车联网V2X通讯包括V2V(车和车)、V2I(车和基础设施)、V2P(车和人)三个方面。其基本要求是V2V的通讯必须随处可用,包括没有网络覆盖的环境,所以V2V的直联是V2X的基本功能。IEEE下面有IEEE 802.11p(DSRC),LTE下面有 LTE-V PC5,都支持V2V直联。许多自动驾驶场景下(如编队行驶、并道等),因为收发车辆的距离近,V2V的直联是更好的通讯模式。另外,由于车辆环境复杂,网络节点(车辆、基础设施、人)众多导致数据量大,所以需要网络拥塞控制、干扰管理和网络覆盖方面的统一协调,将相关视频数据融合可有效减少数据冗余的问题。

图3 视频传输流程

应用层:对有效信息进行处理决策以控制车辆行为,该层使用的关键技术有深度学习、人工智能等。

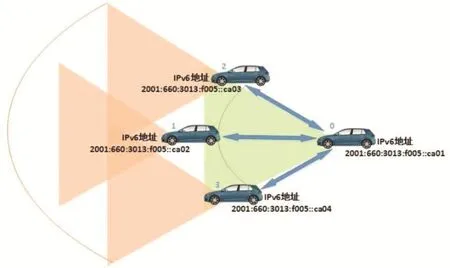

上述模型具体化为IPv6_See_Through系统实现,如图2所示。0号车辆的视野范围为绿色区域,1-3号车辆的视野范围为橙色区域且具有重叠部分。0号车辆的视线被1-3号车辆阻挡,若1号车辆前方发生紧急刹车状况时,极有可能导致追尾情况。然而,若0号车辆接收来自1-3号车辆视野视频并融合为大视野视频,最后通过深度学习等技术识别分类视频中的物体(汽车、人等),尽早在更大视野中做出预判,有效减少事故的发生率。

系统关键技术分析

高速率低时延的视频传输技术

信息传输是合作式自动驾驶的基础,越快速高质量的传输,信息的效用越高,越有利于后续车辆做出正确的判断和抉择。目前车辆数量极大,且车联网环境具有拓扑变化快、车辆之间接触时间短、通信链路不稳定、传输带宽有限、实时性要求较高等特点,文本信息数据量相对较小,传输完成所需时间短,而视频信息数据量巨大,在车辆接触的有限时间有限带宽下,极容易发生信息传输不完整、播放中断、画质不清晰等问题。如图3为视频传输流程图所示,视频从产生、编码、传输到最后播放消费,各个环节都会产生延迟。其中,成像延迟取决于硬件设备,视频编解码延迟和网络延迟通过策略的选择可有效改进。

因此主要考虑如下三点:

(1)使用IPv6地址分配于各车辆以适应车联网节点多的特性。IPv4中规定IP地址长度为32bit,最大地址个数为2^32;而IPv6中IP地址的长度为128,即最大地址个数为2^128,且网络中一个接口可以有一个或多个IPv6地址,将IPv6应用到车联网中,有效解决了地址匮乏问题。

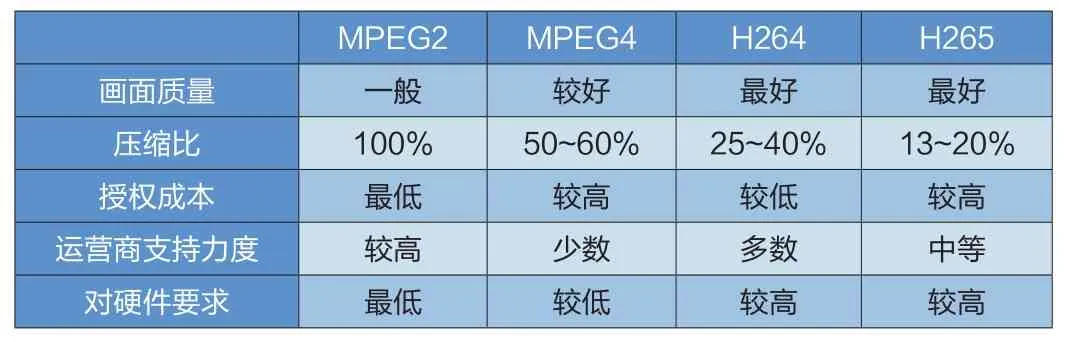

表1 视频压缩标准性能对比

图4 图像拼接流程

(2)选择高效的视频编解码方式以提高带宽利用率、保证传输速率与视频连续性。如表1所示,由于 H.264的压缩比高,授权成本较低,使用领域非常广泛,本文采用H.264编码方式。以MPEG2压缩比为1相比,H.264可达到25%-40%的压缩比率。

(3)选择合适的车辆间网络数据传输协议和传输方式以适应车辆接触时间短的特性。一方面,车联网中车辆为多对多的传输方式。IPv4中定义了三种数据包的传输:单播、组播和广播。组播是一种允许一个或者多个发送者(组播源)发送单一的数据包同时到多个接受者的网络技术,其传输机制是无论有多少个目的地址,在整个网络的任何一条链路上只传输单一的数据包,所以相对于单播,组播具有节约带宽、提高传输速率的优越性。IPv6 协议加强了组播技术并增加了对流媒体的控制,高效实现多路视频数据信息传输。 另一方面,由于车辆接触时间短,通信前需要建立连接的方式会导致时延增加,所以车辆间通信采用802.11p协议(DSRC),802.11p协议中规定工作站可以在不加入基础服务集的情况下建立通信链路,减少了由于加入服务、建立连接、权限认证等过程所消耗的时间,适合高速移动的车载环境。

基于视频融合的分布式目标检测与追踪技术

在目标检测与追踪之前,车辆接收到多路视频后,需要将多路视频融合为大视野视频,以减少视频冗余度,进而降低后续深度学习处理的的目标检测与追踪复杂度与消耗时间。

视频融合的基本技术为图像拼接技术。图像拼接的基本流程如图4所示,主要分为四个步骤:图像匹配(registration)、重投影(reprojection)、缝合(stitching)和融合(blending)。

图像匹配:是指一对描绘相同场景之间的几张图片的几何对应关系。一组照片可以是不同时间不同位置的拍摄,或者由多个传感器同时拍摄多张图像。

重投影:通过图像的几何变换,把一系列图片转换成一个共同的坐标系。

缝合:通过合并重叠部分的像素值并保持没有重叠的像素值使之生成更大画布的图像。

图5 基于视频融合的分布式架构

图6 OpenCL的工作模型

融合:通过几何和光度偏移错误通常导致对象的不连续,并在两个图像之间的边界附近产生可见的接缝。因此,为了减小接缝的出现,需要在缝合时或缝合之后使用混合算法。

进一步,对于单辆汽车而言,由于移动平台其资源受限性和计算能力有限,导致无法进行实时的基于深度学习来做道路物体检测。为此,本文提出一种基于车队通信的分布式深度学习方案,主要用于深度学习执行阶段的分布式计算。分布式架构图如图5所示。每一辆车安装一台车载通信单元 OBU(on-board unit),用于DSRC车辆间通信,同时车辆中安置一台手机,其摄像头用于视频数据的采集,CPU和GPU用于视频数据处理融合以及深度学习的计算。车辆间互相通信传输视频流等信息。当车辆一收到车辆二和车辆三的摄像头中视频流的图片帧后,进行图像融合并且进行分布式目标检测。车辆检测到目标后,识别目标种类与目标的状态作出安全决策,如刹车、减速等行为。

表2 视频参数

图8 视频4路互传实验

图9 两路视频融合互传实验

在Android手机计算集群中,配置有GPU计算设备的计算节点,在目标识别的过程中不但应该充分利用CPU计算能力,更应该充分挖掘GPU强大的并行能力。在GPU并行方案里面,OpenCL具备扩展能力强,并行充分等特点。故本工程采用OpenCL作为GPU并行计算的调用框架。OpenCL提供了控制并行计算设备的一些接口以及一些控制单元行为的类C编程语言。利用OpenCL接口可以开发并行度高、运行在GPU或者其他处理设备上的程序。OpenCL的工作模型如图6所示.

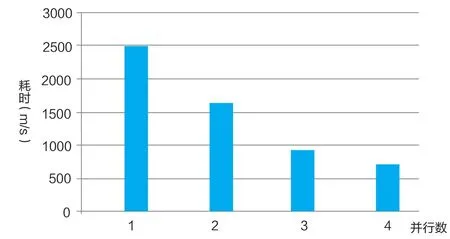

图1O 分布式图片处理实验数据

在深度学习中,运算量最大的卷积层采用OpenCL进行并行GPU加速,根据卷积算法的特点,使用OpenCL实现卷积算法可以分为以下几个步骤:创建OpenCL的存储器对象,即图像对象和缓存对象;通过提供一个三维的偏移和范围并调用函数,将图像对象拷贝到GPU缓存中;编译并执行内核函数。同时单幅图片在单台手机上的识别,采用Yolo深度学习模型耗时1~3秒左右,不能达到安全实时的需求。由此我们设计一套分布式计算的方法去将单台手机计算量划分到多个组中进行。每台手机就是计算任务中的一个进程,手机之间采用OBU的DSRC进行通信。将深度学习中的卷积层的对图像的卷积计算进行横向划分,每台手机负责矩阵图像中的部分矩阵行数据。由此使用分布式技术提升深度学习的计算速度。

系统数据分析

实验中,我们采用4台华为pad进行视频的多路传输,如图8所示,每路视频延时小于0.5s。视频参数如表格2所示。视频传输后,系统做实时融合,两路视频融合时间约为15ms/帧,如图9所示标明图中两帧图片的界线,分别为红色边界和白色边界。

视频融合后,采用最多 4台华为pad进行并行化目标识别,采用Tiny-YOLO的网络结构,其实验结果如图10。

对于单张图片的计算耗时,随着分布式程度的增加时间大大减少。采用4台手机并行处理图片其总时延在1s以内,基本满足安全性要求。

通过车辆间通信形成庞大的合作式智能网络来交换重要信息的方式可大大拓宽车辆视野;通过深度学习的方式使车辆更加智能化的自主判断道路状况并做出应急措施。本文设计的融合IPv6技术的车联网中视频智能处理系统—— IPv6_See_Through,采用视频分发合作的方式,利用IPv6的动态自动配置地址以及增强的组播流媒体控制技术,车辆融合多路视频后通过深度学习进行目标检测,进而增大自动驾驶汽车的驾驶感知范围、提高感知信息的准确性,解决依赖自身传感器无法解决的问题,如盲区监测、不良视线检测等自身传感器无法解决的问题,如盲区监测、不良视线检测等,可起到防患于未然、降低自动驾驶系统成本、提高系统可靠性等作用。在以后研究中将进一步提高系统性能。

(责编:高锦)

[1] 国家车联网产业标准体系建设指南(智能网联汽车)(2017)

[2] Vinel A, Belyaev E, Lamotte O, et al. Video transmission over IEEE 802.11p: Real-world measurements[C]// IEEE International Conference on Communications Workshops. IEEE, 2013:505-509.

[3] Liu Z, Dong M, Zhang B, et al. RMV: Real-Time Multi-View Video Streaming in Highway Vehicle Ad-Hoc Networks (VANETs)[C]// GLOBECOM 2016 - 2016 IEEE Global Communications Conference. IEEE, 2016:1-6.

[4] Segvic S, Sevrovic M, Kos G, et al. Preliminary experiments in multi-view video stitching[J].Proceedings of the International Convention on Information and Communication Technology, Electronics and Microelectronics ? MIPRO 2011 / Bogunovi?, Nikola ; Ribari?, Slobodan, 2011:892-896

[5] Dan G, Marpe D, Mulayoff A, et al. Performance comparison of H.265/MPEG-HEVC, VP9, and H.264/MPEG-AVC encoders[C]// Picture Coding Symposium. IEEE, 2014:394-397.