一种基于CNN和人体椭圆轮廓运动特征的摔倒检测方法

2018-02-23邓志锋闵卫东

邓志锋,闵卫东,邹 松

一种基于CNN和人体椭圆轮廓运动特征的摔倒检测方法

邓志锋,闵卫东,邹 松

(南昌大学信息工程学院,江西 南昌 330031)

为了解决传统的使用几何特征检测摔倒的方法的不稳定、难于区别一些相似的活动等问题,提出了一种基于卷积神经网络(CNN)和人体椭圆轮廓的运动特征的摔倒检测方法。首先,使用高斯混合模型检测出人体目标并求出其最小外接椭圆轮廓。然后在每一帧的椭圆轮廓中提取出长短轴之比、方向角和人体质心的竖直方向速度,融合成一个基于时间序列的运动特征。最后,经过一个浅层的CNN对这些运动特征进行训练,用于摔倒判断,并区分相似的活动。实验结果表明,本文方法和现有的方法相比,克服了几何特征的不稳定性,提高了检测率。

摔倒检测;卷积神经网络;人体椭圆轮廓;时间序列;运动特征

随着中国人口老龄化不断加重,老年人健康问题越来越受到关注。因此,防止老年人摔倒也变得越来越重要了。

如今越来越多的研究者们基于计算机视觉研究了各种摔倒检测方法应用于室内监控,因为基于视觉的方法能够避免穿戴式传感器方法的不方便[1]和基于声音或震动传感器方法容易被噪声影响的缺点[2]。如今已经有许多基于视觉的摔倒检测方法,其中YAO等[3]使用Kinect摄像机提取出人体骨骼,通过主躯干的角度对摔倒进行了判断;AKAGÜNDÜZ等[4]使用了一个单目深度摄像机拍摄出深度视频,再使用轮廓方向体积描述符去代表活动并进行摔倒分类。但是Kinect受距离的限制,深度摄像机容易被噪声干扰。一个单目摄像机非常适合在室内进行视频监督。基于单目摄像机检测摔倒的一个最经典的方法是通过提取几何特征来判断。MIN等[5-6]通过使用一个最小外接矩形边框来表示行人的形状,根据边框宽高比的变换来代表行人的形态比变换来判断摔倒,并能判断不同方向的摔倒。LIU和ZUO[7]融合了形态比,有效面积比和中心变化率判定摔倒。FENG等[8]使用椭圆拟合来代表行人的形状,分别提取出了长短轴之比、方向角、速度和一个积分归一化运动能量图,融合了几何特征和运动特征,再通过一个多层SVM进行分类并判断摔倒。CHUA等[9]在人体轮廓中选取3个代表性的点来代表行人的形状去判断摔倒。然而,这些方法都有不足。因为几何特征不稳定,使用传统的方法难以区别一些相似的活动,容易产生误判,加入了运动特征又容易受到角度的影响,对检测率有一定的影响。

为了解决上述问题,本文提出了一个基于卷积神经网络(convolution neural network,CNN)和人体椭圆轮廓的运动特征的摔倒检测方法。使用了椭圆拟合并提取3个椭圆轮廓特征融合成一个基于时间序列的运动特征,再使用深度学习的方法去训练和分类,用于区别一些相似的活动。

1 人体椭圆轮廓的运动特征提取

1.1 前景检测

在前景检测部分采用了高斯混合模型(Gaussian mixture model,GMM)的方法,把每个像素所呈现的颜色用多个高斯分布来表示。将每个时刻的每个像素看作成一个变量,在进行前景检测前,先对背景进行训练,对每一帧图像中每个背景采用一个混合高斯模型进行模拟。背景一旦提取出来,前景的检测就简单了,检查像素是否与背景的高斯模型匹配,匹配是背景,不匹配就是前景。前景抽取出来后,再采用阴影抑制法去抑制阴影。抑制完阴影后,图像可能会有一些空洞和噪声,再采用膨胀和腐蚀等形态操作去解决这个问题。

1.2 椭圆轮廓的运动特征的提取

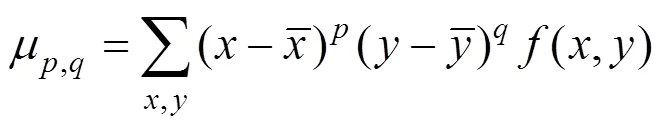

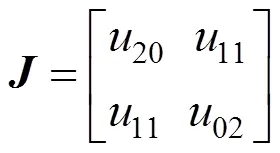

根据中心矩,可通过式(2)计算出椭圆的方向角为

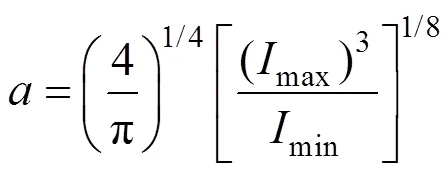

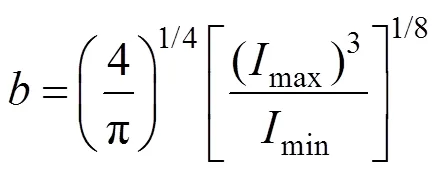

且可以依次计算出椭圆的长、短轴,其计算公式为

其中,max和min分别为式(5)定义的矩阵的最大特征值和最小特征值

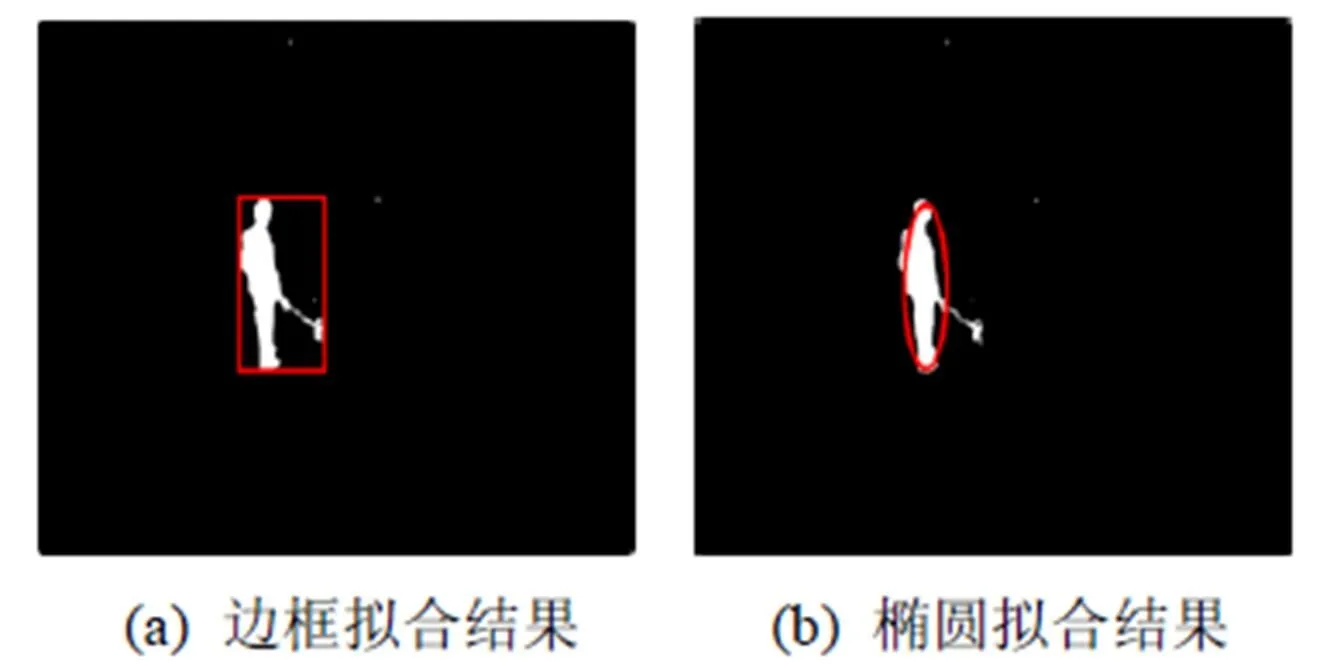

图1对比了椭圆拟合和边框拟合。由图1可知,椭圆拟合比边框拟合更能有效地描述人的运动姿势,因为边框拟合会由于人手臂的运动或手中拿有细长物而容易发生很大的变化。因此本文使用了椭圆拟合来表示人的运动。

图1 边框拟合和椭圆拟合的对比图

1.3 运动特征的提取

随着使用椭圆将前景目标进行拟合后,本文基于椭圆轮廓提取出了2个特征:

(1) 轮廓特征。提取出了椭圆的方向角和椭圆的长轴和短轴的比=/用来代表人的轮廓形状。如果一个人沿着主光轴的方向摔倒,将会发生剧变而方向角基本保持不变。反之,方向角会发生很大的变化而基本保持不变。

(2) 速度特征。如果摔倒发生了,人在竖直方向的速度通常会发生很大的变化;因此,提取了人的竖直方向的速度。本文先求得每间隔两帧中的人的质心的欧氏距离与时间的比值,然后再与椭圆的方向角的正弦值的乘积作为人的竖直方向的速度公式,即

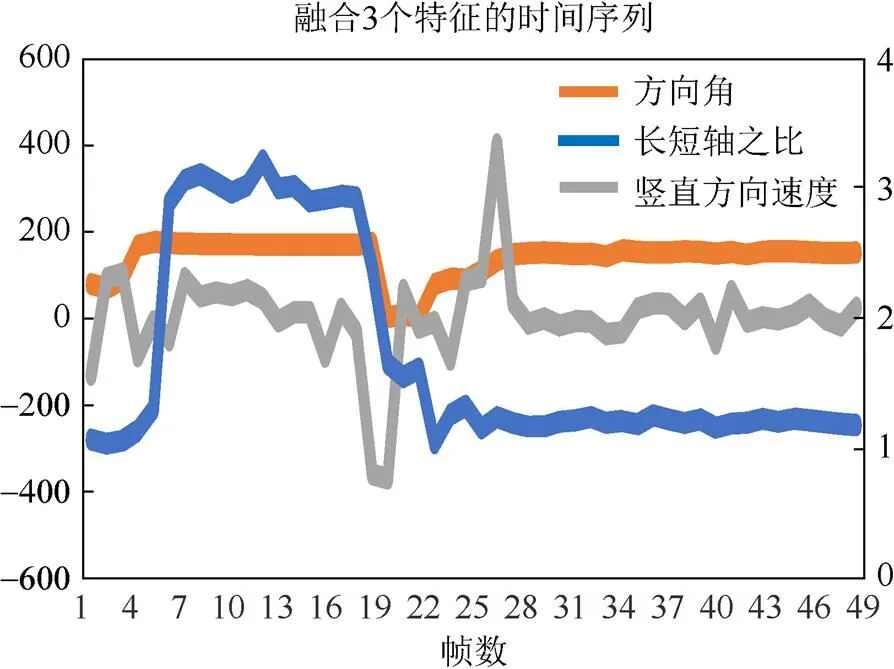

图2中列举了一个摔倒时的特征示意图,以水平方向为轴,竖直方向为轴,其中为长轴,为短轴,为椭圆的方向角,V为质心竖直方向的速度。本文将提取出来的2个特征组成了一个如图3所示基于时间序列的运动特征。

图2 摔倒时的特征示意图

图3 运动特征的时间序列

如图3所示,将50帧中的2个特征折线图组成一个基于时间序列的运动特征,将其经过一个浅层CNN进行学习,并用于区别一些相似的运动。

2 基于CNN的摔倒检测

2.1 卷积神经网络(CNN)

CNN是一种前馈神经网络,其人工神经元可以响应一部分覆盖范围内的周围单元,对于大型图像处理有出色表现。经典的CNN包括卷积层 (convolutional layer)、池化层 (pooling layer)和全连接层(fully connected)。CNN的结构描述如下:

(1) 卷积层。将输入的原始图像通过与多个可训练的滤波器(或称作卷积核)和可加偏置向量进行卷积运算得到多个映射特征图。

(2) 池化层。通常在卷积层后面,用来进行向下采样,降低特征的维数。最传统的两个池化方法是最大池化(max-pooling)和均值池化(average pooling)。

(3) 全连接层。当原始图像经过多个卷积层和池化层的处理之后,再将输出的特征图像压平成一个一维的向量并用于分类。可以将其他的特征加入到这个一维向量中并用于分类。CNN中可以由一个或多个全连接层用来最终的分类。

2.2 使用CNN的摔倒检测方法

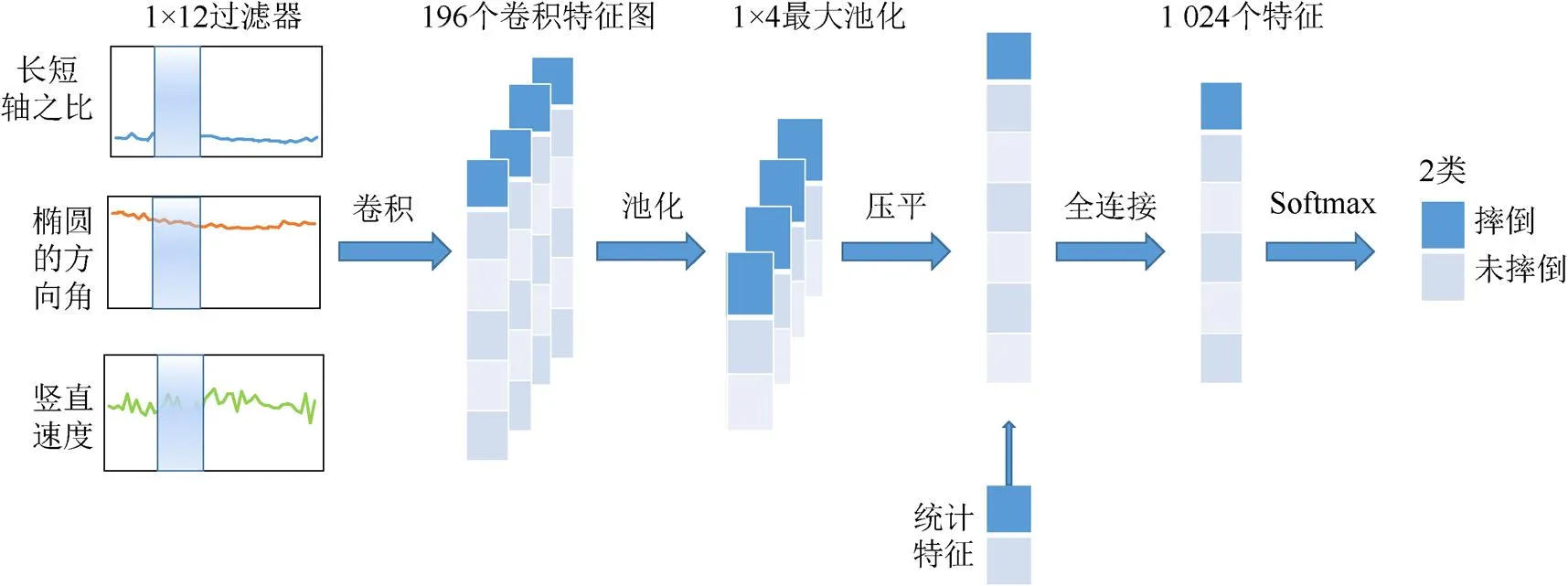

本文提出将一个浅层的CNN结构(图4)引入到摔倒检测中。用CNN对这组基于时间序列的运动特征进行学习。具体结构如下:首先在卷积层使用196个大小为1×12的过滤器对分割好的基于时间序列的3个特征图进行学习得到一个关于数据的丰富的特征代表,其中,卷积层只有一层。然后再用ReLU激活函数对这196个特征图进行处理后,通过一个大小为1×4的最大池化层将其缩小4倍进行降维处理。池化层输出的特征图进行压平,再加上一些统计特征(例如均值、方差等特征)放在一起通过全连接层得到1 024个特征。最后将全连接层得到的特征通过soft-max函数进行最后的分类计算。该模型被训练为最小化交叉熵损失函数,与CNN权值的2范数正规化相结合。利用反向传播算法对梯度进行计算,利用随机梯度下降的修正方法对网络参数进行优。

图4 基于多特征融合的摔倒检测的浅层CNN架构

3 实验结果及分析

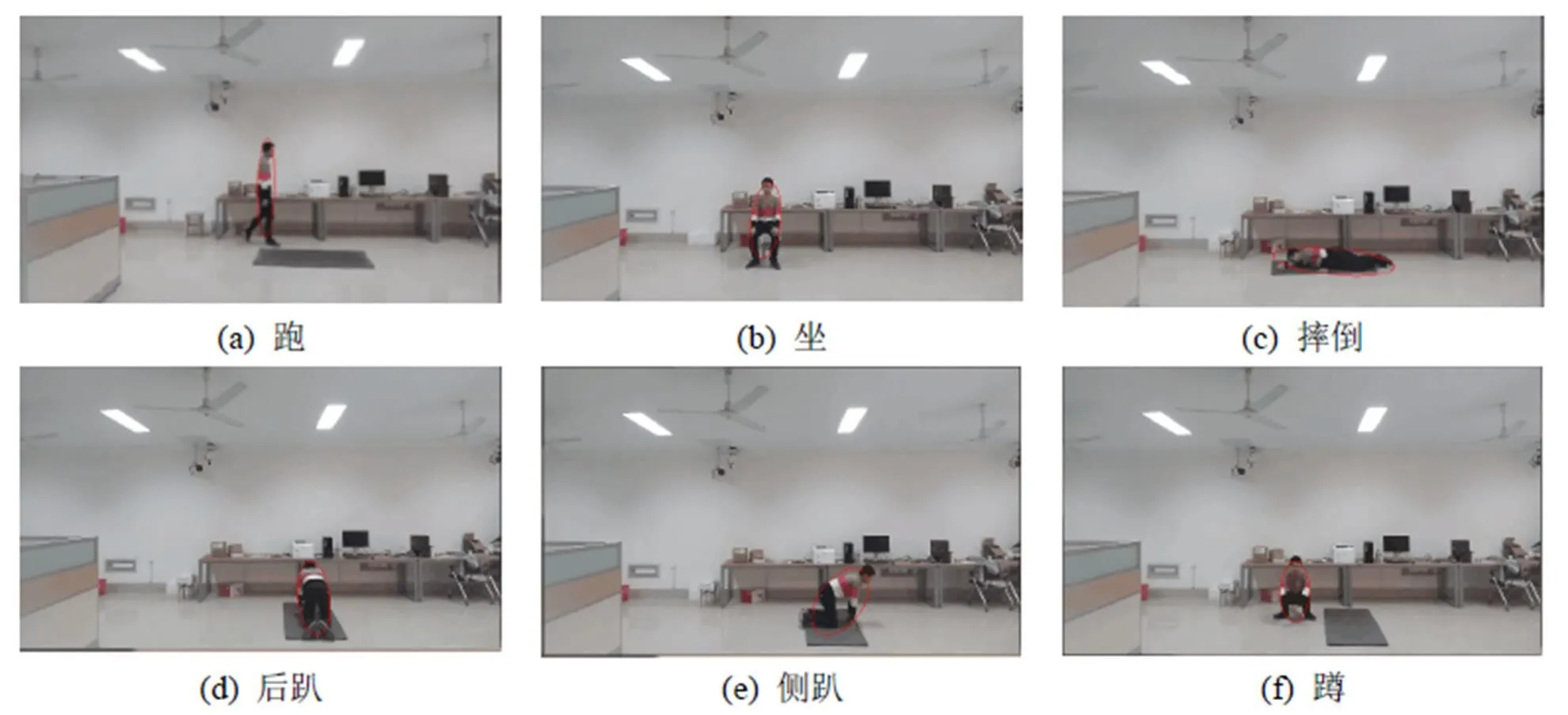

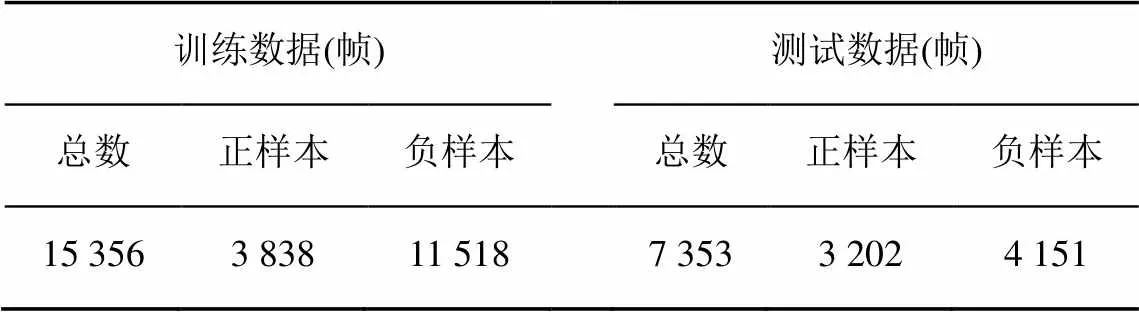

本文实验平台是一台Inter(R) Core(TM) i5-4300U CPU @ 1.9 GHz,4 GB内存的PC,编程软件有VS 2010、OpenCV 3.0、Matlab 2014a和Eclipse。为了训练本文提出的CNN框架,拍摄了16个视频,并收集了15 356帧图像的数据进行训练,其中有3 838帧正样本和11 518帧负样本,视频截图如图5所示,包括摔倒、走、跑、卧、蹲和坐等。为了验证本文提出的方法比现有的基于几何形状特征的摔倒检测方法性能更好,在网上下载了公共数据集,视频网址http://foe.mmu.edu.my/digitalhome/ FallVideo.zip,并在该公共数据集中采集了3 202帧正样本和4 151帧负样本进行测试。详细的实验数据说明见表1。

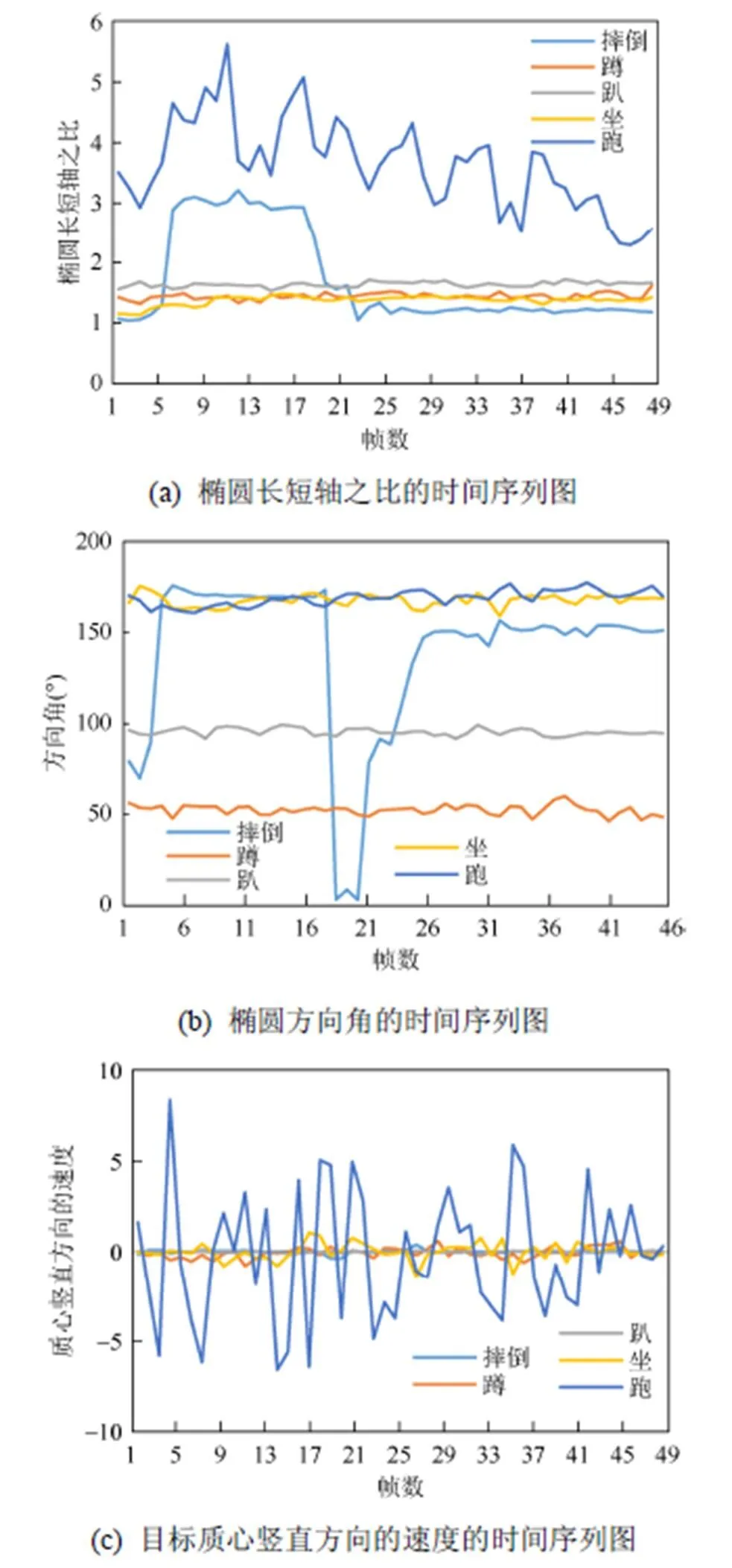

图6分别显示了5个日常的动作的3个特征在50帧中不同的变化情况,包括摔倒、蹲、趴、坐和跑等活动。

图5 日常活动图

表1 实验数据说明表

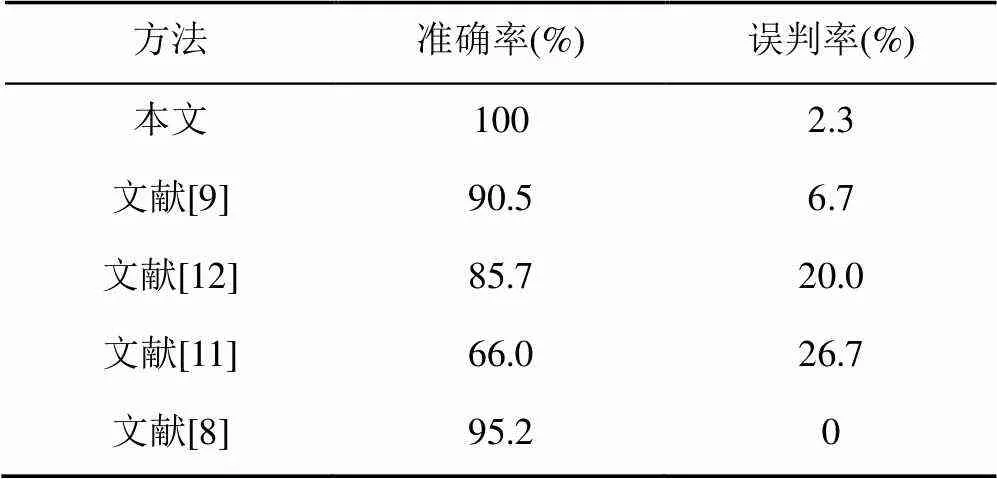

将不同的活动的3个特征融合成如图3中的基于时间序列的运动特征,再放入图4中提出的CNN架构中进行训练和测试。得出的结果分别与文献[8-9,11-12]中的现有的方法做了比较,对比的实验结果见表2。

由表2可知,本文方法在公共数据集上实现了100%的准确率和2.3%的误判率,能够有效地区别一些相似的活动,比现有的基于几何形状特征的摔倒检测方法的准确率高许多;在误判率上也实现了较好的结果。

图6 5个日常动作的特征图

表2 对比实验结果

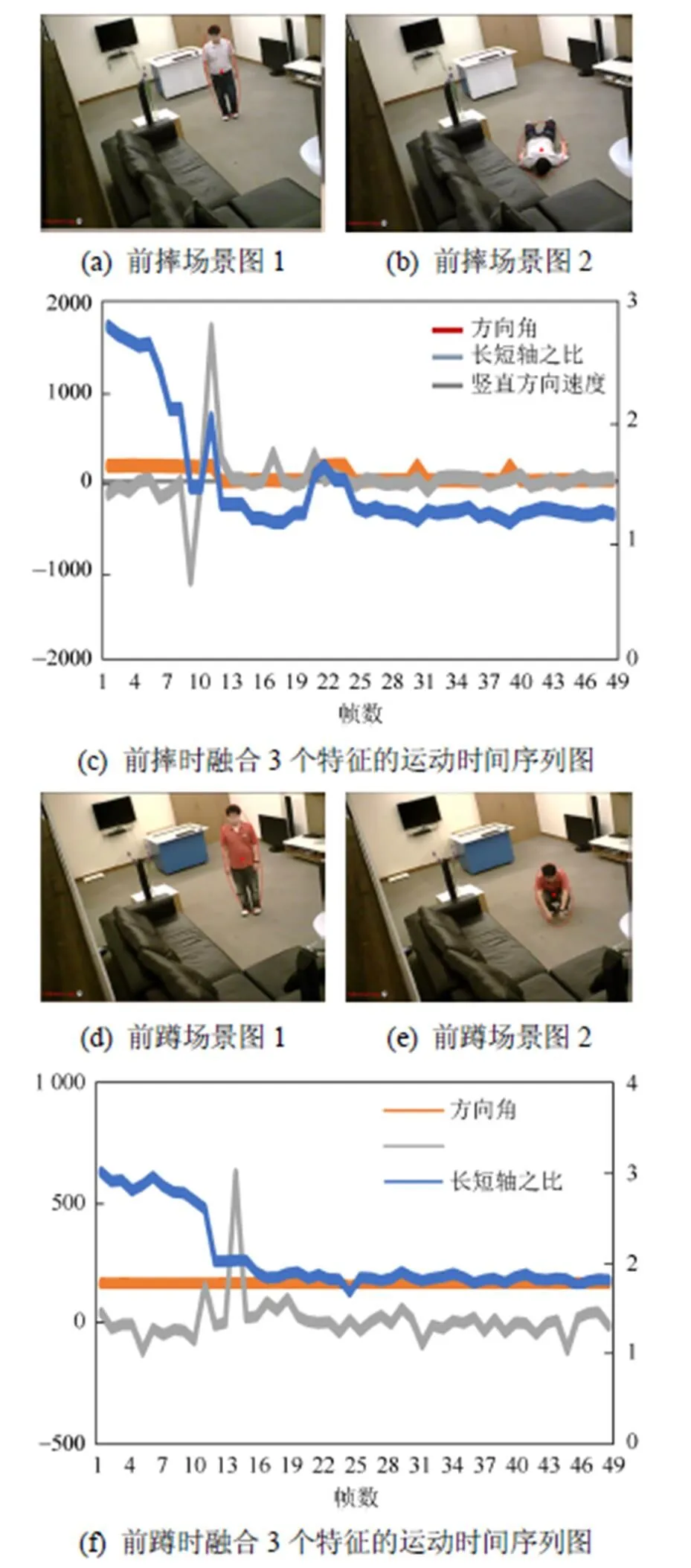

图7、8中分别对两对相似度很大的运动进行了实验结果的分析,即侧摔和侧趴、前摔和前蹲的实验场景图和特征变化情况图。

图7 侧摔和侧趴的运动特征图对比

如图7所示,侧摔和侧趴的竖直方向的速度和方向角的变化情况有很大的不一样,而长短轴之比的变化情况十分相似。本文用了深度学习很好地区分这两种运动。

从图8中可发现,前摔和前蹲的长短轴和方向角的变化情况较相似,而竖直方向速度的变化情况却十分不同,本文通过深度学习也能够有效地区分这两种相似度较高的活动。

图8 前摔和前蹲的运动特征图对比

4 总 结

本文提出了一个基于CNN和人体椭圆轮廓的运动特征的摔倒检测方法。该方法使用高斯混合模型检测目标并求出其最小外接椭圆轮廓,提取其3个特征组成一个基于时间序列的运动特征。再通过一个浅层的CNN进行训练,去判断摔倒,并区分一些相似的活动。通过实验证明了该方法相比现有的基于几何特征的摔倒检测算法更稳定,检测率更高。

[1] XI X G, TANG M Y, MIRAN S M, et al. Evaluation of feature extraction and recognition for activity monitoring and fall detection based on wearable sEMG sensors [J]. Sensors, 2017, 17(6): 1-20.

[2] MAZUREK P, WAGNER J, MORAWSKI R Z, et al. Use of kinematic and mel-cepstrum-related features for fall detection based on data from infrared depth sensors [J]. Biomedical Signal Processing & Control, 2018, 40:102-110.

[3] YAO L Y, MIN W D, LU K Q, et al. A new approach to fall detection based on the human torso motion model [J]. Applied Sciences, 2017, 7(10): 993.

[4] AKAGÜNDÜZ E, ASLAN M, SENGUR A, et al. Silhouette orientation volumes for efficient fall detection in depth videos [J]. IEEE Journal of Biomedical & Health Informatics, 2016, 21(3):756-763.

[5] MIN W D, WEI L S, HAN Q. Human fall detection based on motion tracking and shape aspect ratio [J]. International Journal of Multimedia and Ubiquitous Engineering, 2016, 11(10): 1-14.

[6] MIN W D, CUI H, RAO H. Detection of human falls on furniture using scene analysis based on deep learning and activity characteristics [J]. IEEE Access, 2018, 6:9324-9335.

[7] LIU H,ZUO C L. An improved algorithm of automatic fall detection [J]. AASRJ Procedia, 2012, 1: 353-358.

[8] FENG W G, LIU R, ZHU M. Fall detection for elderly person care in a vision-based home surveillance environment using a monocular camera [J]. Signal, Image and Video Processing, 2014, 8(6): 1129-1138.

[9] CHUA J L, CHANG Y C, LIM W K. A simple vision-based fall detection technique for indoor video surveillance [J]. Signal Image and Video Processing, 2015, 9(3): 623-633.

[10] PRATT W K, ADAMS J E. Digital image processing [J].4th Edition. Journal of Electronic Imaging, 2007, 16(2): 131-145.

[11] WILLIAMS A, GANESAN D, HANSON A. Aging in place: fall detection and localization in a distributed smart camera network [C]//MM’07 Proceedings of the 15thACM International Conference on Multimedia. New York: ACM Press, 2007:892-901.

[12] ROUGIER C, MEUNIER J, ST-ARNAUD A. Fall detection from human shape and motion history using video surveillance [C]//AINAW´07 Proceedings of the 21st International Conference on Advanced Information Networking and Applications Workshops. New York: IEEE Press, 2007, 2: 875-880.

A Fall Detection Method Based on CNN and Motion Features of Human Elliptical Contour

DENG Zhifeng, MIN Weidong, ZOU Song

(School of Information Engineering, Nanchang University, Nanchang Jiangxi 330031, China)

In order to solve the problems of the instability of the traditional method of using geometric features to detect falls, and the difficulty to distinguish some similar activities, a fall detection method based on convolution neural network (CNN) and the motion features of the elliptical contour of human body is proposed. First, this method uses the Gauss mixture model to detect the human target and find out the minimum external elliptical contour. Then, the three features of the long and short axis ratio, the orientation angle and the vertical velocity of the human body’s centroid extracted in each frame’s elliptical contour, are fused into a motion feature based on time series. Last, a shallow CNN is then trained to detect falls and distinguish some similar activities. Experiment results show that our method overcomes the instability of geometric features and therefore enhances the detection rate compared with the existing methods.

fall detection; convolution neural network; human elliptical contour; time series; motion features

TP 391

10.11996/JG.j.2095-302X.2018061042

A

2095-302X(2018)06-1042-06

2018-04-16;

2018-07-24

国家自然科学基金项目(61762061);江西省自然科学基金重大项目(20161ACB20004)

邓志锋(1995-),男,江西临川人,硕士研究生。主要研究方向为图像处理与模式识别。E-mail:2690589616@qq.com

闵卫东(1966-),男,江西赣州人,教授,博士。主要研究方向为图形图像处理、图形学、人工智能、大数据、智慧城市信息技术等。E-mail:minweidong@ncu.edu.cn