基于时空特征的航拍视频运动目标检测研究

2017-12-02刘双岭

刘双岭

摘要:航拍视频具有监控场景范围大、采集设备移动迅捷等优点。与普通监控视频相比,航拍具有目标分辨率低、场景干扰因素多、采集设备不固定等问题,运动目标检测是个难题。针对这些问题,提出一种融合时空特性的两级运动目标检测算法。首先利用SURF算子完成图像匹配,解决摄像机移动问题,并结合目标的运动特性及自适应道路检测算法完成时域上的目标区域检测;采用HSV空间中的S分量图颜色特征,利用道路区域与目标区域的差异性完成空域目标区域检测。实验采用著名的VIVID Egtest01数据库以及Munich Crossroad01数据库中的数据,并与传统方法进行对比。结果显示该算法平均准确率达到93%,相比于传统方法有效性和鲁棒性更好。

关键词关键词:航拍视频;背景补偿;道路检测;HSV;运动目标

DOIDOI:10.11907/rjdk.171850

中图分类号:TP319

文献标识码:A文章编号文章编号:16727800(2017)011014405

0引言

航拍是目前新兴的一种非接触式远距离探测技术,具有拍摄场景范围大、移动便携等优势,逐渐应用于智能交通系统的运动目标检测[13]。运动信息是目标检测最为重要的线索,大部分是基于时间特性的,在固定摄像头条件下,常用的运动目标检测算法有背景差分法、帧差法、光流法等。但是这些方法一般不能直接应用在移动机器人、无人机等场合,这是因为摄像头的运动使背景变得复杂,导致不能精确检测出运动目标。

运动目标检测相关研究已经有一些成果[46]:①基于光流场的运动目标检测法[7]:根据运动目标的运动矢量在局部区域的统一性以及背景和运动目标之间的差异性,对其进行运动分割,此方法缺点是抗噪能力弱且实时性较差;②基于统计模型的运动目标检测法[8]:这种算法首先估算运动矢量场,然后根据马尔可夫随机场(MRF)建立运动矢量场的间断点分布模型,据此模型检测运动矢量场的间断点,从而提取出运动目标。该方法的优点是运算量比较小,能满足实時性要求,缺点是在复杂场景下检测率下降、鲁棒性较差;③基于背景补偿的运动目标检测法:这是目前最常用的一种方法。该方法首先对相邻两帧图像进行图像匹配,然后根据匹配的特征点计算出全局运动参数,依据运动参数完成背景补偿,从而将动态背景转变为静态背景进行处理。

2.3空域目标检测

经过时域特征检测,可得到运动目标的候选区域,但是此候选区域可能是由不精确的背景补偿或其它干扰引起的。为提高算法准确率,本文在此基础上进行空域上的目标检测。采用基于HSV颜色空间的自适应检测方法得出道路区域,将道路区域外的候选运动目标认定为噪声,以减少周围环境的干扰。S分量对于光照不敏感,利用目标在此分量上的颜色特征完成空域目标区域分割。

2.3.1自适应道路检测

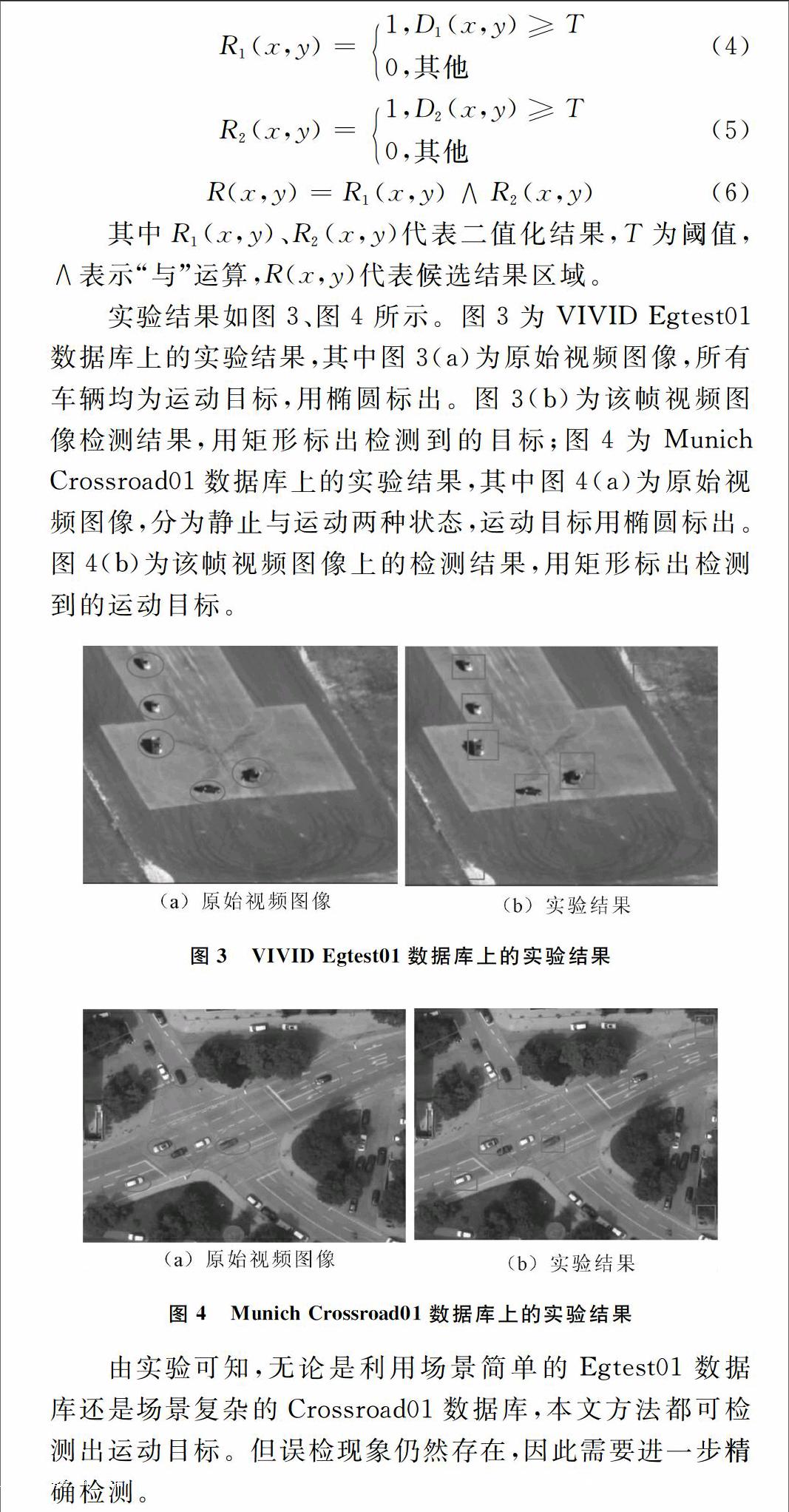

考虑到航拍视频图像背景复杂,同时为了降低虚警率,本文将感兴趣区域设为道路区域。通常情况下,运动目标只位于这部分区域。与基于先验知识的方法不同,本文采用一种自适应方法进行道路提取,流程如图5所示。

图5自适应道路检测流程

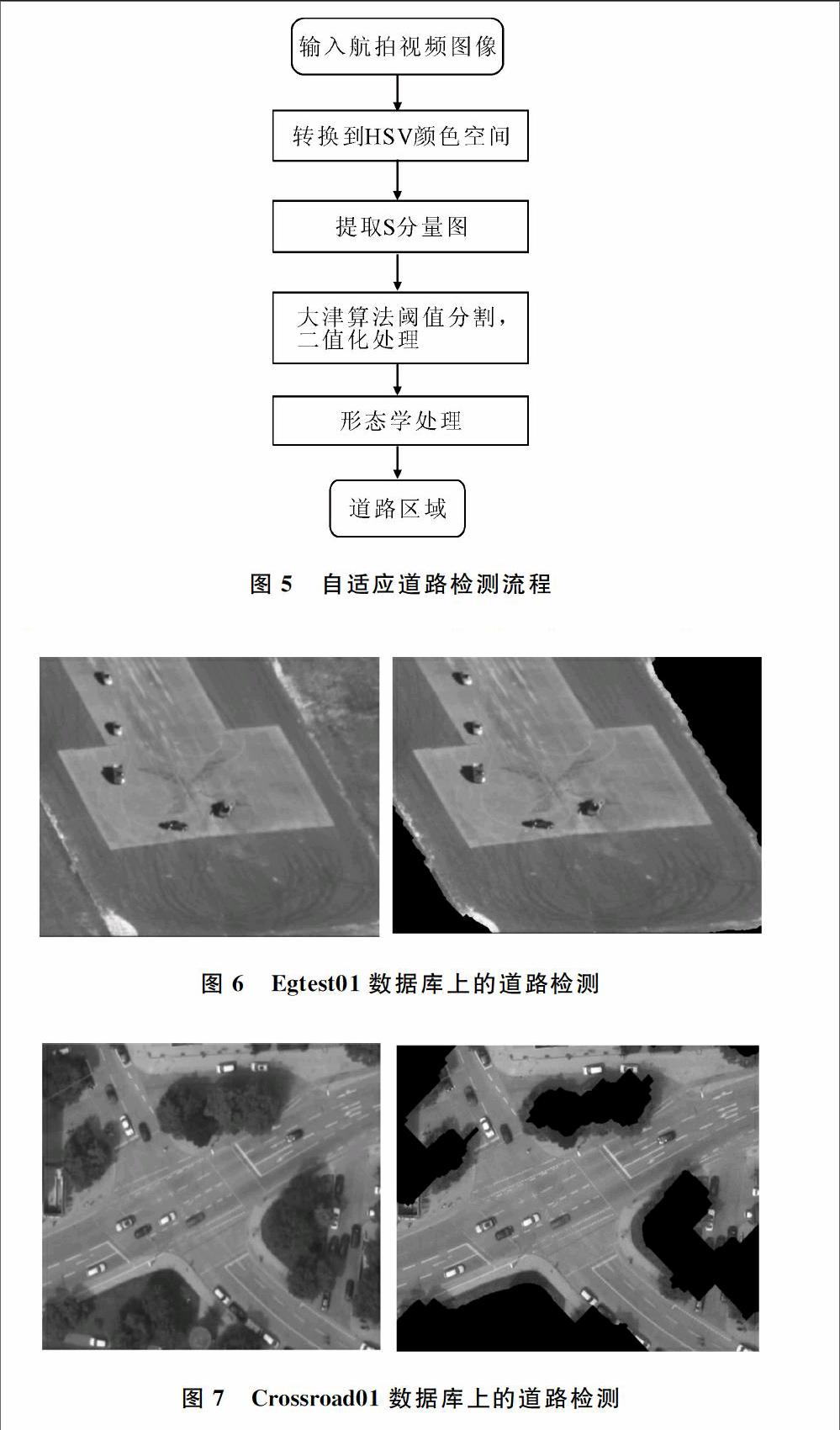

首先将图像转换为HSV颜色空间,在S分量图上进行道路提取。在此分量图上,道路区域与其它区域灰度差别明显。然后利用大津算法[12]结合形态学处理方法对道路区域进行分割,道路分割结果如图6、图7所示。

从图6、图7可以看出,无论是利用场景简单的VIVID Egtest01数据库还是场景复杂的Munich Crossroad01数据库,该方法都能很好地提取道路区域,提高算法效率与鲁棒性。

2.3.2空间特征检测

由于可能存在噪声干扰,单一的时域特征并不能很好地把运动目标检测出来,因此本文在时域目标检测的基础上进行空域目标检测。在S分量图上道路区域与目标区域差异较大,据此差异性将目标与道路区域分离,得到空域上的目标区域,计算公式如下:

B(x)=1,S(x,y)≥T0,S(x,y) 其中,B(x)为阈值比较函数,T代表阈值,S(x,y)为S分量图的灰度值。 将二值图中值为1的区域判定为候选目标区域,结合形态学处理方法得出空域上的最终目标区域,实验效果如图8、图9所示。 图8VIVID Egtest01数据库上的实验结果 图9Munich Crossroad01数据库上的实验结果 由图8、图9可以看出,在VIVID Egtest01数据库上,运动车辆全部被检测出来,所有车辆均为运动目标,故准确率较高;在Munich Crossroad01数据库上,有静止和运动两种状态车辆,还可能会有其它干扰,准确率较低,因此有必要进一步采取措施使运动目标从道路区域中分离出来。 2.4时空特征融合 经过时域特征检测,可得到运动目标的候选区域,但是此候选区域可能由不精确的背景补偿或其它干扰所引起。同时,空域上没有运动信息,检测出来的目标也可能是多余的噪声。因此,该算法通过相与的方式对两种特征进行融合,只有在时域和空域上均判定为目标的区域,才将其判定为最终运动目标。在两种数据库上的最终效果如图10、图11所示。 图10Egtest01数据库上最终的运动目标检测结果 图11Crossroad01数据库上最终的运动目标检测结果 图10(a)为Egtest01数据库的原始视频图像,图中所有车辆全部为运动目标,用椭圆标出。图10(b)为对应的最终目标检测结果,用矩形标出;图11(a)为Crossroad01数据库的原始视频图像,车辆分为静止和运动两种状态,运动车辆用椭圆标出。图11(b)为对应的最终运动目标检测结果,用矩形标出。由图10、图11可以看出,算法经过时空特征融合后,能够准确检测出运动目标,具有较好的有效性和鲁棒性。

3实验结果分析

3.1数据库介绍

该算法采用VIVID EgTest01数据库和Munich Crossroad01数据库进行仿真验证。VIVID EgTest01数据库是一个航拍的视频图像序列,背景简单,周围环境噪声小,经常用于航拍视频中的运动目标检测,且该数据库中所有车辆均为运动车辆;Munich Crossroad01数据库是一个城区航拍视频数据库,与EgTest01数据库相比,该数据库最大的区别在于背景复杂,且包含运动和静止两种状态,很难从该数据库中准确检测出运动目标。

3.2分析

为验证本文算法的有效性,将其与经典的COCOA系统[13]、显著性检测算法[14]进行对比。3种方法在VIVID Egtest01数据库和Munich Crossroad01数据库上的对比结果如表1所示。

COCOA系统是基于Harris角点作的图像匹配,该角点特征不具备尺度不变性,当图像尺度发生较大变化时不能很好地检测出运动目标。显著性检测方法较COCOA系统有更高的准确率,但是当处于复杂背景时易受噪声干扰,鲁棒性较差。本文算法采用基于SURF特征的方式进行背景补偿,利用颜色特征分割出道路区域,通过时空特征融合方式完成运动目标检测,能够准确检测出运动目标。由表1可以看出,无论是在场景简单的Egtest01数据库还是在场景复杂的Crossroad01数据库上,本文算法准确率均是3种方法中最高的,由此验证了本文方法的有效性和鲁棒性。

4结语

本文提出了一种融合时空特征的航拍视频运动目标检测方法,在时域上通过运动信息定位出候选运动目标,然后利用自适应道路检测算法分割出道路区域,完成对候选运动目标的筛选。在空域上利用颜色特征对道路区域中的目标区域进行分割,通过相与的方式对两者进行时空特征融合,最终完成运动目标的检测。在真实的航拍视频场景下对该算法进行仿真实验,并与其它算法对比,得出该算法具有较好的有效性和鲁棒性的结论。但是该算法仍有很多不足,例如可能遇到噪声与运动目标相似的情况时准确率会下降等。未来要在以下两方面进行改进:①找到一种更为快速有效的方法,使时域特征的提取更为快速有效;②采用更为有效的空域检测算法,例如显著性等,改进空域特征的提取。

参考文献参考文献:

[1]PROKAJ J, MEDIONI G. Persistent tracking for wide area aerial surveillance[C]. IEEE Conference on Computer Vision and Pattern Recognition. IEEE,2014:11861193.

[2]SELVAKUMAR K, JEROME J. Least squares estimationbased adaptive observation model for aerial visual tracking applications[J]. International Journal of Computational Vision and Robotics,2014,4(12):134144.

[3]CAO X, GAO C, LAN J. Ego motion guided particle filter for vehicle tracking in airborne videos[J]. Neurocomputing,2014(124):168177.

[4]HU Y, RAJAN D, CHIA L. Attentionfrommotion: a factorization approach for detecting attention objects in motion[J]. Computer Vision and Image Understanding,2009(113):319331.

[5]KIM S W, YUN K, YI K M, et al. Detection of moving objects with a moving camera using nonpanoramic background model[J]. Machine vision and applications,2013,24(5):10151028.

[6]WALHA A, WALI A, ALIMI A M. Video stabilization with moving object detecting and tracking for aerial video surveillance[J]. Multimedia Tools and Applications,2015,74(17):67456767.

[7]ARNELL F, PETERSSON L. Fast object segmentation from a moving camera[C].Intelligent Vehicles Symposium, Proceedings IEEE,2005:136141.

[8]UGEAU A, PEREZ P. Detection and segmentation of moving objects in highly dynamic scenes[C]. IEEE Conference on Computer Vision and Pattern Recognition, New York: IEEE,2007:18.

[9]BAY H, TUYTELAARS T, GOOL L V. SURF: speeded up robust features[J]. Computer Vision & Image Understanding,2006,110(3):404417.

[10]WANG X, ZHANG Y, DONG H, et al. Algorithm research on threeframe difference for detection of moving target[J]. Journal of Shenyang Ligong University,2011,30(6):8285.

[11]LOWE D G. Distinctive image features from scaleinvariant keypoints[J]. International Journal of Computer Vision,2004,60(2):91110.

[12]OTSU N. A threshold selection method from graylevel histograms[J]. IEEE transactions on systems, man, and cybernetics,1979,9(1):6266.

[13]ALI S, SHAH M. COCOA: tracking in aerial imagery[J]. Proceedings of SPIE The International Society for Optical Engineering,2006,5(1):105114.

[14]SHEN H, LI S, ZHU C, et al. Moving object detection in aerial video based on spatiotemporal saliency[J]. Chinese Journal of Aeronautics,2013,26(5):12111217.

責任编辑(责任编辑:杜能钢)endprint