利旧搭建虚拟化系统

2017-11-07

存储网络设计

存储设备存在4个电口,每台服务器也存在4个电口,如图1所示。存储设备可通过与4台服务器直接相连的方式来进行通信,4台服务器可分别通过另一个网口与企业网络进行通信。

但这种组网方式存在弊端,一旦某根网线损坏,或者存储设备的网卡损坏,则会出现服务器无法使用或者服务器无法访问存储的问题。

除此之外,存储设备只存在4个电口,如果将来有新的服务器要加入此存储网络,则无法进行连接,所以在此处组网我们不仅需要考虑存储系统的冗余性,还要考虑将来的扩展性。

一般来说,我们可以使用一台光纤交换机组建FC-SAN网络来扩展存储设备的接口,但是光纤交换机成本高,目前没有现成的设备可以利用,而且利旧的服务器都没有HBA卡,无法使用光纤进行连接。所以,我们只能考虑通过利旧以太网交换机组建IP-SAN网络,通过iSCSI协议来实现存储的访问。

图1 存储系统星型组网拓扑

图2 存储系统树形组网拓扑

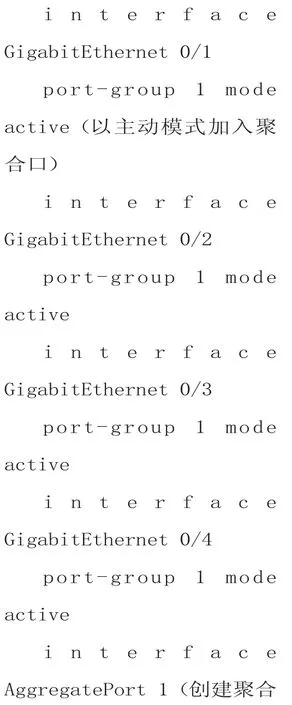

恰好,我们找到一台闲置的24个电口的锐捷5750千兆交换机,这样就可以解决存储网络的汇聚连接问题,为了增加存储系统的冗余性及传输速度,可以将存储系统的4个电口进行捆绑为一个聚合口接入锐捷交换机,而在锐捷交换机上也将对应的四个接口进行捆绑,配置如下所示:

此外,还可以充分利用服务器的以太网口,通过MPIO多路径技术做成冗余,使其分别各使用两个接口上连到企业网的交换机以及下连到存储网络的交换机,如图2所示。

虚拟化系统配置

完成存储网络的搭建之后,分别在四台服务器上进行ESXI系统的安装,并部署vSphere,即可完成虚拟化系统的部署,关于虚拟化系统的详细配置可以参考VMware公司的相关资料文档,本文不进行详细描述。

但是需要特别强调的是,在虚拟化系统的安装过程中,对于服务器的命名必须遵循一定的格式,而且需要与下文图5中所描述的Initiators中的命名相对应。

存储系统规划

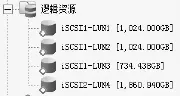

存储系统总共包括10块900G的硬盘,我们使用其中1块盘作为全局热备盘,另外9块盘分成两组,一组5块,一组4块,每组中分别利用1块盘作为该组的热备盘,剩下的盘通过RAID5技术做成磁盘阵列,最终的磁盘分配方案如图3所示。通过以上分配方案,得到存储空间为4652.539GB,再将这些存储空间划分为服务器可以直接读取的LUN,如图4所示。

图3 RAID详细分配图

图4 LUN划分图

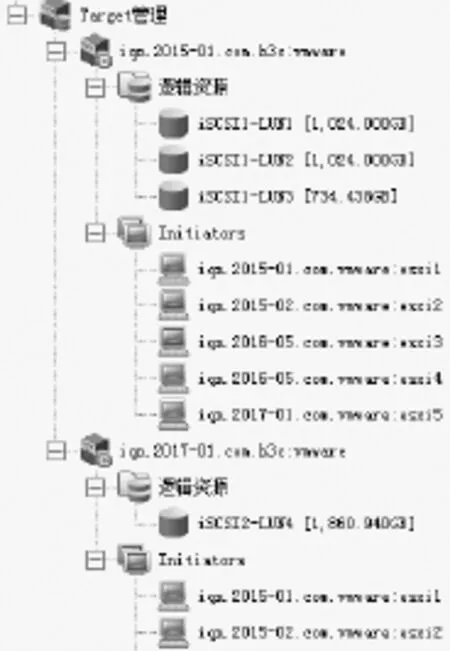

图5 Target与Initiators关联图

为了通过ISCSI协议进行存储数据交换,我们还需要创建Target并分配逻辑资源,再关联相应 的Initiator,接 着 在Initiator上登陆关联的Target,便可以对LUN进行访问了。

在这里,Target我们可以理解为存储系统中供访问的逻辑存储,而Initiator可以理解为就是服务器等需要访问存储的客户端,服务器上的具体的配置方法可以查阅相关手册,最终配置完成后详细的关联关系见图5,图中在同一个组中的Initiators只能访问本组中的LUN。

至此,我们已经完成了一个本地存储系统的搭建,接着就可以在我们部署好的虚拟化系统中创建虚拟机用于系统测试了,将来如果还有淘汰下来的服务器或者存储,把它添加到这个系统进行扩展就可以了。

这样不仅将这些设备废物利用,又可以利用虚拟化技术灵活的搭建测试环境,提高了工作的效率。