折反射周视系统研究进展与展望

2017-10-23王岭雪周星光刘福平李洪兵罗永芳李茂忠

贺 宇,王岭雪*,蔡 毅,2,周星光,薛 唯,姜 杰,刘福平,李洪兵,陈 骥,罗永芳,李茂忠

(1.北京理工大学 光电学院 光电成像技术与系统教育部重点实验室,北京市混合现实与新型显示工程技术研究中心,北京 100081;2.中国兵器科学研究院,北京 100089;3.云南北方驰宏光电有限公司,昆明 650217)

折反射周视系统研究进展与展望

贺 宇1,王岭雪1*,蔡 毅1,2,周星光1,薛 唯1,姜 杰3,刘福平3,李洪兵3,陈 骥3,罗永芳3,李茂忠3

(1.北京理工大学 光电学院 光电成像技术与系统教育部重点实验室,北京市混合现实与新型显示工程技术研究中心,北京 100081;2.中国兵器科学研究院,北京 100089;3.云南北方驰宏光电有限公司,昆明 650217)

折反射周视系统作为近十几年发展起来的一种新型周视视觉实现形式,相比相机旋转扫描、多相机图像拼接和鱼眼镜头大视场成像等常规方法,在小型化、结构灵活性、成本和实时性方面具有优势。本文综述了折反射周视系统的成像模型、系统标定、畸变校正和全视场清晰成像等基本问题研究状况,讨论了折反射周视系统在红外成像和立体视觉领域的扩展应用研究现状,最后总结了目前存在的问题,并提出未来折反射周视成像系统将围绕非单视点成像模型、提高空间分辨力的方法和处理算法实时实现开展研究。

折反射周视系统;畸变校正;红外成像;周视立体视觉

1 引 言

常规视觉系统以视场中的一点作为成像中心点,将物空间有限大小的区域经过该中心点投影到成像平面上,对物空间的一个局部成像,获取的信息量有限。在机器人导航、预警监视、视频监控、虚拟现实和同步定位与绘图等图像视觉领域,为了解决常规系统视场狭小的问题,能够获取360°方位角、大俯仰角的周视系统应运而生,而且随着成像器件像元规模的日益增大,周视系统逐渐获得更多的关注。相比常规视觉系统,周视系统的视场范围和系统结构均有较大差异。目前周视实现方式主要分为多视图型和单视图型两类。多视图型的典型代表有旋转扫描周视和多相机拼接周视。旋转扫描周视围绕一个固定视点旋转拍摄一系列视场有部分重叠的图像序列,再对这些图像序列进行图像拼接,最终得到一幅360°方位视场的周视图像,优点是空间分辨力高,不足是时间分辨力较低,不能完整记录360°全方位实景空间内重要事件的发生、持续和结束整个过程;多相机拼接周视采用多个相机对不同方位角的物空间区域进行成像,再通过图像拼接技术形成周视图像,优点是空间分辨力高,不足是所获取的图像原始数据量大,拼接算法较复杂,存在拼接缝,不同方位角相机拍摄的图像之间存在明暗差异,而且对相机之间的定位要求比较严苛,系统尺寸庞大,成本较高。单视图型的典型代表包括鱼眼镜头成像、全景环形透镜成像和折反射周视系统。单视图型周视的特点是只使用一个面阵探测器、通过一幅视图直接得到周视视场景象,实现凝视型的周视成像,可以完整记录360°全方位实景空间内重要事件的发生、持续和结束。与鱼眼镜头和全景环形透镜成像相比,折反射周视系统的设计灵活性高,可以设计满足单视点结构约束的系统,也可以设计水平无畸变或柱面无畸变的系统,还可以根据实际应用环境需要设计特定的系统结构。另外,鱼眼镜头对大视场光线的弯折主要发生在第一面透镜处,会带来严重的色散,而折反射周视系统的大视场光线弯折主要发生在曲面反射镜处,不会带来色散,因此反射镜的使用能有效减少色散的发生,使系统能以简单结构实现更大的视场。单视图型周视的不足是空间分辨力较低、几何畸变严重。

通过以上分析比较可以发现,折反射周视系统在系统尺寸、结构复杂度、成本和实时性上均具有优势,虽然空间分辨力不及多视图型周视系统,不过目前商业级的可见光成像器件拥有几千万甚至上亿的有效像素、红外探测器也有数百万像素,这有助于解决折反射周视系统空间分辨力不足的问题。因此,折反射周视系统在周视视觉领域具有着很大的应用潜力,也吸引着越来越多的研究者投入到相关技术的研究中。本文将对折反射周视系统相关技术目前的发展进程进行概述,并根据作者对折反射周视系统的认识提出其在发展过程中所遇到的问题以及未来可能的发展趋势。研究发展概述主要分为三部分:

(1)折反射周视系统基本问题研究进展,主要包括成像模型、系统标定、周视成像畸变校正和全视场清晰成像等基本问题。

(2)折反射周视系统光谱域扩展的相关研究进展,主要指红外波段的折反射周视系统,其研究除了包含第一部分中所述的基本问题外,还独具红外成像探测的特色。

(3)折反射周视系统空间维度扩展的相关研究进展,即折反射周视立体视觉系统研究。一般的折反射周视系统只能获得场景的二维图像,不能得到距离(或深度)信息,折反射周视立体视觉系统是在折反射周视系统基础上发展出来的一种周视场景深度估计技术,也是折反射周视系统研究的一个重要应用分支。

2 折反射周视系统基本问题研究进展

2.1折反射周视系统成像模型研究

折反射周视系统的成像模型研究可以分为两种方式,一种是从几何光学的角度,利用基本的光线反射和折射进行成像模型的数学建模,适用于任何形式的折反射周视成像系统。不过模型的表达形式通常不够简洁,不利于系统射影几何性质的研究。另一种方式是以射影几何的方法进行研究,虽然不适用于所有的折反射周视成像系统,但是对于能够适用的特殊结构,可以像常规相机一样对其射影特性进行研究,挖掘更深层次的数学特性。

基于几何光学的建模方式贯穿了折反射周视成像模型研究的整个过程。折反射周视成像系统最早的构思由Rees D W[1]提出,设想通过双曲面和透视相机的结合来获得方位角360°范围的信息。Yamazawa K等人将这种构想应用于实际的机器人系统[2]。后来Pegard C[3]和Nayar S K等人[4]分别提出了利用圆锥面镜和抛物面镜实现折反射周视成像。除了使用这些常见的曲面面型,通过镜面面型的特殊设计,不同光线投影特点的折反射周视成像系统也被设计出来。Chahl J S等人设计的系统使得光线入射反射镜的角度与光线经过镜面反射后入射透视相机的入射角成线性关系[5]。Conroy T等人设计了恒定角分辨力的折反射周视成像系统[6]。Hicks R A等人设计的反射镜则保证与像平面平行的物平面能被折反射系统均匀地分辨[7]。类似地, Gachter S设计了一种物点的垂直位置分布与像平面上极径的位置分布成线性关系的系统,这样能在像平面上保留竖直物体的几何形貌,不产生畸变[8]。

通过灵活的镜面和系统结构设计,折反射系统能满足多种不同的物像投影需要,也就是探测器上像元坐标(进一步的是图像像素坐标)与入射光线方向的对应关系。这种对应关系也是系统标定的对象。标定相关内容会在下一节讨论。对于大多数折反射周视系统,图像像素坐标与入射光线方向的对应关系较为复杂,但是有一类特殊的镜面面型,当其配合合适的系统架构时可以很大程度的降低这种复杂度。这类折反射周视系统被认为具有单视点结束约束[9-10]。单视点和非单视点也成为目前对各种折反射周视系统的一个主要划分依据。下面详细介绍这两类折反射周视系统的特点。

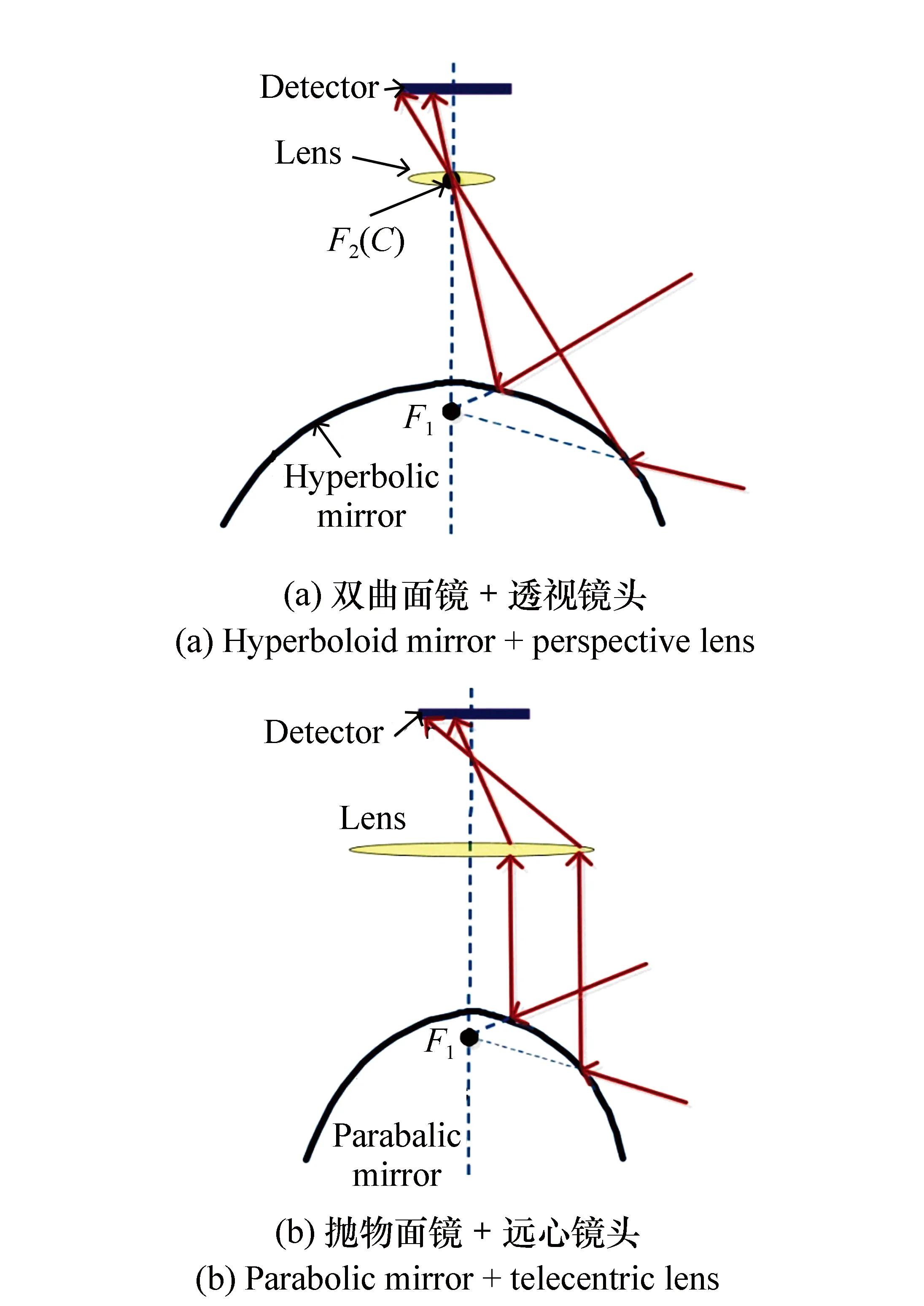

单视点结构约束的折反射周视成像系统通常采用双曲面镜和透视镜头的组合或者是抛物面镜和远心镜头的组合。虽然理论上椭球面镜和透视镜头也可以满足要求,但是这种组合的视场范围比较小,所以很少使用。图1中(a)是双曲面镜的周视系统,(b)是抛物面镜的系统。对于图1(a)的情况,有两个数学焦点,一个位于镜面内的F1处,一个则在镜面外的F2处。这两个数学焦点有这样的光学性质,光线对着其中一个焦点入射,经过反射后,从另外一个焦点出射。而这时如果折射光学组(图1(a)中以一个理想透镜表示)的物方节点(图1中C点,当系统位于空气中等同物方主点)与镜面外的数学焦点F2重合,则该光线会不改变方向穿过C点,投影在探测器上[11]。图1(b)的情况比较类似,只是抛物面的镜面外焦点在无限远处,因此反射的主光线会平行于光轴出射。并且需要镜头为远心镜头。这种结构虽然由于使用远心镜头成本更高,但是镜头和反射镜之间的距离可以不受限制。而图1(a)的镜头和反射镜的距离是严格限制的。常规成像系统的物像透视投影模型中轴外物点出射光线必须通过透视中心这个点,而对于单视点折反射周视系统则有两个空间点来共同约束光线。

图1 单视点结构约束折反射周视系统示意图 Fig.1 Schematic diagram of single viewpoint structural catadioptric panoramic system

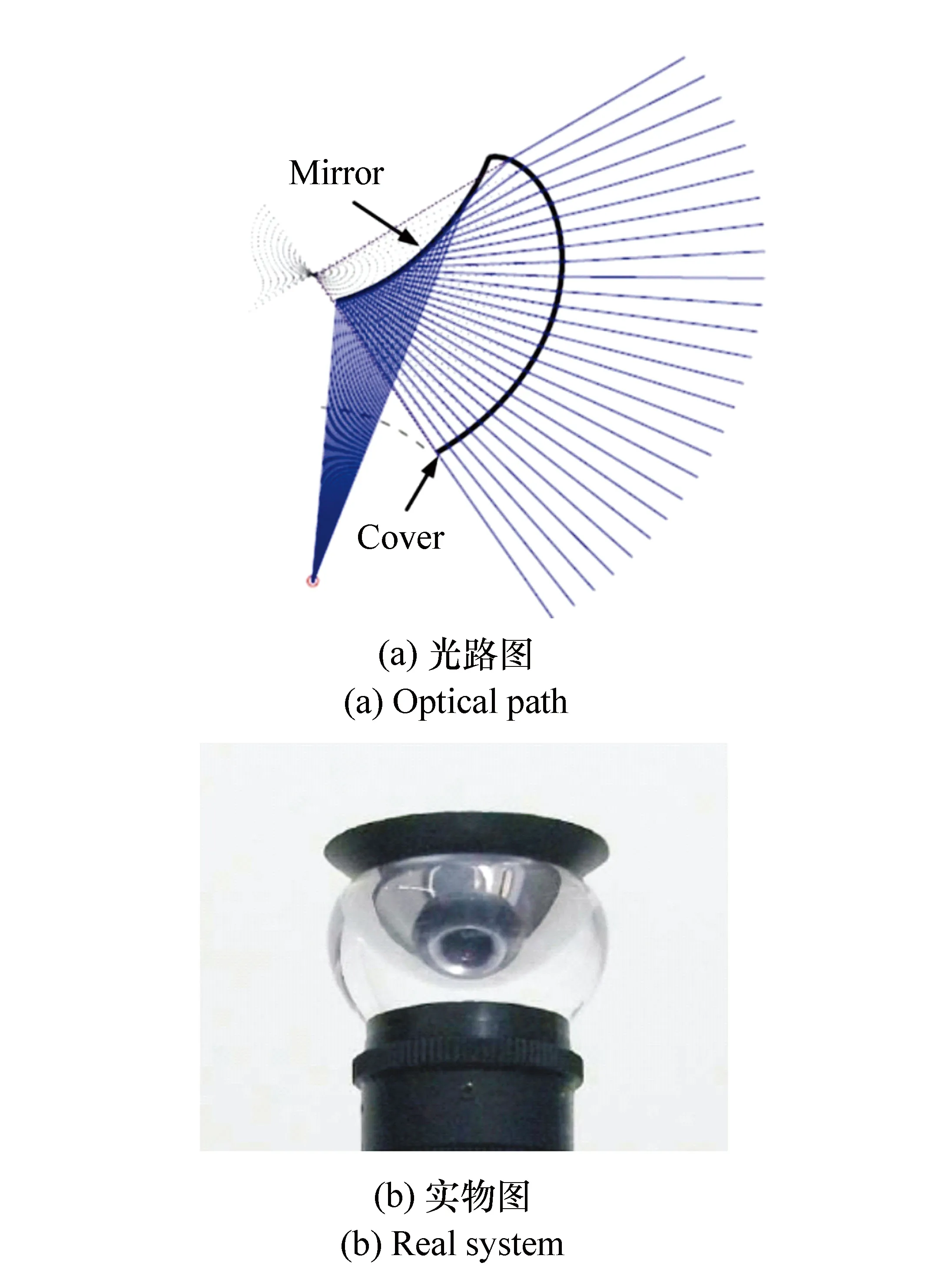

除了单反射镜型的单视点折反射结构,还出现了一些满足单视点结构约束的特殊结构。Nagahara H等人研究了能同时满足等角分辨力和单视点约束的双反射镜组合条件[12]。Hicks R A等人则从理论上分析了利用双反射镜组合的设计可以使系统在满足不同物像投影关系的同时仍然满足单视点结构约束[13]。Sturzl W[14]在Chahl J S[5]的模型基础上做了改进,在反射镜的外侧加上具有折射功能的透明罩,利用折射曲面和反射曲面的组合,在满足Chahl J S模型的投影特性的同时(光线入射反射镜的角度与光线经过镜面反射后入射透视相机的入射角成线性关系),还可以满足单视点的特征,如图2所示。

图2 Sturzl W所设计的折反射系统 Fig.2 Sturzl W′s system. (a)optical path; (b)real system

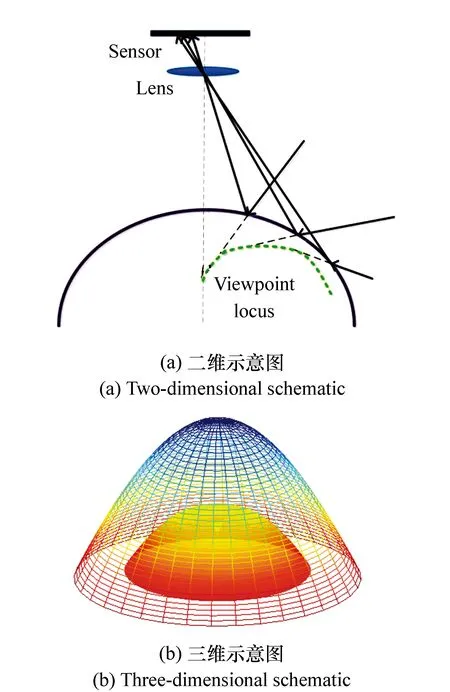

单视点折反射周视系统是非单视点折反射周视系统的特殊情况。单视点系统在不严格满足其配置要求时就会变成非单视点系统,比如双曲面镜和透视镜头的组合,如果透镜光心C偏离了双曲面外焦点F2,那么系统就变为非单视点系统。非单视点可以理解为对于不同入射角的光线有不同的视点,这些视点不会重合到一点,而会形成一个与系统结构有关的空间分布。Swaminathan R等人详细讨论了基于圆锥曲面的非单视点系统模型[15-17],以研究焦散的突变光学理论作为工具,研究了几种常见圆锥曲面折反射周视成像系统在非单视点配置下的视点分布情况,如图3(a),视点轨迹为入射主光线的包络,也就是视点轨迹会与每条主光线相切。视点分布在三维情况下会形成一个视点面,如图3(b),栅格曲面为镜面表面,内部为视点面。除了以焦散的方式研究非单视点情况,Yu J Y[18]等人则考虑将反射镜表面划分为许多三角区域,每块区域的反射当作一般线性相机(GLC)成像过程[19]。

图3 非单视点的视点分布 Fig.3 Viewpoints distribution of non-single viewpoint system

图4 球面统一模型投影示意 Fig.4 Diagram of the unifying catadioptric projection

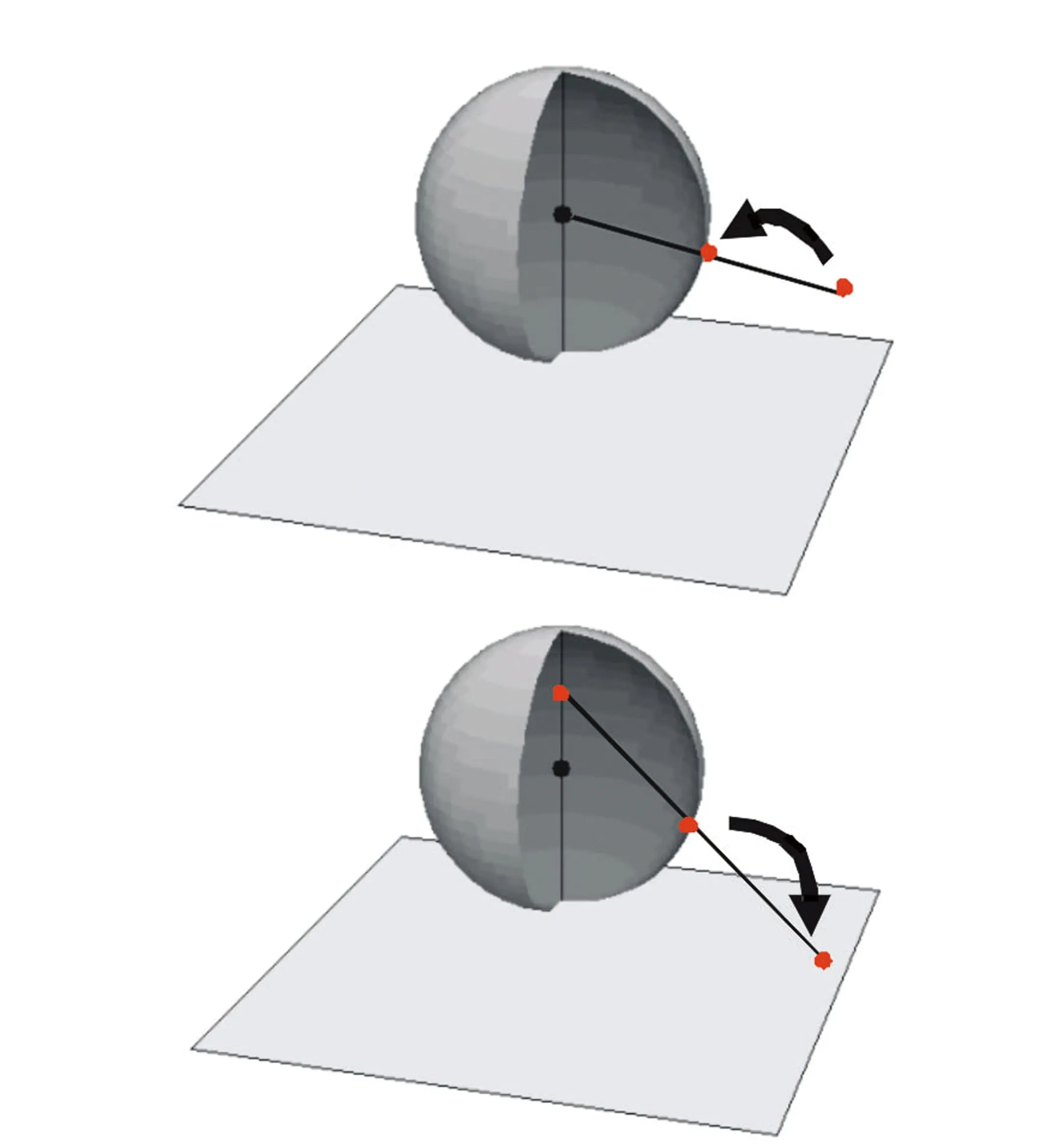

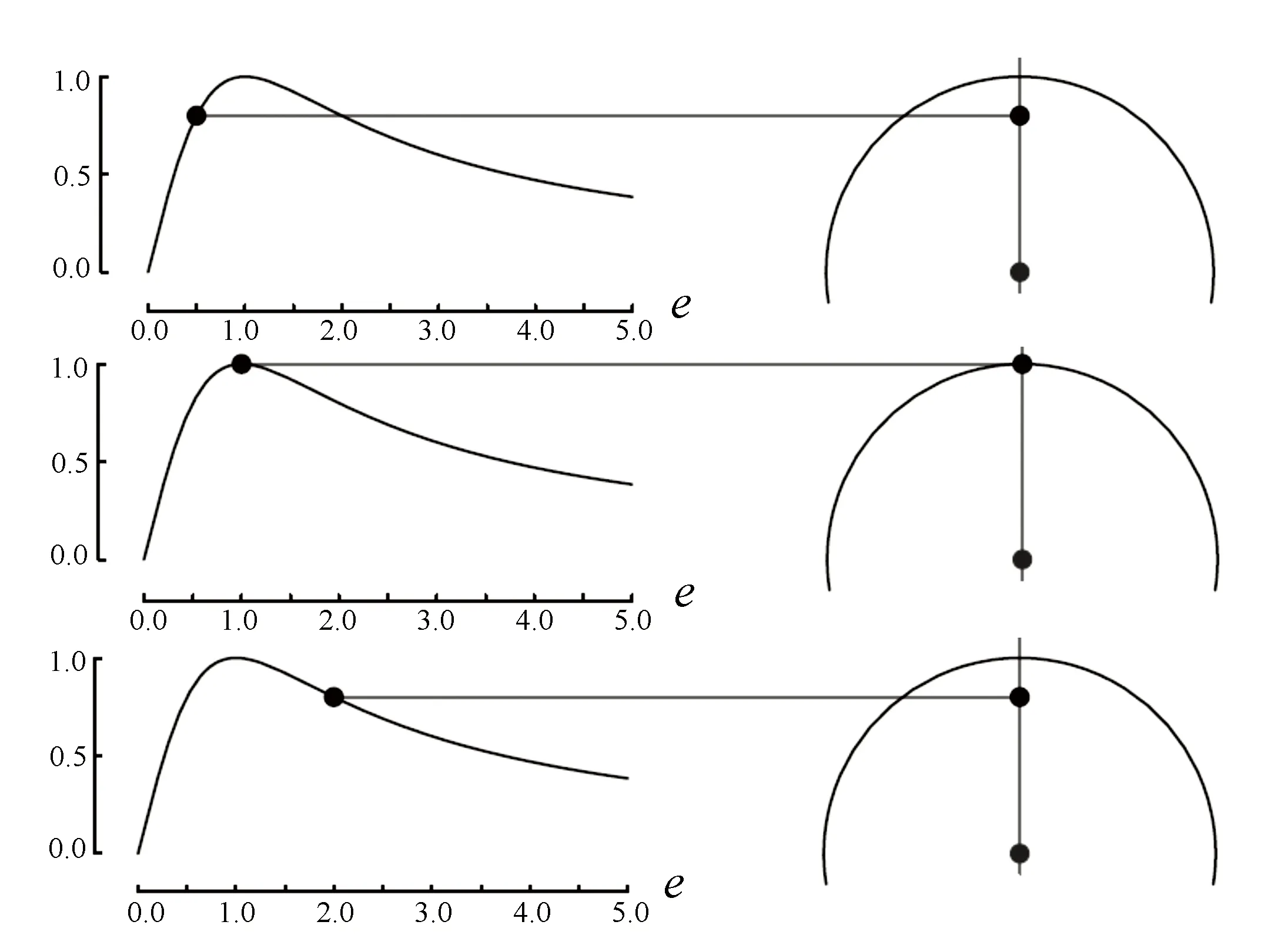

基于几何光学的建模方式虽然适用于任何系统的设计,但是却没有办法来研究一些典型的计算机视觉问题,如建立在射影几何基础上运动结构复原的问题。Geyer C M针对单视点折反射系统建立了折反射射影几何理论[20-22]。在折反射射影几何理论中,不同的单视点折反射周视系统的投影过程被球面统一模型表示。投影过程被分为两步,如图4所示:第一步,以球心视点为投影中心将场景点投影到单位球球面;第二步,将球心与北极点连线中的一点设为新的投影中心,该投影中心的位置与折反射系统镜面的离心率e有关,两者的变化关系见图5。通过这个投影中心将第一步中球面上的点二次投影到像平面上。折反射射影几何理论对符合单视点的折反射周视系统建立了如同传统透视成像系统一样的射影几何理论,可以讨论诸如内参数矩阵、对极几何、基本矩阵等计算机视觉中的基本问题。

图5 投影中心位置与离心率关系 Fig.5 Relationship between the position of projection center and the eccentricity

2.2折反射周视系统标定研究

系统标定的意义在于,一是获得图像像素坐标与入射光线方向的映射关系,二是修正系统搭建时引入的误差。标定可以得到系统的内参数和外参数,其中内参数描述的是相机坐标系下的物像投影关系。外参数则描述了相机在特定参考坐标系下的位置和方向。标定是成像系统视觉应用的前提,折反射周视系统的标定方法在近十几年受到了广泛的关注,这些众多的标定方法可以大致被归为四类:(1)基于空间点投影的标定;(2)基于空间线投影的标定;(3)基于二维图样的标定;(4)自标定。

基于空间点投影的标定需要知道空间点的位置,结合图像上的投影位置估计出标定参数。Aliaga D G[23]提出了针对抛物面镜和远心镜头系统的空间点标定方法,可以同时估计内参数和外参数。Puig L等人[24]建议用6×10的直接线性变换矩阵来联系空间点和图像上的投影点。采取非线性优化方法对矩阵求解,所获得的结果可以分解出内参数和外参数。由于该结论是在球面统一模型下得到的[22],所以可以应用于所用单视点结构。Thirthala S等人[25]提出一种径向多焦距张量方法来标定折反射系统。当使用四阶张量时,可以对场景进行度量重构并去除图像畸变。Wu Y H等人[26]针对单视点折反射系统提出了在不提前消除畸变情况下的场景点和图像点间的投影几何不变特性。这些不变特性与系统主点有关,因此可以用来标定系统的主点位置。

基于线投影的标定方法是研究最广泛的一类标定方法。Geyer C等人[27]首先提出利用空间三条直线的投影恢复抛物面镜系统内参数的方法。Vandeportaele B等人[28]在Geyer C等人的研究基础上做了改进,利用几何距离替代代数距离计算标定参数。Vasseur P等人[29]利用空间直线的投影实现任何单视点折反射系统的内参数估计。Caglioti V等人[30]提出了一种离轴折反射系统标定方法,不同于标准的折反射周视系统,离轴系统中透视相机几乎可以放在任意位置,标定时只需要获取一条空间直线的投影像和反射镜的表面轮廓即可进行计算。中国科学院自动化所Ying X H等人[31]在球面统一模型中研究空间线和球体的投影特性,发现一条空间直线的投影可以提供3个不变量,而一个空间球的投影可以提供两个不变量。利用两条直线或3个球体的投影就能完成折反射周视系统的标定。Wu Y H等人[32]对内参数建立了线性约束,这样不需要先验的物体结构信息,也不需要像面上圆锥曲线拟合,就能实现对抛物面镜和远心镜头系统的标定。北京大学机器感知国家实验室Ying X H等人[33]认为所有空间直线的投影会属于一个圆锥曲线簇,而这个簇会与特定的内参数相联系,他们使用霍夫变换来提取直线的投影,并确保所有的投影属于一个圆锥曲线簇,这样能得到特定的内参数。另外,Ying X H等人[34]发现在单视点折反射系统的像面上会存在一个虚二次曲线,将其称作MIAC,意思是修正的绝对二次曲线像。应用MIAC可以得到一些新的线和球体射影几何特性。利用这些新的几何特性,作者提出了两种线型标定方法。Wu F C等人[35]推导了空间直线在球面统一模型单位球面上的投影和像之间的关系,并建立了关于参数的线性约束,利用这些约束估计任何单视点系统的参数。

基于二维图样的标定是利用图样中易于提取的特征来进行标定。Scaramuzza D等人[36]用泰勒级数来建模投影关系,泰勒级数的系数由两步的线性最小二乘法解出。Mei C等人[37]同样使用级数的方式,但是采用球面统一模型作为投影模型,并且将径向和切向畸变以参数的形式考虑进标定的过程。Gasparini S等人[38]研究了用绝对二次曲线(IAC)估计内参数的方法,首先需要利用网格标定板的像计算至少三组单应,然后利用计算的单应关系计算绝对二次曲线(IAC)的投影像,而内参数则可以从中提取出来。中科院自动化所Deng X M等人[39]利用折反射投影像的边界椭圆和视场来获得内参数,然后利用单视点模型和针孔成像模型来估计外参数。

自标定需要利用多视图中的特征点对应来估计标定参数,也就是通常需要折反射系统进行不同形式的运动来获取多幅标定图。Kang S B[40]使折反射系统整体在场景中运动,然后利用成对追迹点特征在序列图中的一致性对系统进行标定。Ramalingam S等人[41]在系统特定运动下进行标定,其中系统只能做平移和旋转运动,结合图像匹配关系,获得对投影光线的几何约束,借助几何约束完成系统标定。Espuny F等人[42]提出了一种基于系统密集旋转的自标定方法,密集旋转需要分别绕两个线性无关的轴来进行,并且两个轴都需要穿过相机中心。

2.3折反射周视系统畸变校正研究

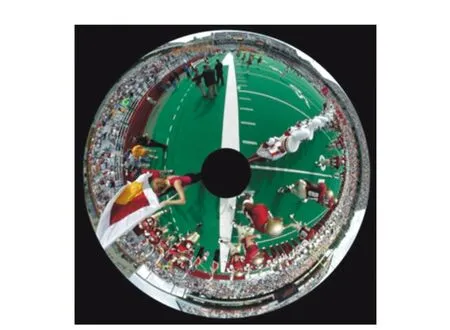

折反射周视系统一般是将360°方位角、大俯仰角的景物投影到矩形(或方形)面阵探测器的内切圆上,形成圆形的图像,几何畸变严重,如图6所示,图像中的人、看台等物体已经发生了明显的几何畸变。目前很多成熟的图像处理方法和计算机视觉方法都是基于传统的透视投影模型开发的,并不适用于具有严重畸变的折反射周视成像系统。为了解决这个问题,折反射周视系统的畸变校正就显得非常重要。

图6 折反射周视系统投影图 Fig.6 Projection of a catadioptric panoramic system

Gaspar J等人[43]建立了地平面和像面极径距离的映射查找表来校正图像畸变,不过这种校正只局限于地平面,不适用一般物体场景。J.Maybank S等人[44]针对空间线投影的畸变特点,提出在抛物面镜和远心镜头系统中使用Fisher-Rao公理对畸变进行校正。Tang Y Z等人[45]基于先验的系统特点和折反射投影特性提出一种参数化的邻域映射模型,该模型能实现目标图像邻域范围内自适应的畸变校正。四川大学曾吉勇等人[46]在针孔成像模型的基础上进行修正,建立了具有二级径向畸变的相机模型,并由此设计合适的镜面面型,以消除系统对水平场景的畸变。浙江大学肖潇等人[47]为了消除径向和切向的畸变,采用球面透视投影模型进行校正,通过在周视图像上选取采样点,对这些点采用遗传算法和初始变形校正参量将其映射为球面点,在该过程中求出变形校正参量,使用变形校正参量对整个像面进行校正。Wu Y H等人[26,48]利用二维或三维的空间点与它们具有径向畸变的图像点建立了精确的几何不变量,基于不变量进一步设计了特征向量来评价成像系统,并计算切向畸变量。

2.4折反射周视系统全视场清晰成像研究

折反射周视成像系统由于通常用现有的透视相机与单独设计加工的曲面反射镜搭建组成,并没有作为一个光学系统整体进行优化,所以一般会存在由曲面反射镜带来的严重场曲,表现在周视图像上就是只有一定宽度的环带能清晰成像,而其它部分是模糊的,这意味着折反射周视系统不能对需要的整个俯仰视场清晰成像。这个问题可以通过提高透视相机的F/#数值来改善,但是会带来噪声增加、曝光时间增加等问题。

全视场清晰成像的问题首先被Baker S和Nayar S K发现并讨论[10],他们建议在系统中加入特定的透镜以补偿场曲带来的影响,但是这需要光学设计软件进行精确的模拟,也就是说需要将反射镜和透镜作为整体进行设计。由于一直没有合适的数学模型来讨论清晰成像问题,这方面的研究很长时间都没有很大进展。2007年,Swaminathan R[49]提出用焦散理论研究反射,又开始讨论折反射周视成像系统的清晰成像问题。Swaminathan R利用焦散理论求得场景经反射镜面压缩后的虚像,将其重心设置为相机对焦点来改善成像清晰度,但是没有评价这种方法对全视场成像清晰度的改善程度,对焦位置的设定与系统其它结构参数如视场大小的关系也没有说明。另外,Swaminathan R认为单视点结构约束导致了成像的清晰范围有限,所以只讨论非单视点结构。香港城市大学Li W M等人[50]也进行了类似分析,给出了解析结果。另外,他们还提出利用不同对焦位置拍摄的多张图片拼接出一幅全视场清晰圈饼图像的方法[51]。国防科技大学李永乐等人[52]理论分析了折反射成像散焦模糊的原因,建立了周视图像点扩展函数与实景空间物点及成像系统虚像位置的关系,在一次曝光时间内匀速旋转镜头对焦环,通过积累曝光使周视图像散焦模糊核具有空间不变性,利用反卷积算法对散焦模糊周视图进行全局复原,得到全视场清晰的周视图像。国防科技大学Liu Y等人[53]和解放军军事交通学院Li Y L等人[54]分别研究了折反射系统编码光阑去模糊方法,用编码光阑替换原系统的光阑,对所成的图像进行去卷积处理还原出清晰的图像。另外,Liu Y等人[55]还提出修改全变分离焦模糊复原算法的全变分正则项,使其能更好的应用于大畸变的周视图像。北京理工大学王岭雪课题组也对全视场清晰成像问题进行了研究[11],研究目的是在特定的视场范围和单视点结构约束要求下,设计合理的系统参数配置使得系统所成像能全视场清晰。利用焦散理论获得景物经过镜面压缩后的虚物点深度位置,将系统的成像过程视为两个步骤:第一步,镜面将实际场景压缩到虚物空间;第二步,透镜组再对虚物空间成像。虚物空间的前后深度只要含在系统折射光学组所能提供的景深内,则可以实现全视场的清晰成像。同时,还研究推导了满足全视场清晰条件的系统参数的解析表达式。

3 红外波段的折反射周视系统研究进展

红外成像系统可以在夜间和低能见度条件下实现成像观察、侦察、监视、制导等,作用距离远且能穿透薄雾和烟尘,具备在全黑的夜间和低能见度条件下获取“单向透明”信息优势的能力。随着红外探测器技术的发展[56],高灵敏度和大面阵红外探测器不断涌现,为红外波段折反射周视系统的发展提供了条件。折反射周视红外成像系统的研究起步较晚,从2005年Applied Science Innovations公司的ViperView折反射周视红外成像仪才开始有公开报道。目前折反射周视红外成像系统主要应用于全景成像探测与跟踪、周边态势感知等领域。

红外波段的折反射周视系统在空间分辨力、视场范围、系统设计复杂度、系统标定和系统性能指标体系及其测试方法等方面与可见光波段的均有较大差异,下面分别进行说明。

空间分辨力方面,折反射周视红外成像系统要逊于可见光系统,原因有二:一是由于探测器材料和器件工艺的原因,红外探测器像元规模比可见光成像器件像元规模至少少一个数量级;二是红外辐射的波长比可见光的长,红外成像系统的爱里斑要大于可见光的,所以从衍射极限的角度来看长的波长已经限制了红外系统的空间分辨力。

视场范围方面,如图1所示的系统架构,最大俯角入射的光线将投影到探测器的边缘,最大仰角入射的光线则投影到探测器中央区域,由于红外探测器像元规模较小,所以探测器中央区域的空间分辨力较差,因此,折反射红外周视系统的最大仰角一般不超过50°。另外,对于昼夜使用的折反射红外周视系统,仰角不能过大的一个重要原因是为了避免太阳长时间直射引起的图像饱和甚至器件损坏。

系统设计复杂度方面,红外波段折反射周视成像系统的设计复杂度远高于可见光,原因在于:(1)红外探测器的灵敏度比可见光成像器件的低得多,所以要在光学和电学层面考虑减少能量的损耗,尤其是设计折反射周视红外镜头时首先需要选择红外透过率高的材料,二是尽量减少透镜数量,而这会加大消除场曲等像差的难度,另外,可选择的红外光学材料比可见光的要少,同样也会增加光学设计的难度;(2)曲面反射镜会带来严重畸变,减少透镜数量就意味着需要使用较多的非球面透镜来校正畸变和场曲;(3)对于制冷红外焦平面探测器,由于冷光阑的存在以及光学系统光阑后移的问题,系统设计难度又进一步提升。一方面,制冷红外焦平面探测器封装在真空杜瓦内,为防止光学系统的辐射直接投影、或经杜瓦内壁反射后投影到探测器上形成“鬼像”,通常在探测器前面设置冷屏和冷滤光片。如果光学系统F/#大于冷屏F/#,寄生辐射(红外成像系统本身的热辐射)会到达探测器,激发光生载流子,使散粒噪声增加、动态范围和灵敏度降低,而光学系统F/#小于冷屏F/#时则会截止部分有用信号,所以通常将光学系统F/#设计等于冷屏F/#。国际上为简化与探测器配套的真空器件的工艺复杂度,制冷红外焦平面探测器冷屏F/#一般为2~4,最常用的F/#是2和4。非制冷红外焦平面探测器通常选择F/#为1的光学系统。而在前文中我们已经讨论过数值小的F/#会给全视场的清晰成像带来问题,所以对于红外的折反射周视系统通常采用整体设计优化的做法,因为无法通过调节F/#来减少曲面镜带来的场曲影响,只能通过光学设计来消除场曲的影响。另一方面,为发挥制冷红外焦平面探测器组件冷光阑的效益,将冷光阑作为红外全景镜头的孔径光阑,这样孔径光阑就固定在整个镜头的后部,需要设计专门的透镜将镜头的主平面后移,并且补偿由于引入的像差。

系统标定方面,光学镜头加工误差和实际装调误差等会造成系统实际参数值偏离设计值,以主点位置为例,实际的主点位置通常不会位于图像正中央,往往会偏离几个像素,因此需要对系统进行标定。目前折反射周视成像系统的标定主要针对可见光波段,尚未见到关于红外波段系统标定的公开报道。折反射周视红外系统标定不能直接使用可见光波段的标定靶标,而是要制作由具有红外辐射强度差异且存在一定物理距离的网络点构成的红外靶标,其次在实际标定时,应将不同旋转角度的红外靶标放置在相对于系统不同距离、俯仰角和方位角的位置进行拍摄,以采集足够多的数据计算出主点位置、镜头焦距、倾斜因子、畸变系数等参数。

系统性能指标体系及其测试方法方面,由于曲面反射镜引入的非线性导致空间分辨力和灵敏度的非线性,所以不能完全沿用常规的红外成像系统性能指标体系,需要根据折反射系统的投影成像特点修改空间分辨力和灵敏度的定义。

折反射周视红外系统的空间分辨力分为俯仰角分辨力和方位角分辨力,如图7所示,其中图7(a)为视场的方位角方向,在像面上对应圆环的切向方向;图7(b)为视场的俯仰角方向,在像面上对应圆环的径向方向。

图7 (a)方位角视场和投影;(b)俯仰角视场和投影 Fig.7 (a)Azimuth FOV and projection. (b)Vertical FOV and projection

折反射红外系统的灵敏度指标主要有NETD、MRTD和作用距离。这些指标的定义与常规红外系统最大的区别在于其均与视场角相关,具体来说,与视场俯仰角相关。在进行灵敏度测试时,需要将整个俯仰角范围的视场进行分段测试。图8展示了一种测试方案,对于俯仰角每隔10°进行一个分段,每段视场投影在像平面的不同环带上。在NETD和MRTD测试时,将靶标分别置于这些不同的视场下进行测量。折反射周视红外系统的作用距离与俯仰角分辨力和方位角分辨力的乘积有关,不过对于特定系统,当俯仰角一定时,这个乘积是确定的,所以也可以对不同俯仰角分段视场分别进行测量。

红外波段折反射周视系统的最大作用是全天时的周视探测、监视与目标跟踪。针对折反射周视红外系统的空间分辨力不高的问题,Willett R M等人讨论利用压缩感知技术来提高对比度和分辨力[57]。Aburmad S[58]从光学设计的角度讨论了反射镜面型对红外光学像差校正的影响。Nichols J M等人[59]则从红外窗口材料的角度研究了影响红外图像像质的因素,分析了尖晶石作为窗口材料时其厚度的改变对折反射系统NETD的影响,得到的结论是系统NETD会随着窗口厚度的增加而线性增加。合适的积分时间和截止波长则可以减少窗口厚度增加所带来的负面影响。另外,随着窗口厚度从0增加到40 mm,最优的截止波长从5.5 μm下降到4.7 μm左右。Nichols J M等人[60]对折反射周视红外成像系统的调制传递函数MTF和噪声等效温差NETD进行了数学建模,并将预测值与实际测量结果进行对照,取得了基本一致的效果。Furxhi O等人[61]建模分析了红外周视系统的空间分辨力,并在TTP准则的基础上建立了抛物面折反射系统的成像探测距离模型。另外还讨论了探测器列阵的像元利用率。Tang Y Z等人[62-65]研究了存在严重几何畸变的折反射周视红外成像系统探测跟踪人形目标的方法,提出一种旋转自适应模型,以同心环和辐射线分割的小单元来进行局域的特征计算,其中轮廓特征可以有3种编码方式:直接梯度值编码、Haar小波变换编码以及结合轮廓梯度值和轮廓方向的编码。采用支持向量机进行特征分类、粒子滤波计算人形目标的跟踪。除了旋转自适应模型,还提出了旋转运动学模型,有效表示畸变的视觉信息,利于多运动目标的跟踪,并适用于短暂的目标遮挡。

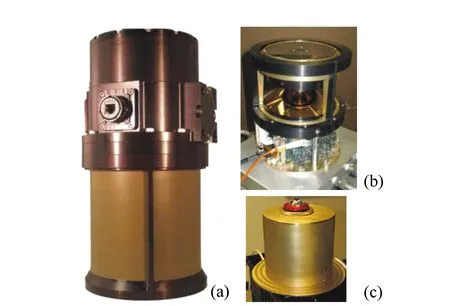

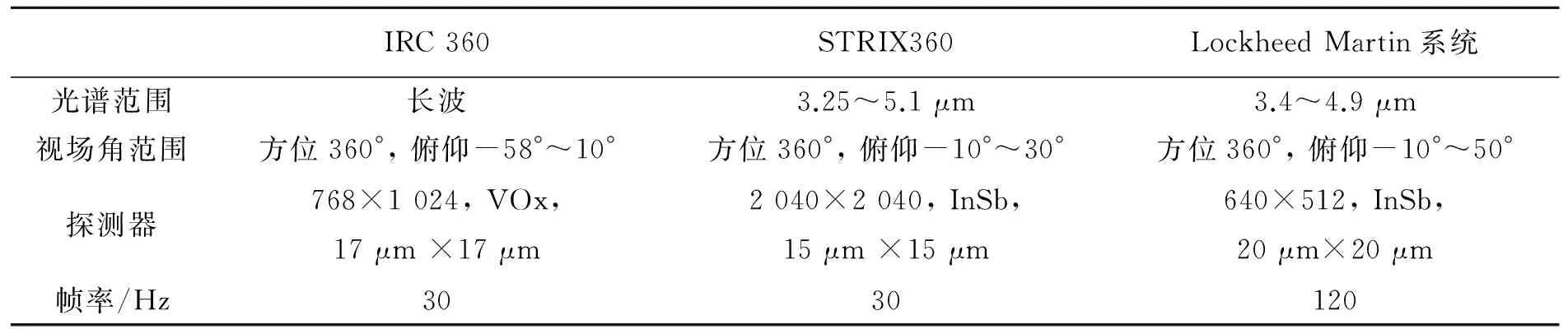

目前,国际上已经有一些公司推出了折反射周视红外成像产品,如IRCAMERAS公司的IRC 360 Single FPA, REMOTEREALITY的STRIX360[66]和 Lockheed Martin的中波红外周视系统[67],图9是外观图,表1对这3套系统的参数进行了对比。

图9 (a)IRC 360 Single FPA,(b)STRIX360, (c)Lockheed Martin的中波红外周视系统 Fig.9 (a)IRC 360 Single FPA; (b)STRIX360; (c)Middle wave infrared panoramic system of Lockheed Martin

IRC360STRIX360LockheedMartin系统光谱范围长波3.25~5.1μm3.4~4.9μm视场角范围方位360°,俯仰-58°~10°方位360°,俯仰-10°~30°方位360°,俯仰-10°~50°探测器768×1024,VOx,17μm×17μm2040×2040,InSb,15μm×15μm640×512,InSb,20μm×20μm帧率/Hz3030120

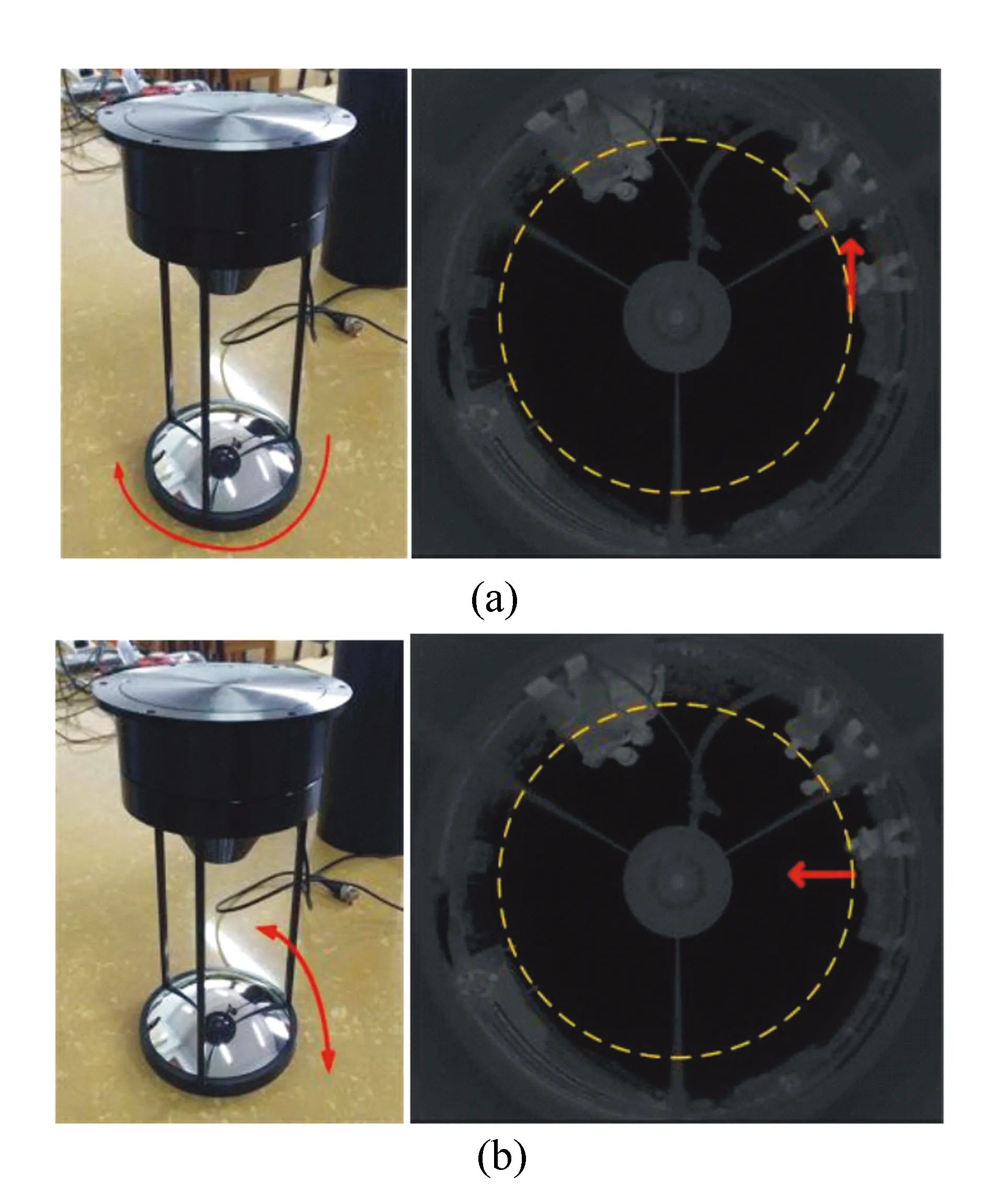

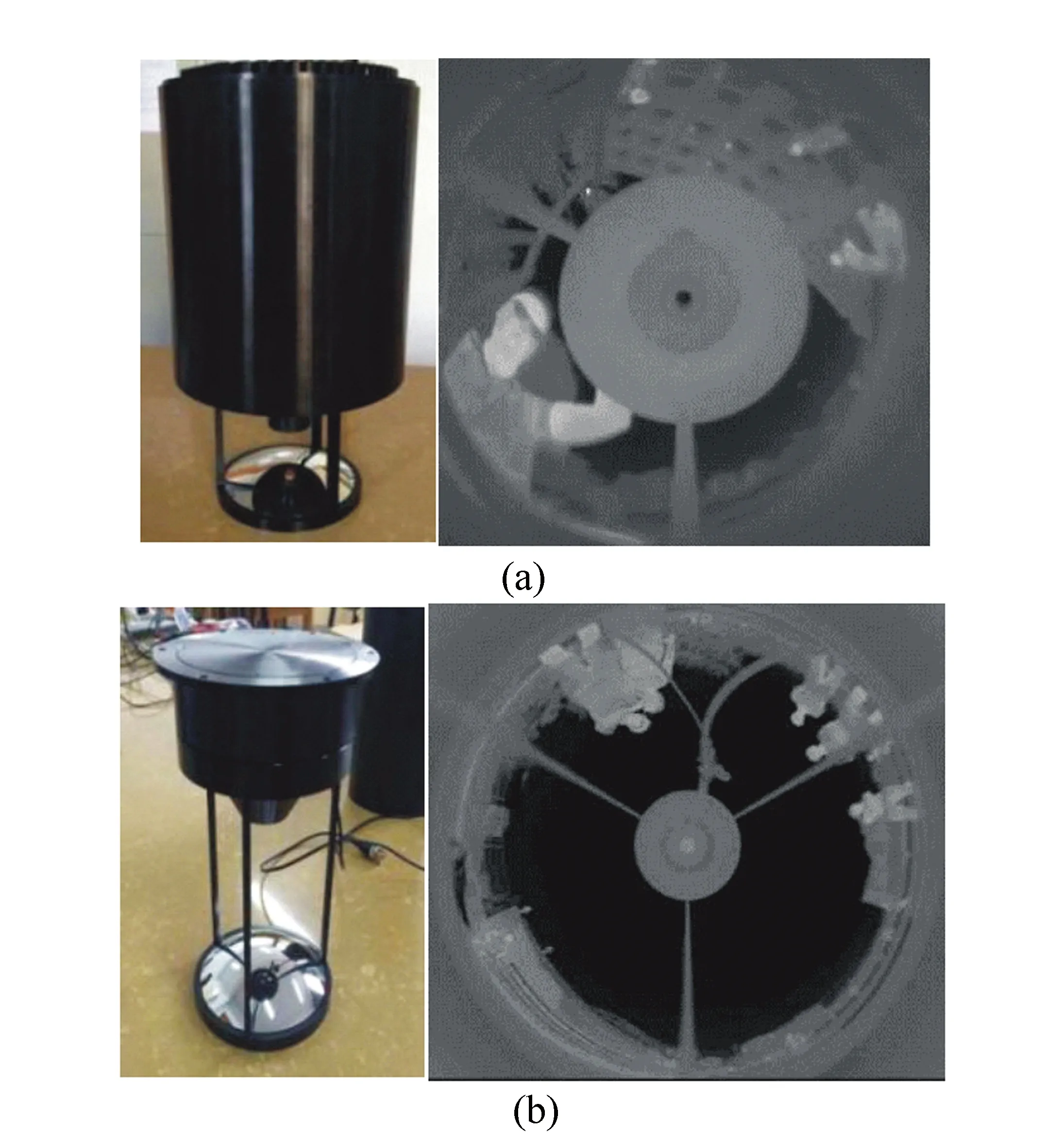

近年来,北京理工大学王岭雪课题组一直从事红外波段折反射周视系统的模型和应用研究。研究了单视点结构约束下的红外折反射周视系统的参数设计、空间分辨力以及系统采用双曲面反射镜时的作用距离公式[11,68]。针对常见圆锥曲面反射镜折反射周视系统存在的不同俯仰角下作用距离差异大的问题,提出了以俯仰角分辨力和方位角分辨力的几何平均数为常数的恒等作用距离条件,并推导了相应的系统设计方法,所设计的系统可以在不同视场下都具有几乎一致的作用距离,充分发挥折反射系统获取广域信息的潜力[69]。课题组也已经成功研制了制冷和非制冷的红外波段折反射周视系统。图10(a)是中波制冷型系统和所成图像,波段范围1~5 μm,方位角视场为360°,俯仰视场-3°~+40°,采用512×512铂硅探测器,像元大小30 μm×30 μm。图10(b)是长波非制冷型系统(需倒置使用)和所成图像,波段范围8~14 μm,方位角视场为360°,俯仰视场为-30°~+5°,采用512×512的氧化钒探测器,像元大小17 μm ×17 μm。

图10 (a)中波红外制冷型系统和所成图像,(b)长波红外非制冷型系统和所成图像 Fig.10 (a)Middle wave infrared refrigeration system and the image; (b)Long wave infrared non-refrigeration system and the image

4 折反射周视立体视觉系统研究进展

虚拟现实和增强现实等技术的快速发展增加了对大视场立体感知和重构的需求。常规的双目相机立体视觉虽然比较成熟[70-82],但是视场非常有限,因此研究者们提出了将具有周视凝视成像特点的折反射周视成像技术与双目立体视觉原理相结合的折反射周视立体视觉技术,其中双目立体视觉原理是利用多相机视点对同一场景成像,通过立体匹配计算视差并利用三角测量原理来获得场景的深度信息。折反射周视立体视觉技术可以视为将常规相机替换为折反射周视成像系统的双目立体视觉系统,目的是同时对周视场景进行深度估计。

图11 双相机双镜面结构 Fig.11 Dual cameras with dual mirrors structure

图12 单相机双镜面结构 Fig.12 Single camera with dual mirrors structure

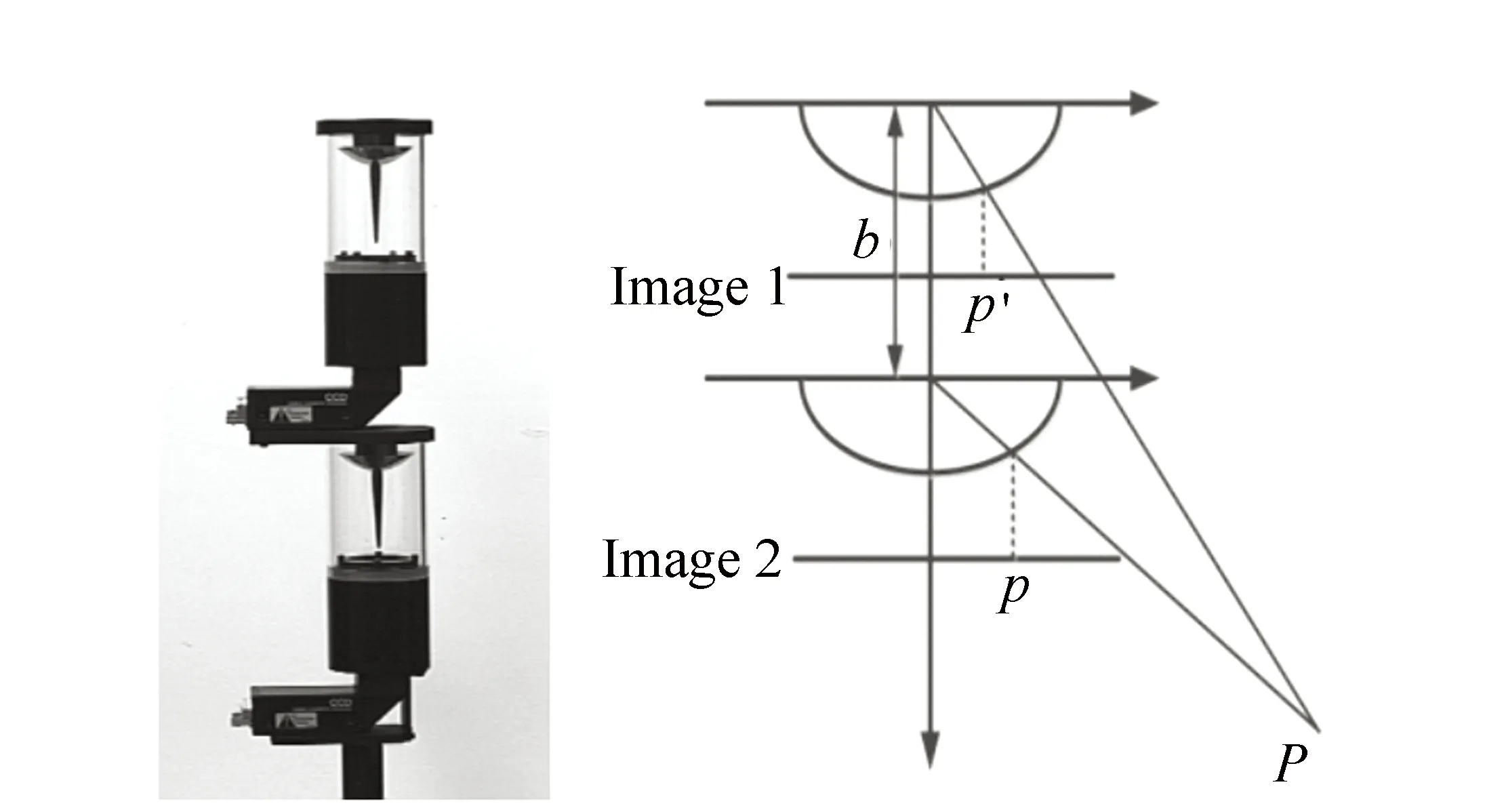

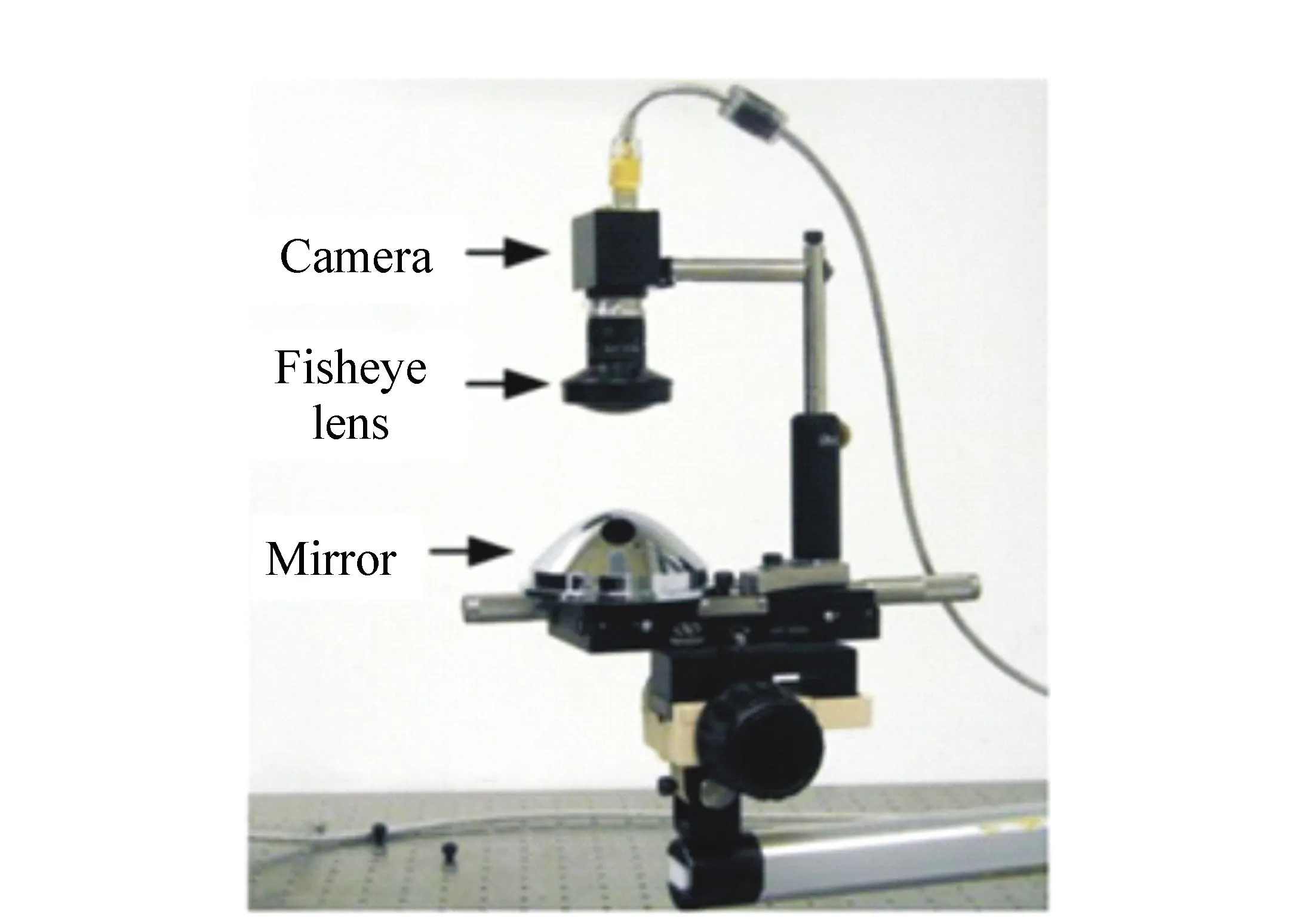

1998年,Gluckman J等人[83]设计了双相机双镜面折反射周视立体视觉系统,如图11所示,该系统由两个折反射周视成像子系统上下共轴叠加组成,两个子系统均为单视点系统,可以满足双目视觉的要求,而两单视点之间的直线距离即为基线距离。2002年,Koyasu H S等人[84]将Gluckman J[83]系统中的抛物面反射镜替换为双曲面反射镜,这样就可以用普通镜头代替远心镜头,明显降低系统成本。虽然这种双相机双镜面的结构可以实现周视立体视觉,但由于是两个折反射周视成像子系统的直接叠加,结构不紧凑,另外,两个相机的物理性能差异会给深度信息获取造成困难。为了解决上述问题,研究人员开始将子系统集成到一起。2004年,Cabral E L L等人[85]提出一种单相机双叶镜面系统,双叶镜是一个同轴的镜面对,可以看做将两个不同曲率的镜面组合到了一起,两个镜面的中心轴与相机光轴共线。空间同一物点经过两个反射镜反射后分别成像在以像平面中心向外径向方向的两个相接圆环内,相当于两个子系统共用一个相机,通过合理的几何设计使两者的像面互相不重合,一个投影在内环,一个投影在外环。但是这种结构的两个镜面距离近,使得基线较短,所以深度获取精度较低,并且这种组合镜面也不容易加工。2006年开始,单相机双镜面结构的折反射周视立体视觉系统开始被研究人员所青睐,如图12所示,这种结构的两个反射镜上下分离,都与相机共轴,整体较为紧凑,同时尽量增加了基线长度。Gijeong Jang等人[86]使用两个相对放置的中部镂空的双曲面镜,并且其中一个曲面镜的镂空处装上平面反射镜作为另一个曲面反射镜的二次反射面。中科院沈阳自动化所苏连成等人[87]则采用两个双曲面同向放置的方式,与相机距离近的镜面中部镂空使得经另一反射面反射的光线能够通过并且入射相机。单相机双镜结构又出现了一些变体结构,2011年,香港城市大学Li W M[88]提出将两个反射镜中靠近相机的那个镜面换为鱼眼透镜,有效提高俯仰视场范围,如图13所示。另一个典型的变体结构是2012年浙江大学Huang Z等人[89-90]提出使用两个PAL结构实现立体视觉的系统,如图14所示,其中PAL是一种腔体内多次反射的结构,起到同曲面反射镜类似的作用。这种结构将反射过程在一个腔体内完成,避免反射镜外露而容易损坏的问题。

图13 具有鱼眼透镜的折反射周视立体视觉系统 Fig.13 Catadioptric panoramic stereo vision system with a fisheye lens

图14 PAL结构折反射周视立体视觉系统 Fig.14 Catadioptric panoramic stereo vision system with PALs structure

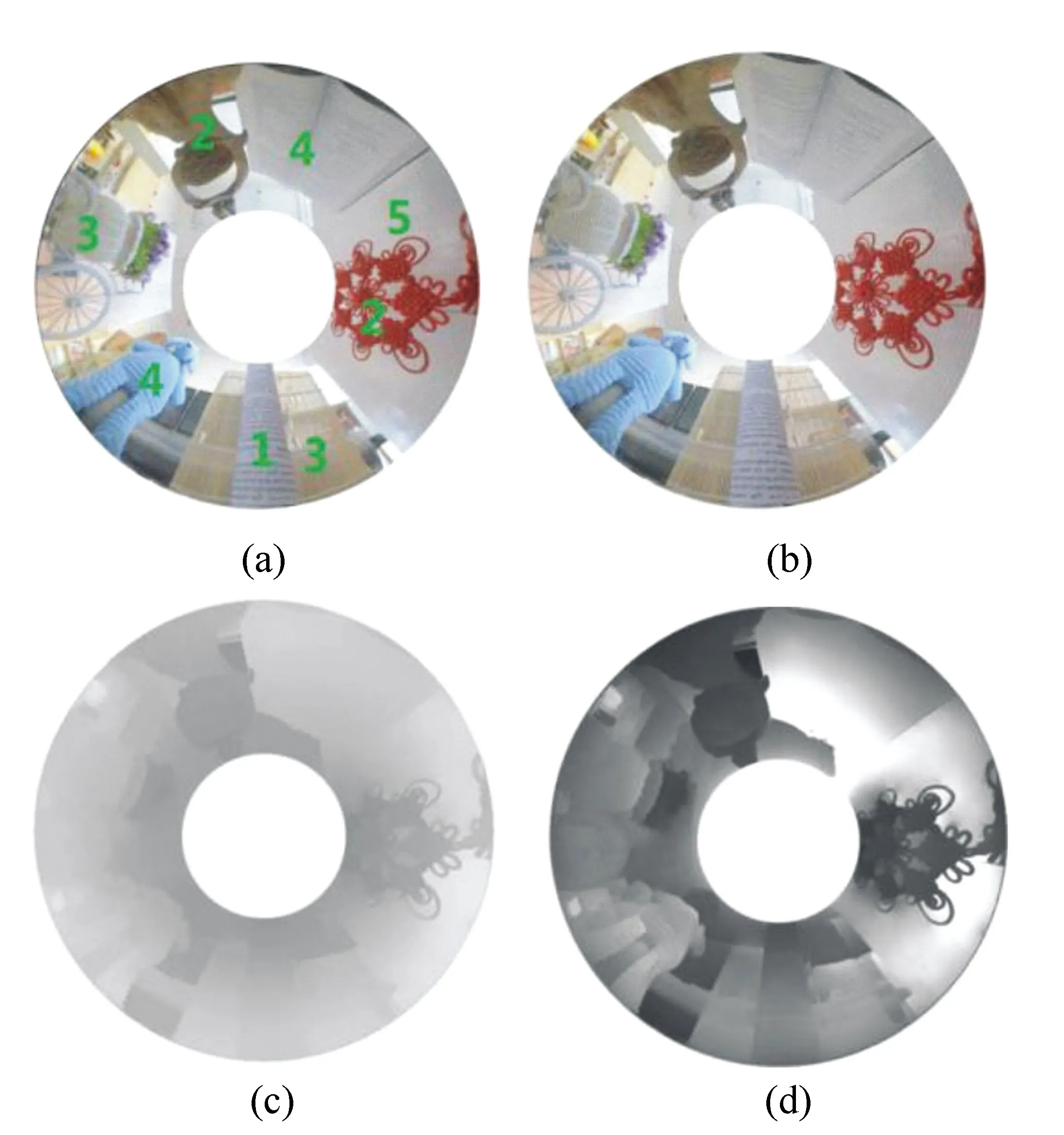

图15 (a)和(b)是对虚场景两次对焦拍摄的图像;(c)是虚场景的深度图;(d)是周视实场景的深度图 Fig.15 (a) and (b) are the two-shot images of the virtual scene surfaces;(c)depth maps of the virtual scene; (d)depth maps of the real panoramic scene

基于双目立体视觉原理的折反射周视立体视觉系统通常结构较为复杂,而且立体匹配较为困难,北京理工大学王岭雪课题组[91]提出一种使用单个折反射周视成像系统(而非专门设计的立体视觉系统)来实现周视场景深度估计的方法,称为单目折反射周视深度估计方法。这种方法以焦散(caustic)建模曲面镜的反射过程,建立周视实场景与反射镜内虚场景的位置之间的对应关系。通过对虚场景进行远、近对焦拍摄,利用两幅图像中的相对离焦计算虚场景的位置,然后数学建模虚场景位置和周视实场景位置之间的关系,进一步得到周视实场景的深度距离位置信息。图15展示了这个过程,图15(a)和15(b)是对镜面内虚场景远、近对焦拍摄的两幅图像,图15(c)是计算出的虚场景深度图,图15(d)是计算出的周视实场景深度图。图15(a)中的数字表示物体距离系统的远近,数字越小表示距离越近,图15(d)中的灰度越深表示距离系统越近。这种方法不依赖于双目视觉原理,可以使用一般的折反射周视成像系统,而且不需要系统满足单视点结构约束,减少了系统硬件的复杂性,增加了灵活性。

5 结束语

折反射周视系统作为一种新型的凝视型周视大视场获取系统,相比传统的多相机拼接周视和鱼眼镜头周视成像等方式,在系统尺寸、结构复杂度、成本和实时性上有明显优势。在视觉导航、监测、虚拟现实和同步定位与绘图等领域具有广泛的应用前景。

折反射周视系统在近十几年因其重要的应用价值,吸引了很多研究者开展了卓有成效的研究。但是,目前这种技术仍然有一些尚待完善之处,我们根据已有的认识对这些问题进行总结,并对未来可能的发展方向进行预测:

(1)非单视点折反射周视成像模型亟待深入研究。单视点作为非单视点的一种特殊情况,迄今为止对单视点折反射周视系统的成像模型和标定模型等研究较为深入,而非单视点在设计和配置时将更加灵活,甚至可以定制特定的投影关系,调整不同视场的分辨力分布,比如恒定角分辨力、恒定垂直分辨等。另外,目前非单视点成像模型基本上由光线追迹得到,缺乏类似单视点球面统一模型的高效模型,所以阻碍了相应的标定模型的研究,延缓了将现有计算机视觉算法移植应用到非单视点折反射周视系统中,因此,亟待深入研究非单视点的成像模型,提出高效的成像模型,以拓展折反射周视系统的应用。

(2)提高折反射周视系统空间分辨力的方法研究,在新的成像方式或图像处理方式下获得更高的空间分辨力,或者是设计大视场与高分辨力能自由切换的系统,比如是否可以通过相机的离轴而使相机只正对镜面的一个侧面,这样虽然减小了视场,但提高了角分辨力,再配合光学系统的少量运动实现大视场与高分辨力的转换。

(3)基于折反射周视系统的经典计算机视觉问题的算法研究及其实时实现技术研究。目前的折反射周视系统相关研究主要集中在成像模型和系统标定上,这只是解决视觉问题的前提,最终是希望利用折反射周视系统大视场的优势解决典型的视觉问题,如Tang Y Z等人[64]所关注的折反射周视红外成像系统下人形目标的探测和追踪方法,Caruso D等人[92]提出的使用周视系统实现实时的大视场SLAM,其中大视场SLAM可以克服窄视场SLAM在高速旋转下的重构错误。

折反射周视立体视觉系统有待解决的问题有:

(1)双目视觉需要长的基线才能保证深度精度,而这无疑会增加双目的折反射周视立体视觉系统的长度,这与系统小型化的趋势相悖。

(2)折反射周视系统的周视图像从中心沿径向方向的空间分辨力是不断变化的,因此空间中某个特征在双目立体视觉的两个子系统中对应的图像分辨力不一致,会导致立体匹配的误差。

(3)目前的双目折反射立体视觉系统均是将两个成像子系统的周视图像投影到同一个探测器上形成两个同心圆环,这样共用探测器的方式会进一步降低图像的分辨力,影响深度估计精度。

[1] US Army. Panoramic television viewing system:America,US,3505465 A[P].1970-04-07.

[2] YAMAZAWA K,YAGI Y,YACHIDA M. Omnidirectional imaging with hyperboloidal projection[C]. 1993 IEEE/RSJ International Conference on Intelligent Robots and Systems,Tokyo,Japan,1993:1029-1034.

[3] PEGARD C,MOUADDIB E M. A mobile robot using a panorama view[C]. IEEE International Conference on Robotics and Automation,IEEE,1996:89-94.

[4] NAYAR S K. Catadioptric omnidirectional camera[C]. IEEE Conference on Computer Vision and Pattern Recognition,IEEE,1997:482-488.

[5] CHAHL J S,SRINIVASAN M V. Reflective surfaces for panoramic imaging[J].AppliedOptics,1997,36(31):8275-8285.

[6] CONROY T,MOORE J T. Resolution invariant surfaces for panoramic vision systems[C]. 7th IEEE International Conference on Computer Vision,IEEE,1999:392.

[7] HICKS R A,BAJCSY R. Reflective surfaces as computational sensors[J].ImageandVisionComputing,1999,19(11):773-777.

[8] GACHTER S. Mirror design for an omnidirectional camera with a uniform cylindrical projection when using the SVAVISCA sensor[R]. Research reports of CMP,OMNIVIEWS Project,Czech Technical University in Prague,2001.

[9] BAKER S,NAYAR S K. A theory of catadioptric image formation[C]. 6th IEEE International Conference on Computer Vision,IEEE,1998:35-42.

[10] BAKER S,NAYAR S K. A theory of single-viewpoint catadioptric image formation[J].Int.J.Comput.Vis.,1999,35(2):175-196.

[11] 贺宇,王岭雪,周星光,等.单视点红外折反射全向成像系统参数设计[J].光学学报,2016,36(1):0111002.

HE Y,WANG L X,ZHOU X G,etal.. Parameters design for single viewpoint infrared omnidirectional view sensors[J].ActaOpticaSinica,2016,36(1):0111002.(in Chinese)

[12] NAGAHARA H,YOSHIDA K,YACHIDA M. An omnidirectional vision sensor with single view and constant resolution[C]. IEEE International Conference on Computer Vision,IEEE,2007:1-8.

[13] HICKS R A,MILLSTONE M,DANIILIDIIS K. Realizing any central projection with a mirror pair[J].AppliedOptics,2006,45(28):7205-7210.

[14] STURZL W,SRINIVASAN M V. Omnidirectional imaging system with constant elevational gain and single viewpoint[C]. 10th Workshop on Omnidirectional Vision,CameraNetworks and Non-classical Cameras,Zaragoa,Spain,2010:1-7.

[15] SWAMINATHAN R,GROSSBERG M D,NAYAR S K. Non-single viewpoint catadioptric cameras: geometry and analysis[J].Int.J.Comput.Vis.,2006,66(3):211-229.

[16] SWAMINATHAN R,GROSSBERG M D,NAYAR S K. Caustics of catadioptric cameras[C]. IEEE International Conference on Computer Vision,IEEE,2001:2-9 .

[17] SWAMINATHAN R,GROSSBERG M D,NAYAR S K. A perspective on distortions[C]. IEEE Computer Vision and Pattern Recognition,IEEE,2003:594-601.

[18] YU J Y,MCMILLAN L. Modelling reflections via multiperspective imaging[J].IEEEComputerVisionandPatternRecognition,2005,1:117-124.

[19] YU J Y,MCMILLAN L. General linear cameras[C]. 8th European. Conf. on Computer vision(ECCV 2004),Prague,Czech,2004:14-27.

[20] GEYER C,DANIILIDIS K. A unifying theory for central panoramic systems and practical applications[C]. 6th European. Conf. on Computer vision(ECCV 2000) ,Antibes,France,2000:445-461.

[21] GEYER C,DANIILIDIS K. Mirrors in motion: Epipolar geometry and motion estimation[J].Int.J.Comput.Vis.,2003,2:766-773.

[22] GEYER C M. Catadioptric projective geometry:theory and applications[D]. Philadelphia:University of Pennsylvania,2003.

[23] ALIAGA D G. Accurate catadioptric calibration for real-time pose estimation in room-size environments[C]. 8th IEEE International Conference on Computer Vision,IEEE,2001:127-134.

[24] PUIG L,BASTANLAR Y,STURM P,etal.. Calibration of central catadioptric cameras using a dlt-like approach[J].Int.J.Comput.Vis.,2011,93(1):101-114.

[25] THIRTHALA S R,POLLEFEYS M. Radial multi-focal tensors[J].Int.J.Comput.Vis.,2012,96(2):195-211.

[26] WU Y H,HU Z Y. Geometric invariants and applications under catadioptric camera model[C]. IEEE International Conference on Computer Vision,IEEE,2005:1547-1554.

[27] GEYER C,DANIILIDIS K. Paracatadioptric camera calibration[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2002,24(5):687-695.

[28] VANDEPORTAELE B,CATTOEN M,MARTHON P,etal. A new linear calibration method for paracatadioptric cameras[C]. 18th IEEE International Conference on Pattern Recognition,IEEE,2006:647-651.

[29] VASSEUR P,MOUADDIB E M. Central catadioptric line detection[C]. In British Machine Vision Conference,London,UK,2004:doi:10.52441C,18.8.

[30] CAGLIOTI V,TADDEI P,BORACCH I ,etal.. Singleimage calibration of off-axis catadioptric cameras using lines[C]. 11th IEEE International Conference on Computer Vision,IEEE,2007:1-6.

[31] YING X H,HU Z Y. Catadioptric camera calibration using geometric invariants[J].IEEETransactionsonPatternAnalysisandMachineIntelligence,2004,26(10):1260-1271.

[32] WU Y H,LI Y F,HU Z Y. Easy calibration for para-catadioptric-like camera[C]. IEEE/RSJ International Conference on Intelligent Robots and Systems,IEEE,2006:5719-5724.

[33] YING X H,ZHA H B. Simultaneously calibrating catadioptric camera and detecting line features using hough transform[C]. IEEE/RSJ International Conference on Intelligent Robots and Systems,IEEE,2005:412-417.

[34] YING X H,ZHA H B. Identical projective geometric properties of central catadioptric line images and sphere images with applications to calibration[J].Int.J.Comput.Vis.,2008,78(1):89-105.

[35] WU F C,DUAN F Q,HU Z Y,etal. A new linear algorithm for calibrating central catadioptric cameras[J].PatternRecognition,2008,41(10):3166-3172.

[36] SCARAMUZZA D,MARTINELLI A,SIEGWART R. A flexible technique for accurate omnidirectional camera calibration and structure from motion[C]. IEEE International Conference on Computer Vision Systems,IEEE,2006:45.

[37] MEI C,RIVES P. Single view point omnidirectional camera calibration from planar grids[C]. IEEE International Conference on Robotics and Automation,IEEE,2007:3945-3950.

[38] GASPARINI S,STURM P,BARRETO J P. Plane-based calibration of central catadioptric cameras[C]. 12th IEEE International Conference on Computer Vision,IEEE,2009:1195-1202.

[39] DENG X M,WU F C,WU Y H. An easy calibration method for central catadioptric cameras[J].ActaAutomaticaSinica,2007,33(8):801-808.

[40] KANG S B. Catadioptric self-calibration[C]. IEEE Conference on Computer Vision and Pattern Recognition,IEEE,2000:201-207.

[41] RAMALINGAM S,STURM P,LODHA S K. Generic self-calibration of central cameras[J].ComputerVisionandImageUnderstanding,2010,114(2):210-219.

[42] ESPUNY F,BURGOS GIL J I. Generic self-calibration of central cameras from two rotational ows[J].Int.J.Comput.Vis.,2011,91(2):131-145.

[43] GASPAR J,SANTOS-VICTOR J. Visual path following with a catadioptric panoramic camera[C]. International Symposium on Intelligent Robotic Systems,IEEE,1999:139-147.

[44] J.MAYBANK S,IENG S,BENOSMAN R. A fisher-rao metric for paracatadioptric images of lines[J].Int.J.Comput.Vis.,2012,99(2):147-165.

[45] TANG Y Z,LI Y F,LUO J. Parametric distortion-adaptive neighborhood for omnidirectional camera[J].AppliedOptics,2015,54(23):6969-6978.

[46] 曾吉勇,苏显渝.水平场景无畸变折反射周视成像系统透镜畸变的消除[J].光学学报,2004,24(6):730-734.

ZENG J Y,SU X Y. Elimination of the lens distortion in catadioptric omnidirectional distortionless imaging system for horizontal scene[J].ActaOpticaSinica,2004,24(6):730-734.(in Chinese)

[47] 肖潇,杨国光,白剑.基于球面透视投影约束的周视环形透镜畸变校正[J].光学学报,2008,28(4):675-680.

XIAO X,YANG G G,BAI J. Panoramic-Annular-Lens distortion correction based on spherical perspective projection constraint[J].ActaOpticaSinica,2008,28(4):675-680.(in Chinese)

[48] WU Y H,HU Z Y,LI Y F. Radial distortion invariants and lens evaluation under a single-optical-axis omnidirectional camera[J].ComputerVisionandImageUnderstanding,2014,126(2):11-27.

[49] SWAMINATHAN R. Focus in catadioptric imaging systems[C]. IEEE 11th International Conference on Computer Vision,IEEE,2007:1-7.

[50] LI W M,LI Y F. An analytical solution to optimal focal distance in catadioptric imaging systems[C]. IEEE International Conference on Robotics and Automation,IEEE,2011:6300-6305.

[51] LI W M,LI Y F. Overall well-focused catadioptric image acquisition with multifocal images:a model-based method[J].IEEETransactionsonImageProcessing,2012,21(8):3697-3706.

[52] 李永乐,张茂军,娄静涛,等.去散焦模糊的折反射全向成像系统设计[J].光学学报,2012,32(9):0911001.

LI Y L,ZHANG M J,LOU J T,etal.. Design of catadioptric omnidirectional imaging system for defocus deblurring[J].ActaOpticaSinica,2012,32(9):0911001.(in Chinese)

[53] LIU Y,LI H F,LI Y L,etal. Coded aperture enhanced catadioptric optical system for omnidirectional image deblurring[J].Optik,2014,125(1):11-17.

[54] LI Y L,LOU J T,XU Y C. Defocus deblurring for catadioptric omnidirectional imaging based on coded aperture and omni-total variation[J].AdvancedRobotics,2015,29(16):1-13.

[55] LIU Y,LI Y L,LOU J T,etal.. Omni-total variation algorithm for the restoration of all-focused catadioptric image[J].Optik,2014,125(14):3685-3689.

[56] 白瑜,廖志远,廖胜,等.共孔径消热差红外双波段光学系统[J].光学 精密工程,2016,24(2):268-277.

BAI Y,LIAO Z Y,LIAO SH,etal.. Infrared dual band a thermal optical system with common aperture[J].Opt.PrecisionEng.,2016,24(2):268-277.(in Chinese)

[57] WILLETT R M,MARCIA R F,NICHOLS J M. Compressed sensing for practical optical imaging systems: a tutorial[J].OpticalEngineering,2011,50(7):072601.

[58] ABURMAD S. Panoramic thermal imaging: challenges and tradeoffs[J].SPIE,2014,9070:90700W.

[59] NICHOLS J M,WATERMAN J R,BAYYA S,etal.. Influence of spinel head window thickness on the performance characteristics of a submarine, panoramic, infrared imaging system[J].SPIE,2011,8012:90122C.

[60] NICHOLS J M,WATERMAN J R,MENON R,etal.. Modeling and analysis of a high-performance midwave infrared panoramic periscope[J].OpticalEngineering,2010,49(11):113202.

[61] FURXHI O,DRIGGERS R G,HOLST G,etal.. Performance analysis of panoramic infrared systems[J].SPIE,2014,9071:907112.

[62] TANG Y Z,LI Y F. Contour coding based rotating adaptive model for human detection and tracking in thermal catadioptric omnidirectional vision[J].AppliedOptics,2012,51(27):6641-6652.

[63] TANG Y Z,LI Y F,BAI T X,etal.. Rotating adaptive Haar wavelet transform for human tracking in thermal omnidirectional vision[C]. IEEE International Conference on Multisensor Fusion and Integration for Intelligent Systems,IEEE,2012:324-329.

[64] TANG Y Z,LUO J,LI Y F,etal.. Rotational kinematics model based adaptive particle filter for robust human tracking in thermal omnidirectional vision[J].MathematicalProblemsinEngineering,2015:347497.

[65] TANG Y Z,LI Y F,BAI T X,etal.. A rotating adaptive model for human tracking in thermal catadioptric omnidirectional vision[C]. IEEE International Conference on Robotics and Biomimetics,IEEE,2011:2435-2440.

[66] RemoteReality. Strix360 camera system[EB/OL].[2015-01-11].http://www.remotereality.com.

[67] BJORK C,WAN W. Mid-wave infrared(MWIR) panoramic sensor for various applications[J].SPIE,2010,7660:76600B.

[68] 周星光,贺宇,王岭雪,等.单视点双曲面折反射红外全景成像系统设计与分析[J].红外与激光工程,2016,45(9):197-205.

ZHOU X G,HE Y,WANG L X,etal.. Hyperbolicsingle-viewpoint infrared catadioptric panoramic imaging system[J].InfraredandLaserEngineering,2016,45(9):197-205.(in Chinese)

[69] 贺宇,王岭雪,蔡毅,等.恒等探测距离折反射周视红外成像系统设计及分析[J].光学学报,2017,37(4):0422002.

HE Y,WANG L X,CAI Y,etal.. Design and analysis for catadioptric omnidirectional view Infrared imaging system with constant detection range[J].ActaOpticaSinica,2017,37(4):0422002.(in Chinese)

[70] SCHARSTEIN D,SZELISKI R. http://vision.middlebury.edu/stereo/eval/[EB/OL].[2016-07-06].

[71] SCHARSTEIN D,SZELISKI R. A taxonomy and evaluation of dense two-frame stereo correspondence algorithms[J].Int.J.Comput.Vis.,2002,47(1):7-42.

[72] HIRSCHMULLER H. Stereo vision in structured environments by consistent semi-global matching[C]. 21rd IEEE Conference on Computer Vision and Pattern Recognition(CVPR),IEEE,2006:2386-2393.

[73] TOMBARI F,MATTOCCIA S,STEFANO L D,etal.. Near real-time stereo based on effective cost aggregation[C]. 22rd IEEE Conference on Computer Vision and Pattern Recognition(CVPR),IEEE,2008:1-4.

[74] MATTOCCIA S,GIARDINO S,GAMBINI A. Accurate and efficient cost aggregation strategy for stereo correspondence based on approximated joint bilateral filtering[C]. Asian Conference on Computer Vision,Queenstown,New Zealand,2010,5995:371-380.

[75] MATTOCCIA S. A locally global approach to stereo correspondence[C]. IEEE International Conference on Computer Vision Workshops,IEEE,2009:1763-1770.

[76] MATTOCCIA S. Improving the accuracy of fast dense stereo correspondence algorithms by enforcing local consistency of disparity fields[C]. 3D Data Processing,Visualization,and Transmission,Paris,Frame,2010:17-20.

[77] MATTOCCIA S. Fast locally consistent dense stereo on multicore[C]. 6th IEEE Embedded Computer Vision Workshop(ECVW2010),CVPR workshop,IEEE,2010:69-76.

[78] MATTOCCIA S. Accurate dense stereo by constraining local consistency on superpixels[C]. 20th International Conference on Pattern Recognition,Istambul,Turkey,2010:1832-1835.

[79] ZHANG C ,LI Z W ,CHENG Y H,etal.. MeshStereo:a global stereo model with mesh alignment regularization for view interpolation[C]. 15th IEEE International Conference on Computer Vision(ICCV),IEEE,2015:2057-2065.

[80] 宋涛,熊文莉,侯培国,等.基于极曲线几何和支持邻域的鱼眼图像立体匹配[J].光学 精密工程,2016,24(8):2050-2058.

SONG T,XIONG W L,HOU P G,etal.. Stereo matching for fish-eye images based on epipolar geometry and support neighborhood[J].Opt.PrecisionEng.,2016,24(8):2050-2058.(in Chinese)

[81] 王晓燕,王世刚,姜秀红,等.亮度优化立体视频视觉舒适度评价[J].中国光学,2015,8(3):394-400.

WANG X Y,WANG SH G,JIANG X H,etal. Evaluation of stereo video visual comfort based on luminance optimization[J].ChineseOptics,2015,8(3):394-400.(in Chinese)

[82] 高礼圳,刘书桂,韩振华.零件的角点提取及匹配定位[J].中国光学,2016,9(4):397-404.

GAO L ZH,LIU SH G,HAN ZH H. Corner extraction and matching location of parts[J].ChineseOptics,2016,9(4):397-404.(in Chinese)

[83] GLUCKMAN J,NAYAR S K,THORESZ K J. Real-time omnidirectional and panoramic stereo[C]. 1998 DARPA Image Understanding Workshop,California,USA,1998:299-303.

[84] KOYASU H S,MIURA J ,SHIRAI Y. Recognizing moving obstacles for robot navigation using real-time omnidirectional stereo vision[J].J.RoboticsandMechatronics,2002,14(2):147-156.

[85] CABRAL E L L,SOUZA J J C,HUNOLD M C. Omnidirectional stereo vision with a hyperbolic double lobed mirror[C]. 17th International Conference on Pattern Recognition ,IEEE,2004:1-9.

[86] JANG G,KIM S,KWEON I. Single-camera panoramic stereo system with single-viewpoint optics[J].OpticsLetters,2006,31(1):41-43.

[87] SU L C,ZHU F. Design of a novel omnidirectional stereo vision system[J].ActaAutomaticaSinica,2006,32(1):67-72.

[88] LI W M,LI Y F. Single-camera panoramic stereo imaging system with a fisheye lens and aconvex mirror[J].OpticsExpress,2011,19(7):5855-5867.

[89] HUANG Z,BAI J,HOU X Y. Design of panoramic stereo imaging with single optical system[J].OpticsExpress,2012,20(6):6085-6096.

[90] 黄治.单传感器全景立体环带成像光学系统的研究[D].杭州:浙江大学,2014.

HUANG ZH. Study of panoramic stereo imaging with single optical system[D]. Hangzhou:Zhejiang University,2014.(in Chinese)

[91] HE Y,WANG L X,CAI Y,etal.. Monocular catadioptric panoramic depth estimation via caustics-based virtual scene transition[J].J.OpticalSocietyofAmericaA,2016,33(9):1872-1879.

[92] CARUSO D,ENGEL J,CREMERS D. Large-scale direct SLAM for omnidirectional cameras[C]. IEEE International Conference on Intelligent Robort & Systems,IEEE,2015:141-148.

Researchprogressandprospectofcatadioptricpanoramicsystem

HE Yu1, WANG Ling-xue1*, CAI Yi1,2, ZHOU Xing-guang1, XUE Wei1, JIANG Jie3, LIU Fu-ping3, LI Hong-bing3, CHEN Ji3, LUO Yong-fang3, LI Mao-zhong3

(1.KeyLaboratoryofPhotoelectronicImagingTechnologyandSystem,MinistryofEducationofChina,BeijingEngineeringResearchCenterforMixedRealityandAdvancedDisplayTechnology,SchoolofOptoelectronics,BeijingInstituteofTechnologyBeijing100081,China; 2.ChinaResearchandDevelopmentAcademyofMachineryEquipment,Beijing100089,China; 3.YunnanKIRO-CHPhotonicsCo.,Ltd,Kunming650217,China)

As a new panoramic vision system developed in recent 10 years, the catadioptric panoramic system has advantages in miniaturization, structural flexibility, low cost and real-time compared to conventional methods such as camera rotation scanning, multi-camera image stitching, and fisheye lens large field imaging. In this review, the recent progress in basic catadioptric panoramic system, including imaging models, system calibration, distortion correction and overall well-focused imaging, are summarized. Moreover, the extended applications in infrared imaging and stereo vision are also presented. Finally, the existing unsolved problems are discussed. It is also suggested that the future catadioptric panoramic system will focus on non-single view imaging model, improving of the spatial resolution method and implementing of the real-time processing algorithm.

catadioptric panoramic system;distortion correction;infrared imaging;panoramic stereo vision

TN201

A

10.3788/CO.20171005.0681

贺 宇(1988—),男,湖北宜昌人,博士研究生,主要从事红外成像、红外成像系统性能建模和折反射周视成像系统方面的研究。E-mail:hy070609@163.com

王岭雪(1973—),女,云南石屏人,博士,副教授,主要从事红外成像、图像处理和红外光谱方面的研究。E-mail:neobull@bit.edu.cn

2017-05-11;

2017-08-13

国家自然科学基金资助项目(No.61471044);高等学校博士学科点专项科研基金资助项目(No.20131101110024);预研基金重点项目资助项目(No.9140A02010114BQ01005)

Supported by National Natural Science Foundation of China(No.61471044); Ph.D Programs Foundation of the Ministry of Education of China(No.20131101110024); Advanced Research Foundation of China(No.9140A02010114BQ01005)

2095-1531(2017)05-0681-18

*Correspondingauthor,E-mail:neobull@bit.edu.cn