声音情绪对面孔性别信息加工的影响

2017-09-18蒋重清郭姗姗张喜娥排日代阿卜杜凯尤木唐晓雨

蒋重清, 郭姗姗, 张喜娥, 李 东, 排日代·阿卜杜凯尤木, 唐晓雨

(1.辽宁师范大学 心理学院,辽宁 大连116029;2.辽宁省儿童青少年健康人格评定与培养协同创新中心,辽宁 大连 116029)

声音情绪对面孔性别信息加工的影响

蒋重清1,2, 郭姗姗1, 张喜娥1, 李 东1, 排日代·阿卜杜凯尤木1, 唐晓雨1

(1.辽宁师范大学 心理学院,辽宁 大连116029;2.辽宁省儿童青少年健康人格评定与培养协同创新中心,辽宁 大连 116029)

为探究声音情绪对面孔性别信息加工的影响,要求被试在高兴、生气、中性、无声四种声音条件下判断中性表情面孔的性别。结果表明:在生气声音条件下,对男性面孔性别判断的反应时显著短于对女性面孔性别判断的反应时,对男性面孔性别判断的正确率显著高于对女性面孔性别判断的正确率;在高兴声音条件下,对女性面孔性别判断的正确率显著高于对男性面孔性别判断的正确率;在无声和中性声音条件下,对面孔性别判断的反应时和正确率均未达到显著差异,且中性声音条件下对面孔性别判断有很短的反应时和很高的正确率,说明中性情绪声音对面孔性别信息的加工既无干扰也无促进。由此推论,面孔性别判断受声音情绪信息的影响,其背后的机制是情绪性别刻板印象。

声音情绪;面孔性别;跨通道;刻板印象

一、研究背景

生活中能够准确识别他人的性别和情绪是社交成功的前提。面孔性别与表情信息之间相互影响*AGUADO L,GARCIA-GUTIERREZ A,SERRANO-PEDRAZA I. Symmetrical interaction of sex and expression in face classification tasks[J]. Attention,perception and psychophysics,2009,71(1):9-25.*PIXTON T S. Happy to see me, aren’t you, Sally? Signal detection analysis of emotion detection in briefly presented male and female faces[J]. Scandinavian journal of psychology,2011,52(4):361.*VALDES-CONROY B,AGUADO L,CAHILL M F,et al. Following the time course of face gender and expression processing:a task-dependent ERP study[J]. International journal of psychophysiology,2014,92(2):59.。研究表明,被试更可能将一个生气表情的中性性别面孔判断为男性,将男性生气面孔判断为男性的速度快于将女性生气面孔判断为女性的速度*石荣. 哭泣表情面孔在识别和解离过程中的注意特征:来自眼动的证据[D]. 曲阜:曲阜师范大学,2016.*HESS U,ADAMS R B,GRAMMER K,et al. Face gender and emotion expression:are angry women more like men?[J]. Journal of vision 2009,9(12):1-8.*吴彬星,张智君,孙雨生. 面孔知觉中面孔性别与情绪表情的相互作用[J]. 心理科学进展, 2014, 22(6):943-952.。Hugenberg 和Sczesny发现,被试对女性面孔高兴表情的识别显著快于对女性面孔生气表情的识别*HUGENBERG K,SCZESNY S. On wonderful women and seeing smiles:social categorization moderates the happy face response latency advantage[J]. Social cognition,2006,24(5):516-539.。

促成面孔性别信息与表情信息交互作用的机制存在自下而上和自上而下两种假说。从自下而上的信息加工角度来看,男性面孔特征和愤怒表情特征存在重叠——男性的眉眼间距比女性的小,而人们生气时由于皱眉也使得眉眼间距变小;而对于笑的表情,眉眼间距得以展开,这与女性面孔特征更相似*蒋重清,王爽,王帅科,等. 对面孔刺激执行趋避任务时的性别效应[J]. 辽宁师范大学学报(社会科学版),2016,39(4):41-45.。当存在相似特征的性别信息和表情信息组合时则可能促进双方的加工*BECKER D V,KENRICK D T,NEUBERG S L,et al. The confounded nature of angry men and happy women[J]. Journal of personality and social psychology,2007,92(2):179.*SLEPIAN M L,WEISBUCH M,ADAMS R B,et al. Gender moderates the relationship between emotion and perceived gaze[J]. Emotion,2011,11(6):1439-1444.。对面孔性别和情绪的识别还涉及自上而下的加工,即受到社会认知定式的影响。调查研究发现,人们普遍认为男性更多表现出生气和自豪等情绪,女性更多表现出高兴和害羞等情绪,这种现象被称之为情绪性别刻板印象*PLANT E A,HYDE J S,KELTNER D,et al.The gender stereotyping of emotions[J]. Psychology of women quarterly,2000,24(1):81-92.。符合该刻板印象的表情与性别组合可以得到更快的加工。

当前对性别与表情信息交互作用的研究仅见于面孔知觉范畴,即性别信息与表情信息都来自于面孔知觉。在现实生活中,人们所接收的信息往往来自多个感觉通道, 如视通道、听通道等。当这些不同感觉通道的信息一致时,通常会相互促进加工,反之则相互干扰*MACLEO A,SUMMERFIEL Q. Quantifying the contribution of vision to speech perception in noise[J]. British journal audiology,2009, 21(2):131.*DE-GELDR B, VROOMEN J. The perception of emotions by ear and by eye[J]. Cognition and emotion,2000,14(3):289-311.*JOASSIN F,MAURAGE P,CAMPANELLA S.The neural network sustaining the cross model processing of human gender from faces and voices:an fMRI study[J]. Neuroimage,2010,54(2):1654-1661.*王苹,潘治辉,张立洁,等. 动态面孔和语音情绪信息的整合加工及神经生理机制[J]. 心理科学进展,2015,23(7):1109-1117.。这些跨通道感知觉的研究关注的主要也是不同通道下同一类信息之间的相互影响,至于对跨通道、跨信息之间的影响的研究较少。

本研究探讨的则是声音中的情绪信息对同时呈现的面孔图片中的性别信息加工的影响。由于这两种信息既跨通道又跨类型,它们之间没有物理特征上的相似性;但是情绪性别刻板印象认知定式应该还会发挥作用,因而,本研究可以直接考察该机制对于情绪与性别信息交互作用的影响。本研究假设:男性面孔匹配生气声音,面孔性别判断得到易化;女性面孔匹配高兴声音,面孔性别判断得到易化。

二、实验研究

(一)被试

选取32名在校大学生(男女各半),年龄在20~24岁之间,裸眼视力或矫正视力正常,色觉正常,双耳听力正常,无精神疾病。

(二)实验材料与仪器

本实验图片材料均选自中国情感面孔表情图片系统(Chinese Affective Face Picture System, CAFPS),选取表情中性(情绪认同度:M=84.04%,SD=7.822)的面孔图片60张(男女各半)。图片为黑白色,亮度、对比度和尺寸统一,去掉头发、耳朵、脖子等外部特征。选取大学生16名(男女各半),视力或矫正视力正常,双耳听力正常,要求其从面孔材料的性别维度上进行5点(1表示男性,5表示女性)等级评定,之后对男女面孔图片的性别评定结果分别与3进行单样本t检验,结果差异显著(p<0.01)。

声音材料均选自蒙特利尔情绪声音库(The Montreal Affective Voices, MAV)*BELIN P,FILLIONBILODEAU S,GOSSELIN F. The montreal affective voices:a validated set of nonverbal affect bursts for research on auditory affective processing[J]. Behavior research methods,2008,40(2):531-539.,选取高兴、生气、中性3种情绪声音各10个,共30个声音材料(男女各半),并将所有声音时长统一为500 ms。对声音情绪材料从性别维度上进行5点(1表示男性,5表示女性)等级评定,之后对男女声音材料的性别评定结果分别与3进行单样本t检验,结果差异显著(p<0.01)。另选取20名研究生,视力或矫正视力正常,双耳听力正常,要求其对声音情绪材料从情绪维度上进行7点(1表示高兴,7表示生气)等级评定,之后将高兴声音和生气声音分别与中性声音进行配对样本t检验,结果差异显著(p<0.01)。材料评定结果见表1。

表1 材料评定结果

实验材料使用17 英寸、刷新率为85Hz 的显示器呈现,采用E-prime 编制实验程序并收集数据*蒋重清,郭姗姗,刘丽莎,等. 面孔的表情信息优先于性别信息加工:来自直接比较的证据[J]. 心理科学,2016(5):1045-1050.。

(三)实验设计及流程

本实验为2(面孔性别:男、女)×4(声音情绪类别:高兴声音、生气声音、中性声音、无声)二因素被试内设计,因变量为面孔性别判断的反应时和正确率。控制声音性别信息这一变量,男性面孔配男性声音,女性面孔配女性声音。

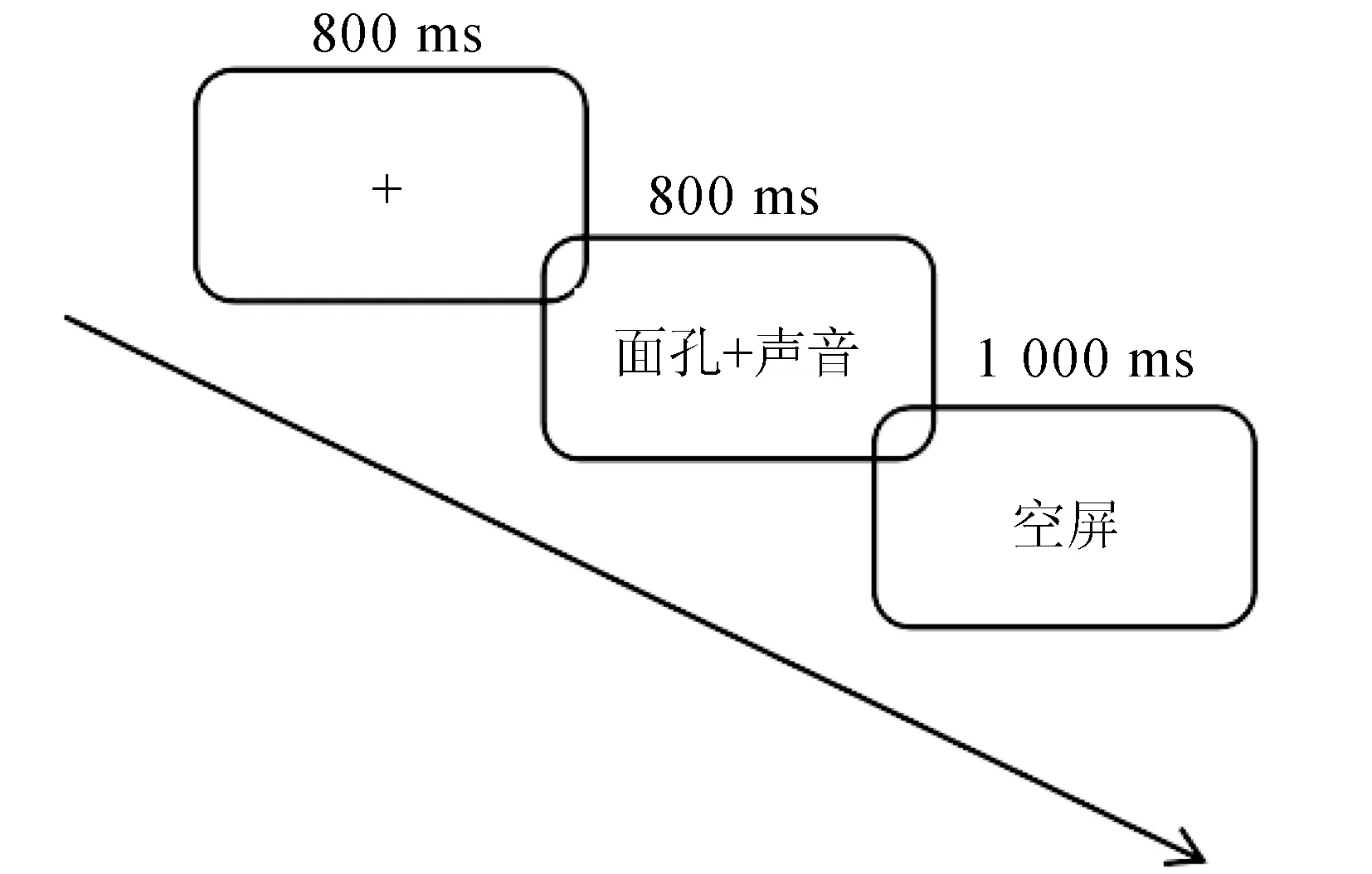

实验流程如图1 所示。实验中面孔和声音同时呈现,要求被试对面孔图片进行性别判断,按F和J键既快又准地做出反应,按键在被试间平衡。实验中每张图片和每个声音重复6次,共360个试次,单呈现面孔180个试次,呈现面孔—声音对儿180个试次,其中高兴面孔—声音对儿、生气面孔—声音对儿、中性面孔—声音对儿各60个试次。

图1 实验流程图

三、结 果

根据实验设计分别以反应时和正确率为因变量,以面孔性别、声音情绪类别为被试内因素,用SPSS16.0进行重复测量方差分析,若不符合球形检验假设则采用Greenhouse-Geisser对自由度进行矫正。

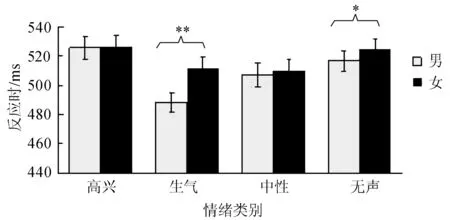

对反应时进行重复测量方差分析,结果表明:声音情绪类别的主效应显著,F(2.42,74.87) =10.45,p<0.01,偏η2=0.25;面孔性别主效应显著,F(1,31)=16.87,p<0.01, 偏η2=0.35,对男性面孔性别判断的反应时均短于对女性面孔性别判断的反应时;声音情绪类别和面孔性别的交互作用显著,F(3,93)=6.71,p<0.01, 偏η2=0.18。

对声音情绪类别和面孔性别的交互作用进行简单效应分析,结果表明,生气声音条件下对男性面孔性别判断的反应时显著短于对女性面孔性别判断的反应时(p<0.01),无声条件下对男性面孔性别判断的反应时显著短于对女性面孔性别判断的反应时(p<0.05),其他未见显著,见图2。进一步对生气声音条件下男女面孔性别判断的反应时差异与无声条件下男女面孔性别判断的反应时差异进行配对样本t检验,结果显示,生气声音条件下男女面孔性别判断的反应时差异显著大于无声条件下的反应时差异,t=2.75,df=31,p=0.01。

图2 四种声音条件下面孔性别判断的反应时比较

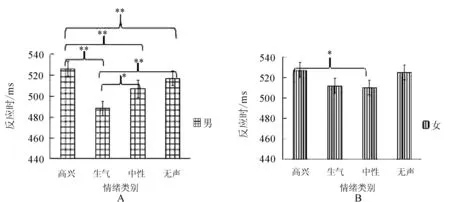

针对声音情绪类别主效应做进一步的多重比较分析,结果表明:被试对男性面孔图片进行判断时,生气声音条件下的反应时显著短于高兴声音条件下的反应时(p<0.01);中性声音条件下的反应时显著

短于高兴声音条件下的反应时(p<0.01);生气声音条件下的反应时显著短于中性声音条件下的反应时(p<0.05);生气声音条件下的反应时显著短于无声条件下的反应时(p<0.01);无声条件下的反应时显著短于高兴声音条件下的反应时(p<0.01)。其他未见显著,见图3A。被试对女性面孔图片进行判断时,生气声音条件下的反应时短于高兴声音条件下的反应时(p= 0.051);中性声音条件下的反应时显著短于高兴声音条件下的反应时(p<0.05),其他未见显著,见图3B。

图3 判断面孔性别时四种声音条件之间的反应时比较

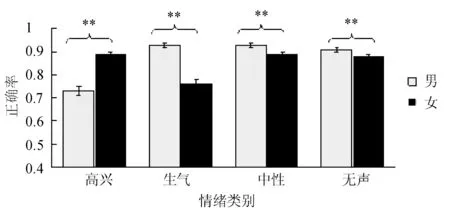

对正确率进行重复测量方差分析,结果表明:声音情绪类别的主效应显著,F(3,93) =24.31,p<0.01,偏η2=0.44;面孔性别主效应显著,F(1,31)=23.01,p<0.01,偏η2=0.42,对男性面孔性别判断的正确率高于对女性面孔性别判断的正确率;声音情绪类别和面孔性别的交互作用显著,F(1.67,51.7)=41.23,p<0.01,偏η2= 0.57。

对声音情绪类别和面孔性别的交互作用进行简单效应分析,结果表明:高兴声音条件下对女性面孔性别判断的正确率显著高于对男性面孔性别判断的正确率(p<0.01);生气声音条件下对男性面孔性别判断的正确率显著高于对女性面孔性别判断的正确率(p<0.01);中性声音条件下对男性面孔性别判断的正确率显著高于对女性面孔性别判断的正确率(p<0.01);无声条件下对男性面孔性别判断的正确率显著高于对女性面孔性别判断的正确率(p<0.01),见图4。进一步对4种声音条件下男女面孔性别判断的正确率差异进行多重比较分析,结果显示:高兴声音条件下对男女面孔性别判断的正确率差异显著大于中性和无声条件下的差异(p<0.05);生气声音条件下对男女面孔性别判断的正确率差异显著大于中性和无声条件下的差异(p<0.01)。

针对声音情绪类别主效应做进一步的多重比较分析,结果表明:被试对男性面孔图片进行判断时,生气声音条件下的正确率显著高于高兴声音条件下的正确率(p<0.01);中性声音条件下的正确率显著高于高兴声音条件下的正确率(p<0.01);无声条件下的正确率显著高于高兴声音条件下的正确率(p<0.01)。其他未见显著,见图5C。被试对女性面孔图片进行判断时,高兴声音条件下的正确率显著高于生气声音条件下的正确率(p<0.01);中性声音条件下的正确率显著高于生气声音条件下的正确率(p<0.01);无声条件下的正确率显著高于生气声音条件下的正确率(p<0.01)。其他未见显著,见图5D。

图4 四种声音条件下面孔性别判断的正确率比较

四、讨 论

在高兴声音、生气声音、中性声音和无声4种条件下,同时呈现面孔图片,要求被试对图片中的性别信息做出判断,探讨声音情绪对面孔性别信息加工的影响。结果表明:在生气声音条件下,被试对男性面孔判断的反应时显著短于对女性面孔性别判断的反应时,而且被试对男性面孔判断的正确率也显著高于对女性面孔性别判断的正确率;在高兴声音条件下,对女性面孔性别判断的正确率显著高于对男性面孔性别判断的正确率。结果还揭示了在生气声音条件下对男女面孔性别判断的反应时差异显著大于无声条件下的反应时差异,在高兴和生气声音条件下对男女面孔性别判断的正确率差异显著大于中性和无声条件下的正确率差异,这进一步表明声音情绪信息对面孔性别信息加工的影响。

该研究结果与以往的关于面部表情影响面孔性别识别的研究结果一致*BECKER D V,KENRICK D T,NEUBERG S L,et al. The confounded nature of angry men and happy women[J]. Journal of personality and social psychology,2007,92(2):179.*HESS U,ADAMS R B,GRAMMER K,et al. Face gender and emotion expression:are angry women more like men?[J]. Journal of vision 2009,9(12):1-8.*SLEPIAN M L,WEISBUCH M,ADAMS R B,et al. Gender moderates the relationship between emotion and perceived gaze[J]. Emotion,2011,11(6):1439-1444.。由于声音情绪与性别信息既跨通道又跨类型,因而不适合用面孔知觉中情绪与性别信息交互作用的自下而上机制解释,而更适合用情绪性别刻板印象认知定式来说明,即人们倾向于认为女性更多表现出高兴情绪而男性更多表现出生气情绪*PRENTICE D A,CARRANZA E. Sustaining cultural beliefs in the face of their violation:the case of gender stereotypes[M]∥SCHALLER M,CRANDALL C S. The psychological foundations of culture. Mahwah NJ:Lawrence Erlbaum associates, Inc, 2004:259-278.,这符合人们的认知定式,并使其得到快速加工。

不过,结果还揭示了在判断女性面孔时,高兴声音条件下的反应时却长于生气声音条件下的反应时,这与Hugenberg 等人关于面部表情影响面孔性别识别的研究,即对女性高兴表情的识别显著快于对女性生气表情的识别这一结果不一致*HUGENBERG K,SCZESNY S. On wonderful women and seeing smiles:social categorization moderates the happy face response latency advantage[J]. Social cognition,2006,24(5):516-539.,也与其正确率结论相悖。原因可能是在这种跨通道的设计下,被试的判断不再受面孔特征信息的影响,而生气声音作为可能的危险信号容易引起被试警觉*IKEDA K,SUGIURA A,HASEGAWA T. Fearful faces grab attention in the absence of late affective cortical responses[J]. Psychophysiology,2013,50(1):60-69.,因此加速了对生气条件下女性面孔的反应。而在生气声音条件下被试对女性面孔反应的正确率显著低于高兴声音条件下的正确率,原因可能在于这不仅受情绪刻板印象的影响,还有可能受到反应速度—准确性的制衡。

此外,因男女面孔均为中性表情图片,故此,仅就有声(中性声音)和无声进行比较。无声条件和中性声音条件下对男女面孔图片性别判断的反应时和正确率均未达到显著差异,说明不论有无匹配中性声音均不影响对面孔性别信息的加工。Stevenage等的启动研究表明,面孔可以启动对声音的认知,但声音却不能启动对面孔的认知,说明二者的影响具有不对称性*STEVENAGE S V, HUGILL A R, LEWIS H G. Integrating voice recognition into models of person perception[J]. Journal of cognitive psychology,2012,24(4):409-419.。这也进一步揭示了“是声音中携带的情绪信息对面孔性别判断产生了影响”这一现象。

五、结 论

综上,在生气声音条件下,对男性面孔性别判断得到易化;在高兴声音条件下,对女性面孔性别判断得到易化。表现在反应时结果上,生气声音条件下对男性面孔性别判断的反应时显著短于对女性面孔性别判断的反应时。表现在正确率结果上,高兴声音条件下对女性面孔性别判断的正确率显著高于对男性面孔性别判断的正确率;生气声音条件下对男性面孔性别判断的正确率显著高于对女性面孔性别判断的正确率;无声和中性声音条件下对面孔性别判断的反应时和正确率均未达到显著差异,且中性声音条件下对面孔性别判断有很短的反应时以及很高的正确率,说明中性情绪声音对面孔性别信息的加工既无干扰也无促进。由此推论,声音情绪同面部表情一样可以影响面孔性别判断;声音情绪携带着性别标签,其背后的机制在于情绪性别刻板印象。

〔责任编辑:张秀红〕

The influence of voice emotion on face gender information processing

Jiang Zhongqing1,2, Guo Shanshan1, Zhang Xi’e1, Li Dong1,Pairidai·Apudukaiyoumu1, Tang Xiaoyu1

(1.School of Psychological Science, Liaoning Normal University, Dalian 116029, China;2.Liaoning Collaborative Innovation Center of Children and Adolescents Healthy Personality Assessment and Cultivation, Dalian 116029, China)

In order to explore how the voice emotion influence the gender information processing participants were asked to judge the gender of faces(neutral expression) under four types of sound conditions: happy, angry, neutral and silent. The results showed that the reaction time(RT) for male faces was significantly shorter as well as the accuracy(ACC) for male faces was significantly higher than that of the female faces under the angry voice condition. The accuracy of female faces was significantly higher than that of male faces under the condition of happy voice. The RT and the ACC of the face gender recognition were not significantly under silent voice condition and neutral voice condition.It showed that the processing of face gender information is not modulated by the neutral voice.So we conclude that face gender recognition is influenced by emotional information of voice and its mechanism is the emotional gender stereotype.

voice emotion;facial gender;cross-modal;stereotype

10.16216/j.cnki.lsxbwk.201705001

2017-03-07

:国家自然科学基金项目“情绪启动与语义启动的发展认知神经机制比较”(31271107);教育部人文社会科学研究青年基金项目“情绪启动与语义启动的直接而系统性实验比较”(11YJC190010)

蒋重清(1973-),男,湖南新宁人,辽宁师范大学教授,博士,主要从事认知神经科学研究。

B842.1

:A

:1000-1751(2017)05-0001-06