深度强化学习在地形自适应运动技能上的应用

2017-07-10刘仕超

刘仕超

摘 要:强化学习为开发模拟特性技能提供了一种很有效的方法,但强化学习通常需要稀疏手动的来获取特征。依赖于深度强化学习,我们引进了动作-评价和专家学习混合的学习方法(MACE)来学习动态地形自适应技能,把高纬度状态和地形描述作为该方法的输入,参数化的跳跃或行走作为输出动作。MACE方法比单一的动作-评价方法的学习效率更快,从而使动作-评价和专家学习变得更具独特性。

关键词:深度强化学习;地形自适应;卷积神经网络

人和动物在环境中优雅敏捷的运动,在动画片中,动物的动作通常是在熟练的动画片制造者和捕获到的动作数据的帮助下创造出来的。从基本原理出发,应用强化学习和基于物理特性的仿真,呈现出了研发不同种类运动技能的美好前景。这需要通过一个连续的决策问题,涉及状态,动作,奖励和控制决策的镜头看问题。给定当前状态的特性,作为捕获的状态,控制策略决定采取最佳动作,从而导致随后的状态,以及奖励发生改变。控制决策的目的是最大限度地提高预期的未来回报,即,任何直接的奖励以及所有预期的回报。

本文应用深度神经网络与强化学习相结合的方式来解决上述问题。在运动技能领域,我们应用控制结构建立设计动作参数的预期工作。强化学习过程中,值函数或者动作-值函数已经作为导向函数应用于动作的合成上,基于深度神经网络的控制策略已经能够借助可微神经网络来控制动作。

1 原理

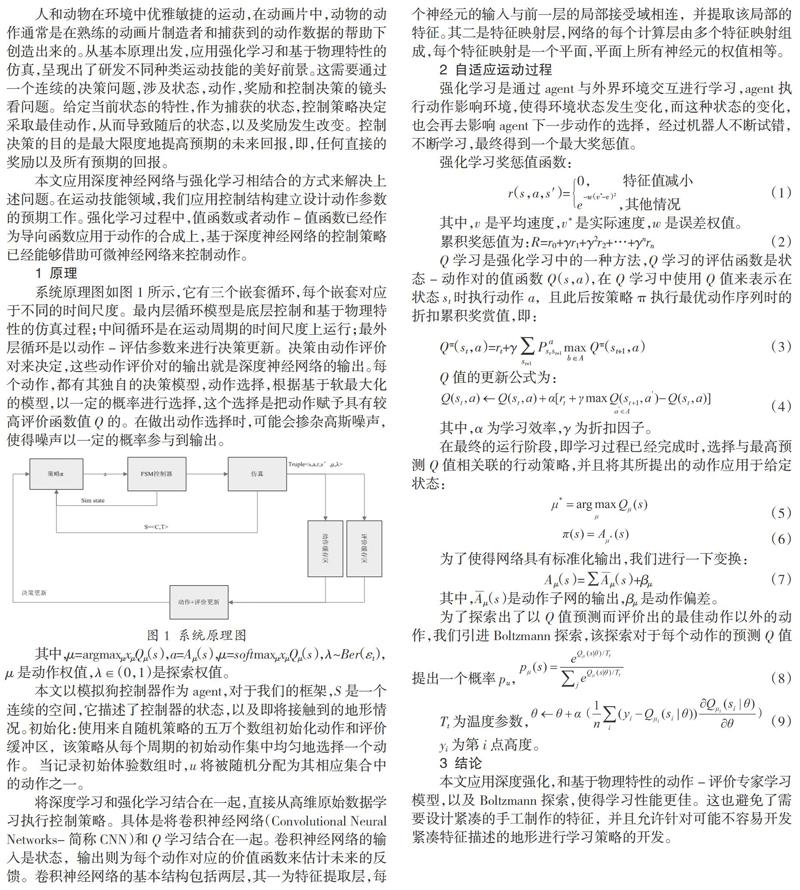

系統原理图如图1所示,它有三个嵌套循环,每个嵌套对应于不同的时间尺度。最内层循环模型是底层控制和基于物理特性的仿真过程;中间循环是在运动周期的时间尺度上运行;最外层循环是以动作-评估参数来进行决策更新。决策由动作评价对来决定,这些动作评价对的输出就是深度神经网络的输出。每个动作,都有其独自的决策模型,动作选择,根据基于软最大化的模型,以一定的概率进行选择,这个选择是把动作赋予具有较高评价函数值Q的。在做出动作选择时,可能会掺杂高斯噪声,使得噪声以一定的概率参与到输出。

3 结论

本文应用深度强化,和基于物理特性的动作-评价专家学习模型,以及Boltzmann探索,使得学习性能更佳。这也避免了需要设计紧凑的手工制作的特征,并且允许针对可能不容易开发紧凑特征描述的地形进行学习策略的开发。

参考文献:

[1] COROS, S., BEAUDOIN, P., YIN, K.K., AND VAN DE PANNE,M.2008.Synthesis of constrained walking skills.ACM Trans. Graph.27,5,Article 113.

[2] COROS, S., BEAUDOIN,P.,AND VAN DE PANNE,M.2010. Generalized biped walking control. ACM Transctions on Graphics 29,4,Article 130.

[3] HAUSKNECHT,M.,AND STONE,P.2015.Deep reinforcement learning in parameterized action space. arXiv preprint arXiv:1511.04143.

[4] HESTER, T., AND STONE, P.2013.Texplore: real-time sampleefficient reinforcement learning for robots. Machine Learning 90,3,385-429.

[5] LEE, Y., KIM, S., AND LEE, J. 2010.Data-driven biped control.ACM Transctions on Graphics 29,4,Article 129.