自适应模态选择的鲁棒目标跟踪方法*

2017-06-15李昌,宋杰

李 昌,宋 杰

安徽大学 计算机科学与技术学院,合肥 230601

自适应模态选择的鲁棒目标跟踪方法*

李 昌+,宋 杰

安徽大学 计算机科学与技术学院,合肥 230601

LI Chang,SONG Jie.Robust object tracking method via adaptive modality selection.Journal of Frontiers of Computer Science and Technology,2017,11(6):998-1005.

在多模态跟踪过程中,为了避免低质量模态的噪声影响和提高跟踪方法的效率,提出了一种基于自适应模态选择的目标跟踪方法,能够选择较好的模态进行跟踪。具体地,对于每个模态,使用聚类方法将目标区域及其周围背景区域各聚为若干个子类,然后通过它们子类之间的特征差异衡量目标和周围背景的判别性(即模态质量),选择判别性最大的模态对目标使用相关性滤波算法进行跟踪。同时,为了维持各个模态的目标模型的有效性,提出了一种双阈值策略更新选择和未被选择模态的跟踪模型。在7组热红外和可见光视频对上进行了实验,验证了该方法的有效性,且跟踪速度达到141 f/s。

模态选择;自适应跟踪;实时处理;热红外信息

1 引言

视觉跟踪(通常又称为单目标跟踪,本文简称为目标跟踪)作为一个经典、热门的计算机视觉问题,在过去的十几年里取得了很大的研究进展。它被广泛地应用于许多领域,如视频监控、人机交互、无人驾驶等,具有较大的研究价值和应用价值。但是由于存在许多具有挑战性的环境因素,比如低照度、雾霾、恶劣天气等,使得仅依赖于可见光成像的跟踪算法性能低下,甚至失效,极大地限制了视觉跟踪的应用范围。因此,极端环境下的视觉跟踪研究是必要的和迫切的。

本文通过引入热红外信息来弥补可见光信息在这方面的不足。热红外传感器通过热辐射成像,即图像反映了物体表面的温度分布,由于其对光照不敏感,同时对雾霾等穿透能力较强,能够很好地克服低照度或零照度、雾霾、恶劣天气等影响。另一方面,当热红外遇到“热交叉现象”(目标与其他物体或背景具有相似的温度)时,可见光模态能够通过颜色信息较好地区分目标和背景。因此,本文在多模态视频中通过一种利用判别性准则自适应地跟踪目标,实现恶劣环境下的稳健、持续跟踪。

单模态的目标跟踪已经被广泛地研究,许多机器学习方法在目标跟踪中都得到了成功的应用,如SVM(support vector machine)[1-3]、稀疏表示[4-6]、相关滤波[7-9]等。然而,多模态跟踪方法的研究相对较少,Bunyak等人在文献[10]中构建了一个运动目标检测和跟踪系统,该系统能够在一个框架内完成可见光和红外视频融合。Conaire等人在文献[11]中提出了一种能够有效地结合各种特征的框架进行鲁棒的目标跟踪,又在文献[12]中评价了多种融合机制的外观模型的跟踪效果。文献[13]提出了一种融合可见光和红外视频的行人跟踪系统,提出了基于背景建模的概率模型,然后根据此模型,将行人跟踪的问题转换为粒子滤波的问题。然而这种简单的融合,会产生一些副作用,如质量较差的模态会带来一定的噪声影响,使得最终的结果受到影响,容易导致目标模型的偏移问题。

为了克服以上问题,本文提出了一种简单有效的基于自适应模态选择的多模态目标跟踪方法,能够根据模态的判别性来自适应地选择可靠的模态,并使用KCF(kernelized correlation filter)[14]算法进行跟踪。本文通过目标与周围背景的特征差异来衡量模态的判别性,在线地选择判别性大(较可靠)的模态使用KCF进行跟踪,以此避免不可靠模态带来的噪声影响,同时只使用一个模态跟踪也会提高跟踪的效率。为了使得各个模态的跟踪模型能够及时更新,以适应目标外观的变化,同时尽可能减少噪声影响,本文提出了一种新的双阈值的更新策略,有效地更新目标模型。在公共的以及本文收集的视频序列对上进行了实验,结果表明,本文方法能够稳健、持续地跟踪恶劣环境下的目标,且跟踪速度达到141 f/s。

2 KCF跟踪算法简介

最近,KCF跟踪算法[14]在视觉跟踪领域因其较高的运算效率和跟踪精度,在公共跟踪数据集上平均精度可达73.2%,且运行速度达到172 f/s。这种基于tracking-by-detection的算法同时可以在一定程度上对目标的遮挡和光照变化等干扰因素具有抑制作用,引起了学者们的广泛研究。本文在KCF跟踪算法的基础上进行跟踪,保留了其高效的优势,于此同时,结合多模态视频,鲁棒地选择质量较好的视频进行跟踪,使得跟踪的结果更加可靠、精确。

KCF跟踪算法根据目标所在的位置,以目标窗口为中心,进行目标图像块的提取。与传统随机采样的方式不同,KCF跟踪算法采样时,考虑了所有的循环移位的情况,即xm,n,(m,n)∈{0,1,…,M-1}×{0,1,…,N-1}作为训练样本。现在举一个一维的例子来说明什么是循环位移。假设有一维的数据x=[x1,x2,…,xn],x的一个循环移位为Px=[xn,x1,x2,…,xn],那么所有的循环移位为可以组成一个循环矩阵X=C(x)。所有的循环矩阵都可以做如下的分解:

其中,F是常量矩阵,被称为离散傅里叶变换(discrete Fourier transform,DFT)矩阵,FH表示F的共轭转置。循环矩阵的分解可以用来大大地简化线性回归的求解。

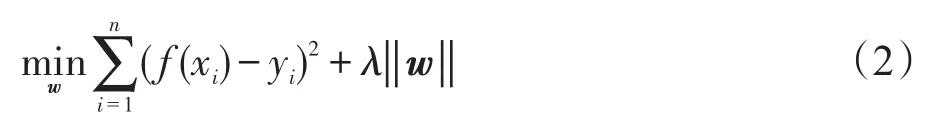

线性岭回归的目标函数可以表示为:

其中,f(xi)可以看作基础样本的线性组合,即f(x)=wTx可以得到岭回归的闭合解:

将式(1)代入式(3)可得:

其中,表示x转化到傅里叶域进行运算的结果;表示的复共轭。

在非线性情况下,KCF跟踪算法用到了核技巧,即:

循环矩阵的技巧也可以应用到大部分经常使用的核函数中。因此,对偶空间的解∂可以表示为:

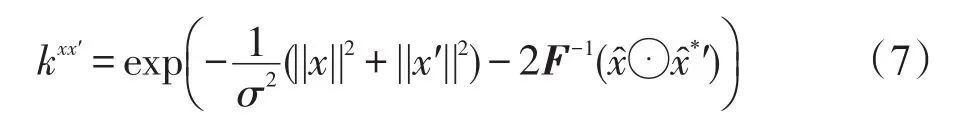

其中,κxx定义为核相关。本文采用高斯核进行相关的运算,即:

循环矩阵的技巧也可以应用到整个跟踪流程中的检测环节以提升整体的速度。相同位置的目标块在下一帧仍然作为基样本(base sample)来计算傅里叶域的响应值:

在将f(z)转换到空域后,最大响应值对应的位置即为所要跟踪的目标所在的位置。

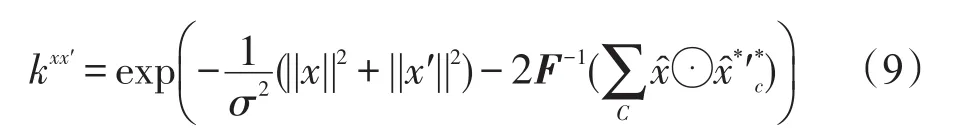

以上所涉及的都是单通道的KCF跟踪算法,为了能够应用各种特征,如HOG等,使得跟踪算法更加鲁棒,从而进一步提升跟踪的精度,作者将其扩展为多通道的KCF跟踪算法。由于上面所涉及的核是基于参数的点积或范数,点积运算可以通过分别将每一个通道的点积相加来实现。又由于离散的傅里叶转换是线性的,允许对每个通道的点积通过简单的相加来实现:

以上是对KCF跟踪算法的简要介绍,想要更加深入地了解,请查阅文献[14]。

3 基于自适应模态选择的目标跟踪方法

3.1 模态可靠性计算

给定空间上、时序上对齐的多模态视频序列,本文的目标是根据各自模态的判别性选择较为可靠的模态进行目标跟踪。这种做法是在跟踪过程中考虑以下两方面:一方面是能够利用较可靠的信息;另一方面是避免不可靠模态中的噪声干扰。为此,本文根据目标与周围背景的特征差异定义模态的判别性作为其跟踪可靠性的度量,即判别性大的模态越容易区分目标和背景,其可靠性就越大,反之,其可靠性越小。下面具体介绍模态可靠性的计算。

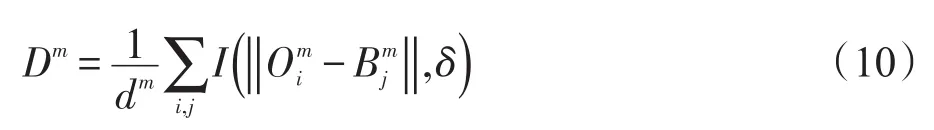

不失一般性,假设有M个模态(本文M=2),对于第m个模态,本文通过目标与周围背景的特征差异计算该模态的判别性,即特征差异越大,判别性越大,反之,判别性越小。给定初始的(第一帧)或跟踪的(其他帧)目标矩形框,计算目标的外观特征Om,同时计算目标周围区域背景的外观特征Bm,如图1所示。在实验中,取扩展的背景区域的长、宽为目标区域的长、宽的两倍。本文把目标区域和背景区域的像素均使用K-Means算法[15]聚为K类,然后通过它们子类的特征差异计算目标与周围背景的判别性,这样能够更好地表达它们之间的区别。如图1所示,采用K-Means聚类的方法,把前景区域和背景区域都聚为K类(本图实例为2类),前景区域(绿色矩形框)包括区域1和区域2,背景区域(黄色矩形框)被聚为区域3和区域4,可以看出,利用前景区域子类(区域1和区域2)的特征可以更好地表达其与背景区域的判别性。

Fig.1 Division of image area图1 区域划分

本文方法流程图如图2所示。

记O为目标的第i个子类的特征表示为背景的第j个子类的特征表示,其中i,j=1,2,…,K,则第m个模态的目标和周围背景的可靠性定义如下:

从式(11)可以看出,目标与周围背景之间的可靠性由它们子类之间的大于一定阈值的特征差异的均值来表示,这样更能准确地表达它们之间的判别性。对于每个模态,均通过这种计算方式得到对应的可靠性,然后选择较为可靠的模态作为当前帧的跟踪方法的输入,即选择的模态为

3.2 基于可靠模态的目标跟踪

目前,很多性能较好的跟踪算法相继被提出,有的侧重于跟踪精度[16],有的侧重于跟踪效率[17]。本文选取在精度和效率上均取得较好表现的KCF算法[14]对以上选择的可靠模态m*进行跟踪,得到最终的结果。

值得注意的是,跟踪过程中目标模型的更新是至关重要的。传统的方法是根据跟踪的结果与目标模型的相似程度来决定当前结果是否更新目标模型。而在本文中,可以根据模态的可靠性来更有效地指导模态的更新。然而,不同的模态可靠性是在变化的,即跟踪过程中选择的模态也有可能是变化的,这就需要一种有效的更新方法,使得每个模态的目标模型能够得到及时的更新,来适应目标外观的变化,同时也需要避免不可靠模态的噪声干扰。为此,本文提出一种简单的双阈值的更新策略,实现各个模态的目标模型的有效更新,避免噪声的干扰,即:

Fig.2 Flow chart of method proposed in this paper图2 本文方法的流程图

(2)若m≠m*,且Dm≥δ2,则更新模态m的目标模型,否则,不更新。

其中,δ1和δ2是预设的两个阈值,且δ1<δ2,表示选择模态的目标模型更容易被更新。当跟踪方法选择某个很多帧未被选择的模态时,这样的更新方式能够使得该模态具有较新的目标模型。同时,通过双阈值的方式,尽可能地避免不可靠模态的噪声影响。

4 实验结果与分析

本文实验所用的平台为桌面台式机:CPU i7 4 790,RAM 16 GB,显卡GTX980。在所提供的7个具有挑战性的多模态视频上进行了实验,并且和3种鲁棒的跟踪算法,即CN[18]、ECST[17]、KCF[14],进行了对比,充分地验证了本文算法的有效性。

如表1所示,通过自己拍摄的,然后手动对齐的7组视频具有以下特点:(1)多个场景,充分考虑到光照的变化、阴影、夜间监控等外界干扰因素的影响。同一场景,考虑到不同时间段对目标跟踪的影响。(2)考虑到跟踪目标的尺寸和外形的变化对跟踪结果的影响。

Table 1 Summary of data sets表1 实验数据信息

4.1 参数设置

实验中的核函数本文选择高斯核,高斯核的带宽δ=0.2,对于一个m×n的目标,其空间带宽s=更新的内插因子为0.075。在实验中,简单地将目标的色彩聚类为两类,以检验所提出的根据目标和背景之间最大的颜色差异性来表示清晰度的有效性。

4.2 评价标准

本文采用了两个广泛应用的衡量标准,精度分数(precision score)和成功覆盖率(success plot)来衡量算法的精度。

精度分数:中心位置误差(center position error)是算法跟踪结果窗口和真值窗口中心位置之间的欧氏距离,经常被用来度量跟踪的精度。然而,当跟踪失败时,这种度量方式显然是不合理的。为了更加有效地衡量整体的表现,采用了最近经常被使用的精度分数。由于目标相对较小,本文设置阈值为5个像素值,以得到具有代表性的精度分数。

成功覆盖率:用来衡量跟踪算法的稳定性,表示跟踪结果对应的跟踪框ro和真实目标跟踪框rg的重叠比例。重叠分数的定义为其中⋂和⋃代表两个区域的交和并,|∙|表示区域中像素的个数。

4.3 定量分析

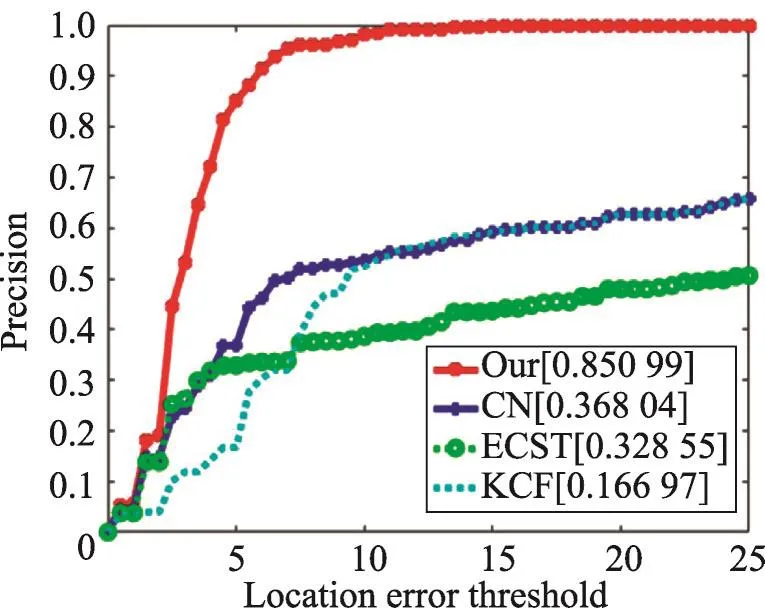

ECST算法也是基于相关滤波发展而来的跟踪算法,然而由于其未能结合红外视频,仅对可见光视频进行处理,显然达不到所要求的效果。KCF跟踪算法可以看作是对ECST算法做了进一步的拓展,使得跟踪的结果更加精确和鲁棒。从图3和图4中也可以看出,相比于KCF算法,CN算法由于结合了可见光视频的色彩信息,并采用了新颖的降维方法,使得保留高效率的同时,可以得到更高的精度。本文算法由于实现了根据模态质量选择较好模态视频进行跟踪的机制,所取得的精度分数和成功覆盖率都远远大于几个对比算法,这也充分说明了结合可见光和红外视频进行全天时鲁棒的目标跟踪的必要性和有效性。

Fig.3 Comparison of precision score图3 精度分数对比

Fig.4 Comparison of success plot图4 成功覆盖率对比

4.4 定性分析

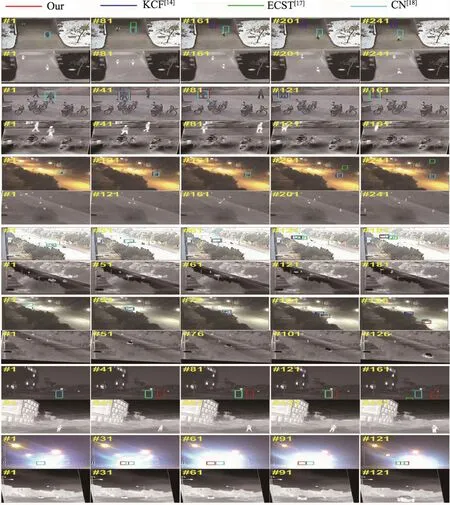

Fig.5 Comparison of tracking results图5 跟踪结果对比

从图5中可以看出,本文算法结合了红外和可见光的信息后,对各种干扰的抑制能力明显增强。从第一组和第六组视频可以看出,在红外视频的协助下,本文算法在低照度环境下也可以进行有效的跟踪。能够进行全天时全天候的目标跟踪在现实监控场景中是非常必要的,而本文提出的多模态跟踪算法可以较好地做到这一点。从第五组视频可以看出,根据模态质量可以智能切换的多模态跟踪算法对部分遮挡也具有一定的鲁棒性。值得注意的是,KCF跟踪算法由于视频质量问题导致跟踪运动的车辆失效了。最后一组视频是由于汽车远光灯导致的目标几乎失效的情况,在这种场景下,几乎所有的跟踪算法都会跟踪失败,而本文多模态跟踪算法依然可以准确地定位运动的汽车,这也充分体现了结合红外视频进行多模态跟踪的必要性和有效性。

4.5 效率分析

跟踪算法的效率也是评价算法优劣的重要指标,这里列出了本文算法和对比算法的效率,如表2所示。从表中可以看出,本文所涉及的几个跟踪算法的效率都是非常高的,本文算法也达到了140.76 f/s,这远远超过了实际监控场景下实时的要求。但是,本文算法的精度远远好于对比算法,达到了较好的精度和效率的平衡,可以实际应用到各种监控场景下,从而实现了全天时的运动目标跟踪。

Table 2 Efficiency of algorithms表2 算法效率

5 结束语

本文提出了一种自适应模态选择算法,能够有效地选择可靠模态的视频进行目标跟踪,较好地解决了直接将可见光和红外视频进行融合而引入的噪声问题。在跟踪过程中,使用双阈值策略更新每个模态的目标模型,以保持模型的有效性。本文在提供的7组多模态视频上进行了实验,验证了本文方法的有效性和高效性。在未来的工作中,研究更鲁棒的多模态选择算法,同时扩充多模态视频,构建一个更全面、标准的多模态跟踪评测平台。

[1]Bai Yancheng,Tang Ming.Robust tracking via weakly supervised ranking SVM[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition,Providence,USA,Jun 16-21,2012.Washington:IEEE Computer Society,2012:1854-1861.

[2]Yin Yingjie,Xu De,Wang Xingang,et al.Online state-based structured SVM combined with incremental PCA for robust visual tracking[J].IEEE Transactions on Cybernetics,2015, 45(9):1988-2000.

[3]Zhang Jianming,Ma Shugao,Sclaroff S.MEEM:robust tracking via multiple experts using entropy minimization [C]//LNCS 8694:Proceedings of the 13th European Conference on Computer Vision,Zurich,Switzerland,Sep 6-12,2014. Berlin,Heidelberg:Springer,2014:188-203.

[4]Avidan S.Ensemble tracking[J].IEEE Transactions on PatternAnalysis and Machine Intelligence,2007,29(2):261-271.

[5]Babenko B,Yang M H,Belongie S.Robust object tracking with online multiple instance learning[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33(8): 1619-1632.

[6]Grabner H,Leistner C,Bischof H.Semi-supervised online boosting for robust tracking[C]//LNCS 5302:Proceedings of the 10th European Conference on Computer Vision,Marseille,France,Oct 12-18,2008.Berlin,Heidelberg:Springer, 2010:234-247.

[7]Mei Xue,Ling Haibin.Robust visual tracking usingl1minimization[C]//Proceedings of the 12th International Conference on Computer Vision,Kyoto,Japan,Sep 29-Oct 2,2009. Piscataway,USA:IEEE,2009:1436-1443.

[8]Zhang Tianzhu,Ghanem B,Liu Si,et al.Robust visual tracking via multi-task sparse learning[C]//Proceedings of the 2012 Conference on Computer Vision and Pattern Recognition,Providence,USA,Jun 16-21,2012.Piscataway, USA:IEEE,2012:2042-2049

[9]Bao Chenglong,Wu Yi,Ling Haibin,et al.Real time robust L1 tracker using accelerated proximal gradient approach [C]//Proceedings of the 2012 Conference on Computer Vision and Pattern Recognition,Providence,USA,Jun 16-21, 2012.Piscataway,USA:IEEE,2012:1830-1837.

[10]Bunyak F,Palaniappan K,Nath S K,et al.Geodesic active contour based fusion of visible and infrared video for persistent object tracking[C]//Proceedings of the 8th IEEE Workshop on Applications of Computer Vision,Austin,USA,Feb 21-22,2007.Washington:IEEE Computer Society,2007:35.

[11]Conaire C Ó,OƳConnor N E,Cooke E,et al.Comparison of fusion methods for thermo-visual surveillance tracking[C]// Proceedings of the 9th International Conference on Information Fusion,Florence,Italy,Jul 10-13,2006.Piscataway, USA:IEEE,2006:413-419.

[12]Conaire C Ó,OƳConnor N E,Smeaton A.Thermo-visual feature fusion for object tracking using multiple spatiogram trackers[J].Machine Vision and Applications,2008,19(5/6): 483-494.

[13]Leykin A,Hammoud R.Pedestrian tracking by fusion of thermal-visible surveillance videos[J].Machine Vision and Applications,2010,21(4):587-595.

[14]Henriques J F,Caseiro R,Martin P,et al.High-speed tracking with kernelized correlation filters[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(3): 583-596.

[15]Kanungo T,Mount D M,Netanyahu N S,et al.An efficientk-means clustering algorithm:analysis and implementation [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2002,24(7):881-892.

[16]Hare S,Saffari A,Torr P H S.Struck:structured output tracking with kernels[C]//Proceedings of the 2011 International Conference on Computer Vision,Barcelona,Spain, Nov 6-13,2011.Piscataway,USA:IEEE,2011:263-270.

[17]Henriques J F,Caseiro R,Martins P,et al.Exploiting the circulant structure of tracking-by-detection with kernels[C]// LNCS 7575:Proceedings of the 12th European Conference on Computer Vision,Florence,Italy,Oct 7-13,2012.Berlin,Heidelberg:Springer,2012:702-715.

[18]Danelljan M,Khan F S,Felsberg M,et al.Adaptive color attributes for real-time visual tracking[C]//Proceedings of the 2014 Conference on Computer Vision and Pattern Recognition,Columbus,USA,Jun 23-28,2014.Washington:IEEE Computer Society,2014:1090-1097.

LI Chang was born in 1990.He is an M.S.candidate at Anhui University.His research interests include embedded system and intelligent computing,etc.

李昌(1990—),男,安徽安庆人,安徽大学硕士研究生,主要研究领域为嵌入式系统,智能计算等。

宋杰(1966—),男,2006年于安徽大学获得博士学位,现为安徽大学副教授,CCF会员,主要研究领域为嵌入式系统,智能计算,生物信息学等。

Robust Object Tracking Method viaAdaptive Modality Selection*

LI Chang+,SONG Jie

School of Computer Science and Technology,Anhui University,Hefei 230601,China

+Corresponding author:E-mail:798110946@qq.com

To alleviate the noises of low quality modalities and improve the efficiency in multimodal object tracking, this paper proposes an adaptive modal selection based method to effectively select most reliable modality to track object.Specifically,for each modal,the clustering algorithm is utilized to divide the object region and its surrounding background region into several sub-clusters,and then the discriminative ability between object and background, which measures the modal quality,is computed by the feature difference between their respective sub-clusters.The most reliable modality is thus selected based on the defined discriminative ability to track object by using the correlation filter algorithm.For maintaining the effective object model,this paper employs double-threshold strategy to update all modal models.Experiments on the collected thermal-visible video pairs demonstrate the effectiveness of the proposed method.In addition,the runtime of the proposed tracker achieves 141 f/s.

modal selection;adaptive tracking;real-time processing;thermal information

was born in 1966.He

the Ph.D.degree from Anhui University in 2006.Now he is an associate professor at Anhui University,and the member of CCF.His research interests include embedded system,intelligent computing and bioinformatics,etc.

A

TP39

*The“12th Five-Year”Support Program of Ministry of Science and Technology of China under Grant No.2015BAK24B01(“十二五”科技部支撑计划项目).

Received 2016-04,Accepted 2016-07.

CNKI网络优先出版:2016-07-14,http://www.cnki.net/kcms/detail/11.5602.TP.20160714.1616.016.html