基于Faster R—CNN的食品图像检索和分类

2017-05-30梅舒欢闵巍庆刘林虎段华蒋树强

梅舒欢 闵巍庆 刘林虎 段华 蒋树强

摘要 面向食品领域的图像检索和分类等方面的研究成为多媒体分析和应用领域越来越受关注的研究课题之一.当前的主要研究方法基于全图提取视觉特征,但由于食品图像背景噪音的存在使得提取的视觉特征不够鲁棒,进而影响食品图像检索和分类的性能.为此,本文提出了一种基于Faster R-CNN网络的食品图像检索和分类方法.首先通过Faster R-CNN检测图像中的候选食品区域,然后通过卷积神经网络(CNN)方法提取候选区域的视觉特征,避免了噪音的干扰使得提取的视觉特征更具有判别力.此外,选取来自视觉基因库中标注好的食品图像集微调 Faster R-CNN网络,以保证Faster R-CNN食品区域检测的准确度.在包括233类菜品和49 168张食品图像的Dish-233数据集上进行实验.全面的实验评估表明:基于Faster R-CNN食品区域检测的视觉特征提取方法可以有效地提高食品图像检索和分类的性能.关键词食品图像;图像检索;图像分类;深度学习;Faster R-CNN;卷积神经网络

中图分类号 TP391.41

文献标志码 A

0 引言

Web2.0的迅速发展使得食品图像分享网站得到迅速的发展,例如國内的大众点评网和国外的Yummly网站等.食品图像检索和识别可以对网络中的食品图像实现有效的组织、总结和检索.自动的食品图像检索和识别也是食品和健康等许多领域中最有前途的应用之一,可以进一步帮助估计食品的热量和分析人的饮食习惯,实现个性化的服务.因此本文主要解决面向食品领域的图像检索和分类问题.

由于食品图像检索和识别广泛的应用价值,近年来,越来越多的研究者开始研究面向食品图像的分析、检索和分类等问题.例如文献[1]用一种基于统计的方法计算食品图像的特征,实现食品图像的识别.但是该方法仅适用于在标准的食品图像数据集上,不具有泛化性.文献[2]提出用随机森林的方法提取图像中的局部视觉特征实现食品图像的分类.随着深度学习技术的发展,基于CNN的方法[3]已经成为提取图像视觉特征的主流方法.例如文献[4]采用AlexNet网络提取图像的视觉特征实现食品图像的检测和分类.文献[5]采用Google的Inception网络提取图像的视觉特征实现食品图像的分类.文献[6]采用GoogLeNet网络提取图像视觉特征实现食品图像和非食品图像的分类.这些方法主要针对整张食品图像进行视觉特征提取,没有考虑食品图像背景信息对食品图像分类的影响.在现实世界中,拍摄的食品图片不仅包含食品本身的视觉信息,还包含各种各样的背景信息.图1展示了来自Dish数据集[7]一些菜品图像的例子,比如CBD寿司图片中包含人的背景信息;三文鱼图片包含调料、虾等其他物的背景信息.现有的方法由于针对整张图像信息提取视觉特征,会不加区分地把不相关的背景信息也作为菜品视觉表示的一部分,从而影响食品图像检索和分类的性能.

为了解决该问题,本文提出了一种基于Faster R-CNN的食品图像检索和分类方法,如图2所示.该方法主要包括以下2个步骤:首先微调(fine-tune)Faster R-CNN,使用训练的Faster R-CNN网络检测食品图像的食品区域;然后基于检测的食品区域,利用CNN深度神经网络提取该候选区域的视觉特征;最后将提取的食物图像的视觉特征应用到食品图像检索和分类任务中.本文在Dish-233食品数据集上进行实验,该数据集为菜品数据集[7]的一个子集,包括233类菜品和49 168张图像.全面的实验评估表明本文提出的方法相较于其他方法,提取的视觉特征更具有判别性,在食品图像检索和分类任务中,性能均得到了改善.

本文的主要贡献包括以下2个方面:1)提出了一种基于Faster R-CNN的食品图像检索和分类方法,由于提取的视觉特征仅针对图片的食物区域因而更为鲁棒和更具有判别力;2)将提出的方法应用到Dish-233数据集上,全面的实验评估验证了本文所提方法的有效性.

1 相关工作

本节将对近年来食品图像检索和分类相关技术和方法进行介绍,主要包括2部分,第1部分主要介绍食品图像检索和分类的相关技术方法;第2部分主要介绍基于物体检测的卷积神经网络的相关方法.

1.1 食品图像检索和分类

近年来,食品图像检索和分类受到了越来越多研究者的关注.例如Farinella等[8]提出了一种基于纹理Anti-Textons特征用于食品图像的检索与分类的方法.Yang等[1]提出了一种基于统计的食品图像的特征表示方法用于食品图像的分类,但该方法仅局限于标准的食品.Xu等[7]通过随机森林的方法学习食品图像中判别性的特征表示实现菜品识别.相比于以上浅层模型的方法,Kagaya等[4]利用当前的深度卷神经网络(CNN)提取食品图像的特征用于食品图像的检测和识别.Hassannejad等[5]进一步采用更深层的网络实现食品图像的识别.还有一些工作集中在面向餐馆上下文信息的菜品识别[10]和面向移动端的菜品识别[11-12].此外,近来的一些工作例如文献[10,13-14]则进一步考虑图像的原料信息,以一种多任务的方法建模原料信息、视觉信息和类别信息之间的关联.Salvador等[15]学习食品图像和原料信息等不同模态信息的嵌入,实现跨模态的检索.

本文也研究基于面向食品领域的图像检索和分类.不同以上基于整张图片提取视觉特征的方法,考虑食品图像中包含许多和食品无关的背景信息,因此提出了首先用Faster R-CNN方法检测食品的图像区域,然后利用CNN方法提取目标物体区域的视觉特征实现面向食品图像的检索与分类.

1.2 基于物体检测的卷积神经网络(CNNs)

卷积神经网络(CNNs)已作为一种主流的特征提取方法成功应用到许多任务中,例如图像的分类[16]和检索[17-18].相比于传统的视觉方法,CNNs能够提取更为丰富的语义信息.为了将基于CNN的方法应用到物体检测任务中,许多基于检测的CNN方法被相继提出.例如Girshick等[19]提出了R-CNN深度框架,该框架首先利用Object Proposal算法提取图像的候选区域,将这些候选区域作为输入进行模型训练.为了改进R-CNN的速度和准确度,有学者提出了SPP-Net[20]和Fast-RCNN[21].Ren等[22]进一步引入了Faster R-CNN网络,提出了一个Region Proposal Network(RPN)方法用于克服object proposal的依赖.近来一些学者为了能够更快地检测物体,提出了YOLO9000[23].考虑到资源的消耗和准确度性能等的因素,本工作充分利用Faster R-CNN算法提取食品图像的区域,提取食品区域的特征并将其应用到食品图像的检索和分类任务中.

2 基于Faster R-CNN的区域视觉特征提取

为了有效提取食品图像的视觉特征,采用了以下2个步骤:1)微调Faster R-CNN;2)基于食品检测区域的CNN特征提取.

如上分析,大多数食品图像都含有不相关的背景信息,如果只针对食品区域进行特征提取,将会降低食品图像背景信息带来的影响.为了解决该问题,需要对图像的食品区域进行检测.Faster R-CNN[9]已经成为物体区域检测的有效方法,因而也可采用Faster R-CNN检测图像的食品区域.但是现有的Faster R-CNN模型主要基于VOC2007中20类常见的物体预训练得到的模型,并没有涉及到与食品相关的类别,为此首先从视觉基因库中选择和食品类别相关的标定好的图像,然后利用选择的食品图像数据集微调Faster R-CNN,最终得到每张食品图像的候选区域.

微调Faster R-CNN后,利用微调的Faster R-CNN网络模型获得食品图像的候选框和对应的每个候选框的得分.

CNNs网络已经成为视觉特征提取的有效方法.对于每张图像得分较高的候选区域,根据候选框的坐标,用AlexNet网络提取FC7层的特征,然后将得分较高的区域的特征进行串联得到最终图像的特征表示.

对于图像检索任务,给定一张查询图像,基于微调的Faster R-CNN和CNN提取食品图像的视觉特征,通过和查询数据库进行相似度计算返回检索的结果.对于食品图像分类任务,对所有的训练集和测试集的食品图像通过上述方法提取视觉特征,然后通过训练集训练分类器,基于训练的分类模型得到分类的结果.在提取图像食品区域的视觉特征时,通常选取得分最高的图像候选区域.

3 实验评估

在本节中,首先描述实验设置,包括数据集和实现细节,然后在Dish-233食品数据集上验证所提方法在食品图像检索和分类任务中的有效性.

3.1 数据库

利用Dish-233数据集来验证本文所提方法的有效性.原始的菜品数据集[7]包含117 504张图像和11 611种菜品类别.从中挑选出图像数量大于或者等于15的菜品类别,最终获得233种菜品类别和49 168张图像,称这个数据集为Dish-233.图3展示了Dish-233数据集中的一些食品类别的例子.

3.2 实现细节

为了利用Faster R-CNN[9]对食品图像区域进行检测,需要微调(fine-tune)Faster R-CNN,为此需要带有区域边框标注的食品图像数据集.视觉基因组数据库(visual genome)[24]包含了标定的108 077张图像,其中包括大量的食品图像.因此利用Dish-233数据集的类别名,将其翻译成成英文,作为查询词,构建查询词典列表,利用关键词匹配从视觉基因数据集中选取食品图像.为了得到更多的食品图片,进一步选用其他食品数据库的类别信息(比如Food-101),选取食品图片,然后经过人工进一步的筛选,去掉非食品图像,最终得到10 641张食品图像及对应标定的区域,称之为VisGenome-11K.图4展示了来自视觉基因带有标注框的菜品图像.

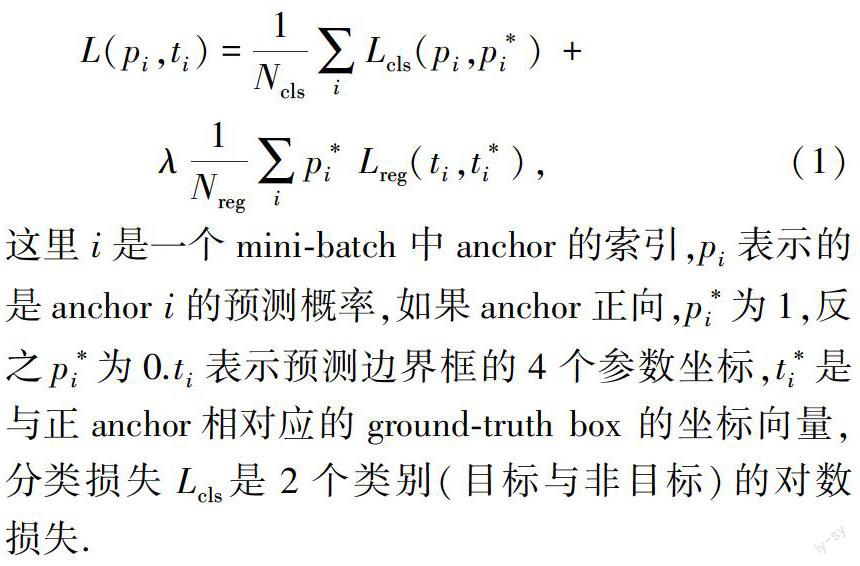

对于模型的参数设置,在Faster R-CNN训练过程中,最小批尺寸(mini-batch)为从一张图像中提取的256个anchor,迭代次数为80 000.其中在前60 000迭代,学习率设为0.001,在后20 000迭代,学习率设为0.000 1.momentum参数设为0.9,权重衰减参数设为0.000 5.在微调AlexNet模型时,将初始学习率设为0.001,每20个时期(epoch)之后,将学习率调整为之前的0.1.最大迭代次数设为60个时期(epoch).

将VisGenome-11K图像集划分成2部分,80%用于训练集,20%用于验证集.利用VisGenome-11K微调Faster R-CNN,然后通过微调的Faster R-CNN模型对Dish数据集的食品图像进行区域检测得到图像中的食品区域,再利用在ImageNet上预训练的AlexNet模型从检测的食品区域提取4096-D的视觉特征.图5是经过微调Faster R-CNN网络得到的一些食品图片的检测结果,从中可以看到经过食品区域检测,可以排除背景噪音的干扰,使得提取的视觉特征更具有判别性.

对所有的图像进行区域检测和视觉特征提取之后,将其应用到食品图像检索和分类任务中.

3.3 检索任务

对于检索任务,从Dish-233 数据集的每一类菜品图像集中随机选取25%的图像作为查询图像,然后将数据集的全集作为查询数据库进行检索.

3.3.1 评价指标和比较方法

采用Precision和MAP 2个评价指标,这2个指标均为信息检索中常用的指标.为了验证本文方法的有效性,和以下方法进行了比较:1) CNN-G[25].该方法主要是利用7层的AlexNet直接提取全局图像的视觉特征;2) CNN-G-F.相比CNN-G,CNN-G-F首先利用训练集对AlexNet网络进行微调,利用微调的网络提取整张图像的视觉特征;3)Faster R-CNN-G.该方法直接用Faster R-CNN网络检测图像的候选食品区域,然后对得分最高的候選区域用微调的AlexNet网络提取视觉特征.方法1)和2)均未用Faster R-CNN进行区域检测,方法3)是为了进一步说明通过VisGenome-11K微调Faster-RCNN产生的影响.

3.3.2 检索结果及分析

分别用上述4种方法在Dish-233数据集上进行检索实验.具体来说,采用Precision@K和MAP@K(K表示在检索过程中返回候选图像的数量),K={1,20,40,60,80,100}.图6 展示了4种不同方法检索在这2个指标的检索结果.从中可以得出以下结论:1)CNN-G-F要比CNN-G的检索性能好,说明通过微调AlexNet网络可以得到更适合Dish数据集的视觉特征;2)Faster R-CNN-G和本文方法要超过CNN-G-F,说明经过Faster R-CNN对食品图像区域进行检测后可以有效减少食品图像背景信息产生的干扰,进而提高了检索性能;3)本文方法比Faster R-CNN-G的性能有适度的提升,说明利用VisGenome-11K微调可以改进食品图像检测的准确度.

圖7展示了一些例子的检索结果.从中可以看到本文方法在所有方法中检索结果是最好的,这进一步验证了其有效性.

3.4 分类任务

对于分类任务,将每一类75%的数据集作为训练集,25%的数据集作为测试集.由于分类任务为单标签的,所以采用准确率(accuracy)作为评价指标.为了验证本文方法的有效性,采用和检索任务相同的比较算法进行比较图8展示了不同方法的分类性能.从中可以看到本文方法的性能最好,相比于CNN-G-F,性能提升了5个百分点.

图9展示了随机选取的20类菜品在不同方法的分类结果.可以看到在大多数例子中,本文方法的分类性能是最好的,进一步验证了其有效性.

4 总结与展望

本文提出了一种基于Faster R-CNN的食品图像检索和分类方法.该方法主要利用Faster R-CNN网络检测图像的食品区域,对检测的食品图像区域通过CNN网络提取视觉特征.相比于传统的基于SIFT和CNN的全局视觉特征提取方法,本文方法所提取的视觉特征更为鲁棒.将本文方法应用到食品图像检索和分类任务中,并在Dish-233数据集上进行实验,实验结果验证了其有效性.在未来的研究中将考虑以下研究方向:1)在更多更大规模的食品数据集上进行实验,比如Food-101[2],以验证本文方法的可扩展性;2)考虑更多食品图像的上下文信息,比如地理位置信息等实现基于上下文的食品图像检索和分类.另外,将其应用到移动设备中实现移动食品图像的检索和分类,以及针对食品区域的热量估计[25]等也将作为后续工作探索的研究方向.

参考文献

References

[1] Yang S L,Chen M,Pomerleau D,et al.Food recognition using statistics of pairwise local features[C]∥IEEE Conference on Computer Vision and Pattern Recognition,2010:2249-2256

[2] Bossard L,Guillaumin M,Van Gool L.Food-101-mining discriminative components with random forests[C]∥European Conference on Computer Vision,2014:446-461

[3] Krizhevsky A,Sutskever I,Hinton G E.ImageNet classification with deep convolutional neural networks[C]∥International Conference on Neural Information Processing Systems,2012:1097-1105

[4] Kagaya H,Aizawa K,Ogawa M.Food detection and recognition using convolutional neural network[C]∥ACM International Conference on Multimedia,2014:1085-1088

[5] Hassannejad H,Matrella G,Ciampolini P,et al.Food image recognition using very deep convolutional networks[C]∥International Workshop on Multimedia Assisted Dietary Management,2016:41-49

[6] Singla A,Yuan L,Ebrahimi T.Food/non-food image classification and food categorization using pre-trained GoogLeNet model[C]∥International Workshop on Multimedia Assisted Dietary Management,2016:3-11

[7] Xu R,Herranz L,Jiang S Q,et al.Geolocalized modeling for dish recognition[J].IEEE Transactions on Multimedia,2015,17(8):1187-1199

[8] Farinella G M,Allegra D,Moltisanti M,et al.Retrieval and classification of food images[J].Computers in Biology & Medicine,2016,77:23-39

[9] Krishna R,Zhu Y K,Groth O,et al.Visual genome:Connecting language and vision using crowdsourced dense image annotations[J].International Journal of Computer Vision,2017,123(1):32-73

[10] Min W Q,Jiang S Q,Wang S H,et al.A delicious recipe analysis framework for exploring multi-modal recipes with various attributes[C]∥ACM International Conference on Multimedia,2017(in press)

[11] Dehais J,Anthimopoulos M,Mougiakakou S.Dish detection and segmentation for dietary assessment on smartphones[C]∥International Conference on Image Analysis and Processing,2015:433-440

[12] Tanno R,Okamoto K,Yanai K.Deepfoodcam:A DCNN-based real-time mobile food recognition system[C]∥International Workshop on Multimedia Assisted Dietary Management,2016:89

[13] Chen J J,Ngo C-W.Deep-based ingredient recognition for cooking recipe retrieval[C]∥ACM on Multimedia Conference,2016:32-41

[14] Min W Q,Jiang W Q,Sang J T,et al.Being a super cook:Joint food attributes and multi-modal content modeling for recipe retrieval and exploration[J].IEEE Transactions on Multimedia,2017,19(5):1100 - 1113

[15] Salvador A,Hynes N,Aytar Y,et al.Learning cross-modal embeddings for cooking recipes and food images[C]∥IEEE Conference on Computer Vision and Pattern Recognition,2017:3020-3028

[16] Szegedy C,Liu W,Jia Y Q,et al.Going deeper with convolutions[C]∥IEEE Conference on Computer Vision and Pattern Recognition,2015:1-9

[17] Tolias G,Sicre R,Jégou H.Particular object retrieval with integral max-pooling of CNN activations[J].arXiv e-print,2015,arXiv:1511.05879

[18] Radenovic F,Tolias G,Chum O.CNN image retrieval learns from DoW:Unsupervised fine-tuning with hard examples[C]∥European Conference on Computer Vision,2016:3-20

[19] Girshick R,Donahue J,Darrell T,et al.Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥IEEE Conference on Computer Vision and Pattern Recognition,2014:580-587

[20] He K M,Zhang X Y,Ren S Q,et al.Spatial pyramid pooling in deep convolutional networks for visual recognition[C]∥European Conference on Computer Vision,2014:346-361

[21] Girshick R.Fast R-CNN[C]∥IEEE International Conference on Computer Vision,2015:1440-1448

[22] Ren S Q,He K M,Girshick R,et al.Faster R-CNN:Towards real-time object detection with region proposal networks[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2017,39(6):1137-1149

[23] Redmon J,Farhadi A.YOLO9000:Better,faster,stronger[J].arXiv e-print,2016,arXiv:1612.08242

[24] Min W Q,Bao B K,Mei S H,et al.You are what you eat:Exploring rich recipe information for cross-region food analysis[C]∥IEEE Transactions on Multimedia,2017(In public)

[25] Meyers A,Johnston N,Rathod V,et al.Im2Calories:Towards an automated mobile vision food diary[C]∥IEEE International Conference on Computer Vision,2015:1233-1241