基于显著计算与变分法的多尺度图像融合

2016-12-29崔洪刚汪永超

崔洪刚,唐 浩,汪永超

(1.广东工业大学计算机学院,广东 广州 510006;2.河源广工大协同创新研究院,广东 河源 517000)

基于显著计算与变分法的多尺度图像融合

崔洪刚1,唐 浩2,汪永超2

(1.广东工业大学计算机学院,广东 广州 510006;2.河源广工大协同创新研究院,广东 河源 517000)

在多尺度图像融合中,通常将图像进行多尺度变换,再对变换后的低频系数与高频系数采用一定的融合规则进行融合,然而融合规则的选择将影响图像的清晰度与融合质量。将视觉显著模型与变分法理论应用在多尺度图像的低频系数融合中,获取最优的融合系数组合,从而增强融合效果,通过对红外线与可见光图像、医学图像的融合实验表明,该方法能克服融合图像对比度偏低的缺陷,获取的图像能较好地保留源图像的显著目标信息,如形状、大小、色调、纹理等,特别是针对异源亮度差异较大的图像。在主观视觉感受与客观评价指标上都有所提升。

多尺度变换;显著计算;变分法;图像融合

图像融合是将同一场景中两幅或多幅图像合成为一幅含有更丰富信息图像的过程。它广泛应用于计算机视觉领域中,如目标识别、特征提取等[1]。多尺度几何分析一直以来是图像融合领域热门研究方法之一,近年来,相关研究者将变分法理论应用在图像融合领域中[2-3],使其成为该领域一个新的热门研究方向。

视觉显著计算 (Visual Saliency Computation)是神经计算科学的分支,是人类处理视觉场景信息的过程,采用这种方法能快速识别出视觉场景中的有用信息。用计算机模拟人类这种特有视觉特征能快速识别处理信息。显著计算是以视觉生理学和认知心理学的研究成果为基础,应用数学模型来研究类似于人类视觉处理方式的信息处理方法。目前研究者已将显著计算应用于静动态目标识别、遥感目标检测等方面。将显著计算用在图像融合过程中能有效保护源图像显著目特征、背景及边缘信息,从而改善融合效果,因此吸引了相关研究者。

多尺度图像融合是将两幅或多幅源图像进行多尺度变换后的低频分量与高频分量采取一定的融合规则进行融合的过程,低频分量包含了图像的大部分细节信心,因此低频系数融合规则会直接影响到最终融合图像的质量,特别是对于异源亮度差异较大图像的融合。最初的简单加权平均规则使得融合图像对比度下降,以往的权值优化方法是采用区域比较方法[4]获取权值进行系数组合,文献[5]采用脉冲耦合神经网络(PCNN)方法获取权值函数,这些方法获取的权值有一定的针对性,并不精准。本文将视觉显著计算与变分法用在多尺度图像融合方法中,对不同种类的图像低频权值α进行优化,得到精准的低频系数组合,从而使得融合图像能更好地保留源图像中的显著信息,使图像更清晰。

1 相关技术

1.1 全变分模型

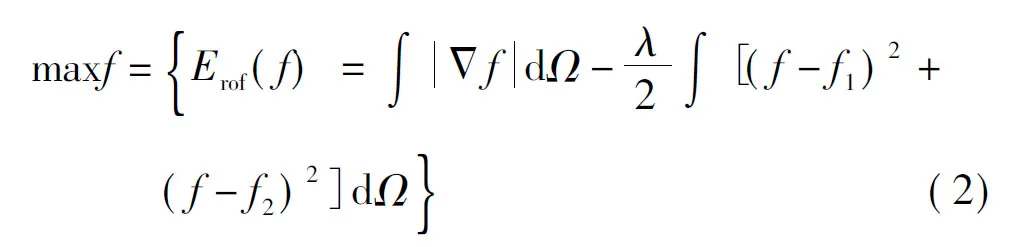

Rudin,Osher和Fatemi等于1992年提出了经典的全变分去噪模型(简称ROF模型),该模型可描述如f0=f+n,其中f0表示受噪声污染的的图像,f表示希望得到的清晰图像,n表示加性噪声,该模型可以表述成求式(1)能量泛函最小值

(1)

(3)

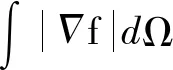

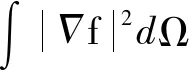

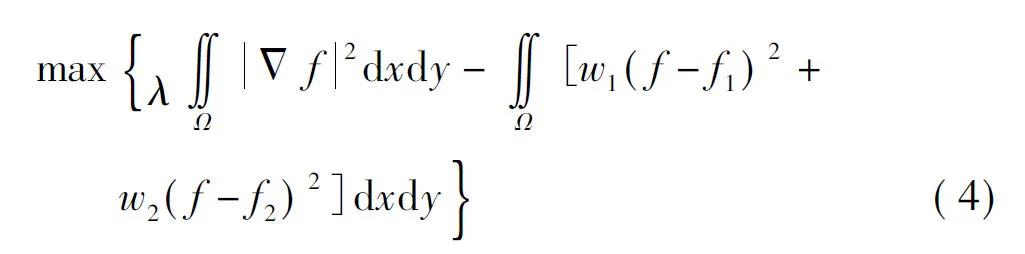

式中:第一项与ROF模型类似,目的是使融合图像更多保留两幅源图像信息;第二项由上文分析可知,使融合图像梯度最大,从而获去更清晰的图像;w1(x,y)与w2(x,y)为源图像对应像素点处权重函数,且权重满足表达式w1+w2=1,表示源图像对融合图像的贡献程度;λ为加权系数,与式(2)所示模型类似,用来权衡源图像与融合图像的保真度。将以上模型化简可得

式(4)所示模型也将图像融合的实际问题转换成了求解数学模型泛函极值问题。

1.2 基于非抽样形态小波的多尺度变换

本文以非抽样形态小波(morphologicalundecidedwavelet,MUDW)[8-9]变换作为多尺度几何分析工具。这种多尺度变换具有较高的运算效率,且实时性与多尺度分解特性良好,从而融合视觉效果较好。其构造方法如下

(5)

(6)

T(xj)+(id-T)(xj)=id(xj)

(7)

(8)

式中:j代表尺度;(xj,Bj+1)表示用结构元素Bj+1对xj进行形态学运算;Bj的定义如下

(9)

形态学滤波器属于非线性滤波器,将其用于图像融合中能达到线性滤波器的效果,并且能增强融合的实时性,使得融合效果更佳。

1.3 视觉显著模型

视觉显著模型分为自顶向下与自底向上两种,前者适用于寻找具体目标、动态图像,融合中需要处理的图像为静态图像,且不依赖于具体目标,因此选择自底向上的视觉显著模型。文献[10]提出的模型采用随机漫步方法去寻找访问次数较少的节点,给出相应的显著值,计算过程复杂,且不够精准;文献[11]提出的模型参考全局颜色平均差异,这并不适合显著目标不均匀或纹理特征较多的图像获取显著性图;文献[12]提出的模型难以确定合适的局部范围而获取显著性图。综合考虑模型的计算效率、准确度及适用性等因素的影响,采用文献[13]提出的模型来计算融合源图像的显著性图。该模型先对源图像各通道进行离散余弦变换(DiscreteCosineTransform,DCT)得到相应的DCT系数,对系数取符号函数后进行DCT逆变换,然后对逆变换后的结果进行Hadamard乘积,对其进行高斯滤波,最后将图像各通道得到的显著性图采用一定的方法加权后得到最终显著性图,如式(10)所示

(10)

(11)

为避免融合图像中出现伪迹,还需对源图像显著性图进行处理,获取显著性权重图,用来决定低频系数融合时所选择的是哪幅源图像的系数,如

(12)

2 显著计算与变分法结合

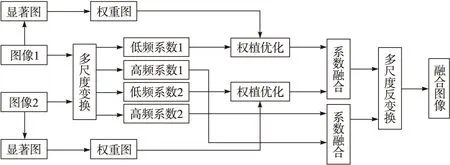

2.1 图像融合框架

基于多尺度变换图像融合方法包含3个步骤:图像分解、系数融合与图像重构。因低频系数代表图像的大部分细节信息,所以对低频系数的融合显得非常关键,本文所做的工作是利用视觉显著模型来指导低频系数的融合,获取更精准的系数组合来增强融合效果,完整的融合流程如图1所示。

图1 融合流程图

具体的融合过程如下:

1)获取低频权重图,分别对源图像1和2按照上文选择的视觉显著模型获取显著性图S1,S2,将显著图采用系数取大的规则得到权重图W1,W2,将该权重图用于全变分模型去引导低频系数融合,从而获取源图像相应加权系数组合。

2)分解图像,采用上文介绍的多尺度变换MUDW对源图像1和2进行分解,获得相应的低频系数L1,L2与各个尺度上的高频系数。

3)低频与高频系数融合,由变换域全变分模型求得低频权值函数α,对低频系数加权融合,高频系数采用绝对值取大的融合规则进行融合。

4)多尺度反变换,将融合后的低频系数与相应的高频系数通过MUDW反变换可获得最终融合图像。

2.2 融合模型与求解方法

本文提出的与变换域全变分模型,如式(13)所示

W2(c-(1-α)c2)]2dxdy}=

W2(αc1)]2dxdy}

(13)

式中:c1与c2分别为源图像多尺度变换后的系数,融合系数为

c=αc1+(1-α)c2

(14)

式中:W1,W2是低频显著性权重图,用于指导多尺度变换后低频系数融合,将该泛函采用梯度下降流进行求解可获得理想的权值,从而使得更精准的低频系数组合。

采用梯度下降流算法进行具体数值计算,α下一个时刻值为

(15)

(16)

根据式(13)得到F的表达式为

(17)

由式(14)得到cx与cy表达式如下

cx=α·(c1x-c2x)+αx·[(c1-c2)τ(1,0)]+c2x

(18)

cy=α·(c1y-c2y)+αy·[(c1-c2)τ(0,1)]+c2y

(19)

由式(17)~(19)可推导出

(20)

(21)

2[W1(1-α)c2+W2(αc1)](c2-c1)

(22)

将式(20)~(22)带入式(15)与(16),采用梯度下降流法利用式(13)~(15)式进行交替迭代运算,可以求出理想权值α和低频系数c,再对融合后的低频与高频系数进行多尺度反变换便求得最终融合图像fF。

3 实验结果与分析

本文提出的方法是在已有的多尺度变换的基础上,将视觉显著计算模型用于其中,并用变分法求解低频系数权值,获得最优的低频系数组合,从而提升融合效果。具体实现过程可表述为,对两幅实验源图像,先分别采用1.3节提出的方法提取显著性图,再将两幅显著性图对应像素位置进行比较,较大者权重为1,较小者权重为0,从而获取两幅显著性权重图,在结合变分法与基于非抽样形态小波的多尺度变换获取合适的低频权值系数,然后针对获取的低频系数,进行相应的多尺度反变换得到最终版的融合图像。实验目的主要是对低频系数融合规则进行改进,因此需要采用相同的多尺度变换,本文针对常见红外线与可见光图像、医学图像进行融合实验并比较结果。

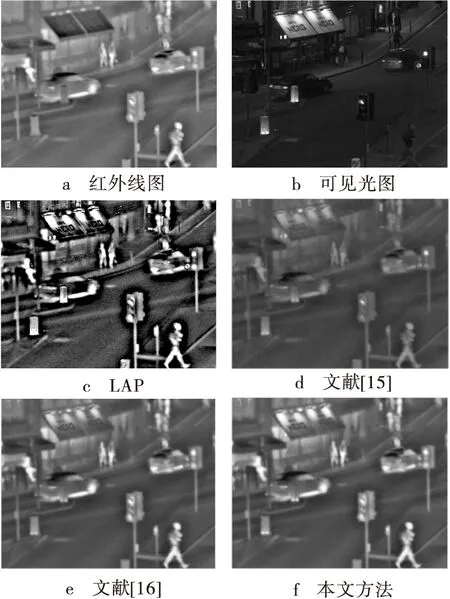

3.1 红外线与可见光图像融合实验

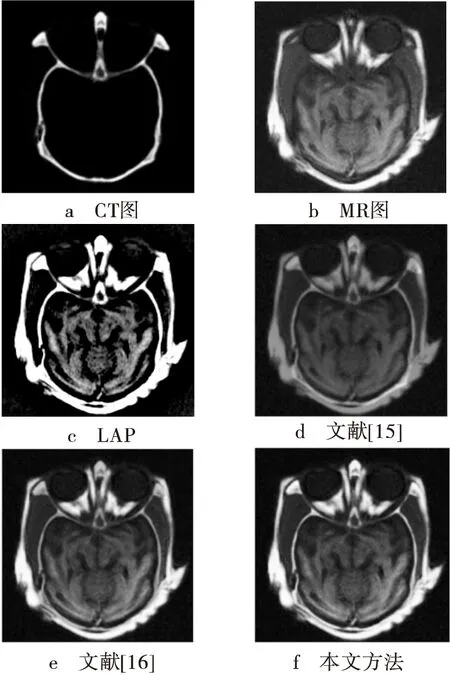

如图2a和图2b是实验的两幅源图像,红外线与可见光图像,其为城市某街道夜景实拍图,显著目标有小汽车、路灯、行人、广告牌及一些道路基础设施,大小为632×496。从其中一幅图像难以显示出所有显著目标的细节,如红外线图像只能看清显著目标物体轮廓与位置,可见光图像能展示目标细节,因光线较暗,也无法直接识别目标的具体情况,这就是图像融合的意义。分别对源图像进传统多尺度变换LAP、变分法[15]、文献[16]提出的基于非抽样形态小波的全变分模型,及本文提出的显著计算与变分法结合的融合方法进行实验对比。所采用的模型参数为:λ=0.2,Δt=5×10-6,低频系数初始权值α设定为0.5,为便于对比,将源图像进行的多尺度变换分解层数都为3层。实验结果如图2c~图2f所示。

图2 红外线与可见光图像与4种方法融合结果对比图

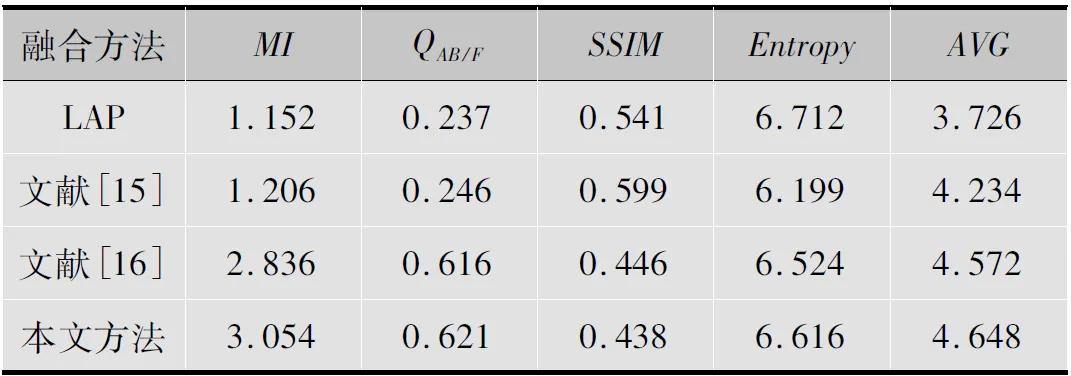

由图2可看出传统多尺度变化LAP方法得到的融合图像显著目标亮度偏大,能识别显著目标,但仅能看清目标轮廓与位置,并不能辨别目标细节部分;文献[15]方法得到结果相反,图像亮度偏小,对比度较低,图像显著不明确,其轮廓与细节都不清楚;文献[16]方法与本文方法亮度与对比度无明显差别,汽车、广告牌、人物、基础设施等显著目标都融合完好,裸眼能分辨清楚,但是本文方法的对比度稍微大,符合人的直观感受。图像左上方的广告牌能明显展示出来,店铺内部细节也能展现出来。为了进一步验证试验结果,本文选取了图像融合领域常用的客观评价指标,互信息量(MI)、边缘保持度(QAB/F)[8]、结构相似度(SSIM)[14]、信息熵(Entropy)[4]、平均梯度(AvreageGradient,AVG)对几种方法的融合结果进行进一步评价对比。结果如表1所示。

表1 红外线与可见光图像融合结果客观评价指标对比

表1实验结果表明,文献[16]方法与本文方法在客观评价指标上明显优于LAP方法与文献[15]方法,这与上文描述的主观视觉感受结果类似。然而,本文采用的融合方法在互信息量、信息熵、边缘保持度、平均结构相似度这4项客观评价指标较文献[16]方法有所提高,结构相似度指标值相近,这也与人的视觉感受结果对应。

3.2 CT/MR医学图像融合

如图3a和图3b是医学CT(Computed Tomography)与MR(Magnetic Resonance)图,大小为512×512,图像为人体结构剖面图,显著目标主要是软组织结构。对其采用相同的方法进行实验,结果如图3c~3f所示。

图3 CT与MR图像及四种方法融合图像结果对比

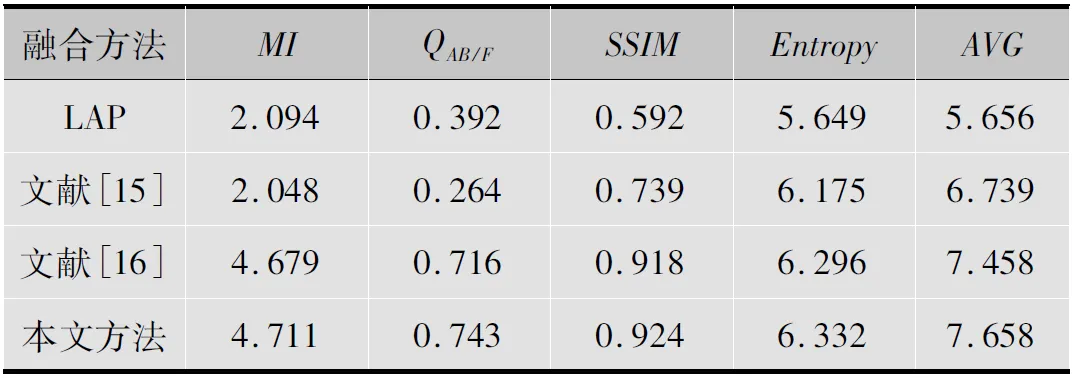

从图3中可看出,传统多尺度变换LAP得到的图像对比度明显偏高,仅仅只能看清图像的轮廓信息,其细节纹理并不能清楚看出;文献[15]基于图像域的变分法得到的图像整体对比度偏低,图像亮度偏暗,无法识别显著目标、边缘与细节;文献[16]基于非抽样形态小波方法与本文方法得到图像裸眼观看无明显区别,仅能看出图像左上方本章方法得到的图像亮度上有些优势,目标更清晰,其他部位无明显区分度。由于源图像所包含的显著目标过少,并且单一,裸眼无法直接评判各种方法的融合效果。分别采用与上文相同的5种客观评价指标对融合结果进行评判。图3的融合结果所对应的5种评价指标对比如表2所示。

表2 医学图像融合五种客观评价指标对比

由表2的结果可以看出传统多尺度变换LAP方法与文献[15]基于图像域的变分法的四项客观评价指标都偏低,这与人眼的主观视觉感受相符合。如上文所述,实验所用医学图像显著目标区域较少,当融合效果比较接近时主观上无法给出准确评价,文献[16]方法与本文方法单从视觉效果上并没有让人感觉到明显差异,但是从常见5项客观评价指标上看,本文方法得出的实验结果各项评价指标均占优势,从而进一步验证了本文方法的优越性。

4 小结

本文方法是在已有的基于非抽样形态小波的多尺度变换MUDW基础上,将视觉显著计算方法用于其中,指导低频系数融合,采用变分法求解出低频权值,从而获得更精准的低频系数组合,该方法是对传统融合规则的改进,从而能提升图像融合的效果。该方法的主要优势表现在:1)运用变分法这一强大的工具去求解泛函极值的方法获取权值系数;2)采用基于非抽样形态小波的多尺度变换,能继承传统多尺度集合分析的优点,更多地保护源图像细节与边缘信息;3)结合了视觉显著计算模型,使获得的权值能随源图像的类型获取更精准的权值,适合多种图像的融合;4)实时性较好,不需要更多的分解层数,运算效率高,迭代次数少。对于本文方法采用的模型选取的参数λ是根据全变分去噪模型对于噪声和图像清晰度的平衡效果获取的,Δt是迭代计算的步长,是通过平衡计算结果的精确度与迭代运算的计算量获得的,W1与W2则通过迭代计算自动获取。

致谢:

论文成果要感谢张梅老师的指导,以及汪永超在设计中进行的大量试验和测试。

[1] RICHA G,DEEPAK A. Wave-packet image fusion technique based on genetic algorithm[C]//Proc. 2014 5th International Conference-Confluence The Next Generation Information Technology Summit (Confluence).Noida,India:[s.n.],2014:280-285.

[2] GEMMA P. Image fusion for enhanced visualization:a variational approach[J]. International journal of computer vision,2009(3):1-11.

[3] MRITYUNJAY K,SARAT D. A total variational-based algorithm for pixel-level image fusion[J].IEEE transactions on image processing, 2009,18(9):1057-1059.

[4] 敬忠良,肖刚,李振华.图像融合——理论与应用[M].北京:高等教育出版社,2007.

[5] 刘建琴.基于变分偏微分方程的图像融合算法研究[D].南京:南京理工大学,2011.

[6] 冈萨雷斯.数字图像处理[M].2版.北京:电子工业出版社,2006.

[7] 李凤霞.基于偏微分方程的图像配准与图像融合研究[D].南京:南京理工大学,2012.

[8] ZHANG J F,SMITH J S,WU J S,et al.Morphological undecimated wavelet decomposition for fault location on power transmission lines[J].IEEE transactions on circuits and systems,2006,53(6):1395-1402.

[9] ZHANG W B,SHEN L,LI J S,et al. Morphological undecimated wavelet decomposition for fault feature extraction of rolling element bearing[C]//2nd International Congress on Image and Signal Processing CISP′09.Tianjin,China:IEEE,2009:1-5

[10] HAREL J, KOCH C, PERONA P. Graph-based visual saliency[J]. Advances in neural information processing systems,2007,12(22):545-552.

[11] ACHANTA R, HEMAMI S. Frequency-tuned salient region detection[J]. International conference on computer vision and pattern recognition,2009,1(4):597-604.

[12] CHENG M M, ZHANG G X. Global contrast based salient region detection[J].IEEE transactions on pattern analysis & machine intelligence,2011, 11(13): 409-416.

[13] LUO X Y,ZHANG J,DAI Q H. Saliency-based geometry measurement for image fusion performance[J]. IEEE transactions on instrumentation and measurement,2012,61(4) :1130-1132.

[14] HOU X D,HAREL J, KOCH C. Image signature:highlighting sparse saliency regions[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(1): 194-201.

[15] 曾志峰,马华山.基于全变分的图像融合算法的研究[J].计算机应用与软件,2009,26(5):225-227.

[16] 邓苗,张基宏.基于形态非抽样小波的实时图像融合方法[J].计算机应用,2012,32(10):1-7.

[17] JIANG B,WANG X Y,ZHANG R,et al. A comparative study of wavelet-based image fusion with a novel fusion rule II[C]//Proc.2015 Fifth International Conference on Instrumentation and Measurement,Computer, Communication and Control. Qinhuangdao,China:[s.n.],2015:1304-1309.

崔洪刚(1976— ),硕士,讲师,主要研究方向为智能计算、知识管理;

唐 浩(1989— ),硕士生,主研计算机技术;

汪永超(1991— ),硕士生,主研机械电子技术。

责任编辑:时 雯

Multiscale image fusion based on saliency computation and total variation

CUI Honggang1, TANG Hao2, WANG Yongchao2

(1.SchoolofComputerScienceandTechnologyofGDUT,Guangzhou510006,China;2.SynergyInnovationInstitudeofGDUT,GuangdongHeyuan517000,China)

In the image fusion methods based on multiscale transform, the coefficients of low and high frequency are fused through a weighted sum rule. The choosing of weight function influences definition and quality of fused image. A novel method is proposed for the optimization of low weight function based on total variation and visual saliency to obtain eventual fused image. Image fusion experiments are carried out utilize visible light images and medical images that is registration processed.Result shows that the proposed method can overcome the low image contrast problem, and the reconstructed image protects salient-object information, such as shape, size, color, texture, etc effectively, and it is more effective for processing source images with brightness differences. The subjective visual perception and objective evaluation index has got certain improvement.

multiscale transformation; saliency computation; total variation; image fusion

崔洪刚,唐浩,汪永超.基于显著计算与变分法的多尺度图像融合[J].电视技术,2016,40(12):17-22. CUI H G, TANG H, WANG Y C. Multiscale image fusion based on saliency computation and total variation[J].Video engineering,2016,40(12):17-22.

TP391

A

10.16280/j.videoe.2016.12.004

广东省科技计划项目(2015A040405007);国家火炬计划项目(2015GH511343)

2016-03-30